1.本发明涉及图像处理技术领域,尤其涉及一种人脸检测方法、智能终端及存储介质。

背景技术:

2.随着人们对智能手机越来越依赖,他们对智能手机的要求也越来越高。为满足用户的需求,厂商也逐步提高手机的像素,也因此,对拍照后的照片处理要求也越来越高。现今的美颜功能包括磨皮、美白、瘦脸、眼部增强等。美颜的第一步是精确获取图像中的人脸皮肤区域。

3.目前常用的获取人脸皮肤区域的方法有两种。一种是采用传统的算法对皮肤进行分割,另一种是通过深度学习检测人脸的关键点,从而确定皮肤区域。但是,采用传统算法分割皮肤效果较差,会将图像中头发或与皮肤颜色相近的无关区域分割进去。如照片中背景为肉色,分割后的皮肤区域会带有很大一部分的背景。同时,对通过传统算法得到的皮肤进行美颜后,其边缘效果较差,例如过渡不自然等。而采用深度学习检测虽然能够提高分割的精确度,但是它的美颜无法兼顾图像中的光线等因素,美颜后的人脸与图像背景存在不自然感,从而导致美颜效果较差。目前对于人脸关键点的检测主要是通过卷积神经网络训练图像实现,在训练过程中并未考虑照片所处的光照环境等因素的影响,因此在复杂环境下,人脸关键点检测的准确率较低。

技术实现要素:

4.本发明的主要目的在于提供一种人脸检测方法、智能终端及存储介质,旨在提高人脸关键点检测的准确率。

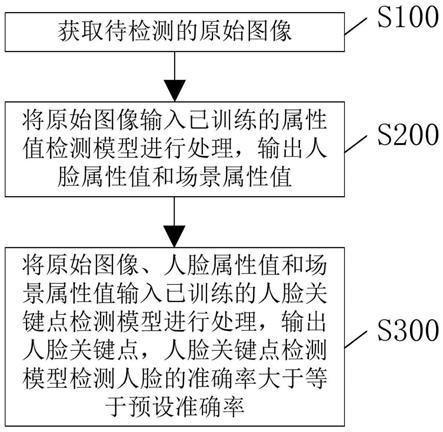

5.为实现上述目的,本发明提供一种人脸检测方法,人脸检测方法包括如下步骤:

6.获取待检测的原始图像;

7.将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值;

8.将原始图像、人脸属性值和场景属性值输入已训练的人脸关键点检测模型进行处理,输出人脸关键点,人脸关键点检测模型检测人脸的关键点的准确率大于等于预设准确率。

9.可选地,人脸检测方法还包括:

10.根据人脸关键点确定原始图像中待美颜的皮肤区域;

11.根据人脸属性值和场景属性值,对皮肤区域进行美颜,得到美颜后的目标图像。

12.此外,为实现上述目的,本发明还提供一种智能终端,其中,智能终端包括:存储器、处理器及存储在存储器上并可在处理器上运行的人脸检测程序,人脸检测程序被处理器执行时实现如上的人脸检测方法的步骤。

13.此外,为实现上述目的,本发明还提供一种存储介质,其中,存储介质存储有人脸

检测程序,人脸检测程序被处理器执行时实现如上的人脸检测方法的步骤。

14.在本发明中,提供了一种兼顾人脸属性值和场景属性值的人脸检测方法。先将待检测的原始图像输入属性值检测模型集,得到人脸属性值和场景属性值,然后将人体属性值和场景属性值与原始图像一同输入人脸关键点检测模型,人脸关键点检测模型在对人脸属性值和场景属性值综合考虑的前提下,对图像进行人脸关键点检测。因此,本发明能够排除或减弱照片中人脸属性及场景属性对人脸关键点检测带来的干扰,从而提高人脸关键点检测的准确率。

15.本发明还包括在检测后对该人脸关键点检测所对应的皮肤区域进行美颜,确定了人脸属性值和场景属性值之后,可确定对应的美颜参数,如美白幅度,滤波算法和滤波参数,从而能够根据不同得人脸属性值和场景属性值,搭配不同的美颜方法,以实现美颜的自适应,更加灵活智能。

附图说明

[0016][0017]

图1是本发明人脸检测方法提供的较佳实施例的流程图;

[0018]

图2是本发明人脸检测方法的较佳实施例中步骤s200中得到人脸属性值的流程图;

[0019]

图3是本发明人脸检测方法的较佳实施例中步骤s200之前步骤的流程图;

[0020]

图4是本发明人脸检测方法在步骤s300之后的步骤的流程图;

[0021]

图5是本发明人脸检测方法的较佳实施例中当要进行的美颜为美白时,步骤s500的流程图;

[0022]

图6是本发明人脸检测方法的较佳实施例中当要进行的美颜为磨皮时,步骤s500的流程图;

[0023]

图7为本发明智能终端的较佳实施例的运行环境示意图。

具体实施方式

[0024]

为使本发明的目的、技术方案及优点更加清楚、明确,以下参照附图并举实施例对本发明进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0025]

本发明较佳实施例的人脸检测方法,如图1所示,人脸检测方法包括以下步骤:

[0026]

步骤s100、智能终端获取待检测的原始图像。

[0027]

在本实施例中,执行人脸检测方法的智能终端为智能手机。在实际应用中,可为电视、电脑等。当用户通过智能手机得到图像时相机将原始图像作为待检测的原始图像发送至智能手机中,以供其对原始图像进行人脸关键点检测。

[0028]

步骤s200、智能终端将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值。

[0029]

具体地,属性值检测模型及包含有多个检测模型,通过这些检测模型和对原始图像进行检测,从而得到对应的人脸属性值和场景属性值。

[0030]

人脸属性值就是指能影响后续美颜的参数的人脸属性,例如性别,年龄,种族等

等。若原始图像中人物为婴儿,所对应的年龄比较小,婴儿本身的皮肤较为白皙,可将美白参数调小,使得美颜后的原始图像显得更真实。

[0031]

场景属性值是指原始图像中场景的光线强弱,光线来源等种种可影响后续美白参数的属性值。例如,若光线较强则可对应调大美白的幅度,如果光线较弱,则可调小美白的幅度。从而使其美颜更为自然。

[0032]

进一步地,属性值检测模型集包括人脸属性值检测模型和场景属性值检测模型,步骤s200包括:

[0033]

智能终端将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值;智能终端将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值;或者,

[0034]

智能终端将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值;智能终端将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值;或者,

[0035]

智能终端在将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值的过程中,智能终端将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值。

[0036]

具体地,预先设置人脸属性检测模型和场景属性检测模型,将待检测的原始图像输入人脸属性值检测模型中,本实施例采用人脸属性值检测模型是预先通过大量的训练样本学习得到的神经网络模型。

[0037]

将原始图像输入人脸属性值检测模型后,以人脸属性值检测模型为卷积神经网络为例,人脸属性值检测模型会对原始图像进行特征提取,然后根据提取的特征,对人脸的属性进行分类,如根据性别,将原始图像中人物分为男性和女性,从而得到人脸属性值进行预测。

[0038]

在将原始图像输入人脸属性值检测模型的同时、之后或之前,也将原始图像输入场景属性值检测模型中,基于同样的原理,得到场景属性值。

[0039]

除单独使用卷积神经网络(convolutional neural networks,cnn) 模型或(recurrent neural networks,rnn)模型外,还可将两种模型进行组合,如rnn模型用于特征提取,cnn模型用于分类,得到人脸属性值或场景属性值。

[0040]

进一步地,参阅图2,在本实施例中,人脸属性值包括年龄和性别,人脸属性值检测模型包括人脸对齐模型、年龄检测模型和性别检测模型,步骤s200中得到人脸属性值的具体过程包括:

[0041]

步骤s211,智能终端将原始图像输入人脸对齐模型进行对齐,输出对齐图像。

[0042]

具体地,人脸对齐是指根据输入的原始图像的人脸与标准的人脸进行五官对齐。为了减少其它因素的干扰,在人脸识别等模型的训练过程中,需提前将原始图像中的人脸进行标准化,也就是人脸对齐。因此在人脸属性值检测中包括人脸对齐模型。先将原始图像输入人脸对齐模型,人脸对齐模型会找到原始图像中的关键点,如鼻子、眼睛、嘴巴,然后通过旋转、平移等手段将原始图像中的人脸进行处理,以将原始图像中的人脸与训练样本图像中的人脸对齐。

[0043]

例如,训练样本图像中的人脸没有微笑,而原始图像微笑,将原始图像输入人脸对齐模型中,人脸对齐模型将找到嘴巴的关键点,并将嘴巴的关键点下移,将原始图像中的嘴巴转为未微笑状态,得到与训练样本图像对齐的对齐图像。

[0044]

步骤s212,智能终端将对齐图像分别输入年龄检测模型和性别检测模型中进行年

龄识别和性别识别,输出年龄和性别。

[0045]

在本实施例中,年龄检测模型和性别检测模型是通过神经网络模型训练得到。神经网络模型包括cnn模型、rnn模型等等。他们的训练过程都是通过对大量的训练样本前向传播,得到预测结果,再计算预测结果与标定文件之间的损失,反向传播进行参数的优化。在本实施例,以cnn模型作为年龄检测模型的基础模型,进行简单描述。

[0046]

先获取大量的训练样本图像,该训练样本图像包含不同年龄的人脸,对每个训练样本图像标注人脸对应的年龄,并作为标注文件保存。然后将训练样本图像输入cnn模型中。cnn模型包含卷积层、池化层以及全连接层。由于图像本质由多个像素点堆积,而每个像素点可用rgb等颜色值表示,因此训练样本图像可视为一个矩阵。先通过 cnn模型的卷积层对训练样本图像进行卷积,池化层对卷积后的矩阵进行池化。卷积层 池化层的组合可在隐藏层出现多次,最后一个池化层得到的特征图依次按行展开,连接成一个向量,将其输入全连接网络。最后通过分类器,判断训练样本图像对应的预测结果。预测结果与之前的标注文件中的年龄会存在一些差异,可根据损失函数计算两者之间的差异,即损失值。通过将损失值反向传输回cnn模型,调整模型的各个参数,直至该模型收敛,得到年龄检测模型。

[0047]

通过同样的方法,可得到性别检测模型。将通过人脸对齐模型得到的对齐图像输入年龄检测模型和性别检测模型。年龄检测模型和性别检测模型分别对对齐图像进行年龄检测和性别检测,得到原始图像对应的年龄和性别。

[0048]

进一步地,上述实施例中人脸属性值检测模型和场景属性值检测模型的损失函数为focal loss函数。

[0049]

具体地,focal loss函数主要为解决one-stage目标检测中正负样本比例严重失衡的问题。该损失函数降低了大量简单负样本在训练中所占的权重。focal loss函数是在交叉熵损失函数基础上进行修改得到。focal loss函数公式如下:

[0050][0051]

其中,l

fl

是损失值,y’是预测结果,y是标注文件中标注的数值, y∈[0,1],α是平衡因子,γ是权重指数。通过对α和γ的调整,可以调节正负样本之间的权重比,减少误差,提高结果的准确率。

[0052]

进一步地,参阅图3,步骤s200之前,还包括:

[0053]

步骤s110,智能终端基于预先设置的人脸肤色算法,计算原始图像的人脸肤色值。

[0054]

具体地,目前人脸肤色算法有基于rgb(red green blue,红绿蓝)颜色空间的肤色识别等等。主要是将像素点的颜色值进行一定的计算,得到人脸肤色值,由于计算人脸肤色值为惯用手段,在此不再进行更进一步说明。

[0055]

步骤s112,智能终端根据人脸肤色值,分别确定检测模型集中对应的人脸属性值检测模型和场景属性值检测模型。

[0056]

具体地,检测模型集中包含了多个不同的人脸属性值检测模型和场景属性值检测模型,预先将不同的人脸部设置进行分组,例如分为三组,每一组对应不同的人脸肤色值范围。而不同的人脸肤色的范围对应不同的人脸属性值检测模型和场景属性值检测模型。当计算得到人脸肤色之后,确定其对应的范围,从而更进一步确定对应的人脸属性值检测模

型和场景属性值检测模型。通过此方法,提高检测的拟合度,降低错误率。

[0057]

步骤s300,智能终端将原始图像、人脸属性值和场景属性值输入已训练的人脸关键点检测模型进行处理,输出人脸关键点,人脸关键点检测模型检测人脸的关键点的准确率大于等于预设准确率。

[0058]

具体地,得到人脸属性值和场景人属性值后,将他们与原始图像一起输入人脸关键点检测模型中。人脸关键点检测模型也可通过对神经网络模型训练得到。由于人脸关键点检测模型根据人脸属性值和场景属性值,对原始图像进行检测,因此所得到的人脸关键点是在人脸属性值和场景属性值的基础上得到,相较于传统的人脸关键点检测模型,本方案能够减少由于人脸属性差异和场景差异导致的检测不准确问题。

[0059]

进一步地,人脸关键点检测模型是基于自注意力机制构建的深度卷积生成对抗网络。

[0060]

在本实施例中,人脸关键点检测模型是通过深度卷积生成对抗网络(deep convolutional generative adversarial,dcgan)训练得到的。 dcgan网络模型是将cnn模型和生成式对抗网络(generative adversarial networks,gan)模型进行整合得到。

[0061]

首先介绍gan模型,包括生成模型和判别模型。生成模型用于生成接近真实的图像或者数据,判别模型用于判别生成模型生成的图像或数据是真实的还是伪造的。生成模型和判别模型彼此不断博弈,因此gan模型对差异更为敏感。

[0062]

而dcgan模型将生成模型和判别模型用cnn来搭建,同时取消了池化成和全连接层等等改进。因此通过dcgan网络模型训练得到的人脸关键点检测模型的更加接近真实值,也更加稳定。以输入原始图像和人脸属性值为例进行简单描述。生成模型先通过输入的人脸属性值,生成一系列与真实图像相似的伪图像。然后采用判别模型判断伪图像和原始图像是否真实以及预测这些图像上的人脸关键点和人脸属性值。然后计算预测的人脸关键点和人脸属性值与输入的标定文件中人脸关键点和人脸属性值的损失值,并将损失值反向传输生成模型和判别模型。生成模型根据损失值,进一步优化生成的伪图,而判别模型进一步优化人脸关键点检测和真伪判断的准确性,直至两者达到收敛且平衡,完成训练。然后将原始图像、人脸属性值和场景属性值输入训练后的判别模型,并控制该判别模型对原始图像进行检测,从而确定原始图像中的人脸关键点,此步骤的训练与神经网络训练方法类似,直至模型收敛。本实施例中,收敛的判定方法为人脸关键点检测模型检测人脸关键点的准确率大约等于预设准确率。其中,本实施例中人脸关键点检测模型的损失函数可用以下公式表示:

[0063][0064]

其中,l

gan

表示损失值,e表示期望,即预先对训练样本的标定值,l

t

表示输入的人脸属性值,v

t

表示输入的人脸关键点,d表示判别模型,g表示生成模型,lg表示伪图像的人脸属性值,vg表示伪图像的人脸关键点。增加场景属性值,生成模型的生成和判别模型的判断都增加场景属性值。

[0065]

此外,dcgan模型还采用了自注意力机制,在特征提取部分,增加了对人脸属性值和场景属性值的学习权重,因此提取的特征中,有更多关于人脸属性和场景属性的特征被保留下来。例如当光线较暗时,人脸关键点检测模型检测时会增加边界数值较为接近的像

素点的权重。

[0066]

进一步地,参阅图4,在步骤s300之后,还包括:

[0067]

步骤s400,智能终端根据人脸关键点确定原始图像中待美颜的皮肤区域。

[0068]

在本实施例中,人脸关键点包括人的五官,例如鼻子,眼睛和嘴巴,以及脸型的轮廓,包括皮肤和头发或者是背景相接触的点。此外还可选择人的手臂或脖子等可能暴露的皮肤的点。获取人脸关键点后,可通过关键点之间的位置关系,将其联系在一起,从而框选出待检测的皮肤区域。

[0069]

步骤s500,智能终端根据人脸属性值和场景属性值,对皮肤区域进行美颜,得到美颜后的目标图像。

[0070]

具体地,美颜包括磨皮、美白、瘦脸、眼部增强、高光等等。

[0071]

以瘦脸为例,瘦脸是通过对原始图像中脸部轮廓的像素点进行偏移,实现对人脸的放大或缩小。确定人脸属性值和场景属性值后,可确定对应的偏移映射关系,例如某像素点坐标为(x1,y1),经过特定的偏移映射关系后,坐标为(x2,y2)。将所有像素点偏移后,即可完成瘦脸,得到瘦脸后的目标图像,最后将目标图像输出,在智能手机的显示屏上展示出来。

[0072]

进一步地,参阅图5,当要进行的美颜为美白时,步骤s500包括:

[0073]

步骤s511,智能终端获取皮肤区域中各个像素点的颜色值。

[0074]

进一步地,由于图像有多个像素点构成,每个像素点都可用颜色值进行表示。因此皮肤区域也有其特定的颜色值。先获取皮肤区域中各个像素点的颜色值,用于后续通过对颜色值的增加实现美白效果。

[0075]

步骤s512,智能终端根据人脸属性值和场景属性值确定美白增幅度。

[0076]

具体地,美白增幅度是指将像素点的颜色值增加一定的数值,该数值可将颜色值所对应的深色和暗色调整为浅色或亮色,在视觉上呈现美白效果。预先将人脸属性值和场景属性值所对应的美白增幅度进行对应。如光线较暗时,美白增幅度也随之减小。此时的美白增幅度若太大,会与背景的光线产生强烈的差异感,美白不够自然。

[0077]

步骤s513,智能终端根据美白增幅度对颜色值进行增加,得到美白后的目标图像。

[0078]

具体地,美白增幅度为固定的数值,当得到美白增幅度后,皮肤区域的像素点的颜色值增加美白增幅度的数值,从而使皮肤区域的颜色值更大,在视觉上呈现美白的效果。

[0079]

进一步地,参阅图6,当要进行的美颜为磨皮时,步骤s500包括:

[0080]

步骤s521,智能终端获取皮肤区域中各个像素点的颜色值。

[0081]

步骤s522,智能终端根据人脸属性值和场景属性值确定滤波算法和滤波参数。

[0082]

具体地,磨皮本质上是通过一定的滤波算法对皮肤区域进行滤波处理,从而使这部分区域模糊化,达到一个过滤瑕疵的效果。确定了人脸属性值和场景属性值后,可进一步确定应当采用何种滤波算法以及该滤波算法所使用的滤波参数。本实施例优选可供选用的滤波算法包括双边滤波和高斯滤波。双边滤波是一种非线性的滤波方法,其结合图像的空间邻近度和颜色值相似度的一种折衷处理,同时考虑空域信息和灰度相似性,达到保边去噪的目的。具有简单、非迭代、局部的特点。高斯滤波一种线性平滑滤波器,主要适用处理高斯噪声,对于抑制服从正态分布的噪声非常有效。

[0083]

步骤s523,智能终端根据滤波算法和滤波参数对皮肤区域进行滤波,得到美颜后

的目标图像。

[0084]

具体地,以滤波算法为双边滤波为例。将滤波参数代入滤波算法中,得到滤波器。然后将各个颜色值输入滤波器中进行滤波处理,得到滤波后的颜色值和磨皮后的目标图像,最后将目标图像输出。

[0085]

由于美颜包括多个部分,本方案将各个美白步骤作为多个模块,以串联的方式进行拼接。当一个模块执行完某个美颜步骤后,进入下一个模块进行下一步美颜。

[0086]

本方案和将人脸属性值和场景属性值作为美颜的参考依据,针对不同的属性值有不同的美颜参数,如美白幅度、滤波算法、滤波参数和偏移映射关系,从而提高了美颜的自然度。

[0087]

进一步地,如图7所示,基于上述人脸检测方法,本发明还相应提供了一种智能终端,智能终端包括处理器10、存储器20及显示器 30。图7仅示出了智能终端的部分组件,但是应理解的是,并不要求实施所有示出的组件,可以替代的实施更多或者更少的组件。

[0088]

存储器20在一些实施例中可以是智能终端的内部存储单元,例如智能终端的硬盘或内存。存储器20在另一些实施例中也可以是智能终端的外部存储设备,例如智能终端上配备的插接式硬盘,智能存储卡(smart media card,smc),安全数字(secure digital,sd)卡,闪存卡(flash card)等。进一步地,存储器20还可以既包括智能终端的内部存储单元也包括外部存储设备。存储器20用于存储安装于智能终端的应用软件及各类数据,例如安装智能终端的程序代码等。存储器20还可以用于暂时地存储已经输出或者将要输出的数据。在一实施例中,存储器20上存储有人脸检测程序40,该人脸检测程序 40可被处理器10所执行,从而实现本技术中人脸检测方法。

[0089]

处理器10在一些实施例中可以是一中央处理器(centralprocessing unit,cpu),微处理器或其他数据处理芯片,用于运行存储器20中存储的程序代码或处理数据,例如执行人脸检测方法等。

[0090]

显示器30在一些实施例中可以是led显示器、液晶显示器、触控式液晶显示器以及oled(organic light-emitting diode,有机发光二极管)触摸器等。显示器30用于显示在智能终端的信息以及用于显示可视化的用户界面。智能终端的部件10-30通过系统总线相互通信。

[0091]

在一实施例中,当处理器10执行存储器20中人脸检测程序40 时实现以下步骤:

[0092]

获取待检测的原始图像;

[0093]

将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值;

[0094]

将原始图像、人脸属性值和场景属性值输入已训练的人脸关键点检测模型进行处理,输出人脸关键点,人脸关键点检测模型检测人脸的关键点的准确率大于等于预设准确率。

[0095]

其中,人脸检测方法还包括:

[0096]

根据人脸关键点确定原始图像中待美颜的皮肤区域;

[0097]

根据人脸属性值和场景属性值,对皮肤区域进行美颜,得到美颜后的目标图像。

[0098]

其中,属性值检测模型集包括人脸属性值检测模型和场景属性值检测模型,将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值,包括:

[0099]

将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值;将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值;或者,

[0100]

将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值;将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值;或者,

[0101]

在将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值的过程中,将原始图像输入场景属性值检测模型进行场景检测,输出场景属性值。

[0102]

其中,人脸属性值包括年龄和性别,人脸属性值检测模型包括人脸对齐模型、年龄检测模型和性别检测模型。

[0103]

将原始图像输入人脸属性值检测模型进行人脸检测,输出人脸属性值,包括:

[0104]

将原始图像输入人脸对齐模型进行对齐,输出对齐图像;

[0105]

将对齐图像分别输入年龄检测模型和性别检测模型中进行年龄识别和性别识别,输出年龄和性别。

[0106]

其中,根据人脸属性值和场景属性值,对皮肤区域进行美颜,得到美颜后的目标图像,包括:

[0107]

获取皮肤区域中各个像素点的颜色值;

[0108]

根据人脸属性值和场景属性值确定美白增幅度;

[0109]

根据美白增幅度对颜色值进行增加,得到美白后的目标图像。

[0110]

其中,根据人脸属性值和场景属性值,对皮肤区域进行美颜,得到美颜后的目标图像,包括:

[0111]

获取皮肤区域中各个像素点的颜色值;

[0112]

根据人脸属性值和场景属性值确定滤波算法和滤波参数;

[0113]

根据滤波算法和滤波参数对皮肤区域进行滤波,得到美颜后的目标图像。

[0114]

其中,将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值之前,方法还包括:

[0115]

基于预先设置的人脸肤色算法,计算原始图像的人脸肤色值;

[0116]

根据人脸肤色值,分别确定检测模型集中对应的人脸属性值检测模型和场景属性值检测模型。

[0117]

本发明还提供一种存储介质,其中,存储介质存储有人脸检测程序,人脸检测程序被处理器执行时实现如上的人脸检测方法的步骤。

[0118]

综上,本发明提供一种人脸检测方法、智能终端及存储介质,方法包括:获取待检测的原始图像;将原始图像输入已训练的属性值检测模型集进行处理,输出人脸属性值和场景属性值;将原始图像、人脸属性值和场景属性值输入已训练的人脸关键点检测模型进行处理,输出人脸关键点,人脸关键点检测模型检测人脸的关键点的准确率大于等于预设准确率。本发明能够提高人脸关键点检测的准确率。

[0119]

当然,本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关硬件(如处理器,控制器等)来完成,的程序可存储于一计算机可读取的存储介质中,程序在执行时可包括如上述各方法实施例的流程。其中的存储介质可为存储器、磁碟、光盘等。

[0120]

应当理解的是,本发明的应用不限于上述的举例,对本领域普通技术人员来说,可

以根据上述说明加以改进或变换,所有这些改进和变换都应属于本发明所附权利要求的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。