背景技术:

1.计算机可输入数据,分析数据,并输出分析结果。例如,计算机可分析图像,该图像可由成像装置捕获或者可已经存储在存储装置中。计算机可使用计算机视觉技术来检测图像中的特征、分割感兴趣的对象等。计算机可向用户指示检测到的特征、被分割的对象等,或者可将它们的位置的指示存储在存储装置中。

技术实现要素:

附图说明

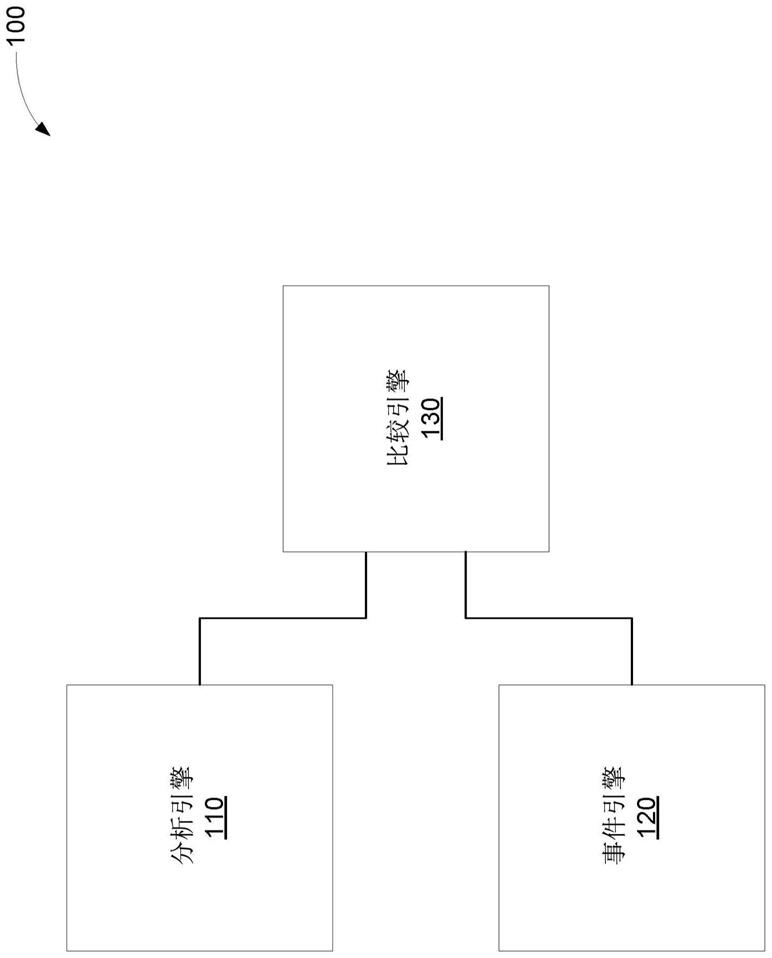

2.图1是用于识别目标的生理识别的重要部分和机器识别的重要部分之间的差异的示例系统的框图。

3.图2是用于识别目标的生理识别的重要部分与机器识别的重要部分之间的差异的另一示例系统的框图。

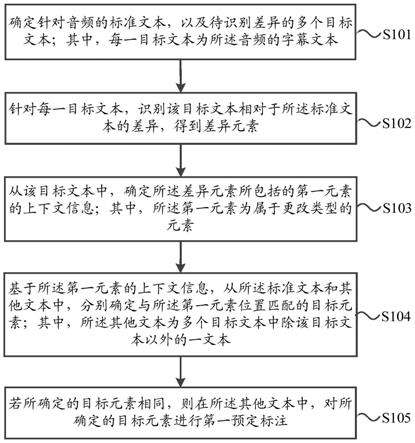

4.图3是用于识别目标的生理识别的重要部分、机器识别的重要部分以及用户指示的重要部分之间的差异的示例方法的流程图。

5.图4是用于识别目标的生理识别的重要部分、机器识别的重要部分以及用户指示的重要部分之间的差异的另一示例方法的流程图。

6.图5是包括指令的示例计算机可读介质的框图,所述指令使处理器识别目标的生理识别的重要部分与机器识别的重要部分之间的差异。

7.图6是包括指令的另一示例计算机可读介质的框图,所述指令使处理器识别目标的生理识别的重要部分与机器识别的重要部分之间的差异。

具体实施方式

8.随着计算机的能力变得越来越强,它们能够以接近或超过人类的熟练程度来执行诸如诊断任务的任务。例如,计算机可用于分析可能由医生分析的医学图像。在这种情况下,人们可能过度依赖于计算机来做出决定,而不是应用他们自己的能力。当人看到计算机分析的结果时,人可能无法忘记或忽视结果,这可能会使人的分析出现偏差。可选地或另外地,与计算机的分歧可能是罕见的事件,因此审查计算机工作的人可能花费他们的大部分时间来应用较低水平的思考和分析。这种较低水平的思考和分析可能使人陷入昏沉,从而未察觉到罕见的事件。此外,由于对计算机的过度依赖,人的能力可能衰退并丧失。在医学图像示例以及其他对健康和安全重要的示例中,人和计算机一起有效工作的失败可能导致灾难性结果。

9.避免这种结果的一种选择是放弃使用计算机来执行任务。然而,放弃使用计算机会造成其自身的一系列悲惨但可避免的结果。计算机可利用最新的分析技术快速有效地更

新,并且不会遭受人类失败的影响。因此,在一些情况下,计算机可比人表现得更好。使用计算机或放弃计算机的任一选择都会产生不良结果并且可能产生应承担的责任。因此,通过允许计算机以不妨碍参与任务的人的表现的方式帮助人执行任务,可实现更好的表现。

10.在一个示例中,可将来自计算机分析的结果与来自人类分析的结果进行比较,从而可向用户指示差异。然而,这些结果的比较可能缺乏来自分析过程的细节。因此,由于缺乏细节,比较可能不必要地识别差异或给用户造成额外的工作。例如,人可能已经分析了目标的一部分,发现了潜在问题,并且意识到潜在问题,但是人可能已经确定潜在问题不是实际问题。可选地或另外地,计算机和人可具有类似的结果,但是关于这些结果是否超过阈值的结论不同。通过明确计算机和人在其分析中的不同之处,可改善计算机与人在任务上的协作。

11.图1是用于识别目标的生理识别的重要部分与机器识别的重要部分之间的差异的示例系统100的框图。系统100可包括分析引擎110。如在此所使用的,术语“引擎”是指硬件(例如,模拟电路或数字电路、处理器(诸如,集成电路)或其他电路)或软件(例如,程序(诸如,机器可执行指令或处理器可执行指令)、命令或代码(诸如,固件代码、设备驱动器代码、程序代码、目标代码等))和硬件的组合。硬件包括没有软件要素的硬件要素,诸如,专用集成电路(asic)、现场可编程门阵列(fpga)等。硬件和软件的组合包括在硬件上托管的软件(例如,存储在处理器可读存储器(诸如,随机存取存储器(ram)、硬盘或固态驱动器、电阻式存储器或光学介质(诸如,数字通用盘(dvd)))上的软件模块和/或由处理器执行或解释的软件模块)或者硬件及在硬件上托管的软件。分析引擎110可检测目标的第一重要部分集合。例如,分析引擎110可对目标进行评估以确定目标的一部分是否满足被包括在第一重要部分集合中的条件。分析引擎110可基于该部分满足所述条件而将目标的该部分包括在第一重要部分集合中。

12.系统100还可包括事件引擎120。事件引擎120可检测生理信号中的潜在事件集合。如在此所使用的,术语“潜在事件”是指与表示大脑对刺激作出响应的生理响应相对应的生理信号的一部分的时间位置。例如,生理信号可以是脑电图(eeg)、功能性磁共振图像(fmri)、脉搏的测量、呼吸率的测量、皮肤电反应(gsr)的测量、瞳孔扩张的测量、面部表情的分析等。生理响应可以是事件相关电位(erp)(例如,能够在eeg或fmri中检测的p300或p3b erp);脉搏、呼吸率、皮肤电导率、瞳孔扩张等的增加;预定面部表情等。

13.在示例中,通过分析生理信号以确定该信号的值是否指示预定生理响应,事件引擎120可检测潜在事件。基于指示预定生理响应的值,事件引擎120可将潜在事件包括在潜在事件集合中。事件引擎120可基于潜在事件集合来识别目标的第二重要部分集合。例如,事件引擎120可确定目标的引发与潜在事件相对应的生理响应的部分。事件引擎120可将目标的引起生理响应的部分包括在第二重要部分集合中。

14.如在此所使用的,术语“目标”是指可由生物感测的环境或对象或者能够用于产生可由生物感测的输出的数据。目标可包括图像、三维场景、音频信号、触摸目标(例如,可通过触摸感测的环境或对象、能够用于产生触觉输出的数据等)、气味、味道、温度等。例如,目标可以是将由医生评估的医学图像、将由消防检查员或职业安全与健康管理局(osha)检查员、声纳技术人员评估的建筑物等。在一些示例中,分析引擎110可直接作用于目标(例如,当目标是存储在计算机可读介质等上的图像或音频信号时),或者可作用于由目标的传感

器测量产生的数据(例如,当目标是三维场景、有形图像、通过介质传播的声波等时)。类似地,产生生理信号的生物可直接感测目标或者可感测基于目标生成的输出。产生生理信号的生物可以是人、动物等。

15.系统100可包括比较引擎130。比较引擎130可识别第一重要部分集合与第二重要部分集合之间的差异。例如,比较引擎130可确定分析引擎110将目标的一部分识别为重要的但是目标的该部分没有在生物中产生生理响应。可选地或另外地,比较引擎130可确定目标的一部分引起生物中的生理响应,但是分析引擎110没有将该部分识别为重要的。

16.图2是用于识别目标的生理识别的重要部分与机器识别的重要部分之间的差异的另一示例系统200的框图。系统200可包括分析引擎210。分析引擎210可检测目标的第一重要部分集合。例如,分析引擎210可从诸如计算机可读介质的存储装置(未示出)接收目标,可接收由传感器(未示出)对目标的传感器测量产生的数据测量等。在示出的示例中,分析引擎210可从存储装置接收图像数据,从相机接收图像数据(例如,环境的图像数据或有形图像的图像数据)等。

17.分析引擎210可评估目标以确定目标的一部分是否满足被包括在第一重要部分集合中的条件。例如,分析引擎210可使用计算机视觉技术来检测目标的重要部分。在示例中,分析引擎210可使用机器学习模型来评估目标以检测目标的重要部分。例如,机器学习模型可已经被训练以使用数据集来检测目标的重要部分,所述数据集包括:包括重要部分的目标和不包括重要部分的目标。在一些示例中,分析引擎210可确定指示特定部分重要的可能性的软输出(例如,概率)。分析引擎210可包括与满足第一重要部分集合中的特定阈值的软输出相对应的部分。例如,分析引擎210可存储目标的被确定为重要的部分的指示(例如,位置的表示)。

18.系统200可包括输入引擎205。输入引擎205可测量生理信号。例如,输入引擎205可通信地连接到生理传感器202,生理传感器202基于用户(例如,生物)的生理响应的测量来生成生理信号。输入引擎205还可测量用户的眼睛跟踪数据。例如,输入引擎205可通信地连接到眼睛跟踪传感器204,并且可从眼睛跟踪传感器204接收眼睛跟踪数据。在示例中,眼睛跟踪传感器204可向输入引擎205提供图像,并且输入引擎205可根据图像确定眼睛跟踪数据。输入引擎205还可通信地连接到用户输入接口206以接收用户输入。输入引擎205可基于用户提供指示重要部分的输入来接收一组用户指示的重要部分。用户输入接口206可包括键盘、鼠标、触摸屏、相机、麦克风等。

19.系统200可包括通信地连接到输入引擎205的事件引擎220。事件引擎220可从输入引擎205接收生理信号,并且可检测生理信号中的潜在事件集合。例如,事件引擎220可确定生理信号的一部分是否满足标准(例如,是否满足阈值、是否在预定时间段内满足阈值、是否与满足阈值的预定信号具有相关性等)。事件引擎220可选择生理信号的满足标准的部分的每个位置作为潜在事件。例如,事件引擎220可存储生理信号的满足标准的部分的位置的指示。

20.事件引擎220可基于潜在事件集合来识别目标的第二重要部分集合。例如,事件引擎220可将眼睛跟踪数据与潜在事件集合进行比较,以识别第二重要部分集合。眼睛跟踪数据可包括在各个时间点观察到目标的哪个部分。因此,事件引擎220可确定目标的作为潜在事件的刺激的部分。事件引擎220可补偿刺激与生理响应之间的延迟,以根据潜在事件确定

刺激的时间。事件引擎220可将刺激的时间与眼睛跟踪数据进行比较,以识别目标的作为刺激的部分。事件引擎220可将目标的被识别到的部分包括在目标的第二重要部分集合中。例如,事件引擎220可存储目标的被识别到的部分的指示(例如,位置的表示)。

21.尽管在示出的示例中系统200包括眼睛跟踪传感器204(其可涉及视觉目标),但是针对其它类型的目标,可使用其它传感器。例如,对于触摸目标,系统200可包括用于跟踪用户对触摸目标进行触摸的部分的传感器。在一些示例中,目标可随时间变化,但是用户在感测目标时可能不会主动改变他们的感觉器官。事件引擎220可在没有用户的感觉器官的状态下基于每次感测到目标的哪个部分来识别目标的作为刺激的部分。

22.系统200可包括比较引擎230。比较引擎230可识别第一重要部分集合与第二重要部分集合之间的差异。该差异可以是被包括在第一集合中但不被包括在第二集合中的部分,或者可以是被包括在第二集合中但不被包括在第一集合中的部分。在一些示例中,第一集合或第二集合可以是空集。例如,分析引擎210和事件引擎220中的一个可能已经将目标的一部分识别为重要的,但是另一个可能没有将目标的任何部分识别为重要的。系统200还可包括输出引擎240,以生成第一重要部分集合和第二重要部分集合之间的差异的指示,并使该指示被提供给用户。例如,输出引擎240可提供差异的视觉指示、听觉指示或类似的指示。例如,输出引擎240可将差异的指示叠加在目标或目标的副本上。在示例中,比较引擎230或输出引擎240可存储差异的指示,而不向用户提供所述指示。

23.比较引擎230或输出引擎240可识别各种类型的差异,并且可有区别地处理它们。分析引擎210可能已经将目标的一部分识别为重要的,但是事件引擎220可能没有将目标的该部分识别为重要的。例如,用户可能没有观察到目标的该部分,或者用户可能已经观察到目标的该部分而没有意识到其重要性(通过缺乏生理响应来证明)。因此,输出引擎240可向用户指示目标的这些部分,从而用户可进一步分析它们(例如,使用第一指示)。在一些示例中,输出引擎240可根据用户是没有观察到目标的部分还是观察到目标的部分但没有生理响应来提供不同的指示。

24.可选地或另外地,事件引擎220可能已经将目标的一部分识别为重要的,但是分析引擎210可能没有将目标的该部分识别为重要的。例如,用户对目标的一部分的反应可能是假阳性,或者分析引擎210未能意识到目标的重要性并因此可能服从进行更新。输出引擎240可向用户指示这些部分以供进一步分析(例如,确定为什么出现不一致)(例如,使用第二指示)。

25.比较引擎230还可将用户指示的重要部分的集合与第一重要部分集合或第二重要部分集合进行比较。例如,事件引擎220可能已经将目标的一部分识别为重要的,但是分析引擎210和用户可能都没有指示目标的该部分是重要的。因此,可能没有理由向用户指示差异,原因在于,不管用户的初始反应如何,用户有意识地决定不将目标的部分识别为重要的。输出引擎240可以不向用户指示差异,可提供差异的不太明显的指示(例如,使用第三指示),可向用户提供是否接收这种差异的指示的选项等。

26.在示例中,事件引擎220和分析引擎210可能已经将目标的部分识别为重要的,但是用户可能没有指示目标的该部分是重要的。同样,可能没有理由向用户指示差异。不管用户的初始反应如何,用户再次有意识地决定不将该部分识别为重要的,因此分析引擎210的决定(如果被呈现的话)可能对用户的决定几乎没有影响。输出引擎240可以不向用户指示

差异,可提供差异的不太明显的指示(例如,使用第四指示),可向用户提供是否接收这种差异的指示的选项等。

27.比较引擎230或输出引擎240还可使用来自分析引擎210的软输出,以向用户提供识别差异时的附加细微差别或指示中的附加细节。例如,在分析引擎210和事件引擎220将目标的一部分识别为重要的但用户没有将目标的该部分识别为重要的情况下,比较引擎230可确定软输出与阈值的接近程度或者可修改阈值。基于软输出在阈值的特定距离内或满足修改后的阈值,输出引擎240可以不指示差异,或者可使用不同的或不太明显的指示。类似地,在用户将一部分识别为重要的但分析引擎210没有将该部分识别为重要的情况下,比较引擎230可确定软输出与阈值的接近程度或者可修改阈值。基于软输出在阈值的特定距离内或满足修改后的阈值,输出引擎240可以不指示差异,或者可使用不同的或不太明显的指示。

28.在示例中,事件引擎220可将目标的一部分识别为重要的,但是分析引擎210和用户可以不将目标的该部分识别为重要的。比较引擎230可确定软输出与阈值的接近程度或者可修改阈值。输出引擎240可基于软输出在阈值的特定距离内或满足修改后的阈值来指示差异(例如,使用具有有限明显性的指示)。在一些示例中,用户可指示用户不确定重要性或者应该执行附加的调查或测试。比较引擎230可确定软输出是否在特定范围内。输出引擎240可向用户指示软输出是否在范围之外,该范围可指示分析引擎210确信目标的该部分是重要的或者确信目标的该部分不重要。在一些示例中,输出引擎240可指示针对目标的一部分的软输出在指示不确定性的范围内,例如,当事件引擎220没有将目标的该部分识别为重要的时,当事件引擎220将目标的该部分识别为重要的但用户没有将目标的该部分识别为重要的时,当用户将目标的该部分识别为重要的时等。

29.比较引擎230可确定目标的一部分被用户和分析引擎210两者识别为重要的。在这种情况下,比较引擎230可通过自动准备注释来提高用户生产力,该注释描述识别实际重要的部分的原因。例如,比较引擎230可基于在分析引擎210的机器学习模型中哪些神经元被最强地激活来确定目标的该部分重要的原因,或者比较引擎230可包括附加的机器学习模型以基于目标的该部分来确定重要的原因。

30.在一些示例中,输出引擎240可基本上实时地向用户指示差异。例如,输入引擎205或事件引擎220可确定用户何时观察到目标的由分析引擎210识别为重要的部分。响应于事件引擎220响应于用户观察到目标的该部分而没有检测到潜在事件,输出引擎240可基本上实时地指示差异。输入引擎205或事件引擎220可使输出引擎240基于用户将观察移动到目标的新部分、基于超过时间阈值等来指示差异。在示例中,响应于用户指示目标的未被分析引擎210识别的重要部分,输出引擎240可基本上实时地指示差异。如在此所使用的,术语“基本上实时地”是指:指示直接响应于用户动作或未发生潜在事件而被提供,但可能由于对用户动作或未发生潜在事件进行检测所花费的时间或者由于处理延迟而延迟。

31.分析引擎210可基于由比较引擎230识别的差异来更新机器学习模型。在示例中,输出引擎240可向用户指示目标的第一重要部分集合、目标的第二重要部分集合或目标的用户指示的重要部分的集合之间的任何先前论述的类型的差异。用户可向用户输入接口206提供附加输入,并且输入引擎205可识别目标的用户指示的重要部分的修改集合。分析引擎210可基于经用户指示的重要部分的修改集合来更新机器学习模型。例如,分析引擎

210可使用用户指示的重要部分的修改集合作为机器学习模型的附加训练数据。在一些示例中,分析引擎210可使用目标的用户指示的重要部分的原始集合中的一些或全部来更新机器学习模型。

32.因此,系统200可在执行任务时增强用户与分析引擎210之间的协作。系统200避免提供可能妨碍用户表现的信息,同时仍然向用户提供分析引擎210的益处。系统200还避免不必要地识别分析引擎210与用户之间的差异,或者对用户可能不太重要的差异使用不太明显的指示。另外,通过使用若干类型的指示或软输出,系统200可提供与分析引擎210和用户之间的差异有关的附加细节和细微差别。因此,系统200可提供用户与分析引擎210之间的更有效的协作。

33.图3是用于识别目标的生理识别的重要部分、机器识别的重要部分以及用户指示的重要部分之间的差异的示例方法300的流程图。处理器可执行方法300的要素。在框302处,方法300可包括检测目标的机器识别的重要部分的集合。例如,处理器可对目标进行分析以确定目标的重要部分。

34.框304可包括测量来自用户的生理信号。测量生理信号可包括测量先前论述的生理信号中的任何生理信号。框306可包括检测生理信号中的潜在事件集合。检测生理信号中的潜在事件集合可包括确定生理信号的与指示大脑对刺激做出响应的生理响应相对应的部分的时间位置。在框308处,方法300可包括:基于潜在事件来识别目标的对用户潜在重要的部分的集合。例如,识别目标的潜在重要的部分可包括识别目标的引起与潜在事件相对应的生理响应的部分(因为用户正在观察目标的该部分)。

35.在框310处,方法300可包括:基于来自用户的输入来识别目标的对用户实际重要的部分的集合。用户可经由向用户呈现目标或目标的表示的用户界面来选择目标的对用户重要的部分。所选择的部分可被包括在目标的对用户实际重要的部分的集合中。

36.框312可包括:向用户指示潜在重要的部分的集合与机器识别的重要部分的集合之间的第一差异以及实际重要的部分的集合与机器识别的重要部分的集合之间的第二差异。例如,第一差异可以是目标的被包括在潜在重要的部分的集合中并且不被包括在机器识别的重要部分的集合中的一部分,或者可以是目标的被包括在机器识别的重要部分的集合中并且不被包括在潜在重要的部分的集合中的一部分。类似地,第二差异可以是目标的被包括在实际重要的部分的集合中并且不被包括在机器识别的重要部分的集合中的一部分,或者可以是目标的被包括在机器识别的重要部分的集合中并且不被包括在实际重要的部分的集合中的一部分。参照图2,在示例中,分析引擎210可执行框302,输入引擎205可执行框304或框310,事件引擎220可执行框306或框308,并且输出引擎240可执行框312。

37.图4是用于识别目标的生理识别的重要部分、机器识别的重要部分以及用户指示的重要部分之间的差异的另一示例方法400的流程图。处理器可执行方法400的要素。在框402处,该方法可包括检测目标的机器识别的重要部分的集合。例如,可使用机器学习模型来检测目标的重要部分。在示例中,可通过机器学习模型分析图像或三维场景的区域以识别哪些区域是重要的。

38.框404可包括测量来自用户的生理信号。例如,传感器可将生理信号生成为基于用户的生理特性而变化的数字电信号或模拟电信号。测量生理信号可包括从传感器读取生理信号的值。框406可包括检测生理信号中的潜在事件集合。例如,检测潜在事件可包括确定

生理信号满足阈值、在预定时间段内满足阈值等。检测潜在事件可包括:将测量的生理信号与已知事件的生理信号进行比较(例如,使用相关函数),并且确定测量的生理信号是否与已知事件的生理信号足够相似(例如,相关函数的输出是否满足阈值)。

39.在框408处,方法400可包括测量用户注视的方向。例如,可测量用户的眼睛或瞳孔的取向以确定用户正在看的方向。测量用户注视的方向可包括确定目标(例如,目标的一部分)上用户将其注视指向的位置。测量用户注视的方向可包括存储眼睛跟踪数据。眼睛跟踪数据可包括目标上的用户将其注视指向的位置的指示,并且可包括用户注视每个指示位置的时间。

40.框410可包括:基于潜在事件识别目标的对用户潜在重要的部分的集合。可将潜在事件与眼睛跟踪数据进行比较,以确定目标的哪些部分对应于潜在事件。例如,潜在事件的时间位置可与眼睛跟踪数据中的时间匹配,以便在眼睛跟踪数据中确定目标上的对应位置。目标上的所确定的位置可被包括在潜在重要的部分的集合中(例如,通过存储所确定的位置的指示)。将潜在事件的时间与眼睛跟踪数据中的时间匹配可包括调节刺激与生理响应之间的延迟。例如,延迟可以是针对特定生理信号或生理响应的预定偏移。

41.在框412处,方法400可包括:基于来自用户的输入来识别目标的对用户实际重要的部分的集合。在示例中,目标可以是(例如,经由显示器、增强现实头戴式装置或虚拟现实头戴式装置等)显示给用户的图像或场景,并且用户可(例如,使用鼠标、触摸屏、虚拟现实控制器等)选择图像或场景上的位置。例如,通过存储所选择的位置的指示,可将所选择的位置作为目标的一部分包括在实际重要的部分的集合中。

42.在框414处,方法400可包括:提供机器识别的重要部分的集合中的未被用户观察到的一个机器识别的重要部分的第一指示。例如,可将目标的机器识别的重要部分的集合与目标的由用户观察到的部分进行比较,以确定目标的未被用户观察到但在框402处被识别为重要的部分。在示例中,可将目标的被机器学习模型识别为重要的每个部分与眼睛跟踪数据进行比较。可向用户显示未被包括在眼睛跟踪数据中的任何地方但被机器学习模型识别为重要的位置。

43.框416可包括:提供机器识别的重要部分的集合中的另一个机器识别的重要部分的第二指示,所述另一个机器识别的重要部分被用户观察到但未被识别为潜在重要的部分集合中的一个潜在重要的部分。例如,可将在框410处识别的潜在重要的部分的集合与在框402处识别的机器识别的重要部分的集合进行比较,以确定不被包括在潜在重要的部分的集合中的机器识别的重要部分。可基于确定机器识别的重要部分未被包括在潜在重要的部分的集合中而提供第二指示。在示例中,可确定该机器识别的重要部分是否被包括在眼睛跟踪数据中,例如,以确定要提供哪种类型的指示。

44.在示例中,可基本上实时地提供第二指示。例如,可确定用户正在观察目标的被包括在机器识别的重要部分的集合中的部分。基于未检测到潜在事件,可提供第二指示。可基于经过了预定的时间量、基于用户变为观察目标的新部分等来确定尚未检测到目标的该部分。

45.在示例中,可以不实时地提供第一指示。例如,一旦用户已经完成观察目标,则可确定目标的眼睛跟踪数据是否包括目标的在机器识别的重要部分的集合中的每个部分。在一些示例中,可使用不同的阈值来确定将包括以下集合中的部分:用于确定第一指示的机

器识别的重要部分的集合以及用于确定第二指示的集合中的部分。在示例中,与用于定义用于确定第一指示的机器识别的重要部分的集合相比,可使用更高的阈值来定义用于确定第二指示的机器识别的重要部分的集合。与目标的根本未被观察到的部分相比,目标的被观察到但未引起生理响应的部分可能不太可能是重要的。

46.在框418处,方法400可包括:指示被包括在实际重要的部分的集合中而未被包括在机器识别的重要部分的集合中的部分(例如,提供第三指示)。例如,如果该部分被包括在被用户识别为实际重要的部分的集合中但未被包括在机器识别的重要部分集合中,则该部分可能是误报。在示例中,可基本上实时地提供指示。可响应于用户输入指示该部分实际上是重要的而提供指示。响应于用户指示该部分,可将所指示的部分与被包括在机器识别的重要部分的集合中的部分进行比较,以确定在该集合中是否存在对应的部分。如果没有找到对应的部分,则可提供指示。在示例中,图2的分析引擎210可执行框402,输入引擎205可执行框404、框408或框412,事件引擎220可执行框406或框410,并且比较引擎230或输出引擎240可执行框414、框416或框418。

47.图5是包括指令的示例计算机可读介质500的框图,所述指令在由处理器502执行时使处理器502识别目标的生理识别的重要部分与机器识别的重要部分之间的差异。计算机可读介质500可以是非暂时性计算机可读介质,诸如,易失性计算机可读介质(例如,易失性ram、处理器高速缓存、处理器寄存器等)、非易失性计算机可读介质(例如,磁存储装置、光存储装置、纸存储装置、闪存、只读存储器、非易失性ram等)等。处理器502可以是通用处理器或专用逻辑,诸如,微处理器(例如,中央处理单元、图形处理单元等)、数字信号处理器、微控制器、asic、fpga、可编程阵列逻辑(pal)、可编程逻辑阵列(pla)、可编程逻辑器件(pld)等。

48.计算机可读介质500可包括事件模块510。如在此所使用的,“模块”(在一些示例中被称为“软件模块”)是当由处理器执行或解释或者被存储在处理器可读介质上时实现组件或者执行方法的指令集合。事件模块510可包括指令,所述指令在被执行时使处理器502基于眼睛跟踪数据和生理信号来确定目标的对用户潜在重要的部分的集合。例如,事件模块510可使处理器502执行以下操作:基于生理信号来确定目标的当前被观察的部分是否是潜在重要的,并且基于眼睛跟踪数据来确定目标的哪个部分当前被观察并因此是潜在重要的。

49.计算机可读介质500可包括分析模块520。分析模块520可使处理器502检测目标的机器识别的重要部分的集合。例如,分析模块520可使处理器502评估目标的一部分以确定该部分是否满足使其有资格重要的条件。基于该部分满足条件,分析模块520可使处理器502将该部分包括在机器识别的重要部分的集合中。

50.计算机可读介质500可包括比较模块530。比较模块530可使处理器502识别潜在重要的部分的集合与机器识别的重要部分的集合之间的差异。例如,比较模块530可使处理器502确定目标的被包括在潜在重要的部分的集合和机器识别的重要部分的集合中的一个中而不被包括在潜在重要的部分的集合和机器识别的重要部分的集合中的另一个中的部分。在示例中,当被处理器502执行时,事件模块510可实现图1的事件引擎120,分析模块520可实现分析引擎110,或者比较模块530可实现比较引擎130。

51.图6是包括指令的另一示例计算机可读介质600的框图,所述指令在被处理器602

执行时使处理器602识别目标的生理识别的重要部分与机器识别的重要部分之间的差异。计算机可读介质600可包括事件模块610。事件模块610在被处理器602执行时可使处理器602基于眼睛跟踪数据和生理信号来确定目标的对用户潜在重要的部分的集合。事件模块610可使处理器602确定生理信号的值何时与生理响应一致。事件模块610可使处理器602基于眼睛跟踪数据来确定在生理响应之前目标的哪个部分接收用户的注视,并且因此确定目标的哪个部分引起生理响应。

52.计算机可读介质600可包括分析模块620。分析模块620可使处理器602检测目标的机器识别的重要部分的集合。例如,分析模块620可包括机器学习模型622。分析模块620可利用机器学习模型622来检测机器识别的重要部分的集合。机器学习模型622可能已经被训练,以基于包括目标的重要部分和非重要部分的数据集来区分目标的重要部分与目标的非重要部分。

53.计算机可读介质600可包括比较模块630。比较模块630可使处理器602识别潜在重要的部分的集合与机器识别的重要部分的集合之间的差异。计算机可读介质600可包括用户输入模块640。用户输入模块640可使处理器602基于来自用户的输入来识别对用户实际重要的部分的集合。例如,用户输入模块640可使处理器602接收包括目标的重要部分的指示的用户输入。比较模块630可使处理器602在潜在重要的部分的集合、机器识别的重要部分的集合和实际重要的部分的集合中的任何一对或全部之间执行双向或三向比较,以识别被包括在被比较的集合中的部分的差异。

54.分析模块620可包括训练模块624。训练模块624可使处理器602更新机器学习模型622。在示例中,比较模块630可使处理器602向用户指示潜在重要的部分的集合与机器识别的重要部分的集合之间的差异。用户输入模块640可使处理器602基于来自用户的附加输入来识别改进的对用户实际重要的部分的集合。例如,用户输入模块640可使处理器602接收指示目标的应向实际重要的部分的集合添加或者从实际重要的部分的集合移除的部分的输入。训练模块624可使处理器602基于修改的实际重要的部分的集合来更新机器学习模型622。例如,修改的实际重要的部分的集合或未被包括在修改的实际重要的部分的集合中的部分可用作机器学习模型622的训练数据。在示例中,未被修改的实际重要的部分的集合或未被包括在未被修改的实际重要的部分的集合中的部分可用作机器学习模型622的训练数据。

55.计算机可读介质600可包括注释模块650。比较模块630可使处理器602识别目标的对用户实际重要的部分,目标的对用户实际重要的部分与机器识别的重要部分的集合中的一个机器识别的重要部分相匹配。例如,比较模块630可使处理器602识别目标的被包括在实际重要的部分的集合和机器识别的重要部分的集合两者中的部分。注释模块650可使处理器602准备描述实际重要的部分被识别的原因的注释。例如,机器学习模型622可包括机器学习模型622的输出中的原因的指示(例如,若干输出节点中的哪一个被激活),或者注释模块650可使处理器602分析目标的被识别的部分或者机器学习模型622的计算(例如,神经元激活)以确定原因。注释模块650可使处理器602识别与所识别的原因相对应的文本,或者基于目标的部分的特性来准备文本。

56.比较模块630可使处理器602基于针对实际重要的部分确定的机器识别的重要性概率来确定是否向用户指示未被包括在机器识别的重要部分的集合中的对用户实际重要

的部分。例如,分析模块620可包括阈值处理模块626。阈值处理模块626可包括用于各种情况的阈值,或者使处理器602基于各种情况来确定对阈值的修改。在示例中,与当与实际重要的部分的集合进行比较时相比,当与潜在重要的部分的集合进行比较时,可使用不同的阈值来定义机器识别的重要部分的集合。当确定将被包括在机器识别的重要部分的集合中的部分时,阈值处理模块626可使处理器602确定哪个阈值应作为机器学习模型622的软输出的比较点(例如,机器识别的重要性概率)。与将机器识别的重要部分的集合与实际重要的部分的集合进行比较时相比,当将机器识别的重要部分的集合与潜在重要的部分的集合进行比较时,可使用更高的阈值,反之亦然。参照图2,在示例中,当被处理器602执行时,事件模块610可实现事件引擎220,分析模块620、训练模块624或阈值处理模块626可实现分析引擎210,比较模块630或注释模块650可实现比较引擎230或输出引擎240,或者用户输入模块640可实现输入引擎205。

57.以上描述说明了本公开的各种原理和实现方式。预见了对在此描述的示例的多种变型和修改。因此,本技术的范围应仅由所附权利要求书确定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。