技术特征:

1.一种神经网络改进循环变化学习率的方法,其特征在于,具体按照如下步骤实施:s1: 搭建tensorflow或者pytorch框架,进行神经网络框架的搭建,其中神经网络包括输入层、隐藏层、全链接层和输出层;s2: 建立bsgd梯度下降框架,并且设定权值和阈值,其中bsgd梯度下降的公式为:,其中为学习率,随后模型估算神经网络允许的最小学习率和最大学习率;s3:设定阈值最小初始学习率,随后不断进行batch操作,然后在每个batch之后都进行模型网络的更新,然后同比增加学习率;s4:统计每个batch操作计算出的损失值,随后进行描绘学习的变化曲线和损失值变化曲线,从中计算出batch操作中的最优学习率;s5:经过一定量的batch操作训练后,使用热重启的方式将学习率初始化为某个值,然后逐渐减少,此学习率设定为s4步骤中的最优学习率;s6:重复迭代至损失值趋于稳定。2.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:针对步骤s1:所述全链接层和所述输出层之间的损失函数为srelu损失函数,其中srelu的非线性公式为:,其中为srelu对训练模型进行参数化得到的输出平均值,表示x对应的概率值,表示正区间数值,表示负区间数值。3.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:针对步骤s2:其中bsgd梯度下降算法包含bgd算法和sgd算法,在进行梯度下降时随机采样n个样本进行迭代训练,然后进行重复训练,其中迭代公式为:,其中为所述步骤s1中的隐藏层阈值。4.如权利要求3所述的一种神经网络改进循环变化学习率的方法,其特征在于:所述的bsgd梯度下降中n个样本采样为热重启训练策略,将网络跳出局部,其中n在合理的边界之间循环变化。5.如权利要求3的所述的一种神经网络改进循环变化学习率的方法,其特征在于:所述的bsgd梯度下降输出的梯度值均暂存在存储器中,随后进行平均值计算,然后更新变量给输入层。6.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:针对步骤s3:所述s3步骤中的batch操作为定义在更新内部模型参数之前要处理的样本数,然后对循环迭代一个或多个样本并进行预测,每个batch操作之间进行预测与预期输出变量进行比较,并计算误差,并且将信号返回所述s1步骤中的输入层,随后再次更新权值。7.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:所述步骤5中的热重启之前会在网络训练的时候设定一个重启周期,当达到这个重启的周期的时

候热重启进行启动,随后初始化学习率同时模型使用上一次热重启的参数作为初始化。8.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:针对步骤s5:每次热重启时学习率初始化为某个值,然后逐渐减少,所述热重启可以随时进行。9.如权利要求7所述的一种神经网络改进循环变化学习率的方法,其特征在于:所述热重启之后,用一个高的初始学习率从根本上把参数从先前的收敛到的最小值弹射到损失函数曲面的不同区域。10.如权利要求1所述的一种神经网络改进循环变化学习率的方法,其特征在于:针对步骤s6:训练模型趋于稳定后,继续使用所述热重启初始化学习率。

技术总结

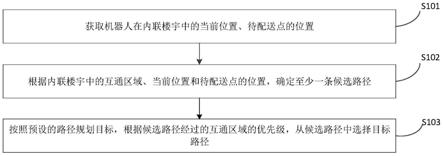

本发明属于深度学习领域,具体为一种神经网络改进循环变化学习率的方法,包括以下步骤:搭建Tensorflow或者Pytorch框架,建立BSGD梯度下降框架,并且设定权值和阈值,随后模型估算神经网络允许的最小学习率和最大学习率,设定阈值最小初始学习率,随后不断进行batch操作,然后在每个batch之后都进行模型网络的更新,然后同比增加学习率,统计每个batch操作计算出的损失值,从中计算出batch操作中的最优学习率,经过一定量的batch操作训练后,使用热重启的方式将学习率初始化为某个值,然后逐渐减少,最后重复迭代至损失值趋于稳定,本发明用热重启方式来替代学习率退火制度,这种重启可以随时进行,这样加快了学习的所需时间。间。间。

技术研发人员:董琴 王昕 黄乾峰 陈瑾 姜碧怡 范浩楠 史鸣凤

受保护的技术使用者:云火科技(盐城)有限公司

技术研发日:2021.10.15

技术公布日:2021/12/16

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。