1.本公开涉及计算机视觉技术领域,尤其涉及一种数据处理方法和装置。

背景技术:

2.随着科学技术的发展,视频安防替代人力工作成为工业主流。视频安防领域大多利用基于图像分割的异常行为的检测方法,异常行为如:异常人员的闯入、摔倒、打架、抢劫、快跑等。但是在进行模型训练时,一些异常行为的样本获取十分困难,而缺少这些异常行为的样本会导致模型训练数据不均衡,最终造成模型分类结果不准确。

3.相关技术中,为了获取应用场景的异常行为样本,甚至需要人员前往现场环境进行采样模拟,这样非常耗费人力物力。

4.因此,亟需一种数据处理方法,能够自动的获取异常行为样本,从而得到更准确的检测异常行为的模型。

技术实现要素:

5.为克服相关技术中存在的至少一个问题,本公开提供一种数据处理方法和装置。

6.根据本公开实施例的第一方面,提供一种数据处理方法,包括:

7.获取至少包括异常行为的目标对象的标定框数据和掩膜数据;

8.根据所述标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹;

9.根据所述掩膜数据,从带有所述运动轨迹视频数据中获取所述目标对象的前景图像;

10.将所述前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据。

11.在一种可能的实现方式中,所述根据所述标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹,包括:

12.获取所述标定框数据的置信度信息;

13.根据所述置信度信息,对所述标定框数据进行分类,得到不同精度类别的标定框数据;

14.利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹。

15.在一种可能的实现方式中,所述利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹,包括:

16.获取第一标定框数据和第二标定框数据,其中,所述第一标定框数据的精度大于第二标定框数据的精度;

17.利用所述第一标定框数据中历史帧标定框的标识信息以及所述第二标定框数据,确定所述第一标定框数据中当前帧标定框的标识信息;

18.获取同一标识信息的第二标定框数据,作为与所述标识信息相对应的目标对象的

运动轨迹。

19.在一种可能的实现方式中,所述利用所述第一标定框数据中历史帧标定框的标识信息以及所述第二标定框数据,确定当前帧标定框的标识信息,包括:

20.利用所述第一标定框数据中历史帧标定框的标识信息,确定所述第一标定框数据中当前帧中所有标定框的标识信息;

21.在所述当前帧的标定框中不存在与历史帧的标定框相匹配的情况下,从所述第二标定框数据中确定与所述历史帧的标定框相匹配的标定框;

22.将所述历史帧标定框的标识信息设置到所述相匹配的标定框的标识信息,将设置完标识信息后的所述相匹配的标定框补充到对应帧中。

23.在一种可能的实现方式中,两标定框相匹配的条件被设置为两标定框中目标对象的重合度大于预设值。

24.在一种可能的实现方式中,所述将所述前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据,包括:

25.对所述前景图像进行几何变换,得到多种前景图像;

26.将所述前景图像和所述多种前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据。

27.在一种可能的实现方式中,所述获取至少包括有异常行为的目标对象的标定框数据和掩膜数据,包括:

28.获取至少包括异常行为的目标对象的视频数据;

29.将所述视频数据输入至图像分割模型,经所述图像分割模型,输出所述目标对象的标定框数据和掩膜数据,其中,所述图像分割模型被设置为利用样本视频数据与样本目标对象的标定框、掩膜的对应关系训练获得。

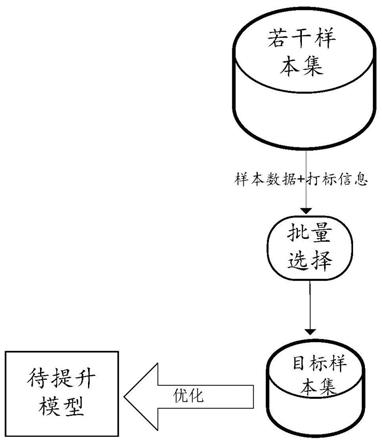

30.在一种可能的实现方式中,所述图像分割模型被设置为利用样本视频数据与样本目标对象的标定框、掩膜的对应关系训练获得,包括:

31.获取目标对象的视频数据的样本集合,所述样本集合中包括多个在目标对象上标注标定框和掩膜的图像数据,

32.构建图像分割模型,所述图像分割模型中设置有训练参数;

33.将所述目标对象的视频数据输入至所述图像分割模型,生成预测结果;

34.基于所述预测结果与标注的标定框和掩膜之间的差异,对所述训练参数进行迭代调整,直至所述差异满足预设要求。

35.在一种可能的实现方式中,所述将所述目标对象的视频数据输入至所述图像分割模型,生成预测结果,包括:

36.获取图像尺寸大于预设值的目标对象的视频数据;

37.对所述视频数据进行下采样,得到多个尺寸缩小的视频数据;

38.将所述视频数据输入至所述图像分割模型,生成预测结果。

39.根据本公开实施例的第二方面,提供一种检测目标对象异常行为的方法,包括:

40.获取视频数据;

41.将所述视频数据输入至异常行为检测模型,经所述异常行为检测模型,输出所述视频数据中有异常行为的目标对象,其中,所述异常行为检测模型被利用权利要求1至9中

任一项所述的数据处理方法得到的样本视频数据与标注异常行为的目标对象之间的对应关系训练获得。

42.根据本公开实施例的第三方面,提供一种数据处理装置,包括:

43.处理器;

44.用于存储处理器可执行指令的存储器;

45.其中,所述处理器被配置为执行权利根据本公开实施例任一项所述的方法。

46.根据本公开实施例的第四方面,提供一种非临时性计算机可读存储介质,当所述存储介质中的指令由处理器执行时,使得处理器能够执行根据本公开实施例中任一项所述的方法。

47.本公开的实施例提供的技术方案可以包括以下有益效果:本公开实施例中,通过获取至少包括异常行为的目标对象的标定框数据和掩膜数据,利用获取到的标定框数据和掩膜数据确定目标对象的前景图像的运动轨迹,再将前景图像插入新的应用场景的图像中可以得到新的视频图像,并确保新的视频图像包含有异常行为的目标对象。相较于传统的人工模拟或搜集相关场景的视频,本公开实施例能够高效准确的获得大量的带有异常行为目标对象的视频数据。

48.应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

附图说明

49.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本公开的实施例,并与说明书一起用于解释本公开的原理。

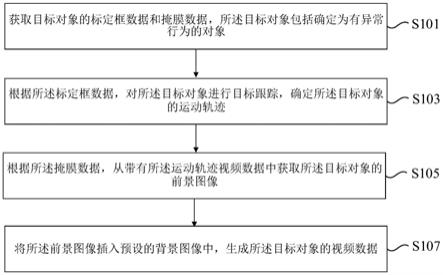

50.图1是根据一示例性实施例示出的一种数据处理方法的流程图。

51.图2是根据一示例性实施例示出的fpn结构的示意图。

52.图3是根据一示例性实施例示出的protonet结构的示意图。

53.图4是根据一示例性实施例示出的focus结构的示意图。

54.图5是根据一示例性实施例示出的一种数据处理方法的流程图。

55.图6是根据一示例性实施例示出的一种数据处理装置的示意框图。

56.图7是根据一示例性实施例示出的一种数据处理装置的示意框图。

具体实施方式

57.这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本公开相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本公开的一些方面相一致的装置和方法的例子。

58.为了方便本领域技术人员理解本公开实施例提供的技术方案,下面先对技术方案实现的技术环境进行说明。

59.相关技术中,对带有异常行为的样本视频数据的获取依赖于人工模拟。例如,检测异常行为的模型应用在a城市,获取a城市的视频数据比较容易,但获取a城市的带有异常行为的目标对象的视频数据就非常困难。一种可能的方法是需要人员前往a城市进行模拟异

常行为,以获得相应的模型训练样本。该方案耗费人力物力,且视频样本难以通过如图片编辑的方式进行编辑。由于缺少异常行为的训练样本,导致正常行为和异常行为的样本分布不均衡,导致检测异常行为的模型精度不够高,模型对各场景的泛化能力不够好。

60.基于类似于上文所述的实际技术需求,亟需一种数据处理方法,能够自动的获取异常行为样本,从而得到更准确的检测异常行为的模型。

61.图6是根据一示例性实施例示出的一种数据处理方法的流程图。参考图6所示,首先获取包括有异常行为的视频数据,所述视频数据可以是前景视频。对该视频数据进行处理,得到目标对象的掩码(掩膜),对多张图像进行上述处理,可以得到目标对象的运动轨迹,对所述运动轨迹进行平移、旋转和缩放等几何变换,将目标对象的掩膜坐标映射到背景视频中,生成新的应用场景的视频数据。本公开实施例可以根据需要更换异常行为所发生的背景环境;可以根据需要对异常行为在新背景环境中发生的像素位置、角度、像素区域大小进行编辑;还可以在一个新背景环境中插入多个人的异常行为模板进行包含多种异常行为的样本生成。

62.下面结合附图1对本公开所述的数据处理方法进行详细的说明。图1是本公开提供的数据处理方法的一种实施例的方法流程图。虽然本公开提供了如下述实施例或附图所示的方法操作步骤,但基于常规或者无需创造性的劳动在所述方法中可以包括更多或者更少的操作步骤。在逻辑性上不存在必要因果关系的步骤中,这些步骤的执行顺序不限于本公开实施例提供的执行顺序。

63.具体的,本公开提供的数据处理方法一种实施例如图1所示,所述方法可以应用于终端或服务器,包括:

64.步骤s101,获取目标对象的标定框数据和掩膜数据,所述目标对象包括确定为有异常行为的对象。

65.本公开实施例中,所述目标对象可以包括图像中的人物,所述异常行为可以包括异常人员的闯入、摔倒、打架、抢劫、快跑等。所述至少包括异常行为的目标对象可以包括:仅有异常行为的目标对象、有异常行为的目标对象和没有异常行为的目标对象。本公开实施例中,所述目标对象的标定框数据包括以预设图形标注出的视频数据,所述预设图形如矩形、圆形、或与目标对象相同的形状等。所述目标对象的掩膜数据包括与目标对象的形状相同的图形,该图形的像素值为1,图像其余像素值为0。目标对象的掩膜用于与视频数据相乘,得到视频数据中的目标对象,并且视频数据中除所述目标对象外,其余图像值为0。本公开实施例中,获取目标对象的标定框数据的方法可以包括基于目标检测的算法,例如基于候选框的r

‑

cnn系算法:r

‑

cnn,fast r

‑

cnn,faster r

‑

cnn等,或仅用一个卷积神经网络cnn直接预测不同目标的类别与位置。本公开实施例中,获取目标对象的掩膜数据的方法可以包括基于图像分割的算法,确定目标对象的掩膜。在一个示例中,可以分别利用目标检测模型和掩膜模型获取目标对象的标定框数据和掩膜数据,也可以利用同一个模型,例如yolact算法,在输入包括有目标对象的视频数据后,同时得到目标对象的标定框数据和掩膜数据。在另一个示例中,可以对yolact算法进行改进,如在输入层和第一个卷积层件插入focus结构,达到推理提速的作用。

66.步骤s102,根据所述标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹。

67.本公开实施例中,所述目标对象的运动轨迹包括按照时间的先后顺序,依次出现的连续多张包含该目标对象的视频图像。在一个示例中,对目标对象进行目标跟踪的方法可以包括:在第一帧图像中,为每个目标对象的标定框设置初始标识信息,例如1号、2号、3号

…

n号等。对于在第k帧(k≥2)才出现的目标对象的标定框同样设置初始标识信息。对于在第k帧已出现的目标对象的标定框,通过将第k帧中的目标对象与历史帧的目标对象进行重叠度的计算,所述重叠度计算算法可以包括iou算法、giou算法、ciou算法和diou等。将重叠度大于预设阈值的目标对象确定为同一个目标对象,对k帧的目标对象的标定框使用历史帧同一目标对象的标定框的标识信息。按照时间的先后顺序,将相同标识信息的标定框确定为同一目标对象的运动轨迹。

68.步骤s103,根据所述掩膜数据,从带有所述运动轨迹视频数据中获取所述目标对象的前景图像。

69.本公开实施例中,首先获取所述运动轨迹视频数据中对应的掩膜数据,利用图像的掩膜数据,乘以相同帧的视频数据,从而将视频数据中除目标对象以外的区域置零,得到所述目标对象的前景图像,记录所述前景图像相对于所述视频数据位置变化。

70.步骤s104,将所述前景图像插入预设的背景图像中,生成所述目标对象的视频数据。

71.本公开实施例中,首先确定第一帧前景图像,按照目标对象的运动轨迹,依次将多张所述前景图像插入到背景图像中。所述背景图像是具有区别与原视频图像不同的场景的图像。生成所述目标对象的视频数据。

72.本公开实施例中,通过获取至少包括异常行为的目标对象的标定框数据和掩膜数据,利用获取到的标定框数据和掩膜数据确定目标对象的前景图像的运动轨迹,再将前景图像插入的新的应用场景的图像中可以得到新的视频图像,并确保新的视频图像包含有异常行为的目标对象。相较于传统的人工模拟或搜集相关场景的视频,本公开实施例能够高效准确的获得大量的带有异常行为目标对象的视频数据。

73.在一种可能的实现方式中,所述根据所述标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹,包括:

74.获取所述标定框数据的置信度信息;

75.根据所述置信度信息,对所述标定框数据进行分类,得到不同精度类别的标定框数据;

76.利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹。

77.本公开实施例中,利用目标检测的算法获取标定框数据的时候,可以根据标定框数据的置信度信息,即标定框的分类得分,利用非极大值抑制(nms,non maximum suppression)的方法,对标定框数据进行分类。以目标检测算法为例,同一个目标对象,由于滑动窗口,可能有几个框,每一个框都带有一个分类器得分。利用非极大值抑制方法,首先使用预设的第一阈值过滤目标框的得分,得到第一过滤结果;然后在第一过滤结果中挑选出得分大于预设的第二阈值的目标框,得到第二过滤结果。在一个示例中,可以设置所述第一阈值小于第二阈值,如第一阈值为0.2,第二阈值为0.5。因此,第一过滤结果包括第二过滤结果。由于第二阈值比较高,因此第二过滤结果中标定框的精度要高于第一过滤结果

中标定框的精度。

78.本公开实施例中,所述利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪可以包括:利用高精度的标定框数据对所述目标对象进行目标跟踪,在高精度的标定框数据中匹配不到目标对象的情况下,利用低精度的标定框数据继续对所述目标对象进行目标跟踪。从而确定目标对象的运动轨迹。

79.本公开实施例,首先使用高精度的标定框数据对目标对象进行跟踪,保证了目标对象的准确性,即确保目标对象为人物而不是其他运动物体。在高精度的下一帧标定框数据无法匹配当前帧图像的目标对象的情况下,可以从低精度的标定框数据中去寻找匹配的目标对象,以使得该目标对象的运动轨迹能够延续下去。本公开实施例能够准确的获得目标对象的运动轨迹,同时保证的运动轨迹的连续性。

80.在一种可能的实现方式中,所述利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹,包括:

81.获取第一标定框数据和第二标定框数据,其中,所述第一标定框数据的精度大于第二标定框数据的精度;

82.利用所述第一标定框数据中历史帧标定框的标识信息以及所述第二标定框数据,确定所述第一标定框数据中当前帧标定框的标识信息;

83.获取同一标识信息的第一标定框数据,作为与所述标识信息相对应的目标对象的运动轨迹。

84.本公开实施例中,在所述第一标定数据的第一帧图像中,为每个目标对象的标定框设置初始标识信息,例如1号、2号、3号

…

n号等。对于在第k帧(k≥2)才出现的目标对象的标定框同样设置初始标识信息。在一个示例中,所述初始标识信息与标定框相对应,能够唯一确认该标定框。对于在第k帧已出现的目标对象的标定框,通过将第k帧中的目标对象与历史帧的目标对象进行重叠度的计算,所述重叠度计算算法可以包括iou算法、giou算法、ciou算法和diou等。将重叠度大于预设阈值的目标对象确定为同一个目标对象,将历史帧中同一目标对象的标定框的标识信息设置于第k帧的目标对象的标定框上。在另一个示例中,若所述第一标定框数据中匹配不到目标对象的情况下,从第二标定框数据的对应帧的标定框数据继续寻找上述匹配不到的目标对象。若匹配成功,则将第二标定框数据中的标定框加入到第一标定数据中。

85.本公开实施例,标识信息相同,对应相同的目标对象,因此,可以将同一标识信息的第一标定框数据作为与所述标识信息相对应的目标对象的运动轨迹。

86.在一种可能的实现方式中,所述利用所述第一标定框数据中历史帧标定框的标识信息以及所述第二标定框数据,确定当前帧标定框的标识信息,包括:

87.利用所述第一标定框数据中历史帧标定框的标识信息,确定所述第一标定框数据中当前帧中所有标定框的标识信息;

88.在所述当前帧的标定框中不存在与历史帧的标定框相匹配的情况下,从所述第二标定框数据中确定与所述前一帧的标定框相匹配的标定框;

89.将所述前一帧标定框的标识信息设置到所述相匹配的标定框的标识信息,将设置完标识信息后的所述相匹配的标定框补充到所述对应帧中。

90.为了更好的说明本公开实施例,现对各标定框做如下设置。所述第一标定框数据

中第k帧的标定框可以表示为boxes1[k],所述第二标定框数据中第k帧的标定框可以表示为boxes2[k]。boxes1[k][i]表示第一标定框数据中第k帧第i个标定框,boxes1[k][j]表示第一标定框数据中第k帧第j个标定框。其中,k的取值范围是1<=k<=视频数据的总帧数i和j的取值范围是:1<=i≤第一或第二标定框数据中总目标框的个数;1<=j≤第一或第二标定框数据中总目标框的个数。

[0091]

本公开实施例中,对于第一标定框数据中的第一帧的标定框boxes1[1],对每个标定框添加对应的标识信息。对于第一标定数据中的第k(k≥2)帧的标定框boxes1[k],将标定框boxes1[k]与上一帧中的所述标定框boxes1[k

‑

1]进行匹配,若匹配失败,则将标定框boxes1[k]继续与上上帧的所有标定框boxes1[k

‑

2]进行匹配,若仍然匹配失败,则将标定框boxes1[k]继续与历史帧的标定框进行匹配,或者认为匹配不成功的boxes1[k]是一个新的目标框,为boxes1[k]设置新的标识信息。若标定框boxes1[k]与标定框boxes1[k

‑

1]匹配成功,则将标定框boxes1[k

‑

1]的标识信息赋值给标定框boxes1[k];若标定框boxes1[k]与标定框boxes1[k

‑

2]匹配成功,则将标定框boxes1[k

‑

2]的标识信息赋值给标定框boxes1[k],以此类推。应当注意的是,由于第一标定数据中的第k帧的标定框boxes1[k]可能包括多个标定框,因此,需要将标定框boxes1[k]所有的标定框与历史帧的标定框做匹配。

[0092]

在所述当前帧的标定框中不存在与历史帧的标定框相匹配的情况下,例如boxes1[k]中没有与boxes1[k

‑

1][j]相匹配的标定框,则从第二标定数据boxes2[k]中寻找与boxes1[k

‑

1][j]相匹配的标定框,若存在boxes2[k][i]与boxes1[k

‑

1][j]相匹配,则将boxes2[k][i]补充到第一标定数据boxes1[k]中,并将boxes1[k

‑

1][j]的标识信息赋值给boxes2[k][i]。在一个示例中,若第二标定数据boxes2[k]中未存在与boxes1[k

‑

1][j]相匹配的标定框,则从第二标定数据k 1帧中boxes2[k 1]中去寻找与boxes1[k

‑

1][j]相匹配的标定框,若存在boxes2[k 1][i]与boxes1[k

‑

1][j]相匹配,则将boxes2[k 1][i]补充到第一标定数据boxes1[k 1]中,并将boxes1[k

‑

1][j]的标识信息赋值给boxes2[k 1][i]。在另一个示例中,若第二标定数据中也没有与boxes1[k

‑

1][j]相匹配的标定框,则认为该目标框的动作轨迹结束。依次类推,获取每个目标对象的标定框和掩膜的轨迹。

[0093]

在一种可能的实现方式中,筛选运动轨迹包含帧数大于预设值的运动轨迹,所述预设值可以设置,如5帧。本公开实施例可以对整个数据进行降噪,降低了由于模型误检产生的较短的运动轨迹。

[0094]

本公开实施例,在高精度的下一帧标定框数据无法匹配当前帧图像的目标对象的情况下,可以从低精度的标定框数据中去寻找匹配的目标对象,以使得该目标对象的运动轨迹能够连续。

[0095]

在一种可能的实现方式中,两标定框相匹配的条件被设置为两标定框中目标对象的重合度大于预设值,其中重合度的算法可以包括iou算法、giou算法、ciou算法、和diou。

[0096]

在一种可能的实现方式中,所述将所述前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据,包括:

[0097]

对所述前景图像进行几何变换,得到多种前景图像;

[0098]

将所述前景图像和所述多种前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据。

[0099]

本公开实施例中,所述对前景图像进行几何变换,可以包括:改变前景图像与背景

图像的水平或垂直方向的位置关系,对前景图像进行尺寸大小的缩放或旋转、镜像等操作,得到多种前景图像,将所述前景图像和所述多种前景图像插入预设的背景图像中,生成所述目标对象的新的视频数据。

[0100]

本公开实施例,对前景图像进行几何变换得到多种前景图像,可以增加训练样本的种类,提高模型的泛化能力。

[0101]

在一种可能的实现方式中,所述获取至少包括有异常行为的目标对象的标定框数据和掩膜数据,包括:

[0102]

获取至少包括异常行为的目标对象的视频数据;

[0103]

将所述视频数据输入至图像分割模型,经所述图像分割模型,输出所述目标对象的标定框数据和掩膜数据,其中,所述图像分割模型被设置为利用样本视频数据与样本目标对象的标定框、掩膜的对应关系训练获得。

[0104]

本公开实施例中,所述视频数据中至少包括异常行为的目标对象,该视频数据是可以人为筛选的,由于不限定异常行为的应用场景,因此,该视频数据的获得方式是比较容易的。在一个示例中,可以利用目标对象在本地进行模拟,以获得所述视频数据。本公开实施例中,所述图像分割模型是利用样本视频数据与样本目标对象的标定框、掩膜的对应关系训练获得的,在一个示例中,所述图像分割模型可以利用已有的yolact网络模型算法,得到目标对象的标定框和掩膜。所述yolact网络模型包括fpn结构和protonet结构。图2是根据一示例性实施例示出的fpn结构的示意图,图3是根据一示例性实施例示出的protonet结构的示意图。参考图2,输入的图像分辨率可以包括550

×

550

×

3,使用resnet101网络作为主干网络,首先对输入的图像进行深度卷积,然后对第二层201及以上的层进行通过卷积进行特征提取,并进行降采样。对第四层进行上采样,使得右侧图像金字塔层203与左侧图像金字塔层201具有相同的尺寸。然后层203由层201与层203在特征金字塔的上层经过结构202结构操作得到。具体地,层203在特征金字塔的上层经过上采样处理后,与层201经过一次1*1卷积处理后的结果进行对应元素相加。将处理过的低层特征和处理过的高层特征进行累加,这样做的目的是因为低层特征可以提供更加准确的位置信息,而多次的降采样和上采样操作使得深层网络的定位信息存在误差,因此我们将其结合起来使用,这样我们就构建了一个更深的特征金字塔,融合了多层特征信息。参考图3所示,p3对应于图2中的右侧图像金字塔203,此处特征映射图feature_map分辨率计算是假定网络输入为550*550*3通过网络推导所得。第一个69*69*256的特征映射图表示取用p3,经过3次3*3卷积后得到第二个69*69*256的特征映射图,再使用上采样(upsampling)以及一次3*3卷积得到138*138*256的特征映射图,最后经过一次1*1卷积降低通道数至k(此处k=32),得到138*138*32的特征映射图。最终的32个特征映射图即为protonet为每张图片生成的原型掩膜(prototype mask)。yolact的损失函数分为三种:类别置信度损失(softmax损失)、坐标框回归损失(smooth

‑

l1损失)、掩码损失(binary_cross_entropy损失)。yolact方法的优势有:针对大目标的mask比maskr

‑

cnn和fcis算法的质量有显著的优势;推理速度能够达到实时,能够更快速的进行语义分割任务;在动态视频检测中yolact比maskrcnn能够提供时域上更稳定的掩码结果。

[0105]

在另一个示例中,所述图像分割模型被设置为利用样本视频数据与样本目标对象的标定框、掩膜的对应关系训练获得,包括:

[0106]

获取目标对象的视频数据的样本集合,所述样本集合中包括多个在目标对象上标注标定框和掩膜的图像数据,

[0107]

构建图像分割模型,所述图像分割模型中设置有训练参数;

[0108]

将所述目标对象的视频数据输入至所述图像分割模型,生成预测结果;

[0109]

基于所述预测结果与标注的标定框和掩膜之间的差异,对所述训练参数进行迭代调整,直至所述差异满足预设要求。

[0110]

本公开实施例中所述图像分割模型可以通过深度学习的方法训练获得。所述视频数据中包括目标对象,该目标对象可以是有异常行为的目标对象也可以没有异常行为的目标对象。样本集合中包括了标注了标定框和掩膜的视频数据。可以采用人工标注或其他已标定好的数据,本公开不做限制。所述图像分割模型可以包括卷积神经网络,如r

‑

cnn,fast r

‑

cnn,faster r

‑

cnn等。将所述视频数据输入至图像分割模型,生成带有标定框和掩膜的预测结果,基于所述预测结果与标注的标定框和掩膜之间的差异,对所述训练参数进行迭代调整,直至所述差异满足预设要求。

[0111]

本公开实施例中,图像分割模型的类别置信度损失采用focal loss损失,focal loss损失的计算公式如下:

[0112]

fl(p

t

)=

‑

α

t

(1

‑

p

t

)

γ

log(p

t

) (1)

[0113][0114]

其中,α

t

为平衡因子,此处取值可以为0.25,γ为聚焦参数,此处取值可以为2,式中,y为真实样本类别,值为1或

‑

1,表示样本属于正类或负类,p为模型预测样本属于正类的概率,t无实义。

[0115]

在一种可能的实现方式中,所述将所述目标对象的视频数据输入至所述图像分割模型,生成预测结果,包括:

[0116]

获取图像尺寸大于预设值的目标对象的视频数据;

[0117]

对所述视频数据进行下采样,得到多个尺寸缩小的视频数据;

[0118]

将所述视频数据输入至所述图像分割模型,生成预测结果。

[0119]

本公开实施例中,获取图像尺寸大于预设值的目标对象的视频数据,例如:640

×

640

×

3。越大的图像,进行图像分割时,预测预测结果越准确。而图像尺寸的增加,会降低运行速度,因此,本公开实施例,对视频数据进行下采样,例如在输入层和卷积层之间插入focus结构,达到推理提速的作用。利用focus结构处理过程包括:对输入的图像,如640

×

640

×

3,以2

×

2的网格窗口步长为2对图像进行滑动窗口,将2

×

2中第一个网格经过的像素点整合为一个通道,对2、3、4的网格也做相应的操作,如此,通过focus结构后输入尺寸由640

×

640

×

3转换为320

×

320

×

12。如此达到降低分辨率的同时又能够保证输入信息的完整性。

[0120]

在一种可能的实现方式中,提供一种检测目标对象异常行为的方法,获取视频数据;

[0121]

将所述视频数据输入至异常行为检测模型,经所述异常行为检测模型,输出所述视频数据中有异常行为的目标对象,其中,所述异常行为检测模型被利用本公开实施例中

任一项所述的数据处理方法得到的样本视频数据与标注异常行为的目标对象之间的对应关系训练获得。

[0122]

本公开实施例检测目标对象异常行为的模型可以通过深度学习的方法训练获得。利用本公开实施例中任一项所述的数据处理方法得到的样本视频数据与标注异常行为的目标对象,构建样本集合。样本集合中包括了标注了异常行为的目标对象。可以利用上述实施例中的标定框数据标注异常行为或其他人工标注的方法,本公开不做限制。所述异常行为检测模型可以包括卷积神经网络,如r

‑

cnn,fast r

‑

cnn,faster r

‑

cnn等。将所述视频数据输入至图像分割模型,生成带有异常行为的目标对象的预测结果,基于所述预测结果与标注的目标对象之间的差异,对所述训练参数进行迭代调整,直至所述差异满足预设要求。

[0123]

图6是根据一示例性实施例示出的一种数据处理装置框图。参照图6,该装置包括:第一获取模块601、确定模块602、第二获取模块、生成模块。

[0124]

第一获取模块601,用于获取目标对象的标定框数据和掩膜数据,所述目标对象包括确定为有异常行为的对象;

[0125]

确定模块602,用于根据所述标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹;

[0126]

第二获取模块603,用于根据所述掩膜数据,从带有所述运动轨迹视频数据中获取所述目标对象的前景图像;

[0127]

生成模块604,用于将所述前景图像插入预设的背景图像中,生成所述目标对象的视频数据。

[0128]

在一种可能的实现方式中,所述确定模块602包括:

[0129]

获取子模块,用于获取所述标定框数据的置信度信息;

[0130]

分类子模块,用于根据所述置信度信息,对所述标定框数据进行分类,得到不同精度类别的标定框数据;

[0131]

确定子模块,用于利用所述不同精度的标定框数据,对所述目标对象进行目标跟踪,确定所述目标对象的运动轨迹。关于上述实施例中的装置,其中各个模块执行操作的具体方式已经在有关该方法的实施例中进行了详细描述,此处将不做详细阐述说明。

[0132]

图7是根据一示例性实施例示出的一种数据处理装置700的框图。例如,装置700可以被提供为一服务器。参照图7,装置700包括处理组件722,其进一步包括一个或多个处理器,以及由存储器732所代表的存储器资源,用于存储可由处理组件722的执行的指令,例如应用程序。存储器732中存储的应用程序可以包括一个或一个以上的每一个对应于一组指令的模块。此外,处理组件722被配置为执行指令,以执行上述实施例中任一项所述的数据处理方法方法。

[0133]

装置700还可以包括一个电源组件726被配置为执行装置700的电源管理,一个有线或无线网络接口750被配置为将装置700连接到网络,和一个输入输出(i/o)接口758。装置700可以操作基于存储在存储器732的操作系统,例如windows server,mac os x,unix,linux,freebsd或类似。

[0134]

在示例性实施例中,还提供了一种包括指令的非临时性计算机可读存储介质,例如包括指令的存储器732,上述指令可由装置700的处理组件722执行以完成上述方法。例如,所述非临时性计算机可读存储介质可以是rom、随机存取存储器(ram)、cd

‑

rom、磁带、软

盘和光数据存储设备等。

[0135]

本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本公开的其它实施方案。本技术旨在涵盖本公开的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本公开的一般性原理并包括本公开未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本公开的真正范围和精神由下面的权利要求指出。

[0136]

应当理解的是,本公开并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本公开的范围仅由所附的权利要求来限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。