1.本发明属于计算机视觉、深度学习技术领域,涉及一种基于联合表示法的遥感目标检测方法。

背景技术:

2.近年来,基于深度学习的目标检测方法取得了突破性的发展。由于拍摄视角的差异,相较于日常场景中的目标,遥感图像中的目标通常具有密集排布、任意方向、大宽高比等特性,所以不能将场景目标检测的框架直接应用于遥感目标检测领域。一般情况下,目标检测的水平范围框由[x,y,w,h]四个参数表示,其中(x,y)代表范围框的中心点坐标,(w,h)代表框的宽和高。

[0003]

因为遥感图像中目标的特殊性,最初的遥感目标检测方法给水平范围框引入角度参数,从而能够表示带有方向的旋转目标,称为五参数表示法,五参数的组成为(x,y,w,h,θ),其中前四个参数与水平范围框意义相同,θ代表角度参数。又由于定义角度的方式不同,五参数表示法可细分为opencv定义法和长边定义法,前者中的角度θ代表范围框与x轴的最小夹角,并将形成此夹角的边定义为范围框的w,因此opencv定义法的θ角度变化范围为后者长边定义法选定范围框最长边和x轴的夹角,所以此定义下的角度变化范围为θ∈[0,π]。

[0004]

五参数表示法能够直接使用角度参数,将遥感图像目标的方向信息进行编码,从而完成场景目标检测框架到遥感目标检测框架的迁移。但是因为角度θ的定义问题,无论是opencv定义法还是长边定义法,在其角度范围的临界处,微小的角度变化往往会产生较大的损失差异,理想预测结果超出了角度的定义范围,使角度参数的回归出现歧义,最终影响模型的检测效果。随后提出的八参数表示法,即使用范围框的四个顶点坐标表示带有方向的目标,参数组成是[x1,y1,x2,y2,x3,y3,x4,y4],其中(x

i

,y

i

),i∈[1,2,3,4]表示从左上角的坐标开始,顺时针方向上第i个顶点的坐标。八参数表示法能够避免角度参数引起的损失不连续问题,但是其存在顶点排序问题,若范围框在定义边界产生微小偏移,同样会导致模型在训练时出现损失函数的局部激增现象。

[0005]

基于无锚(anchor

‑

free)的方法在遥感目标检测领域有很大的发展潜力,也取得了可观的成果,这些成果主要集中于关键点的预测,倾向使用点对点监督的训练方案,一方面能够避免五参数表示法和八参数表示法带来的损失不连续问题,另一方面无锚检测器无需提前设置锚框(anchor),能够减少计算量。

技术实现要素:

[0006]

本发明的目的是提供一种基于联合表示法的遥感目标检测方法,解决了现有技术中存在的预设锚框匹配度较差,以及角度回归表示方法模糊性大的问题。

[0007]

本发明所采用的技术方案是,一种基于联合表示法的遥感目标检测方法,按照以

下步骤实施:

[0008]

步骤1、对遥感图像进行图像预处理和特征提取;

[0009]

步骤2、获取中心点;

[0010]

步骤3、由自适应特征点集合得到初始化旋转范围框;

[0011]

步骤4、对初始化旋转范围框进行修正,采用精细化模块对特征点进行精细化地调整,提高网络的定位精度。

[0012]

本发明的有益效果是,使用深度学习技术,识别和定位卫星遥感图像中飞机、舰船、车辆、桥梁等有价值目标,利用特征点集合表示以生成精确旋转范围框的检测方法;同时,本发明能避免基于角度表示的方法造成的损失不连续问题,从而使模型获得更快的收敛速度和更强的泛化能力。本发明属于无锚检测器的一种,但是不同于简单的点到点的监督方式,而是使用关键点匹配和自适应点集合的一种联合表示方法,将目标中心点作为关键点匹配,同时选取特征响应较强的前n个特征点,组成特征点集合,再根据特征点集合生成外接范围框以定位具有任意方向的目标,相较于只使用点对点的监督训练方式,这种联合表示方法在宏观上的容错性能更强,灵活性更高,具有更加广阔的发展前景。使用本发明遥感目标检测方法,能够在保证精确度的前提下,快速检测高分辨率遥感图像中存在的高价值地物目标,获得其位置信息和类别信息。

附图说明

[0013]

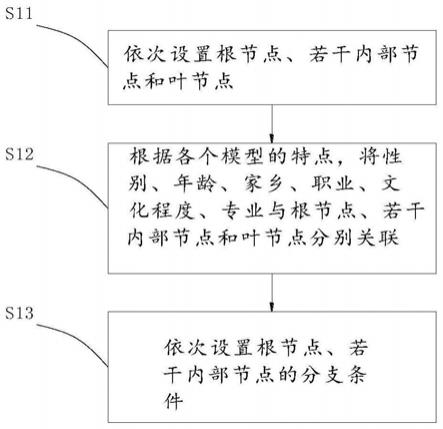

图1是本发明方法中的步骤1实施例的算法流程图;

[0014]

图2是本发明方法中的中心点预测示意图;

[0015]

图3是本发明方法构建的信息整合与可变形卷积流程;

[0016]

图4a是舰船特征点集生成旋转范围框的示意图,图4b是飞机特征点集生成旋转范围框的示意图;

[0017]

图5是本发明方法中的分类子网络示意图。

具体实施方式

[0018]

下面结合附图和具体实施方式对本发明进行详细说明。

[0019]

本发明方法的主要思路是:首先,使用fpn网络提取不同尺度下遥感图像的特征,对每个尺度的特征图,将特征输入卷积层以得到整合特征,把整合特征输送给基础模块,先提取目标的中心点特征,再将特征图上的特征点按照响应强度从大到小排列,为每个目标分配其自身的前n个特征点,同时利用中心点对特征点进行约束,组成粗略的点集合;然后,在精细化模块,特征图经过可变形卷积(deformable convolution)操作之后,得到特征点的修改偏移量,粗略的点集合得到改善,生成较为精确的点集合;最后,使用函数生成二维平面上包含本目标所有点的最小外接矩形,经过后处理得到最终的预测范围框,同时输出类别置信度。

[0020]

本发明方法,基于上述的构架,按照以下步骤实施:

[0021]

步骤1、对遥感图像进行图像预处理和特征提取,

[0022]

由于原始的遥感图像的分辨率很高,大视场的光学遥感场景中,经常会出现微小目标,通常需要从数亿像素的大宽度俯瞰场景中提取大小约为12个像素的目标,而这些大

场景可以覆盖超过32平方公里的区域,所以将遥感图像输入网络之前需要对遥感图像进行裁剪的预处理操作。

[0023]

本步骤的算法流程如图1所示,将预处理后的尺寸为800*800的遥感图像输送入fpn网络(即特征金字塔网络,feature pyramid network)来提取图像的特征,fpn网络先利用自下而上的卷积操作,再使用侧向连接,同时与自上而下的卷积操作相结合,得到遥感图像中所包含的浅层细粒度特征以及深层语义特征。根据图1实施例所示,fpn网络能够提取到四种尺寸不同的特征图,每种尺寸的特征图都会向下传递进行定位和分类任务,为了简洁,在图1中只展示了其中一种尺寸的后续操作信息。

[0024]

步骤2、获取中心点,

[0025]

由fpn网络提取到的特征,先经过一个卷积层,其卷积核尺寸为3*3,再使用sigmoid函数进行激活操作;该卷积层的作用在于整合特征向量的关键信息,激活后的特征被称为整合特征a,其被分别馈送至基础模块中的中心点预测支路和特征点集合生成支路;基础模块的作用是生成粗略的目标中心点集合和特征点集合,为二者的精确预测建立基础,并输出整合特征b。

[0026]

在中心点预测支路中,首先根据整合特征a的大小,选择上采样或下采样操作,得到尺寸为的热图(heatmap),其中c代表通道数量,默认值为256,w和h代表原始输入的遥感图像的宽和高;中心点的获取类似于像素分类任务,预测尺寸为的热图上每个像素属于目标中心点的概率p

cxy

,其中的p∈[0,1],c代表目标所预测概率最大的类别,x和y则代表热图上(x,y)处像素点的位置坐标,本步骤对现有的中心点提取方案进行了改进,取消了只选取前100个特征点进行预测的方案,修改为阈值判断法,即给定阈值σ=0.3,将预测概率p>σ的像素视作正样本,其余像素归类为负样本,然后采用以下两个策略,实现缓解正负样本失衡的目的:

[0027]

第一个策略,给定中心点像素标签其中(i,j)代表标签中心点在输入遥感图像上的位置坐标,i∈[0,w],j∈[0,h];得到热图后,根据计算低分辨率标签中心点其中(x

*

,y

*

)代表热图上低分辨率标签中心点像素的位置坐标,最后围绕低分辨率中心点生成二维高斯分布:

[0028][0029]

其中,如图2所示,中心点被表示为目标中心的区域,越靠近中心点损失值越小;

[0030]

第二个策略,为约束负样本对损失的影响,突出正样本特征点的贡献,选择在像素

级别对中心点进行约束,因此中心点定位损失l

center

的表达式是:

[0031][0032]

其中,n是原始输入图像中目标的数量,γ和β是超参数,分别设置为γ=2,β=4,p

cxy

代表预测的热图上(x,y)处像素属于类别c的置信度,代表热图上(x,y)处像素的类别置信度标签。

[0033]

步骤3、由自适应特征点集合得到初始化旋转范围框,

[0034]

在特征点集合生成支路中,整合特征a再次经过三个卷积层,如图3所示,该三个卷积层的卷积核尺寸均为3*3,步长均为1,通道数均为256,所有卷积层均执行批量归一化,并通过relu函数激活输出,然后经过可变形卷积操作,获得特征点的空间偏移量(δx

v

,δy

v

),卷积后的特征i大小为2n为通道数,此处的卷积通道数取决于特征点的数量,代表n个特征点分别在横纵坐标方向的偏移情况;

[0035]

自适应初始点集合d=[d1,d2,d3,...,d

n

],其中的d

v

=x

v

δx

v

代表同一目标的第v个初始化的自适应特征点,v∈[1,2,3,...,n],本步骤实施例采用9个特征点表示一个目标,即n=9。(此处n含义与前述步骤相同)

[0036]

参照图4a和图4b实施例,白色为自适应特征点,黑色为中心点。利用minaerarect函数,从旋转目标学习到特征点中找到面积最小的旋转矩形,其转化过程是m

ob

=t(d),其中的m

ob

表示从点集合得到的最小面积旋转范围框,t(

·

)表示minaerarect函数,d则表示初化自适应点集合;

[0037]

使用giou损失函数以驱动预测框向标签范围框靠拢,表达式是:

[0038][0039]

其中,则为标签范围框,area表示能包围预测框与标签框的最小外接矩形面积,iou的表达式是:

[0040][0041]

因此,基础模块的定位损失l

loc

表达式是:

[0042][0043]

其中,n

loc

表示基础模块中正样本点集合的数量,sn代表点集合的序号,l

giou

代表giou损失函数,即l

giou

=1

‑

giou。

[0044]

由于特征点为自适应选取,不是由点到点的监督方式获得,因此得到特征点集合

后,利用中心点对特征点进行约束,约束的目的在于对超出目标范围的点进行惩罚;惩罚时,首先判断特征点的位置是否在标签范围框内部,然后对超出范围框的特征点计算其与中心点的欧氏距离,表达式如下:

[0045][0046]

其中,center

(x,y)

代表预测的中心点坐标,d

v

代表同一目标的第v个特征点,根据式(6)得到特征点空间位置损失,表达式是其中,n代表特征点数量,对于一个目标而言,n=9;dist

v

表示每个特征点的距离参数,表达式是:

[0047][0048]

其中gt代表标签范围框,即ground truth;

[0049]

步骤4、对初始化旋转范围框进行修正,

[0050]

由于在基础模块得到的初始化旋转范围框精确度并未达到要求,因此本步骤还设置有一个精细化模块,用于对特征点进行精细化地调整,以提高网络的定位精度。

[0051]

如图1所示,精细化模块包含定位子网络分支和分类子网络分支,

[0052]

4.1)在定位子网络分支中,沿用基础模块的原理,基础模块得到的中心点特征、初始化的特征点信息及旋转范围框信息均以concat操作同整合特征a进行合并得到整合特征b,合并后的整合特征b再次使用三个卷积层操作进行处理,三个卷积层的卷积核尺寸均为3*3,步长均为1,通道数均为256,所有卷积层均执行批量归一化,并通过relu函数激活,随后通过可变形卷积层,得到新的特征点偏移量将新的特征点偏移量同初始化特征点位置进行加和,表达式是得到自适应特征点集合,表示为其中的代表同一目标的自适应特征点集中的第n个特征点(此处n含义与前述步骤含义相同);

[0053]

同时,定位子网络分支同样对基础模块的中心点坐标进行修正,再通过minaerarect函数得到修正后的精确范围框表达式是其中的为修正后的自适应特征点集合,精细化模块的定位损失策略和基础模块相似,表达式是:

[0054][0055]

其中代表精细化模块正样本特征点集合的个数,sn即为点集合序号(此处的sn与前文的涵义相同)。

[0056]

为了进一步加快模型收敛速度和提高检测精度,在训练时,本步骤利用预测范围框与标签范围框的面积相关性作为驱动,以约束由特征点集合生成的旋转范围框,具体操作是计算预测范围框与标签范围框的giou值,综合式(2)、式(5)和式(8),定位损失的表达

式是:

[0057][0058]

4.2)在分类子网络分支中,从基础模块得到的整合特征b经过一个卷积层的处理,卷积层的卷积核尺寸为3*3,包含批量归一化操作,通道数为256,再使用sigmoid函数进行激活,从而得到整合特征c,该卷积层的目的同样是对特征向量的关键信息进行整合;参照图5,整合特征c经过四层卷积层,其中每个卷积层的卷积核尺寸均为3*3,步长均为1,通道数均为256,所有卷积层均执行批量归一化操作,并通过sigmoid函数激活,使用大小为h*w*c的卷积操作,得到目标的类别置信度(即目标的分类分数),类别预测的损失函数l

c

的表达式是:

[0059][0060]

其中,代表所预测的第m个目标的类别置信度,为此目标对应的标签类别置信度,l

cls

代表focal loss,n

cls

为点集合的总数,则训练总损失l的表达式是:

[0061]

l=l

t_loc

l

c

l

d

ꢀꢀꢀ

(11)

[0062]

至此,在训练阶段使用训练总损失l驱动模型收敛;在预测阶段,将需要预测的遥感图像(原始输入图像)输入给fpn网络,并调用收敛后的参数模型,即完成对该遥感图像的检测任务,得到该遥感图像中关键目标的准确位置信息和分类信息。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。