1.本发明设计一种多尺度注意力模块mam的建立方法,以及一种基于纸张图像分析的古籍年份检验分析方法。

背景技术:

2.文物古籍是研究古代历史社会的重要资料,具有不可替代的文献价值。而且古籍的版本种类很多,同一本古籍的不同版本也具有研究价值。文物古籍还承载着不可替代的学术价值和艺术价值,在收藏市场上占据特殊的地位。由于古籍近年来在收藏品市场上十分受宠,所以各种伪造的古籍也层出不穷。因此文物古籍的真伪鉴定具有重大意义。

3.现有的古籍鉴定涉及到如下几个方面:1.书籍校勘的粗精。2.开本的大小。3.版式的规制。4.印纸。5.墨水。6.字体的风格。7.装帧的特点。

4.这些鉴定方法都对鉴定人员具备专业知识的要求极高,而且我们很难将所有的鉴定方法和现代科学技术结合,设计成自动化的古籍鉴定方式。不论是书籍的校勘、开本的大小以及版式的规制,还是字体风格和装帧的特点,都需要相关领域的专家根据专业知识和经验等对古籍进行真伪鉴定。而且不同时代的文物古籍的鉴定方法差异很大,鉴定方法很大程度取决于该时代书籍的独特特色,导致文物古籍鉴定的周期长,过程复杂。因此迫切需要一种简单快捷的自动化文物古籍鉴定方法。

5.在古籍鉴定过程中,专家并非只是用其中一个方面对古籍进行真伪的鉴定,而是综合多个方面对古籍进行鉴定。本文希望设计一种自动化的鉴定方法协助专家进行古籍真伪的鉴定,加快鉴定的速度。历史上很多学者研究文件古籍纸张的年份,进而判断书籍的生产年份,通过书籍准确的生产年份来判断古籍的真伪。古籍鉴定专家能够通过纸张的外观和手感大致判定出纸张的年代,但这种方法由于缺乏系统的理论基础,可靠性不高,只可意会不可言传,也不便于学习和推广。

6.本文主要通过古籍的纸张研究古籍的生产年份,专家将研究得到的年份和古籍的实际年份进行对比,进而综合判断古籍的真伪。

技术实现要素:

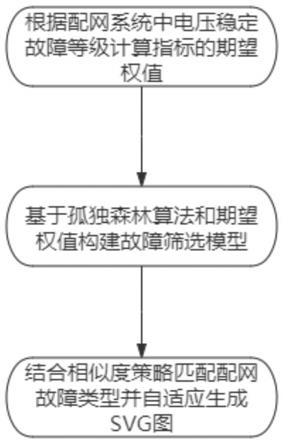

7.本发明提出了一种基于纸张图像分析的古籍年份检验分析方法及相应模块,使用神经网络对纸张图片提取纸张图像的全局特征,并在神经网络模型中加入多尺度注意力模块mam,用于提取纸张显微图片的局部特征;然后,融合纸张图片的全局特征和局部特征,得到最终的纸张纹理特征;最后,融合后的纸张纹理特征作为递归神经网络的输入数据,组成纸张年份回归模型;围绕这个纸张年代回归模型,并使用优化的损失函数进行训练。最终实现了通过纸张显微图片特征推导纸张生产年份的目的;实现快速精准的区分古籍纸张的年份,达到古籍鉴定纸张的目的,具有较广泛的推广价值;克服现有技术的缺陷。

8.本发明提供一种多尺度注意力模块mam的建立方法,包括以下步骤:

9.步骤d

‑1‑

1、建立注意力模块1。

10.将输入的特征图的每一个通道上整个空间特征通过全局平均池化编码为一个全局特征f

sq

,f

sq

公式如下:

[0011][0012]

其中,f表示输入的特征图,f∈r

w

×

h

×

c

,表示c个w

×

h的通道特征图,w表示每个通道的宽,h表示每个通道的高,c表示通道的个数,r为自然数,z

c

表示f

sq

得到的结果。

[0013]

计算特征1权重f

ex

,也就是纸张图片中完整的纤维形态特征在全局特征中的权重。f

ex

公式如下:

[0014]

s

c

=f

ex

(z

c

,w

f

)=σ(g(z

c

,w

f

))=σ(w2δ(w1z

c

))

[0015]

其中,s

c

表示f

ex

得到的结果,w

f

表示全连接层操作,w1表示第一个全连接层操作,w2表示第二个全连接层操作,表示第二个全连接层操作,σ表示sigmoid函数,降维系数为r是个超参数。

[0016]

步骤d

‑1‑

2、根据注意力模块1得到的特征1权重f

ex

进行计算,得到混合特征f

mix1

。

[0017]

f

mix1

=s

c

×

f f

[0018]

其中,c表示通道数目,s

c

用来刻画f中c个特征图的权重。

[0019]

步骤d

‑1‑

3、建立注意力模块2。

[0020]

计算特征2权重f

sp

,也就是纸张图片中独特的纤维形态特征在全局特征中的权重。f

sp

公式如下:

[0021][0022]

其中,f表示输入的特征图,f7×7表示一个卷积核尺寸为7

×

7的卷积操作。是f

sp

平均池化操作生成,是f

sp

生成最大池化操作。

[0023]

步骤d

‑1‑

4、根据注意力模块2得到特征2权重f

sp

进行计算,得到混合特征f

mix2

。

[0024]

f

mix2

=f

sp

×

f f。

[0025]

步骤d

‑1‑

5、把混合特征f

mix1

和混合特征f

mix2

进行相加,得到多尺度特征f

mix

。

[0026]

f

mix

=f

mix1

f

mix2

。

[0027]

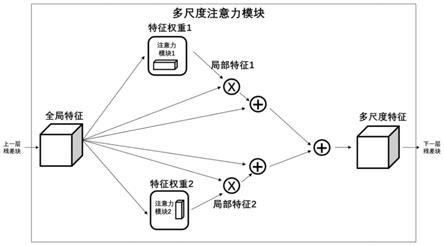

另外,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,包括以下步骤:

[0028]

步骤a、预定义纸张年份标签s。

[0029]

步骤b、采集每一种年份纸张在x种设定的采集条件c={c

x

|x=1,2,3,

····

,x}下的图片,每一种设定采集条件c

x

获得k张相应采集得到的图片,用数组表示为i1={i

1t

|t=1,2,3

…

,k},对于s类书籍每一种设定采集条件c

x

下,共得到s

×

k张图片,年份标签记载在图片上。

[0030]

步骤c、对每一张图片均进行若干种方式的图像数据增强,得到sum张增强后的图像,对于s类书籍每一种设定采集条件c

x

下的s

×

k张图片进行图像数据增强后共得到s

×

k

×

sum张增强后的图像。

[0031]

步骤d、建立每一种设定的采集条件下的具有多尺度注意力机制的神经网络模型model

nx

。

[0032]

步骤d

‑

1、如权利要求1所述的多尺度注意力模块mam的建立方法,建立多尺度注意

力模块mam。f为步骤c中s

×

k

×

sum张增强后的图像的特征图。

[0033]

步骤d

‑

2、将多尺度注意力模块mam加载标准的神经网络模型中,再将融合后的神经网络模型与回归模型组合,形成古籍年份分析模型,将每一种设定采集条件c

x

下的数据集通过古籍年份分析模型训练,得到与设定采集条件c

x

下的训练好的基于多尺度注意力机制的神经网络模型model

nx

。

[0034]

步骤e、确定待鉴定纸张的所属年份。

[0035]

步骤e

‑

1、获得待的鉴定纸张的若干个预测标签及标签概率值。

[0036]

采集待测纸张的所有x种设定采集条件c

x

下的图片的采集,每种设定的采集条件c

x

下采集a张图片,共a

×

x个图片。

[0037]

将每一张图片作为输入,输入到相应采集条件c

x

下的训练好的基于多尺度注意力机制的神经网络模型model

nx

中。

[0038]

该神经网络模型model

nx

输出每一张图片预测标签及标签概率值,即获得a

×

x个预测标签及标签概率值。

[0039]

步骤e

‑

2、根据a

×

x个预测标签及标签概率值,计算获得待鉴定纸张最终预测标签及最终标签概率值。

[0040]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:其中,x种的设定采集条件的其中一种为以下的任意一种:

[0041]

第一种特定采集条件c1为光学放大倍率为40且光源环境为白光背光,相应采集得到的图片用数组表示为i1={i

1t

|t=1,2,3

…

,k}。

[0042]

第二种设定采集条件c2为光学放大倍率为40且光源环境为白光侧光,相应采集得到的图片用数组表示为i2={i

2t

|t=1,2,3

…

,k}。

[0043]

第三种设定采集条件c3为光学放大倍率为80且光源环境为白光背光,相应采集得到的图片用数组表示为i3={i

3t

|t=1,2,3

…

,k}。

[0044]

第四种设定采集条件c4为光学放大倍率为80且光源环境为白光侧光,相应采集得到的图片用数组表示为i4={i

4t

|t=1,2,3

…

,k}。

[0045]

第五种设定采集条件c5为光学放大倍率为40且光源环境为红外光,相应采集得到的图片用数组表示为i5={i

5t

|t=1,2,3

…

,k}。

[0046]

第六种设定采集条件c6为光学放大倍率为40且光源环境为紫外光,相应采集得到的图片用数组表示为i6={i

6t

|t=1,2,3

…

,k}。

[0047]

第七种设定采集条件c7为光学放大倍率为80且光源环境为红外光,相应采集得到的图片用数组表示为i7={i

7t

|t=1,2,3

…

,k}。

[0048]

第八种设定采集条件c8为光学放大倍率为80且光源环境为紫外光,相应采集得到的显微图片用数组表示为i8={i

8t

|t=1,2,3

…

,k}。

[0049]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:若干种方式的图像数据增强中的一种方式为以下的任意一种:

[0050]

第一种图像缩放:

[0051]

读取图片,以向量的形式体现,以裁剪的方式将向量分别缩放0.75倍、0.5倍、1倍、2倍,输出4个向量,再将缩放后的向量恢复成4个显微图片,再进行特定裁剪,得到4个增强后的图像。

[0052]

第二种图像旋转:

[0053]

读取图片,以向量的形式体现,以旋转的方式将向量在0

‑

360度范围内依次平均每次旋转15度,得到20个不同旋转角度的向量,并将旋转后的向量恢复成20个显微图片,再进行特定裁剪,得到20个增强后的图片。

[0054]

第三种图像翻转:

[0055]

读取图片,以向量的形式体现,以翻转的方式将向量上下翻转、左右翻转、左对角线翻转、右对角线翻转,得到4个向量,再将缩放后的向量恢复成4个显微图片,再进行特定裁剪,得到4个增强后的图像。

[0056]

第四种图像对比度加强:

[0057]

读取图片,以向量的形式体现,以直方图均衡化的方法实现对比度加强,对向量进行处理,使得映射范围是[0,255],得到向量,并将对比度加强后的向量恢复成1个显微图片,再进行特定裁剪,得到1个增强后的图像。

[0058]

第五种同态滤波处理:

[0059]

读取图片,以向量的形式体现,以同态滤波的方法对向量进行处理,得到向量,并将同态滤波后的向量恢复成1个显微图片,再进行特定裁剪,得到1个增强后的图像。

[0060]

第六种图像去除噪处理:

[0061]

读取图片,以向量的形式体现,使用均值滤波法、高斯滤波法、双边滤波法、引导滤波法、nlm算子、bm3d算子、频域滤波法、小波域滤波法、p

‑

m方程去噪法、tv法去噪中的任意一种去除噪音的方法处理,得到向量,并向量恢复成1个显微图片,进行图像去除噪处理,再进行特定裁剪,得到1个增强后的图像。

[0062]

第七种图像增强:

[0063]

读取图片,将该图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为300

×

300的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小为300

×

300的特定裁剪,得到的s

n1

张新增强图片。

[0064]

第八种图像增强:

[0065]

读取图片,将该图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为600

×

600的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小,得到

的s

n2

张新增强图片。

[0066]

第九种图像增强:

[0067]

读取图片,将该图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为300

×

n的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小,得到的s

n3

张新增强图片。

[0068]

第十种图像增强:

[0069]

读取图片,将该图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为m

×

300的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小,得到的s

n4

张新增强图片。

[0070]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:去除噪音的方法采用均值滤波法、高斯滤波法和双边滤波法,引导滤波法,nlm算子,bm3d算子,频域滤波法,小波域滤波法,p

‑

m方程去噪法,tv法去噪中的任意一种或几种。

[0071]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:标准神经网络模型为cnn模型或inception_resnet模型或xception模型或resnet_attention模型或nasnet模型或efficientnet模型中的任意一种。回归模型为gru模型或lstm模型或svr模型中的任意一种。

[0072]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:步骤4中标准神经网络模型为卷积神经网络(cnn)模型。卷积神经网络(cnn)模型在xception的每个残差后加载入多尺度注意力模块mam。

[0073]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:

[0074]

损失函数公式如下:

[0075][0076]

其中α和β是权重。y

i

是预测值,是真实值,n表示测试数据的个数。

[0077]

进一步,本发明还提供一种基于纸张图像分析的古籍年份检验分析方法,还具有以下特征:步骤e

‑

2中,设置每个设定采集条件给予相应的权重,即每个预测标签及标签概

率值具有相应的权重;将预测标签相同的分为一组,计算每组中的预测标签对应的概率值*相应的weight的平均值;平均值最高的那一组所对应的预测标签即为最终预测标签(年份),以及最高那组的平均值为最终标签概率值。

附图说明

[0078]

图1是实施例中的卷积神经网络模型model

nx

流程框图。

[0079]

图2是实施例中的多尺度注意力模块mam的演示图。

[0080]

图3是实施例中的注意力模块1的演示图。

[0081]

图4是实施例中的注意力模块2的演示图。

[0082]

图5是实施例中的神经网络模型model

nx

的entry flow的网络结构图。

[0083]

图6是实施例中的神经网络模型model

nx

的middle flow网络结构图。

[0084]

图7是实施例中的神经网络模型model

nx

的exit flow网络结构图。

[0085]

图8是实施例中的神经网络模型model

nx

的gru flow网络结构图。

具体实施方式

[0086]

实施例

[0087]

本是实施例中,基于纸张图像分析的古籍年份检验分析方法包括以下步骤:

[0088]

步骤a预定义纸张年份标签s。

[0089]

预先对不同年份的书籍纸张分别设置不同的标签。由于同一本书籍的纸张制作成因相同(默认不包括书籍封面,通常同一本书籍封面与内部纸张制作成因不相同),因此将同一本书籍的纸张归属同一年份类别,同一年份的书籍采用一个标签,书籍年份种类数表示为s。为使得数据库中拥有足够多的样本,因此需要的书籍种类数s优选满足:s≥50。

[0090]

步骤b:采集显微图片。

[0091]

采集每一种年份纸张在x种设定的采集条件c={c

x

|x=1,2,3,

…

,x}下的图片,每一种设定采集条件c

x

获得k张相应采集得到的图片,用数组表示为i1={i

1t

|t=1,2,3

…

,k},x对应表示设定采集条件c

x

的序号,t可以对应表示空白处的序号。对于s类书籍每一种设定采集条件c

x

下,共得到s

×

k张图片,年份标签作为图片一起输入的数据。

[0092]

本实施例中,采用8种设定采集条件,具体如下:

[0093]

第一种设定采集条件c1为光学放大倍率为40且光源环境为白光背光,相应采集得到的图片用数组表示为i1={i

1t

|t=1,2,3

…

,k}。

[0094]

第二种设定采集条件c2为光学放大倍率为40且光源环境为白光侧光,相应采集得到的图片用数组表示为i2={i

2t

|t=1,2,3

…

,k}。

[0095]

第三种设定采集条件c3为光学放大倍率为80且光源环境为白光背光,相应采集得到的图片用数组表示为i3={i

3t

|t=1,2,3

…

,k}。

[0096]

第四种设定采集条件c4为光学放大倍率为80且光源环境为白光侧光,相应采集得到的图片用数组表示为i4={i

4t

|t=1,2,3

…

,k}。

[0097]

第五种设定采集条件c5为光学放大倍率为40且光源环境为红外光,相应采集得到的图片用数组表示为i5={i

5t

|t=1,2,3

…

,k}。

[0098]

第六种设定采集条件c6为光学放大倍率为40且光源环境为紫外光,相应采集得到

的图片用数组表示为i6={i

6t

|t=1,2,3

…

,k}。

[0099]

第七种设定采集条件c7为光学放大倍率为80且光源环境为红外光,相应采集得到的图片用数组表示为i7={i

7t

|t=1,2,3

…

,k}。

[0100]

第八种设定采集条件c8为光学放大倍率为80且光源环境为紫外光,相应采集得到的显微图片用数组表示为i8={i

8t

|t=1,2,3

…

,k}。

[0101]

其中,每一类书籍的k张显微图片获取为:选择每一类书籍空白处,预计采集不同区域的空白处共k处,k≥40。每一类书籍采集得到的k张显微图片按照比例1:1分为训练集t

li

和验证集v

li

,则s类书籍对应的采集得到显微图片的训练集表示为t

l

={t

li

|i=1,2,3,...s},验证集表示为v

l

={v

li

|i=1,2,3,...s}。

[0102]

设定采集条件c

x

是指同时满足某种设定的光学放大倍率且某种设定的光源环境的采集条件。采集条件:光学放大倍率为40倍率和80倍率。光源环境是背面白光、侧面白光、红外光(800nm)、紫外光(275nm),可构成8种设定采集条件,当然采集倍率、采集光源环境、以及采用的光源都可以自定,不受以上描述的限定。

[0103]

显微图片的具体采集方法如下:

[0104]

(1)使用工业相机以及配套镜头设备,采集某一类书籍在某一种光学放大倍率以及某一种光源环境下的显微图片。

[0105]

(2)在采集的显微图片中,去除因为对焦错误导致的模糊图片。

[0106]

(3)在采集的显微图片中,去除因为破损、墨迹损坏纹理图案的非理想图片。

[0107]

(4)补充采集这一张纸张在这一种光学放大倍率、这一种光源环境下的显微图片,使得这一张纸张在这种采集条件下所采集的显微图片数量k≥40。

[0108]

步骤c、图像数据增强

[0109]

对步骤2采集得到的每一张显微图片均进行多种方式的图像数据增强,对于每一张显微图片进行图像数据增强后均得到sum张增强后的图像,对于s

×

k张显微图片进行图像数据增强后共得到s

×

k

×

sum张增强后的图像。

[0110]

其中,对于每一张显微图片具体按照如下多种方式进行图像数据增强处理如下,得到:

[0111]

第一种图像缩放:

[0112]

读取该显微图片,以向量的形式体现,以裁剪的方式将向量分别缩放0.75倍、0.5倍、1倍、2倍,输出4个向量,再将缩放后的向量恢复成4个显微图片,再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到4个增强后的图像。

[0113]

第二种图像旋转:

[0114]

读取该显微图片,以向量的形式体现,以旋转的方式将向量在0

‑

360度范围内依次平均每次旋转15度,得到20个不同旋转角度的向量,并将旋转后的向量恢复成20个显微图片,再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到20个增强后的图片。

[0115]

第三种图像翻转:

[0116]

读取该显微图片,以向量的形式体现,以翻转的方式将向量上下翻转、左右翻转、左对角线翻转、右对角线翻转,得到4个向量,再将缩放后的向量恢复成4个显微图片,再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到4个增强后的图

像。

[0117]

第四种图像对比度加强:

[0118]

读取该显微图片,以向量的形式体现,以直方图均衡化的方法实现对比度加强,对向量进行处理,使得映射范围是[0,255],得到向量,并将对比度加强后的向量恢复成1个显微图片,再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到1个增强后的图像。

[0119]

第五种同态滤波处理:

[0120]

读取该显微图片,以向量的形式体现,以同态滤波的方法对向量进行处理,得到向量,并将同态滤波后的向量恢复成1个显微图片,再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到1个增强后的图像。

[0121]

第六种图像去除噪处理:

[0122]

读取该显微图片,以向量的形式体现,使用均值滤波法、高斯滤波法、双边滤波法、引导滤波法、nlm算子、bm3d算子、频域滤波法、小波域滤波法、p

‑

m方程去噪法、tv法去噪中的任意一种去除噪音的方法处理,得到向量,并向量恢复成1个显微图片,在本实施例中如图3所示采用高斯滤波法进行图像去除噪处理。再进行设定裁剪(以图像中心为裁剪图像的中心,裁剪大小为300

×

300),得到1个增强后的图像。

[0123]

第七种图像增强:

[0124]

读取该显微图片,将该显微图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为300

×

300的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小为300

×

300的设定裁剪,得到的s

n1

张新显微图片,以达到数据增强的效果。

[0125]

第八种图像增强:

[0126]

读取该显微图片,将该显微图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为600

×

600的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小为300

×

300的设定裁剪,得到的s

n2

张新显微图片,以达到数据增强的效果。

[0127]

第九种图像增强:

[0128]

读取该显微图片,将该显微图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为300

×

n的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小为300

×

300的设定裁剪,得到的s

n3

张新显微图片,以达到数据增强的效果。

[0129]

第十种图像增强:

[0130]

读取该显微图片,将该显微图片的图片尺寸表示为m

×

n,将每一张显微图片以图像左上角为起点s

p

,p=1,先横向移动起点s1,步长step为100,依次裁剪出长宽m

×

n为m

×

300的图像。以起点s1下方100像素处作为新起点s

p

,p=2,并横向移动起点s2。步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s2下方100像素处作为新起点s

p

,p=3,并横向移动起点s3,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。以起点s3下方100像素处作为起点s

p

,p=4,并横向移动起点s4,步长step为100,依次裁剪出图片尺寸为m

×

n的图像。重复上述步骤,使用前一个起点s

p

‑1下方100像素处作为下一个起点s

p

的方式改变起点,直到起点距离图像边缘不再满足m

×

n裁剪条件。再进行以图像中心为裁剪图像的中心、裁剪大小为300

×

300的设定裁剪,得到的s

n4

张新显微图片,以达到数据增强的效果。

[0131]

去除噪音的方法可以采用均值滤波法、高斯滤波法和双边滤波法,引导滤波法,nlm算子,bm3d算子,频域滤波法,小波域滤波法,p

‑

m方程去噪法,tv法去噪中的任意一种或几种。

[0132]

步骤d、建立每一种设定的采集条件下的具有多尺度注意力机制的神经网络模型model

nx

,如图1所示。

[0133]

步骤d

‑

1、建立多尺度注意力模块mam(multiscale attention mechanism),如图2所示。

[0134]

步骤d

‑1‑

1、建立注意力模块1,如图3所示。

[0135]

第一步、将输入的特征图的每一个通道上整个空间特征通过全局平均池化编码为一个全局特征f

sq

,f

sq

公式如下:

[0136][0137]

其中,f表示输入的特征图,f∈r

w

×

h

×

c

,表示c个w

×

h的通道特征图,w表示每个通道的宽,h表示每个通道的高,c表示通道的个数,r为自然数,z

c

表示f

sq

得到的结果。当然按照设定采集条件分组进行输入。且输入时,同时输入图片设定的年份标签s。

[0138]

第二步、计算特征1权重f

ex

。

[0139]

第二步的目的是完全捕获通道依赖关系。第一个全连接层起到降维的作用,然后采用relu激活。最后利用第二个全连接层恢复原始输入特征的维度,得到特征权重f

ex

,也就是纸张图片中完整的纤维形态特征在全局特征中的权重。

[0140]

f

ex

公式如下:

[0141]

s

c

=f

ex

(z

c

,w

f

)=σ(g(z

c

,w

f

))=σ(w2δ(w1z

c

))

[0142]

其中,s

c

表示f

ex

得到的结果,w

f

表示全连接层操作,w1表示第一个全连接层操作,

w2表示第二个全连接层操作,表示第二个全连接层操作,σ表示sigmoid函数,降维系数为r是个超参数。

[0143]

步骤d

‑1‑

2、将注意力模块1得到的局部特征和全局特征进行混合,得到混合特征f

mix1

。全局特征表示古籍纸张显微图片的全局堆叠形态特征。将局部特征权重乘以全局特征,得到表示完整的纤维形态特征的局部特征。最后把局部特征和全局特征进行相加,得到通道混合特征f

mix1

,f

mix1

中不仅包含了古籍纸张显微图片的全局堆叠形态特征,还包含了完整的纤维形态特征。

[0144]

根据注意力模块1得到的特征1权重f

ex

进行计算,得到混合特征f

mix1

。

[0145]

f

mix1

=s

c

×

f f

[0146]

其中,c表示通道数目,s

c

用来刻画f中c个特征图的权重。而且这个权重是通过前面这些全连接层和非线性层学习得到的,这两个全连接层的作用就是融合各通道的特征图信息。

[0147]

步骤d

‑1‑

3、建立注意力模块2,如图4所示。

[0148]

注意力模块2可以定位到具有独特特征的纤维形态的区域,更加关注有鉴别性的纤维形态特征。计算特征2权重f

sp

,也就是纸张图片中独特的纤维形态特征在全局特征中的权重。f

sp

公式如下:

[0149][0150]

其中,f表示输入的特征图,即步骤c中s

×

k

×

sum张增强后的图像的特征图,f7×7表示一个卷积核尺寸为7

×

7的卷积操作。f

sp

操作是先通过平均池化操作和最大池化操作来聚合一个特征图的通道信息,生成和之后和被拼接在一起,并通过7

×

7的卷积操作,生成空间注意力图。

[0151]

步骤d

‑1‑

4、注意力模块2得到的局部特征和全局特征进行混合,得到混合特征f

mix2

。f

mix2

不仅包含了古籍纸张显微图片的全局堆叠形态特征,还包含了鉴定性纤维形态特征。

[0152]

根据注意力模块2得到特征2权重f

sp

进行计算,得到混合特征f

mix2

。

[0153]

f

mix2

=f

sp

×

f f

[0154]

步骤d

‑1‑

5、把混合特征f

mix1

和混合特征f

mix2

进行相加,得到多尺度特征f

mix

。

[0155]

f

mix

=f

mix1

f

mix2

。

[0156]

f

mix

不仅包含了古籍纸张显微图片的全局堆叠形态特征和完整的纤维形态特征,还包含了鉴定性纤维形态特征。

[0157]

步骤d

‑

2、将多尺度注意力模块mam加载标准的神经网络模型中,再将融合后的神经网络模型与回归模型组合,形成古籍年份分析模型,将每一种设定采集条件c

x

下的数据集通过古籍年份分析模型训练,得到与设定采集条件c

x

下的训练好的基于多尺度注意力机制的神经网络模型model

nx

。

[0158]

本实施例中,如图1所示,本文设计的卷积神经网络(cnn)模型是在xception的每个残差后加入优化后的多尺度注意力模块mam(multiscale attention mechanism),用于提取纸张纹理图像的纹理特征。而且卷积神经网络模型使用损失函数。损失函数公式如下:

[0159][0160]

其中α和β是权重,可以自行定义。yi是预测值,是真实值,n表示测试数据的个数。

[0161]

如图5、图6和图7所示,本实施例中,神经网络模型model

nx

依次包含四个部分:entry flow,middle flow,exit flow和gru flow。其中,entry flow结构是model

nx

的起始部分,entry flow结构输出的特征图作为middle flow结构的输入,而且middle flow结构会重复使用8次。接着,第8个middle flow结构输出的特征图作为exit flow结构的输入。最后,exit flow结构的输出是gru模型的输入,最终gru模型输出待鉴定纸张的预测标签和标签概率值。

[0162]

本实施例中,神经网络模型model

nx

的entry flow网络结构如下:

[0163]

步骤1、输入是书籍纸张显微图片,图片大小转化为299*299*3(大于该尺寸的图片,自动缩放至这个尺寸)。

[0164]

步骤2、第一层是卷积层,有32个卷积核,卷积核的大小是3*3,卷积的步长是2*2,使用bn层进行batch normalization归一化,激活函数是relu。

[0165]

步骤3、第二层是卷积层,有64个卷积核,卷积核的大小是3*3,使用bn层进行batch normalization归一化,激活函数是relu。

[0166]

步骤4、进行第一种xception残差模块,具体结构如下:

[0167]

a)深度可分离卷积层(depthwise separable convolution):有128个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化。

[0168]

b)深度可分离卷积层(depthwise separable convolution):有128个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0169]

c)最大值池化:卷积核大小是3*3,步长是2*2。

[0170]

d)步骤3的输出进行卷积操作,有128个卷积核,卷积核大小为1*1,步长为2*2。

[0171]

e)步骤c)的输出和步骤d)的输出相加。

[0172]

步骤5、进行多尺度注意力模块mam,具体结构如下:

[0173]

a)步骤4的输出作为输入,进行全局池化层。

[0174]

b)全连接层:缩放参数r为8,维度是第一种xception残差模块输出的通道数除以8,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0175]

c)全连接层:维度是第一种xception残差模块输出的通道数,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0176]

d)步骤c)的输出和步骤4的输出相乘。

[0177]

e)步骤d)的输出和步骤4的输出相加。

[0178]

f)步骤4的输出作为输入,进行全局池化层。

[0179]

g)步骤4的输出作为输入,进行最大池化层。

[0180]

h)步骤f)的输出和步骤g)的输出进行concatenate操作,实现水平拼接

[0181]

i)步骤h)的输出进行卷积层,有个卷积核,步长为1,激活函数为sigmoid,卷积核的初始化器为均匀分布初始化,不使用偏置项。

[0182]

j)步骤i)的输出和步骤4的输出相乘。

[0183]

k)步骤j)的输出和步骤4的输出相加。

[0184]

l)步骤e)的输出和步骤k)的输出相加。

[0185]

步骤6、进行第一种xception残差模块,具体结构如下:

[0186]

a)深度可分离卷积层(depthwise separable convolution):有256个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0187]

b)深度可分离卷积层(depthwise separable convolution):有256个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0188]

c)最大值池化:卷积核大小是3*3,步长是2*2。

[0189]

d)步骤5的输出进行卷积操作,有256个卷积核,卷积核大小为1*1,步长为2*2。

[0190]

e)步骤c)的输出和步骤d)的输出相加。

[0191]

步骤7、进行多尺度注意力模块mam,具体结构如下:

[0192]

a)步骤6的输出作为输入,进行全局池化层。

[0193]

b)全连接层:缩放参数r为8,维度是第一种xception残差模块输出的通道数除以8,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0194]

c)全连接层:维度是第一种xception残差模块输出的通道数,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0195]

d)步骤c)的输出和步骤6的输出相乘。

[0196]

e)步骤d)的输出和步骤6的输出相加。

[0197]

f)步骤6的输出作为输入,进行全局池化层。

[0198]

g)步骤6的输出作为输入,进行最大池化层。

[0199]

h)步骤f)的输出和步骤g)的输出进行concatenate操作,实现水平拼接

[0200]

i)步骤h)的输出进行卷积层,有个卷积核,步长为1,激活函数为sigmoid,卷积核的初始化器为均匀分布初始化,不使用偏置项。

[0201]

j)步骤i)的输出和步骤6的输出相乘。

[0202]

k)步骤j)的输出和步骤6的输出相加。

[0203]

l)步骤e)的输出和步骤k)的输出相加。

[0204]

步骤8、进行第一种xception残差模块,具体结构如下:

[0205]

a)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0206]

b)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0207]

c)最大值池化:卷积核大小是3*3,步长是2*2。

[0208]

d)步骤6的输出进行卷积操作,有728个卷积核,卷积核大小为1*1,步长为2*2。

[0209]

e)步骤c)的输出和步骤d)的输出相加。

[0210]

步骤9、进行多尺度注意力模块mam,具体结构如下:

[0211]

a)步骤8的输出作为输入,进行全局池化层。

[0212]

b)全连接层:缩放参数r为8,维度是第一种xception残差模块输出的通道数除以8,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0213]

c)全连接层:维度是第一种xception残差模块输出的通道数,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0214]

d)步骤c)的输出和步骤8的输出相乘。

[0215]

e)步骤d)的输出和步骤8的输出相加。

[0216]

f)步骤8的输出作为输入,进行全局池化层。

[0217]

g)步骤8的输出作为输入,进行最大池化层。

[0218]

h)步骤f)的输出和步骤g)的输出进行concatenate操作,实现水平拼接

[0219]

i)步骤h)的输出进行卷积层,有个卷积核,步长为1,激活函数为sigmoid,卷积核的初始化器为均匀分布初始化,不使用偏置项。

[0220]

j)步骤i)的输出和步骤8的输出相乘。

[0221]

k)步骤j)的输出和步骤8的输出相加。

[0222]

步骤e)的输出和步骤k)的输出相加。

[0223]

本实施例中,神经网络模型model

nx

的middle flow网络结构如下:

[0224]

步骤1、进行第二种xception残差模块,具体结构如下:

[0225]

a)深度可分离卷积层(depthwise separableconvolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0226]

b)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0227]

c)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0228]

d)步骤1)的输入进行卷积操作,有728个卷积核,卷积核大小为1*1,步长为2*2。

[0229]

e)步骤a)的输出和步骤d)的输出相加。

[0230]

步骤2、进行多尺度注意力模块mam,具体结构如下:

[0231]

a)步骤1的输出作为输入,进行全局池化层。

[0232]

b)全连接层:缩放参数r为8,维度是第一种xception残差模块输出的通道数除以8,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0233]

c)全连接层:维度是第一种xception残差模块输出的通道数,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0234]

d)步骤c)的输出和步骤1的输出相乘。

[0235]

e)步骤d)的输出和步骤1的输出相加。

[0236]

f)步骤1的输出作为输入,进行全局池化层。

[0237]

g)步骤1的输出作为输入,进行最大池化层。

[0238]

h)步骤f)的输出和步骤g)的输出进行concatenate操作,实现水平拼接

[0239]

i)步骤h)的输出进行卷积层,有个卷积核,步长为1,激活函数为sigmoid,卷积核的初始化器为均匀分布初始化,不使用偏置项。

[0240]

j)步骤i)的输出和步骤1的输出相乘。

[0241]

k)步骤j)的输出和步骤1的输出相加。

[0242]

l)步骤e)的输出和步骤k)的输出相加。

[0243]

步骤1和步骤2重复使用8次运算。第一个middle flow的步骤1的输入是model

nx

的entry flow的输出,第二个middle flow的步骤1的输入是第一个middle flow的步骤2的输出。以此类推,第二个到第8个middle flow的输入均是前一个middle flow的输出。

[0244]

本实施例中,神经网络模型model

nx

的exit flow网络结构如下:

[0245]

步骤1、第8个middle flow的输出作为输入,进行第一种xception残差模块,具体结构如下:

[0246]

a)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0247]

b)深度可分离卷积层(depthwise separable convolution):有728个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0248]

c)最大值池化:卷积核大小是3*3,步长是2*2。

[0249]

d)model

nx

的第8个middle flow的输出进行卷积操作,有728个卷积核,卷积核大小为1*1,步长为2*2。

[0250]

e)步骤c)的输出和步骤d)的输出相加。

[0251]

步骤2、进行多尺度注意力模块mam,具体结构如下:

[0252]

a)步骤1的输出作为输入,进行全局池化层。

[0253]

b)全连接层:缩放参数r为8,维度是第一种xception残差模块输出的通道数除以8,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0254]

c)全连接层:维度是第一种xception残差模块输出的通道数,激活函数是relu,卷积核的初始化器为均匀分布初始化,使用偏置项,偏置项的初始化器默认初始化为0;

[0255]

d)步骤c)的输出和步骤1的输出相乘。

[0256]

e)步骤d)的输出和步骤1的输出相加。

[0257]

f)步骤1的输出作为输入,进行全局池化层。

[0258]

g)步骤1的输出作为输入,进行最大池化层。

[0259]

h)步骤f)的输出和步骤g)的输出进行concatenate操作,实现水平拼接

[0260]

i)步骤h)的输出进行卷积层,有个卷积核,步长为1,激活函数为sigmoid,卷积核

的初始化器为均匀分布初始化,不使用偏置项。

[0261]

j)步骤i)的输出和步骤1的输出相乘。

[0262]

k)步骤j)的输出和步骤1的输出相加。

[0263]

l)步骤e)的输出和步骤k)的输出相加。

[0264]

步骤3、深度可分离卷积层(depthwise separable convolution):有1536个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0265]

步骤4、深度可分离卷积层(depthwise separable convolution):有2048个卷积核,卷积核的大小是3*3,步长是1*1,使用bn层进行batch normalization归一化,激活函数是relu。

[0266]

步骤5最大值池化。

[0267]

本实施例中,神经网络模型model

nx

的gru结构如下:

[0268]

如图7所示,exit flow的输出,为gru的输入,一个门控循环单元gru:维度为2048。全连接层:维度为1。最终神经网络模型model

nx

输出待鉴定纸张的预测标签和标签概率值。

[0269]

当然,每一种设定条件相应采集得到的显微图片用数组分别作为输入,得到的相应训练好的卷积神经网络模型表示为model

n1

,本实施例具体如下:

[0270]

第一种设定采集条件c1为光学放大倍率为40且光源环境为白光背光,相应采集得到的显微图片用数组表示为i1={i

1t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n1

。

[0271]

第二种设定采集条件c2为光学放大倍率为40且光源环境为白光侧光,相应采集得到的显微图片用数组表示为i2={i

2t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n2

。

[0272]

第三种设定采集条件c3为光学放大倍率为80且光源环境为白光背光,相应采集得到的显微图片用数组表示为i3={i

3t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n3

。

[0273]

第四种设定采集条件c4为光学放大倍率为80且光源环境为白光侧光,相应采集得到的显微图片用数组表示为i4={i

4t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n4

。

[0274]

第五种设定采集条件c5为光学放大倍率为40且光源环境为红外光,相应采集得到的显微图片用数组表示为i5={i

5t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n5

。

[0275]

第六种设定采集条件c6为光学放大倍率为40且光源环境为紫外光,相应采集得到的显微图片用数组表示为i6={i

6t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n6

。

[0276]

第七种设定采集条件c7为光学放大倍率为80且光源环境为红外光,相应采集得到的显微图片用数组表示为i7={i

7t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经网络模型表示为model

n7

。

[0277]

第八种设定采集条件c8为光学放大倍率为80且光源环境为紫外光,相应采集得到的显微图片用数组表示为i8={i

8t

|t=1,2,3

…

,k},k=30。得到的相应训练好的卷积神经

网络模型表示为model

n8

。

[0278]

步骤e、确定待鉴定纸张的所属年份。

[0279]

步骤e

‑

1、获得待的鉴定纸张的若干个预测标签及标签概率值。

[0280]

采集待测纸张的所有8种设定采集条件c

x

下的显微图片的采集,每种设定的采集条件c

x

下采集a张图片,a>1。,共a

×

8个图片。

[0281]

将每一张图片作为输入,输入到相应采集条件c

x

下的训练好的基于多尺度注意力机制的神经网络模型model

nx

中,进行图像纹理特征提取,然后再使用对应的训练好的卷积神经网络模型分别进行图像纹理特征分类。

[0282]

该神经网络模型model

nx

输出每一张图片预测标签及标签概率值,即获得a

×

x个预测标签及标签概率值。

[0283]

步骤e

‑

2、根据a

×

x个预测标签及标签概率值,计算获得待鉴定纸张最终预测标签及最终标签概率值。

[0284]

每个采集条件c

x

下的训练好的基于多尺度注意力机制的神经网络模型model

nx

获得的预测标签及其标签概率值设定相应的权重值weight。

[0285]

将预测标签相同的分为一组,计算每组中的预测标签对应的概率值*相应的weight的平均值。

[0286]

最后,平均值最高的那一组所对应的预测标签即为最终预测标签(年份),以及最高那组的平均值为最终标签概率值。

[0287]

最终预测标签(年份)就是待鉴定纸张的最后所属类别标签,该类别标签即为最终鉴定结果即:

[0288]

其中按照权重重新计算标签概率值,具体方法为:weight是针对每一种设定采集条件下的图像分类权重,比如一张待鉴定纸张,每种设定采集条件下采集了a张图像,然后该种设定采集条件下的图像预测标签和概率值是按每张weight的权重进行分配,得到了这类环境下的预测标签和标签概率值,又因为本实施例中有8种设定采集条件,所以每种设定采集条件给予不同权重,前面四种设定采集条件下赋予的权重是0.2,其余四种设定采集条件分别赋予的权重0.05,这样8种设定采集条件下的预测标签和概率值按权重计算得到最终的纸张标签和概率值。当然,每种设定的采集条件的权重可以均等,这样只需要求每个预测标签和标签概率值的平均值即为最终预测标签和最终标签概率值。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。