1.本发明涉及一种基于图卷积网络与目标检测的动火作业识别方法,属于计算机视觉领域。

背景技术:

2.动火作业是在禁火区进行焊接与切割作业及在易燃易爆场所使用喷灯、电钻、砂轮等进行可能产生火焰、火花和炽热表面的临时性作业。为加强集团公司动火作业安全管理,确保人身、生产、设备安全,控制动火作业行为,减少和避免火灾事故和其它事故的发生。在判定画面中是否存在动火作业的电焊火焰时,传统的目标检测基于弱特征,难以处理遮挡、光照等因素造成的问题,因此识别精度不够高。

技术实现要素:

3.为解决上述问题,本发明采用神经网络对目标的表观特征和行为模式进行建模,并将两者的预测结果进行综合决策,输出画面中作业人员的动火行为情况,提高结果预测的准确度。

4.为实现上述目的,本技术采用以下技术方案予以实现:

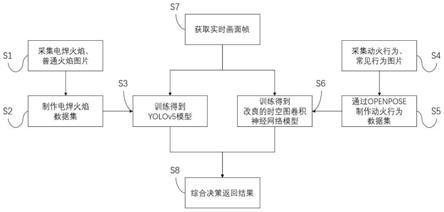

5.一种基于图卷积网络与目标检测的动火作业识别方法,该方法包括以下步骤:

6.s1:采集带有电焊火和其他普通火焰的视频和图片;

7.s2:截取带有电焊火和其他普通火焰的画面,保存不同环境、不同角度、不同火焰种类的电焊火图片和普通火焰图片,其中电焊火为正样本,普通火焰为负样本,构建电焊火火焰数据集;

8.s3:将电焊火火焰数据集放入yolov5网络模型中训练,得到用于检测电焊火和普通火焰的yolov5网络模型;

9.s4:采集带有电焊动火行为和其他常见行为的视频和图片;

10.s5:截取带有电焊动火行为和其他常见行为的画面,保存不同环境、不同角度的电焊动火行为和常见行为的视频,其中动火行为为正样本,常见行为为负样本,放入openpose网络模型中,得到动火行为的关节点数据集;

11.openpose网络模型得到的人体骨架可以看作为一种拓扑图,而连续视频帧的检测结果序列则由多个这样的拓扑图组成,对于一段视频中的骨架拓扑图序列a

g

,其表达式如下:

[0012][0013]

其中,表示在第f帧时骨架拓扑图中的第i个关节点;表示在第f帧时骨架拓扑图中的第i个关节点和第j个关节点之间的连接边;表示在第f帧时骨架拓扑图中的第i个关节点和第f 1帧时骨架拓扑图中的第i个关节点之间的连接边;i,j=1,2,

…

,i,i为

设定的将人体骨架分解的关节点数;f=1,2,

…

,f,f为骨架拓扑图序列a

g

的长度,f=t

×

r,t为视频的时长,r为视频的帧率,即f也为视频的总帧数;

[0014]

s6:将动火行为的关节点数据集放入改良的时空图卷积神经网络模型中训练,得到用于识别电焊动火行为的时空图卷积神经网络模型;

[0015]

由于根节点周围不具有刚性网格结构,定义一个分区规则使得根节点及其邻居集能够被卷积;将邻居集分为固定数量的n个子集,分别为(1)根节点自身,(2)比根节点更接近骨架重心,同时比骨架重心更接近区域重心的邻居节点,(3)比根节点更接近骨架重心,同时比骨架重心更远离区域重心的邻居节点,(4)比根节点更远离骨架重心,同时比骨架重心更接近区域重心的邻居节点(5)比根节点更远离骨架重心,同时比骨架重心更远离区域重心的邻居节点;分区规则的数学表示如下:

[0016][0017]

其中d

c

为根节点到骨架重心的距离,d

j

为邻居节点到骨架重心的距离;a

c

为骨架重心到区域重心的距离,a

j

为邻居节点到区域重心的距离,距离均采用欧式距离,骨架重心为所有关节点的坐标均值,区域重心为所有邻居节点的坐标均值;

[0018]

采用上述分区规则能让时空图卷积神经网络的区域卷积部分学习到不同动作的更多潜在特征,从而使最终得到的网络对动作的识别更加精确;

[0019]

s7:获取摄像头实时画面帧;

[0020]

s8:将实时画面帧的检测结果综合决策,判断该画面中各人员的动火行为其步骤如下:

[0021]

s81:使用欧氏距离,对openpose识别出的每个人体骨架中的关节点与yolov5检测的火焰坐标进行加权求和,其公式如下:

[0022][0023]

其中p

i

为openpose检测到的第i个人体骨架,o

j

为yolov5网络检测到的第j个火焰目标框,为第j个火焰目标框的中心点,为第i个人体骨架上的第m个关节点,ρ2( )为欧氏距离,w

m

为人体骨架的各关节点至火焰目标框中心点的距离所对应的加权权重;对每个人体骨架的各关节点至火焰目标框中心点的距离加权求和,作为第i个人体骨架和第j个火焰目标框的相关程度;

[0024]

考虑到人的动作姿态比较复杂,只考虑人体目标框和火焰目标框两者中心点的欧式距离作为匹配标准,无法准确判断图像中的哪个人正在进行动火行为;例如当多个人体目标框与某个火焰的目标框的距离比较接近时,难以判断他们与火焰之间的动火关系;

[0025]

该方式会将人体骨架中的眼、手、脚等关节点至火焰目标框中心点的权重提高,将其他相关程度较低的关节点的权重降低,当人体骨架中的某些关节点识别不全时,也需要

对其他关节点的权重进行相应调整,这样计算出来的加权值更能表征人与火焰的匹配程度,能在一定程度上解决上述问题。

[0026]

s82:对人体骨架与火焰进行匹配,最终可以得到图像中有无动火行为,及各火焰的相应负责人;设定集合a和集合b如下:

[0027]

a=o

c

[0028][0029]

其中,o

c

为yolov5网络模型检测的电焊火焰的目标框中心点集合,p

c

为openpose网络模型检测的人体骨架中心点集合,r

i

为时空图卷积神经网络对画面中第i个人体骨架的动作预测结果,值为1表示动火行为,n为当前画面中的人体骨架数,因此集合b只包含被检测为动火行为的人体骨架的中心点;

[0030]

基于匈牙利算法思想,将画面中各电焊火焰与动火人员进行匹配,最后输出画面中动火检测结果,包括有无动火行为,和电焊火焰的对应负责人。

附图说明

[0031]

图1为基于监控视频的作业区动火检测方法流程图;

[0032]

图2为部分关节点的分区策略示例图;

[0033]

图3为存在动火行为的视频帧;

具体实施方式

[0034]

一种基于图卷积网络与目标检测的动火作业识别方法,该方法包括以下步骤:

[0035]

s1:采集带有电焊火和其他普通火焰的视频和图片;

[0036]

s2:截取带有电焊火和其他普通火焰的画面,保存不同环境、不同角度、不同火焰种类的电焊火图片和普通火焰图片,其中电焊火为正样本,普通火焰为负样本,构建电焊火火焰数据集;

[0037]

s3:将电焊火火焰数据集放入yolov5网络模型中训练,得到用于检测电焊火和普通火焰的yolov5网络模型;

[0038]

s4:采集带有电焊动火行为和其他常见行为的视频和图片;

[0039]

s5:截取带有电焊动火行为和其他常见行为的画面,保存不同环境、不同角度的电焊动火行为和常见行为的视频,其中动火行为为正样本,常见行为为负样本,放入openpose网络模型中,得到动火行为的关节点数据集;

[0040]

openpose网络模型得到的人体骨架可以看作为一种拓扑图,而连续视频帧的检测结果序列则由多个这样的拓扑图组成,对于一段视频中的骨架拓扑图序列a

g

,其表达式如下:

[0041][0042]

其中,表示在第f帧时骨架拓扑图中的第i个关节点;表示在第f帧时骨架拓扑图中的第i个关节点和第j个关节点之间的连接边;表示在第f帧时骨架拓扑图中的第i个关节点和第f 1帧时骨架拓扑图中的第i个关节点之间的连接边;i,j=1,2,

…

,i,i为

设定的将人体骨架分解的关节点数;f=1,2,

…

,f,f为骨架拓扑图序列a

g

的长度,f=t

×

r,t为视频的时长,r为视频的帧率,即f也为视频的总帧数;

[0043]

s6:将动火行为的关节点数据集放入改良的时空图卷积神经网络模型中训练,得到用于识别电焊动火行为的时空图卷积神经网络模型;

[0044]

由于根节点周围不具有刚性网格结构,定义一个分区规则使得根节点及其邻居集能够被卷积;如图2所示,以两个根节点为例,将它们的邻居集按以下5种条件进行划分,分别为(1)根节点自身,为图2中的a节点;(2)比根节点更接近骨架重心,同时比骨架重心更接近区域重心的邻居节点,为图2中的b节点;(3)比根节点更接近骨架重心,同时比骨架重心更远离区域重心的邻居节点,为图2中的c节点;(4)比根节点更远离骨架重心,同时比骨架重心更接近区域重心的邻居节点,为图2中的d节点;(5)比根节点更远离骨架重心,同时比骨架重心更远离区域重心的邻居节点,为图2中的e节点;分区规则的数学表示如下:

[0045][0046]

其中d

c

为根节点到骨架重心的距离,d

j

为邻居节点到骨架重心的距离,如图2中各节点与五角星之间的虚线所示;a

c

为骨架重心到区域重心的距离,a

j

为邻居节点到区域重心的距离,如图2中各节点与四角星之间的虚线所示;距离均采用欧式距离,骨架重心为所有关节点的坐标均值,如图2中的五角星所示;区域重心为根节点的所有邻居节点的坐标均值,如图2中的四角星所示;

[0047]

采用上述分区规则能让时空图卷积神经网络的区域卷积部分学习到不同动作的更多潜在特征,从而使最终得到的网络对动作的识别更加精确;

[0048]

s7:获取摄像头实时画面帧;

[0049]

s8:将实时画面帧的检测结果综合决策,判断该画面中各人员的动火行为,其步骤如下:

[0050]

s81:使用欧氏距离,对openpose识别出的每个人体骨架中的关节点与yolov5检测的火焰坐标进行加权求和,其公式如下:

[0051][0052]

其中p

i

为openpose检测到的第i个人体骨架,o

j

为yolov5网络检测到的第j个火焰目标框,为第j个火焰目标框的中心点,为第i个人体骨架上的第m个关节点,ρ2( )为欧氏距离,w

m

为人体骨架的各关节点至火焰目标框中心点的距离所对应的加权权重;对每个人体骨架的各关节点至火焰目标框中心点的距离加权求和,作为第i个人体骨架和第j个火焰目标框的相关程度;

[0053]

考虑到人的动作姿态比较复杂,只考虑人体目标框和火焰目标框两者中心点的欧

式距离作为匹配标准,无法准确判断图像中的哪个人正在进行动火行为;例如当多个人体目标框与某个火焰的目标框的距离比较接近时,难以判断他们与火焰之间的动火关系;

[0054]

该方式会将人体骨架中的眼、手、脚等关节点至火焰目标框中心点的权重提高,将其他相关程度较低的关节点的权重降低,当人体骨架中的某些关节点识别不全时,也需要对其他关节点的权重进行相应调整,这样计算出来的加权值更能表征人与火焰的匹配程度,能在一定程度上解决上述问题;

[0055]

s82:对人体骨架与火焰进行匹配,最终可以得到图像中有无动火行为,及各火焰的相应负责人;设定集合a和集合b如下:

[0056]

a=o

c

[0057][0058]

其中,o

c

为yolov5网络模型检测的电焊火焰的目标框中心点集合,p

c

为openpose网络模型检测的人体骨架中心点集合,r

i

为时空图卷积神经网络对画面中第i个人体骨架的动作预测结果,值为1表示动火行为,n为当前画面中的人体骨架数,因此集合b只包含被检测为动火行为的人体骨架的中心点;

[0059]

基于匈牙利算法思想,将画面中各电焊火焰与动火人员进行匹配,最后输出画面中动火检测结果,包括有无动火行为,和电焊火焰的对应负责人;

[0060]

如图3所示,将检测到的电焊火焰目标和人体骨架都用矩形框标示出;将画面中的各人体骨架和电焊火焰进行匹配,最后输出画面内的电焊动火行为识别结果。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。