1.本发明属于计算机视觉领域,特别涉及一种运用事件相机和深度相机完成对快速动作的识别和质量评估技术。

背景技术:

2.基于光学传感器的视觉相机采集一段时间内像素的亮度值积累,受到感光和数据读取速率的限制,帧率非常有限,而且存在易受环境光照的影响、硬件性能要求高、能耗大,延迟大等缺点,同时对于高速运动的物体存在运动模糊和响应时间长的问题,用于动作识别和评估效果不理想。事件相机是一种特殊的只对像素亮度变化敏感的相机,是一种新型的神经拟态视觉传感器,其脉冲神经形态系统具有异步、低功耗、低计算吞吐量,高动态范围、高时间分辨率以及与场景环境的动态关系等特点,可以提供微秒级的响应信号,其反应速度和动态范围大大优于现有的普通光学相机,因而很适合应用在高动态目标检测的场合

3.动作训练与质量评估是目前竞技体育研究的热点问题,例如羽毛球击球瞬间动作的规范性,包括肩、肘和腕部的运动轨迹是否正确,这会影响发力和击球的效果;乒乓球的发球和扣球动作、轨迹分析和步伐分析;体操动作标准性分析等问题。由于竞技类运动动作快速、复杂(需要身体各部分地协同参与),基于光学相机的训练评估系统无法捕获快速的运动轨迹和肢体形态,无法有效的评价动作质量,无法提供有效的训练指导。

技术实现要素:

4.为解决上述技术问题,本发明提供一种基于事件相机和视觉相机协同的运动训练评估系统及方法,通过视觉相机和事件相机协同,不仅可以评估快速动作的精准度,还能以可视情景交互的形式进行标准动作示教和训练。

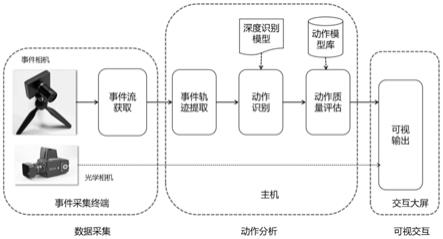

5.本发明采用的技术方案之一为:一种基于事件相机和视觉相机协同的运动训练评估系统,包括:事件采集终端、主机、以及交互端;

6.所述事件采集终端包括事件相机与事件流获取模块,事件流获取模块通过usb连接到事件相机;

7.所述主机包括事件轨迹提取模块、动作识别模块和动作质量评估模块;事件轨迹提取模块根据事件采集终端的输出提取事件轨迹,动作识别模块根据提取的事件轨迹进行动作识别,动作质量评估模块对识别的动作进行评估;

8.所述交互端用于显示动作识别结果;

9.所述事件采集终端还包括光学相机,用于将采集的视频流传输至交互端进行动作回放。

10.所述事件相机用于实时捕获目标区域的运动事件。

11.每个事件为一个四元组,表示为[x,y,t,p],其中x、y为像素坐标,t为时间戳,p为极性,极性用于表示亮度的增加或降低。

[0012]

所述光学相机采用rgb相机。

[0013]

本发明采用的技术方案之二为:一种基于事件相机和视觉相机协同的运动训练评估方法,包括:

[0014]

s1、将事件相机实时捕获的目标区域的运动事件表示为:

[0015]

e

t

=(x,y,t,p)

[0016]

其中,x、y为像素坐标,t为时间戳,p为极性,极性用于表示亮度的增加或降低;

[0017]

s2、将捕获的运动事件转换为事件流图像;

[0018]

s3、对每一个事件流图像,提取其中的事件轨迹;

[0019]

s4、提取时间轨迹中的特征;

[0020]

s5、将提取出的特征输入长短时记忆网络,输出动作类别与动作相似度。

[0021]

步骤s3具体为:

[0022]

a1、在事件流图像e

i

中,对每个事件点p

i

(x,y,v

i

),若事件发生次数v

i

小于阈值ε,则更新该时间点的v

i

=0,消除运动不显著点;ε=α

·

average(v

i

),v

i

>0,1≥α≥0,α为过滤系数;

[0023]

a2、对经步骤a1处理后的事件流图像e

i

进行形态学先膨胀再腐蚀闭运算;

[0024]

a3、对经步骤a2处理后的事件流图像e

i

中每个事件点,消除离群噪声点。

[0025]

步骤a3具体包括以下分步骤:

[0026]

a31、按照邻域扩展的方式逐步搜索当前事件流图像中每个事件点的邻域,计算各事件点邻域中与其最近点之间的欧式距离;对找到的第一个点,计算其欧氏距离;

[0027]

a32、根据当前事件流图像中所有事件点的最近的欧氏距离,得到当前事件流图像对应的最近欧氏距离表;

[0028]

a33、根据当前事件流图像对应的最近欧氏距离表,计算欧氏距离分布的平均值和标准差;

[0029]

a34、若某个事件点的最近的欧式距离大于均值与标准差之和,则将其作为离群噪声点去除,记留下来的事件图像为et

i

;

[0030]

a35、使用canny边检测法从et

i

中提取其边缘信息保存为边图e

i

,每个事件流图对应一个边图。

[0031]

本发明的有益效果:本发明以事件流形式提供连续的人体运动事件,可达到毫秒级运动响应,且不受高速运动物体运动模糊效应的影响,还能够提供更高的动态范围,在强光、逆光、明暗变化剧烈的场景下可提供更有效的运动训练评估;本发明的方法根据动作各个微阶段的位置重构成动作的轨迹,并通过深度学习方法得到轨迹特征,从而实现动作识别和质量评估。

附图说明

[0032]

图1为本发明的系统结构;

[0033]

图2为本发明实施例提供的事件流图像生成示意图;

[0034]

图3为本发明实施例提供的动作事件空间描述示意图。

具体实施方式

[0035]

为便于本领域技术人员理解本发明的技术内容,下面结合附图对本发明内容进一步阐释。

[0036]

如图1所示系统包括数据采集终端、主机和交互大屏三部分。

[0037]

各部分功能简介如下:

[0038]

事件采集终端:包括事件相机和事件流获取模块,事件流获取模块通过usb连接到事件相机,并实时捕获目标区域的运动事件并输出高动态事件流数据。每个事件由包含像素坐标x、y、时间戳t(触发事件的时间标记)、极性p四个元素的元组表示,即[x,y,t,p],其中极性表示亮度的增加或降低。

[0039]

光学相机:rgb相机,采集动作视频,用于可视交互;光学相机通过usb3.0接口和usb线缆连接到主机。

[0040]

主机:主要为高配置计算机系统,主要完成事件流数据分析,判断动作的类别及评估动作的准确度,输出动作与标准动作的误差。包括事件轨迹提取、动作识别和动作质量评估三个主要功能模块,基于深度学习的动作识别模型和标准动作模式库;主机通过hdmi接口连接到交互大屏,主机可存储和对视频进行编解码及输出;主机和事件采集终端之间通过usb3.0接口和usb线缆连接。

[0041]

交互大屏:提供动作回放、动作误差显示、实时动作视频播放和动作示教等显示输出。实现友好的人机交互。

[0042]

本发明的方法流程包括以下步骤:

[0043]

s1:事件流获取与表示

[0044]

所述步骤s1中,主要包括事件表示和将相机捕获的事件转换为事件流图像,并对事件流图像进行预处理。

[0045]

(1)事件表示

[0046]

e

t

=(x,y,t,p)

[0047]

用四元组来(x,y,t,p)表示一个事件,其中x、y为事件发生的像素点二维坐标,t为事件产生的时间戳,单位为毫秒;p为事件信号的极性,亮度降低超过阈值为

‑

1,亮度升高超过阈值为 1,亮度变化未超过阈值时,则不产生事件。本实施例中阈值设置为0.2,表示亮度变化不超过20%;阈值为一个可设置的系统参数,不同的光照环境下需要进行调整,一般在系统启动后通过校准来设置该参数,如果采集到的事件流图像噪声比较多,需要增加阈值,反之亦然。

[0048]

(2)事件流图像

[0049]

由于事件相机是高动态,所以输出的是事件流,把某一个时刻(事件点)的输出保存为一个图像,就是事件流图像。

[0050]

事件流图像是流式的事件数据在事件维度上的积分图像,用事件三维数组表示,记为e

i

(x,y,v),其中x、y为事件图像的像素点二维坐标,i为事件流图像的序号,v为图像对应点的极性累加值。即

[0051]

[0052]

其中,δt=t

i

‑

t

i

‑1为第i个事件累计间隔时间,对于高速运动的人体动作,一般取10ms以下,可以根据具体的运动进行灵活设置,t

i

和t

i

‑1分别表示间隔终止和起始时间。δt固定长度,其取值方式采用如图2所示的滑动窗口模式,滑动窗口长度为w=δt/2。

[0053]

s2:事件轨迹获取

[0054]

对每一个事件流图像,需要提取其中的事件轨迹,在极短时间内人体的运动可以视为刚体运动,因此其边缘可以视为身体部分的轮廓,通过轮廓边缘可以得到运动轨迹,主要步骤如下:

[0055]

a1、在事件流图像e

i

中,对每个事件点p

i

(x,y,v

i

),v

i

<ε,即事件发生次数v

i

小于阈值ε,则v

i

=0,消除运动不显著点,减少后续计算量。其中ε=α

·

average(v

i

),v

i

>0,1≥α≥0,α为过滤系数。

[0056]

a2、消除运动不显著点后,对过滤后的事件流图像e

i

进行形态学先膨胀再腐蚀闭运算,

[0057]

a3、对e

i

中每个事件点,消除离群噪声点,具体包括以下分步骤:

[0058]

a31、按照邻域扩展的方式逐步搜索其邻域,对找到的第一个点,即最接近的事件点,计算其欧氏距离;

[0059]

a32、遍历整个事件点的最近欧氏距离表,并计算欧氏距离分布的平均值和标准差;

[0060]

a33、对距离最近点欧氏距离大于均值与标准差之和的数据点,将其作为离群噪声点去除;取保留下来的事件图像et

i

,输入下一步计算。

[0061]

a34、使用canny边检测法(1987年,由john canny等人在会议readings in computer vision,第184

‑

203页上发表的文章《a computational approach to edge detection》即《边缘检测的计算方法》提出)从et

i

中提取其边缘信息保存为边图e

i

,每个事件流图对应一个边图。

[0062]

s3:动作事件空间表示

[0063]

动作事件空间:表示一个动作从开始到结束时间段内所对应的空间信息变化情况。比如兵乓球扣球动作从开始到结束整个时间段所有动作的合集,动作空间表示用于根据动作合集提起动作轨迹特征,从而判断动作准确性和质量。

[0064]

一个动作是有一定的持续时间的,比如1秒或500毫秒;微阶段是指动作过程中的一小段时间,比如8ms,就是说一个动作过程可以看作是多个微动作构成的,本发明根据动作各个微阶段的位置重构成动作的轨迹,并通过深度学习方法得到轨迹特征,从而实现动作识别和质量评估。

[0065]

动作事件的空间描述如图3所示,动作事件由时间序列事流件边图构成,为了有效表达事件中的动作轨迹,采用三维卷积神经网络(3dcnn,3d convolutional neural networks)深度学习模型提取动作事件轨迹中的特征,模型每相邻n个边图e

i

作为一组输入cube

i

,相邻两组滑动n/4个图像,经3dcnn提取特征表达(x1,x2,

…

,x

m

);

[0066]

s4:动作识别

[0067]

如图3所示,提取的事件序列动作特征(x1,x2,

…

,x

m

)使用长短时记忆网络(long short term memory network,lstm)进行动作识别,模型输出动作类别及相似度。实现高动态动作的识别和相似度度量。

[0068]

s5:可视互动评估

[0069]

可视互动评估将训练动作轨迹、标准动作轨迹和视觉相机的视频流叠加输出,为训练者提供动作误差的可视展示,方便训练者改进动作,减少误差,提升训练效率。主要步骤如下:

[0070]

基于事件相机和视觉相机在互动训练场景配准时得到的变换矩阵参数,将原始获取的rgb图像转化为适配事件相机的成像大小的配准后图像;

[0071]

(1)根据识别的动作类型获取标准库中存储的标准动作轨迹,通过轨迹图像的尺度不变特征变换(scale

‑

invariant feature transform,sift)特征匹配确定动作匹配起始时间点;

[0072]

(2)从起始点开始,采用基于形状的方法计算标准动作轨迹和训练动作轨迹的相似性,实现动作质量评估;

[0073]

(3)根据事件流和视频流时间同步的特点,确定视觉相机中对应于时间信息的配准后图像;

[0074]

(4)将训练动作轨迹、标准动作轨迹叠加于配准图像得到可视互动评估结果;

[0075]

(5)训练者通过视频查看动作相似度和视觉误差,以改进动作,提升质量。

[0076]

本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的原理,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的权利要求范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。