1.本发明属于图像处理方法技术领域,涉及一种基于深层注意力机制的超分辨率重建方法。

背景技术:

2.注意力机制的概念可以用生活化的例子做出解释,比如当人们在阅读一本书的时候,会把注意力放在文字上面,而不会去关注书页上的空白区域,而当某一页有一幅彩色插图,人们往往又会被这张彩色插图吸引。人们的视觉系统倾向于关注图像中辅助判断的部分信息,并忽略掉不相关的信息。计算机视觉任务中,注意力机制会确保深度网络学习相对重要的信息,而忽略无关信息。2014年google团队首次把注意力机制运用到了一个图像分类的任务上。同年,bahdanau等人把他们的注意力模型广泛地运用到了一个机器译码的任务中。现如今的注意力机制已被广泛地应用于各个领域,xu等在2015年将有关注意力的机制研究运用到了一个图片表达的任务,并提出了硬、软注意力机制的概念。hu等在2017年将注意力机制运用到了目标检测任务中,提升了模型的识别效果。注意力机制可以分为硬注意力机制和软注意力机制。

3.硬注意力机制(hard

‑

attention)是一种0/1问题,它会保留输入信息中的重要特征,而忽略掉那些不重要的特征。比如在一些细粒度物体分类任务中,硬注意力机制可以对图像输入的关键信息进行定位,并将其作为下一步输入。此时的硬注意力机制可以有效减少网络模型的计算量,只选择对分类结果有用的特征信息,显著提高网络的计算效率与分类准确性。

4.软注意力机制(soft

‑

attention)关注的是一种[0,1]区域之间连续性地分布的问题,软注意力机制对每一被关注的区域,按关注程度的大小赋予0至1的权重。其训练过程可以直接依附于神经网络,并且更加关注通道这一区域,让每一个被关注区域都对结果产生作用,在计算量上相较于硬注意力机制会有所增加。

[0005]

根据软注意力机制关注点的不同,通常将其分为通道注意力机制、空间注意力机制。

技术实现要素:

[0006]

本发明的目的是提供一种基于深层注意力机制的超分辨率重建方法,该方法在结合通道注意力机制的同时,提出深度注意力机制模块,在深度维度对网络模型进行优化,将网络训练重点放在能提取到关键信息的卷积核上,实现对图像的超分辨率重建。

[0007]

本发明所采用的技术方案是,一种基于深层注意力机制的超分辨率重建方法,具体包括如下步骤:

[0008]

步骤1,获取低分辨率lr图像;

[0009]

步骤2,将步骤1中的低分辨率lr图像输入到深层注意力机制网络中,经过浅层特征提取模块提取,得到浅层特征图;

[0010]

步骤3,将步骤1中的低分辨率lr图像输入到深层注意力机制网络中,经过深层特征提取模块进行深度特征提取,得到深层特征图;将浅层特征图和深层特征图进行级联,得到级联特征图,对级联特征图进行给予权重分配,并对特征图降维,得到降维特征图;

[0011]

步骤4,将步骤3中得到的降维特征图与步骤1中获取的lr图像相加,学习特征残差,得到全局特征图;

[0012]

步骤5,将步骤4中得到的全局特征图输入到上采样模块中,将低分辨率特征图放大到输出尺度,最后在重建模块中对图像进行超分辨率重建。

[0013]

本发明的特点还在于:

[0014]

步骤1的具体操作为:

[0015]

步骤1.1,在网络上分别下载set5、set14、bsd100、urban100、manga109数据集;

[0016]

步骤1.2,对步骤1.1中的各个数据集进行4倍下采样预处理,得到各自对应的低分辨率lr图像。

[0017]

步骤2具体步骤为:

[0018]

将步骤1中的低分辨率lr图像输入到深层注意力机制网络中,经过浅层特征提取模块,通过两层带有relu激活函数的卷积层将输入网络的低分辨率图像变换到特征图空间,浅层特征提取过程的数学公式如(1)、(2):

[0019]

f

‑1=h

sfeb

(i

lr

)

ꢀꢀꢀ

(1);

[0020]

f0=h

sfeb

(f

‑1)

ꢀꢀꢀ

(2);

[0021]

式中,i

lr

代表低分辨率图像,h

sfeb

()代表潜层特征提取,f

‑1代表经过第一次潜层特征提取之后的结果,f0代表经过第二次潜层特征提取之后的结果。

[0022]

步骤3的具体过程为:

[0023]

步骤3.1,利用若干个包含了通道注意力机制的dfeb模块对特征图进行深度特征提取;

[0024]

步骤3.2,将经过浅层特征提取模块提取出的浅层特征图f

‑1、f0及经过深层特征模块提取出的深层特征图f1,f

d

,...f

d

级联在一起,得到的级联特征图,记作f

con

,数学表达公式如公式(3)所示:

[0025]

f

con

=[f

‑1,f0,f1,...,f

d

,...,f

d

]

ꢀꢀꢀ

(3);

[0026]

步骤3.3,利用dab模块在网络模型的深度维度,对级联特征图给予权重分配,并对级联特征图进行降维,得到降维特征图。

[0027]

步骤4的具体过程为:利用如下公式(4)得到全局特征图:

[0028]

f

gf

=f

df

i

lr

ꢀꢀꢀ

(4);

[0029]

其中,i

lr

代表低分辨率图像lr,f

df

代表降维后的加权特征图,f

gf

代表全局特征图。

[0030]

步骤5的具体过程为:

[0031]

步骤5.1,将步骤4得到的全局特征图f

gf

输入到上采样模块,采用反卷积的方式将低分辨率特征图放大到输出尺度;

[0032]

步骤5.2,在重建模块中采用一层卷积层对步骤5.1得到的图像进行超分辨率重建,最终得到重建后的高分辨率图片。

[0033]

本发明的有益效果是,本发明方法相较于一些传统的基于注意力机制的超分辨率重建方法来说,本方法提出的深度注意力机制模块(dab),在处理浅层网络与深层网络过程

中有进行权值优化。传统的注意力机制仅优化通道维度权重,而在处理浅层网络与深层网络过程中没有进行权值优化。本发明方法在训练时的收敛速度较快,同时在迭代次数相同时,相较于不含有dab模块的方法,在psnr与ssim评价指标上均取得了提升。

附图说明

[0034]

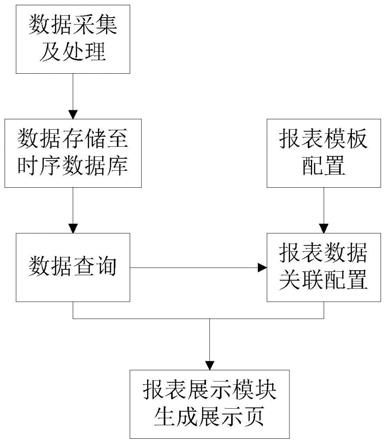

图1是本发明一种基于深层注意力机制的超分辨率方法的网络结构图;

[0035]

图2是本发明一种基于深层注意力机制的超分辨率方法网络结构图的深层特征提取模块(dfeb)模块结构图;

[0036]

图3是本发明一种基于深层注意力机制的超分辨率方法网络结构图中深层特征提取模块(dfeb)模块中的ca模块结构图;

[0037]

图4是本发明一种基于深层注意力机制的超分辨率方法网络结构图的dab模块结构图;

[0038]

图5(a)、(b)是使用本发明一种基于深层注意力机制的超分辨率方法进行的结果对比效果图;

[0039]

图6(a)、(b)是使用本发明一种基于深层注意力机制的超分辨率方法进行dab模块有效性验证的实验结果。

具体实施方式

[0040]

下面结合附图和具体实施方式对本发明进行详细说明。

[0041]

本发明一种基于深层注意力机制的超分辨率方法,如图1所示,i

lr

表示输入的低分辨率图片,sfeb代表浅层特征提取模块,f

‑1,f0为浅层特征提取模块得到的浅层特征图;dfeb代表深层特征提取模块,f1‑

f

d

为深层特征提取模块得到的深层特征图;concate代表级联操作,将浅层特征图f

‑1,f0,深层特征图f1,f

d

,...f

d

级联得到级联特征图f

con

;然后通过dab(deepattention block)模块赋予这些特征图新的权重,在深度维度建立注意力机制,得到加权特征图f

dab

;然后经过两个卷积操作,第一个卷积操作对dab模块得到的加权特征图先做降维操作,将特征图减少到64维,第二个卷积卷积操作将特征图降维至3通道,得到特征图f

df

;接下来与lr相加学习特征残差,得到全局特征图f

gf

再输入到上采样模块;上采样模块采用反卷积的方式将低分辨率特征图放大到输出尺度;最后在重建模块采用一层卷积层对图像进行超分辨率重建,得到高分辨率图片i

hr

。

[0042]

具体按照如下步骤实施:

[0043]

步骤1,获取低分辨率lr图像;

[0044]

步骤1.1,在网络上下载set5,set14,bsd100,urban100,manga109数据集。

[0045]

步骤1.2,对步骤1.1中的各个数据集进行4倍下采样预处理,得到各自对应的低分辨率lr图片。

[0046]

步骤2,将步骤1中的低分辨率lr图像输入到深层注意力机制网络中,经过浅层特征提取模块提取,得到浅层特征图;具体为:

[0047]

将步骤1中的低分辨率lr图像输入到深层注意力机制网络中,该深层注意力机制网络可以分为浅层特征提取模块、深层特征提取模块、上采样模块和重建模块四个模块。低分辨率lr图像首先经过浅层特征提取模块(shallow feature extraction block,sfeb),

通过两层带有relu激活函数的卷积层将输入网络的低分辨率图像变换到特征图空间,变换后的特征图通道数为64。浅层特征提取模块主要负责提取图像的低频信息,并且在网络上进行传递。低分辨率lr图像输入到浅层特征提取模块(sfeb)中,得到浅层特征图f

‑1,f0,用数学公式表示如公式(1)、(2)所示:

[0048]

f

‑1=h

sfeb

(i

lr

)

ꢀꢀꢀ

(1);

[0049]

f0=h

sfeb

(f

‑1)

ꢀꢀꢀ

(2);

[0050]

式中,i

lr

代表低分辨率图像,h

sfeb

()代表潜层特征提取操作,f

‑1,f0代表经过浅层特征提取之后的得到的浅层特征图。

[0051]

步骤3,将步骤2中的浅层特征图输入到深层特征提取模块中,对浅层特征图进行深度特征提取,得到深层特征图,将浅层特征图和深层特征图进行级联,得到级联特征图,对级联特征图进行给予权重分配,并对特征图降维,得到降维特征图;

[0052]

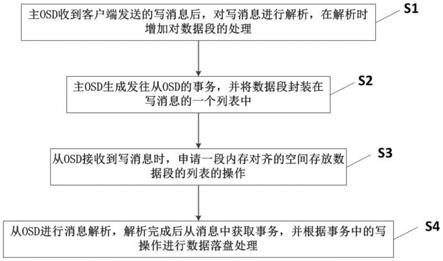

步骤3.1,利用若干个包含了通道注意力机制的dfeb模块对特征图进行深度特征提取,深层提取模块的一个子模块dfeb结构如图2所示。上一层特征图f

d

‑1输入dfeb模块,ca模块即通道注意力机制,通过通道注意力机制对上一层特征图赋予不同的权重;再经过4层卷积以及relu激活函数,训练ca模块的残差分量;最后将ca模块的输出即不同权重的特征图与ca模块的残差分量相加得到dfeb模块的输出fd。其中,d表示第d个dfeb模块。一个dfeb模块的数学表达式如公式(3):

[0053]

f

d

=h

dfeb,d

(f

d

‑1)

[0054]

=h

dfeb,d

(h

dfeb,d

‑1(

…

(h

dfeb,1

(f0))

…

))

ꢀꢀꢀ

(3);

[0055]

式中,f

d

‑1为d

‑

1层dfeb模块的特征图输出,h

dfeb

表示深层特征提取操作,d表示第d个dfeb模块,f0表示第0层dfeb模块的特征图输出,f

d

表示第d层dfeb模块的特征图输出。

[0056]

步骤3.1.1,如图3所示为ca模块的结构图,即为通道注意力模块的示意图,n表示尺寸为h

′×

w

′×

c

′

的特征图,经过相应的卷积操作后得到h

×

w

×

c的特征图u;f

sq

即squeeze操作对特征图u进行全局平均池化,得到1

×1×

c大小的特征图;f

ex

即excitation操作使用一个全连接网络,对squeeze之后的结果做一个非线性变换;f

scale

即使用excitation得到的结果作为权重,乘到对应通道的输入特征上即通道加权;最后得到每个通道不同权重的加权特征图

[0057]

全局平均池化的具体操作为:对每个通道的特征图做全局范围内的平均池化,把一个二维特征图转化为一个实数,记作zc,数学表达式如(4)所示:

[0058][0059]

式中,h和w分别代表输入图片的高和宽,u

c

代表通道数为c的特征图,f

sq

代表对特征图u进行全局平均池化操作,u(i,j)代表特征图u第i行第j列的像素。

[0060]

excitation的具体操作为:通过两个全连接层对每个实数产生不同的激励,其中w1表示第一个全连接操作,将通道数从c2维降维到c2/r维,dδ表示relu激活层,其中r为超参数16。w2表示第二个全连接操作,将通道数还原到c2维。最后经过sigmoid函数映射得到s,数学表达式如(5)所示:

[0061]

s=f

ex

(z,w)=σ(g(z,w))=σ(w26(w1z))

ꢀꢀꢀ

(5);

[0062]

式中,w1、w2分别表示第一个、第二个全连接操作,6表示relu激活层,σ表示sigmoid函数映射,z表示池化后的实数,s代表学习到的权值。

[0063]

f

scale

的具体操作为:把(5)中输出的s权重按照通道加权,达到通道注意力机制的目的,数学表达式如(6)所示:

[0064]

x

c

=f

scale

(u,s

c

)=u

·

s

c

ꢀꢀꢀ

(6);

[0065]

式中,u代表通道数为c2的特征图,s

c

代表学习到的权值(s

c

为权值s加权后的权值),其中c代表通道数。

[0066]

步骤3.2,在分别经过了浅层特征提取以及深层特征提取后,得到了多组特征图,浅层特征图f

‑1,f0,深层特征图f1,f

d

,...f

d

。把这些特征图级联在一起,得到的级联特征图,记作f

con

,数学表达式如公式(7):

[0067]

f

con

=[f

‑1,f0,f1,...,f

d

,...,f

d

]

ꢀꢀꢀ

(7);

[0068]

步骤3.3,在注意力机制的启发下,利用所提出的dab(deep attention block)模块在网络模型的深度维度,对级联后的多组深层特征图给予权重分配。级联特征图是不同深度卷积层所提取到的图像特征信息,此时它们在深度方向上拥有相同的权重,我们通过dab(deep attention block)模块赋予这些特征图新的权重,在深度维度建立注意力机制,其中,dab模块示意图如图4所示。经过f

sq

即squeeze操作对道数为c1的级联特征图f

con

进行平均池化,得到c1个实数组成的特征图z;然后通过w1,w2两个全连接层得到权值s;经过f

scale

操作即将学习到的权值s与级联特征图相乘,即可得到深度维度dab模块最终的输出f

dab

。

[0069]

将逐像素损失与感知损失相结合作为优化网络的目标函数。逐像素损失函数就是均方误差损失函数又称mse损失函数,它表示的是预测值与真值的差值平方和的均值,由于mse损失函数求导数后的计算量不大,代码实现简单。损失函数最小值点表示预测值为真值,损失函数值随着误差的增大而陡然增大。随着图像风格化迁移任务的成功,发现可以将卷积神经网络中得到的特征图作为目标损失的一部分。感知损失函数通过优化输入低分辨率图像经过卷积神经网络得到的特征图,与真值图通过相同网络的特征图二者之间的差值可以使得生成图像在语义上更接近于真值图像。感知损失函数的意义在于,若有两副看起来十分相似的网络预测图像与真值图像,但二者仅存在一列像素的平移偏差,那么对二者按照逐像素损失计算则会得到较大的误差,这样的误差不能有效反应预测图像的真实重建效果,并且会减缓网络的收敛速度,在这样的背景下提出感知损失作为目标函数的一部分,有利于重建得到效果更好的预测图像。本方法的损失函数数学公式如下:

[0070][0071]

式中,y

i

代表预测值,代表真值,n表示数据的维度。mse损失函数曲线光滑,处处连续可导,便于网络的前、后向传播,表示预测值,v

dab

(y)表示真值。c

j

、h

j

、w

j

分别表示输出特征值的形状。其中第一项代表逐像素损失,第二项代表dab模块输出的预测特征图与真值特征图之间的感知损失,对两项的和进行优化不断更新网络结构直到网络训练完成。

[0072]

步骤3.3.1,对通道数为c1的级联特征图f

con

进行平均池化,公式如下所示,计算结果z表示由c1个实数组成的特征图,数学表达式如公式(9):

[0073][0074]

式中,h和w分别代表输入图片的高和宽,u

c

代表通道数为c1的特征图,f

sq

代表对特征图u进行全局平均池化操作,u(i,j)代表特征图u第i行第j列的像素。

[0075]

步骤3.3.2,通过两个全连接层生成c1个通道的新权重,公式如下所示,w1表示第一个全连接层,δ代表relu激活函数,将c1维特征图非线性映射到c2维。w2表示第二个全连接层,将c2维特征图还原回c1维,σ表示sigmoid激活函数,结果记作s,数学表达式如公式(10):

[0076]

s=f

ex

(z,w)=σ(g(z,w))=σ(w2δ(w1z))

ꢀꢀꢀ

(10);

[0077]

式中w1、w2分别表示第一个、第二个全连接操作,δ表示relu激活层,σ表示sigmoid函数映射,z表示步骤3.3.1中的实数。f

ex

即excitation操作使用一个全连接网络,对squeeze之后的结果做一个非线性变换。

[0078]

步骤3.3.3,将学习到的权值与级联特征图相乘,即可得到深度维度dab模块最终的输出f

dab

,其公式可表示如公式(11):

[0079]

f

dab

=f

scale

(u

c

,s)=u

c

·

s

[0080]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(11);

[0081]

式中,u

c

代表通道数为c1的级联特征图,s代表步骤3.3.2中学习到的权值。

[0082]

步骤4,将步骤3中得到的降维特征图与步骤1中获取的lr图像相加,学习特征残差,得到全局特征图;

[0083]

步骤4.1,网络模型在经过dab模块处理后,赋予了不同深度网络所提取到的信息不同的重要程度。对dab模块得到的加权特征图先做降维操作,将特征图减少到64维。

[0084]

步骤4.2,将步骤4.1得到的64维特征图再再做一层卷积操作,并且将特征图降维至三通道,与lr相加学习特征残差,得到全局特征图f

gf

,其公式可表示如公式(12):

[0085]

f

gf

=f

df

i

lr

[0086]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(12);

[0087]

式中,i

lr

代表低分辨率图片,f

df

代表3通道的特征图,f

gf

代表全局特征图。

[0088]

步骤5,将步骤4中得到的全局特征图再输入到上采样模块中,将低分辨率特征图放大到输出尺度,最后在重建模块对图像进行超分辨率重建。

[0089]

步骤5.1,将步骤4.2得到全局特征图f

gf

输入到上采样模块,采用反卷积的方式将低分辨率特征图放大到输出尺度。

[0090]

步骤5.2,在重建模块中采用一层卷积层对步骤5.1所得的进行超分辨率重建,其重建结果对比图如图5所示,图5(a)为低分辨率图片,图5(b)为高分辨率图片。

[0091]

dab模块有效性验证:

[0092]

本方法提出深度注意力机制模块(dab),传统的注意力机制仅优化通道维度权重,而在处理浅层网络与深层网络过程中没有进行权值优化。dab的有效性验证实验将本方法与网络结构相同但不含有dab模块的算法相对比,其结果如图6所示,(图6(a)为psnr变化曲线,图6(b)为ssim变化曲线)。由实验结果可得,含有dab模块的算法在训练时的收敛速度较快,同时在迭代次数相同时,相较于不含有dab模块的算法,在psnr与ssim评价指标上均取

得了提升。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。