1.本技术涉及人工智能技术,尤其涉及一种基于人工智能的图像处理方法、装置、电子设备及计算机可读存储介质。

背景技术:

2.人工智能(artificial intelligence,ai)是计算机科学的一个综合技术,通过研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。人工智能技术是一门综合学科,涉及领域广泛,例如自然语言处理技术以及机器学习/深度学习等几大方向,随着技术的发展,人工智能技术将在更多的领域得到应用,并发挥越来越重要的价值。

3.基于人工智能的图像编辑技术已经被广泛应用到图像创作过程中,尤其是针对图像的动作编辑技术,但是相关技术中针对图像的动作编辑技术虽然可以实现动作编辑,但是难以保证编辑前后的图像一致性,从而影响图像编辑效果。

技术实现要素:

4.本技术实施例提供一种基于人工智能的图像处理方法、装置、电子设备、计算机可读存储介质,能够在保留对象图像的主体内容的同时实现动作编辑。

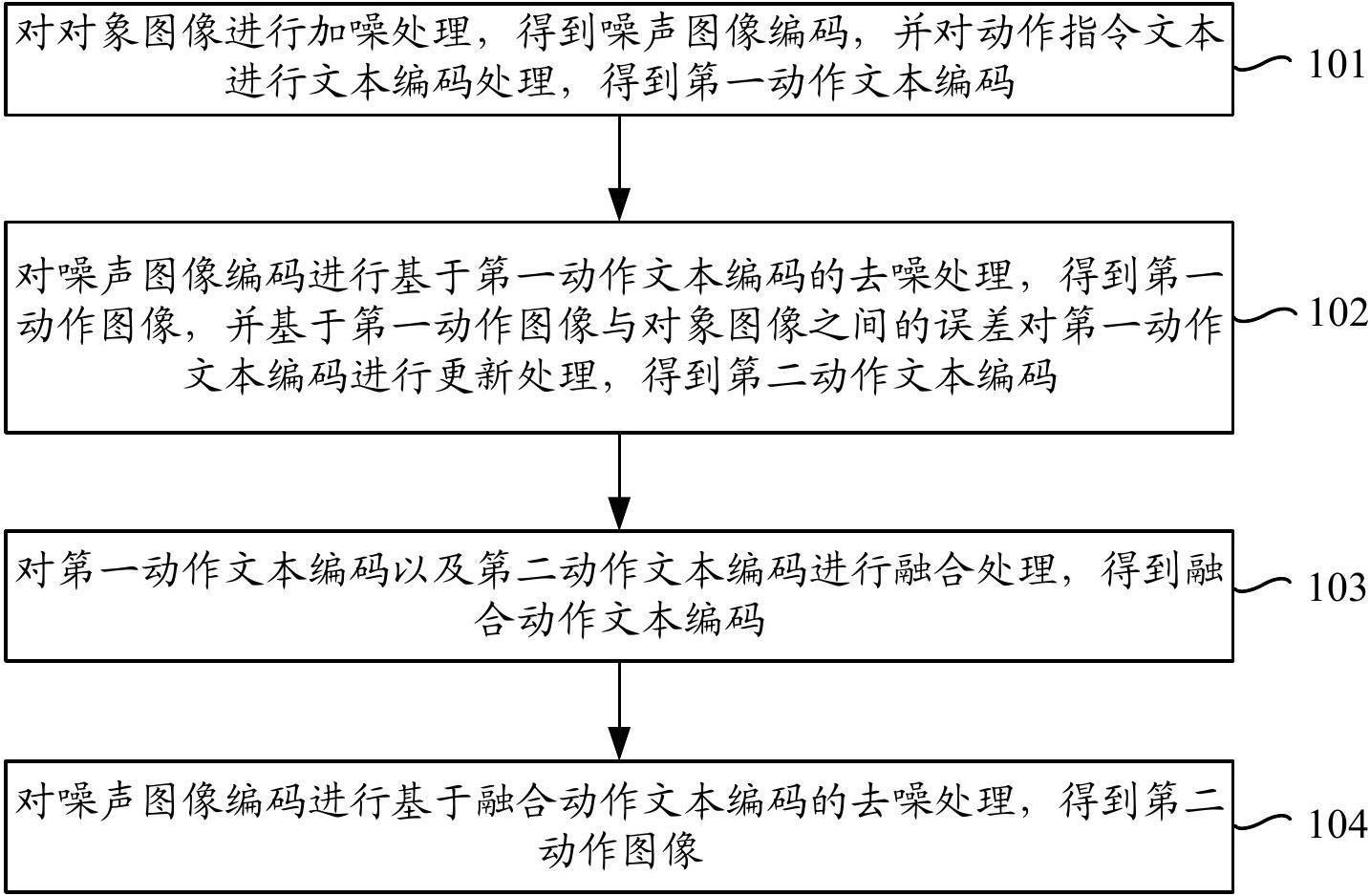

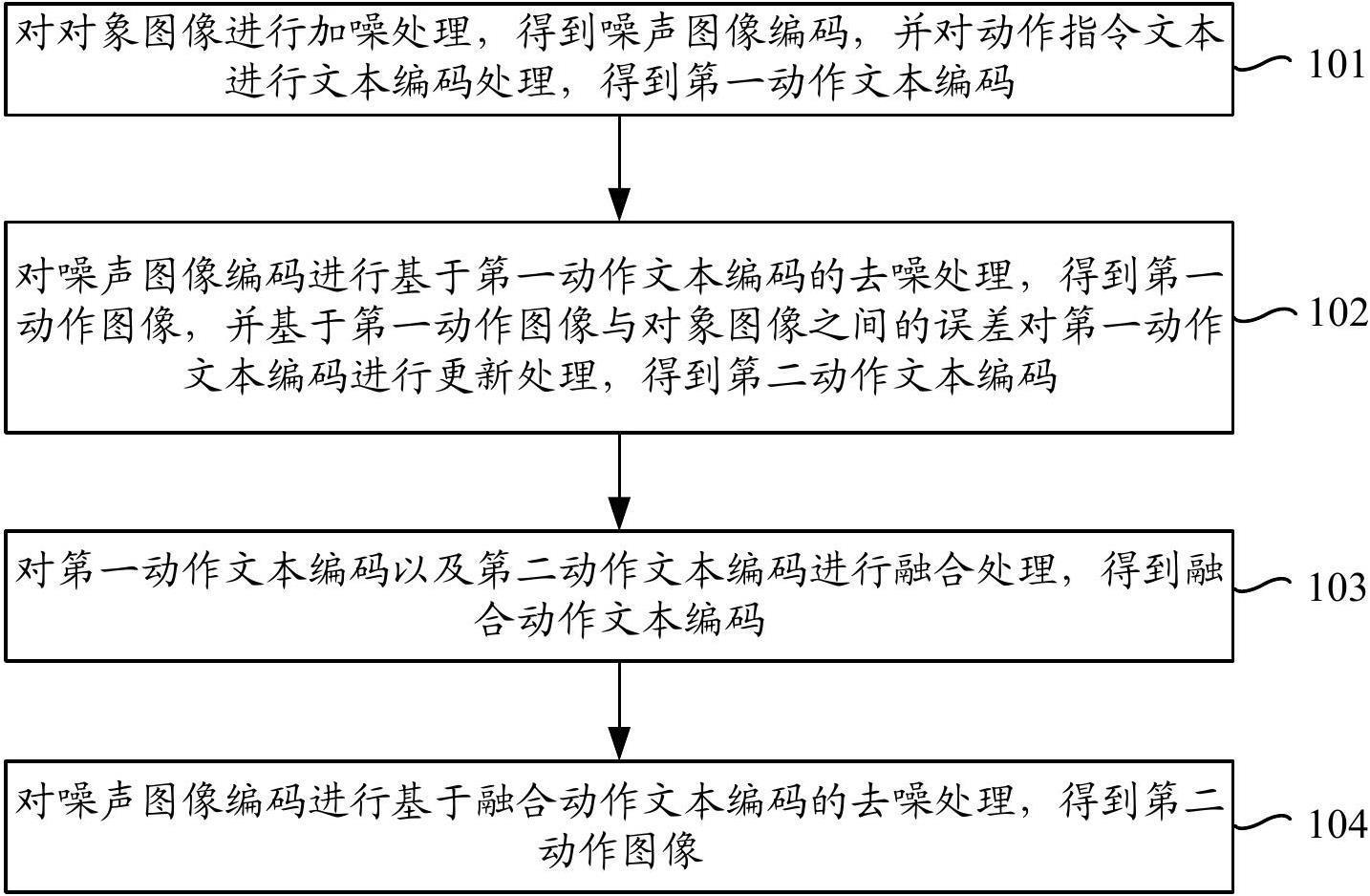

5.本技术实施例的技术方案是这样实现的:本技术实施例提供一种基于人工智能的图像处理方法,包括:对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;对所述噪声图像编码进行基于所述第一动作文本编码的去噪处理,得到第一动作图像,并基于所述第一动作图像与所述对象图像之间的误差对所述第一动作文本编码进行更新处理,得到第二动作文本编码;对所述第一动作文本编码以及所述第二动作文本编码进行融合处理,得到融合动作文本编码;对所述噪声图像编码进行基于所述融合动作文本编码的去噪处理,得到第二动作图像,其中,所述第二动作图像是将所述动作指令文本对应的动作应用至所述对象图像所包括对象的结果。

6.本技术实施例提供一种基于人工智能的图像处理装置,包括:编码模块,用于对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;微调模块,用于对所述噪声图像编码进行基于所述第一动作文本编码的去噪处理,得到第一动作图像,并基于所述第一动作图像与所述对象图像之间的误差对所述第一动作文本编码进行更新处理,得到第二动作文本编码;融合模块,用于对所述第一动作文本编码以及所述第二动作文本编码进行融合处

理,得到融合动作文本编码;生成模块,用于对所述噪声图像编码进行基于所述融合动作文本编码的去噪处理,得到第二动作图像,其中,所述第二动作图像是将所述动作指令文本对应的动作应用至所述对象图像所包括对象的结果。

7.本技术实施例提供一种基于人工智能的图像处理方法,包括:获取图像编辑请求,其中,所述图像编辑请求包括以下任意一种:图像渲染请求、动作编辑请求;当所述图像编辑请求是图像渲染请求时,调用图像渲染模型对所述图像编辑请求携带的对象图像进行图像渲染处理,得到渲染图像;当所述图像编辑请求是动作编辑请求时,调用动作编辑模型以对所述图像编辑请求携带的对象图像执行本技术实施例所述的方法,得到第二动作图像。

8.本技术实施例提供一种基于人工智能的图像处理装置,包括:获取模块,用于获取图像编辑请求,其中,所述图像编辑请求包括以下任意一种:图像渲染请求、动作编辑请求;渲染模块,用于当所述图像编辑请求是图像渲染请求时,调用图像渲染模型对所述图像编辑请求携带的对象图像进行图像渲染处理,得到渲染图像;动作模块,用于当所述图像编辑请求是动作编辑请求时,调用动作编辑模型以对所述图像编辑请求携带的对象图像执行本技术实施例所述的方法,得到第二动作图像。

9.本技术实施例提供一种基于人工智能的图像处理方法,所述方法包括:显示图像编辑入口;响应于在所述图像编辑入口的信息输入操作,显示输入的图像编辑信息,其中,所述图像编辑信息包括基础图像以及编辑信息,所述编辑信息包括以下至少之一:编辑文本以及引导图像,所述编辑文本是动作指令文本或者渲染文本,所述引导图像以及所述渲染文本均表征渲染方向;响应于基于所述图像编辑信息的图像处理操作,显示基于所述编辑信息对所述基础图像进行编辑得到的目标图像。

10.本技术实施例提供一种基于人工智能的图像处理装置,包括:显示模块,用于显示图像编辑入口;输入模块,用于响应于在所述图像编辑入口的信息输入操作,显示输入的图像编辑信息,其中,所述图像编辑信息包括基础图像以及编辑信息,所述编辑信息包括以下至少之一:编辑文本以及引导图像,所述编辑文本是动作指令文本或者渲染文本,所述引导图像以及所述渲染文本均表征渲染方向;编辑模块,用于响应于基于所述图像编辑信息的图像处理操作,显示基于所述编辑信息对所述基础图像进行编辑得到的目标图像。

11.本技术实施例提供一种电子设备,所述电子设备包括:存储器,用于存储计算机可执行指令;处理器,用于执行所述存储器中存储的计算机可执行指令时,实现本技术实施例提供的基于人工智能的图像处理方法。

12.本技术实施例提供一种计算机可读存储介质,存储有计算机可执行指令,用于被

处理器执行时,实现本技术实施例提供的基于人工智能的图像处理方法。

13.本技术实施例提供一种计算机程序产品,包括计算机可执行指令,所述计算机可执行指令被处理器执行时,实现本技术实施例提供的基于人工智能的图像处理方法。

14.本技术实施例具有以下有益效果:通过本技术实施例对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码,这里相当于对动作指令文本的表征进行微调,从而确保图像处理过程中对原始的对象图像的认知,控制图像编辑过程中的一致性,对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码,对噪声图像编码进行基于融合动作文本编码的去噪处理,得到将动作指令文本对应的动作应用至对象图像所包括对象的结果,由于是基于融合动作文本编码控制生成的结果,因此可以在保证图像一致性的情况下实现动作编辑。

附图说明

15.图1是本技术实施例提供的图像处理系统的结构示意图;图2是本技术实施例提供的电子设备的结构示意图;图3a是本技术实施例提供的图像处理方法的第一流程示意图;图3b是本技术实施例提供的图像处理方法的第二流程示意图图3c是本技术实施例提供的图像处理方法的第三流程示意图;图3d是本技术实施例提供的图像处理方法的第四流程示意图;图3e是本技术实施例提供的图像处理方法的第五流程示意图;图4a是相关技术提供的图像创作界面的第一示意图;图4b是相关技术提供的图像创作界面的第二示意图;图5a是本技术实施例提供的图像处理方法的第一界面示意图;图5b是本技术实施例提供的图像处理方法的第二界面示意图;图5c是本技术实施例提供的图像处理方法的第三界面示意图;图5d是本技术实施例提供的图像处理方法的第四界面示意图;图5e是本技术实施例提供的图像处理方法的第五界面示意图;图5f是本技术实施例提供的图像处理方法的第六界面示意图;图6是本技术实施例提供的图像处理方法的系统示意图;图7是本技术实施例提供的图像处理方法的渲染处理示意图;图8是本技术实施例提供的图像处理方法的动作编辑示意图;图9是本技术实施例提供的图像处理方法的微调示意图;图10是本技术实施例提供的图像处理方法的动作编辑示意图。

具体实施方式

16.为了使本技术的目的、技术方案和优点更加清楚,下面将结合附图对本技术作进一步地详细描述,所描述的实施例不应视为对本技术的限制,本领域普通技术人员在没有

做出创造性劳动前提下所获得的所有其它实施例,都属于本技术保护的范围。

17.在以下的描述中,涉及到“一些实施例”,其描述了所有可能实施例的子集,但是可以理解,

ꢀ“

一些实施例”可以是所有可能实施例的相同子集或不同子集,并且可以在不冲突的情况下相互结合。

18.在以下的描述中,所涉及的术语“第一\第二\第三”仅仅是是区别类似的对象,不代表针对对象的特定排序,可以理解地,“第一\第二\第三”在允许的情况下可以互换特定的顺序或先后次序,以使这里描述的本技术实施例能够以除了在这里图示或描述的以外的顺序实施。

19.除非另有定义,本文所使用的所有的技术和科学术语与属于本技术的技术领域的技术人员通常理解的含义相同。本文中所使用的术语只是为了描述本技术实施例的目的,不是旨在限制本技术。

20.对本技术实施例进行进一步详细说明之前,对本技术实施例中涉及的名词和术语进行说明,本技术实施例中涉及的名词和术语适用于如下的解释。

21.1)文生图扩散模型:基于扩散过程的生成模型,生成模型的输入是文本,生成模型对随机噪声图进行基于文本的图像恢复,产生与文本相关的预测图像。

22.2)图像编辑:图像编辑包括多种情况:风格变化、动作编辑以及场景时间氛围渲染,风格变化是对输入图像进行图像风格转变,动作编辑是改变图像中对象的动作,场景时间氛围渲染是改变全图氛围,例如将晴天的图像改为雨天的图像。

23.3)场景时间氛围渲染,是对图像中的场景进行时间、四季、早晚等操作,如图像最初是白天氛围,经过渲染后变成黑夜氛围,图像最初是春天氛围,渲染后变成秋天氛围,渲染前后图像内容不变仅季节相关内容被改变。

24.在图像编辑领域,虽然相关技术中可以实现对象动作编辑,但是相关技术中的动作编辑方案无法在实现动作编辑时保证编辑前后的图像一致性。

25.本技术实施例提供一种图像处理方法、装置、电子设备、计算机可读存储介质及计算机程序产品,能够在保留对象图像的主体内容的同时实现动作编辑。

26.下面说明本技术实施例提供的电子设备的示例性应用,本技术实施例提供的电子设备可以实施为终端或服务器。

27.参考图1,图1是本技术实施例提供的图像处理方法的应用模式示意图;示例的,图1中涉及服务器200、网络300及终端400。终端400通过网络300连接服务器200,网络300可以是广域网或者局域网,又或者是二者的组合。

28.在一些实施例中,服务器200可以是应用程序对应的服务器,例如:应用程序是安装在终端400中的图像处理软件,则服务器200是图像处理后台,用于执行本技术实施例提供的图像处理方法。

29.在一些实施例中,终端400接收到图像编辑请求,这里的图像编辑请求携带有用户上传的图像以及动作指令文本,终端400将图像编辑请求发送到服务器200,服务器200对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码;对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合

动作文本编码;对噪声图像编码进行基于融合动作文本编码的去噪处理,得到将动作指令文本对应的动作应用至对象图像的第二动作图像,并将第二动作图像返回至终端400。

30.在一些实施例中,服务器200可以是独立的物理服务器,也可以是多个物理服务器构成的服务器集群或者分布式系统,还可以是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件服务、域名服务、安全服务、cdn、以及大数据和人工智能平台等基础云计算服务的云服务器。终端400可以是智能手机、平板电脑、笔记本电脑、台式计算机、智能音箱、智能手表、智能电视、车载终端等,但并不局限于此。终端以及服务器可以通过有线或无线通信方式进行直接或间接地连接,本技术实施例中不做限制。数据库500可以单独设置,可以集成在服务器200上,或者数据库500可以设置在独立于服务器200的机器上,本技术实施例不做限制,本技术实施例提供的数据库500可以用于存储服务器200生成的第二动作图像以进行远程存储备份。

31.在一些实施例中,终端400可以通过运行计算机程序来实现本技术实施例提供的图像处理方法,例如,计算机程序可以是操作系统中的原生程序或软件模块;可以是本地(native)应用程序(app,application),即需要在操作系统中安装才能运行的程序,例如摄影app;也可以是小程序,即只需要下载到浏览器环境中就可以运行的程序;还可以是能够嵌入至任意app中的小程序。总而言之,上述计算机程序可以是任意形式的应用程序、模块或插件。

32.参见图2,图2是本技术实施例提供的电子设备的结构示意图,电子设备为终端或者服务器,以电子设备是服务器为例进行说明,图2所示的服务器包括:至少一个处理器210、存储器250、至少一个网络接口220和用户接口230。终端400中的各个组件通过总线系统240耦合在一起。可理解,总线系统240用于实现这些组件之间的连接通信。总线系统240除包括数据总线之外,还包括电源总线、控制总线和状态信号总线。但是为了清楚说明起见,在图2中将各种总线都标为总线系统240。

33.处理器210可以是一种集成电路芯片,具有信号的处理能力,例如通用处理器、数字信号处理器(dsp,digital signal processor),或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等,其中,通用处理器可以是微处理器或者任何常规的处理器等。

34.用户接口230包括使得能够呈现媒体内容的一个或多个输出装置231,可以包括一个或多个扬声器和/或一个或多个视觉显示屏。用户接口230还包括一个或多个输入装置232,可以包括有助于用户输入的用户接口部件,比如键盘、鼠标、麦克风、触屏显示屏、摄像头、其他输入按钮和控件。

35.存储器250可以是可移除的,不可移除的或其组合。示例性的硬件设备包括固态存储器,硬盘驱动器,光盘驱动器等。存储器250可选地包括在物理位置上远离处理器 210的一个或多个存储设备。

36.存储器250包括易失性存储器或非易失性存储器,也可包括易失性和非易失性存储器两者。非易失性存储器可以是只读存储器(rom,read only memory),易失性存储器可以是随机存取存储器(ram,random access memory)。本技术实施例描述的存储器250旨在包括任意适合类型的存储器。

37.在一些实施例中,存储器250能够存储数据以支持各种操作,这些数据的示例包括

程序、模块和数据结构或者其子集或超集,下面示例性说明。

38.操作系统251,包括用于处理各种基本系统服务和执行硬件相关任务的系统程序,例如框架层、核心库层、驱动层等,用于实现各种基础业务以及处理基于硬件的任务;网络通信模块252,用于经由一个或多个(有线或无线)网络接口220到达其他电子设备,示例性的网络接口220包括:蓝牙、无线相容性认证(wifi)、和通用串行总线(usb,universal serial bus)等;呈现模块253,用于经由一个或多个与用户接口230相关联的输出装置231(例如,显示屏、扬声器等)使得能够呈现信息(例如,用于操作外围设备和显示内容和信息的用户接口);输入处理模块254,用于对一个或多个来自一个或多个输入装置232之一的一个或多个用户输入或互动进行检测以及翻译所检测的输入或互动。

39.在一些实施例中,本技术实施例提供的图像处理装置可以采用软件方式实现,图2示出了存储在存储器250中的图像处理装置255-1,其可以是程序和插件等形式的软件,包括以下软件模块:编码模块2551、微调模块2552、融合模块2553,生成模块2554、训练模块2555,图2示出了存储在存储器250中的图像处理装置255-2,其可以是程序和插件等形式的软件,包括以下软件模块:获取模块2556、渲染模块2557、动作模块2558,这些模块是逻辑上的,因此根据所实现的功能可以进行任意的组合或进一步拆分。将在下文中说明各个模块的功能。

40.下面,说明本技术实施例提供的图像处理方法,如前,实现本技术实施例的图像处理方法的电子设备可以是终端或者服务器,以服务器为例进行说明。因此下文中不再重复说明各个步骤的执行主体。参见图3a,结合图3a示出的步骤101至步骤104进行说明。

41.在步骤101中,对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码。

42.作为示例,对象图像可以是通过用户上传的图像或者是拍摄得到的,这里的对象图像可以是包括人物以及动物的图像,还可以是包括某个物品的图像。这里的动作指令文本由图像基础描述以及用户编辑动作文本组成,图像基础描述是用于描述对象图像的文本,例如“男人”、“女人”,用户编辑动作文本是用户希望呈现的动作,例如“微笑”、“举手”等等。

43.在一些实施例中,步骤101中对对象图像进行加噪处理,得到噪声图像编码,可以通过以下技术方案实现:将对象图像与噪声图像进行叠加处理,得到叠加图像;对叠加图像进行图像隐空间编码处理,得到噪声图像编码。通过本技术实施例所执行的隐空间编码处理,可以使得后续的去噪处理在隐空间内执行,从而降低计算量并且提高去噪效果。

44.作为示例,随机取种子i产生噪声图像,将产生的噪声图像与原始的对象图像进行叠加产生叠加图像x,对叠加图像x进行隐空间编码得到作为隐空间表征的噪声图像编码z

t

。

45.在一些实施例中,文本编码处理是通过调用文本图像对比模型中的文本模型实现的,获取多个第一文本样本以及与每个第一文本样本匹配的第一图像样本;通过文本图像对比模型的视觉模型对每个第一图像样本进行图像编码处理,得到每个第一图像样本的图像编码;通过文本图像对比模型的文本模型对每个第一文本样本进行文本编码处理,得到

每个第一文本样本的文本编码;基于每个第一文本样本的文本编码、每个第一图像样本的图像编码、以及每个第一文本样本与每个第一图像样本之间的匹配关系,确定文本图像对比损失;基于文本图像对比损失更新文本图像对比模型的参数。通过本技术实施例可以约束视觉模型以及文本模型在语义空间对齐,从而提高第一动作文本编码的表征能力。

46.作为示例,文本图像对比模型的核心思想是用第一图像样本和第一文本样本之间的语义相似性来训练视觉-语言模型。具体来说,文本图像对比模型使用双塔结构的神经网络,其中一塔是图像编码器,另一塔是文本编码器。图像编码器负责将图像转换为一个向量表示(图像编码),文本编码器负责将文本转换为一个向量表示(文本编码)。然后,文本图像对比模型使用对比损失函数,来优化这两个向量之间的内积。也就是说,文本图像对比模型希望图像和文本之间的内积越大,表示它们越相似;反之,图像和文本之间的内积越小,表示它们越不相似。

47.在步骤102中,对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码。

48.在一些实施例中,基于第一动作文本编码的去噪处理是通过图像生成模型实现的,图像生成模型包括n个级联的去噪网络以及解码网络,n的取值满足;参见图3b,步骤102中对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,可以通过图3b示出的步骤1021至步骤1022实现。

49.在步骤1021中,通过n个级联的去噪网络中第n去噪网络,对第n去噪网络的输入进行去噪处理,并将第n去噪网络输出的第n去噪结果传输到第n 1去噪网络以继续进行去噪处理,得到对应第n 1去噪网络的第n 1去噪结果。

50.在步骤1022中,通过解码网络对第n去噪网络输出的去噪结果进行解码处理,得到第一动作图像。

51.作为示例,图像生成模型中有n个去噪网络级联以及解码网络,从而相当于执行了n次去噪处理最后会进行图像解码处理,每次都是根据前一次去噪得到的隐空间图像编码进行去噪处理,再输入到下一个去噪网络中进行去噪处理,n为取值从1开始递增的整数变量,n的取值范围为,当n取值为1时,第n去噪网络的输入为噪声图像编码以及第一动作文本编码,当n取值为时,第n去噪网络的输入为第n-1去噪网络输出的第n-1去噪结果以及第一动作文本编码。

52.作为示例,以n为3举例进行说明,通过第1去噪网络对噪声图像编码(隐空间噪声编码)以及第一动作文本编码进行去噪处理,得到第1去噪结果,通过第2去噪网络对第1去噪结果以及第一动作文本编码进行去噪处理,得到第2去噪结果,通过第3去噪网络对第2去噪结果以及第一动作文本编码进行去噪处理,得到第3去噪结果,通过上述方式得到的每个去噪结果也均是隐空间编码,每个去噪网络所执行的去噪处理相当于是一个时间步的去噪处理。

53.在一些实施例中,步骤1021中通过n个级联的去噪网络中第n去噪网络,对第n去噪网络的输入进行去噪处理,可以通过以下技术方案实现:通过第n去噪网络中第m注意力层对第m注意力层的输入以及第一动作文本编码进行第一注意力处理,得到第一注意力特征作为第n去噪网络中第m注意力层的第m注意力结果;将第n去噪网络中第m注意力层的第m注

意力结果传输到第m 1注意力层以继续进行注意力处理,得到第n去噪网络中第m 1注意力层的第m 1注意力结果;将第n去噪网络中第m注意力层输出的第m注意力结果作为第n去噪结果。

54.作为示例,m的取值满足,m为取值从1开始递增的整数变量,m的取值范围为,当m取值为1时,第m注意力层的输入为第n-1融合去噪结果,当m取值为时,第m注意力层的输入为第m-1注意力层输出的第m-1注意力结果。

55.作为示例,第n去噪网络包括级联的h个下采样网络以及h个上采样网络,这里的m的取值即为,h的取值满足;上述通过n个级联的去噪网络中第n去噪网络,对第n去噪网络的输入进行去噪处理,可以通过以下技术方案实现:通过h个级联的下采样网络对第n-1去噪结果以及第一动作文本编码进行下采样处理,得到第n去噪网络的下采样结果;通过h个级联的上采样网络对第n去噪网络的下采样结果进行上采样处理,得到第n去噪网络的上采样结果,作为对应第n去噪网络的第n去噪结果,通过在每步去噪过程中进行下采样以及上采样,从而可以在去噪过程中保留更多的细节信息。

56.承接上述示例,以第2去噪网络为例进行说明,去噪网络可以包括3个下采样网络以及3个上采样网络,通过3个级联的下采样网络对第1去噪结果以及第一动作文本编码进行下采样处理,得到第2去噪网络的下采样结果;通过3个级联的上采样网络对第2去噪网络的下采样结果进行上采样处理,得到第2去噪网络的上采样结果作为对应第2去噪网络的第2去噪结果。

57.作为示例,通过h个级联的下采样网络对第n去噪结果以及第一动作文本编码进行下采样处理,得到第n去噪网络的下采样结果,可以通过以下技术方案实现:通过h个级联的下采样网络中的第h下采样网络,对第h下采样网络的输入进行下采样处理,得到对应第h下采样网络的第h下采样结果,将对应第h下采样网络的第h下采样结果传输到第h 1下采样网络以继续进行下采样处理,得到对应第h 1下采样网络的第h 1下采样结果;将第h下采样网络输出的下采样结果作为第n去噪结果;其中,h为取值从1开始递增的整数变量,h的取值范围为,当h取值为1时,第h采样网络的输入为第n-1去噪结果以及第一动作文本编码,当h取值为时,第h下采样网络的输入为第h-1下采样网络输出的第h-1下采样结果以及第一动作文本编码。上采样网络的处理过程与下采样网络的处理过程相同。

58.承接上述示例,通过第1下采样网络,对第1下采样网络的输入进行下采样处理,得到对应第1下采样网络的下采样结果,将对应第1下采样网络的下采样结果传输到第2下采样网络以继续进行下采样处理,得到对应第2下采样网络的第2下采样结果;通过第2下采样网络,对第2下采样网络的输入进行下采样处理,得到对应第2下采样网络的下采样结果,将对应第2下采样网络的下采样结果传输到第3下采样网络以继续进行下采样处理,得到对应第3下采样网络的第3下采样结果,将第3下采样网络输出的第3下采样结果作为第2去噪结果,这里每个下采样网络的输入均包括第一动作文本编码。

59.作为示例,第m下采样网络包括注意力层;通过m个级联的下采样网络中的第m下采样网络,对第m下采样网络的输入进行下采样处理,得到对应第m下采样网络的第m下采样结果,可以通过以下技术方案实现:通过注意力层对对应第m-1下采样网络的第m-1下采样结果以及第一动作文本编码进行第一注意力处理,得到对应第m下采样网络的第m下采样结

果。每个下采样网络包括注意力层。注意力层的输入是上一个级联的下采样网络的输出(也即上一个级联的下采样网络中包括的注意力层的输出),通过本技术实施例可以通过残差层保留更多的有效信息,通过注意力层可以基于文本编码对空间维度进行建模,从而提高去噪效果。

60.在一些实施例中,第n去噪网络包括m个级联的注意力层;上述通过第n去噪网络中第m注意力层对第m注意力层的输入以及第一动作文本编码进行第一注意力处理,得到第一注意力特征作为第n去噪网络中第m注意力层的第m注意力结果,可以通过以下技术方案实现:对第m注意力层的输入进行基于查询矩阵的映射处理,得到注意力查询矩阵;对第一动作文本编码进行基于键矩阵的映射处理,得到注意力键矩阵;对第一动作文本编码进行基于值矩阵的映射处理,得到注意力值矩阵;将注意力查询矩阵与注意力键矩阵的转置矩阵进行相乘处理,得到相乘结果,并获取相乘结果与注意力键矩阵的维度之间的比值;对比值进行最大似然处理,并将最大似然结果与注意力值矩阵进行相乘处理,得到第一注意力特征。通过本技术实施例可以将动作指令文本有针对性融入到去噪网络中,从而起到针对图像生成的约束作用,提高模型的训练效果。

61.作为示例,通过交叉注意力机制引入作为条件信号的第一动作文本编码,这种交叉注意力机制还可以动作指令文本的条件信息融合到去噪过程,参见公式(1)至公式(3):

ꢀꢀꢀꢀꢀ

(1);

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2);

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3);其中,表示第m-1注意力层的输出,,和是具有可学习参数的投影矩阵,是注意力值矩阵,是注意力查询矩阵,是注意力键矩阵,是第一动作文本编码,q是注意力查询矩阵,k是注意力键矩阵,v是注意力值矩阵。

62.在一些实施例中,参见图3c,步骤102中基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码之前,可以执行图3c示出的步骤105至步骤107。

63.在步骤105中,获取第一动作图像中每个位置的第一像素值、以及对象图像中每个位置的第二像素值。

64.在步骤106中,针对每个位置,获取第一像素值与第二像素值之间的误差。

65.在步骤107中,对多个位置的误差进行融合处理,得到第一动作图像与对象图像之间的误差。

66.作为示例,参见公式(4)

ꢀꢀꢀꢀꢀꢀ

(4);其中,是对象图像中位置i的第二像素值,是第一动作图像中位置i的第一像素值,是第一动作图像与对象图像之间的误差。

67.通过本技术实施例约束图像前后一致性,从而可以确保在动作编辑的过程中图像的主体内容不变,优化图像的动作编辑效果。

68.在一些实施例中,基于第一动作文本编码的去噪处理是通过图像生成模型实现的,当基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理时,基于第一动作图像与对象图像之间的误差对图像生成模型进行更新处理,得到经过更新的图像生成模型。

69.作为示例,可以基于误差仅更新第一动作文本编码,还可以基于误差同时更新第一动作文本编码以及图像生成模型(这里可以更新图像生成模型中的全部参数,或者更新图像生成模型中u型网络的参数)。通过本技术实施例可以在微调第一动作文本编码的同时也微调用于执行去噪处理的图像生成模型,从而可以优化去噪效果。

70.在步骤103中,对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码。

71.在一些实施例中,步骤103中对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码,可以通过图3d示出的步骤1031至步骤1033实现。

72.在步骤1031中,对第一动作文本编码进行基于第一数目的截取处理,得到第一截取编码,其中,第一截取编码包括第一动作文本编码中位置靠前的第一数目的向量。

73.在步骤1032中,对第二动作文本编码进行基于第二数目的截取处理,得到第二截取编码,其中,第二截取编码包括第二动作文本编码中位置靠前的第二数目的向量。

74.在步骤1033中,将第二截取编码拼接至第一截取编码的尾部,得到融合动作文本编码。

75.作为示例,首先对微调后第二动作文本编码与未微调的第一动作文本编码通过拼接产生最终的融合动作文本编码,拼接原则是未微调的第一动作文本编码在前,微调的第二动作文本编码在后,取两者各半拼接成最终的融合动作文本编码,例如,对于扩散模型采用77个向量作为编码,则取未微调的第一动作文本编码的前38个向量,和微调后的第二动作文本编码的前39个向量进行拼接。此处必须要把未微调的第一动作文本编码放在最前面,由于未微调的第一动作文本编码保留了更多的编辑能力,而已经微调的第二动作文本编码代表的是原始的对象图像,对象图像无法提供编辑控制信息,故必须要未微调的第一动作文本编码在前来保证更高的编辑能力。

76.在步骤104中,对噪声图像编码进行基于融合动作文本编码的去噪处理,得到第二动作图像,其中,第二动作图像是将动作指令文本对应的动作应用至对象图像所包括对象的结果。

77.在一些实施例中,这里基于融合动作文本编码的去噪处理与步骤102中基于第一动作文本编码的去噪处理可以采用完全相同的模型执行,即均采用经过预训练的图像生成模型执行,或者,这里基于融合动作文本编码的去噪处理与步骤102中基于第一动作文本编码的去噪处理可以采用结构相同参数不同的模型执行,即步骤104采用基于误差更新得到的图像生成模型执行,步骤102仅采用经过预训练的图像生成模型执行,或者这里基于融合动作文本编码的去噪处理与步骤102中基于第一动作文本编码的去噪处理可以采用结构相关但是结构不同的动作编辑模型执行,动作编辑模型由图像生成模型(基于步骤102的误差更新得到的或者是步骤102中所使用的预训练的图像生成模型)以及多个图像信息网络构

成。

78.在一些实施例中,基于动作文本编码的去噪处理是通过图像生成模型实现的,基于融合动作文本编码的去噪处理是通过动作编辑模型实现的,动作编辑模型由图像生成模型以及多个图像信息网络构成;在对噪声图像编码进行基于融合动作文本编码的去噪处理,得到第二动作图像之前,将噪声图像编码以及动作文本编码在动作编辑模型中进行正向传播,得到第三动作图像,其中,动作文本编码是第一动作文本编码或者融合动作文本编码;基于第三动作图像与对象图像之间的误差对动作编辑模型中的多个图像信息网络进行更新处理,得到更新后的动作编辑模型。

79.作为示例,动作编辑模型在图像生成模型的基础上级联有多个图像信息网络。可以在执行步骤104之前对动作编辑模型进行训练,在训练过程中可以仅更新多个图像信息网络,保持图像生成模型的参数不变,这里的图像生成模型可以是基于步骤102得到的误差更新得到的图像生成模型。

80.作为示例,动作编辑模型所包括的图像生成模型还可以是预训练得到的图像生成模型,即没有基于步骤102得到的误差进行更新过,此时针对动作编辑模型的训练可以在模型部署在服务端之前执行,即步骤102所涉及到的更新发生在接收到用户的图像编辑请求之后,而动作编辑模型的训练可以在接收到用户的图像编辑请求之后(基于步骤102得到的误差更新动作文本编码之后)也可以在接收到用户的图像编辑请求之前执行。

81.在一些实施例中,图像生成模型包括n个级联的去噪网络以及解码网络,n的取值满足,动作编辑模型是在图像生成模型的基础上针对每个去噪网络配置一个图像信息网络得到的,每个去噪网络以及对应的图像信息网络构成融合去噪网络,多个融合去噪网络的级联关系与多个去噪网络的级联关系相同;上述将噪声图像编码以及动作文本编码在动作编辑模型中进行正向传播,得到第三动作图像,可以通过以下技术方案实现:通过n个级联的融合去噪网络中第n融合去噪网络,对第n融合去噪网络的输入进行融合去噪处理,并将第n融合去噪网络输出的第n融合去噪结果传输到第n 1融合去噪网络以继续进行融合去噪处理,得到对应第n 1融合去噪网络的第n 1融合去噪结果;对第n融合去噪网络输出的融合去噪结果进行解码处理,得到第三动作图像。

82.作为示例,n为取值从1开始递增的整数变量,n的取值范围为,当n取值为1时,第n融合去噪网络的输入为噪声图像编码以及动作文本编码,当n取值为时,第n融合去噪网络的输入为第n-1融合去噪网络输出的第n-1融合去噪结果以及动作文本编码。

83.作为示例,图像生成模型中有n个融合去噪网络级联以及解码网络,从而相当于执行了n次融合去噪处理最后会进行图像解码处理,每次都是根据前一次去噪得到的隐空间图像编码进行去噪处理,再输入到下一个融合去噪网络中进行去噪处理,n为取值从1开始递增的整数变量,n的取值范围为,当n取值为1时,第n融合去噪网络的输入为噪声图像编码以及动作文本编码,当n取值为时,第n融合去噪网络的输入为第n-1融合去噪网络输出的第n-1融合去噪结果以及动作文本编码。

84.作为示例,以n为3举例进行说明,通过第1融合去噪网络对噪声图像编码(隐空间噪声编码)以及动作文本编码进行融合去噪处理,得到第1融合去噪处理,通过第2融合去噪网络对第1融合去噪处理以及动作文本编码进行融合去噪结果,得到第2融合去噪结果,通

过第3融合去噪网络对第2融合去噪结果以及动作文本编码进行融合去噪处理,得到第3融合去噪结果,通过上述方式得到的每个融合去噪结果也均是隐空间编码,每个融合去噪网络所执行的融合去噪处理相当于是一个时间步的融合去噪处理。

85.在一些实施例中,第n融合去噪网络包括多个下采样网络以及多个上采样网络、对应第n去噪网络的第n图像信息网络;上述通过n个级联的融合去噪网络中第n融合去噪网络,对第n融合去噪网络的输入进行融合去噪处理,可以通过以下技术方案实现:通过第n图像信息网络对噪声图像编码以及动作文本编码进行旁路控制处理,得到旁路控制结果;通过下采样网络对动作文本编码以及旁路控制结果进行下采样处理,得到下采样结果;通过上采样网络对下采样结果进行上采样处理,得到第n融合去噪结果。通过本技术实施例可以引入旁路控制,从而利用旁路控制对整体动作编辑模型进行微调,从而避免整体模型更新所耗费的计算资源。

86.在一些实施例中,第n图像信息网络包括p个级联的注意力层,p的取值满足;上述通过第n图像信息网络对噪声图像编码以及动作文本编码进行旁路控制处理,得到旁路控制结果,可以通过以下技术方案实现:将第n图像信息网络中第p注意力层的第p注意力结果传输到第p 1注意力层以继续进行第二注意力处理,得到第n图像信息网络中第p 1注意力层的第p 1注意力结果;将每个注意力层输出的第二注意力结果作为旁路控制结果。第n图像信息网络与第n融合去噪网络的结构是相同的,从而可以通过微调第n图像信息网络的参数来实现对整体动作编辑模型的微调。

87.作为示例,p为取值从1开始递增的整数变量,p的取值范围为,当p取值为1时,第p注意力层的输入为第n-1融合去噪结果,当p取值为时,第p注意力层的输入为第n图像信息网络中第p-1注意力层输出的第p-1注意力结果。

88.作为示例,每个注意力层的输入是上一个级联的注意力层的输出。上述通过第n图像信息网络中第p注意力层对第p注意力层的输入以及动作文本编码进行第二注意力处理,可以通过以下技术方案实现:对第p注意力层的输入进行基于查询矩阵的映射处理,得到注意力查询矩阵;对动作文本编码进行基于键矩阵的映射处理,得到注意力键矩阵;对动作文本编码进行基于值矩阵的映射处理,得到注意力值矩阵;将注意力查询矩阵与注意力键矩阵的转置矩阵进行相乘处理,得到相乘结果,并获取相乘结果与注意力键矩阵的维度之间的比值;对比值进行最大似然处理,并将最大似然结果与注意力值矩阵进行相乘处理,得到第一注意力特征。通过本技术实施例可以将动作指令文本有针对性融入到图像信息网络中,从而起到针对图像生成的约束作用,提高模型的训练效果。

89.在一些实施例中,下采样网络包括p个级联的注意力层;上述通过下采样网络对动作文本编码以及旁路控制结果进行下采样处理,得到下采样结果,可以通过以下技术方案实现:通过下采样网络中第p注意力层对第p注意力层的输入以及动作文本编码进行第一注意力处理,得到第一注意力特征;将第一注意力特征与第n图像信息网络中第p注意力层输出的第p注意力结果进行融合处理,得到下采样网络中第p注意力层的第p注意力结果;将下采样网络中第p注意力层的第p注意力结果传输到下采样网络中第p 1注意力层以得到下采样网络中第p 1注意力层的第p 1注意力结果;将下采样网络中第p注意力层输出的第p注意力结果作为下采样结果。

90.作为示例,p为取值从1开始递增的整数变量,p的取值范围为,当p

取值为1时,第p注意力层的输入为第n-1融合去噪结果,当p取值为时,第p注意力层的输入为第p-1注意力层输出的第p-1注意力结果。

91.作为示例,以p取值是3为例进行说明,通过下采样网络的第1注意力层对第1注意力层的输入(上一个级联的第n-1融合去噪网络的输出)以及动作文本编码进行第一注意力处理,得到第一注意力特征;将第一注意力特征与第n图像信息网络中第1注意力层输出的第1注意力结果进行融合处理,得到下采样网络中第1注意力层的第1注意力结果;将下采样网络中第1注意力层的第1注意力结果传输到下采样网络中第2注意力层以得到下采样网络中第2注意力层的第2注意力结果;将下采样网络中第3注意力层输出的第3注意力结果作为下采样结果,即第n融合去噪网络的下采样网络的每个注意力层输出的第一注意力特征会和第n图像信息网络中对应注意力层的输出融合,并将融合结果传输到下采样网络的下一个注意力层进行处理。

92.下面,继续说明本技术实施例提供的图像处理方法,如前,实现本技术实施例的图像处理方法的电子设备可以是终端或者服务器,以服务器为例进行说明。因此下文中不再重复说明各个步骤的执行主体。参见图3e,结合图3e示出的步骤201至步骤203进行说明。

93.在步骤201中,获取图像编辑请求,其中,图像编辑请求包括以下任意一种:图像渲染请求、动作编辑请求。

94.在步骤202中,当图像编辑请求是图像渲染请求时,调用图像渲染模型对图像编辑请求携带的对象图像进行图像渲染处理,得到渲染图像。

95.在步骤203中,当图像编辑请求是动作编辑请求时,调用动作编辑模型以对图像编辑请求携带的对象图像执行本技术实施例的图像处理方法,得到第二动作图像。

96.参见图6,接收用户的图像编辑请求,图像编辑请求包括以下任意一种:图像渲染请求、动作编辑请求,图像渲染请求可以是风格渲染请求或者是氛围渲染请求。图像编辑请求中携带有用户输入的图像编辑信息,根据图像编辑请求确定对应的图像编辑分支。服务器部署有模型库,包括模型系列1(写实风格的扩散模型或者是动漫风格的anythingv5模型)、模型系列2以及模型系列3(开源的instruct pix2pix模型),模型系列2包括文本模型(开源的instruct pix2pix模型)以及图像模型(开源的adain模型)。

97.作为示例,当图像编辑请求是动作编辑请求时,对图像编辑请求携带的对象图像执行步骤101至步骤104以得到第二动作图像,来响应动作编辑请求。

98.针对动作编辑请求,需要先根据图像编辑信息中记载的基础风格从系列1模型中采用写实模型(扩散模型)还是动漫模型(anythingv5模型),选择模型后基于动作指令文本进行基于对象图像的微调(一次性图像训练)并生成目标图像(第二动作图像)。

99.针对风格渲染请求,根据图像编辑信息中是否有编辑文本以及是否有风格引导图像决定具体需要执行的分支,如果编辑文本非空,则从模型系列2包括的文本模型中选择模型以生成风格与编辑文本相同的目标图像,如果引导图像非空,则从模型系列2包括的图像模型中选择模型以生成风格与引导图像相同的目标图像,当两路分支都执行时,最终输出两个目标图像供用户选择。

100.针对氛围渲染请求,从模型系列3中选择模型以生成氛围与编辑文本相同的目标图像。

101.本技术实施例针对风格渲染请求以及氛围渲染请求的分支均提供一个模型,或者

也可以参考动作编辑请求,针对每个分支各设置写实模型以及动漫模型,根据基础图像风格选择对应模型。由于原instruct pix2pix为写实模型,故实际需要做的是训练instruct pix2pix的动漫基础模型作为模型库中动漫模型的选择。

102.下面,继续说明本技术实施例提供的图像处理方法,如前,实现本技术实施例的图像处理方法的电子设备可以是终端或者服务器,以终端为例进行说明。因此下文中不再重复说明各个步骤的执行主体。显示图像编辑入口;响应于在图像编辑入口的信息输入操作,显示输入的图像编辑信息,其中,图像编辑信息包括基础图像以及编辑信息,编辑信息包括以下至少之一:编辑文本以及引导图像,编辑文本是动作指令文本或者渲染文本,引导图像以及渲染文本均表征渲染方向;响应于基于图像编辑信息的图像处理操作,显示基于编辑信息对基础图像进行编辑得到的目标图像。

103.作为示例,当编辑文本是动作指令文本时,将基础图像作为对象图像,并针对对象图像执行步骤101至步骤104得到第二动作图像,并将第二动作图像作为目标图像。

104.作为示例,当编辑文本是渲染文本时,且渲染文本是风格渲染文本时,从模型系列2包括的文本模型中选择模型以生成风格与编辑文本相同的目标图像,当编辑信息包括引导图像时,从模型系列2包括的图像模型中选择模型以生成风格与引导图像相同的目标图像。当编辑文本是渲染文本时,且渲染文本是氛围渲染文本时,从模型系列3中选择模型以生成氛围与编辑文本相同的目标图像。

105.参见图5a,图5a示出了未进行任何操作时的人机交互界面,人机交互界面中包括输入控制窗口以及图像展示窗口。

106.参见图5b,响应于在图像编辑入口的信息输入操作,显示输入的图像编辑信息,图5b示出对象图像(基础图像)以及编辑文本,编辑文本是“竖起拇指点赞”,图5b还示出了图像编辑信息所表征的图像编辑请求对应的分支(对象动作编辑)、基础风格选择是“写实”(对应调用模型系列1中的写实模型)以及基础图描述选择是“男人”,此时图像展示窗口被灰度显示,表示不可用。响应于基于图像编辑信息的图像处理操作,显示基于编辑信息对基础图像进行编辑得到的目标图像,参见图5c,图5c示出执行对象动作编辑之后的输出情况,图像展示窗口取消灰度显示,表示启用该窗口,在图像展示窗口中显示经过对象动作编辑后的目标图像。

107.参见图5d,图5d是对对象图像进行基于编辑文本中所提到的风格进行风格转换的结果。参见图5e,图5e是当输入风格引导图像(而非编辑文本)时输出引导图像风格的编辑结果。参见图5f,图5f是输入表征风格的编辑文本以及风格引导图像时,输出两个风格转化结果,从而可以从图像展示窗口的两种结果中选择1个返回。

108.下面,将说明本技术实施例在一个实际的应用场景中的示例性应用。

109.在一些实施例中,终端接收到图像编辑请求,这里的图像编辑请求携带有用户上传的图像以及动作指令文本,终端将图像编辑请求发送到服务器,服务器对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码;对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码;对噪声图像编码进行基于融合动作文本编码的去噪处理,得到将动作指令文本对应的动作

应用至对象图像的第二动作图像,并将第二动作图像返回至终端。

110.图像编辑包含以下多种情况:1、需要某个场景出现早午晚变化以作为时间变迁的转场画面;2、需要把图像转成指定风格;3、需要把图中人物手部动作改成竖起拇指点赞动作等。以上图像编辑涉及到多种输入情况、多种图像部位编辑(如图像画风或氛围需要对全局图像改变、动作变化需要局部图像改变),并且不同的图像编辑能力需要不同的模型处理,如画风编辑需要尽量维持不同画风下原图信息不丢失、时间变迁需要能维持全画面主体信息不变的模型生成、动作变化时需要对模型进行微调再生成。相关技术的图像编辑系统不能支持对象动作编辑;同时多种编辑能力分散到系统各处导致不同功能,当用户需要编辑时难以找到相应的功能按键。

111.本技术实施例设计了一种支持用户创作性图像编辑能力的系统,通过统一输入即可实现多种创作型编辑,本技术实施例提供的系统根据用户输入进行编辑模型选择、根据编辑模型的选择进行图像编辑,图像编辑后进行最终结果的展示。

112.本技术实施例中引入了对象动作编辑(包括训练和推理实现有效编辑)、场景时间变化编辑,大大提升了图像的可编辑范围,同时采用统一入口支持多种编辑能力生成,包括全图渲染的时间变化编辑、对象动作编辑、风格转换等。本技术实施例的服务通过分功能的模块调度组合整合当前最佳生成效果的模型训练与图像生成,最终可实现用户创意式图像生成。

113.参见图4a以及图4b,相关技术的方案只提供风格转化、图像加滤镜等简单的物理性编辑,无法进行对象动作编辑、图像语义层面编辑(如下雨、下雪、转黑夜等)、参考图引导的风格转化编辑等。同时该软件功能选择分布在页面多处,如动画风、图片编辑,影楼修图等,用户需要多次入口尝试才知道需要从何处获取自己需要的编辑功能,浪费用户进入应用时间、使用效率不高、造成用户烦躁。

114.申请人在实施本技术实施例时发现相关技术中的对象动作编辑方案无法确保图像的前后一致性;并且相关技术的图像编辑app难以同时提供风格渲染、语义层面图像渲染(例如,时间氛围渲染等),同时相关技术的图像编辑app的功能选择分布在页面多处,不利于用户使用。

115.本技术实施例引入对象动作编辑能力,实现语义层面的动作编辑,可以对输入图像进行文本表征的微调,再基于微调文本表征进行动作编辑,服务内部调用不需要用户人工参与。

116.本技术实施例还可以实现语义层面的氛围渲染、带引导图或者不带引导图的风格渲染等多种形式编辑,从而整体编辑功能更加丰富。

117.本技术实施例还通过统一的图像编辑输入接口进行模型调用,用户指定输入后,系统根据统一输入的信息确定调用上述何种编辑能力,同时支持不同编辑所需的输入(文本以及图像)、直接调用模型进行编辑以及对模型进行微调后编辑等多种功能,降低用户寻找各个功能入口的时间,提升编辑效率。

118.参见图7,图7示出了本技术实施例的图像氛围渲染以及风格编辑的模型推理过程。以编辑文本(表征风格)以及基础图作为输入,输入至模型系列2的模型中得到经过风格渲染的输出图,以编辑文本(表征氛围)以及基础图作为输入,输入至模型系列3的模型中得到经过氛围渲染的输出图。

119.下面介绍图像氛围渲染,本技术实施例的氛围渲染模型采用基于开源的instruct pix2pix模型,输入一张图像和编辑文本,然后通过该模型生成目标图像,需要首先对编辑文本翻译成英文,例如python edit_cli.py

ꢀ–

input input_image.jpg

ꢀ‑‑

output output.jpg

ꢀ‑‑

edit "make it nighttime",本技术实施例可以更换氛围渲染模型,除采用此开源模型外,还可以采用新训练的模型,如按照该开源模型方法收集一批新渲染数据(此模型需要较多训练样本,故需要保证对每种编辑指令各收集100张以上训练数据),微调训练上述instruct pix2pix模型以得到新训练的氛围渲染模型。

120.下面介绍基于文本的风格编辑,本技术实施例采用开源的instruct pix2pix模型,输入图像和风格编辑指令(宫崎骏风格),然后通过该模型生成目标图形,需要首先将编辑文本翻译成英文,即输入以下编辑指令“python edit_cli.py

ꢀ–

input input_image.jpg

ꢀ‑‑

output output.jpg

ꢀ‑‑

edit "hayao miyazaki style"”。

121.下面介绍基于图像的风格编辑,本技术实施例采用开源的adain模型,该模型可以支持输入对象图像以及风格引导图像,生成目标内容在引导风格下的图像,生成指令为“python test.py

ꢀ‑‑

content input_image.jpg

ꢀ–

style reference_image.jpg”。

122.参见图8,图8示出了对象动作编辑过程,将基础图描述以及编辑文本组成动作指令文本,将动作指令文本以及基础图作为输入,输入至来源于模型系列1的动作编辑模型(生成模型的基础结构,即u型网络),得到输出图,基于输出图与基础图之间的误差对动作指令文本的文本表征(embedding)以及动作编辑模型(u型网络)进行微调。将动作指令文本的原始表征与微调后的表征进行合并,将合并结果与基础图输入至微调过的动作编辑模型,得到输出图。

123.下面介绍对象动作编辑,本技术实施例的对象动作编辑基于扩散模型生成的。针对对象动作编辑,首先需要保证生成后图像必须与原图像足够相似。上述时间渲染、风格渲染的模型在保证图像一致性上效果更好(因为其训练样本即为一致性样本,即编辑前后图像内容相同),但相关技术中的对象动作编辑技术较难保证图像前后一致性。

124.故本技术实施例基于生成效果较好的扩散模型(作为动作编辑模型)提供在应用中进行微调的机制,通过把原始的对象图像与动作指令文本微调进动作编辑模型中,实现模型对对象图像的认知,然后通过微调的动作指令文本的表征与原始的动作指令文本的表征进行合并产生新表征,通过新表征驱动动作编辑模型产生目标图像。

125.本技术实施例提供的扩散模型的实现原理在于对原图像加噪声后进行编码,可以采用变分自动编码映射到潜在特征空间,经过扩散过程得到t时刻的隐空间表征,通过t次降噪过程操作还原到不加噪声的原图特征,还原后的编码特征经过变分自动解码得到目标图像。对于动作指令文本,经过clip文本分支得到文本嵌入编码后通过u型网络的注意力机制进行控制,扩散抽样用于获取将噪声图像编码的隐空间表征,后续在噪声图像编码的去噪过程中学习生成噪声表征的拟合,从而原图减去噪声表征得到真实需要的图像表征,并经过解码器得到真实需要的图像。

126.由于图生图机制无法进行对象动作编辑,故本技术实施例用以下方式保证对象动作编辑:1)把图像信息与动作指令文本作为训练样本微调到文本表征中,使得该文本表征可以包含图像信息;2)把图像信息与控制文本作为训练样本微调模型的旁路生成控制结构——图像信息网络,通过该旁路结构保证模型生成的图像与原图像更相似;3)把未经微

调的文本表征与经过微调的文本表征进行拼接,得到控制力强的文本表征,再采用微调后的模型生成图像。

127.参见图9,在对象动作编辑的微调过程中,依次进行文本表征的微调和图像信息网络的微调。例如,用户输入的编辑文本是“面带微笑”,基础图描述是“一个男人”,则动作指令文本为“面带微笑的男人”。这里取随机一个种子i产生噪声图像,将该噪声图像与基础图像叠加产生叠加图c,叠加图c经过编码以及隐空间表征(扩散过程)得到噪声图像编码z

t

。首先将噪声图像编码以及动作指令文本的原始的文本表征输入至图9所示的t个级联的去噪u型网络(去噪u型网络中每个采样层均是注意力层,在图9中用qkv对注意力层进行表示)中,通过第一个去噪u型网络可以得到中间结果z

t-1’,再通过第二个去噪u型网络x

t-1

继续处理,并对最终输出结果z’进行解码得到输出图像y,基于输出图像y与基础图像之间的误差对动作指令文本的原始的文本表征进行微调,此时不需要经过图像信息网络,直接采用原始的扩散模型对动作指令文本的原始表征微调即可,得到微调后的表征。接下来再微调图像信息网络,对扩散模型不直接微调该模型结构,而是微调旁路的图像信息网络,通过把监督图像信息微调到旁路的图像信息网络中从而可以将图像信息嵌入到动作编辑模型中。

128.参见图10,在对象动作编辑的推理过程中,这里取随机一个种子i产生噪声图像,将该噪声图像与基础图像叠加产生叠加图c,叠加图c经过编码以及隐空间表征(扩散过程)得到噪声图像编码z

t

。首先按照上述方式微调原始的文本表征,对微调后文本表征与未微调的文本表征通过拼接产生最终文本表征(融合编码),将最终文本表征以及噪声图像编码输入到微调了图像信息网络的动作编辑模型中生成输出图像,具体而言,图10所示的动作编辑模型包括t个级联的去噪u型网络(去噪u型网络中每个采样层均是注意力层)以及图像信息网络,图像信息网络也是由多个注意力层级联得到的,在图10中用qkv对注意力层进行表示,通过第一个去噪u型网络可以得到中间结果z

t-1’,再通过第二个去噪u型网络x

t-1

继续处理,并对最终输出结果z’进行解码得到输出图像y。

129.此处必须要把未微调的文本表征放在最前面,由于未微调的文本表征保留了更多的编辑能力,而已经微调的文本表征代表的是基础图像,基础图像信息无法提供编辑控制信息,故必须要未微调的文本表征在前来保证更高的编辑能力。另外需要强调的是,由于动作指令文本较短,因此前38个向量足以覆盖所有有意义的文本表征,所以最终文本表征采取前38后39的结构拼接足以满足动作编辑与基础图像表征需求。合并时可以采用文本表征(embedding)拼接的方法,也可以采用embedding加权求和的方法得到最终embedding。

130.下面介绍微调过程。微调的图文对为(基础图像,动作指令文本),即(基础图像,a man with a big smile)。对1张输入图像共进行n轮(如20)迭代,在每轮迭代过程中,1张输入图像在模型中均被训练完一次称为一轮迭代。训练采用图文对样本,对某个图文对样本,原图用于添加噪声后作为噪声图输入变分自编码器,文本用于生成约束,原图同时用于损失计算,下面介绍训练方案。

131.首先,进行参数初始化,对变分自编码器、文本编码器、u型网络采用开源已训练好的扩散模型参数并且在本训练中仅u型网络的参数需要更新,其他参数不更新。初始化采用0.0004 的学习率,以后每10轮学习后学习率变为原来的0.1倍,共训练20轮。

132.接着,取随机一个种子i产生噪声图,将该噪声图与原图叠加产生图x,图x经过隐空间表征产生z

t

。然后,把文本信息经过文本图像对比模型得到文本表征,输入到动作编辑

模型中(将文本表征作为kv信息),并对z

t

在kv约束下进行t次u型网络前向计算,第1次前向计算后得到z

t-1

,最终t次后u型网络输出得到预测z0,经过解码网络得到预测图像。

133.接着,计算批次损失,即统计该批次样本的总损失。具体而言,采用mse损失由输出预测图像,图文对的图像的均方误差计算。作为示例,参见公式(5)

ꢀꢀꢀꢀꢀꢀ

(5);其中,是原始图像中位置i的第二像素值,是生成图像中位置i的第一像素值,是原始图像与生成图像之间的误差。

134.然后,采用随即梯度下降方法,把损失反向回传到模型中得到模型参数(u-net)的梯度并更新参数。最后,完成所有多个批次训练,结束迭代。

135.在一些实施例中,根据统一输入中的信息,确定选择何种编辑,根据选择的编辑(风格渲染、氛围渲染、对象动作编辑)采用不同的分支处理,并返回生成的图像给用户。对于既有编辑文本描述,又有参考图像的风格渲染,提供两个分支的生成效果供用户选择。

136.本技术实施例引入对象动作编辑能力实现语义层面的人物图像编辑,以及一种有效的对象动作编辑方法。本技术实施例引入语义层面图像时间氛围渲染、带或不带引导图的风格转化编辑等多种形式编辑,实现整体编辑功能丰富。本技术实施例通过统一语义图像编辑输入接口,用户指定输入后,系统根据统一输入的信息服务产生图像并返回展示,降低用户探索应用的时间,提升编辑效率。

137.可以理解的是,在本技术实施例中,涉及到用户信息等相关的数据,当本技术实施例运用到具体产品或技术中时,需要获得用户许可或者同意,且相关数据的收集、使用和处理需要遵守相关国家和地区的相关法律法规和标准。

138.下面继续说明本技术实施例提供的图像处理装置255-1的实施为软件模块的示例性结构,在一些实施例中,如图2所示,存储在存储器250的图像处理装置255-1中的软件模块可以包括编码模块2551,用于对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;微调模块2552,用于对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码;融合模块2553,用于对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码;生成模块2554,用于对噪声图像编码进行基于融合动作文本编码的去噪处理,得到第二动作图像,其中,第二动作图像是将动作指令文本对应的动作应用至对象图像所包括对象的结果。

139.在一些实施例中,文本编码处理是通过调用文本图像对比模型中的文本模型实现的,编码模块2551,还用于获取多个第一文本样本以及与每个第一文本样本匹配的第一图像样本;通过文本图像对比模型的视觉模型对每个第一图像样本进行图像编码处理,得到每个第一图像样本的图像编码;通过文本图像对比模型的文本模型对每个第一文本样本进行文本编码处理,得到每个第一文本样本的文本编码;基于每个第一文本样本的文本编码、每个第一图像样本的图像编码、以及每个第一文本样本与每个第一图像样本之间的匹配关系,确定文本图像对比损失;基于文本图像对比损失更新文本图像对比模型的参数。

140.在一些实施例中,编码模块2551,还用于将对象图像与噪声图像进行叠加处理,得到叠加图像;对叠加图像进行图像隐空间编码处理,得到噪声图像编码。

141.在一些实施例中,基于第一动作文本编码的去噪处理是通过图像生成模型实现的,图像生成模型包括n个级联的去噪网络以及解码网络,n的取值满足;微调模块2552,还用于:通过n个级联的去噪网络中第n去噪网络,对第n去噪网络的输入进行去噪处理,并将第n去噪网络输出的第n去噪结果传输到第n 1去噪网络以继续进行去噪处理,得到对应第n 1去噪网络的第n 1去噪结果;通过解码网络对第n去噪网络输出的去噪结果进行解码处理,得到第一动作图像;其中,n为取值从1开始递增的整数变量,n的取值范围为,当n取值为1时,第n去噪网络的输入为噪声图像编码以及第一动作文本编码,当n取值为时,第n去噪网络的输入为第n-1去噪网络输出的第n-1去噪结果以及第一动作文本编码。

142.在一些实施例中,第n去噪网络包括m个级联的注意力层;微调模块2552,还用于通过第n去噪网络中第m注意力层对第m注意力层的输入以及第一动作文本编码进行第一注意力处理,得到第一注意力特征作为第n去噪网络中第m注意力层的第m注意力结果;将第n去噪网络中第m注意力层的第m注意力结果传输到第m 1注意力层以继续进行注意力处理,得到第n去噪网络中第m 1注意力层的第m 1注意力结果;将第n去噪网络中第m注意力层输出的第m注意力结果作为第n去噪结果;其中,m为取值从1开始递增的整数变量,m的取值范围为,当m取值为1时,第m注意力层的输入为第n-1融合去噪结果,当m取值为时,第m注意力层的输入为第m-1注意力层输出的第m-1注意力结果。

143.在一些实施例中,微调模块2552,还用于对第m注意力层的输入进行基于查询矩阵的映射处理,得到注意力查询矩阵;对第一动作文本编码进行基于键矩阵的映射处理,得到注意力键矩阵;对第一动作文本编码进行基于值矩阵的映射处理,得到注意力值矩阵;将注意力查询矩阵与注意力键矩阵的转置矩阵进行相乘处理,得到相乘结果,并获取相乘结果与注意力键矩阵的维度之间的比值;对比值进行最大似然处理,并将最大似然结果与注意力值矩阵进行相乘处理,得到第一注意力特征。

144.在一些实施例中,微调模块2552,还用于获取第一动作图像中每个位置的第一像素值、以及对象图像中每个位置的第二像素值;针对每个位置,获取第一像素值与第二像素值之间的误差;对多个位置的误差进行融合处理,得到第一动作图像与对象图像之间的误差,并基于第一损失对第一动作文本编码进行更新处理,得到第二动作文本编码。

145.在一些实施例中,基于第一动作文本编码的去噪处理是通过图像生成模型实现的,微调模块2552,还用于当基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理时,基于第一动作图像与对象图像之间的误差对图像生成模型进行更新处理,得到经过更新的图像生成模型。

146.在一些实施例中,融合模块2553,还用于对第一动作文本编码进行基于第一数目的截取处理,得到第一截取编码,其中,第一截取编码包括第一动作文本编码中位置靠前的第一数目的向量;对第二动作文本编码进行基于第二数目的截取处理,得到第二截取编码,其中,第二截取编码包括第二动作文本编码中位置靠前的第二数目的向量;将第二截取编码拼接至第一截取编码的尾部,得到融合动作文本编码。

147.在一些实施例中,基于第一动作文本编码的去噪处理是通过图像生成模型实现

的,基于融合动作文本编码的去噪处理是通过图像编辑模型实现的,图像编辑模型包括图像生成模型以及多个图像信息网络;在对噪声图像编码进行基于融合动作文本编码的去噪处理,得到第二动作图像之前,生成模块2554,还用于将噪声图像编码以及第一动作文本编码在图像编辑模型中进行正向传播,得到第三动作图像;基于第三动作图像与对象图像之间的误差对图像编辑模型中的多个图像信息网络进行更新处理,得到更新后的图像编辑模型。

148.在一些实施例中,图像生成模型包括n个级联的去噪网络以及解码网络,n的取值满足,图像编辑模型是在图像生成模型的基础上针对每个去噪网络配置一个图像信息网络得到的,每个去噪网络以及对应的图像信息网络构成融合去噪网络,多个融合去噪网络的级联关系与多个去噪网络的级联关系相同;生成模块2554,还用于通过n个级联的融合去噪网络中第n融合去噪网络,对第n融合去噪网络的输入进行融合去噪处理,并将第n融合去噪网络输出的第n融合去噪结果传输到第n 1融合去噪网络以继续进行融合去噪处理,得到对应第n 1融合去噪网络的第n 1融合去噪结果;对第n融合去噪网络输出的融合去噪结果进行解码处理,得到第三动作图像;其中,n为取值从1开始递增的整数变量,n的取值范围为,当n取值为1时,第n融合去噪网络的输入为噪声图像编码以及第一动作文本编码,当n取值为时,第n融合去噪网络的输入为第n-1融合去噪网络输出的第n-1融合去噪结果以及第一动作文本编码。

149.在一些实施例中,第n融合去噪网络包括多个下采样网络以及多个上采样网络、对应第n去噪网络的第n图像信息网络;生成模块2554,还用于通过第n图像信息网络对噪声图像编码以及第一动作文本编码进行旁路控制处理,得到旁路控制结果;通过下采样网络对第一动作文本编码以及旁路控制结果进行下采样处理,得到下采样结果;通过上采样网络对下采样结果进行上采样处理,得到第n融合去噪结果。

150.在一些实施例中,第n图像信息网络包括p个级联的注意力层;生成模块2554,还用于将第n图像信息网络中第p注意力层的第p注意力结果传输到第p 1注意力层以继续进行第二注意力处理,得到第n图像信息网络中第p 1注意力层的第p 1注意力结果;将每个注意力层输出的第二注意力结果作为旁路控制结果;其中,p为取值从1开始递增的整数变量,p的取值范围为,当p取值为1时,第p注意力层的输入为第n-1融合去噪结果,当p取值为时,第p注意力层的输入为第n图像信息网络中第p-1注意力层输出的第p-1注意力结果。

151.在一些实施例中,下采样网络包括p个级联的注意力层;生成模块2554,还用于通过下采样网络中第p注意力层对第p注意力层的输入以及第一动作文本编码进行第一注意力处理,得到第一注意力特征;将第一注意力特征与第n图像信息网络中第p注意力层输出的第p注意力结果进行融合处理,得到下采样网络中第p注意力层的第p注意力结果;将下采样网络中第p注意力层的第p注意力结果传输到下采样网络中第p 1注意力层以得到下采样网络中第p 1注意力层的第p 1注意力结果;将下采样网络中第p注意力层输出的第p注意力结果作为下采样结果;其中,p为取值从1开始递增的整数变量,p的取值范围为,当p取值为1时,第p注意力层的输入为第n-1融合去噪结果,当p取值为时,第p注意力层的输入为第p-1注意力层输出的第p-1注意力结果。

152.下面继续说明本技术实施例提供的图像处理装置255-2的实施为软件模块的示例

性结构,在一些实施例中,如图2所示,存储在存储器250的图像处理装置255-2中的软件模块可以包括获取模块2556,用于获取图像编辑请求,其中,图像编辑请求包括以下任意一种:图像渲染请求、动作编辑请求;渲染模块2557,用于当图像编辑请求是图像渲染请求时,调用图像渲染模型对图像编辑请求携带的对象图像进行图像渲染处理,得到渲染图像;动作模块2558,用于当图像编辑请求是动作编辑请求时,调用图像编辑模型以对图像编辑请求携带的对象图像执行本技术实施例的图像处理方法,得到第二动作图像。

153.下面继续说明本技术实施例提供的图像处理装置的实施为软件模块的示例性结构,在一些实施例中,存储在存储器的图像处理装置中的软件模块可以包括显示模块,用于显示图像编辑入口;输入模块,用于响应于在图像编辑入口的信息输入操作,显示输入的图像编辑信息,其中,图像编辑信息包括基础图像以及编辑信息,编辑信息包括以下至少之一:编辑文本以及引导图像,编辑文本是动作指令文本或者渲染文本,引导图像以及渲染文本均表征渲染方向;编辑模块,用于响应于基于图像编辑信息的图像处理操作,显示基于编辑信息对基础图像进行编辑得到的目标图像。

154.本技术实施例提供了一种计算机程序产品,该计算机程序产品包括计算机可执行指令,该计算机可执行指令存储在计算机可读存储介质中。电子设备的处理器从计算机可读存储介质读取该计算机可执行指令,处理器执行该计算机可执行指令,使得该电子设备执行本技术实施例上述的方法。

155.本技术实施例提供一种存储有计算机可执行指令的计算机可读存储介质,其中存储有计算机可执行指令,当计算机可执行指令被处理器执行时,将引起处理器执行本技术实施例提供的方法。

156.在一些实施例中,计算机可读存储介质可以是fram、rom、prom、eprom、eeprom、闪存、磁表面存储器、光盘、或cd-rom等存储器;也可以是包括上述存储器之一或任意组合的各种设备。

157.在一些实施例中,计算机可执行指令可以采用程序、软件、软件模块或脚本的形式,按任意形式的编程语言(包括编译或解释语言,或者声明性或过程性语言)来编写,并且其可按任意形式部署,包括被部署为独立的程序或者被部署为模块、组件、子例程或者适合在计算环境中使用的其它单元。

158.作为示例,计算机可执行指令可以但不一定对应于文件系统中的文件,可以可被存储在保存其它程序或数据的文件的一部分,例如,存储在超文本标记语言(html,hyper text markup language)文档中的一个或多个脚本中,存储在专用于所讨论的程序的单个文件中,或者,存储在多个协同文件(例如,存储一个或多个模块、子程序的文件)中。

159.作为示例,可执行指令可被部署为在一个电子设备上执行,或者在位于一个地点的多个电子设备上执行,又或者,在分布在多个地点且通过通信网络互连的多个电子设备上执行。

160.综上,通过本技术实施例对对象图像进行加噪处理,得到噪声图像编码,并对动作指令文本进行文本编码处理,得到第一动作文本编码;对噪声图像编码进行基于第一动作文本编码的去噪处理,得到第一动作图像,并基于第一动作图像与对象图像之间的误差对第一动作文本编码进行更新处理,得到第二动作文本编码,这里相当于对动作指令文本的表征进行微调,从而确保图像处理过程中对原始的对象图像的认知,控制图像编辑过程中

的一致性,对第一动作文本编码以及第二动作文本编码进行融合处理,得到融合动作文本编码,对噪声图像编码进行基于融合动作文本编码的去噪处理,得到将动作指令文本对应的动作应用至对象图像所包括对象的结果,由于是基于融合动作文本编码控制生成的结果,因此可以在保证图像一致性的情况下实现动作编辑。

161.以上所述,仅为本技术的实施例而已,并非用于限定本技术的保护范围。凡在本技术的精神和范围之内所作的任何修改、等同替换和改进等,均包含在本技术的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。