1.本发明涉及时间同步误差感知的边端协同分布式能源调控方法及系统,属于通信技术领域。

背景技术:

2.目前,低碳智慧园区中部署大量的可再生能源、可控负荷和分布式储能等多能源主体,是实现碳减排、碳中和,以及绿色可持续发展的基本单元。然而,由于分布式资源如风电、光伏等属于间歇性能源,随机波动的分布式能源供给和负荷需求之间难以实现稳定的供需平衡,严重影响电网安全稳定运行。因此,亟需研究低碳智慧园区分布式能源调控方法,对分布式资源进行统一协同管理,以消除能源调度盲区,从而实现资源互补、时空关联,促进新能源消纳,确保电力稳定供应。

3.为支撑低碳智慧园区分布式能源调控,包含大量电力设备与传感器节点的终端层采集光伏板、充电桩、可控负荷的电压、电流、有功/无功功率等海量运行状态数据。基于这些采集数据,可利用联邦学习训练分布式能源调控模型,形成电网运行状态、负荷状态等到光伏并网、负荷投切、储能充放电等分布式能源调控策略的映射。基于联邦学习的分布式能源调控模型训练通过边端之间模型的共享聚合,避免了大量原始采集数据的交互。具体来说,边缘网关与终端设备分别训练分布式能源调控全局模型和本地模型,并以迭代交互的方式协同优化模型训练性能,每次迭代交互包括四个步骤,即边端时间同步、网关全局模型下发、设备本地模型训练和上传、网关全局模型聚合,利用聚合的全局模型生成分布式能源调控策略。模型训练时延和训练精度是影响分布式能源调控策略时效性和有效性的关键指标。其中,模型训练时延包括模型传输时延、本地模型训练时延、全局模型聚合时延;模型训练精度与上传的本地模型数量和边端时间同步误差有关。模型训练性能由包括路由管理、设备调度在内的网络资源管理策略决定,因此,需要对网关和设备之间的网络资源进行协同管理优化,以实现低时延、高精度的分布式能源调控模型训练。然而,分布式能源调控模型训练仍需解决以下挑战:

4.第一,园区中网关与设备之间基于电力线通信(power line communication,plc)进行时间同步,然而时间同步过程容易受信道条件和电磁干扰等因素影响,造成较大的时间同步误差,从而导致参与全局模型聚合的设备数据不同步,降低分布式能源调控模型训练的精度。

5.第二,分布式能源调控模型训练时延依赖于网络资源管理策略,然而针对设备的路由管理存在对抗性竞争问题,当多个设备选择同一个中继进行本地模型上传时,会由于频谱和功率等资源的限制,导致中继和网关间较大的模型传输时延,从而影响分布式调控模型训练性能。

6.第三,为优化分布式能源调控策略,模型训练的精度和时延性能需要权衡。一方面,为确保模型的精度,网关需要调度更多的设备进行全局模型聚合以满足充分的环境观测需求,然而,如果被调度设备计算资源和信道条件较差会增大模型训练的时延,难以保障

分布式能源调控策略的时效性;另一方面,调度少量设备以减小模型训练时延则会导致不充分的环境观测,从而降低模型训练精度,难以保障分布式能源调控策略的有效性。

7.有鉴于上述的缺陷,本发明以期创设一种时间同步误差感知的边端协同分布式能源调控方法及系统,使其更具有产业上的利用价值。

技术实现要素:

8.为解决上述技术问题,本发明的目的是提供一种时间同步误差感知的边端协同分布式能源调控方法及系统。实现智慧园区分布式能源调控模型训练与策略优化,同时考虑时间同步误差的影响,利用惩罚竞争深度q网络(pddqn)解决路由选择的对抗性竞争,减少边端同步时延和同步误差,实现高精度、低时延的分布式能源调控模型训练,支撑低碳智慧园区分布式能源调控策略优化。

9.本发明的时间同步误差感知的边端协同分布式能源调控方法,具体调控步骤为:

10.获得边层时间同步信号,通过边缘网关从卫星或地面基站接收时间同步信号;

11.将所述边层时间同步信号传输至终端层,并基于边端协同训练分布式能源调控全局模型和本地模型,建立路由选择及时间同步模型、基于时间同步误差的设备调度及本地模型训练模型、分布式能源调控全局聚合模型和模型训练时延模型;

12.基于所述路由选择及时间同步模型中的长期时间同步误差约束、基于时间同步误差的设备调度及本地模型训练模型、分布式能源调控全局聚合模型和模型训练时延模型,获得边端协同下基于路由选择和设备调度策略优化的分布式能源调控模型训练优化问题模型;

13.将上述边端协同分布式能源调控模型训练优化问题模型基于伸缩和和虚拟队列进行转换,进一步转化为马尔可夫问题,并基于pddqn的时间同步误差敏感边端协同分布式能源调控算法进行求解,根据求解结果,获得所述路由选择与设备调度策略,以及训练后的所述分布式能源调控全局模型,确定时间同步误差感知的边端协同分布式能源调控。

14.进一步的,所述路由选择及时间同步模型具体为:

15.④

基于ptp的网关与中继之间的时间同步过程

16.在第t次迭代中,网关m0通过ptp协议实现与中继sj之间的时间同步,获得两者之间delay_req与sync时间同步报文传输的时间戳则网关m0与中继sj之间的时间同步误差表示为:

[0017][0018]

其中,|ud(t)|为delay_req报文的大小,|us(t)|为sync报文的大小,和分别为网关m0与中继sj之间的上行及下行传输速率;

[0019]

⑤

基于ptp的中继与设备之间的时间同步过程

[0020]

同理,基于ptp的中继与设备之间的时间同步过程中获得时间同步报文传输时间戳分别为和则第t次迭代中继sj与设备mi之间的时间同步误差表示为:

[0021][0022]

其中,和分别为中继sj与设备mi之间的上行及下行传输速率;

[0023]

综上,网关m0和设备mi之间的时间同步误差表示为:

[0024][0025]

⑥

长期时间同步误差约束

[0026]

长期时间同步误差约束为:

[0027][0028]

其中,e

i,max

表示m0与mi之间的长期同步误差的最大阈值。

[0029]

进一步的,所述基于时间同步误差的设备调度及本地模型训练模型具体为:

[0030]

第t次迭代中,可调度设备的集合表示为即,e

max

为短期时间同步误差约束,用于对设备的可调度性进行区分。设备调度指示变量用二进制变量ai(t)∈{0,1}表示,其中,ai(t)=1表示第t次迭代中设备mi参与模型训练,否则ai(t)=0;

[0031]

网关m0通过所选择的中继下发全局模型ω(t-1)给被调度设备mi;然后,设备mi更新本地模型ωi(t)=ω(t-1)并基于状态信息数据样本集合执行本地模型训练,其中为设备mi的第k个数据样本,βi(t)为设备mi的在第t次迭代中数据样本的数量;为衡量本地模型训练的精度,定义设备mi在第t次迭代的本地损失函数为:

[0032][0033]

其中,表示训练样本的损失函数,随着ei(t)的增大而增大,fi(ωi(t),t,ei(t))用于本地模型更新,基于梯度下降法,设备mi的本地模型为:

[0034][0035]

其中,σ为学习步长;

[0036]

设备mi的本地模型训练时延表示为:

[0037][0038]

其中,ψ为训练一个数据样本所需的cpu周期数,fi(t)为mi可用计算资源。

[0039]

进一步的,所述分布式能源调控全局聚合模型具体为:

[0040]

本地模型训练结束后,设备mi通过对应的中继sj上传本地模型到网关m0,并在网关处执行全局模型聚合

[0041][0042]

评估全局模型训练精度的全局模型损失函数表示为:

[0043][0044]

其中,e(t)={ei(t)|ai(t)=1}。

[0045]

进一步的,所述模型训练时延模型具体为:

[0046]

(1)上下行传输速率

[0047]

在第t次迭代中,网关m0与中继sj之间下行传输速率为

[0048][0049]

其中,ns为ofdm符号传输速率,为第t次迭代网关m0与中继sj之间的下行传输功率,为第t次迭代网关m0与中继sj之间的频率响应,表示网关m0与中继sj之间的信干噪比(signal to interference plus noise ratio,sinr)间隙,为第t次迭代网关m0与中继sj之间的电磁干扰功率,δ0为高斯白噪声功率;

[0050]

同理,可将网关m0与中继sj之间上行传输速率、中继sj与设备mi之间的下行传输速率、中继sj与设备mi之间的上行传输速率分别表示为和

[0051]

(2)模型传输时延

[0052]

在第t次迭代中,从网关m0到设备mi的全局模型下发时延包括从m0到sj的下行传输时延和从sj到mi的下行传输时延,表示为:

[0053][0054]

其中,|ω(t-1)|表示全局模型的大小;

[0055]

在第t次迭代中,从设备mi到网关m0的本地模型上传时延包括从mi到sj的上行传输时延和从sj到m0的上行传输时延,表示为:

[0056][0057]

其中,|ωi(t)|表示本地模型的大小;

[0058]

(3)分布式能源调控模型训练总时延

[0059]

在第t次迭代中,设备mi的训练总时延包括全局模型下发时延、本地模型训练时延和本地模型上传时延,表示为:

[0060][0061]

全局模型聚合在被调度设备完成本地模型上传之后执行,因此,在第t次迭代中,分布式能源调控模型训练总时延表示为:

[0062][0063]

其中,τg为全局模型聚合时延。

[0064]

进一步的,所述边端协同下基于路由选择和设备调度策略优化的分布式能源调控模型训练优化问题模型具体为:

[0065]

定义路由选择和设备调度的优化变量分别为和该优化问题可建模为:

[0066]

p1:

[0067][0068][0069][0070][0071][0072][0073]

其中,v是权重参数,用于动态权衡全局损失函数与平均模型训练总时延;c1,c2和c3为路由选择约束,表示每次迭代中网关最多只能为每个设备选择一个中继;c4和c5为设备调度约束,表示第t次迭代中仅集合内设备是可调度的;c6为长期时间同步误差约束。

[0074]

基于伸缩和定理和虚拟队列,将长期优化目标变量f(ω(t),t,e(t))和长期时间同步误差约束c6进行解耦,p1转换为其中,vd是权衡队列波动和π(t)最小化的权重。

[0075]

进一步的,所述为马尔可夫问题包括状态空间、动作空间与奖励函数,具体定义如下:

[0076]

1)状态空间:

[0077]

基于pddqn的路由选择优化的状态空间包括数据样本数量、时间同步误差最大阈值、delay_req报文大小、sync报文大小和电磁干扰功率,即

[0078]

基于dqn的设备调度优化的状态空间为其中,e'(t),g(t),β(t)分别为时间同步误差、同步误差赤字和可调度设备数据样本数量的集合,即,

[0079]

2)动作空间:

[0080]

定义路由选择优化的动作空间为其中,

[0081]

定义设备调度优化问题的动作空间为aa(t)=a(t);

[0082]

3)奖励函数:

[0083]

路由选择和设备调度优化的奖励函数定义为p2的优化目标re(t)。

[0084]

进一步的,所述基于pddqn的时间同步误差敏感边端协同分布式能源调控算法的具体步骤为:

[0085]

①

初始化阶段:初始化时间同步误差赤字gi(t)、路由选择和设备调度变量x(t),a(t)为0;

[0086]

②

对抗性路由选择和时间同步阶段:每次迭代开始时,m0为每个设备选择具有最大的动作,当存在对抗性竞争即m0为不同设备选择同一中继时,将中继分配给q值较大的设备,如果两个设备q值相同,将中继随机分配给其中一个设备,对于未成功分配中继的设备,网关将基于该设备剩余q值中的最大值进行中继分配直至所有中继都被分配,或全部设备都已被分配中继。随后,m0基于最终路由选择策略完成边端时间同步。

[0087]

③

设备调度决策阶段:m0根据得到mi的时间同步误差,并得到可调度设备集合随后,m0基于ε-greedy算法和qa(sa(t),aa(t),ν

main

)选择时间同步误差敏感的设备调度策略

[0088]

④

模型训练阶段:基于路由选择和设备调度决策,m0下发全局模型给被调度设备;接着,mi根据执行本地模型训练并上传训练后的本地模型到m0;随后,m0根据执行全局模型聚合;最后,m0根据公式gi(t 1)=max{gi(t) ei(t)-e

i,max

,0}更新时间同步误差赤字gi(t 1)并根据计算奖励re(t);

[0089]

⑤

对抗性pddqn学习阶段:对于设备mi,m0将当前状态转换到下一状态同时,生成一个pddqn样本存入经验回放池并覆盖之前的pddqn样本其中,z是的大小;设被分配给设备mi的中继为所提算法target定义惩罚函数为:

[0090][0091]

其中,为在第t次迭代中被选择分配给不同设备的次数,反映了对抗性竞争强度;基于惩罚函数,定义第z个pddqn样本的td误差为:

[0092][0093]

其中,γ

x

是pddqn的折扣因子;根据是pddqn的折扣因子;根据越大表明在路由选择优化中被选择的次数越多,即对抗性竞争强度越大,而这产生的较大的td误差使pddqn沿着更倾向于避免选择的方向更新,解决了对抗性竞争问题;

[0094]

m0在pddqn经验回放池中随机抽取s个经验样本组成集合且满足s<z,则pddqn的损失函数为:

[0095][0096]

基于梯度下降法,m0更新为:

[0097][0098]

其中,为pddqn学习速率;pddqn目标网络每t0>1次迭代更新一次,更新为

[0099]

⑥

dqn学习阶段:m0将当前状态sa(t)转换到下一状态sa(t 1);同时,生成一个dqn样本存入经验回放池并覆盖之前的dqn样本其中,k是的大小;定义第k个dqn样本的td误差为:

[0100][0101]

其中,γa为dqn折扣因子;

[0102]

m0在dqn经验回放池中随机抽取h个经验样本组成集合且满足h<k;dqn的损失函数为:

[0103][0104]

基于梯度下降法,m0更新ν

main

为:

[0105][0106]

其中,为dqn学习速率;dqn目标网络每t0>1次迭代更新一次,更新为ν

target

=ν

main

;

[0107]

重复上述步骤

②

到步骤

⑥

,直至t次迭代结束;随后,利用训练后的分布式能源调控模型,根据实时负载、储能单元状态、光照强度等输入,可以生成分布式能源调控策略,以改善能源供需平衡,并促进可再生能源利用。

[0108]

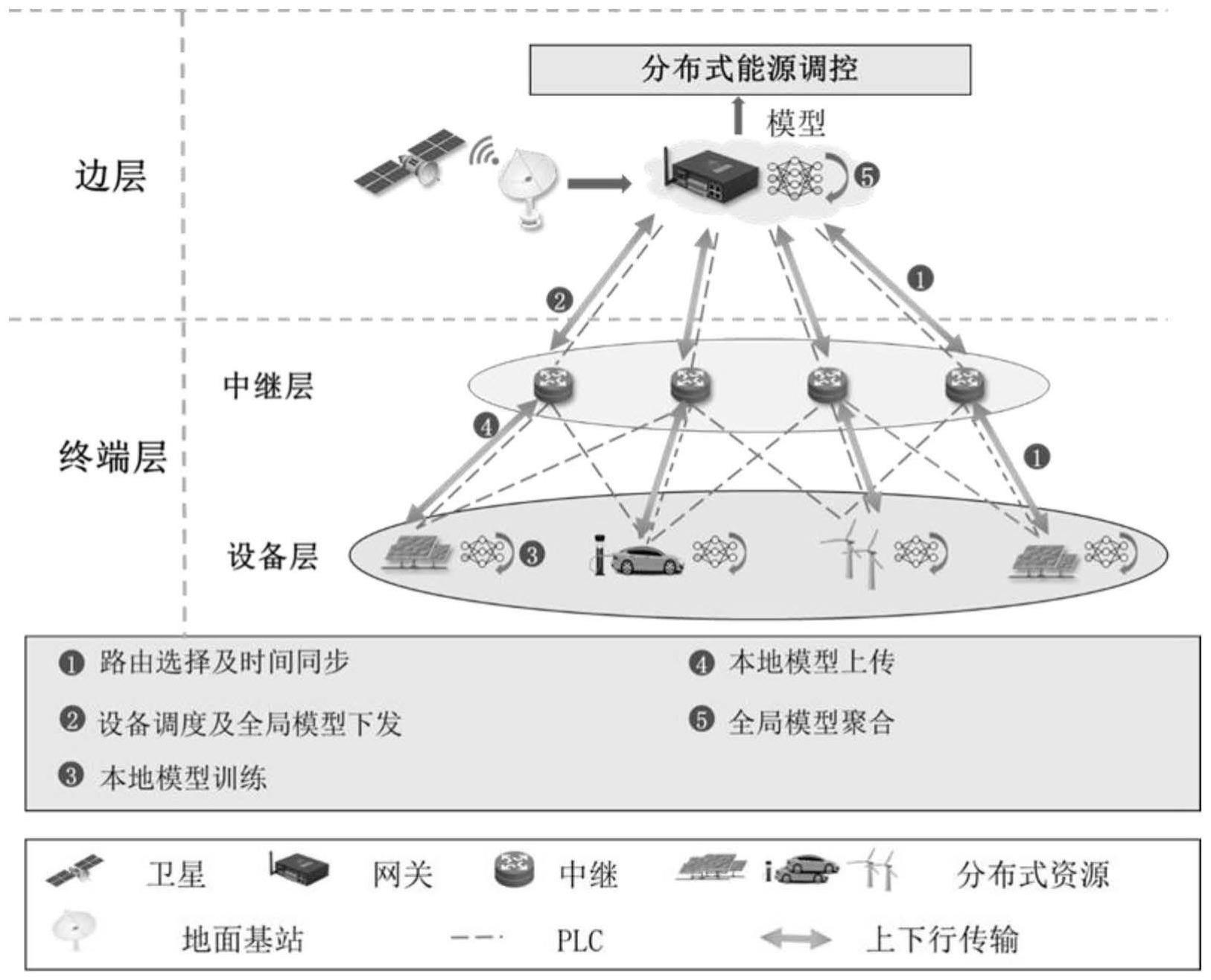

时间同步误差感知的边端协同分布式能源调控系统,包括边层和终端层;

[0109]

其中:

[0110]

边层包括一个边缘网关;

[0111]

边缘网关用于从卫星或地面基站接收时间同步信号,通过plc对终端层进行授时,并负责进行分布式能源调控全局模型的聚合,边缘网关基于所提时间同步误差感知的边端协同分布式能源调控方法优化时间同步与模型交互的路由选择,以及优化参与全局模型聚合的设备调度,支撑低时延、高精度分布式能源调控模型训练;

[0112]

终端层包括中继层和设备层;

[0113]

中继层用于连接底层设备和网关,负责边端之间时间同步及模型转发;

[0114]

设备层用于收集电气设备的状态信息并执行本地模型训练,并基于所提时间同步误差感知的边端协同分布式能源调控方法生成的路由选择和设备调度策略进本地模型上传。

[0115]

一种时间同步误差感知的边端协同分布式能源调控装置,包括:

[0116]

信号获取模块:用于获得边层时间同步信号,通过边缘网关从卫星或地面基站接收时间同步信号;

[0117]

建模模块:用于将所述边层时间同步信号传输至终端层,并基于边端协同训练分布式能源调控全局模型和本地模型,建立路由选择及时间同步模型、基于时间同步误差的设备调度及本地模型训练模型、分布式能源调控全局聚合模型和模型训练时延模型;

[0118]

优化建模模块:用于基于所述路由选择及时间同步模型中的长期时间同步误差约束、基于时间同步误差的设备调度及本地模型训练模型、分布式能源调控全局聚合模型和模型训练时延模型,获得边端协同下基于路由选择和设备调度策略优化的分布式能源调控模型训练优化问题模型;

[0119]

转化计算模块:用于将上述边端协同分布式能源调控模型训练优化问题模型基于伸缩和和虚拟队列进行转换,进一步转化为马尔可夫问题,并基于pddqn的时间同步误差敏感边端协同分布式能源调控算法进行求解,根据求解结果,获得所述路由选择与设备调度策略,以及训练后的所述分布式能源调控全局模型,确定时间同步误差感知的边端协同分布式能源调控。

[0120]

进一步的,

[0121]

所述优化建模模块中,边端协同下基于路由选择和设备调度策略优化的分布式能源调控模型训练优化问题模型具体为:

[0122]

p1:

[0123][0124][0125][0126][0127]

[0128][0129]

其中,v是权重参数,用于动态权衡全局损失函数与平均模型训练总时延;c1,c2和c3为路由选择约束,表示每次迭代中网关最多只能为每个设备选择一个中继;c4和c5为设备调度约束,表示第t次迭代中仅集合内设备是可调度的;c6为长期时间同步误差约束。

[0130]

借由上述方案,本发明至少具有以下优点:

[0131]

1.本发明提出时间同步误差感知的边端协同分布式能源调控方法,通过联合优化路由选择和设备调度策略以实现边侧网关和端侧设备协同的分布式能源调控模型训练,以最小化基于时间同步误差的全局损失函数和平均模型训练总时延的加权和为优化目标,动态权衡模型精度和时延,为智慧园区低碳运行提供低时延、高精度的分布式能源调控策略。

[0132]

2.本发明解决了分布式能源调控模型训练中对抗性竞争与时间同步感知的问题。通过网关协调与基于中继选择次数的惩罚函数设计,解决不同设备在路由选择中的对抗性竞争问题,缓解了因对抗性竞争导致的模型训练时延增长问题;通过短期与长期时间同步误差约束设置与虚拟赤字队列转换,筛选可调度设备集合,并基于时间同步误差赤字动态调整路由选择与设备调度策略,实现时间同步误差感知,缓解由于时间同步误差较大导致的模型训练精度下降问题。

[0133]

3.本发明提出时间同步误差感知的边端协同分布式能源调控系统,包括边层和终端层。在边端协同的分布式能源调控模型训练与策略优化下,边层网关基于所提方法生成的路由选择和设备调度策略对中继和设备进行时间同步,并下发全局模型,设备基于所提方法生成的路由选择和设备调度策略进行本地模型训练与上传,最终网关进行分布式能源调控全局模型的聚合,实现低时延、高精度分布式能源调控。

[0134]

上述说明仅是本发明技术方案的概述,为了能够更清楚了解本发明的技术手段,并可依照说明书的内容予以实施,以下以本发明的较佳实施例并配合附图详细说明如后。

附图说明

[0135]

为了更清楚地说明本发明实施例的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,应当理解,以下附图仅示出了本发明的某个实施例,因此不应被看作是对范围的限定,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他相关的附图。

[0136]

图1是本发明的系统模型图;

[0137]

图2是本发明的算法流程图;

[0138]

图3是本发明v2g调节前后的负荷曲线(target);

[0139]

图4是本发明v2g调节前后的负荷曲线(fcs-rms);

[0140]

图5是本发明v2g调节前后的负荷曲线(ds-rms)。

具体实施方式

[0141]

下面结合附图和实施例,对本发明的具体实施方式作进一步详细描述。以下实施例用于说明本发明,但不用来限制本发明的范围。

[0142]

整个技术方案包括整体系统和具体方法两部分。

[0143]

1.整体系统

[0144]

如图1所示,时间同步误差感知的边端协同分布式能源调控系统包括边层和终端层。

[0145]

边层包含一个边缘网关,边缘网关从卫星或地面基站接收时间同步信号,通过plc对终端层进行授时,并负责进行分布式能源调控全局模型的聚合。边缘网关基于所提时间同步误差感知的边端协同分布式能源调控方法优化时间同步与模型交互的路由选择,以及优化参与全局模型聚合的设备调度,支撑低时延、高精度分布式能源调控模型训练。

[0146]

终端层包含中继层和设备层。在中继层,中继连接终底层设备和网关,负责边端之间时间同步及模型转发。在设备层,设备收集光伏板、充电桩等电气设备的状态信息并执行本地模型训练,并基于所提时间同步误差感知的边端协同分布式能源调控方法生成的路由选择和设备调度策略进本地模型上传。

[0147]

2.具体方法

[0148]

本发明设计了一种时间同步误差感知的边端协同分布式能源调控方法,主要包括分布式能源调控训练模型构建、优化问题建模及转化以及基于pddqn的时间同步误差敏感边端协同分布式能源调控算法设计三阶段,具体介绍如下:

[0149]

(1)分布式能源调控训练模型构建

[0150]

本发明考虑智慧园区中时间同步误差敏感的边端协同分布式能源调控场景。边层网关m0接收卫星及地面基站的时间同步信号并通过plc实现对端层设备的时间同步。j个中继连接设备和网关,其集合表示为i个设备收集光伏等电气设备的状态信息并执行本地模型训练,其集合表示为在分布式能源调控模型训练和策略优化过程中,共考虑t次迭代,集合表示为假设plc信道状态在一次迭代中保持不变。每次迭代由如下五个步骤组成。

[0151]

①

路由选择及时间同步:网关为每个设备选择中继来实现基于高精度时间同步协议(precision time protocol,ptp)的时间同步。

[0152]

②

设备调度及全局模型下发:网关基于时间同步误差进行设备调度,并将全局模型通过所选择的中继下发到被调度的设备。

[0153]

③

本地模型训练:被调度的设备基于全局模型及采集到的状态信息执行本地模型训练。

[0154]

④

本地模型上传:被调度的设备将训练好的本地模型通过所选择的中继上传到网关。

[0155]

⑤

全局模型聚合:网关基于上传的本地模型执行全局模型聚合。

[0156]

在每次迭代中,网关m0通过协调路由选择及设备调度来优化分布式能源调控模型的训练精度及训练时延。

[0157]

考虑路由选择及时间同步模型、基于时间同步误差的设备调度及本地模型训练模型、分布式能源调控全局聚合模型和模型训练时延模型,具体如下所述。

[0158]

1)路由选择及时间同步模型

[0159]

路由选择指示变量用二进制变量x

j,i

∈{0,1}表示,其中,x

j,i

(t)=1表示第t次迭

代中选择中继sj来实现从m0到mi的时间同步报文和全局模型下发,同时实现从mi到m0的本地模型上传,否则x

j,i

(t)=0。基于ptp的时间同步过程及长期时间同步误差约束如下。

[0160]

①

基于ptp的网关与中继之间的时间同步过程

[0161]

在第t次迭代中,网关m0通过ptp协议实现与中继sj之间的时间同步,获得两者之间delay_req与sync时间同步报文传输的时间戳则网关m0与中继sj之间的时间同步误差表示为

[0162][0163]

其中,|ud(t)|为delay_req报文的大小,|us(t)|为sync报文的大小,和分别为网关m0与中继sj之间的上行及下行传输速率。

[0164]

②

基于ptp的中继与设备之间的时间同步过程

[0165]

同理,基于ptp的中继与设备之间的时间同步过程中获得时间戳分别为和则第t次迭代中继sj与设备mi之间的时间同步误差表示为

[0166][0167]

其中,和分别为中继sj与设备mi之间的上行及下行传输速率。

[0168]

综上,网关m0和设备mi之间的时间同步误差表示为

[0169][0170]

③

长期时间同步误差约束

[0171]

考虑到分布式能源调控对时间同步精度的严格要求,构建长期时间同步误差约束为

[0172][0173]

其中,e

i,max

表示m0与mi之间的长期同步误差的最大阈值。

[0174]

2)基于时间同步误差的设备调度及本地模型训练模型

[0175]

具有较大时间同步误差的设备不应参与模型训练,因此设置短期时间同步误差约束e

max

用于对设备的可调度性进行区分。当设备时间同步误差小于e

max

时,该设备可被调度参与分布式能源调控模型训练。第t次迭代中,可调度设备的集合表示为即,设备调度指示变量用二进制变量ai(t)∈{0,1}表示,其中,ai(t)=1表示第t次迭代中设备mi参与模型训练,否则ai(t)=0。

[0176]

网关m0通过所选择的中继下发全局模型ω(t-1)给被调度设备,如mi。然后,设备mi更新本地模型ωi(t)=ω(t-1)并基于状态信息数据样本集合执行本地模型训练,其中为设备mi的第k个数据样本,βi(t)为设备mi的在第t次迭代中数据样

本的数量。为衡量本地模型训练的精度,定义设备mi在第t次迭代的本地损失函数为

[0177][0178]

其中,表示训练样本的损失函数,考虑到时间同步误差的影响,随着ei(t)的增大而增大。fi(ωi(t),t,ei(t))用于本地模型更新。基于梯度下降法,设备mi的本地模型更新为

[0179][0180]

其中,σ为学习步长。

[0181]

设备mi的本地模型训练时延表示为

[0182][0183]

其中,ψ为训练一个数据样本所需的cpu周期数,fi(t)为mi可用计算资源。

[0184]

3)分布式能源调控全局聚合模型

[0185]

本地模型训练结束后,设备mi通过对应的中继sj上传本地模型到网关m0,并在网关处执行全局模型聚合

[0186][0187]

评估全局模型训练精度的全局模型损失函数表示为

[0188][0189]

其中,e(t)={ei(t)|ai(t)=1}。

[0190]

4)模型训练时延

[0191]

①

上下行传输速率

[0192]

本发明基于正交频分复用技术(orthogonal frequency division multiplexing,ofdm)实现网关、中继和设备间时间同步报文、全局模型和本地模型传输。在第t次迭代中,网关m0与中继sj之间下行传输速率为

[0193][0194]

其中,ns为ofdm符号传输速率,为第t次迭代网关m0与中继sj之间的下行传输功率,为第t次迭代网关m0与中继sj之间的频率响应。表示网关m0与中继sj之间的信干噪比(signal to interference plus noise ratio,sinr)间隙。为第t次迭代网关m0与中继sj之间的电磁干扰功率,δ0为高斯白噪声功率。

[0195]

同理,可将网关m0与中继sj之间上行传输速率、中继sj与设备mi之间的下行传输速

率、中继sj与设备mi之间的上行传输速率分别表示为和

[0196]

②

模型传输时延

[0197]

在第t次迭代中,从网关m0到设备mi的全局模型下发时延包括从m0到sj的下行传输时延和从sj到mi的下行传输时延,表示为

[0198][0199]

其中,|ω(t-1)|表示全局模型的大小。

[0200]

在第t次迭代中,从设备mi到网关m0的本地模型上传时延包括从mi到sj的上行传输时延和从sj到m0的上行传输时延,表示为

[0201][0202]

其中,|ωi(t)|表示本地模型的大小。

[0203]

③

分布式能源调控模型训练总时延

[0204]

在第t次迭代中,设备mi的训练总时延包括全局模型下发时延、本地模型训练时延和本地模型上传时延,表示为

[0205][0206]

全局模型聚合在被调度设备完成本地模型上传之后执行,因此,在第t次迭代中,分布式能源调控模型训练总时延表示为

[0207][0208]

其中,τg为全局模型聚合时延。

[0209]

(2)优化问题建模与转换

[0210]

1)问题建模

[0211]

本发明的优化目标是在长期时间同步误差约束下,通过边端协同的路由选择和设备调度策略优化,最小化分布式能源调控模型训练全局损失函数和平均模型训练总时延的加权和。定义路由选择和设备调度的优化变量分别为和该优化问题可建模为

[0212][0213]

其中,v是权重参数,用于动态权衡全局损失函数与平均模型训练总时延。c1,c2和c3为路由选择约束,表示每次迭代中网关最多只能为每个设备选择一个中继。c4和c5为设备调度约束,表示第t次迭代中仅集合内设备是可调度的。c6为长期时间同步误差约束。

[0214]

2)问题转换

[0215]

由于分布式能源调控模型训练优化策略与f(ω(t),t,e(t))及长期时间同步误差约束c6耦合,p1无法直接求解。因此,采用伸缩和定理解耦

[0216][0217]

其中,f(ω(t-1),t-1,e(t-1))在第t次迭代时为已知参量。

[0218]

采用虚拟队列来解耦长期时间同步误差约束,即构建时间同步误差赤字虚拟队列为

[0219]gi

(t 1)=max{gi(t) ei(t)-e

i,max

,0} (17)

[0220]

当gi(t)平均速率稳定时,约束c6自动满足。

[0221]

定义lyapunov漂移加惩罚为

[0222][0223]

其中,vd是权衡队列波动和π(t)最小化的权重。

[0224]

因此,p1被转换为最大化δ

vd

k(g(t))的负上界,即

[0225][0226]

(3)基于pddqn的时间同步误差敏感边端协同分布式能源调控算法设计

[0227]

考虑到设备调度需要全部设备的时间同步误差信息,依赖路由选择策略,因此,路由选择和设备调度优化无法同时进行。本发明提出基于pddqn的时间同步误差敏感边端协

同分布式能源调控算法target解决上述优化问题,其中,采用pddqn进行路由选择优化以解决不同设备中继选择的对抗性竞争问题,并采用dqn进行设备调度优化。

[0228]

本发明将优化问题建模为马尔可夫过程(markov decision process,mdp),状态空间、动作空间与奖励函数定义如下:

[0229]

1)状态空间:

[0230]

基于pddqn的路由选择优化的状态空间包括数据样本数量、时间同步误差最大阈值、delay_req报文大小、sync报文大小和电磁干扰功率,即

[0231]

基于dqn的设备调度优化的状态空间为其中,e'(t),g(t),β(t)分别为时间同步误差、同步误差赤字和可调度设备数据样本数量的集合,即,

[0232]

2)动作空间:

[0233]

定义路由选择优化的动作空间为其中,

[0234]

定义设备调度优化问题的动作空间为aa(t)=a(t)。

[0235]

3)奖励函数:

[0236]

路由选择和设备调度优化的奖励函数定义为p2的优化目标re(t)。

[0237]

如图2所示,所提基于pddqn的时间同步误差敏感边端协同分布式能源调控算法的主体为网关m0。m0分别为每个设备维护pddqn的一个评估网络和一个目标网络及经验回放池进行路由选择优化。此外,m0维护dqn的一个评估网络ν

main

和一个目标网络ν

target

及经验回放池进行设备调度优化。

[0238]

对于路由选择优化,所采用的pddqn的q值由两部分组成,分别是仅与状态有关的价值函数和与状态和动作有关的优势函数其中,和分别为价值函数和优势函数的特定网络参数。因此,pddqn的q值表示为

[0239][0240]

pddqn的q值设置能有效解决不同动作对应相同q值的对抗性问题,有利于网关优化中继选择策略以加快学习收敛速度。pddqn的目标网络和经验回放池作用与传统的dqn相同。

[0241]

对于设备调度优化问题,采用dqn评估网络实现“状态-动作”到q值的映射,并利用目标网络协助训练评估网络以提高学习过程的收敛性和稳定性。此外,通过经验回放池机制克服经验数据的相关性和非平稳分布问题,提高dqn的学习效率。

[0242]

本发明设计的基于pddqn的时间同步误差敏感边端协同分布式能源调控算法具体步骤如下:

[0243]

①

初始化阶段:初始化时间同步误差赤字gi(t)、路由选择和设备调度变量x(t),a(t)为0。

[0244]

②

对抗性路由选择和时间同步阶段:每次迭代开始时,m0为每个设备选择具有最

大的动作。具体而言,当存在对抗性竞争即m0为不同设备选择同一中继时,将中继分配给q值较大的设备,如果两个设备q值相同,将中继随机分配给其中一个设备,对于未成功分配中继的设备,网关将基于该设备剩余q值中的最大值进行中继分配直至所有中继都被分配,或全部设备都已被分配中继。随后,m0基于最终路由选择策略完成边端时间同步。

[0245]

③

设备调度决策阶段:m0根据公式(3)得到mi的时间同步误差,并得到可调度设备集合随后,m0基于ε-greedy算法和qa(sa(t),aa(t),ν

main

)选择时间同步误差敏感的设备调度策略

[0246]

④

模型训练阶段:基于路由选择和设备调度决策,m0下发全局模型给被调度设备。接着,mi根据公式(6)执行本地模型训练并上传训练后的本地模型到m0。随后,m0根据公式(8)执行全局模型聚合。最后,m0根据公式(17)更新时间同步误差赤字gi(t 1)并根据公式(19)计算奖励re(t)。

[0247]

⑤

对抗性pddqn学习阶段:对于设备mi,m0将当前状态转换到下一状态同时,生成一个pddqn样本存入经验回放池并覆盖之前的pddqn样本其中,z是的大小。设被分配给设备mi的中继为所提算法target定义惩罚函数为

[0248][0249]

其中,为在第t次迭代中被选择分配给不同设备的次数,反映了对抗性竞争强度。基于惩罚函数,定义第z个pddqn样本的td误差为

[0250][0251]

其中,γ

x

是pddqn的折扣因子。根据公式(21),越大表明在路由选择优化中被选择的次数越多,即对抗性竞争强度越大,而这产生的较大的td误差使pddqn沿着更倾向于避免选择的方向更新,解决了对抗性竞争问题。

[0252]

m0在pddqn经验回放池中随机抽取s个经验样本组成集合且满足s<z,则pddqn的损失函数为

[0253][0254]

基于梯度下降法,m0更新为

[0255][0256]

其中,为pddqn学习速率。pddqn目标网络每t0>1次迭代更新一次,更新为

[0257]

⑥

dqn学习阶段:m0将当前状态sa(t)转换到下一状态sa(t 1)。同时,生成一个dqn样本存入经验回放池并覆盖之前的dqn样本其中,k是的大小。定义第k个dqn样本的td误差为

[0258][0259]

其中,γa为dqn折扣因子。

[0260]

m0在dqn经验回放池中随机抽取h个经验样本组成集合且满足h<k。dqn的损失函数为

[0261][0262]

基于梯度下降法,m0更新ν

main

为

[0263][0264]

其中,为dqn学习速率。dqn目标网络每t0>1次迭代更新一次,更新为ν

target

=ν

main

。

[0265]

重复上述步骤

②

到步骤

⑥

,直至t次迭代结束。随后,利用训练后的分布式能源调控模型,根据实时负载、储能单元状态、光照强度等输入,可以生成分布式能源调控策略,以改善能源供需平衡,并促进可再生能源利用。

[0266]

本发明对上述提出的基于pddqn的时间同步误差敏感边端协同分布式能源调控算法,进行了如下仿真对比:

[0267]

对比算法1为基于快速收敛调度的资源管理策略(the fast converge scheduling-based resource management strategy,fcs-rms),该算法通过优化路由选择和设备调度来最小化全局损失函数和平均训练延迟的加权和,但忽略了路由选择中的对抗性竞争问题。对比算法2为基于设备调度的资源管理策略(device scheduling-based resource management strategy,ds-rms),该算法仅通过优化设备调度来最小化全局损失函数,而忽略了路由选择优化问题。此外,fcs-rms和ds-rms都无法保证长期时间同步误差约束。

[0268]

本发明考虑典型分布式能源调控v2g(vehicle-to-grid)场景验证基于所提算法训练的分布式能源调控模型性能,假设100辆电动汽车通过充电桩面向电网充放电,其电池容量为60kwh,充放电功率为7kw。仿真结果如下。

[0269]

图3、4、5分别展示了v2g场景中三种分布式能源调控策略应用前后的负荷曲线变化。其输入包括光伏出力、电价、负荷及可调控的电动汽车数量,应用训练好的分布式调控模型输出电动汽车充放电功率策略。与fcs-rms和ds-rms相比,应用target的负荷率,即最大负荷与平均负荷之比,分别提升了10.33%和13.77%,说明电网运行稳定性更高。

[0270]

以上所述仅是本发明的优选实施方式,并不用于限制本发明,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明技术原理的前提下,还可以做出若干改进和

变型,这些改进和变型也应视为本发明的保护范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。