1.本发明涉及视频超分辨率的传输,具体涉及基于可伸缩视频超分辨率模型的视频传输方法及系统。

背景技术:

2.在带宽条件较差或波动较大的回程或核心网络上提供高清/超高清视频服务至关重要,但具有挑战性。传统的http动态自适应流(dash)高度依赖于网络条件,在网络条件较差时提供的视频质量差;

3.为提高视频质量,现有技术采用了以下几种方法:

4.1、利用视频超分辨率(vsr)在终端附近将低分辨率视频重建为高分辨率视频,打破网络依赖,但vsr需要强大的处理能力,而大多数现有vsr模型无法在移动设备上实现线速vsr处理;

5.2、在边缘节点对低分辨率视频进行重建,节省服务器到边缘节点的带宽;vsr模型的时间复杂度与边缘节点的可用计算能力应形成动态匹配关系,但由于边缘节点被不同的应用程序共享,导致边缘节点的计算能力是时变的;同时,对低分辨率视频进行重建得到的高分辨率视频的比特率应与动态接入网络条件相匹配,否则将引入额外的处理延迟或传输延迟;

6.3、基于dash的视频传输框架,该框架在客户端上使用vsr来提高视频质量,但需要客户端具有强大的计算能力,这对于移动设备来说并不实用;

7.为打破网络带宽对视频质量的影响,现有技术提出了一种边缘辅助自适应视频流解决方案,该解决方案增强了边缘vsr从远程服务器下载的缓存低质量视频块,尽管这种方法在回程网络资源稀缺的情况下也可以提供高质量的视频,但它没有考虑边缘节点上可用计算能力的动态状态,当可用的计算能力不能满足vsr的要求时,将引入额外的超分辨率处理延迟,这将导致更多的拒绝,降低用户的qoe。

技术实现要素:

8.本发明所要解决的技术问题是提高视频质量,目的在于提供基于可伸缩视频超分辨率模型的视频传输方法及系统,解决了视频质量差的问题。

9.本发明通过下述技术方案实现:

10.第一方面提供基于可伸缩视频超分辨率模型的视频传输方法,包括以下步骤:

11.采集网络状态信息,根据所述网络状态信息和边缘节点上的可用计算资源确定可伸缩视频超分辨率模型的模型大小和重建分辨率;

12.服务器端接收到请求信号后,根据所述请求信号反馈相应的低分辨率视频块;

13.服务器端将相应的低分辨率视频块传输至边缘节点;

14.利用确定模型大小和重建分辨率后的所述可伸缩视频超分辨率模型在边缘节点上对低分辨率视频块进行重建,得到高分辨率视频块;

15.将所述高分辨率视频块传输至播放缓冲区后,播放所述高分辨率视频块。

16.由于各计算设备的性能不同、边缘节点的实时计算能力不同等情况,故而对于每个低分辨率视频块重建的决策,均先根据网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率,然后再利用确定后的可伸缩视频超分辨率模型对该低分辨率视频块进行重建,在边缘节点上将低分辨率视频块重建为高分辨率视频块,即使在网络资源匮乏的情况下也可以为用户提供高质量的视频,同时也考虑到了边缘节点的时变计算能力,将可伸缩视频超分辨率模型的模型大小设计为可伸缩的,重建后的高分辨率视频块与动态接入网络的匹配度提升,降低了处理延迟和传输延迟,提高了视频质量。

17.进一步的,根据上述网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率的具体步骤如下:

18.预先配置一组神经网络模型,根据残差卷积块的数量从该组神经网络模型中选择与之匹配的神经网络模型;

19.根据不同数量的残差卷积块的输出特征确定退出可伸缩视频超分辨率模型的输出路径。

20.不同数量的残差卷积块会获得不同的模型级别,残差卷积块的数量越多,模型级别越高,重建后的视频质量越好,但相应的重建时间越长;对每个可能重建的低分辨率预先配置一组神经网络模型,从而使得在边缘节点上能够选择与计算设备最匹配的神经网络模型;

21.为进一步适应边缘节点的时变计算能力,需要通过不同数量的残差卷积块的输出特征去动态确定退出可伸缩视频超分辨率模型的输出路径,输出路径中加入残差卷积块的数量越多,重建后的视频质量越好,即使输出路径中的残差卷积块数量很少,与直接观看低分辨率视频块相比,用户体验质量仍有很大提高。

22.进一步的,利用确定模型大小和重建分辨率后的上述可伸缩视频超分辨率模型对低分辨率视频块进行重建,具体步骤如下:

23.将上述低分辨率视频块缓存至低分辨率视频块缓冲区,按照先进先出原则依次对低分辨率视频块缓冲区中的低分辨率视频块进行重建,得到高分辨率视频块;

24.将上述高分辨率视频块缓存至高分辨率视频块缓冲区;对于下载缓冲区中的第i个低分辨率视频块,drl代理应相应地确定svsr的视频重建分辨率级别(ri,ri′

),ri,ri′

∈r;

25.设表示所有重建对;设表示超分辨率缓冲区的最大长度,设表示重建第i个低分辨率视频块的开始时间;

26.根据公式(1)计算第i个低分辨率视频块的重建开始时间;

27.对于低分辨率视频块缓冲区中的第i个低分辨率视频块,深度强化学习(deep reinforcement learning,drl)代理应相应地确定视频重建分辨率级别(ri,r

′i),ri,r

′i∈r;

28.设表示所有重建对;设表示超分辨率缓冲区的最大长度,设表示重建第i个低分辨率视频块的重建开始时间;

[0029][0030]

其中,表示第i个低分辨率视频块的重建开始时间;表示第(i-1)个低分辨率视频块的重建开始时间;φ

i-1

(r

i-1

,r'

i-1

)表示将第(i-1)个低分辨率视频块重建为高分辨率视频块的重建处理时间;表示第个高分辨率视频块缓存至播放缓冲区的缓存开始时间,d表示所有重建对,表示高分辨率视频块缓冲区的最大长度;

[0031]

根据公式(2)计算第i个低分辨率视频块的重建处理时间,

[0032][0033]

其中,φi(ri,r'i)表示第i个低分辨率视频块的重建处理时间;ui表示边缘节点上可用于重建第i个低分辨率视频块的计算能力;表示基线重建时间。

[0034]

进一步的,将上述高分辨率视频块缓存至播放缓冲区的缓存开始时间:上述第i个低分辨率视频块重建完成,且第(i-1)个高分辨率视频块传输至播放缓冲区后,第i个高分辨率视频块开始向播放缓冲区传输;

[0035]

根据公式(3)计算第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间,

[0036][0037]

其中,表示第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间;表示第(i-1)个高分辨率视频块缓存至播放缓冲区的缓存开始时间;d

i-1

表示(i-1)个高分辨率视频块的下载时间;表示第i个低分辨率视频块的重建开始时间;φi(ri,r'i)表示将第i个低分辨率视频块重建为高分辨率视频块的重建处理时间;表示第个高分辨率视频块的播放开始时间,表示播放缓冲区的最大长度。

[0038]

进一步的,上述高分辨率视频块的播放时间:上述第(i-1)个高分辨率视频块播放完成,且第i个高分辨率视频块已缓存至播放缓冲区;

[0039]

根据公式(4)计算第i个高分辨率视频块的播放开始时间,

[0040][0041]

其中,ti表示第i个高分辨率视频块的播放开始时间;t

i-1

表示第(i-1)个高分辨率视频块的播放开始时间;t表示高分辨率视频块或低分辨率视频块的时间长度;表示第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间;di表示第i个高分辨率视频块的下载时间。

[0042]

进一步的,播放上述高分辨率视频块时,若上述高分辨率视频块在播放缓冲区耗

尽,则需重新缓存上述高分辨率视频块;

[0043]

若需要重新缓存上述高分辨率视频块,则根据公式(5)计算重新缓存上述高分辨率视频块的时间,

[0044]

τi=t

i-(t

i-1

t)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

公式(5)

[0045]

其中,τi表示重新缓存第i个高分辨率视频块的时间;ti表示第i个高分辨率视频块的播放开始时间;t

i-1

表示第i-1个高分辨率视频块的播放开始时间;t表示高分辨率视频块或低分辨率视频块的时间长度。

[0046]

第二方面提供可伸缩视频超分辨率模型的视频传输系统,该视频传输系统用于实现上述的基于可伸缩视频超分辨率模型的视频传输方法,该视频传输系统包括:

[0047]

客户端,用于发送请求信号和接收高分辨率视频块;

[0048]

服务器,用于接收请求信号和发送低分辨率视频块;

[0049]

边缘节点,

[0050]

上述边缘节点与客户端通信连接,用于接收上述客户端发送的请求信号,并将上述请求信号发送至服务器;

[0051]

上述边缘节点与服务器通信连接,用于接收上述服务器发送的低分辨率视频块,对上述低分辨率视频块进行重建,得到高分辨率视频块,将上述高分辨率视频块发送至客户端。

[0052]

上述边缘节点能够收集网络状态信息、具有支撑可伸缩视频超分辨率处理的能力,并且能够自适应调节可伸缩视频超分辨率模型的模型大小和重建分辨率,融合了边缘计算和视频超分辨率,提高了视频质量。

[0053]

进一步的,上述服务器用于存储低分辨率视频,将上述低分辨率视频划分为n个具有相同时间长度t的低分辨率视频块,得到由n个低分辨率视频块组成的低分辨率视频块组。

[0054]

进一步的,上述边缘节点包括监视器、drl代理和可伸缩视频超分辨率(scalable video super resolution,svsr)处理器;

[0055]

所述监视器与客户端和drl代理和服务器通信连接,所述监视器用于监视服务器、边缘节点和客户端的网络状态;

[0056]

所述drl代理用于接收网络状态信息,根据所述网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率;

[0057]

所述svsr处理器与drl代理通信连接,所述svsr处理器用于利用确定模型大小和重建分辨率后的所述可伸缩视频超分辨率模型对低分辨率视频块进行重建,得到高分辨率视频块。。

[0058]

进一步的,上述svsr处理器包括低分辨率视频块缓冲区、高分辨率视频块缓冲区和处理区;

[0059]

上述低分辨率视频块缓冲区用于缓存上述服务器发送至svsr处理器的低分辨率视频块;

[0060]

在上述处理区按照先进先出原则依次对上述低分辨率视频块缓冲区的低分辨率视频块进行重建,得到高分辨率视频块;

[0061]

将上述高分辨率视频块缓存至上述高分辨率视频块缓冲区。

[0062]

本发明与现有技术相比,具有如下的优点和有益效果:

[0063]

由于各计算设备的性能不同、边缘节点的实时计算能力不同等情况,故而对于每个低分辨率视频块重建的决策,均先根据网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率,然后再利用确定后的可伸缩视频超分辨率模型对该低分辨率视频块进行重建,在边缘节点上将低分辨率视频块重建为高分辨率视频块,即使在网络资源匮乏的情况下也可以为用户提供高质量的视频,同时也考虑到了边缘节点的时变计算能力,将可伸缩视频超分辨率模型的模型大小设计为可伸缩的,重建后的高分辨率视频块与动态接入网络的匹配度提升,降低了处理延迟和传输延迟,提高了视频质量。本方案还建立融合边缘计算和视频超分辨率的超高清视频传输的联合优化,系统的性能主要体现在边缘节点的超分辨率过程和重建视频从边缘节点到客户端的传输过程,为了保证流畅的视频流服务,超分辨率缓冲区和播放缓冲区应满足一系列条件,以避免视频中断。在视频流服务的流畅度得到保证的前提下,建立能够提升视频传输质量、减少重缓冲时间和减少质量抖动的优化模型,决策变量为重建视频分辨率级别和svsr模型的配置。采用强化学习方法对联合优化问题进行求解。对支撑强化学习的智能边缘节点进行训练,直到算法收敛为止。利用训练好的强化学习算法,对重建视频分辨率级别和svsr模型的配置进行决策,提高用户的qoe,同时节省网络带宽。

附图说明

[0064]

为了更清楚地说明本发明示例性实施方式的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,应当理解,以下附图仅示出了本发明的某些实施例,因此不应被看作是对范围的限定,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他相关的附图。在附图中:

[0065]

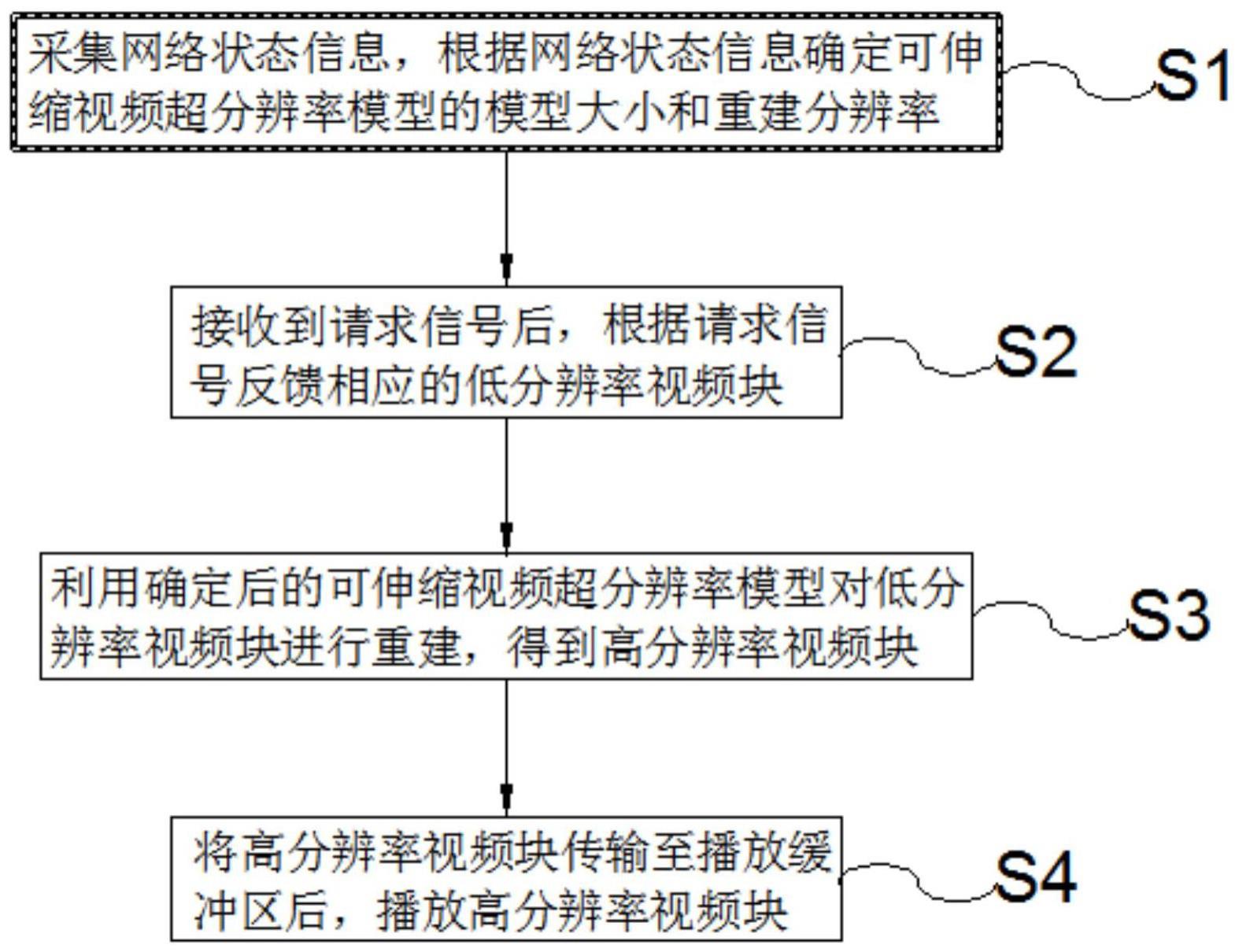

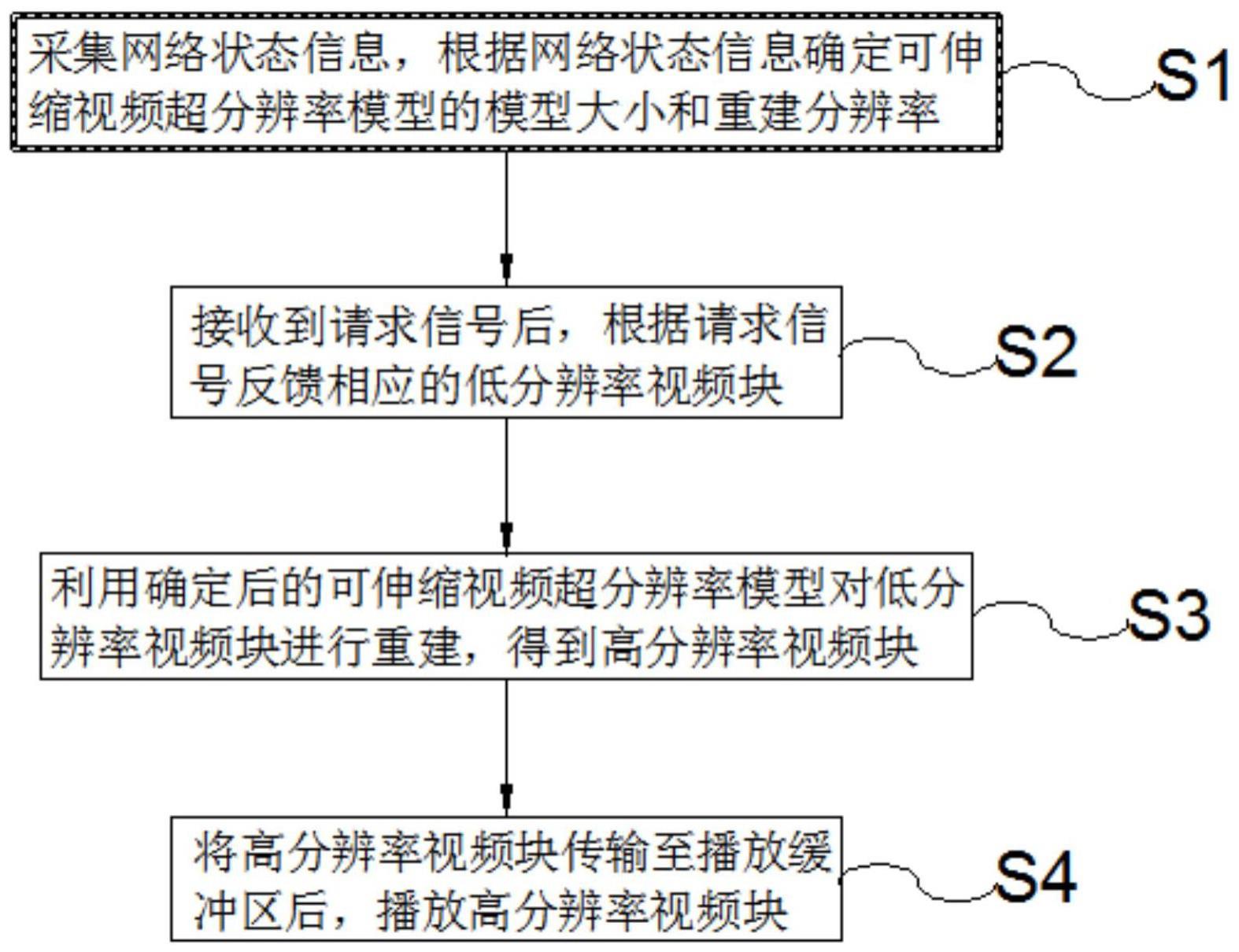

图1为实施例1提供的流程图;

[0066]

图2为实施例1提供的可伸缩视频超分辨率模型结构;

[0067]

图3为实施例2提供的系统框图。

[0068]

附图中标记及对应的零部件名称:

[0069]

100-客户端,110-播放缓冲区,200-边缘节点,210-监视器,220-drl代理,230-svsr处理器,231-低分辨率视频块缓冲区,232-处理区,233-高分辨率视频块缓冲区,300-服务器。

具体实施方式

[0070]

为使本发明的目的、技术方案和优点更加清楚明白,下面结合实施例和附图,对本发明作进一步的详细说明,本发明的示意性实施方式及其说明仅用于解释本发明,并不作为对本发明的限定。

[0071]

实施例1

[0072]

如图1所示,本实施例1提供基于可伸缩视频超分辨率模型的视频传输方法,包括以下步骤:

[0073]

s1、采集网络状态信息,根据上述网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率;

[0074]

s2、接收到请求信号后,根据上述请求信号反馈相应的低分辨率视频块;

[0075]

s3、利用确定模型大小和重建分辨率后的上述可伸缩视频超分辨率模型对低分辨率视频块进行重建,得到高分辨率视频块;

[0076]

s4、将上述高分辨率视频块传输至播放缓冲区后,播放上述高分辨率视频块。

[0077]

由于各计算设备的性能不同、边缘节点的实时计算能力不同等情况,故而对于每个低分辨率视频块重建的决策,均先根据网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率,然后再利用确定后的可伸缩视频超分辨率模型对该低分辨率视频块进行重建,在边缘节点上将低分辨率视频块重建为高分辨率视频块,即使在网络资源匮乏的情况下也可以为用户提供高质量的视频,同时也考虑到了边缘节点的时变计算能力,将可伸缩视频超分辨率模型的模型大小设计为可伸缩的,重建后的高分辨率视频块与动态接入网络的匹配度提升,降低了处理延迟和传输延迟,提高了视频质量。

[0078]

具体的实施例,如图2所示,根据上述网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率的具体步骤如下:

[0079]

预先配置一组神经网络模型,根据残差卷积块的数量从该组神经网络模型中选择与之匹配的神经网络模型;

[0080]

根据不同数量的残差卷积块的输出特征确定退出可伸缩视频超分辨率模型的输出路径。

[0081]

不同数量的残差卷积块会获得不同的模型级别,残差卷积块的数量越多,模型级别越高,重建后的视频质量越好,但相应的重建时间越长;对每个可能重建的低分辨率预先配置一组神经网络模型,从而使得在边缘节点上能够选择与计算设备最匹配的神经网络模型;

[0082]

为进一步适应边缘节点的时变计算能力,需要将各个视频超分辨率神经网络模型生成多条输出路径,即可以在可伸缩超分辨率模型中添加从中间块到最终层的直接连接,也就是早退机制的建立。输出路径中加入的残差卷积块数量越多,svsr重建后的视频质量越好,但相应的重建时间越长。即使输出路径中的残差卷积块数量很少,与直接观看低分辨率视频相比,用户体验质量仍有很大提高。

[0083]

具体的实施例,sr处理开始时间。在智能边缘节点,从服务器端下载的低分辨率视频块首先缓存到下载缓冲区中,然后svsr处理器根据先进先出(fifo)原则对下载缓冲区中的低分辨率视频块进行重建,将高分辨率视频块输出到超分辨率缓冲区中。对于下载缓冲区中的第i个低分辨率视频块,drl代理应相应地确定svsr的视频重建分辨率级别(ri,ri′

),ri,ri′

∈r。

[0084]

设表示所有重建对。设表示超分辨率缓冲区的最大长度,设表示重建第i个低分辨率视频块的开始时间。

[0085]

重建第i个低分辨率视频块的开始时间可以定义为:

[0086][0087]

其中,表示第i个低分辨率视频块的重建开始时间;表示第i-1个低分辨率

视频块的重建开始时间;φ

i-1

(r

i-1

,r'

i-1

)表示将第i-1个低分辨率视频块重建为高分辨率视频块的重建处理时间;表示第个高分辨率视频块缓存至播放缓冲区的缓存开始时间,d表示所有重建对,表示高分辨率视频块缓冲区的最大长度;

[0088]

根据公式(6)计算边缘节点上可用于重建第δ个低分辨率视频块的计算能力,

[0089][0090]

其中,u

δ

表示边缘节点上可用于重建第δ个低分辨率视频块的计算能力;φ

δ

(r

δ

,r'

δ

)表示第δ个低分辨率视频块的重建处理时间;表示基线重建时间,用于估计时间长度为t的低分辨率视频块重建为高分辨率视频块所需的时间;

[0091]

通过计算u

i-1

,u

i-2

,

…

,u

i-k

来估计可用于重建第i个低分辨率视频块的计算能力ui。

[0092]

根据公式(2)计算第i个低分辨率视频块的重建处理时间,

[0093][0094]

其中,φi(ri,r'i)表示第i个低分辨率视频块的重建处理时间;ui表示边缘节点200上可用于重建第i个低分辨率视频块的计算能力;表示基线重建时间。

[0095]

具体的实施例,将上述高分辨率视频块缓存至播放缓冲区的缓存开始时间:上述第i个低分辨率视频块重建完成,且第i-1个高分辨率视频块传输至播放缓冲区后,第i个高分辨率视频块开始向播放缓冲区传输;

[0096]

根据公式(3)计算第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间,

[0097][0098]

其中,表示第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间;表示第i-1个高分辨率视频块缓存至播放缓冲区的缓存开始时间;d

i-1

表示(i-1)个高分辨率视频块的下载时间;表示第i个低分辨率视频块的重建开始时间;φi(ri,r'i)表示将第i个低分辨率视频块重建为高分辨率视频块的重建处理时间;表示第个高分辨率视频块的播放开始时间,表示播放缓冲区的最大长度。

[0099]

具体的实施例,上述高分辨率视频块的播放时间:上述第i-1个高分辨率视频块播放完成,且第i个高分辨率视频块已缓存至播放缓冲区;

[0100]

根据公式(4)计算第i个高分辨率视频块的播放开始时间,

[0101]

[0102]

其中,ti表示第i个高分辨率视频块的播放开始时间;t

i-1

表示第i-1个高分辨率视频块的播放开始时间;t表示高分辨率视频块或低分辨率视频块的时间长度;表示第i个高分辨率视频块缓存至播放缓冲区的缓存开始时间;di表示第i个高分辨率视频块的下载时间。

[0103]

具体的实施例,播放上述高分辨率视频块时,若上述高分辨率视频块在播放缓冲区110耗尽,则需重新缓存上述高分辨率视频块;

[0104]

若需要重新缓存上述高分辨率视频块,则根据公式(5)计算重新缓存上述高分辨率视频块的时间,

[0105]

τi=t

i-(t

i-1

t)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

公式(5)

[0106]

其中,τi表示重新缓存第i个高分辨率视频块的时间;ti表示第i个高分辨率视频块的播放开始时间;t

i-1

表示第i-1个高分辨率视频块的播放开始时间;t表示高分辨率视频块或低分辨率视频块的时间长度。

[0107]

具体的实施例,低分辨率视频块缓冲区和高分辨率视频块缓冲区,以及播放缓冲区在t时刻的状态如公式(7)和公式(8)所示:

[0108][0109][0110]

其中,bs(t)表示低分辨率视频块缓冲区和高分辨率视频块缓冲区在t时刻的状态;b

p

(t)表示播放缓冲区在t时刻的状态;表示第k个低分辨率视频块的重建开始时间;φk(rk,r'k)表示将第k个低分辨率视频块重建为高分辨率视频块的重建处理时间;表示第k个高分辨率视频块缓存至播放缓冲区的缓存开始时间。

[0111]

具体的实施例,高分辨率视频块缓冲区和播放缓冲区满足条件后,视频流服务的流畅度得到了保证,从而避免了视频中断。在视频流服务的流畅度得到保证的前提下,为适应动态网络条件和边缘节点的时变计算能力,drl代理需要对重建视频分辨率级别和svsr模型的配置(包括模型级别和输出路径)同时进行决策,因此优化目标是最大化视频观看者的用户体验质量(qoe),由于qoe分别受视频质量、重缓冲时间和视频块之间的质量抖动三个方面影响,那么可以采用这三个可以量化的指标来定义qoe,具体步骤如下:

[0112]

(1)设定目标函数;建立能够提升用户视频质量、减少重缓冲时间(当播放缓冲区中没有未播放的视频块时将发生重缓冲过程从而产生重缓冲时间)和减少质量抖动(视频质量抖动是qoe的一个关键指标,因为它可能会导致视频观看者头晕和头痛等生理症状)的优化模型,决策变量为视频重建分辨率级别和svsr模型配置。具体地,目标函数包括以下三个部分:

[0113]

q1:视频质量可以定义为:

[0114][0115]

其中,bi′

表示重建后第i个高分辨率视频块的比特率,动态自适应流(dash)系统会将分辨率对应成相应的比特率,f(bi′

)表示将比特率bi映射为用户能感知到的质量,nc表示整个系统运行期间客户端接收到的视频块总数;

[0116]

q2:重缓冲时间可以定义为:

[0117][0118]

其中,τi表示重新缓存第i个高分辨率视频块的时间;nr表示整个系统运行时的重缓冲总次数;

[0119]

q3:两个相邻视频块之间的质量抖动可以定义为:

[0120][0121]

其中,b

′i表示重建后第i个高分辨率视频块的比特率;b

′

i-1

表示重建后第i-1个高分辨率视频块的比特率;nc表示整个系统运行期间客户端接收到的视频块总数。

[0122]

当视频存在重缓冲和抖动时,将获得一个惩罚值,时延越长,惩罚值越大。对于单个用户的体验质量(qoe)可以表示为:

[0123]

qoe=q

1-μq

2-λq3ꢀꢀ

(公式12)

[0124]

其中,μ和λ为权重因子。

[0125]

为了进一步防止终端产生播放中断,可以为播放缓冲区的缓冲长度加下溢概率约束,即

[0126][0127]

其中,表示开始重建第i个视频块时播放缓冲区的缓冲长度,b

bound

为播放缓冲区缓冲长度的最低阈值,当播放缓存区的缓冲长度低于b

bound

时,有视频中断的可能,ε2为约束的违反概率。

[0128]

综上,其优化问题可以表示为:

[0129]

max e{qoe}=e{q

1-μq

2-λq3}

[0130]

s.t.p(μ

δ

<μ

′

δ

)≤ε1[0131][0132]

其中,q1为视频质量;q2为重缓冲时间;q3为相邻视频块分辨率切换造成的质量抖动;μ和λ为权重因子;μ

′

δ

为边缘节点需要用于重建视频块的计算能力;ε1为约束的概率约束阈值;qoe为单个用户的体验质量;b

bound

为播放缓存队列播放视频时长的最低阈值;ε2为约束的违反概率。

[0133]

(2)采用强化学习方法求解优化问题,对支撑强化学习的智能边缘节点进行训练,指导算法收敛为止,利用训练好的强化学习算法,对重建视频分辨率级别和svsr模型的配

置进行决策,具体步骤如下:

[0134]

①

高分辨率视频块播放过程是一个马尔可夫决策问题,而强化学习不要求预先给定任何数据,而是通过接收环境对动作的奖励(反馈)获得学习信息并更新模型参数。因此可以利用强化学习对优化问题进行求解。

[0135]

②

状态空间。svsr在开始重建第i个视频块时的状态可表示为

[0136][0137]

其中,和分别表示开始重建第i个视频块时播放缓冲区和高分辨率视频块缓冲区的长度;决策的主要限制是带宽,是过去k1个视频块的平均下载带宽;是过去k2个视频块从被请求到被下载的总等待时间;是过去k3个视频块的隐式可用计算能力;r

′

i-1

是第i-1个视频块的分辨率;n-i是视频块的剩余块数。

[0138]

③

行动空间。对于每个视频块,drl代理必须根据当前状态选择重建目标视频分辨率,并根据当前可用的计算资源选择最合适的svsr模型。vsr模型的大小和提升的目标视频分辨率都会影响边缘节点上计算资源的消耗。因此svsr中的drl代理需要决策包括1)视频重建分辨率级别(ri,r

′i),2)svsr模型的配置(包括模型级别mi和输出路径li)。svsr在开始重建第i个视频块时的行动向量可表示为

[0139]

④

奖励函数。drl代理根据采集的实时系统状态进行自适应决策,系统执行某个行动后,会反馈给drl代理一个即时奖励。为了使用户能够获得更好的视频服务体验,实现用户qoe最大化的目标。将奖励函数定义为

[0140]ri

=b

′

i-μτ

i-λ|b

′

i-b

′

i-1

|

[0141]

其中,b

′i示重建后第i个视频块的分辨率;τi表示处理第i个视频块时发生的重缓冲时间;|b

′

i-b

′

i-1

|表示第i个视频块和第i-1个视频块之间质量抖动;μ和λ为权重因子。

[0142]

⑤

深度神经网络模型和模型训练。

[0143]

深度强化学习贝尔曼(bellman)方程相应地可以写为

[0144][0145]

对具有大量状态和动作的马尔可夫决策过程(mdp),可以利用深度神经网络q(si,ai;θ)来近似q(si,ai),θ为参数。

[0146]

对于深度神经网络q(si,ai;θ)的训练遵循dqn(deep q-network)算法。

[0147]

dqn中包含两个神经网络。一个评估网络(eval_net),一个目标网络(target_net)。评估网络用来评价当前状态下各个动作ai的q值,通过使用该网络选择动作ai,选择q值最大的动作ai后,环境反馈回reward和下一个状态s

i 1

,即(si,ai,ri,s

i 1

),然后存储其中。向目标网络输入s

i 1

,即下一个环境状态,从而通过网络得到各个动作下ai的q值,然后利用状态si下动作ai得到的奖励ri,和贝尔曼方程计算目标,得到q(si,ai)。

[0148]

dqn算法是将神经网络和q-learing结合,利用神经网络近似模拟函数q(si,ai),输入是状态si,输出是每个动作ai对应的q值,然后依据q值大小选择对应状态执行的动作,以完成控制。

[0149]

状态si输入,获得所有动作对应的q值q(si,ai);选择对应q值最大的动作a

′i并执行;执行后环境发生变化,并能够获得环境的奖励ri;利用奖励ri更新q(si,a

′i),利用新的q(si,a

′i)更新网络参数。

[0150]

⑥

模型训练好后可以采集实时的状态信息作为输入,输出最优控制策略,包括1)视频重建分辨率级别(ri,r

′i),2)svsr模型的配置(包括模型级别mi和输出路径li)。

[0151]

实施例2

[0152]

如图3所示,本实施例2提供可伸缩视频超分辨率模型的视频传输系统,该视频传输系统用于实现上述的基于可伸缩视频超分辨率模型的视频传输方法,该视频传输系统包括:

[0153]

客户端100,用于发送请求信号,并在第一次连接到边缘节点200时,将设备类型和最高显示分辨率随请求信号发送至边缘节点200,客户端100需要定期向边缘节点200报告播放状态;还用于接收和播放高分辨率视频块;

[0154]

服务器300,用于接收请求信号;还用于发送低分辨率视频块;

[0155]

边缘节点200,

[0156]

上述边缘节点200与客户端100通信连接,用于接收上述客户端100发送的请求信号,并将上述请求信号发送至服务器300;

[0157]

上述边缘节点200与服务器300通信连接,用于接收上述服务器300发送的低分辨率视频块,对上述低分辨率视频块进行重建,得到高分辨率视频块,将上述高分辨率视频块发送至客户端100。

[0158]

上述边缘节点200能够收集网络状态信息、具有支撑可伸缩视频超分辨率处理的能力,并且能够自适应调节可伸缩视频超分辨率模型的模型大小和重建分辨率,融合了边缘计算和视频超分辨率,提高了视频质量。

[0159]

具体的实施例,客户端100向边缘节点200发送请求信号,边缘节点200向服务器300发送客户端100的请求信号,服务器300在接收到请求信号后向边缘节点200提供该请求信号的最低分辨率视频块,然后边缘节点200接收该最低分辨率视频块,通过drl处理确定可伸缩视频超分辨率模型的模型大小和重建分辨率,svsr处理器230利用确定后的可伸缩视频超分辨率模型对该最低分辨率视频块完成重建,得到高分辨率视频块,将该高分辨率视频块缓存至高分辨率视频块缓冲区233,最后将该高分辨率视频块发送至客户端100,从而完成视频播放。

[0160]

具体的实施例,上述服务器300用于存储低分辨率视频,按照dash标准,将上述低分辨率视频划分为n个具有相同时间长度t的低分辨率视频块,将n个低分辨率视频块编码成一组分辨率,得到由n个低分辨率视频块组成的低分辨率视频块组。

[0161]

具体的实施例,上述边缘节点200包括监视器210、drl代理220和svsr处理器230;

[0162]

所述监视器210与客户端100和drl代理220通信连接,所述监视器210用于监视服务器300、边缘节点200和客户端100的网络状态;

[0163]

所述drl代理220与服务器300通信连接,所述drl代理220用于接收网络状态信息,根据所述网络状态信息确定可伸缩视频超分辨率模型的模型大小和重建分辨率;

[0164]

上述svsr处理器230与drl代理220、服务器300和客户端100通信连接,上述svsr处理器230能够支撑基于深度学习的svsr算法,用于利用确定模型大小和重建分辨率后的上

述可伸缩视频超分辨率模型对低分辨率视频块进行重建,得到高分辨率视频块。

[0165]

具体的实施例,上述svsr处理器230包括低分辨率视频块缓冲区231、高分辨率视频块缓冲区233和处理区232;

[0166]

上述低分辨率视频块缓冲区231用于缓存上述服务器300发送至svsr处理器230的低分辨率视频块;

[0167]

在上述处理区232按照先进先出原则依次对上述低分辨率视频块缓冲区231的低分辨率视频块进行重建,得到高分辨率视频块;

[0168]

将上述高分辨率视频块缓存至上述高分辨率视频块缓冲区233。

[0169]

以上所述的具体实施方式,对本发明的目的、技术方案和有益效果进行了进一步详细说明,所应理解的是,以上所述仅为本发明的具体实施方式而已,并不用于限定本发明的保护范围,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。