1.本发明总体上涉及图形处理器的领域。更具体地,本发明涉及用于改进包括光线追踪和光栅化实现的图形处理的性能的装置和方法。

背景技术:

2.光线追踪是其中通过基于物理的渲染对光传输进行仿真的技术。在电影渲染中广泛使用,它被认为对于实时性能而言太过资源密集型,直到仅几年前。光线追踪中的关键操作之一是:处理被称为“光线遍历”的针对光线场景交叉的可见性查询,该可见性查询通过在包围体层级(bvh)中对节点进行遍历且使节点相交来计算光线-场景交叉。

3.光栅化是其中根据从三角形网状物创建的对象的3d模型创建屏幕对象的技术。每个三角形的顶点与不同形状和大小的其他三角形的顶点相交。每个顶点具有空间中的位置以及与颜色、纹理及其法线有关的信息,该信息用于确定对象的表面所面向的方向。光栅化单元将3d模型的三角形转换成2d屏幕空间中的像素,并且,可以基于顶点数据来给每个像素指派初始颜色值。

附图说明

4.可以结合以下附图从以下具体实施方式获得对本发明的更好理解,在附图中:图1是具有一个或多个处理器核的处理器和图形处理器的计算机系统的实施例的框图;图2a-d图示了本发明实施例所提供的计算系统和图形处理器;图3a-c图示了另外图形处理器和计算加速器架构的框图;图4是针对图形处理器的图形处理引擎的实施例的框图;图5a-b图示了包括处理元件阵列的线程执行逻辑;图6是包括处理元件阵列的线程执行逻辑的框图;图7图示了根据实施例的图形处理器执行单元指令格式;图8是包括图形流水线、媒体流水线、显示引擎、线程执行逻辑和渲染输出流水线的图形处理器的另一实施例的框图;图9a是图示了根据实施例的图形处理器命令格式的框图;图9b是图示了根据实施例的图形处理器命令序列的框图;图10图示了根据实施例的针对数据处理系统的示例性图形软件架构;图11a图示了根据实施例的可以用于制造集成电路以执行操作的示例性ip核开发系统;图11b-d图示了包括小芯片和中介层衬底的示例性封装布置;图12图示了根据实施例的可使用一个或多个ip核而制造的示例性片上系统集成电路;图13图示了可使用一个或多个ip核而制造的片上系统集成电路的示例性图形处

理器;图14图示了可使用一个或多个ip核而制造的片上系统集成电路的另外示例性图形处理器;图15图示了用于执行机器学习架构的初始训练的架构;图16图示了如何在运行时期间持续训练和更新机器学习引擎;图17图示了如何在运行时期间持续训练和更新机器学习引擎;图18a-b图示了如何在网络上共享机器学习数据;以及图19图示了用于训练机器学习引擎的方法;图20图示了节点如何交换鬼区数据以执行分布式去噪操作;图21图示了其中图像渲染和去噪操作跨多个节点而分布的架构;图22图示了用于分布式渲染和去噪的架构的另外细节;图23图示了用于执行分布式渲染和去噪的方法;图24图示了机器学习方法;图25图示了多个互连通用图形处理器;图26图示了针对机器学习实现的卷积层和全连接层的集合;图27图示了卷积层的示例;图28图示了机器学习实现中的互连节点的集合的示例;图29图示了在其内神经网络使用训练数据集进行学习的训练框架;图30a图示了模型并行结构和数据并行结构的示例;图30b图示了片上系统(soc);图31图示了包括光线追踪核和张量核的处理架构;图32图示了光束的示例;图33图示了用于执行光束追踪的装置;图34图示了光束层级的示例;图35图示了用于执行光束追踪的方法;图36图示了分布式光线追踪引擎的示例;图37-38图示了在光线追踪系统中执行的压缩;图39图示了在光线追踪架构上实现的方法;图40图示了示例性混合光线追踪装置;图41图示了用于光线追踪操作的栈;图42图示了针对混合光线追踪装置的另外细节;图43图示了包围体层级;图44图示了调用栈和遍历状态存储器;图45图示了用于遍历和交叉的方法;图46a-b图示了如何要求多个分派周期执行某些着色器;图47图示了单个分派周期如何执行多个着色器;图48图示了单个分派周期如何执行多个着色器;图49图示了用于执行光线追踪指令的架构;图50图示了用于在线程内执行光线追踪指令的方法;

图51图示了用于异步光线追踪的架构的一个实施例;图52a图示了光线遍历电路的一个实施例;图52b图示了在一个实施例中被执行以管理光线存储库的过程;图53图示了优先级选择电路系统/逻辑的一个实施例;图54和55a-b图示了在本发明一个实施例中使用的包括标记、异常和剔除数据的不同类型的光线追踪数据;图56图示了用于确定光线追踪流水线的早出(early out)的一个实施例;图57图示了优先级选择电路系统/逻辑的一个实施例;图58图示了用于光线遍历操作的示例包围体层级(bvh);图59a-b图示了另外遍历操作;图60图示了用于管理bvh栈的栈管理电路系统的一个实施例;图61a-b图示了针对光线、命中和栈而执行的示例数据结构、子结构和操作;图62图示了具有n位比较操作掩码的细节选择器的级别的实施例;图63图示了根据本发明一个实施例的加速数据结构;图64图示了包括残差值和元数据的压缩块的一个实施例;图65图示了根据本发明一个实施例的方法;图66图示了块偏移索引压缩块的一个实施例;图67a图示了根据本发明一个实施例的分层位向量编索引(hbi);图67b图示了根据本发明一个实施例的索引压缩块;以及图68图示了包括bvh压缩电路系统/逻辑和解压缩电路系统/逻辑的示例架构;图69a图示了被应用于网状物的位移函数;图69b图示了用于压缩网状物或小网状物的压缩电路系统的一个实施例;图70a图示了基础细分表面上的位移映射;图70b-c图示了相对于粗基础网状物的差向量;图71图示了根据本发明一个实施例的方法;图72-74图示了包括多个互连顶点的网状物;图75图示了用于生成网状物的曲面细分器的一个实施例;图76-77图示了其中基于网状物形成包围体的一个实施例;图78图示了共享重叠顶点的网状物的一个实施例;图79图示了在三角形之间具有共享边的网状物;图80图示了根据一个实施例的光线追踪引擎;图81图示了根据一个实施例的bvh压缩器;图82a-c图示了针对64位寄存器的示例数据格式;图83a-b图示了针对环形缓冲区的索引的一个实施例;图84a-b图示了针对生产者和消费者的示例环形缓冲区原子;图85a图示了拼贴(tiled)资源的一个实施例;图85b图示了根据本发明一个实施例的方法;图86a图示了包括按需构建器的bvh处理逻辑的一个实施例;图86b图示了针对加速结构的按需构建器的一个实施例;

图86c图示了可见底级加速结构图的一个实施例;图86d图示了不同类型的实例和遍历决策;图87图示了基于材料的剔除掩码的一个实施例;图88图示了其中在几何网状物上形成四叉树的一个实施例;图89a图示了光线追踪架构的一个实施例;图89b图示了包括小网状物压缩的一个实施例;图90图示了包括同步线程、发散派生(spawn)线程、规则派生线程和收敛派生线程的多个线程;图91图示了具有无绑定线程分派器的光线追踪架构的一个实施例;图92图示了根据一个实施例的光线追踪集群;图93-100图示了在多节点光线追踪实现中使用代理数据的实施例;图101图示了根据本发明一个实施例的方法;图102图示了0

……

1范围内的随机样本的示例曲线图;图103图示了用于实现本发明实施例的照明引擎的一个实施例;图104图示了用于重要性采样的方法的一个实施例;图105图示了与重要性采样的一个特定实施例相关联的细节;以及图106图示了根据本发明一个实施例的方法。

具体实施方式

5.在以下描述中,出于解释的目的,阐述了许多特定细节,以便提供以下描述的本发明实施例的透彻理解。然而,对本领域技术人员来说将明显的是,可以在没有这些特定细节中的一些的情况下实践本发明实施例。在其他实例中,以框图形式示出了公知结构和设备,以避免使本发明实施例的基础原理模糊。

6.示例性图形处理器架构和数据类型系统概述图1是根据实施例的处理系统100的框图。系统100可用于单处理器台式计算机系统、多处理器工作站系统或具有大量处理器102或处理器核107的服务器系统中。在一个实施例中,系统100是并入在供移动、手持式或嵌入式设备中(诸如在带有到局域或广域网的有线或无线连接性的物联网(iot)设备内)使用的片上系统(soc)集成电路内的处理平台。

7.在一个实施例中,系统100可包括以下各项、与以下各项耦合或者被集成在以下各项内:基于服务器的游戏平台;游戏控制台,包括游戏和媒体控制台;移动游戏控制台、手持式游戏控制台或在线游戏控制台。在一些实施例中,系统100是以下各项的一部分:移动电话、智能电话、平板计算设备或诸如带有低内部存储容量的膝上型计算机之类的移动因特网连接的设备。处理系统100还可包括以下各项、与以下各项耦合或者被集成在以下各项内:可穿戴设备,诸如智能手表可穿戴设备;智能眼镜(smart eyewear)或服装,其用增强现实(ar)或虚拟现实(vr)特征而增强以提供视觉、音频或触觉输出,以补充现实世界视觉、音频或触觉体验或者以其他方式提供文本、音频、图形、视频、全息图像或视频、或者触觉反馈;其他增强现实(ar)设备;或者其他虚拟现实(vr)设备。在一些实施例中,处理系统100包括电视或机顶盒设备,或者是电视或机顶盒设备的一部分。在一个实施例中,系统100可包

括以下各项、与以下各项耦合或者被集成在以下各项内:自动驾驶交通工具,诸如公共汽车、牵引车拖车、汽车、摩托车或电动自行车、飞机或滑翔机(或其任何组合)。自动驾驶交通工具可使用系统100来处理在交通工具周围感测到的环境。

8.在一些实施例中,一个或多个处理器102均包括一个或多个处理器核107以处理指令,所述指令在被执行时,执行用于系统或用户软件的操作。在一些实施例中,一个或多个处理器核107中的至少一个处理器核被配置成处理特定指令集109。在一些实施例中,指令集109可促进复杂指令集计算(cisc)、精简指令集计算(risc)或经由超长指令字(vliw)的计算。一个或多个处理器核107可处理不同指令集109,所述指令集109可包括用于促进对其他指令集的仿真的指令。处理器核107还可包括其他处理设备,诸如数字信号处理器(dsp)。

9.在一些实施例中,处理器102包括高速缓冲存储器104。取决于架构,处理器102可具有单个内部高速缓存或多个级别的内部高速缓存。在一些实施例中,在处理器102的各种组件之间共享高速缓冲存储器。在一些实施例中,处理器102还使用外部高速缓存(例如,3级(l3)高速缓存或末级高速缓存(llc))(未示出),其可在使用已知高速缓存一致性技术的处理器核107之间被共享。寄存器堆106可另外被包括在处理器102中,并且可包括用于存储不同类型的数据的不同类型的寄存器(例如,整数寄存器、浮点寄存器、状态寄存器和指令指针寄存器)。一些寄存器可以是通用寄存器,而其他寄存器可特定于处理器102的设计。

10.在一些实施例中,一个或多个处理器102与一个或多个接口总线110耦合,以在处理器102与系统100中的其他组件之间传送通信信号,诸如地址、数据或控制信号。在一个实施例中,接口总线110可以是处理器总线,诸如某一版本的直接媒体接口(dmi)总线。然而,处理器总线不限于dmi总线,并且可包括一个或多个外设组件互连总线(peripheral component interconnect bus)(例如,pci、pci express)、存储器总线或其他类型的接口总线。在一个实施例中,(一个或多个)处理器1402包括集成的存储器控制器116和平台控制器集线器130。存储器控制器116促进存储器设备与系统100的其他组件之间的通信,而平台控制器集线器(pch)130经由本地i/o总线提供到i/o设备的连接。

11.存储器设备120可以是动态随机存取存储器(dram)设备、静态随机存取存储器(sram)设备、闪速存储器设备、相变存储器设备或具有适合性能以充当进程存储器的某一其他存储器设备。在一个实施例中,存储器设备120可作为用于系统100的系统存储器进行操作,以存储数据122和指令121以供在一个或多个处理器102执行应用或进程时使用。存储器控制器116还与可选的外部图形处理器118耦合,所述外部图形处理器118可与处理器102中的一个或多个图形处理器108进行通信以执行图形和媒体操作。在一些实施例中,可由加速器112协助图形、媒体和/或计算操作,所述加速器112是可被配置成执行图形、媒体或计算操作的专门集合的协处理器。例如,在一个实施例中,加速器112是用于优化机器学习或计算操作的矩阵乘法加速器。在一个实施例中,加速器112是光线追踪加速器,其可被用于与图形处理器108协同执行光线追踪操作。在一个实施例中,可替代加速器112或与加速器112协同使用外部加速器119。

12.在一些实施例中,显示设备111可连接到(一个或多个)处理器102。显示设备111可以是如在移动电子设备或膝上型设备中的内部显示设备或者经由显示接口(例如,displayport等)附连的外部显示设备中的一个或多个。在一个实施例中,显示设备111可以是头戴式显示器(hmd),诸如供在虚拟现实(vr)应用或增强现实(ar)应用中使用的立体显

示设备。

13.在一些实施例中,平台控制器集线器130使得外设能经由高速i/o总线连接到存储器设备120和处理器102。i/o外设包括但不限于音频控制器146、网络控制器134、固件接口128、无线收发器126、触摸传感器125、数据存储设备124(例如,非易失性存储器、易失性存储器、硬盘驱动器、闪速存储器、nand、3d nand、3d xpoint等)。数据存储设备124可经由存储接口(例如,sata)或经由诸如外设组件互连总线(例如,pci、pci express)之类的外设总线进行连接。触摸传感器125可包括触摸屏传感器、压力传感器或指纹传感器。无线收发器126可以是wi-fi收发器、蓝牙收发器或诸如3g、4g、5g或长期演进(lte)收发器之类的移动网络收发器。固件接口128实现与系统固件的通信,并且可以是例如统一可扩展固件接口(uefi)。网络控制器134可实现到有线网络的网络连接。在一些实施例中,高性能网络控制器(未示出)与接口总线110耦合。在一个实施例中,音频控制器146是多通道高清晰度音频控制器。在一个实施例中,系统100包括用于将传统(例如,个人系统2(ps/2))设备耦合到系统的可选的传统i/o控制器140。平台控制器集线器130还可连接到一个或多个通用串行总线(usb)控制器142连接输入设备,诸如键盘和鼠标143组合、相机144或其他usb输入设备。

14.将领会的是,示出的系统100是示例性的而非限制性的,因为以不同方式配置的其他类型的数据处理系统也可被使用。例如,存储器控制器116和平台控制器集线器130的实例可被集成到分立的外部图形处理器(诸如,外部图形处理器118)中。在一个实施例中,平台控制器集线器130和/或存储器控制器116可在一个或多个处理器102的外部。例如,系统100可包括外部存储器控制器116和平台控制器集线器130,其可被配置为与(一个或多个)处理器102通信的系统芯片组内的存储器控制器集线器和外设控制器集线器。

15.例如,可使用电路板(“滑板(sled)”),将诸如cpu、存储器和其他组件之类的组件放置在所述滑板上,其被设计用于增加的热性能。在一些示例中,诸如处理器之类的处理组件位于滑板的顶侧上,而诸如dimm之类的近存储器位于滑板的底侧上。作为通过此设计提供的增强气流的结果,组件可比在典型系统中更高的频率和功率水平操作,由此增加性能。此外,滑板被配置成与机架中的功率和数据通信缆线盲配对,从而增强它们被快速移除、升级、重新安装和/或替换的能力。类似地,位于滑板上的各个组件(诸如处理器、加速器、存储器和数据存储驱动器)被配置成由于它们与彼此增加的间距而容易被升级。在说明性实施例中,组件另外包括硬件证明特征以证实其确实性(authenticity)。

16.数据中心可利用单个网络架构(“组构”),所述单个网络架构支持包括以太网和全路径(omni-path)的多个其他网络架构。滑板可经由光纤被耦合到交换机,所述光纤提供比典型双绞线缆线(例如,类别5、类别5e、类别6等)更高的带宽和更低的时延。由于高带宽、低时延互连和网络架构,数据中心可在使用时对在物理上解聚的资源(诸如存储器、加速器(例如,gpu、图形加速器、fpga、asic、神经网络和/或人工智能加速器等)以及数据存储驱动器)进行池化,并在按照需要的基础上将它们提供到计算资源(例如,处理器),使得计算资源能访问池化资源,如同池化资源是本地的那样。

17.电力供应或电源可将电压和/或电流提供到本文描述的系统100或任何组件或系统。在一个示例中,电力供应包括用于插入到壁装电源插座的ac到dc(交流到直流)适配器。此类ac电力可以是可再生能源(例如,太阳能)电源。在一个示例中,电源包括dc电源,诸如外部ac到dc转换器。在一个示例中,电源或电力供应包括无线充电硬件以经由接近充电场

进行充电。在一个示例中,电源可包括内部电池、交流供应、基于运动的电力供应、太阳能供应或燃料电池源。

18.图2a-2d图示了由本文描述的实施例提供的计算系统和图形处理器。图2a-2d的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。

19.图2a是处理器200的实施例的框图,处理器200具有一个或多个处理器核202a-202n、集成存储器控制器214和集成图形处理器208。处理器200可包括另外的核,所述另外的核多达并且包括由虚线框表示的另外的核202n。处理器核202a-202n中的每个包括一个或多个内部高速缓存单元204a-204n。在一些实施例中,每个处理器核还可访问一个或多个共享高速缓存单元206。内部高速缓存单元204a-204n和共享高速缓存单元206表示处理器200内的高速缓冲存储器层级。高速缓冲存储器层级可包括每个处理器核内的至少一级的指令和数据高速缓存,以及一级或多级的共享中间级高速缓存,诸如2级(l2)、3级(l3)、4级(l4)或其他级的高速缓存,其中在外部存储器前的最高级的高速缓存被分类为llc。在一些实施例中,高速缓存一致性逻辑维持各种高速缓存单元206与204a-204n之间的一致性。

20.在一些实施例中,处理器200还可包括一组一个或多个总线控制器单元216和系统代理核210。一个或多个总线控制器单元216管理一组外设总线,诸如一个或多个pci或pci express总线。系统代理核210提供用于各种处理器组件的管理功能性。在一些实施例中,系统代理核210包括一个或多个集成存储器控制器214以管理对各种外部存储器设备(未示出)的访问。

21.在一些实施例中,处理器核202a-202n中的一个或多个处理器核包括对同时多线程的支持。在此类实施例中,系统代理核210包括用于在多线程的处理期间协调和操作核202a-202n的组件。系统代理核210可另外包括功率控制单元(pcu),所述功率控制单元(pcu)包括用于调节处理器核202a-202n和图形处理器208的功率状态的逻辑和组件。

22.在一些实施例中,处理器200另外包括用于执行图形处理操作的图形处理器208。在一些实施例中,图形处理器208与一组共享高速缓存单元206和系统代理核210耦合,所述系统代理核210包括一个或多个集成存储器控制器214。在一些实施例中,系统代理核210还包括用于将图形处理器输出驱动到一个或多个耦合的显示器的显示控制器211。在一些实施例中,显示控制器211还可以是经由至少一个互连与图形处理器耦合的单独模块,或者可被集成在图形处理器208内。

23.在一些实施例中,基于环的互连单元212被用于耦合处理器200的内部组件。然而,可使用备选互连单元,诸如点对点互连、交换互连或其他技术,其包括本领域中公知的技术。在一些实施例中,图形处理器208经由i/o链路213与环互连212耦合。

24.示例性i/o链路213表示多个种类的i/o互连中的至少一个,其包括促进各种处理器组件与诸如edram模块之类的高性能嵌入式存储器模块218之间的通信的封装上i/o互连。在一些实施例中,处理器核202a-202n中的每个和图形处理器208可使用嵌入式存储器模块218作为共享末级高速缓存。

25.在一些实施例中,处理器核202a-202n是执行相同指令集架构的同质核(homogenous core)。在另一实施例中,处理器核202a-202n在指令集架构(isa)方面是异质的(heterogeneous),其中处理器核202a-202n中的一个或多个处理器核执行第一指令集,

而其他核中的至少一个核执行第一指令集的子集或不同指令集。在一个实施例中,处理器核202a-202n在微架构方面是异质的,其中具有相对更高功耗的一个或多个核与具有更低功耗的一个或多个功率核耦合。在一个实施例中,处理器核202a-202n在计算能力方面是异质的。另外,处理器200可在一个或多个芯片上被实现,或者被实现为除其他组件外还具有所图示的组件的soc集成电路。

26.图2b是根据本文描述的一些实施例的图形处理器核219的硬件逻辑的框图。图2b的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。有时被称为核切片的图形处理器核219可以是模块化图形处理器内的一个或多个图形核。图形处理器核219是一个图形核切片的示例,并且如本文描述的图形处理器可包括基于目标功率和性能包络的多个图形核切片。每个图形处理器核219可包括与也称为子切片的多个子核221a-221f耦合的固定功能块230,所述多个子核221a-221f包括通用和固定功能逻辑的模块化块。

27.在一些实施例中,固定功能块230包括几何/固定功能流水线231,所述几何/固定功能流水线231可例如在更低性能和或更低功率图形处理器实现中由图形处理器核219中的所有子核共享。在各种实施例中,几何/固定功能流水线231包括3d固定功能流水线(例如,如下述图3和图4中的3d流水线312)、视频前端单元、线程派生器(thread spawner)和线程分派器、以及管理统一返回缓冲器(例如,如下所述的在图4中的统一返回缓冲器418)的统一返回缓冲器管理器。

28.在一个实施例中,固定功能块230还包括图形soc接口232、图形微控制器233和媒体流水线234。图形soc接口232提供图形处理器核219与片上系统集成电路内的其他处理器核之间的接口。图形微控制器233是可编程子处理器,其可被配置成管理图形处理器核219的各种功能,其包括线程分派、调度和抢占(pre-emption)。媒体流水线234(例如,图3和图4的媒体流水线316)包括用于促进包括图像和视频数据的多媒体数据的解码、编码、预处理和/或后处理的逻辑。媒体流水线234经由对子核221-221f内的计算或采样逻辑的请求来实现媒体操作。

29.在一个实施例中,soc接口232使得图形处理器核219能够与通用应用处理器核(例如,cpu)和/或soc内的其他组件通信,所述soc内的其他组件包括诸如共享末级高速缓冲存储器、系统ram和/或嵌入式片上或封装上dram之类的存储器层级元件。soc接口232还可实现与soc内的固定功能设备(诸如,相机成像流水线)的通信,并且实现全局存储器原子的使用和/或实现全局存储器原子,所述全局存储器原子可在图形处理器核219与soc内的cpu之间被共享。soc接口232还可实现针对图形处理器核219的功率管理控制,并且实现图形核219的时钟域与soc内的其他时钟域之间的接口。在一个实施例中,soc接口232使得能够接收来自命令流播器和全局线程分派器的命令缓冲器,所述命令流播器和全局线程分派器被配置成向图形处理器内的一个或多个图形核中的每个提供命令和指令。命令和指令可在要执行媒体操作时被分派到媒体流水线234,或者在要执行图形处理操作时被分派到几何和固定功能流水线(例如,几何和固定功能流水线231、几何和固定功能流水线237)。

30.图形微控制器233可被配置成执行用于图形处理器核219的各种调度和管理任务。在一个实施例中,图形微控制器233可在子核221a-221f内的执行单元(eu)阵列222a-222f、224a-224f内的各种图形并行引擎上执行图形和/或计算工作负载调度。在该调度模型中,

在包括图形处理器核219的soc的cpu核上执行的主机软件可将工作负载提交给多个图形处理器门铃中的一个,这调用适当图形引擎上的调度操作。调度操作包括确定接下来要运行哪个工作负载、向命令流播器提交工作负载、对在引擎上运行的现有工作负载进行抢占、监视工作负载的进展、以及在工作负载完成时通知主机软件。在一个实施例中,图形微控制器233还可促进用于图形处理器核219的低功率或空闲状态,从而为图形处理器核219提供独立于操作系统和/或系统上的图形驱动器软件跨低功率状态转变来对图形处理器核219内的寄存器进行保存和恢复的能力。

31.图形处理器核219可具有多于或少于所图示的子核221a-221f,多达n个模块化子核。对于n个子核的每个集合,图形处理器核219还可包括共享功能逻辑235、共享和/或高速缓冲存储器236、几何/固定功能流水线237以及另外的固定功能逻辑238以加速各种图形和计算处理操作。共享功能逻辑235可包括与图4的共享功能逻辑420相关联的逻辑单元(例如,采样器、数学和/或线程间通信逻辑),所述逻辑单元可由图形处理器核219内的每n个子核共享。共享和/或高速缓冲存储器236可以是用于图形处理器核219内的n个子核221a-221f的集合的末级高速缓存,并且还可充当可由多个子核访问的共享存储器。几何/固定功能流水线237可代替固定功能块230内的几何/固定功能流水线231而被包括并且可包括相同或类似的逻辑单元。

32.在一个实施例中,图形处理器核219包括另外的固定功能逻辑238,其可包括供图形处理器核219使用的各种固定功能加速逻辑。在一个实施例中,另外的固定功能逻辑238包括供在仅位置着色中使用的另外的几何流水线。在仅位置着色中,存在两个几何流水线:几何/固定功能流水线238、231内的完全几何流水线;以及剔除流水线(cull pipeline),其是可被包括在另外的固定功能逻辑238内的另外的几何流水线。在一个实施例中,剔除流水线是完全几何流水线的裁减版本(trimmed down version)。完全流水线和剔除流水线可执行相同应用的不同实例,每个实例具有单独的上下文。仅位置着色可隐藏被丢弃三角形的长剔除运行,使得在一些实例中能更早完成着色。例如并且在一个实施例中,另外的固定功能逻辑238内的剔除流水线逻辑可执行与主应用并行的位置着色器,并且一般比完全流水线更快生成关键结果,因为剔除流水线仅对顶点的位置属性进行提取并着色,而不向帧缓冲器执行像素的光栅化和渲染。剔除流水线可使用所生成的关键结果来计算用于所有三角形的可见性信息,而不考虑那些三角形是否被剔除。完全流水线(其在该实例中可被称为重放流水线)可消耗可见性信息以跳过被剔除的三角形,以仅对最终被传递到光栅化阶段的可见三角形进行着色。

33.在一个实施例中,另外的固定功能逻辑238还可包括诸如固定功能矩阵乘法逻辑之类的机器学习加速逻辑,以用于包括针对机器学习训练或推理的优化的实现。

34.在每个图形子核221a-221f内包括一组执行资源,其可被用于响应于图形流水线、媒体流水线或着色器程序的请求而执行图形、媒体和计算操作。图形子核221a-221f包括多个eu阵列222a-222f、224a-224f、线程分派和线程间通信(td/ic)逻辑223a-223f、3d(例如,纹理)采样器225a-225f、媒体采样器206a-206f、着色器处理器227a-227f和共享本地存储器(slm)228a-228f。eu阵列222a-222f、224a-224f各自包括多个执行单元,所述多个执行单元是能够为图形、媒体或计算操作(包括图形、媒体或计算着色器程序)服务而执行浮点和整数/固定点逻辑运算的通用图形处理单元。td/ic逻辑223a-223f执行用于子核内的执行

单元的本地线程分派和线程控制操作,并且促进在子核的执行单元上执行的线程之间的通信。3d采样器225a-225f可将纹理或其他3d图形相关数据读取到存储器中。3d采样器可基于所配置的样本状态和与给定纹理相关联的纹理格式以不同方式读取纹理数据。媒体采样器206a-206f可基于与媒体数据相关联的类型和格式来执行类似的读取操作。在一个实施例中,每个图形子核221a-221f可交替包括统一3d和媒体采样器。在子核221a-221f中的每个子核内的执行单元上执行的线程可利用每个子核内的共享本地存储器228a-228f,以使得在线程组内执行的线程能使用片上存储器的公共池来执行。

35.图2c图示了包括被布置到多核组240a-240n中的图形处理资源的专用集合的图形处理单元(gpu)239。尽管提供了仅单个多核组240a的细节,但将领会,其他多核组240b-240n可以配备有图形处理资源的相同或类似集合。

36.如所图示的那样,多核组240a可以包括一组图形核243、一组张量核244和一组光线追踪核245。调度器/分派器241调度和分派图形线程以用于在各种核243、244、245上执行。一组寄存器堆242存储核243、244、245在执行图形线程时使用的操作数值。这些可以包括例如用于存储整数值的整数寄存器、用于存储浮点值的浮点寄存器、用于存储打包数据元素(整数和/或浮点数据元素)的向量寄存器和用于存储张量/矩阵值的贴片寄存器。在一个实施例中,贴片寄存器被实现为向量寄存器的组合集合。

37.一个或多个组合1级(l1)高速缓存和共享存储器单元247在每个多核组240a内本地存储图形数据,诸如纹理数据、顶点数据、像素数据、光线数据、包围体数据等。一个或多个纹理单元247还可以用于执行纹理操作,诸如纹理映射和采样。由多核组240a-240n的全部或子集共享的2级(l2)高速缓存253存储针对多个同时图形线程的图形数据和/或指令。如所图示的那样,l2高速缓存253可以跨多个多核组240a-240n而共享。一个或多个存储器控制器248将gpu 239耦合到存储器249,存储器249可以是系统存储器(例如,dram)和/或专用图形存储器(例如,gddr6存储器)。

38.输入/输出(i/o)电路系统250将gpu 239耦合到一个或多个i/o设备252,诸如数字信号处理器(dsp)、网络控制器或用户输入设备。片上互连可以用于将i/o设备252耦合到gpu 239和存储器249。i/o电路系统250的一个或多个i/o存储器管理单元(iommu)251将i/o设备252直接耦合到系统存储器249。在一个实施例中,iommu 251管理页表的多个集合以将虚拟地址映射到系统存储器249中的物理地址。在该实施例中,i/o设备252、(一个或多个)cpu 246和(一个或多个)gpu 239可以共享相同虚拟地址空间。

39.在一个实现中,iommu 251支持虚拟化。在该情况下,它可以管理页表的第一集合以将客户/图形虚拟地址映射到客户/图形物理地址,并管理页表的第二集合以将客户/图形物理地址映射到系统/主机物理地址(例如,在系统存储器249内)。页表的第一和第二集合中的每个的基址可被存储在控制寄存器中并且在上下文切换时被换出(例如,使得新的上下文被提供有对页表的相关集合的访问)。尽管在图2c中未图示,但核243、244、245和/或多核组240a-240n中的每个可以包括转化后备缓冲器(tlb),以对客户虚拟到客户物理转化、客户物理到主机物理转化以及客户虚拟到主机物理转化进行高速缓存。

40.在一个实施例中,cpu 246、gpu 239和i/o设备252被集成在单个半导体芯片和/或芯片封装上。所图示的存储器249可被集成在相同芯片上,或者可经由片外接口而耦合到存储器控制器248。在一个实现中,存储器249包括gddr6存储器,所述gddr6存储器共享与其他

物理系统级存储器相同的虚拟地址空间,尽管本发明的基础原理不限于此特定实现。

41.在一个实施例中,张量核244包括特别设计成执行矩阵运算的多个执行单元,所述矩阵运算是用于执行深度学习操作的基础计算操作。例如,同时矩阵乘法运算可被用于神经网络训练和推理。张量核244可使用多种操作数精度来执行矩阵处理,所述多种操作数精度包括单精度浮点(例如,32位)、半精度浮点(例如,16位)、整数字(16位)、字节(8位)和半字节(4位)。在一个实施例中,神经网络实现取出每个经渲染的场景的特征,潜在地组合来自多个帧的细节,以构造高质量的最终图像。

42.在深度学习实现中,可调度并行矩阵乘法工作以用于在张量核244上执行。神经网络的训练特别要求大量的矩阵点积运算。为了处理n x n x n矩阵相乘的内积公式,张量核244可包括至少n个点积处理元素。在矩阵相乘开始前,一个完整矩阵被加载到贴片寄存器中,并且在n个周期的每个周期,第二矩阵的至少一列被加载。每个周期,有被处理的n个点积。

43.取决于特定实现,可以以不同精度存储矩阵元素,所述不同精度包括16位字、8位字节(例如,int8)和4位半字节(例如,int4)。可为张量核244指定不同精度模式以确保最高效的精度被用于不同工作负载(例如,诸如可容许量化到字节和半字节的推理工作负载)。

44.在一个实施例中,光线追踪核245对于实时光线追踪和非实时光线追踪实现二者均使光线追踪操作加速。特别地,光线追踪核245包括光线遍历/交叉电路系统,以用于使用包围体层级(bvh)来执行光线遍历并且标识封闭在bvh体积之内的图元与光线之间的交叉。光线追踪核245还可包括用于执行深度测试和剔除(例如,使用z缓冲器或类似布置)的电路系统。在一个实现中,光线追踪核245与本文描述的图像去噪技术协同执行遍历和交叉操作,其至少一部分可在张量核244上被执行。例如,在一个实施例中,张量核244实现要执行的深度学习神经网络,包括本地存储器9010(和/或系统存储器)对由光线追踪核245生成的帧的去噪。然而,(一个或多个)cpu 246、图形核243和/或光线追踪核245还可实现去噪和/或深度学习算法的全部或一部分。

45.另外,如上所述,可采用去噪的分布式方法,其中gpu 239处于通过网络或高速互连耦合到其他计算设备的计算设备中。在该实施例中,互连的计算设备共享神经网络学习/训练数据来改进速度,利用该速度,整个系统学习对不同类型的图像帧和/或不同的图形应用执行去噪。

46.在一个实施例中,光线追踪核245处理所有bvh遍历和光线-图元交叉,从而避免图形核243以每光线数千个指令而过载。在一个实施例中,每个光线追踪核245包括用于执行包围盒测试(例如,对于遍历操作)的专用电路系统的第一集合和用于执行光线-三角形交叉测试(例如,交叉已被遍历的光线)的专用电路系统的第二集合。因此,在一个实施例中,多核组240a可仅仅启动光线探头,并且光线追踪核245独立执行光线遍历和交叉并且将命中数据(例如,命中、无命中、多次命中等)返回到线程上下文。在光线追踪核245执行遍历和交叉操作的同时,其他核243、244被释放以执行其他图形或计算工作。

47.在一个实施例中,每个光线追踪核245包括用于执行bvh测试操作的遍历单元和执行光线-图元交叉测试的交叉单元。交叉单元生成“命中”、“无命中”或“多次命中”响应,交叉单元将该响应提供到适当的线程。在遍历和交叉操作期间,其他核(例如,图形核243和张量核244)的执行资源被释放以执行其他形式的图形工作。

48.在下述的一个特定实施例中,使用了混合光栅化/光线追踪方法,其中在图形核243与光线追踪核245之间分布工作。

49.在一个实施例中,光线追踪核245(和/或其他核243、244)包括对诸如microsoft的directx光线追踪(dxr)之类的光线追踪指令集的硬件支持,所述dxr包括dispatchrays命令以及光线-生成、最接近-命中、任何-命中和未命中着色器,这些实现对每个对象指派纹理和着色器的独特集合。可由光线追踪核245、图形核243和张量核244支持的另一光线追踪平台是vulkan 1.1.85。然而,注意本发明的基础原理不限于任何特定光线追踪isa。

50.一般而言,各种核245、244、243可支持光线追踪指令集,所述光线追踪指令集包括用于光线生成、最接近命中、任何命中、光线-图元交叉、每图元和分层包围盒构造、未命中、访问和异常的指令/功能。更特定地,一个实施例包括光线追踪指令以执行以下功能:光线生成

ꢀ–ꢀ

可为每个像素、样本或其他用户定义的工作指派执行光线生成指令。

51.最接近命中

ꢀ–ꢀ

可执行最接近命中指令,以用场景内的图元来定位光线的最接近交点。

52.任何命中

ꢀ‑ꢀ

任何命中指令标识场景内的图元与光线之间的多个交叉,潜在地标识新的最接近交点。

53.交叉

ꢀ‑ꢀ

交叉指令执行光线-图元交叉测试并且输出结果。

54.每图元包围盒构造

ꢀ‑ꢀ

此指令围绕给定图元或图元的组构建包围盒(例如,在构建新的bvh或其他加速数据结构时)。

55.未命中

ꢀ–ꢀ

指示光线未命中场景的指定区或场景内的所有几何结构。

56.访问

ꢀ–ꢀ

指示光线将遍历的子代体积(children volume)。

57.异常

ꢀ‑ꢀ

包括各种类型的异常处理程序(例如,针对各种误差状况而被调用)。

58.图2d是根据本文描述的实施例的可被配置为图形处理器和/或计算加速器的通用图形处理单元(gpgpu)270的框图。gpgpu 270可经由一个或多个系统和/或存储器总线与主机处理器(例如,一个或多个cpu 246)和存储器271、272互连。在一个实施例中,存储器271是可与一个或多个cpu 246共享的系统存储器,而存储器272是专用于gpgpu 270的设备存储器。在一个实施例中,设备存储器272和gpgpu 270内的组件可被映射到一个或多个cpu 246可访问的存储器地址中。可经由存储器控制器268来促进对存储器271和272的访问。在一个实施例中,存储器控制器268包括内部直接存储器存取(dma)控制器269,或者可包括逻辑以执行否则将由dma控制器执行的操作。

59.gpgpu 270包括多个高速缓冲存储器,其包括l2高速缓存253、l1高速缓存254、指令高速缓存255和共享存储器256,该共享存储器256的至少一部分也可被分区为高速缓冲存储器。gpgpu 270还包括多个计算单元260a-260n。每个计算单元260a-260n包括一组向量寄存器261、标量寄存器262、向量逻辑单元263和标量逻辑单元264。计算单元260a-260n还可包括本地共享存储器265和程序计数器266。计算单元260a-260n可与常量高速缓存267耦合,该常量高速缓存267可被用于存储常量数据,所述常量数据是在gpgpu 270上执行的内核或着色器程序的运行期间将不改变的数据。在一个实施例中,常量高速缓存267是标量数据高速缓存,并且经高速缓存的数据可被直接提取到标量寄存器262中。

60.在操作期间,一个或多个cpu 246可将命令写入已被映射到可访问地址空间中的gpgpu 270中的寄存器或存储器中。命令处理器257可从寄存器或存储器读取命令,并且确

定将在gpgpu 270内如何处理那些命令。然后线程分派器258可被用于将线程分派到计算单元260a-260n,以执行那些命令。每个计算单元260a-260n可独立于其他计算单元执行线程。另外,每个计算单元260a-260n可被独立配置用于有条件的计算,并且可有条件地将计算的结果输出到存储器。在提交的命令完成时,命令处理器257可中断一个或多个cpu 246。

61.图3a-3c图示了由本文描述的实施例提供的另外的图形处理器和计算加速器架构的框图。图3a-3c的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。

62.图3a是图形处理器300的框图,该图形处理器300可以是分立的图形处理单元,或者可以是与多个处理核集成的图形处理器,或诸如但不限于存储器设备或网络接口的其他半导体设备。在一些实施例中,图形处理器经由到图形处理器上的寄存器的存储器映射i/o接口并且利用被放置到处理器存储器中的命令进行通信。在一些实施例中,图形处理器300包括用于访问存储器的存储器接口314。存储器接口314可以是到本地存储器、一个或多个内部高速缓存、一个或多个共享外部高速缓存和/或到系统存储器的接口。

63.在一些实施例中,图形处理器300还包括用于将显示输出数据驱动到显示设备318的显示控制器302。显示控制器302包括用于一个或多个覆盖平面的硬件,以用于显示和组成用户接口元素或视频的多个层。显示设备318可以是内部或外部显示设备。在一个实施例中,显示设备318是头戴式显示设备,诸如虚拟现实(vr)显示设备或增强现实(ar)显示设备。在一些实施例中,图形处理器300包括视频编解码器引擎306以将媒体编码成一个或多个媒体编码格式、从一个或多个媒体编码格式将媒体解码、或者在一个或多个媒体编码格式之间对媒体进行转码,所述媒体编码格式包括但不限于运动图像专家组(mpeg)格式(诸如,mpeg-2)、高级视频编码(avc)格式(诸如,h.264/mpeg-4 avc、h.265/hevc)、开放媒体联盟(aomedia)vp8、vp9以及电影与电视工程师协会(smpte)421m/vc-1和联合图像专家组(jpeg)格式,诸如,jpeg、和运动jpeg(mjpeg)格式。

64.在一些实施例中,图形处理器300包括用于执行二维(2d)光栅化器操作(包括例如位边界块传送)的块图像传送(blit)引擎304。然而,在一个实施例中,使用图形处理引擎(gpe)310的一个或多个组件来执行2d图形操作。在一些实施例中,gpe 310是用于执行包括三维(3d)图形操作和媒体操作的图形操作的计算引擎。

65.在一些实施例中,gpe 310包括用于执行3d操作的3d流水线312,所述3d操作诸如是使用作用于3d图元形状(例如,矩形、三角形等)的处理功能来渲染三维图像和场景。3d流水线312包括可编程和固定功能元件,所述可编程和固定功能元件在元件内执行各种任务和/或派生(spawn)到3d/媒体子系统315的执行线程。尽管3d流水线312可被用于执行媒体操作,但gpe 310的实施例还包括特别用于执行媒体操作(诸如,视频后处理和图像增强)的媒体流水线316。

66.在一些实施例中,媒体流水线316包括固定功能或可编程逻辑单元以代替或者代表视频编解码器引擎306来执行一个或多个专用媒体操作,诸如视频解码加速、视频去交织和视频编码加速。在一些实施例中,媒体流水线316另外包括线程派生单元以派生用于在3d/媒体子系统315上执行的线程。派生的线程在3d/媒体子系统315中包括的一个或多个图形执行单元上执行用于媒体操作的计算。

67.在一些实施例中,3d/媒体子系统315包括用于执行由3d流水线312和媒体流水线

316派生的线程的逻辑。在一个实施例中,流水线将线程执行请求发送到3d/媒体子系统315,所述3d/媒体子系统315包括线程分派逻辑,所述线程分派逻辑用于将各种请求仲裁并分派到可用线程执行资源。执行资源包括用于处理3d和媒体线程的图形执行单元的阵列。在一些实施例中,3d/媒体子系统315包括用于线程指令和数据的一个或多个内部高速缓存。在一些实施例中,子系统还包括共享存储器,所述共享存储器包括寄存器和可寻址存储器,以在线程之间共享数据并且存储输出数据。

68.图3b图示了根据本文描述的实施例的具有拼贴架构的图形处理器320。在一个实施例中,图形处理器320包括图形处理引擎集群322,所述图形处理引擎集群322在图形引擎贴片310a-310d内具有图3a的图形处理引擎310的多个实例。每个图形引擎贴片310a-310d可经由一组贴片互连323a-323f而被互连。每个图形引擎贴片310a-310d还可经由存储器互连325a-325d被连接到存储器模块或存储器设备326a-326d。存储器设备326a-326d可使用任何图形存储器技术。例如,存储器设备326a-326d可以是图形双倍数据率(gddr)存储器。在一个实施例中,存储器设备326a-326d是高带宽存储器(hbm)模块,其可与其相应图形引擎贴片310a-310d一起在管芯上。在一个实施例中,存储器设备326a-326d是堆叠存储器设备,其可被堆叠在其相应图形引擎贴片310a-310d顶上。在一个实施例中,如图11b-11d中进一步详细描述的那样,每个图形引擎贴片310a-310d和关联存储器326a-326d驻留在单独的小芯片上,所述小芯片被接合到基础管芯或基础衬底。

69.图形处理引擎集群322可与片上或封装上组构互连324连接。组构互连324可实现图形引擎贴片310a-310d与诸如视频编解码器306和一个或多个拷贝引擎304之类的组件之间的通信。拷贝引擎304可被用于将数据移出以下各项、将数据移入以下各项以及在以下各项之间移动数据:存储器设备326a-326d和处于图形处理器320外的存储器(例如,系统存储器)。组构互连324还可被用于互连图形引擎贴片310a-310d。图形处理器320可以可选地包括用于实现与外部显示设备318的连接的显示控制器302。图形处理器还可被配置为图形或计算加速器。在加速器配置中,可省略显示控制器302和显示设备318。

70.图形处理器320可经由主机接口328连接到主机系统。主机接口328可实现图形处理器320、系统存储器和/或其他系统组件之间的通信。主机接口328可例如是pci express总线或另一类型的主机系统接口。

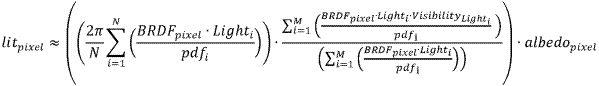

71.图3c图示了根据本文描述的实施例的计算加速器330。计算加速器330可包括与图3b的图形处理器320的架构类似性并且被优化用于计算加速。计算引擎集群332可包括计算引擎贴片340a-340d的集合,其包括被优化用于并行或基于向量的通用计算操作的执行逻辑。在一些实施例中,计算引擎贴片340a-340d不包括固定功能图形处理逻辑,尽管在一个实施例中,计算引擎贴片340a-340d中的一个或多个计算引擎贴片可包括用于执行媒体加速的逻辑。计算引擎贴片340a-340d可经由存储器互连325a-325d连接到存储器326a-326d。存储器326a-326d和存储器互连325a-325d可以是与在图形处理器320中类似的技术,或者可以是不同的。图形计算引擎贴片340a-340d还可经由贴片互连323a-323f的集合被互连,并且可与组构互连324连接和/或通过组构互连324被互连。在一个实施例中,计算加速器330包括可被配置为设备范围高速缓存的大的l3高速缓存336。计算加速器330还可以以与图3b的图形处理器320类似的方式经由主机接口328连接到主机处理器和存储器。

72.图形处理引擎

图4是根据一些实施例的图形处理器的图形处理引擎410的框图。在一个实施例中,图形处理引擎(gpe)410是图3a中示出的gpe 310的某一版本,并且还可表示图3b的图形引擎贴片310a-310d。图4的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。例如,图示了图3a的3d流水线312和媒体流水线316。媒体流水线316在gpe 410的一些实施例中是可选的,并且可未被显式地包括在gpe 410内。例如并且在至少一个实施例中,单独的媒体和/或图像处理器被耦合到gpe 410。

73.在一些实施例中,gpe 410与命令流播器403耦合或者包括该命令流播器403,该命令流播器403将命令流提供到3d流水线312和/或媒体流水线316。在一些实施例中,命令流播器403与存储器耦合,所述存储器可以是系统存储器,或内部高速缓冲存储器和共享高速缓冲存储器中的一个或多个。在一些实施例中,命令流播器403接收来自存储器的命令,并且将命令发送到3d流水线312和/或媒体流水线316。命令是从存储用于3d流水线312和媒体流水线316的命令的环形缓冲器提取的指令(directive)。在一个实施例中,环形缓冲器可另外包括存储批量的多个命令的批量命令缓冲器。用于3d流水线312的命令还可包括对在存储器中存储的数据(诸如但不限于用于3d流水线312的顶点和几何数据和/或用于媒体流水线316的图像数据和存储器对象)的引用。3d流水线312和媒体流水线316通过经由相应流水线内的逻辑执行操作或者通过将一个或多个执行线程分派到图形核阵列414来处理命令和数据。在一个实施例中,图形核阵列414包括图形核(例如,(一个或多个)图形核415a、(一个或多个)图形核415b)的一个或多个块,每个块包括一个或多个图形核。每个图形核包括:图形执行资源的集合,其包括用于执行图形和计算操作的通用和图形特定执行逻辑;以及固定功能纹理处理和/或机器学习和人工智能加速逻辑。

74.在各种实施例中,3d流水线312可包括用于通过处理指令并且将执行线程分派到图形核阵列414来处理一个或多个着色器程序(诸如,顶点着色器、几何着色器、像素着色器、片段着色器、计算着色器或其他着色器程序)的固定功能和可编程逻辑。图形核阵列414提供执行资源的统一块以用于在处理这些着色器程序时使用。图形核阵列414的(一个或多个)图形核415a-415b内的多用途执行逻辑(例如,执行单元)包括对各种3d api着色器语言的支持,并且可执行与多个着色器相关联的多个同时执行线程。

75.在一些实施例中,图形核阵列414可包括用于执行媒体功能(诸如,视频和/或图像处理)的执行逻辑。在一个实施例中,执行单元包括通用逻辑,该通用逻辑可编程以除图形处理操作外还执行并行通用计算操作。该通用逻辑可与在图1的(一个或多个)处理器核107或如图2a中的核202a-202n内的通用逻辑并行或结合地执行处理操作。

76.由在图形核阵列414上执行的线程生成的输出数据可将数据输出到统一返回缓冲器(urb)418中的存储器。urb 418可存储用于多个线程的数据。在一些实施例中,urb 418可被用于在图形核阵列414上执行的不同线程之间发送数据。在一些实施例中,urb 418可另外被用于在图形核阵列上的线程与在共享功能逻辑420内的固定功能逻辑之间的同步。

77.在一些实施例中,图形核阵列414是可缩放的,使得该阵列包括可变数量的图形核,这些图形核各自基于gpe 410的目标功率和性能水平而具有可变数量的执行单元。在一个实施例中,执行资源是动态可缩放的,使得可按照需要启用或禁用执行资源。

78.图形核阵列414与共享功能逻辑420耦合,该共享功能逻辑420包括在图形核阵列

中的图形核之间共享的多个资源。共享功能逻辑420内的共享功能是硬件逻辑单元,所述硬件逻辑单元将专用补充功能性提供到图形核阵列414。在各种实施例中,共享功能逻辑420包括但不限于采样器421、数学422和线程间通信(itc)423逻辑。另外,一些实施例实现共享功能逻辑420内的一个或多个高速缓存425。

79.至少在其中对给定专用功能的需求不足以包括在图形核阵列414内的情况下,实现共享功能。相反,该专用功能的单个实例化被实现为共享功能逻辑420中的独立实体,且在图形核阵列414内的执行资源之间被共享。在图形核阵列414之间共享且包括在图形核阵列414内的功能的精确集合跨实施例而变化。在一些实施例中,由图形核阵列414广泛使用的共享功能逻辑420内的特定共享功能可被包括在图形核阵列414内的共享功能逻辑416内。在各种实施例中,图形核阵列414内的共享功能逻辑416可包括共享功能逻辑420内的一些或全部逻辑。在一个实施例中,可在图形核阵列414的共享功能逻辑416内重复共享功能逻辑420内的全部逻辑元件。在一个实施例中,排除了共享功能逻辑420以有利于图形核阵列414内的共享功能逻辑416。

80.执行单元图5a-5b图示了根据本文描述的实施例的线程执行逻辑500,其包括在图形处理器核中采用的处理元件的阵列。图5a-5b的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。图5a-5b图示了线程执行逻辑500的概述,该线程执行逻辑500可表示利用图2b的每个子核221a-221f图示的硬件逻辑。图5a表示通用图形处理器内的执行单元,而图5b表示可在计算加速器内使用的执行单元。

81.如图5a中所图示,在一些实施例中,线程执行逻辑500可包括着色器处理器502、线程分派器504、指令高速缓存506、包括多个执行单元508a-508n的可缩放执行单元阵列、采样器510、共享本地存储器511、数据高速缓存512和数据端口514。在一个实施例中,可缩放执行单元阵列可通过基于工作负载的计算要求启用或禁用一个或多个执行单元(例如,执行单元508a、508b、508c、508d到508n-1和508n中的任何执行单元)来动态地进行缩放。在一个实施例中,所包括的组件经由链接到组件中的每个组件的互连组构而互连。在一些实施例中,线程执行逻辑500包括通过指令高速缓存506、数据端口514、采样器510和执行单元508a-508n中的一个或多个到存储器(诸如,系统存储器或高速缓冲存储器)的一个或多个连接。在一些实施例中,每个执行单元(例如,508a)是独立可编程通用计算单元,其能执行多个同时硬件线程,同时为每个线程并行处理多个数据元素。在各种实施例中,执行单元508a-508n的阵列是可缩放的,以包括任何数量的各个执行单元。

82.在一些实施例中,执行单元508a-508n主要被用于执行着色器程序。着色器处理器502可处理各种着色器程序,且经由线程分派器504分派与着色器程序相关联的执行线程。在一个实施例中,线程分派器包括用于对来自图形和媒体流水线的线程发起请求进行仲裁并且在执行单元508a-508n中的一个或多个执行单元上实例化所请求的线程的逻辑。例如,几何流水线可将顶点、曲面细分或几何着色器分派到线程执行逻辑以用于处理。在一些实施例中,线程分派器504还可处理来自执行的着色器程序的运行时线程派生请求。

83.在一些实施例中,执行单元508a-508n支持指令集,所述指令集包括对许多标准3d图形着色器指令的本机支持,使得来自图形库(例如,direct 3d和opengl)的着色器程序以

最小的转化被执行。执行单元支持顶点和几何处理(例如,顶点程序、几何程序、顶点着色器)、像素处理(例如,像素着色器、片段着色器)和通用处理(例如,计算和媒体着色器)。执行单元508a-508n中的每个执行单元能进行多发布(multi-issue)单指令多数据(simd)执行,并且多线程操作在面临更高时延存储器访问时实现高效执行环境。每个执行单元内的每个硬件线程具有专用高带宽寄存器堆和关联独立线程状态。执行是对能进行整数、单精度和双精度浮点运算、simd分支能力、逻辑运算、超越运算和其他杂项运算的流水线的每时钟多发布。在等待来自存储器或共享功能之一的数据时,执行单元508a-508n内的依赖性逻辑促使等待的线程进行休眠,直到所请求的数据已被返回为止。在等待的线程正在休眠时,硬件资源可专用于处理其他线程。例如,在与顶点着色器操作相关联的延迟期间,执行单元可执行用于像素着色器、片段着色器或另一类型的着色器程序(包括不同顶点着色器)的操作。各种实施例可应用于:通过作为使用simd的备选方案或者除使用simd之外还使用单指令多线程(simt)来使用执行。对simd核或操作的引用也可应用于simt或者应用于与simt组合的simd。

84.执行单元508a-508n中的每个执行单元对数据元素的阵列进行操作。数据元素的数量是“执行大小”或指令的通道的数量。执行通道是用于指令内的数据元素访问、掩蔽(masking)和流控制的执行的逻辑单元。通道的数量可独立于特定图形处理器的物理算术逻辑单元(alu)或浮点单元(fpu)的数量。在一些实施例中,执行单元508a-508n支持整数和浮点数据类型。

85.执行单元指令集包括simd指令。各种数据元素可作为打包数据类型存储在寄存器中,并且执行单元将基于元素的数据大小来处理各种元素。例如,在对256位宽向量进行操作时,向量的256位被存储在寄存器中,并且执行单元对作为四个单独的54位打包数据元素(四字(qw)大小数据元素)、八个单独的32位打包数据元素(双字(dw)大小数据元素)、十六个单独的16位打包数据元素(字(w)大小数据元素)或三十二个单独的8位数据元素(字节(b)大小数据元素)的向量进行操作。然而,不同向量宽度和寄存器大小是可能的。

86.在一个实施例中,一个或多个执行单元可被组合成具有线程控制逻辑(507a-507n)的融合的执行单元509a-509n,所述线程控制逻辑(507a-507n)对于融合的eu是公共的。多个eu可被融合成eu群组。融合的eu群组中的每个eu可被配置成执行单独的simd硬件线程。融合的eu群组中eu的数量可根据实施例而变化。另外,可每eu执行各种simd宽度,包括但不限于simd8、simd16和simd32。每个融合的图形执行单元509a-509n包括至少两个执行单元。例如,融合的执行单元509a包括第一eu 508a、第二eu 508b以及线程控制逻辑507a,该线程控制逻辑507a对第一eu 508a和第二eu 508b是公共的。线程控制逻辑507a控制在融合的图形执行单元509a上执行的线程,允许融合的执行单元509a-509n内的每个eu使用公共指令指针寄存器来执行。

87.在线程执行逻辑500中包括一个或多个内部指令高速缓存(例如,506)以对用于执行单元的线程指令进行高速缓存。在一些实施例中,包括一个或多个数据高速缓存(例如,512)以在线程执行期间对线程数据进行高速缓存。在执行逻辑500上执行的线程还可在共享本地存储器511中存储显式管理的数据。在一些实施例中,包括采样器510以提供3d操作的纹理采样和媒体操作的媒体采样。在一些实施例中,采样器510包括专用纹理或媒体采样功能性,以在向执行单元提供采样的数据前在采样过程期间处理纹理或媒体数据。

88.在执行期间,图形和媒体流水线经由线程派生和分派逻辑向线程执行逻辑500发送线程发起请求。一旦几何对象的群组已被处理且光栅化成像素数据,着色器处理器502内的像素处理器逻辑(例如,像素着色器逻辑、片段着色器逻辑等)就被调用以进一步计算输出信息,且使结果被写入到输出表面(例如,颜色缓冲器、深度缓冲器、模板缓冲器等)。在一些实施例中,像素着色器或片段着色器计算要跨光栅化对象内插的各种顶点属性的值。在一些实施例中,着色器处理器502内的像素处理器逻辑然后执行应用编程接口(api)供应的像素或片段着色器程序。为了执行着色器程序,着色器处理器502经由线程分派器504向执行单元(例如,508a)分派线程。在一些实施例中,着色器处理器502使用采样器510中的纹理采样逻辑来访问存储在存储器中的纹理映射中的纹理数据。对纹理数据和输入几何数据的算术运算为每个几何片段计算像素颜色数据,或者丢弃一个或多个像素而不进行进一步处理。

89.在一些实施例中,数据端口514提供存储器访问机制,以供线程执行逻辑500将经处理的数据输出至存储器以用于在图形处理器输出流水线上进一步处理。在一些实施例中,数据端口514包括或者耦合到一个或多个高速缓冲存储器(例如,数据高速缓存512)来对数据进行高速缓存以用于经由数据端口的存储器访问。

90.在一个实施例中,执行逻辑500还可包括光线追踪器505,所述光线追踪器505可提供光线追踪加速功能性。光线追踪器505可支持包括用于光线生成的指令/功能的光线追踪指令集。该光线追踪指令集可与由图2c中的光线追踪核245支持的光线追踪指令集类似或不同。

91.图5b图示了根据实施例的执行单元508的示例性内部细节。图形执行单元508可包括指令提取单元537、通用寄存器堆阵列(grf)524、架构寄存器堆阵列(arf)526、线程仲裁器522、发送单元530、分支单元532、simd浮点单元(fpu)534的集合以及在一个实施例中专用整数simd alu 535的集合。grf 524和arf 526包括与可在图形执行单元508中活动的每个同时硬件线程相关联的通用寄存器堆和架构寄存器堆的集合。在一个实施例中,在arf 526中维持每线程架构状态,而在线程执行期间使用的数据被存储在grf 524中。每个线程的执行状态(包括用于每个线程的指令指针)可被保持在arf 526中的线程特定寄存器中。

92.在一个实施例中,图形执行单元508具有下述架构:该架构是同时多线程(smt)和细粒度交错多线程(imt)的组合。该架构具有模块化配置,其可在设计时基于每执行单元的寄存器的数量和同时线程的目标数量而微调,其中执行单元资源跨用于执行多个同时线程的逻辑而被划分。可由图形执行单元508执行的逻辑线程的数量不限于硬件线程的数量,并且多个逻辑线程可被指派到每个硬件线程。

93.在一个实施例中,图形执行单元508可共同发布多个指令,所述多个指令各自可以是不同的指令。图形执行单元线程508的线程仲裁器522可将指令分派到发送单元530、分支单元532或(一个或多个)simd fpu 534中的一个以用于执行。每个执行线程可访问grf 524内的128个通用寄存器,其中每个寄存器可存储32个字节,其可作为32位数据元素的simd 8元素向量而访问。在一个实施例中,每个执行单元线程可访问grf 524内的4千字节,尽管实施例不限于此,并且在其他实施例中可提供更多或更少的寄存器资源。在一个实施例中,图形执行单元508被分区成可独立执行计算操作的七个硬件线程,尽管每执行单元的线程的数量还可根据实施例而变化。例如,在一个实施例中,支持多达16个硬件线程。在其中七个

线程可访问4千字节的实施例中,grf 524可存储总共28千字节。在16个线程可访问4千字节的情况下,grf 524可存储总共64千字节。灵活的寻址模式可允许对寄存器一起进行寻址以有效地构建更宽的寄存器或者表示跨步矩形块数据结构(strided rectangular block data structure)。

94.在一个实施例中,经由通过消息传递发送单元530执行的“发送”指令来分派存储器操作、采样器操作和其他较长时延系统通信。在一个实施例中,将分支指令分派到专用分支单元532以促进simd发散和最终收敛。

95.在一个实施例中,图形执行单元508包括一个或多个simd浮点单元((一个或多个)fpu)534以执行浮点运算。在一个实施例中,(一个或多个)fpu 534还支持整数计算。在一个实例中,(一个或多个)fpu 534可simd执行多达m数量的32位浮点(或整数)运算,或者simd执行多达2m个16位整数或16位浮点运算。在一个实施例中,(一个或多个)fpu中的至少一个提供扩展的数学能力以支持高吞吐量超越数学函数和双精度54位浮点。在一些实施例中,还存在8位整数simd alu 535的集合,并且8位整数simd alu 535的集合可被特别地优化以执行与机器学习计算相关联的操作。

96.在一个实施例中,图形执行单元508的多个实例的阵列可在图形子核分组(例如,子切片)中被实例化。为了可缩放性,产品架构师可选定每子核分组的执行单元的确切数量。在一个实施例中,执行单元508可跨多个执行通道执行指令。在另一实施例中,在图形执行单元508上执行的每个线程是在不同的通道上执行的。

97.图6图示了根据实施例的另外的执行单元600。执行单元600可以是用于在例如如图3c中的计算引擎贴片340a-340d中使用的计算优化的执行单元,但不限于此。执行单元600的变型还可被用在如图3b中的图形引擎贴片310a-310d中。在一个实施例中,执行单元600包括线程控制单元601、线程状态单元602、指令提取/预提取单元603和指令解码单元604。执行单元600另外包括寄存器堆606,所述寄存器堆606存储可被指派到执行单元内的硬件线程的寄存器。执行单元600另外包括发送单元607和分支单元608。在一个实施例中,发送单元607和分支单元608可与图5b的图形执行单元508的发送单元530和分支单元532类似地操作。

98.执行单元600还包括计算单元610,所述计算单元610包括多个不同类型的功能单元。在一个实施例中,计算单元610包括alu单元611,所述alu单元611包括算术逻辑单元的阵列。alu单元611可被配置成执行64位、32位和16位整数和浮点运算。整数和浮点运算可同时被执行。计算单元610还可包括脉动阵列612和数学单元613。脉动阵列612包括可用于以脉动方式执行向量或其他数据并行操作的数据处理单元的宽度w和深度d的网络。在一个实施例中,脉动阵列612可被配置成执行矩阵运算,诸如矩阵点积运算。在一个实施例中,脉动阵列612支持16位浮点运算以及8位和4位整数运算。在一个实施例中,脉动阵列612可被配置成加速机器学习操作。在此类实施例中,脉动阵列612可被配置有对bfloat16(16位浮点格式)的支持。在一个实施例中,可包括数学单元613来以高效且比alu单元611更低功率的方式执行数学运算的特定子集。数学单元613可包括在由其他实施例提供的图形处理引擎的共享功能逻辑中找到的数学逻辑的变型(例如,图4的共享功能逻辑420的数学逻辑422)。在一个实施例中,数学单元613可被配置成执行32位和64位浮点运算。

99.线程控制单元601包括用于控制执行单元内线程的执行的逻辑。线程控制单元601

可包括用于开始、停止和抢占执行单元600内线程的执行的线程仲裁逻辑。线程状态单元602可用于为被指派以在执行单元600上执行的线程存储线程状态。在执行单元600内存储线程状态实现在线程变为阻塞或空闲时那些线程的快速抢占。指令提取/预提取单元603可从更高级别执行逻辑的指令高速缓存(例如,如图5a中的指令高速缓存506)提取指令。指令提取/预提取单元603还可基于当前执行的线程的分析来发布对要被加载到指令高速缓存中的指令的预提取请求。指令解码单元604可被用于解码要由计算单元执行的指令。在一个实施例中,指令解码单元604可被用作次级解码器以将复杂指令解码成组成的微操作。

100.执行单元600另外包括可由在执行单元600上执行的硬件线程使用的寄存器堆606。可跨用于执行执行单元600的计算单元610内的多个同时线程的逻辑而划分寄存器堆606中的寄存器。可由图形执行单元600执行的逻辑线程的数量不限于硬件线程的数量,并且多个逻辑线程可被指派到每个硬件线程。寄存器堆606的大小可基于支持的硬件线程的数量跨实施例而变化。在一个实施例中,寄存器重命名可被用于动态地将寄存器分配到硬件线程。

101.图7是图示了根据一些实施例的图形处理器指令格式700的框图。在一个或多个实施例中,图形处理器执行单元支持具有采用多种格式的指令的指令集。实线框示出了一般被包括在执行单元指令中的组成部分,而虚线包括可选的或者仅被包括在指令的子集中的组成部分。在一些实施例中,描述和图示的指令格式700是宏指令,因为它们是供应给执行单元的指令,而与一旦指令被处理由指令解码产生的微操作相反。

102.在一些实施例中,图形处理器执行单元本机地支持采用128位指令格式710的指令。基于所选择的指令、指令选项和操作数的数量,64位压缩指令格式730可用于一些指令。本机128位指令格式710提供对所有指令选项的访问,而采用64位格式730,一些选项和操作被限制。采用64位格式730的可用的本机指令随实施例而变化。在一些实施例中,使用索引字段713中索引值的集合来部分地压缩指令。执行单元硬件基于索引值来引用压缩表的集合,并且使用压缩表输出来重构采用128位指令格式710的本机指令。可使用指令的其他大小和格式。

103.对于每种格式,指令操作码712定义执行单元要执行的操作。执行单元跨每个操作数的多个数据元素并行执行每个指令。例如,响应于相加指令,执行单元跨表示纹理元素或图片元素的每个颜色通道来执行同时加法运算。默认情况下,执行单元跨操作数的所有数据通道来执行每个指令。在一些实施例中,指令控制字段714实现对诸如通道选择(例如,断定(predication))和数据通道次序(例如,搅混(swizzle))之类的某些执行选项的控制。对于采用128位指令格式710的指令,执行大小字段716限制将被并行执行的数据通道的数量。在一些实施例中,执行大小字段716不可供64位压缩指令格式730中使用。

104.一些执行单元指令具有多达三个操作数,所述三个操作数包括两个源操作数src0 720、src1 722和一个目的地718。在一些实施例中,执行单元支持双目的地指令,其中目的地中的一个是隐含的。数据操纵指令可具有第三源操作数(例如,src2 724),其中指令操作码712确定源操作数的数量。指令的最后源操作数可以是利用指令传递的立即(例如,硬编码的)值。

105.在一些实施例中,128位指令格式710包括访问/地址模式字段726,该访问/地址模式字段726指定例如使用直接寄存器寻址模式还是间接寄存器寻址模式。在使用直接寄存

器寻址模式时,由指令中的位来直接提供一个或多个操作数的寄存器地址。

106.在一些实施例中,128位指令格式710还包括访问/地址模式字段726,该访问/地址模式字段726指定指令的地址模式和/或访问模式。在一个实施例中,访问模式被用于定义指令的数据访问对齐。一些实施例支持包括16字节对齐的访问模式和1字节对齐的访问模式的访问模式,其中访问模式的字节对齐确定指令操作数的访问对齐。例如,当处于第一模式中时,指令可将字节对齐的寻址用于源操作数和目的地操作数,并且当处于第二模式中时,指令可将16字节对齐的寻址用于所有源操作数和目的地操作数。

107.在一个实施例中,访问/地址模式字段726的地址模式部分确定指令要使用直接寻址还是间接寻址。在使用直接寄存器寻址模式时,指令中的位直接提供一个或多个操作数的寄存器地址。在使用间接寄存器寻址模式时,可基于指令中的地址立即字段和地址寄存器值来计算一个或多个操作数的寄存器地址。

108.在一些实施例中中,基于操作码712位字段来对指令进行分组,以简化操作码解码740。对于8位操作码,4、5和6位允许执行单元确定操作码的类型。所示出的精确操作码分组仅是示例。在一些实施例中,移动和逻辑操作码群组742包括数据移动和逻辑指令(例如,移动(mov)、比较(cmp))。在一些实施例中,移动和逻辑群组742共享五个最高有效位(msb),其中移动(mov)指令采用0000xxxxb的形式,并且逻辑指令采用0001xxxxb的形式。流控制指令群组744(例如调用、跳(jmp))包括采用0010xxxxb(例如,0x20)形式的指令。杂项指令群组746包括指令的混合,包括采用0011xxxxb(例如,0x30)形式的同步指令(例如等待、发送)。并行数学指令群组748包括采用0100xxxxb(例如,0x40)的形式的逐组成部分的算术指令(例如,加、乘(mul))。并行数学群组748跨数据通道并行执行算术运算。向量数学群组750包括采用0101xxxxb(例如,0x50)形式的算术指令(例如,dp4)。向量数学群组对向量操作数执行诸如点积计算的算术。示出的操作码解码740在一个实施例中可用于确定执行单元的哪个部分将被用于执行解码的指令。例如,一些指令可被定名为将由脉动阵列执行的脉动指令。诸如光线追踪指令(未示出)的其他指令可被路由到执行逻辑的切片或分区内的光线追踪核或光线追踪逻辑。

109.图形流水线图8是图形处理器800的另一实施例的框图。图8的与本文中任何其他图的元件具有相同附图标记(或名称)的元件可以以与本文其他地方描述的元件类似的任何方式操作或起作用,但不限于此。

110.在一些实施例中,图形处理器800包括几何流水线820、媒体流水线830、显示引擎840、线程执行逻辑850和渲染输出流水线870。在一些实施例中,图形处理器800是包括一个或多个通用处理核的多核处理系统内的图形处理器。通过对一个或多个控制寄存器(未示出)的寄存器写入或者经由通过环形互连802发布至图形处理器800的命令来控制图形处理器。在一些示例实施例中,环形互连802将图形处理器800耦合到其他处理组件,诸如其他图形处理器或通用处理器。来自环形互连802的命令由命令流播器803解译,该命令流播器803将指令供应至几何流水线820或媒体流水线830的各个组件。

111.在一些实施例中,命令流播器803指导顶点提取器805的操作,该顶点提取器805从存储器读取顶点数据,并执行由命令流播器803提供的顶点处理命令。在一些实施例中,顶点提取器805将顶点数据提供给顶点着色器807,该顶点着色器807对每个顶点执行坐标空

间变换和照明操作。在一些示例中,顶点提取器805和顶点着色器807通过经由线程分派器831向执行单元852a-852b分派执行线程来执行顶点处理指令。

112.在一些实施例中,执行单元852a-852b是具有用于执行图形和媒体操作的指令集的向量处理器的阵列。在一些实施例中,执行单元852a-852b具有附连的l1高速缓存851,所述l1高速缓存2151对于每个阵列是特定的,或者在阵列之间被共享。高速缓存能被配置为数据高速缓存、指令高速缓存或被分区以在不同分区中包含数据和指令的单个高速缓存。

113.在一些实施例中,几何流水线820包括曲面细分组件以执行3d对象的硬件加速的曲面细分。在一些实施例中,可编程外壳着色器811配置曲面细分操作。可编程域着色器817提供曲面细分输出的后端评估。曲面细分器813在外壳着色器811的指导下进行操作,并且包含专用逻辑以基于作为到几何流水线820的输入而提供的粗略几何模型来生成详细的几何对象的集合。在一些实施例中,如果未使用曲面细分,则可绕过曲面细分组件(例如,外壳着色器811、曲面细分器813和域着色器817)。

114.在一些实施例中,完整几何对象可由几何着色器819经由分派到执行单元852a-852b的一个或多个线程来处理,或者可直接行进至裁剪器(clipper)829。在一些实施例中,几何着色器对整个几何对象进行操作,而不是如在图形流水线的先前阶段中对顶点或顶点的补片(patch)进行操作。如果曲面细分被禁用,则几何着色器819接收来自顶点着色器807的输入。在一些实施例中,几何着色器819由几何着色器程序可编程以在曲面细分单元被禁用时执行几何曲面细分。

115.在光栅化前,裁剪器829处理顶点数据。裁剪器829可以是具有裁剪和几何着色器功能的可编程裁剪器或固定功能裁剪器。在一些实施例中,渲染输出流水线870中的光栅化器和深度测试组件873分派像素着色器以将几何对象转换成逐像素表示。在一些实施例中,像素着色器逻辑被包括在线程执行逻辑850中。在一些实施例中,应用可绕过光栅化器和深度测试组件873,并且经由流出单元823访问未光栅化的顶点数据。

116.图形处理器800具有允许数据和消息在处理器的主要组件之间传递的互连总线、互连组构或某种其他互连机构。在一些实施例中,执行单元852a-852b和关联的逻辑单元(例如,l1高速缓存851、采样器854、纹理高速缓存858等)经由数据端口856互连,以执行存储器访问并且与处理器的渲染输出流水线组件进行通信。在一些实施例中,采样器854、高速缓存851、858和执行单元852a-852b各自具有单独的存储器访问路径。在一个实施例中,纹理高速缓存858还可被配置为采样器高速缓存。

117.在一些实施例中,渲染输出流水线870包含光栅化器和深度测试组件873,该光栅化器和深度测试组件873将基于顶点的对象转换成关联的基于像素的表示。在一些实施例中,光栅化器逻辑包括用于执行固定功能三角形和线光栅化的窗口化器(windower)/掩蔽器单元。关联的渲染高速缓存878和深度高速缓存879在一些实施例中也是可用的。像素操作组件877对数据执行基于像素的操作,尽管在一些实例中,与2d操作相关联的像素操作(例如,带有混合(blending)的位块图像传送)由2d引擎841执行,或者在显示时由显示控制器843使用覆盖显示平面代替。在一些实施例中,共享l3高速缓存875对于全部图形组件是可用的,从而允许在不使用主系统存储器的情况下共享数据。

118.在一些实施例中,图形处理器媒体流水线830包括媒体引擎837和视频前端834。在一些实施例中,视频前端834接收来自命令流播器803的流水线命令。在一些实施例中,媒体

流水线830包括单独的命令流播器。在一些实施例中,视频前端834在将命令发送至媒体引擎837之前处理媒体命令。在一些实施例中,媒体引擎837包括线程派生功能性来派生线程,以便经由线程分派器831分派到线程执行逻辑850。

119.在一些实施例中,图形处理器800包括显示引擎840。在一些实施例中,显示引擎840处于处理器800的外部,且经由环形互连802或某一其他互连总线或组构与图形处理器耦合。在一些实施例中,显示引擎840包括2d引擎841和显示控制器843。在一些实施例中,显示引擎840包含能独立于3d流水线操作的专用逻辑。在一些实施例中,显示控制器843与显示设备(未示出)耦合,该显示设备可以是系统集成的显示设备(如在膝上型计算机中),或者可以是经由显示设备连接器附连的外部显示设备。

120.在一些实施例中,几何流水线820和媒体流水线830可配置成基于多个图形和媒体编程接口执行操作,并且不特定于任何一个应用编程接口(api)。在一些实施例中,用于图形处理器的驱动器软件将特定于特定图形或媒体库的api调用转化成可由图形处理器处理的命令。在一些实施例中,为全部来自khronos group的开放图形库(opengl)、开放计算语言(opencl)和/或vulkan图形和计算api提供支持。在一些实施例中,还可为来自微软公司的direct3d库提供支持。在一些实施例中,可支持这些库的组合。还可为开源计算机视觉库(opencv)提供支持。如果可进行从未来api的流水线到图形处理器的流水线的映射,则具有兼容3d流水线的未来api也将被支持。

121.图形流水线编程图9a是图示了根据一些实施例的图形处理器命令格式900的框图。图9b是图示了根据实施例的图形处理器命令序列910的框图。图9a中的实线框图示了一般被包括在图形命令中的组成部分,而虚线包括可选的或者仅被包括在图形命令的子集中的组成部分。图9a的示例性图形处理器命令格式900包括用于标识命令的客户端902、命令操作代码(操作码)904和数据906的数据字段。在一些命令中还包括子操作码905和命令大小908。

122.在一些实施例中,客户端902指定处理命令数据的图形设备的客户端单元。在一些实施例中,图形处理器命令解析器检查每个命令的客户端字段以调节命令的进一步处理,并且将命令数据路由到适当的客户端单元。在一些实施例中,图形处理器客户端单元包括存储器接口单元、渲染单元、2d单元、3d单元和媒体单元。每个客户端单元具有处理命令的对应处理流水线。一旦由客户端单元接收到命令,客户端单元便读取操作码904和子操作码905(如果子操作码905存在的话),以确定要执行的操作。客户端单元使用数据字段906中的信息来执行命令。对于一些命令,预期显式命令大小908来指定命令的大小。在一些实施例中,命令解析器基于命令操作码来自动确定至少一些命令的大小。在一些实施例中,经由双字的倍数来对齐命令。可使用其他命令格式。

123.图9b中的流程图示了示例性图形处理器命令序列910。在一些实施例中,以图形处理器的实施例为特征的数据处理系统的软件或固件使用所示出的命令序列的版本来设定、执行和终止图形操作的集合。仅出于示例的目的示出并描述了样本命令序列,这是由于实施例不限于这些特定命令或此命令序列。另外,命令可作为命令序列中的批量命令被发布,使得图形处理器将至少部分并发地处理命令的序列。

124.在一些实施例中,图形处理器命令序列910可以以流水线转储清除命令912开始,以促使任何活动的图形流水线完成该流水线的当前未决命令。在一些实施例中,3d流水线

922和媒体流水线924不并发地操作。执行流水线转储清除以促使活动的图形流水线完成任何未决命令。响应于流水线转储清除,图形处理器的命令解析器将暂停命令处理,直至活动的绘图引擎完成未决操作并且相关的读取高速缓存失效。可选地,可将渲染高速缓存中标记为“脏”的任何数据转储清除到存储器。在一些实施例中,流水线转储清除命令912可被用于流水线同步,或者在将图形处理器置于低功率状态前被使用。

125.在一些实施例中,在命令序列要求图形处理器在流水线之间显式地切换时,使用流水线选择命令913。在一些实施例中,除非上下文要为两个流水线发布命令,在发布流水线命令前,在执行上下文内仅要求一次流水线选择命令913。在一些实施例中,紧接经由流水线选择命令913的流水线切换之前,要求流水线转储清除命令912。

126.在一些实施例中,流水线控制命令914配置图形流水线以用于操作,且被用于对3d流水线922和媒体流水线924进行编程。在一些实施例中,流水线控制命令914配置活动的流水线的流水线状态。在一个实施例中,流水线控制命令914被用于流水线同步,并且在处理一批命令前从活动的流水线内的一个或多个高速缓冲存储器中清除数据。

127.在一些实施例中,返回缓冲器状态命令916被用于为相应流水线配置返回缓冲器的集合以写入数据。一些流水线操作要求分配、选择或配置一个或多个返回缓冲器,在处理期间这些操作将中间数据写入到所述一个或多个返回缓冲器。在一些实施例中,图形处理器还使用一个或多个返回缓冲器来存储输出数据并且执行跨线程通信。在一些实施例中,返回缓冲器状态916包括选择要用于流水线操作的集合的返回缓冲器的大小和数量。

128.命令序列中的剩余命令基于用于操作的活动流水线而不同。基于流水线确定920,将命令序列定制到以3d流水线状态930开始的3d流水线922或者从媒体流水线状态940开始的媒体流水线924。

129.用于配置3d流水线状态930的命令包括3d状态设置命令,所述3d状态设置命令用于在处理3d图元命令之前要配置的顶点缓冲器状态、顶点元素状态、恒定颜色状态、深度缓冲器状态以及其他状态变量。至少部分基于使用中的特定3d api来确定这些命令的值。在一些实施例中,如果将不使用某些流水线元件,则3d流水线状态930命令还能够选择性地禁用或绕过那些元件。

130.在一些实施例中,3d图元932命令被用于提交要由3d流水线处理的3d图元。经由3d图元932命令传递到图形处理器的命令和相关联的参数被转发到图形流水线中的顶点提取功能。顶点提取功能使用3d图元932命令数据来生成顶点数据结构。顶点数据结构被存储在一个或多个返回缓冲器中。在一些实施例中,3d图元932命令被用于经由顶点着色器对3d图元执行顶点操作。为了处理顶点着色器,3d流水线922将着色器执行线程分派到图形处理器执行单元。

131.在一些实施例中,经由执行934命令或事件来触发3d流水线922。在一些实施例中,寄存器写入触发命令执行。在一些实施例中,经由命令序列中的“go”或“kick”命令来触发执行。在一个实施例中,使用流水线同步命令来触发命令执行以转储清除通过图形流水线的命令序列。3d流水线将执行3d图元的几何处理。一旦操作完成,所得到的几何对象便被光栅化,并且像素引擎对所得到的像素进行上色。对于那些操作,还可包括用于控制像素着色和像素后端操作的另外的命令。

132.在一些实施例中,在执行媒体操作时,图形处理器命令序列910沿着媒体流水线

924路径。一般而言,用于媒体流水线924的编程的特定使用和方式取决于要执行的媒体或计算操作。可在媒体解码期间将特定媒体解码操作卸载到媒体流水线。在一些实施例中,还可绕过媒体流水线,并且可使用由一个或多个通用处理核提供的资源来全部或部分地执行媒体解码。在一个实施例中,媒体流水线还包括用于通用图形处理器单元(gpgpu)操作的元件,其中图形处理器被用于使用计算着色器程序来执行simd向量运算,所述计算着色器程序与图形图元的渲染不是显式相关的。

133.在一些实施例中,以与3d流水线922类似的方式对媒体流水线924进行配置。将用于配置媒体流水线状态940的命令的集合分派或放置到在媒体对象命令942之前的命令队列中。在一些实施例中,用于媒体流水线状态940的命令包括用于配置媒体流水线元件的数据,所述媒体流水线元件将被用于处理媒体对象。这包括用于配置媒体流水线内的视频解码和视频编码逻辑的数据,诸如编码和解码格式。在一些实施例中,用于媒体流水线状态940的命令还支持使用到包含一批状态设置的“间接”状态元素的一个或多个指针。

134.在一些实施例中,媒体对象命令942将指针供应到媒体对象以便由媒体流水线处理。媒体对象包括存储器缓冲器,所述存储器缓冲器包含要处理的视频数据。在一些实施例中,在发布媒体对象命令942之前,所有媒体流水线状态必须是有效的。一旦配置了流水线状态并且将媒体对象命令942排队,就经由执行命令944或等效执行事件(例如,寄存器写入)来触发媒体流水线924。然后可通过由3d流水线922或媒体流水线924提供的操作对来自媒体流水线924的输出进行后处理。在一些实施例中,以与媒体操作类似的方式配置和执行gpgpu操作。

135.图形软件架构图10图示了根据一些实施例的用于数据处理系统1000的示例性图形软件架构。在一些实施例中,软件架构包括3d图形应用1010、操作系统1020和至少一个处理器1030。在一些实施例中,处理器1030包括图形处理器1032和一个或多个通用处理器核1034。图形应用1010和操作系统1020各自在数据处理系统的系统存储器1050中执行。

136.在一些实施例中,3d图形应用1010包含一个或多个着色器程序,该一个或多个着色器程序包括着色器指令1012。着色器语言指令可采用高级着色器语言,诸如direct3d的高级着色器语言(hlsl)或opengl着色器语言(glsl)等等。应用还包括采用适合由通用处理器核1034执行的机器语言的可执行指令1014。应用还包括由顶点数据定义的图形对象1016。

137.在一些实施例中,操作系统1020是来自微软公司的microsoft

®ꢀ

windows

®

操作系统、专有的类unix操作系统或使用linux内核的变型的开源类unix操作系统。操作系统1020可支持图形api 1022,诸如direct3d api、opengl api或vulkan api。当direct3d api在使用中时,操作系统1020使用前端着色器编译器1024来将采用hlsl的任何着色器指令1012编译成更低级着色器语言。编译可以是即时(jit)编译或者应用可执行着色器预编译。在一些实施例中,在3d图形应用1010的编译期间将高级着色器编译成低级着色器。在一些实施例中,以中间形式(诸如,由vulkan api使用的标准可移植中间表示(spir)的版本)提供着色器指令1012。

138.在一些实施例中,用户模式图形驱动器1026包含用于将着色器指令1012转换成硬件特定表示的后端着色器编译器xxxx。当opengl api在使用中时,将采用glsl高级语言的

着色器指令1012传递到用户模式图形驱动器1026以用于编译。在一些实施例中,用户模式图形驱动器1026使用操作系统内核模式功能1028来与内核模式图形驱动器1029通信。在一些实施例中,内核模式图形驱动器1029与图形处理器1032通信以分派命令和指令。

139.ip核实现至少一个实施例的一个或多个方面可由存储在机器可读介质上的代表性代码来实现,该代表性代码表示和/或定义诸如处理器的集成电路内的逻辑。例如,机器可读介质可包括表示处理器内的各种逻辑的指令。在由机器读取时,指令可促使机器制作逻辑以执行本文描述的技术。称为“ip核”的此类表示是用于集成电路的逻辑的可重复使用单元,该可重复使用单元可作为对集成电路的结构进行描述的硬件模型而被存储在有形机器可读介质上。可将硬件模型供应至各种客户或制造设施,所述客户或制造设施将硬件模型加载在制造集成电路的制作机器上。可制作集成电路,使得电路执行与本文描述的实施例中的任何实施例相关联的所描述的操作。

140.图11a是示出根据实施例的可被用于制造集成电路以执行操作的ip核开发系统1100的框图。ip核开发系统1100可被用于生成可被并入到更大的设计中或被用于构造完整集成电路(例如,soc集成电路)的模块化、可重复使用设计。设计设施1130可生成采用高级编程语言(例如,c/c )的ip核设计的软件仿真1110。软件仿真1110可被用于使用仿真模型1112来设计、测试和验证ip核的行为。仿真模型1112可包括功能、行为和/或时序仿真。然后可从仿真模型1112创建或合成寄存器传送级(rtl)设计1115。rtl设计1115是对硬件寄存器之间的数字信号流进行建模的集成电路的行为的抽象,包括使用建模的数字信号执行的相关联的逻辑。除rtl设计1115外,还可创建、设计或合成处于逻辑级或晶体管级的较低级设计。因此,初始设计和仿真的特定细节可变化。

141.可由设计设施将rtl设计1115或等效物进一步合成为硬件模型1120,该硬件模型1120可采用硬件描述语言(hdl)或物理设计数据的某种其他表示。可进一步对hdl进行仿真或测试以验证ip核设计。可使用非易失性存储器1140(例如,硬盘、闪速存储器或任何非易失性存储介质)来存储ip核设计以用于递送到第三方制作设施1165。备选的是,可通过有线连接1150或无线连接1160(例如,经由因特网)来传送ip核设计。制作设施1165然后可制作至少部分基于ip核设计的集成电路。制作的集成电路可被配置成执行根据本文描述的至少一个实施例的操作。

142.图11b图示了根据本文描述的一些实施例的集成电路封装组装件1170的截面侧视图。集成电路封装组装件1170图示了如本文描述的一个或多个处理器或加速器设备的实现。封装组装件1170包括连接到衬底1180的硬件逻辑1172、1174的多个单元。逻辑1172、1174可至少部分地以可配置逻辑或固定功能性逻辑硬件实现,并且可包括本文描述的(一个或多个)处理器核、(一个或多个)图形处理器或其他加速器设备中的任何设备的一个或多个部分。逻辑1172、1174的每个单元可在半导体管芯内被实现,并且经由互连结构1173与衬底1180耦合。互连结构1173可被配置成在逻辑1172、1174与衬底1180之间路由电信号,并且可包括互连,该互连诸如但不限于凸块(bump)或柱。在一些实施例中,互连结构1173可被配置成路由电信号,诸如,例如与逻辑1172、1174的操作相关联的输入/输出(i/o)信号和/或功率或接地信号。在一些实施例中,衬底1180可以是环氧基层压衬底。衬底1180可在其他实施例中包括其他合适类型的衬底。封装组装件1170可经由封装互连1183被连接到其他电

气设备。封装互连1183可被耦合到衬底1180的表面,以将电信号路由到其他电气设备,诸如主板、其他芯片组或多芯片模块。

143.在一些实施例中,逻辑1172、1174的单元与桥1182电耦合,该桥1182被配置成在逻辑1172、1174之间路由电信号。桥1182可以是为电信号提供路线(route)的密集互连结构。桥1182可包括由玻璃或合适的半导体材料构成的桥衬底。可在桥衬底上形成电路由部件(electrical routing feature),以在逻辑1172、1174之间提供芯片到芯片连接。

144.尽管图示了逻辑1172、1174的两个单元和桥1182,但是本文描述的实施例可包括在一个或多个管芯上的更多或更少逻辑单元。由于当逻辑被包括在单个管芯上时可排除桥1182,因此可通过零个或多于零个桥来连接一个或多个管芯。备选的是,可通过一个或多个桥来连接多个管芯或逻辑单元。另外,在其他可能配置(包括三维配置)中可将多个逻辑单元、管芯和桥连接在一起。

145.图11c图示了包括连接到衬底1180(例如,基础管芯)的硬件逻辑小芯片的多个单元的封装组装件1190。如本文描述的图形处理单元、并行处理器和/或计算加速器可由单独制造的多样化的硅小芯片构成。在此上下文中,小芯片是至少部分封装的集成电路,其包括可与其他小芯片被组装到更大封装中的逻辑的不同单元。带有不同ip核逻辑的小芯片的多样化集合可被组装到单个设备中。另外,可使用有源中介层(interposer)技术将小芯片集成到基础管芯或基础小芯片中。本文描述的概念能够实现gpu内的不同形式的ip之间的互连和通信。可使用不同工艺技术来制造并且在制造期间构成ip核,这避免了将多个ip(特别是在带有若干特点(flavors)ip的大的soc上)汇聚到相同制造工艺的复杂性。实现多个工艺技术的使用改进了推向市场的时间,并且提供了创建多个产品sku的有成本效益的方式。另外,解聚的ip更易于独立地被功率选通,在给定工作负载上不在使用中的组件可被断电,从而降低总体功率消耗。

146.硬件逻辑小芯片可包括专用硬件逻辑小芯片1172、逻辑或i/o小芯片1174和/或存储器小芯片1175。硬件逻辑小芯片1172和逻辑或i/o小芯片1174可至少部分地用可配置逻辑或固定功能性逻辑硬件实现,并且可包括(一个或多个)处理器核、(一个或多个)图形处理器、并行处理器或本文描述的其他加速器设备中的任何的一个或多个部分。存储器小芯片1175可以是dram(例如,gddr、hbm)存储器或高速缓冲(sram)存储器。

147.每个小芯片可被制作为单独的半导体管芯,并且经由互连结构1173与衬底1180耦合。互连结构1173可被配置成在各种小芯片与衬底1180内的逻辑之间路由电信号。互连结构1173可包括互连,诸如但不限于凸块或柱。在一些实施例中,互连结构1173可被配置成路由电信号,诸如,例如与逻辑、i/o和存储器小芯片的操作相关联的输入/输出(i/o)信号和/或功率或接地信号。

148.在一些实施例中,衬底1180是环氧基层压衬底。衬底1180可在其他实施例中包括其他合适类型的衬底。封装组装件1190可经由封装互连1183连接到其他电气设备。封装互连1183可被耦合到衬底1180的表面,以将电信号路由到其他电气设备,诸如主板、其他芯片组或多芯片模块。

149.在一些实施例中,逻辑或i/o小芯片1174和存储器小芯片1175可经由桥1187电耦合,该桥1187被配置成在逻辑或i/o小芯片1174与存储器小芯片1175之间路由电信号。桥1187可以是为电信号提供路由的密集互连结构。桥1187可包括由玻璃或合适的半导体材料

构成的桥衬底。可在桥衬底上形成电路由部件,以在逻辑或i/o小芯片1174与存储器小芯片1175之间提供芯片到芯片连接。桥1187还可被称为硅桥或互连桥。例如,在一些实施例中,桥1187是嵌入式多管芯互连桥(emib)。在一些实施例中,桥1187可只是从一个小芯片到另一小芯片的直接连接。

150.衬底1180可包括用于i/o 1191、高速缓冲存储器1192和其他硬件逻辑1193的硬件组件。组构1185可被嵌入在衬底1180中以能够实现在各种逻辑小芯片与衬底1180内的逻辑1191、1193之间的通信。在一个实施例中,i/o 1191、组构1185、高速缓存、桥和其他硬件逻辑1193可被集成到基础管芯中,该基础管芯被层叠在衬底1180顶上。

151.在各种实施例中,封装组装件1190可包括由组构1185或一个或多个桥1187互连的更少或更多数量的组件和小芯片。封装组装件1190内的小芯片可按在3d或2.5d布置来进行布置。一般而言,桥结构1187可被用于促进在例如逻辑或i/o小芯片与存储器小芯片之间的点到点互连。组构1185可被用于将各种逻辑和/或i/o小芯片(例如,小芯片1172、1174、1191、1193)与其他逻辑和/或i/o小芯片互连。在一个实施例中,衬底内的高速缓冲存储器1192可充当用于封装组装件1190的全局高速缓存、分布式全局高速缓存的一部分或者充当用于组构1185的专用高速缓存。

152.图11d图示了根据实施例的包括可互换小芯片1195的封装组装件1194。可互换小芯片1195可被组装到一个或多个基础小芯片1196、1198上的标准化槽中。基础小芯片1196、1198可经由桥互连1197被耦合,该桥互连1197可类似于本文描述的其他桥互连,并且可例如是emib。存储器小芯片还可经由桥互连被连接到逻辑或i/o小芯片。i/o和逻辑小芯片可经由互连组构通信。基础小芯片可各自支持采用标准化格式的一个或多个槽以用于逻辑或i/o或存储器/高速缓存中的一个。

153.在一个实施例中,可将sram和功率递送电路制作到基础小芯片1196、1198中的一个或多个基础小芯片中,所述基础小芯片1196、1198可使用相对于堆叠在基础小芯片顶上的可互换小芯片1195不同的工艺技术而被制作。例如,可使用更大的工艺技术来制作基础小芯片1196、1198,而可使用更小的工艺技术来制作可互换小芯片。可互换小芯片1195中的一个或多个可互换小芯片可以是存储器(例如,dram)小芯片。可基于针对使用封装组装件1194的产品的功率和/或性能,为封装组装件1194选择不同存储器密度。另外,可基于针对产品的功率和/或性能,在组装时选择带有不同数量的类型的功能单元的逻辑小芯片。另外,可将包含不同类型的ip逻辑核的小芯片插入到可互换小芯片槽中,能够实现可混合并匹配不同技术ip块的混合处理器设计。

154.示例性片上系统集成电路图12-13图示了根据本文描述的各种实施例的可使用一个或多个ip核而制作的示例性集成电路以及相关联的图形处理器。除了所示出的内容外,还可包括其他逻辑和电路,包括另外的图形处理器/核、外设接口控制器或通用处理器核。

155.图12是图示了根据实施例的可使用一个或多个ip核而制作的示例性片上系统集成电路1200的框图。示例性集成电路1200包括一个或多个应用处理器1205(例如,cpu)、至少一个图形处理器1210,且可另外包括图像处理器1215和/或视频处理器1220,以上处理器中的任何处理器可以是来自相同或多个不同设计设施的模块化ip核。集成电路1200包括外设或总线逻辑,所述外设或总线逻辑包括usb控制器1225、uart控制器1230、spi/sdio控制

器1235和i2s/i2c控制器1240。另外,集成电路可包括耦合到高清晰度多媒体接口(hdmi)控制器1250和移动工业处理器接口(mipi)显示接口1255中的一个或多个的显示设备1245。可通过包括闪速存储器和闪速存储器控制器的闪速存储器子系统1260来提供存储。可经由存储器控制器1265提供存储器接口以便访问sdram或sram存储器设备。一些集成电路另外包括嵌入式安全引擎1270。

156.图13-14是图示了根据本文描述的实施例的供soc内使用的示例性图形处理器的框图。图13图示了根据实施例的可使用一个或多个ip核而制作的片上系统集成电路的示例性图形处理器1310。图14图示了根据实施例的可使用一个或多个ip核而制作的片上系统集成电路的另外的示例性图形处理器1340。图13的图形处理器1310是低功率图形处理器核的示例。图14的图形处理器1340是更高性能图形处理器核的示例。图形处理器1310、1340中的每个图形处理器可以是图12的图形处理器1210的变型。

157.如图13中所示,图形处理器1310包括顶点处理器1305和一个或多个片段处理器1315a-1315n(例如,1315a、1315b、1315c、1315d到1315n-1和1315n)。图形处理器1310可经由单独的逻辑执行不同着色器程序,使得顶点处理器1305被优化以执行用于顶点着色器程序的操作,而一个或多个片段处理器1315a-1315n执行用于片段或像素着色器程序的片段(例如,像素)着色操作。顶点处理器1305执行3d图形流水线的顶点处理阶段,并且生成图元和顶点数据。(一个或多个)片段处理器1315a-1315n使用由顶点处理器1305生成的图元和顶点数据来产生在显示设备上显示的帧缓冲(framebuffer)。在一个实施例中,(一个或多个)片段处理器1315a-1315n被优化以执行如opengl api中提供的片段着色器程序,所述片段着色器程序可被用于执行与如针对在direct 3d api中提供的像素着色器程序类似的操作。

158.图形处理器1310另外包括一个或多个存储器管理单元(mmu)1320a-1320b、(一个或多个)高速缓存1325a-1325b和(一个或多个)电路互连1330a-1330b。一个或多个mmu 1320a-1320b为图形处理器1310(包括为顶点处理器1305和/或(一个或多个)片段处理器1315a-1315n)提供虚拟地址到物理地址映射,这些处理器除了引用在一个或多个高速缓存1325a-1325b中存储的顶点或图像/纹理数据之外还可引用在存储器中存储的顶点或图像/纹理数据。在一个实施例中,一个或多个mmu 1320a-1320b可与系统内的其他mmu同步,所述其他mmu包括与图12的一个或多个应用处理器1205、图像处理器1215和/或视频处理器1220相关联的一个或多个mmu,使得每个处理器1205-1220可参与到共享或统一的虚拟存储器系统中。根据实施例,一个或多个电路互连1330a-1330b使得图形处理器1310能够经由soc的内部总线或者经由直接连接来与soc内的其他ip核通过接口连接。

159.如图14中所示,图形处理器1340包括图13的图形处理器1310的一个或多个mmu 1320a-1320b、(一个或多个)高速缓存1325a-1325b和(一个或多个)电路互连1330a-1330b。图形处理器1340包括提供统一着色器核架构的一个或多个着色器核1355a-1355n(例如,1455a、1355b、1355c、1355d、1355e、1355f到1355n-1和1355n),在该统一着色器核架构中单个核或类型或核可执行全部类型的可编程着色器代码,其包括用于实现顶点着色器、片段着色器和/或计算着色器的着色器程序代码。存在的着色器核的确切数量可在实施例和实现之间变化。另外,图形处理器1340包括核间任务管理器1345,该核间任务管理器1345充当用于将执行线程分派到一个或多个着色器核1355a-1355n的线程分派器;以及用于为基于

贴片的渲染加速拼贴操作的拼贴单元1358,在该基于贴片的渲染中,用于场景的渲染操作在图像空间中被细分,例如以利用场景内的局部空间相干性或优化内部高速缓存的使用。

160.具有机器学习的光线追踪如上所提及,光线追踪是图形处理技术,其中通过基于物理的渲染来仿真光传输。光线追踪中的关键操作之一是:处理可见性查询,其需要包围体层级(bvh)中的节点的遍历和交叉测试。

161.基于光线和路径追踪的技术通过下述操作来计算图像:追踪经过每个像素的光线和路径,并使用随机采样以计算高级效果,诸如阴影、光泽度、间接照明等。使用仅几个样本是快速的,但产生有噪图像,而使用许多样本产生高质量图像,但成本过高。

162.机器学习包括能够逐步地改进指定任务的性能或逐步地呈现更准确预测或决策的任何电路、程序代码或其组合。一些机器学习引擎可以执行这些任务或呈现这些预测/决策,而不显式地被编程成执行任务或呈现预测/决策。存在多种机器学习技术,包括(但不限于)受监督和半监督学习、无监督学习和强化学习。

163.在最近若干年中,对针对实时使用的光线/路径追踪的突破性解决方案已经以“去噪”的形式出现——使用图像处理技术以从有噪低样本计数输入产生高质量滤波/去噪图像的过程。最有效的去噪技术依赖于机器学习技术,其中机器学习引擎学习有噪图像在它已利用更多样本而计算的情况下将很可能看上去像什么。在一个特定实现中,机器学习由卷积神经网络(cnn)执行,然而,本发明的基础原理不限于cnn实现。在这种实现中,利用低样本计数输入和真正事实产生训练数据。cnn被训练成预测来自所讨论的像素周围的有噪像素输入的邻域的收敛像素。

164.尽管不完美,但该基于ai的去噪技术已经证明为出人意料地有效。然而,警告是需要良好训练数据,这是由于否则网络可能预测错误结果。例如,如果动画电影工作室训练了具有陆地上的场景的过去电影上的去噪cnn且然后试图使用经训练的cnn以对来自水上的新电影片场的帧进行去噪,则去噪操作将次优地执行。

165.为了解决该问题,可以在渲染的同时动态地收集学习数据,并且机器学习引擎(诸如,cnn)可以是基于当前在其上运行它的数据来连续训练的,从而针对手边的任务而连续地改进机器学习引擎。因此,训练阶段仍然可以在运行时之前被执行,但被继续以在运行时期间按照需要调整机器学习权重。由此,通过将学习数据的生成限于每帧或每n个帧的图像的子区,来避免计算训练所需的参考数据的高成本。特别地,生成帧的有噪输入,以用于利用当前网络对全部帧进行去噪。另外,生成和使用参考像素的小区以用于连续训练,如下所述。

166.尽管本文描述了cnn实现,但可以使用任何形式的机器学习引擎,包括但不限于执行受监督学习(例如,构建包含输入和期望输出两者的数据集的数学模型)、无监督学习(例如,其评估针对某些类型的结构的输入数据)、和/或受监督和无监督学习的组合。

167.现有去噪实现在训练阶段和运行时阶段中操作。在训练阶段期间,定义了网络拓扑,其接收具有各种每像素数据通道(诸如,像素颜色、深度、法线、法线偏差、图元id和反照率)的n

×

n像素的区,并生成最终像素颜色。使用一个帧价值的低样本计数输入且参考利用非常高样本计数而计算的“期望”像素颜色来生成“代表性”训练数据的集合。针对这些输入而训练网络,从而生成针对网络的“理想”权重的集合。在这些实现中,参考数据用于训练网

络的权重,以将网络的数据最接近地匹配到期望结果。

168.在运行时,加载给定的预先计算的理想网络权重并且对网络进行初始化。对于每个帧,生成去噪输入(即,与用于训练相同)的低样本计数图像。对于每个像素,像素的输入的给定邻域穿过网络,以预测“去噪的”像素颜色,从而生成去噪帧。

169.图15图示了初始训练实现。机器学习引擎1500(例如,cnn)接收具有各种每像素数据通道(诸如,像素颜色、深度、法线、法线偏差、图元id和反照率)的n

×

n像素的区作为高样本计数图像数据1702,并生成最终像素颜色。使用一个帧价值的低样本计数输入1501来生成代表性训练数据。针对这些输入而训练网络,从而生成机器学习引擎1500后续使用以在运行时对低样本计数图像进行去噪的“理想”权重1505的集合。

170.为了改进上述技术,增强用于每帧或帧子集(例如,每n个帧,其中n = 2、3、4、10、25等)生成新训练数据的去噪阶段。特别地,如图16中所图示,选择每个帧中的一个或多个区,这里被称作“新参考区”1602,其利用高样本计数而渲染成单独高样本计数缓冲区1604。低样本计数缓冲区1603存储低样本计数输入帧1601(包括与新参考区1602相对应的低样本区1604)。

171.可以随机选择新参考区1602的位置。可替换地,可以以针对每个新帧预先指定的方式(例如,使用帧之间的区的预定义移动,该区限于帧的中心处的指定区等)调整新参考区1602的位置。

172.不论如何选择新参考区,它都被机器学习引擎1600使用以持续地刷新和更新用于去噪的经训练的权重1605。特别地,渲染来自每个新参考区1602的参考像素颜色和来自对应低样本计数区1607的有噪参考像素输入。然后在机器学习引擎1600上使用高样本计数参考区1602和对应低样本计数区1607来执行补充训练。相比于初始训练,该训练是在运行时期间针对每个新参考区1602连续执行的——从而确保机器学习引擎1600被精确地训练。例如,可以评估每像素数据通道(例如像素颜色、深度、法线、法线偏差等),机器学习引擎1600使用该每像素数据通道以作出对经训练的权重1605的调整。如在训练情况(图15)中那样,针对理想权重1605的集合而训练机器学习引擎1600,以用于从低样本计数输入帧1601移除噪声,以生成去噪帧1620。然而,基于新类型的低样本计数输入帧1601的新图像特性来持续地更新经训练的权重1605。

173.可以在图形处理器单元(gpu)或主机处理器上的后台进程中并发地执行由机器学习引擎1600执行的再训练操作。可被实现为驱动器组件和/或gpu硬件组件的渲染循环可以连续地产生它放置在队列中的新训练数据(例如,以新参考区1602的形式)。在gpu或主机处理器上执行的后台训练进程可以从该队列连续地读取新训练数据,再训练机器学习引擎1600,并以适当间隔利用新权重1605更新它。

174.图17图示了其中后台训练进程1700由主机cpu 1710实现的一个这种实现的示例。特别地,后台训练进程1700使用高样本计数新参考区1602和对应低样本区1604以持续地更新经训练的权重1605,从而更新机器学习引擎1600。

175.如图18a中针对多玩家在线游戏的非限制性示例而图示的那样,不同主机1820-1822个体地生成后台训练进程1700a-c向服务器1800(例如,诸如游戏服务器)传输的参考区。服务器1800然后在机器学习引擎1810上使用从主机1821-1822中的每一个接收的新参考区来执行训练,从而如前所述更新权重1805。它将这些权重1805传输到存储权重1605a-c

的主机1820,从而更新每个个体机器学习引擎(未示出)。因为可以在短时间段中给服务器1800提供大量参考区,所以它可以高效且精确地更新针对正在由用户执行的任何给定应用(例如,在线游戏)的权重。

176.如图18b中所图示,不同主机可以生成新的经训练的权重(例如,如前所述基于训练/参考区1602)并与服务器1800(例如,诸如游戏服务器)共享新的经训练的权重,或者可替换地使用对等共享协议。服务器上的机器学习管理组件1810使用从主机中的每一个接收的新权重来生成组合权重1805的集合。组合权重1805例如可以是从新权重生成且如本文描述的那样持续更新的平均值。一旦被生成,就可以传输组合权重1605a-c的拷贝并将其存储在主机1820-1821中的每一个上,主机1820-1821然后可以如本文描述的那样使用组合权重以执行去噪操作。

177.半闭环更新机制也可以被硬件制造商使用。例如,参考网络可以被包括,作为由硬件制造商分发的驱动器的一部分。随着驱动器使用本文描述的技术来生成新训练数据并将这些连续地提交回到硬件制造商,硬件制造商使用该信息以继续针对新驱动器更新而改进其机器学习实现。

178.在示例实现中(例如,在渲染场上的批量电影渲染中),渲染器将新生成的训练区传输到专用服务器或数据库(处于该工作室的渲染场中),该专用服务器或数据库随时间从多个渲染节点聚集该数据。单独机器上的单独进程连续地改进工作室的专用去噪网络,并且新渲染器作业始终使用最近训练的网络。

179.在图19中图示了机器学习方法。该方法可以被实现在本文描述的架构上,但不限于任何特定系统或图形处理架构。

180.在1901处,作为初始训练阶段的一部分,针对多个图像帧生成低样本计数图像数据和高样本计数图像数据。在1902处,使用高/低样本计数图像数据来训练机器学习去噪引擎。例如,可以根据训练来更新与像素特征相关联的卷积神经网络权重的集合。然而,可以使用任何机器学习架构。

181.在1903处,在运行时,连同具有高样本计数的至少一个参考区一起生成低样本计数图像帧。在1904处,由机器学习引擎和/或单独训练逻辑(例如,后台训练模块1700)使用高样本计数参考区,以持续地刷新机器学习引擎的训练。例如,可以结合低样本计数图像的对应部分而使用高样本计数参考区,以继续向机器学习引擎1904教导如何最有效地执行去噪。在cnn实现中,例如,这可以涉及更新与cnn相关联的权重。

182.可以实现上述多个变型,诸如,对到机器学习引擎的反馈回路进行配置的方式、生成训练数据的实体、将训练数据反馈到训练引擎的方式、以及如何将改进的网络提供给渲染引擎。另外,尽管上述示例使用单个参考区来执行连续训练,但可以使用任何数量的参考区。此外,如前所提及,参考区可以是不同大小的,可以是在不同数量的图像帧上使用的,且可以使用不同技术(例如随机、根据预定模式等)而定位在图像帧内的不同位置中。

183.另外,尽管卷积神经网络(cnn)被描述为机器学习引擎1600的一个示例,但本发明的基础原理可以是使用能够使用新训练数据持续刷新其结果的机器学习引擎的任何形式来实现的。作为示例而非限制,其他机器学习实现包括成组数据处理方法(gmdh)、长短期存储器、深度储藏库计算、深度信任网络、张量深度堆叠网络和深度预测编码网络,仅举几例。

184.用于高效分布式去噪的装置和方法

如上所述,去噪已经变为用于利用平滑无噪图像的实时光线追踪的关键特征。渲染可以跨多个设备上的分布式系统而完成,但到目前为止,现有去噪框架全部在单个机器上的单个实例上操作。如果渲染正在跨多个设备而完成,则它们可能未全部渲染可访问以用于计算图像的去噪部分的像素。

185.呈现了与基于人工智能(ai)和非ai两者的去噪技术一起工作的分布式去噪算法。图像的区已经根据分布式渲染操作而跨节点分布,或者根据单个帧缓冲而分开和分布。在需要时从相邻节点采集计算足够去噪所需的相邻区的鬼区,并且将最终所得贴片复合成最终图像。

186.分布式处理图20图示了执行渲染的多个节点2021-2023。尽管为了简明而图示了仅三个节点,但本发明的基础原理不限于任何特定数量的节点。事实上,可以使用单个节点以实现本发明的某些实施例。

187.节点2021-2023各自渲染图像的部分,从而得到该示例中的区2011-2013。尽管在图20中示出了矩形区2011-2013,但可以使用任何形状的区并且任何设备可以处理任何数量的区。节点执行充分平滑的去噪操作所需的区被称作鬼区2011-2013。换言之,鬼区2001-2003表示以指定质量水平执行去噪所需的整个数据。降低质量水平减小了鬼区的大小且因而减少了所需的数据量,并且提高质量水平增大了鬼区和所需的对应数据。

188.如果诸如节点2021之类的节点确实具有鬼区2001的以指定质量水平对其区2011进行去噪所需的部分的本地拷贝,则该节点将从一个或多个“邻近”节点(诸如,拥有如所图示的鬼区2001的部分的节点2022)检索所需数据。类似地,如果节点2022确实具有鬼区2002的以指定质量水平对其区2012进行去噪所需的部分的本地拷贝,则节点2022将从节点2021检索所需鬼区数据2032。可以在总线、互连、高速存储器组构、网络(例如,高速以太网)上执行检索,或者检索甚至可以是能够在多个核(例如,用于以极端分辨率或时变地渲染大图像)之间分发渲染工作的多核芯片中的片上互连。每个节点2021-2023可以包括个体执行单元或者图形处理器内的执行单元的指定集合。

189.要发送的指定数据量取决于正在使用的去噪技术。此外,来自鬼区的数据可以包括改进每个相应区的去噪所需的任何数据。例如,鬼区数据可以包括图像颜色/波长、强度/阿尔法数据和/或法线。然而,本发明的基础原理不限于鬼区数据的任何特定集合。

190.另外细节对于较慢网络或互连,可以使用现有通用无损或有损压缩来利用该数据的压缩。示例包括但不限于zlib、gzip和伦佩尔-齐夫-马尔可夫链算法(lzma)。可以通过注意到帧之间的光线命中信息中的增量可以相当稀疏来使用进一步内容特定压缩,并且当节点已经具有从先前帧采集的增量时,仅有对该增量作出贡献的样本需要被发送。这些可以被选择性地推送到采集那些样本的节点i,或者节点i可以请求来自其他节点的样本。无损压缩用于某些类型的数据和程序代码,而有损数据用于其他类型的数据。

191.图21图示了节点2021-2022之间的交叉的另外细节。每个节点2021-2022包括用于渲染相应图像区2011-2012和鬼区2001-2002的光线追踪渲染电路系统2081-2082。去噪器2100-2111分别对每个节点2021-2022负责渲染和去噪的区2011-2012执行去噪操作。去噪器2021-2022例如可以包括用于分别生成去噪区2121-2122的电路系统、软件或其任何组

合。如所提及的那样,在生成去噪区时,去噪器2021-2022可能需要依赖于不同节点所拥有的鬼区内的数据(例如,去噪器2100可能需要来自节点2022所拥有的鬼区2002的数据)。

192.因此,去噪器2100-2111可以使用分别来自区2011-2012和鬼区2001-2002的数据来生成去噪区2121-2122,该数据的至少部分可以是从另一节点接收的。区数据管理器2101-2102可以如本文所描述的那样管理来自鬼区2001-2002的数据传送。压缩器/解压缩器单元2131-2132可以分别执行在节点2021-2022之间交换的鬼区数据的压缩和解压缩。

193.例如,节点2021的区数据管理器2101可以在从节点2022请求时将来自鬼区2001的数据发送到压缩器/解压缩器2131,压缩器/解压缩器2131压缩数据以生成它向节点2022传输的经压缩的数据2106,从而减小互连、网络、总线或其他数据通信链路上的带宽。节点2022的压缩器/解压缩器2132然后对经压缩的数据2106进行解压缩,并且去噪器2111使用经解压缩的鬼数据以生成比在仅有来自区2012的数据的情况下将可能的质量更高的质量的去噪区2012。区数据管理器2102可以将来自鬼区2001的经解压缩的数据存储在高速缓存、存储器、寄存器堆或其他储存器中,以在生成去噪区2122时使它可用于去噪器2111。可以执行操作的类似集合以将来自鬼区2002的数据提供给节点2021上的去噪器2100,去噪器2100结合来自区2011的数据而使用该数据以生成更高质量的去噪区2121。

194.抓取数据或渲染如果诸如节点2021-2022之类的设备之间的连接是缓慢的(即,比阈值时延和/或阈值带宽慢),则本地渲染鬼区而不是请求来自其他设备的结果可能更快。这可以是通过下述操作来在运行时确定的:跟踪针对鬼区大小的网络交易速度和线性外插渲染时间。在渲染出整个鬼区更快的这种情况下,多个设备可以最后渲染图像的相同部分。可以基于基础区的方差和所确定的模糊程度来调整鬼区的所渲染的部分的分辨率。

195.负载平衡可以使用静态和/或动态负载平衡方案以在各种节点2021-2023之间分发处理负载。对于动态负载平衡,由去噪滤波器确定的方差可能在去噪中需要更多时间,但利用低方差和需要更少样本的图像的模糊区驱动用于渲染场景的特定区的样本的量。可以基于来自先前帧的数据来动态地调整被指派给特定节点的特定区,或者在设备正在渲染时跨设备动态地传送该特定区,使得所有设备将具有相同量的工作。

196.图22图示了在每个相应节点2021-2022上运行的监视器2201-2202如何采集性能度量数据,包括但不限于在网络接口2211-2212上传输数据所耗费的时间、在对区进行去噪(在具有鬼区数据的情况下以及在没有鬼区数据的情况下)时耗费的时间、以及渲染每个区/鬼区所耗费的时间。监视器2201-2202将这些性能度量报告回到管理器或负载平衡器节点2201,管理器或负载平衡器节点2201分析数据以识别每个节点2021-2022上的当前工作负载并潜在地确定处理各种去噪区2121-2122的更高效模式。管理器节点2201然后根据所检测到的负载将针对新区的新工作负载分发到节点2021-2022。例如,管理器节点2201可以将更多工作传输到未重加载的那些节点,和/或重新分配来自过载的那些节点的工作。另外,负载平衡器节点2201可以传输重配置命令以调整由节点中的每一个执行渲染和/或去噪的特定方式(上面描述了其一些示例)。

197.确定鬼区可以基于由去噪器2100-2111实现的去噪算法来确定鬼区2001-2002的大小和形

状。它们的相应大小然后可以是基于被去噪的样本的所检测到的方差来动态修改的。用于ai去噪自身的学习算法可以用于确定适当区大小,或者在诸如双侧模糊之类的其他情况下,预定滤波器带宽将确定鬼区2001-2002的大小。在使用学习算法的示例性实现中,可以在管理器节点2201上执行机器学习引擎,和/或可以在个体节点2021-2023中的每一个上执行机器学习的部分(参见例如图18a-b和以上关联文本)。

198.收集最终图像可以通过从节点2021-2023中的每一个收集所渲染且经去噪的区来收集最终图像,而无需鬼区或法线。在图22中,例如,去噪区2121-2122被传输到管理器节点2201的区处理器2280,其对区进行组合以生成最终去噪图像2290,然后,最终去噪图像2290被显示在显示器2290上。区处理器2280可以使用多种2d复合技术来对区进行组合。尽管被图示为单独组件,但区处理器2280和去噪图像2290可以是显示器2290的组成部分。各种节点2021-2022可以使用直接发送技术以传输去噪区2121-2122,并潜在地使用区数据的各种有损或无损压缩。

199.ai去噪仍然是高成本操作,并且随着游戏移动到云中。由此,跨多个节点2021-2022的去噪的分布式处理可能变为实现用于传统游戏的实时帧速率或者需要更高帧速率的虚拟现实(vr)所必需。电影工作室还常常在可以用于更快去噪的大渲染场中渲染。

200.在图23中图示了用于执行分布式渲染和去噪的示例性方法。该方法可以是在上述系统架构的上下文内实现的,但不限于任何特定系统架构。

201.在2301处,将图形工作分派到多个节点,该多个节点执行光线追踪操作以渲染图像帧的区。每个节点可能已经具有在存储器中执行操作所需的数据。例如,节点中的两个或更多个可以共享公共存储器,或者节点的本地存储器可能已经存储来自在先光线追踪操作的数据。可替换地或另外,可以将某个数据传输到每个节点。

202.在2302处,确定指定水平的去噪(即,在可接受性能水平处)所需的“鬼区”。鬼区包括执行指定水平的去噪所需的任何数据,包括一个或多个其他节点所拥有的数据。

203.在2303处,在节点之间交换与鬼区(或其部分)相关的数据。在2304处,每个节点在其相应区上执行去噪(例如,使用所交换的数据),并且在2305处,对结果进行组合以生成最终去噪图像帧。

204.诸如图22中所示的管理器节点或主节点可以将工作分派到节点,且然后对由节点执行的工作进行组合以生成最终图像帧。可以使用基于对等端的架构,其中节点是交换数据以对最终图像帧进行渲染和去噪的对等端。

205.本文描述的节点(例如,节点2021-2023)可以是经由高速网络而互连的图形处理计算系统。可替换地,节点可以是耦合到高速存储器组构的个体处理元件。所有节点可以共享公共虚拟存储器空间和/或公共物理存储器。可替换地,节点可以是cpu和gpu的组合。例如,上述管理器节点2201可以是cpu和/或在cpu上执行的软件,并且节点2021-2022可以是gpu和/或在gpu上执行的软件。可以使用各种不同类型的节点,同时仍符合本发明的基础原理。

206.示例神经网络实现存在许多类型的神经网络;简单类型的神经网络是前馈网络。前馈网络可被实现为其中节点用层布置的非循环图(acyclic graph)。通常,前馈网络拓扑包括被至少一个隐

藏层分开的输入层和输出层。隐藏层将输入层接收的输入变换为对在输出层中生成输出有用的表示。网络节点经由边而完全连接到邻近层中的节点,但在每个层内的节点之间没有边。在前馈网络的输入层的节点处接收的数据经由激活函数而被传播(即,“前馈”)到输出层的节点,该激活函数基于分别与连接层的边中的每个相关联的系数(“权重”)计算网络中的每个连续层的节点的状态。根据由被执行的算法表示的特定模型,来自神经网络算法的输出可采取各种形式。

207.在机器学习算法可用于对特定问题进行建模之前,使用训练数据集来训练算法。训练神经网络涉及选择网络拓扑、使用表示正被网络建模的问题的训练数据的集合以及调整权重直到网络模型以最小误差对训练数据集的所有实例执行。例如,在对于神经网络的受监督学习训练过程期间,网络响应于表示训练数据集中的实例的输入而产生的输出与对该实例的“正确的”经标记的输出比较,计算表示输出与经标记的输出之间的差异的误差信号,并且调整与连接相关联的权重以在误差信号通过网络层向后传播时使该误差最小化。在对于从训练数据集的实例生成的输出中的每个的误差被最小化时,网络被认为是“经训练的”。

208.机器学习算法的准确度可明显受到用于训练算法的数据集的质量的影响。训练过程可以是计算密集的并且在常规的通用处理器上可能需要大量时间。相应地,并行处理硬件用于训练许多类型的机器学习算法。这对于优化神经网络的训练特别有用,这是因为在调整神经网络中的系数时执行的计算使得它们自身自然地有助于并行实现。具体地,许多机器学习算法和软件应用已适合于利用通用图形处理设备内的并行处理硬件。

209.图24是机器学习软件栈200的通用图。机器学习应用2402可配置成使用训练数据集来训练神经网络或使用经训练的深度神经网络来实现机器智能。机器学习应用2402可包括用于神经网络的训练和推理功能性和/或可用于在部署之前训练神经网络的专用软件。机器学习应用2402可实现任何类型的机器智能,其包括但不限于图像识别、测绘(mapping)和定位(localization)、自主导航、话音合成、医学成像或语言翻译。

210.用于机器学习应用2402的硬件加速可经由机器学习框架2404而启用。机器学习框架2404可以被实现在本文描述的硬件上,该硬件诸如是包括本文描述的处理器和组件的处理系统100。针对图24而描述的与本文中任何其他图的元件具有相同或类似名称的元件描述与在其他图中相同的元件,可以以与其类似的方式操作或起作用,可以包括相同组件,且可以链接到其他实体,如本文其他地方描述的那些实体,但不限于此。机器学习框架2404可提供机器学习图元库。机器学习图元是机器学习算法普遍执行的基本操作。在没有机器学习框架2404的情况下,将需要机器学习算法的开发人员创建和优化与机器学习算法相关联的主计算逻辑,然后在开发新的并行处理器时重新优化计算逻辑。取而代之,机器学习应用可配置成使用机器学习框架2404提供的图元来执行必要的计算。示例性图元包括张量卷积、激活函数和池化,它们是在训练卷积神经网络(cnn)时执行的计算操作。机器学习框架2404还可提供图元来实现由许多机器学习算法执行的基本线性代数子程序,例如矩阵和向量运算。

211.机器学习框架2404可处理从机器学习应用2402接收的输入数据并且生成到计算框架2406的合适输入。计算框架2406可抽取被提供给gpgpu驱动器2408的底层指令,以使机器学习框架2404能够经由gpgpu硬件2410利用硬件加速而不需要机器学习框架2404深入了

解gpgpu硬件2410的架构。另外,计算框架2406可对机器学习框架2404实现跨多种类型和代际的gpgpu硬件2410的硬件加速。

212.gpgpu机器学习加速图25图示了多gpu计算系统2500,其可以是处理系统100的变型。因此,本文与处理系统100结合的任何特征的公开内容还公开了与多gpu计算系统2500的对应结合,但不限于此。图25的与本文中任何其他图的元件具有相同或类似名称的元件描述与在其他图中相同的元件,可以以与其类似的方式操作或起作用,可以包括相同组件,且可以链接到其他实体,如本文其他地方描述的那些实体,但不限于此。多gpu计算系统2500可包括处理器2502,其经由主机接口开关2504耦合到多个gpgpu 2506a-d。主机接口开关2504可以例如是pci express开关设备,其将处理器2502耦合到pci express总线,处理器2502通过该pci express总线可与一组gpgpu 2506a-d通信。多个gpgpu 2506a-d中的每个可以是上述gpgpu的实例。gpgpu 2506a-d可经由一组高速点到点gpu到gpu链路2516互连。高速gpu到gpu链路可经由专用gpu链路而连接到gpgpu 2506a-d中的每个。p2p gpu链路2516在gpgpu 2506a-d中的每个之间实现直接通信而不需要在处理器2502连接到的主机接口总线上通信。利用被引导到p2p gpu链路的gpu到gpu业务,主机接口总线仍然可用于系统存储器访问或者例如经由一个或多个网络设备与多gpu计算系统2500的其他实例通信。取代经由主机接口开关2504将gpgpu 2506a-d连接到处理器2502,处理器2502可包括对p2p gpu链路2516的直接支持且因而直接连接到gpgpu 2506a-d。

213.机器学习神经网络实现本文描述的计算架构可配置成执行特别适合于训练和部署神经网络以用于机器学习的并行处理的类型。神经网络可归纳为具有图关系的功能的网络。如在本领域内众所周知的,存在多种类型的神经网络实现在机器学习中使用。一个示例性类型的神经网络是前馈网络,如之前描述的那样。

214.第二个示例性类型的神经网络是卷积神经网络(cnn)。cnn是用于处理具有已知的网格状拓扑的数据(诸如图像数据)的专门前馈神经网络。相应地,cnn通常用于计算视觉和图像识别应用,但它们也可用于其他类型的模式识别,诸如话音和语言处理。cnn输入层中的节点被组织成一组“滤波器”(受在视网膜中发现的接受野启发的特征检测器),并且每组滤波器的输出被传播到网络的连续层中的节点。对于cnn的计算包括对每个滤波器应用卷积数学运算来产生该滤波器的输出。卷积是由两个函数执行以产生第三函数的专门种类的数学运算,该第三函数是该两个原始函数中的一个的修改后的版本。在卷积网络术语中,到卷积的第一函数可称为输入,而第二函数可称为卷积内核。输出可称为特征图。例如,到卷积层的输入可以是定义输入图像的各种颜色分量的多维阵列的数据。卷积内核可以是多维阵列的参数,其中这些参数由训练过程针对神经网络而适配。

215.递归神经网络(rnn)是前馈神经网络族,其包括层之间的反馈连接。rnn通过跨神经网络的不同部分共享参数数据来启用对顺序数据的建模。rnn的架构包括循环。循环表示变量的当前值在未来时间处对它自身值的影响,这是因为来自rnn的输出数据的至少一部分被用作反馈以用于处理序列中的后续输入。该特征由于可在其中组成语言数据的变量性质而使得rnn对于语言处理特别有用。

216.下文描述的图呈现示例性前馈、cnn和rnn网络,以及描述用于分别训练和部署那

些类型的网络中的每个的通用过程。将理解这些描述是示例性且非限制性的并且所图示的概念一般可应用于深度神经网络和一般的机器学习技术。

217.上文描述的示例性神经网络可用于执行深度学习。深度学习是使用深度神经网络的机器学习。在深度学习中使用的深度神经网络是由多个隐藏层组成的人工神经网络,这与只包括单个隐藏层的浅层神经网络相对。更深层神经网络通常在计算上更密集来训练。然而,网络的另外隐藏层实现多步模式识别,其相对于浅层机器学习技术导致输出误差减小。

218.在深度学习中使用的深度神经网络通常包括耦合到后端网络的前端网络,用于执行特征识别,该后端网络表示可基于被提供给模型的特征表示来执行操作(例如,对象分类、话音识别等)的数学模型。深度学习使机器学习能够被执行而不需要对模型执行手工特征工程化。取而代之,深度神经网络可基于输入数据内的统计结构或相关性来学习特征。习得的特征可被提供给数学模型,其可将所检测到的特征映射到输出。网络使用的数学模型一般专门针对待执行的特定任务,并且不同模型将用于执行不同任务。

219.一旦神经网络被结构化,学习模型就可应用于网络来训练网络以执行特定任务。学习模型描述了如何调整模型内的权重来减小网络的输出误差。误差后向传播是用于训练神经网络的常见方法。向网络呈现输入向量以用于处理。使用损耗函数将网络的输出与期望输出进行比较并且对输出层中的神经元中的每个计算误差值。然后,误差值被向后传播直到每个神经元具有关联的误差值,其大致表示它对原始输出的贡献。然后,网络可使用算法(诸如随机梯度下降算法)从那些误差中学习,以更新神经网络的权重。

220.图26-27图示了示例性卷积神经网络。图26图示了cnn内的各种层。如图26中所示,用于对图像处理进行建模的示例性cnn可接收输入2602,其描述输入图像的红、绿和蓝(rgb)分量。输入2602可被多个卷积层(例如,卷积层2604、卷积层2606)处理。来自多个卷积层的输出可以可选地被一组全连接层2608处理。全连接层中的神经元具有到之前的层中的所有激活的全连接,如之前针对前馈网络描述的那样。来自全连接层2608的输出可用于从网络生成输出结果。全连接层2608内的激活可使用矩阵乘法而不是卷积而计算。不是所有的cnn实现都利用全连接层。例如,在一些实现中,卷积层2606能够为cnn生成输出。

221.卷积层是稀疏连接的,这与在全连接层2608中发现的传统神经网络配置不同。传统神经网络层是全连接的,使得每个输出单元与每个输入单元交互。然而,如所图示的那样,因为场的卷积的输出是到后续层的节点的输入(而不是场中的节点中的每个节点的相应状态值),所以卷积层是稀疏连接的。与卷积层相关联的内核执行卷积运算,其输出被发送给下一个层。在卷积层内执行的降维是使cnn能够放缩以处理大图像的一个方面。

222.图27图示了cnn的卷积层内的示例性计算级。到cnn的卷积层2712的输入可在卷积层2714的三个级中被处理。这三个级可包括卷积级2716、检测器级2718和池化级2720。然后,卷积层2714可向连续卷积层输出数据。网络的最终卷积层可生成输出特征图数据或向全连接层提供输入,例如以对到cnn的输入生成分类值。

223.在卷积级2716中并行执行若干卷积以产生一组线性激活。卷积级2716可包括仿射变换,其是可被规定为线性变换加平移的任何变换。仿射变换包括这些变换的旋转、平移、缩放和组合。卷积级计算连接到输入中的特定区的功能(例如,神经元)的输出,该特定区可被确定为与神经元相关联的局部区。神经元计算神经元的权重与神经元连接到的局部输入

中的区之间的点积。来自卷积级2716的输出定义被卷积层2714的连续级所处理的一组线性激活。

224.线性激活可被检测器级2718处理。在检测器级2718中,每个线性激活被非线性激活函数处理。该非线性激活函数使整体网络的非线性性质增加而不影响卷积层的相应场。可使用若干类型的非线性激活函数。一个特定类型是整流线性单元(relu),其使用被定义为 f(x)=max(0,x)的激活函数,使得激活被阈值化在零处。

225.池化级2720使用池化函数,其用附近输出的汇总统计来代替卷积层2706的输出。池化函数可用于将平移不变性引入神经网络,使得对输入的小平移不改变池化输出。局部平移的不变性在输入数据中特征的存在比特征的精确位置更重要的场景中可以是有用的。在池化级2720期间可使用各种类型的池化函数,其包括最大池化、平均池化和l2范数池化。另外,一些cnn实现不包括池化级。取而代之,这样的实现替代相对于之前的卷积级具有增加步幅的另外卷积级。

226.然后,来自卷积层2714的输出可被下一个层2722处理。下一个层2722可以是另外卷积层,或全连接层2708中的一个。例如,图27的第一卷积层2704可向第二卷积层2706输出,而第二卷积层可向全连接层2808的第一层输出。

227.图28图示了示例性递归神经网络2800。在递归神经网络(rnn)中,网络的之前的状态影响网络的当前状态的输出。rnn可使用多种函数用多种方式加以构建。rnn的使用一般围绕着使用数学模型以基于输入的在先序列预测未来。例如,给定之前的词序列,rnn可用于执行统计语言建模来预测即将到来的词。所图示的rnn 2800可被描述为具有接收输入向量的输入层2802、实现递归功能的隐藏层2804、启用之前状态的

‘

记忆’的反馈机制2805和输出结果的输出层2806。rnn 2800基于时间步长来操作。rnn在给定时间长处的状态基于之前的时间步长经由反馈机制2805而受影响。对于给定时间步长,隐藏层2804的状态由之前的状态和当前时间步长处的输入来定义。第一时间步长处的初始输入(x1)可被隐藏层2804处理。第二输入(x2)可被隐藏层2804使用在初始输入(x1)的处理期间所确定的状态信息来处理。给定状态可被计算为s_t=f(ux_t ws_(t-1)),其中u和w是参数矩阵。函数f一般是非线性,诸如双曲正切函数(tanh)或整流器函数f(x)=max(0,x)的变型。然而,在隐藏层2804中使用的特定数学函数可根据rnn 2800的特定实现细节而变化。

228.除所描述的基本cnn和rnn网络外,可启用那些网络上的变化。一个示例rnn变型是长短期记忆(lstm)rnn。lstm rnn能够学习长期依赖性,其对于处理较长语言序列是必要的。关于cnn的变型是卷积深度信任网络,其具有与cnn相似的结构并且采用与深度信任网络相似的方式来训练。深度信任网络(dbn)是生成式神经网络,其由多层的概率性(随机)变量组成。dbn可使用贪婪的无监督学习而逐层训练。然后,dbn的习得权重可用于通过对神经网络确定权重的最优初始集来提供预先训练神经网络。

229.图29图示了深度神经网络的训练和部署。一旦已经针对任务而结构化给定网络,就使用训练数据集2902来训练神经网络。已开发各种训练框架2904来启用训练过程的硬件加速。例如,上述机器学习框架可配置为训练框架。训练框架2904可钩入(hook into)未经训练的神经网络2906并且使该未经训练的神经网能够使用本文描述的并行处理资源而训练以生成经训练的神经网2908。

230.为了开始训练过程,可随机或通过使用深度信任网络的预先训练来选择初始权

重。然后,采用受监督或无监督方式执行训练循环。

231.受监督学习是其中训练作为介导(mediated)操作而执行的学习方法,诸如当训练数据集2902包括与针对输入的期望输出配对的输入时,或在训练数据集包括具有已知输出的输入并且神经网络的输出被人工分级的情况下。网络处理输入并且将所得的输出与一组预期或期望输出相比较。然后,误差通过系统而被向后传播。训练框架2904可调整成调整控制未经训练的神经网络2906的权重。训练框架2904可提供工具来监视未经训练的神经网络2906在多大程度上向适合于基于已知输入数据生成正确应答的模型收敛。随着网络的权重被调整以改善神经网络生成的输出,训练过程重复发生。训练过程可持续直到神经网络达到与经训练的神经网2908相关联的统计上期望的准确度。然后,可部署经训练的神经网络2908来实现任何数量的机器学习操作。

232.无监督学习是其中网络试图使用未标记的数据来训练它自己的学习方法。因此,对于无监督学习,训练数据集2902将包括输入数据而没有任何关联的输出数据。未经训练的神经网络2906可学习未标记的输入内的分组并且可确定个体输入如何与整体数据集相关。无监督训练可用于生成自组织图,其是能够执行在降低数据的维度方面有用的操作的一类经训练的神经网络2907。无监督训练还可用于执行异常检测,其允许标识输入数据集中偏离数据的正常模式的数据点。

233.还可采用关于受监督和无监督训练的变化。半监督学习是其中训练数据集2902包括相同分布的标记和无标记数据的混合的技术。递增式学习是其中输入数据被连续用于进一步训练模型的受监督学习的变型。递增式学习使经训练的神经网络2908能够适合于新的数据2912而没有忘记初始训练期间网络内灌输的知识。

234.无论是受监督还是无监督,针对特别深度神经网络的训练过程对于单个计算节点在计算上可能太密集。取代使用单个计算节点,计算节点的分布式网络可用于加速训练过程。

235.图30a是图示了分布式学习的框图。分布式学习是使用多个分布式计算节点(诸如,上述节点)以执行神经网络的受监督或无监督训练的训练模型。分布式计算节点可各自包括一个或多个主机处理器以及通用处理节点中的一个或多个,诸如,高度并行通用图形处理单元。如所图示的那样,分布式学习可以是所执行的模型并行结构3002、数据并行结构3004或模型和数据并行结构的组合。

236.在模型并行结构3002中,分布式系统中的不同计算节点可对单个网络的不同部分执行训练计算。例如,神经网络的每个层可由分布式系统的不同处理节点训练。模型并行结构的优点包括放缩到特别大模型的能力。拆分与神经网络的不同层相关联的计算启用了其中所有层的权重将不适合单个计算节点的存储器的非常大神经网络的训练。在一些实例中,模型并行结构在执行大神经网络的无监督训练时可特别有用。

237.在数据并行结构3004中,分布式网络的不同节点具有模型的完整实例并且每个节点接收数据的不同部分。然后,来自不同节点的结果被组合。尽管不同的方法对于数据并行结构是可能的,但数据并行训练方法全部需要将结果进行组合并使每个节点之间的模型参数同步的技术。组合数据的示例性方法包括参数平均和基于更新的数据并行结构。参数平均训练了训练数据子集上的每个节点并将全局参数(例如,权重、偏置)设置成来自每个节点的参数的平均值。参数平均使用中央参数服务器,其维持参数数据。基于更新的数据并行

结构与参数平均相似,不同之处在于对模型的更新被传送,而不是将来自节点的参数传送到参数服务器。另外,基于更新的数据并行结构可采用分散方式执行,其中更新被压缩且在节点之间传送。

238.组合模型和数据并行结构3006可例如在其中每个计算节点包括多个gpu的分布式系统中实现。每个节点可具有模型的完整实例,其中每个节点内的单独gpu用于训练模型的不同部分。

239.分布式训练相对于在单个机器上的训练具有增加的开销。然而,本文描述的并行处理器和gpgpu可各自实现各种技术来减少分布式训练的开销,这些技术包括实现高带宽gpu到gpu数据传送和加速远程数据同步的技术。

240.示例性机器学习应用机器学习可应用于解决多种技术问题,其包括但不限于计算机视觉、自主驾驶和导航、话音识别和语言处理。在传统上,计算机视觉已经是机器学习应用的最活跃研究领域之一。计算机视觉的应用的范围从再现人类视觉能力(诸如,识别面部)到创建视觉能力的新类别而变化。例如,计算机视觉应用可配置成从视频中可见的对象中引发的振动中识别声波。并行处理器加速机器学习使计算机视觉应用能够使用比之前可行的明显更大的训练数据集而训练,并使推理系统能够使用低功率并行处理器而部署。

241.并行处理器加速机器学习具有自主驾驶应用,其包括车道和道路标志识别、障碍物避免、导航和驾驶控制。加速机器学习技术可用于基于定义对特定训练输入的合适响应的数据集来训练驾驶模型。本文描述的并行处理器可对用于自主驾驶技术方案的日益复杂的神经网络实现快速训练,并在适合于集成到自主交通工具中的移动平台中启用低功率推理处理器的部署。

242.并行处理器加速深度神经网络已对自动话音识别(asr)启用机器学习方法。asr包括创建下述函数:给定输入声序列,该函数计算最可能的语言序列。使用深度神经网络的加速机器学习已经实现了对之前用于asr的隐藏马尔可夫模型(hmm)和高斯混合模型(gmm)的替换。

243.并行处理器加速机器学习还可用于加速自然语言处理。自动学习过程可利用统计推理算法来产生对错误或不熟悉输入具有鲁棒性的模型。示例性自然语言处理器应用包括人类语言之间的自动机器翻译。

244.用于机器学习的并行处理平台可被分成训练平台和部署平台。训练平台一般是高度并行的并且包括优化,以加速多gpu单节点训练和多节点多gpu训练。适合于训练的示例性并行处理器包括本文描述的高度并行通用图形处理单元和/或多gpu计算系统。相反,所部署的机器学习平台一般包括适合于用在诸如相机、自主机器人和自主交通工具之类的产品中的较低功率并行处理器。

245.图30b图示了适合于使用经训练的模型执行推理的示例性推理片上系统(soc)3100。图30b的与本文中任何其他图的元件具有相同或类似名称的元件描述与在其他图中相同的元件,可以以与其类似的方式操作或起作用,可以包括相同组件,且可以链接到其他实体,如本文其他地方描述的那些实体,但不限于此。soc 3100可集成处理组件,其包括媒体处理器3102、视觉处理器3104、gpgpu 3106和多核处理器3108。soc 3100可另外包括片上存储器3105,其可实现处理组件中的每一个可访问的共享片上数据池。处理组件可针对低

功率操作而优化以实现到多种机器学习平台的部署,其包括自主交通工具和自主机器人。例如,soc 3100的一个实现可被用作自主交通工具的主控制系统的一部分。在soc 3100配置成供自主交通工具中使用的情况下,soc被设计且配置成符合部署管辖的相关功能安全标准。

246.在操作期间,媒体处理器3102和视觉处理器3104可协同工作来加速计算机视觉操作。媒体处理器3102可实现多个高分辨率(例如,4k、8k)视频流的低时延解码。经解码的视频流可被写入到片上存储器3105中的缓冲器。然后,视觉处理器3104可对经解码的视频进行解析,并在使用经训练的图像识别模型准备处理帧时对经解码的视频的帧执行初步处理操作。例如,视觉处理器3104可针对用于在高分辨率视频数据上执行图像识别的cnn加速卷积运算,而后端模型计算由gpgpu 3106执行。

247.多核处理器3108可包括控制逻辑来帮助媒体处理器3102和视觉处理器3104所执行的数据传送和共享存储器操作的定序和同步。多核处理器3108还可充当应用处理器来执行可利用gpgpu 3106的推理计算能力的软件应用。例如,导航和驾驶逻辑的至少一部分可以以在多核处理器3108上执行的软件而实现。这样的软件可直接向gpgpu 3106发出计算工作负载,或者,可将计算工作负载发出到多核处理器3108,该多核处理器3108可向gpgpu 3106卸载那些操作的至少一部分。

248.gpgpu 3106可包括计算集群,诸如高度并行通用图形处理单元dplab00内的处理集群dplab06a-dplab06h的低功率配置。gpgpu 3106内的处理集群可支持被专门优化以在经训练的神经网络上执行推理计算的指令。例如,gpgpu 3106可支持执行诸如8位和4位整数向量运算之类的低精度计算的指令。

249.光线追踪架构在一个实现中,图形处理器包括用于执行实时光线追踪的电路系统和/或程序代码。光线追踪核的专用集合可以被包括在图形处理器中,以执行本文描述的各种光线追踪操作,包括光线遍历和/或光线交叉操作。除光线追踪核外,还可以包括用于执行可编程着色操作的图形处理核的多个集合和用于在张量数据上执行矩阵运算的张量核的多个集合。

250.图31图示了一个这种图形处理单元(gpu)3105的示例性部分,该图形处理单元(gpu)3105包括被布置到多核组3100a-n中的图形处理资源的专用集合。图形处理单元(gpu)3105可以是图形处理器300、gpgpu 1340和/或本文描述的任何其他图形处理器的变型。因此,图形处理器的任何特征的公开内容还公开了与gpu 3105的对应结合,但不限于此。此外,图31的与本文中任何其他图的元件具有相同或类似名称的元件描述与在其他图中相同的元件,可以以与其类似的方式操作或起作用,可以包括相同组件,且可以链接到其他实体,如本文其他地方描述的那些实体,但不限于此。尽管提供了仅单个多核组3100a的细节,但是将领会,其他多核组3100b-n可以配备有图形处理资源的相同或类似集合。

251.如所图示的那样,多核组3100a可以包括一组图形核3130、一组张量核3140和一组光线追踪核3150。调度器/分派器3110调度和分派图形线程以用于在各种核3130、3140、3150上执行。一组寄存器堆3120存储核3130、3140、3150在执行图形线程时使用的操作数值。这些可以包括例如用于存储整数值的整数寄存器、用于存储浮点值的浮点寄存器、用于存储打包数据元素(整数和/或浮点数据元素)的向量寄存器和用于存储张量/矩阵值的贴片寄存器。贴片寄存器可以被实现为向量寄存器的组合集合。

252.一个或多个1级(l1)高速缓存和纹理单元3160在每个多核组3100a内本地存储图形数据,诸如纹理数据、顶点数据、像素数据、光线数据、包围体数据等。由多核组3100a-n的全部或子集共享的2级(l2)高速缓存3180存储针对多个同时图形线程的图形数据和/或指令。如所图示的那样,l2高速缓存3180可以跨多个多核组3100a-n而共享。一个或多个存储器控制器3170将gpu 3105耦合到存储器3198,存储器3198可以是系统存储器(例如,dram)和/或本地图形存储器(例如,gddr6存储器)。

253.输入/输出(i/o)电路系统3195将gpu 3105耦合到一个或多个io设备3195,诸如数字信号处理器(dsp)、网络控制器或用户输入设备。片上互连可以用于将i/o设备3190耦合到gpu 3105和存储器3198。io电路系统3195的一个或多个io存储器管理单元(iommu)3170将io设备3190直接耦合到系统存储器3198。iommu 3170可以管理页表的多个集合以将虚拟地址映射到系统存储器3198中的物理地址。另外,io设备3190、(一个或多个)cpu 3199和(一个或多个)gpu 3105可以共享相同虚拟地址空间。

254.iommu 3170还可以支持虚拟化。在该情况下,它可以管理页表的第一集合以将客户/图形虚拟地址映射到客户/图形物理地址,并管理页表的第二集合以将客户/图形物理地址映射到系统/主机物理地址(例如,在系统存储器3198内)。页表的第一和第二集合中的每个的基址可被存储在控制寄存器中并且在上下文切换时被换出(例如,使得新的上下文被提供有对页表的相关集合的访问)。尽管在图31中未图示,但核3130、3140、3150和/或多核组3100a-n中的每个可以包括转化后备缓冲器(tlb),以对客户虚拟到客户物理转化、客户物理到主机物理转化以及客户虚拟到主机物理转化进行高速缓存。

255.cpu 3199、gpu 3105和io设备3190可被集成在单个半导体芯片和/或芯片封装上。所图示的存储器3198可被集成在相同芯片上,或者可经由片外接口而耦合到存储器控制器3170。在一个实现中,存储器3198包括gddr6存储器,所述gddr6存储器共享与其他物理系统级存储器相同的虚拟地址空间,尽管本发明的基础原理不限于此特定实现。

256.张量核3140可包括特别设计成执行矩阵运算的多个执行单元,所述矩阵运算是用于执行深度学习操作的基础计算操作。例如,同时矩阵乘法运算可被用于神经网络训练和推理。张量核3140可使用多种操作数精度来执行矩阵处理,所述多种操作数精度包括单精度浮点(例如,32位)、半精度浮点(例如,16位)、整数字(16位)、字节(8位)和半字节(4位)。神经网络实现还可以取出每个经渲染的场景的特征,潜在地组合来自多个帧的细节,以构造高质量的最终图像。

257.在深度学习实现中,可调度并行矩阵乘法工作以用于在张量核3140上执行。神经网络的训练特别要求大量的矩阵点积运算。为了处理n x n x n矩阵相乘的内积公式,张量核3140可包括至少n个点积处理元素。在矩阵相乘开始前,一个完整矩阵被加载到贴片寄存器中,并且在n个周期的每个周期,第二矩阵的至少一列被加载。每个周期,有被处理的n个点积。

258.取决于特定实现,可以以不同精度存储矩阵元素,所述不同精度包括16位字、8位字节(例如,int8)和4位半字节(例如,int4)。可为张量核2140指定不同精度模式以确保最高效的精度被用于不同工作负载(例如,诸如可容许量化到字节和半字节的推理工作负载)。

259.光线追踪核3150可以用于对于实时光线追踪和非实时光线追踪实现二者均使光

线追踪操作加速。特别地,光线追踪核3150可以包括光线遍历/交叉电路系统,以用于使用包围体层级(bvh)来执行光线遍历并且标识封闭在bvh体积之内的图元与光线之间的交叉。光线追踪核3150还可包括用于执行深度测试和剔除(例如,使用z缓冲器或类似布置)的电路系统。在一个实现中,光线追踪核3150与本文描述的图像去噪技术协同执行遍历和交叉操作,其至少一部分可在张量核3140上被执行。例如,张量核3140可以实现深度学习神经网络,以执行对由光线追踪核3150生成的帧的去噪。然而,(一个或多个)cpu 3199、图形核3130和/或光线追踪核3150还可实现去噪和/或深度学习算法的全部或一部分。

260.另外,如上所述,可采用去噪的分布式方法,其中gpu 3105处于通过网络或高速互连耦合到其他计算设备的计算设备中。互连的计算设备可以另外共享神经网络学习/训练数据来改进速度,利用该速度,整个系统学习对不同类型的图像帧和/或不同的图形应用执行去噪。

261.光线追踪核3150可以处理所有bvh遍历和光线-图元交叉,从而避免图形核3130以每光线数千个指令而过载。每个光线追踪核3150可以包括用于执行包围盒测试(例如,对于遍历操作)的专用电路系统的第一集合和用于执行光线-三角形交叉测试(例如,交叉已被遍历的光线)的专用电路系统的第二集合。因此,多核组3100a可仅仅启动光线探头,并且光线追踪核3150独立执行光线遍历和交叉并且将命中数据(例如,命中、无命中、多次命中等)返回到线程上下文。在光线追踪核3150执行遍历和交叉操作的同时,其他核3130、3140可以被释放以执行其他图形或计算工作。

262.每个光线追踪核3150可以包括用于执行bvh测试操作的遍历单元和执行光线-图元交叉测试的交叉单元。交叉单元然后可以生成“命中”、“无命中”或“多次命中”响应,交叉单元将该响应提供到适当的线程。在遍历和交叉操作期间,其他核(例如,图形核3130和张量核3140)的执行资源可以被释放以执行其他形式的图形工作。

263.还可以使用混合光栅化/光线追踪方法,其中在图形核3130与光线追踪核3150之间分布工作。

264.光线追踪核3150(和/或其他核3130、3140)可以包括对诸如microsoft的directx光线追踪(dxr)之类的光线追踪指令集的硬件支持,所述dxr包括dispatchrays命令以及光线-生成、最接近-命中、任何-命中和未命中着色器,这些实现对每个对象指派纹理和着色器的独特集合。可由光线追踪核3150、图形核3130和张量核3140支持的另一光线追踪平台是vulkan 1.1.85。然而,注意本发明的基础原理不限于任何特定光线追踪isa。

265.一般而言,各种核3150、3140、3130可支持光线追踪指令集,所述光线追踪指令集包括用于光线生成、最接近命中、任何命中、光线-图元交叉、每图元和分层包围盒构造、未命中、访问和异常的指令/功能。更特定地,光线追踪指令可以被包括以执行以下功能:光线生成

ꢀ–ꢀ

可为每个像素、样本或其他用户定义的工作指派执行光线生成指令。

266.最接近命中

ꢀ–ꢀ

可执行最接近命中指令,以用场景内的图元来定位光线的最接近交点。

267.任何命中

ꢀ‑ꢀ

任何命中指令标识场景内的图元与光线之间的多个交叉,潜在地标识新的最接近交点。

268.交叉

ꢀ‑ꢀ

交叉指令执行光线-图元交叉测试并且输出结果。

269.每图元包围盒构造

ꢀ‑ꢀ

此指令围绕给定图元或图元的组构建包围盒(例如,在构建

新的bvh或其他加速数据结构时)。

270.未命中

ꢀ–ꢀ

指示光线未命中场景的指定区或场景内的所有几何结构。

271.访问

ꢀ–ꢀ

指示光线将遍历的子代体积。

272.异常

ꢀ‑ꢀ

包括各种类型的异常处理程序(例如,针对各种误差状况而被调用)。

273.分层光束追踪包围体层级普遍用于改进在图形图元和其他图形对象上执行操作的效率。bvh是基于几何对象的集合而构建的分层树形结构。在树形结构顶上的是根节点,其封闭给定场景中的所有几何对象。在形成树的叶节点的包围体中包裹个体几何对象。这些节点然后被分组为小集合且被封闭在更大包围体内。这些进而还以递归方式而被分组和封闭在其他更大包围体内,从而最终得到具有树顶部处的由根节点表示的单个包围体的树形结构。包围体层级用于高效地支持几何对象集合上的多种操作,诸如碰撞检测、图元剔除以及在光线追踪中使用的光线遍历/交叉操作。

274.在光线追踪架构中,使光线遍历通过bvh以确定光线-图元交叉。例如,如果光线未经过bvh的根节点,那么光线不与由bvh封闭的图元中的任一个交叉,并且对于光线而言关于该组图元不需要进一步处理。如果光线经过bvh的第一子节点但未经过第二子节点,那么不需要针对由第二子节点封闭的任何图元而测试光线。以该方式,bvh提供了针对光线-图元交叉进行测试的高效机制。

275.可以针对bvh而测试被称作“光束”的邻接光线的组,而不是个体光线。图32图示了由四个不同光线概述的示例性光束3201。与由四个光线定义的补片3200交叉的任何光线被视为处于相同光束内。尽管图32中的光束3201由光线的矩形布置定义,但可以以各种其他方式定义光束,同时仍符合本发明的基础原理(例如圆形、椭圆形等)。

276.图33图示了gpu 3320的光线追踪引擎3310如何实现本文描述的光束追踪技术。特别地,光线生成电路系统3304生成要针对其而执行遍历和交叉操作的多个光线。然而,不是在个体光线上执行遍历和交叉操作,而是使用由光束层级构造电路系统3305生成的光束层级3307来执行遍历和交叉操作。光束层级与包围体层级(bvh)相似。例如,图34提供了可被细分成多个不同组件的主光束3400的示例。特别地,主光束3400可以被划分成象限3401-3404,并且每个象限自身可以被划分成子象限,诸如象限3404内的子象限a-d。主光束可以是以多种方式细分的。例如,主光束可以被划分成两半(而不是象限),并且每一半可以被划分成两半,依此类推。不论如何作出细分,都以与bvh类似的方式生成分层结构,例如,其中根节点表示主光束3400,第一级子节点各自由象限3401-3404表示,第二级子节点针对每个子象限a-d,依此类推。

277.一旦光束层级3307被构造,遍历/交叉电路系统3306就可以使用光束层级3307和bvh 3308来执行遍历/交叉操作。特别地,它可以针对bvh而测试光束并剔除光束的不与bvh的任何部分交叉的部分。使用例如图34中所示的数据,如果与子区3402和3403相关联的子光束不与bvh或bvh的特定分支交叉,那么可以关于bvh或分支而剔除它们。可以通过执行深度优先搜索或其他搜索算法来针对bvh而测试剩余部分3401、3404。

278.在图35中图示了用于光线追踪的方法。该方法可以是在上述图形处理架构的上下文内实现的,但不限于任何特定架构。

279.在3500处,构造包括多个光线的主光束,并且在3501处,对光束进行细分并生成分

层数据结构以创建光束层级。可以作为从多个光线构造光束层级的单个集成操作而执行操作3500-3501。在3502处,与bvh一起使用光束层级以从bvh剔除光线(来自光束层级)和/或节点/图元。在3503处,针对剩余光线和图元而确定光线-图元交叉。

280.分布式光线追踪系统中的有损和无损分组压缩光线追踪操作可以跨在网络上耦合在一起的多个计算节点而分布。图36例如图示了包括多个光线追踪节点3610-3613的光线追踪集群3600,该多个光线追踪节点3610-3613并行执行光线追踪操作,从而在节点之一上潜在地组合结果。在所图示的架构中,光线追踪节点3610-3613经由网关而通信耦合到客户端侧光线追踪应用3630。

281.关于分布式架构的困难之一是必须在光线追踪节点3610-3613中的每一个之间传输的大量分组化数据。可以使用无损压缩技术和有损压缩技术两者,以减少在光线追踪节点3610-3613之间传输的数据。

282.为了实现无损压缩而不是发送充满某些类型的操作的结果的分组,发送允许接收节点重构结果的数据或命令。例如,随机采样的区域光和环境遮蔽(ao)操作不必然需要方向。因此,发射节点可以仅仅发送随机种子,该随机种子然后被接收节点使用以执行随机采样。例如,如果场景跨节点3610-3612而分布,则为了在点p1-p3处对光1进行采样,仅需要将光id和原点发送到节点3610-3612。节点中的每一个然后可以独立地对光进行随机采样。随机种子可以由接收节点生成。类似地,对于主光线命中点,可以在不针对连续帧等待原点的情况下在节点3610-3612上计算环境遮蔽(ao)和软阴影采样。另外,如果已知光线集合将去往相同点光源,则可以将识别光源的指令发送到接收节点,该接收节点会将它应用于光线集合。作为另一示例,如果存在单点传输的n个环境遮蔽光线,则可以发送从该点生成n个样本的命令。

283.可以针对有损压缩而应用各种另外技术。例如,可以采用量化因子以对与bvh、图元和光线相关联的所有坐标值进行量化。另外,可以将针对诸如bvh节点和图元之类的数据而使用的32位浮点值转换成8位整数值。在示例性实现中,以全精度存储光线分组的边界,但将个体光线点p1-p3作为经编索引的偏移而传输到边界。类似地,可以生成使用8位整数值作为局部坐标的多个局部坐标系。可以使用全精度(例如,32位浮点)值来对这些局部坐标系中的每一个的原点的位置进行编码,从而有效地连接全局和局部坐标系。

284.以下是无损压缩的示例。在光线追踪程序中内部使用的光线数据格式的示例如下:struct ray{

ꢀꢀ

uint32 pixid;

ꢀꢀ

uint32 materialid;

ꢀꢀ

uint32 instanceid;

ꢀꢀ

uint64 primitiveid;

ꢀꢀ

uint32 geometryid;

ꢀꢀ

uint32 lightid;

ꢀꢀ

float origin[3];

ꢀꢀ

float direction[3];

ꢀꢀ

float t0;

ꢀꢀ

float t;

ꢀꢀ

float time;

ꢀꢀ

float normal[3]; //用于几何交叉

ꢀꢀ

float u;

ꢀꢀ

float v;

ꢀꢀ

float wavelength;

ꢀꢀ

float phase; //干涉法

ꢀꢀ

float refractedoffset; //纹影法

ꢀꢀ

float amplitude;

ꢀꢀ

float weight; };

[0285]

取代发送针对所生成的每一个节点的原始数据,可以通过对值进行分组并且通过在可能的情况下使用适用元数据创建隐式光线,来压缩该数据。

[0286]

对光线数据进行捆绑和分组可以针对具有修饰语的公共数据或掩码而使用标志(flag)。

[0287]

struct raypacket{

ꢀꢀ

uint32 size;

ꢀꢀ

uint32 flags;

ꢀꢀ

list《ray》 rays;}例如:raypacket.rays = ray_1 至 ray_256。

[0288]

原点全部被共享除了跨所有光线而存储仅单个原点外,所有光线数据被打包。针对raypacket_common_origin而设置raypacket.flags。当raypacket在被接收到时未被打包时,从单个原点值填入原点。

[0289]

仅在一些光线之间共享原点除共享原点的光线外,所有光线数据被打包。对于唯一共享原点的每个组,对操作符进行打包,该操作符标识操作(共享原点)、存储原点并标记哪些光线共享信息。这种操作可以在节点之间的任何共享值(诸如材料id、图元id、原点、方向、法线等)上完成。

[0290]

struct rayoperation{

ꢀꢀ

uint8 operationid;

ꢀꢀ

void* value;

ꢀꢀ

uint64 mask;}

[0291]

发送隐式光线

时常,可以在接收端上利用用于生成光线数据的最小元信息导出该光线数据。非常普遍的示例是生成多个次级光线以对区域进行随机采样。取代发送者生成次级光线、发送它并且接收者对它进行操作,发送者可以发送需要利用任何相关信息生成光线的命令,并且在接收端上生成该光线。在需要首先由发送者生成光线以确定将它发送到哪个接收者的情况下,生成光线并且可以发送随机种子以再生完全相同的光线。

[0292]

例如,为了利用对区域光源进行采样的64个阴影光线对命中点进行采样,所有64个光线与来自相同计算n4的区交叉。创建具有公共原点和法线的raypacket。如果希望接收者对所得到的像素贡献进行着色,则可以发送更多数据,但是对于该示例,让我们假定希望仅返回光线是否命中另一节点数据。针对生成阴影光线操作而创建rayoperation,并且给rayoperation指派要采样的lightid的值和随机数种子。当n4接收到光线分组时,它通过对所有光线填入共享原点数据并基于利用随机数种子而随机采样的lightid设置方向,来生成完全填充的光线数据,以生成原始发送者生成的相同光线。当结果被返回时,仅需要返回针对每个光线的二进制结果,其可以通过光线上的掩码而转交。

[0293]

在该示例中发送原始64个光线将使用104个字节*64个光线=6656个字节。如果返回光线也是以它们的原始形式发送的,那么这还被加倍到13312个字节。使用在仅发送公共光线原点、法线的情况下的无损压缩以及具有种子和id的光线生成操作,利用针对交叉掩码而返回的8个字节发送仅29个字节。这导致需要在~360:1的网络上发送的数据压缩率。这不包括自身处理消息的开销,其将需要以某种方式而标识,但这由实现决定。可以完成其他操作,以用于根据针对主光线的pixelid重新估算光线原点和方向、基于光线分组中的范围来重新计算pixelid、以及值的重新估算的许多其他可能实现。类似操作可以用于所发送的任何光线或光线组,包括阴影、反射、折射、环境遮蔽、交叉、体积交叉、着色、路径追踪中的反弹反射等。

[0294]

图37图示了针对执行光线追踪分组的压缩和解压缩的两个光线追踪节点3710-3711的另外细节。特别地,当第一光线追踪引擎3730准备好将数据传输到第二光线追踪引擎3731时,光线压缩电路系统3720执行如本文描述的光线追踪数据的有损和/或无损压缩(例如将32位值转换成8位值、用原始数据替代重构数据的指令等)。在本地网络(例如,10gb/s、100gb/s以太网网络)上将经压缩的光线分组3710从网络接口3725传输到网络接口3726。光线解压缩电路系统然后在适当时对光线分组进行解压缩。例如,它可以执行重构光线追踪数据(例如,使用随机种子以执行针对照明操作的随机采样)的命令。光线追踪引擎3731然后使用所接收到的数据以执行光线追踪操作。

[0295]

在相反方向上,光线压缩电路系统3741压缩光线数据,网络接口3726在网络上传输经压缩的光线数据(例如, 使用本文描述的技术),光线解压缩电路系统3740在必要时对光线数据进行解压缩,并且光线追踪引擎3730在光线追踪操作中使用该数据。尽管在图37中被图示为单独的单元,但光线解压缩电路系统3740-3741可以分别集成在光线追踪引擎3730-3731内。例如,就经压缩的光线数据包括重构光线数据的命令而言,这些命令可以由每个相应光线追踪引擎3730-3731执行。

[0296]

如图38中所图示,光线压缩电路系统3720可以包括:有损压缩电路系统3801,用于执行本文描述的有损压缩技术(例如,将32位浮点坐标转换成8位整数坐标);以及无损压缩电路系统3803,用于执行无损压缩技术(例如,传输命令和数据以允许光线重新压缩电路系

统3821重构数据)。光线解压缩电路系统3721包括有损解压缩电路系统3802和用于执行无损解压缩的无损解压缩电路系统3804。

[0297]

在图39中图示了另一示例性方法。该方法可以被实现在本文描述的光线追踪架构或其他架构上,但不限于任何特定架构。

[0298]

在3900处,接收将从第一光线追踪节点传输到第二光线追踪节点的光线数据。在3901处,有损压缩电路系统在第一光线追踪数据上执行有损压缩,并且在3902处,无损压缩电路系统在第二光线追踪数据上执行无损压缩。在3903处,将经压缩的光线追踪数据传输到第二光线追踪节点。在3904处,有损/无损解压缩电路系统执行光线追踪数据的有损/无损解压缩,并且在3905处,第二光线追踪节点执行对经解压缩的数据的光线追踪操作。

[0299]

具有硬件加速混合光线追踪的图形处理器接下来呈现混合渲染流水线,其在图形核3130上执行光栅化并在光线追踪核3150、图形核3130和/或cpu 3199核上执行光线追踪操作。例如,可以在图形核3130上执行光栅化和深度测试,以替代主光线投射级。光线追踪核3150然后可以生成针对光线反射、折射和阴影的次级光线。另外,将选择其中光线追踪核3150将执行光线追踪操作(例如,基于材料性质阈值,诸如高反射率级别)的场景的某些区,同时将利用图形核3130上的光栅化来渲染场景的其他区。该混合实现可以用于实时光线追踪应用——其中时延是关键问题。

[0300]

下述光线遍历架构可以例如在使用专用硬件来加速关键功能(诸如,bvh遍历和/或交叉)的同时,使用现有单指令多数据(simd)和/或单指令多线程(simt)图形处理器来执行光线遍历的可编程着色和控制。可以通过在遍历期间以及在着色之前的特定点处对派生着色器重新分组来改进针对不相干路径的simd占用。这是使用对着色器进行动态分类的专用硬件在片上实现的。通过将功能拆分成在返回时执行的延续部分并在执行之前针对改进的simd占用而对延续部分重新分组,来管理递归。

[0301]

通过将遍历功能性分解成内部遍历和外部遍历来实现光线遍历/交叉的可编程控制,该内部遍历可以被实现为固定功能硬件,该外部遍历在gpu处理器上执行并通过用户定义的遍历着色器来实现可编程控制。通过在内部和外部遍历之间的过渡期间保守地截断内部遍历状态,来降低在硬件与软件之间传送遍历上下文的成本。

[0302]

可以通过在下表a中列出的不同着色器类型来表达光线追踪的可编程控制。可以存在针对每个类型的多个着色器。例如,每个材料可以具有不同的命中着色器。着色器类型功能性主启动主光线命中双向反射比分布函数(brdf)采样,启动次级光线任何命中计算针对阿尔法纹理几何结构的透射比未命中计算来自光源的辐射交叉使定制形状交叉遍历实例选择和变换可调用通用函数

[0303]

表a递归光线追踪可以由api函数发起,api函数命令图形处理器启动可派生针对主光线的光线-场景交叉的主着色器或交叉电路系统的集合。这进而派生其他着色器,诸如遍

历、命中着色器或未命中着色器。派生子着色器的着色器还可以从该子着色器接收返回值。可调用着色器是可直接由另一着色器派生且还可将值返回给调用着色器的通用函数。

[0304]

图40图示了包括着色器执行电路系统4000和固定功能电路系统4010的图形处理架构。通用执行硬件子系统包括多个单指令多数据(simd)和/或单指令多线程(simt)核/执行单元(eu)4001(即,每个核可以包括多个执行单元)、一个或多个采样器4002和1级(l1)高速缓存4003或其他形式的本地存储器。固定功能硬件子系统4010包括消息单元4004、调度器4007、光线-bvh遍历/交叉电路系统4005、分类电路系统4008和本地l1高速缓存4006。

[0305]

在操作中,主分派器4009将主光线的集合分派到调度器4007,调度器4007将工作调度给在simd/simt核/eu 4001上执行的着色器。simd核/eu 4001可以是上述光线追踪核3150和/或图形核3130。主着色器的执行派生要执行(例如,要由一个或多个子着色器和/或固定功能硬件执行)的另外工作。消息单元4004将由simd核/eu 4001派生的工作分发给调度器4007从而按照需要访问空闲栈池、分发给分类电路系统4008或光线-bvh交叉电路系统4005。如果另外的工作被发送到调度器4007,则对它进行调度以用于在simd/simt核/eu 4001上处理。在调度之前,分类电路系统4008可以如本文描述的那样将光线分类成组或箱(例如,对具有类似特性的光线进行分组)。光线-bvh交叉电路系统4005使用bvh体积来执行光线的交叉测试。例如,光线-bvh交叉电路系统4005可以将光线坐标与bvh的每个级别进行比较以识别被光线交叉的体积。

[0306]

可以使用着色器记录、包括指向入口函数的指针的用户分配的结构、供应商特定元数据、以及对由simd核/eu 4001执行的着色器的全局参数,来引用着色器。着色器的每个执行实例与调用栈相关联,该调用栈可以用于存储在父着色器与子着色器之间传递的参数。调用栈还可以存储对在调用返回时执行的延续函数的引用。

[0307]

图41图示了所指派的栈4101的示例集合,栈4101包括主着色器栈、命中着色器栈、遍历着色器栈、延续函数栈和光线-bvh交叉栈(如所描述的那样,其可以由固定功能硬件4010执行)。新着色器调用可以实现来自空闲栈池4102的新栈。可以在本地l1高速缓存4003、4006中高速缓存调用栈(例如,所指派的栈的集合所包括的栈),以减小访问的时延。

[0308]

可以存在有限数量的调用栈,每个调用栈具有在邻接存储区中分配的固定最大大小“sstack”。因此,可以根据栈索引(sid)直接计算栈的基址,作为基址 = sid * sstack。栈id可以被调度器4007在将工作调度给simd核/eu 4001时分配和解除分配。

[0309]

主分派器4009可以包括:图形处理器命令处理器,其响应于来自主机(例如,cpu)的分派命令而分派主着色器。调度器4007可以接收这些分派请求,并且如果它可以分配针对每个simd通道的栈id,则它在simd处理器线程上启动主着色器。可以从在分派命令的开始处初始化的空闲栈池4102分配栈id。

[0310]

执行着色器可以通过将派生消息发送到消息传递单元4004来派生子着色器。该命令包括与着色器相关联的栈id,且还包括指向针对每个活跃simd通道的子着色器记录的指针。父着色器可以针对活跃通道仅发出该消息一次。在发送针对所有相关通道的派生消息之后,父着色器可以终止。

[0311]

在simd核/eu 4001上执行的着色器还可以使用具有针对固定功能硬件而预留的着色器记录指针的派生消息,来派生固定功能任务,诸如光线-bvh交叉。如所提及的那样,消息传递单元4004将所派生的光线-bvh交叉工作发送到固定功能光线-bvh交叉电路系统

4005,并将可调用着色器直接发送到分类电路系统4008。分类电路系统可以通过着色器记录指针来对着色器进行分组,以导出具有类似特性的simd批量。相应地,来自不同父着色器的栈id可以由分类电路系统4008分组在相同批量中。分类电路系统4008将经分组的批量发送到调度器4007,调度器4007访问来自图形存储器2511或末级高速缓存(llc)4020的着色器记录并在处理器线程上启动着色器。

[0312]

延续部分可以被视为可调用着色器,且还可以通过着色器记录而引用。当子着色器被派生且将值返回给父着色器时,可以在调用栈4101上推送指向延续部分着色器记录的指针。当子着色器返回时,然后可以从调用栈4101弹出延续部分着色器记录并且可以派生延续部分着色器。可选地,所派生的延续部分可以经过与可调用着色器类似的分类单元,并得以在处理器线程上启动。

[0313]

如图42中所图示,分类电路系统4008通过着色器记录指针4201a、4201b、4201n来对所派生的任务进行分组,以创建用于着色的simd批量。可以从不同分派和不同输入simd通道对经分类的批量中的栈id或上下文id进行分组。分组电路系统4210可以使用包括多个条目的内容可寻址存储器(cam)结构4201来执行分类,其中每个条目是利用标签4201标识的。如所提及的那样,标签4201可以是对应着色器记录指针4201a、4201b、4201n。cam结构4201可以存储各自与对应于着色器记录指针的不完整simd批量相关联的有限数量的标签(例如32、64、128等)。

[0314]

对于传入的派生命令,每个simd通道具有对应栈id(被示作每个cam条目中16个上下文id 0-15)和着色器记录指针4201a-b、

……

n(充当标签值)。分组电路系统4210可以将针对每个通道的着色器记录指针与cam结构4201中的标签4201进行比较,以找到匹配批量。如果匹配批量被找到,则可以将栈id/上下文id添加到批量。否则,可以创建具有新着色器记录指针标签的新条目,从而可能驱逐具有不完整批量的较旧条目。

[0315]

执行着色器可以在调用栈为空时通过将解除分配消息发送到消息单元来对调用栈解除分配。解除分配消息被中继到调度器,该调度器将针对活跃simd通道的栈id/上下文id返回给空闲池。

[0316]

呈现使用固定功能光线遍历和软件光线遍历的组合的用于光线遍历操作的混合方法。因此,它在维持固定功能遍历的效率的同时提供了软件遍历的灵活性。图43示出了可以用于混合遍历的加速结构,其为具有单个顶级bvh 4300以及若干底级bvh 4301和4302的两级树。右侧示出了图形元素,以指示内部遍历路径4303、外部遍历路径4304、遍历节点4305、具有三角形的叶节点4306和具有定制图元的叶节点4307。

[0317]

顶级bvh 4300中的具有三角形的叶节点4306可以引用三角形、针对定制图元的交叉着色器记录、或遍历着色器记录。底级bvh 4301-4302的具有三角形的叶节点4306仅可以引用三角形和针对定制图元的交叉着色器记录。引用的类型被封闭在叶节点4306内。内部遍历4303指代每个bvh 4300-4302内的遍历。内部遍历操作包括光线-bvh交叉的计算,并且跨bvh结构4300-4302的遍历被称作外部遍历。可以在固定功能硬件中高效地实现内部遍历操作,而可以利用关于可编程着色器的可接受性能执行外部遍历操作。因此,可以使用固定功能电路系统4010来执行内部遍历操作,并且可以使用包括用于执行可编程着色器的simd/simt核/eu 4001的着色器执行电路系统4000来执行外部遍历操作。

[0318]

注意,为了简明,simd/simt核/eu 4001在本文中有时被简称作“核”、“simd核”、“eu”或“simd处理器”。类似地,光线-bvh遍历/交叉电路系统4005有时被简称作“遍历单元”、“遍历/交叉单元”或“遍历/交叉电路系统”。当使用可替换术语时,用于标明相应电路系统/逻辑的特定名称不更改电路系统/逻辑所执行的基础功能,如本文描述的那样。

[0319]

此外,尽管在图40中出于解释的目的而被图示为单个组件,但遍历/交叉单元4005可以包括不同的遍历单元和单独的交叉单元,其中每一个可以在如本文描述的电路系统和/或逻辑中实现。

[0320]

当光线在内部遍历期间与遍历节点交叉时,可以派生遍历着色器。分类电路系统4008可以通过着色器记录指针4201a-b、n来对这些着色器进行分组,以创建由调度器4007启动的simd批量,以用于在图形simd核/eu4001上的simd执行。遍历着色器可以以若干方式修改遍历,从而启用大范围的应用。例如,遍历着色器可以在更粗细节水平(lod)处选择bvh或者变换光线,以实现刚性体变换。遍历着色器然后可以针对所选择的bvh而派生内部遍历。

[0321]

内部遍历通过对bvh进行遍历并计算光线-盒和光线-三角形交叉来计算光线-bvh交叉。通过将消息发送到消息传递电路系统4004来以与着色器相同的方式派生内部遍历,消息传递电路系统4004将对应的派生消息中继到光线-bvh交叉电路系统4005,光线-bvh交叉电路系统4005计算光线-bvh交叉。

[0322]

针对内部遍历的栈可以被本地存储在固定功能电路系统4010中(例如,在l1高速缓存4006内)。当光线与对应于遍历着色器或交叉着色器的叶节点交叉时,可以终止内部遍历并且可以截断内部栈。可以在由调用着色器指定的位置处连同指向光线和bvh的指针一起将经截断的栈写入到存储器,并且然后可以派生对应的遍历着色器或交叉着色器。如果光线在内部遍历期间与任何三角形交叉,则可以将对应命中信息作为输入参数而提供给这些着色器,如下面的代码中所示。这些派生着色器可以由分类电路系统4008分组,以创建用于执行的simd批量。

[0323]

structhitinfo{

ꢀꢀꢀꢀ

floatbarycentrics[2];

ꢀꢀꢀꢀ

floattmax;

ꢀꢀꢀꢀ

boolinnertravcomplete;

ꢀꢀꢀꢀ

uintprimid;

ꢀꢀꢀꢀ

uintgeomid;

ꢀꢀꢀꢀ

shaderrecord*leafshaderrecord;}

[0324]

截断内部遍历栈降低了使其溢出到存储器的成本。在restarttrailforstacklessbvhtraversal,highperformancegraphics(2010),pp.107

–

111中描述的方法,为了在栈的顶部处将栈截断到少量的条目,可以应用42位重启尾部和6位深度值。重启尾部指示已经在bvh内部取得的分支,并且深度值指示与最后栈条目相对应的遍历的深度。这是在稍后的时间处恢复内部遍历的足够信息。

[0325]

当内部栈为空并且不存在更多bvh节点要测试时,内部遍历是不完整的。在该情况下,派生外部栈处理程序,其弹出外部栈的顶部并在外部栈不为空的情况下恢复遍历。

[0326]

外部遍历可以执行主要遍历状态机,且可以被实现在由着色器执行电路系统4000

执行的程序代码中。它可以在以下条件下派生内部遍历查询:(1)当新光线被命中着色器或主着色器派生时;(2)当遍历着色器针对遍历而选择bvh时;以及(3)当外部栈处理程序针对bvh而恢复内部遍历时。

[0327]

如图44中所图示,在内部遍历被派生之前,在调用栈4405上分配空间以供固定功能电路系统4010存储经截断的内部栈4410。在也在存储器2511中存储的遍历状态4400中维持到调用栈和内部栈的顶部的偏移4403-4404。遍历状态4400还包括世界空间4401和对象空间4402中的光线以及针对最接近交叉图元的命中信息。

[0328]

遍历着色器、交叉着色器和外部栈处理程序都由光线-bvh交叉电路系统4005派生。遍历着色器在发起针对第二级bvh的新内部遍历之前在调用栈4405上分配。外部栈处理程序是负责更新命中信息且恢复任何未决内部遍历任务的着色器。外部栈处理程序还负责在遍历完成时派生命中或未命中着色器。当不存在未决内部遍历查询要派生时,遍历完成。当遍历完成并且交叉被找到时,派生命中着色器;否则,派生未命中着色器。

[0329]

尽管上述混合遍历方案使用两级bvh层级,但还可以实现具有外部遍历实现中的对应改变的任意数量的bvh级别。

[0330]

另外,尽管上面描述了用于执行光线-bvh交叉的固定功能电路系统4010,但还可以在固定功能电路系统中实现其他系统组件。例如,上述外部栈处理程序可以是可潜在地在固定功能bvh遍历/交叉电路系统4005中实现的内部(非用户可见)着色器。该实现可以用于减少所分派的着色器级的数量以及固定功能交叉硬件4005与处理器之间的往返旅程。

[0331]