1.本发明涉及一种数据治理模型及方法,具体为一种基于政务数据的治理模型及方法,属于数据治理技术领域。

背景技术:

2.随着信息技术的发展,政府部门将信息科技运用于行政组织的管理,已经成为一个普遍趋势,政府部门产生的数据被广泛应用于社会各领域,在政府管理与决策、政府服务、企业经营与决策、个人发展等活动中发挥着重要的作用,其作为国家基础性战略资源,权威性高、体量巨大,具有很高的开发利用价值,受到各界的高度重视和普遍关注。

3.在申请号为cn201911038460.2的中国发明专利中提出一种构建政务大数据治理体系的方法,实现了将业务数据与二、三维图形数据进行有效的融合,实现多维度的立体化的数据信息呈现,辅助决策者进行议案的决策。

4.各政府部门信息系统和数据的不断增加正面临复杂的数据环境,而信息系统多、数据标准不统一、数据不一致、数据不完整等问题日益凸显,数据不能有效共享,一定程度上制约了数据的开发和使用,影响了数据价值的发挥,这不仅将政务数据的统一管理陷入困境,也对政务数据的有效开发、高效利用和数据要素市场的供给水平带来了极大的挑战,上述对比文件也并未有效的解决该问题。

5.有鉴于此特提出本发明。

技术实现要素:

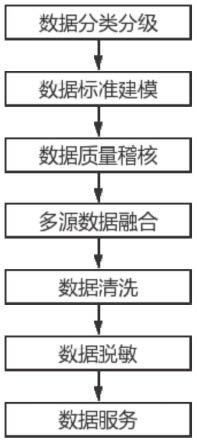

6.本发明的目的就在于为了解决上述问题而提供一种基于政务数据的治理模型及方法,通过数据分类分级对数据元进行标准化,按照统一标准及口径,对政务数据进行数据质量稽核、多源数据融合、数据清洗、数据脱敏,提高政务数据的质量,再以数据服务形式对外提供更精准的数据服务,充分发挥数据的价值,形成政务数据资产,实现数据增值,为数据共享交换和数据开放提供体系化支撑,驱动政府数据服务创新。

7.本发明通过以下技术方案来实现上述目的,一种基于政务数据的治理模型,包括数据分类分级模块、数据标准建模模块、数据质量稽核模块、多源数据融合模块、数据清洗模块、数据脱敏模块和数据服务模块。

8.一种基于政务数据的治理方法,通过数据分类分级模块、数据标准建模模块、数据质量稽核模块、多源数据融合模块、数据清洗模块、数据脱敏模块和数据服务模块共同实现。

9.基于政务数据的治理方法,包括以下步骤:

10.1)数据分类分级,是确定数据保护和利用之间平衡点的一个重要依据,为各类数据的安全保护奠定了基础。数据分类分级主要根据政务数据的属性和特征,按照数据的多维特征及其相互间客观存在的逻辑关联进行系统化归类和符合数据实际情况的区分和归类,并建立起一定的分类体系和排列顺序,其目的是更好的管理和使用政务数据。

11.2)数据标准,对信息系统所涉及的各项数据的定义与解释,是数据质量规则、数据管理与应用的基础。数据标准建模是根据数据元标准将数据目录与数据元标准建立关联模型的过程。

12.3)数据质量稽核,按照数据元标准规则和设置的检查维度、规则对数据进行多方位的校验检查,数据质量检查完成后,会将结果数据存储到指定数据库中,并生成质量报告,也可以对检查出的问题数据,指派给相应的数据提供方进行查询与整改。

13.4)数据融合,对多来源数据分析处理的过程,目的是得出更准确、统一的信息,通常用来增强决策过程。

14.5)数据清洗,把不符合质量规则的数据清洗过滤出来进行加工处理,也是一个将脏数据替换成高质量可用数据的过程。

15.6)数据脱敏,也是数据去隐私化,对不同的数据值设置不同的数据脱敏规则,通过脱敏规则进行数据的变形。

16.7)数据服务,数据服务主要是解决数据最后一公里的问题,通过所述数据服务模块将数据资产通过在线化配置api的方式提供给业务方调用,数据服务以目录的方式对外发布,使用者可以查询到相应的数据服务,申请使用,经过审核审批管理后,使用者才能使用数据提供者的数据服务。

17.进一步,在步骤1)中,数据分类分级方法如下:

18.一、制定数据分类分级标准,制定数据分类分级标准需根据国家相关标准、行业相关标准,结合政府业务特性制定地方政务数据分类分级标准。数据分类强调的是根据种类的不同按照属性、特征而进行的划分,可以根据政务数据所描述的主体对象、所属领域、所属部门、所属行业进行划分。数据分级侧重于按照划定的某种标准,对同一类别的属性按照高低、大小进行级别的划分,可以根据数据的共享类别、开放类别、主体对象、数据特征、数据体量、敏感程度、影响程度综合考量划分。

19.二、梳理分类分级识别规则,根据数据分类分级标准,梳理分类分级识别规则,形成分类分级规则的相关模板。

20.三、数据资产准备,根据数据分类分级标准中所关联的维度,例如主体对象、所属领域、所属部门、所属行业、数据特征、数据体量、敏感程度、影响程度,对数据目录进行标记与划分,为后续分类分级工作打好基础。

21.四、分类分级建模,通过数据内容分析、机器学习手段根据分类分级识别规则对数据资产进行智能分析,形成数据分类分级的策略规则及模型模板。

22.五、分类分级判定,按照已配置的时间周期自动扫描,智能分析,并输出分类分级结果。

23.持续更新,数据具有自我繁衍性,会在使用中产生更多的数据,其数据体量、影响程度会随之变化,因此数据的分类分级也需要持续更新与维护。

24.进一步的,在步骤2)中,数据标准建模方法如下:

25.一、梳理数据元信息。根据数据元标准文件中定义的标准数据元结合系统中制定的标准化模板梳理出数据元的信息。

26.二、新增/导入数据元信息。将数据元信息录入/导入系统中,并提交审核。数据元信息包括中文名称、内部标识符、中文全拼、英文名称、定义、数据类型、数据长度、数据格

式、计量单位、值域说明、关联代码、关联数据元、备注,参考来源的标准类型、标准号、标准名称、实施日期、是否强制实施。

27.三、审核发布。数据元信息提交后,需要走相应的审核、发布流程,确保数据元信息的准确性。

28.四、关联数据元。梳理政务信息资源目录中与标准数据元的关联关系,并建立关联模型,形成对标准数据元的统一规范管理。

29.五、建立数据模型。在对标准数据元统一规范管理的基础上建立与质量规则、数据模型的关系,形成统一标准规则库。

30.六、维护与管理。数据标准可进行维护和管理,如果数据模型建立完成之后,有新增或更新的数据元标准,可以相应的进行调整走相应的审核发布流程,进而保障数据标准的更新、发布、使用的管理。

31.进一步的,在步骤3)中,数据质量稽核的方法如下:

32.一、创建数据稽核规则。创建数据多维度规则检查,是数据质量稽核的前提条件。可以根据及时性、可用性、完整性、规范性、准确性、一致性这些维度设置数据多维度的检查规则,包括设置维度编号、维度名称、配分值、计算方法、描述。创建配分值、计算方法是为了评估数据质量优劣程度的依据,也是生成质量报告中得分的依据。

33.二、实体数据关联数据稽核规则。创建数据稽核规则后,需要把实体数据与数据稽核规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法、维度、描述。

34.三、数据质量精细化检查。数据质量精细化检查前需要创建质量检查服务,引用质量规则方法,并运行服务,进而开展数据质量精细化检查。数据质量精细化检查后会把有问题的数据抽取到问题库中。

35.四、生成质量报告。根据数据质量精细化检查的结果和数据稽核规则设置的配分值、计算方法,最终会形成各数据提供方的数据质量报告。

36.五、问题数据反馈及整改。生成质量报告后,可以把质量报告分派给各数据提供方,供其查阅问题数据,并开展问题数据整改工作。

37.六、数据统计展示。数据统计展示可以对各数据提供方的数据检查维度、数据检查结果、质量报告分派情况、问题数据整改情况进行可视化展示,便于整体了解数据质量稽核情况。

38.七、监控与维护。把数据质量稽核所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据质量稽核工作的正常运行。

39.进一步的,在步骤4)中,多源数据融合方法如下:

40.一、选择需要融合的表。开展多源数据融合的第一步,是在数据库中选择需要融合的表或者数据来源的表。

41.二、建立数据融合模型。建立数据融合模型首先需要分析各数据来源表之间的关联关系和关联字段,从而梳理出一个新的数据模型。

42.三、来源表与数据融合模型关系映射。通过分析出的各数据来源表与数据融合模型之间的关联关系和关联字段,按照新的数据组织逻辑进行关联映射,其目的是加强数据的内在联系。

43.四、设置数据同步规则。分析和明确数据来源表与数据融合模型中数据的同步规

则,进行系统设置。比如数据来源表中删除了某条数据,数据融合模型中该条数据是否同步删除。

44.五、数据融合。按照上述所配置的方法、规则运行相关服务,完成多源数据的融合,最终会形成一张新表。

45.六、监控与维护。把多源数据融合所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障多源数据融合工作的正常运行。

46.进一步的,在步骤5)中,数据清洗的方法如下:

47.一、创建数据清洗规则。创建数据清洗规则是开展数据清洗的前提条件,可以引用数据元标准进行数据标准化清洗,配置相应的数据清洗规则。也可以根据特定的业务需求梳理数据清洗规则,进行数据清洗规则配置。

48.二、实体数据关联数据清洗规则。创建数据清洗规则后,需要把实体数据与数据清洗规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法、维度、描述。

49.三、数据质量清洗检查。数据质量清洗检查前需要创建数据清洗检查服务,引用数据清洗规则和方法,并运行服务,进而开展数据质量清洗检查。数据质量清洗检查后会把不符合数据清洗规则的数据抽取到问题库中,符合数据清洗规则的数据抽取到标准库中。

50.四、问题数据加工处理。检查出的问题数据,需要进行加工处理,将“脏数据”替换成“高质量可用数据”。例如,所创建的数据清洗规则是根据数据元标准设置的,“姓名”在元数据标准中的中文名称为“姓名”、中文全拼为“xing-ming”,英文名称为“name”,数据类型为“字符串型c”,所检查为“姓名”的字段,如果不符合该规范的,将全部进行替换。又如,根据业务需求需要对a表中b列数据进行数据清洗,b列中的数据若不等于a列-c列的值,将全部替换成a列-c列的值。

51.五、“脏数据”回流。当问题数据加工处理完成后,会回流至标准库中,从形成闭环。

52.六、数据统计展示。数据统计展示可以对各数据提供方的数据清洗维度、数据清洗情况、问题数据处理情况进行可视化展示,便于整体了解数据清洗的情况。

53.七、监控与维护。把数据清洗所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据清洗工作的正常运行。

54.进一步的,在步骤6)中,数据脱敏的流程如下:

55.一、创建数据脱敏规则。创建数据脱敏规则是数据脱敏工作的前提条件。数据脱敏规则包括数据加密解密、数据模糊化处理、数据掩饰替换、数字脱敏、数据混洗。

56.二、实体数据关联数据脱敏规则。创建数据脱敏规则后,需要把实体数据与数据脱敏规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法。

57.三、数据脱敏。数据脱敏前需要创建数据脱敏服务,引用数据脱敏规则和方法,并运行服务,进而开展数据脱敏工作。

58.四、脱敏数据入库。数据脱敏后,需要把已脱敏的数据抽取到业务库中,便于数据应用。

59.五、监控与维护。把数据脱敏所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据脱敏工作的正常运行。

60.本发明的技术效果和优点:本发明以提高政务数据质量,对外提供精准的数据服务为目的,通过对数据元进行标准化,按照统一标准及口径,对政务数据进行数据质量稽

核、多源数据融合、数据清洗、数据脱敏,提高政务数据的质量,再以数据服务形式对外提供更精准的数据服务,充分发挥数据的价值,形成政务数据资产,实现数据增值,为数据共享交换和数据开放提供体系化支撑,驱动政府数据服务创新。

附图说明

61.图1为本发明中治理模型的模块示意图;

62.图2为本发明中治理方法的流程图;

具体实施方式

63.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

64.请参阅图1-2所示,一种基于政务数据的治理模型,包括数据分类分级模块、数据标准建模模块、数据质量稽核模块、多源数据融合模块、数据清洗模块、数据脱敏模块和数据服务模块。

65.基于政务数据的治理方法,通过数据分类分级模块、数据标准建模模块、数据质量稽核模块、多源数据融合模块、数据清洗模块、数据脱敏模块和数据服务模块共同实现。

66.基于政务数据的治理方法,包括以下步骤:

67.1)数据分类分级,是确定数据保护和利用之间平衡点的一个重要依据,为各类数据的安全保护奠定了基础。数据分类分级主要根据政务数据的属性和特征,按照数据的多维特征及其相互间客观存在的逻辑关联进行系统化归类和符合数据实际情况的区分和归类,并建立起一定的分类体系和排列顺序,其目的是更好的管理和使用政务数据。

68.2)数据标准,对信息系统所涉及的各项数据的定义与解释,是数据质量规则、数据管理与应用的基础。数据标准建模是根据数据元标准将数据目录与数据元标准建立关联模型的过程。

69.3)数据质量稽核,按照数据元标准规则和设置的检查维度、规则对数据进行多方位的校验检查,数据质量检查完成后,会将结果数据存储到指定数据库中,并生成质量报告,也可以对检查出的问题数据,指派给相应的数据提供方进行查询与整改。

70.4)数据融合,对多来源数据分析处理的过程,目的是得出更准确、统一的信息,通常用来增强决策过程。

71.5)数据清洗,把不符合质量规则的数据清洗过滤出来进行加工处理,也是一个将脏数据替换成高质量可用数据的过程。

72.6)数据脱敏,也是数据去隐私化,对不同的数据值设置不同的数据脱敏规则,通过脱敏规则进行数据的变形。

73.7)数据服务,数据服务主要是解决数据最后一公里的问题,通过所述数据服务模块将数据资产通过在线化配置api的方式提供给业务方调用,数据服务以目录的方式对外发布,使用者可以查询到相应的数据服务,申请使用,经过审核审批管理后,使用者才能使用数据提供者的数据服务。

74.数据分类分级方法如下:

75.一、制定数据分类分级标准,制定数据分类分级标准需根据国家相关标准、行业相关标准,结合政府业务特性制定地方政务数据分类分级标准。数据分类强调的是根据种类的不同按照属性、特征而进行的划分,可以根据政务数据所描述的主体对象、所属领域、所属部门、所属行业进行划分。数据分级侧重于按照划定的某种标准,对同一类别的属性按照高低、大小进行级别的划分,可以根据数据的共享类别、开放类别、主体对象、数据特征、数据体量、敏感程度、影响程度综合考量划分。

76.二、梳理分类分级识别规则,根据数据分类分级标准,梳理分类分级识别规则,形成分类分级规则的相关模板。

77.三、数据资产准备,根据数据分类分级标准中所关联的维度,例如主体对象、所属领域、所属部门、所属行业、数据特征、数据体量、敏感程度、影响程度,对数据目录进行标记与划分,为后续分类分级工作打好基础。

78.四、分类分级建模,通过数据内容分析、机器学习手段根据分类分级识别规则对数据资产进行智能分析,形成数据分类分级的策略规则及模型模板。

79.五、分类分级判定,按照已配置的时间周期自动扫描,智能分析,并输出分类分级结果。

80.持续更新,数据具有自我繁衍性,会在使用中产生更多的数据,其数据体量、影响程度会随之变化,因此数据的分类分级也需要持续更新与维护。

81.数据标准建模方法如下:

82.一、梳理数据元信息。根据数据元标准文件中定义的标准数据元结合系统中制定的标准化模板梳理出数据元的信息。

83.二、新增/导入数据元信息。将数据元信息录入/导入系统中,并提交审核。数据元信息包括中文名称、内部标识符、中文全拼、英文名称、定义、数据类型、数据长度、数据格式、计量单位、值域说明、关联代码、关联数据元、备注,参考来源的标准类型、标准号、标准名称、实施日期、是否强制实施。

84.三、审核发布。数据元信息提交后,需要走相应的审核、发布流程,确保数据元信息的准确性。

85.四、关联数据元。梳理政务信息资源目录中与标准数据元的关联关系,并建立关联模型,形成对标准数据元的统一规范管理。

86.五、建立数据模型。在对标准数据元统一规范管理的基础上建立与质量规则、数据模型的关系,形成统一标准规则库。

87.六、维护与管理。数据标准可进行维护和管理,如果数据模型建立完成之后,有新增或更新的数据元标准,可以相应的进行调整走相应的审核发布流程,进而保障数据标准的更新、发布、使用的管理。

88.数据质量稽核的方法如下:

89.一、创建数据稽核规则。创建数据多维度规则检查,是数据质量稽核的前提条件。可以根据及时性、可用性、完整性、规范性、准确性、一致性这些维度设置数据多维度的检查规则,包括设置维度编号、维度名称、配分值、计算方法、描述。创建配分值、计算方法是为了评估数据质量优劣程度的依据,也是生成质量报告中得分的依据。

90.二、实体数据关联数据稽核规则。创建数据稽核规则后,需要把实体数据与数据稽核规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法、维度、描述。

91.三、数据质量精细化检查。数据质量精细化检查前需要创建质量检查服务,引用质量规则方法,并运行服务,进而开展数据质量精细化检查。数据质量精细化检查后会把有问题的数据抽取到问题库中。

92.四、生成质量报告。根据数据质量精细化检查的结果和数据稽核规则设置的配分值、计算方法,最终会形成各数据提供方的数据质量报告。

93.五、问题数据反馈及整改。生成质量报告后,可以把质量报告分派给各数据提供方,供其查阅问题数据,并开展问题数据整改工作。

94.六、数据统计展示。数据统计展示可以对各数据提供方的数据检查维度、数据检查结果、质量报告分派情况、问题数据整改情况进行可视化展示,便于整体了解数据质量稽核情况。

95.七、监控与维护。把数据质量稽核所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据质量稽核工作的正常运行。

96.多源数据融合方法如下:

97.一、选择需要融合的表。开展多源数据融合的第一步,是在数据库中选择需要融合的表或者数据来源的表。

98.二、建立数据融合模型。建立数据融合模型首先需要分析各数据来源表之间的关联关系和关联字段,从而梳理出一个新的数据模型。

99.三、来源表与数据融合模型关系映射。通过分析出的各数据来源表与数据融合模型之间的关联关系和关联字段,按照新的数据组织逻辑进行关联映射,其目的是加强数据的内在联系。

100.四、设置数据同步规则。分析和明确数据来源表与数据融合模型中数据的同步规则,进行系统设置。比如数据来源表中删除了某条数据,数据融合模型中该条数据是否同步删除。

101.五、数据融合。按照上述所配置的方法、规则运行相关服务,完成多源数据的融合,最终会形成一张新表。

102.六、监控与维护。把多源数据融合所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障多源数据融合工作的正常运行。

103.数据清洗的方法如下:

104.一、创建数据清洗规则。创建数据清洗规则是开展数据清洗的前提条件,可以引用数据元标准进行数据标准化清洗,配置相应的数据清洗规则。也可以根据特定的业务需求梳理数据清洗规则,进行数据清洗规则配置。

105.二、实体数据关联数据清洗规则。创建数据清洗规则后,需要把实体数据与数据清洗规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法、维度、描述。

106.三、数据质量清洗检查。数据质量清洗检查前需要创建数据清洗检查服务,引用数据清洗规则和方法,并运行服务,进而开展数据质量清洗检查。数据质量清洗检查后会把不符合数据清洗规则的数据抽取到问题库中,符合数据清洗规则的数据抽取到标准库中。

107.四、问题数据加工处理。检查出的问题数据,需要进行加工处理,将“脏数据”替换

成“高质量可用数据”。例如,所创建的数据清洗规则是根据数据元标准设置的,“姓名”在元数据标准中的中文名称为“姓名”、中文全拼为“xing-ming”,英文名称为“name”,数据类型为“字符串型c”,所检查为“姓名”的字段,如果不符合该规范的,将全部进行替换。又如,根据业务需求需要对a表中b列数据进行数据清洗,b列中的数据若不等于a列-c列的值,将全部替换成a列-c列的值。

108.五、“脏数据”回流。当问题数据加工处理完成后,会回流至标准库中,从形成闭环。

109.六、数据统计展示。数据统计展示可以对各数据提供方的数据清洗维度、数据清洗情况、问题数据处理情况进行可视化展示,便于整体了解数据清洗的情况。

110.七、监控与维护。把数据清洗所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据清洗工作的正常运行。

111.数据脱敏的流程如下:

112.一、创建数据脱敏规则。创建数据脱敏规则是数据脱敏工作的前提条件。数据脱敏规则包括数据加密解密、数据模糊化处理、数据掩饰替换、数字脱敏、数据混洗。

113.二、实体数据关联数据脱敏规则。创建数据脱敏规则后,需要把实体数据与数据脱敏规则关联起来,包括关联规则编号、规则名称、规则方法、处理方法。

114.三、数据脱敏。数据脱敏前需要创建数据脱敏服务,引用数据脱敏规则和方法,并运行服务,进而开展数据脱敏工作。

115.四、脱敏数据入库。数据脱敏后,需要把已脱敏的数据抽取到业务库中,便于数据应用。

116.五、监控与维护。把数据脱敏所配置的所有服务纳入监控管理中,如果发现错误警告,需要及时排查问题并进行维护,保障数据脱敏工作的正常运行。

117.对于本领域技术人员而言,显然本发明不限于上述示范性实施例的细节,而且在不背离本发明的精神或基本特征的情况下,能够以其他的具体形式实现本发明。因此,无论从哪一点来看,均应将实施例看作是示范性的,而且是非限制性的,本发明的范围由所附权利要求而不是上述说明限定,因此旨在将落在权利要求的等同要件的含义和范围内的所有变化囊括在本发明内。不应将权利要求中的任何附图标记视为限制所涉及的权利要求。

118.此外,应当理解,虽然本说明书按照实施方式加以描述,但并非每个实施方式仅包含一个独立的技术方案,说明书的这种叙述方式仅仅是为清楚起见,本领域技术人员应当将说明书作为一个整体,各实施例中的技术方案也可以经适当组合,形成本领域技术人员可以理解的其他实施方式。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。