1.本发明涉及无人机视觉技术领域,尤其涉及一种基于航拍实时图像的空间目标定位方法。

背景技术:

2.随着近几年小型无人机技术及5g通信的发展,民用小型无人机得到了广泛的应用,同时也对无人机的功能提出了更高的要求,现有的无人机遥控技术,图传技术,数传技术都发展得较为成熟,目标检测识别技术随着计算机视觉技术的发展层出不穷,同时目标检测中比较关注的精度和效率问题也得到了比较好的解决。

3.但是对于无人机航拍图像,目标检测识别后的实时定位还有待提高,现阶段基于图像的目标三维定位方法主要是运用在点云图像的获取,三维地图的构建等方法,这些算法需要强大的算力以及预先构建的地图,很难应用在对时间效率要求比较高的无人机实时侦察图像中,导致实现起来较复杂,实时性也不高。

技术实现要素:

4.针对现有技术中所存在的不足,本发明提供了一种基于航拍实时图像的空间目标定位方法,以解决相关技术中在对时间效率要求比较高的无人机实时侦察图像中,导致实现起来较复杂,实时性也不高的问题。

5.本发明提供了一种基于航拍实时图像的空间目标定位方法,包括如下步骤:

6.s1、无人机基于含有激光测距功能的视觉吊舱获取实时图像画面,并基于所述视觉吊舱获取目标物和无人机的距离p2;

7.s2、获取所述无人机的实时参数,所述实时参数至少包括飞行高度h、视觉吊舱俯仰角alfa、视觉吊舱的横摆角belta、视觉吊舱的横向视场角wangle、纵向视场角hangle、图像中心坐标(uc,vc)以及焦距f;

8.s3、于所述实时图像画面分别选取目标物像素坐标(u,v)及目标物的垂直投影像素坐标(u1,v1);

9.s4、通过所述距离p2和所述目标物相对于无人机的垂直偏角计算出目标物和所述无人机的视觉吊舱之间的高度差hp,根据所述无人机的飞行高度和所述高度差获得目标物的高度ht;

10.s5、利用平面定位方法,结合所述高度差hp、目标物像素点坐标(u,v)及所述实时参数求出所述目标物的经纬度。

11.可选地,所述目标物相对于无人机的垂直偏角,包括:

12.根据所述视觉吊舱俯仰角alfa、目标物像素坐标(u,v)、图像中心坐标(uc,vc)、所述图像画面中每个像素的尺寸及焦距f计算无人机的垂直偏角,所述垂直偏角的计算公式为:

13.gama=-alfa actan((v-vc)*yp/f)

14.其中,yp为所述图像画面中每个像素的宽度。

15.可选地,所述图像画面中每个像素的尺寸,包括:

16.所述像素的尺寸包括像素长度xp和像素宽度yp,所述像素长度xp由焦距f和视觉吊舱的横向视场角wangle计算,所述像素长度xp的计算公式为:

17.xp=2*f*tan(wangle/2)/像素列数

18.所述像素宽度yp由焦距f和纵向视场角hangle计算,所述像素宽度yp的计算公式为:

19.yp=2*f*tan(hangle/2)/像素行数

20.可选地,所述像素宽度yp,包括:

21.通过纵向分辨率调整参数ys对所述像素宽度yp进行调整形成新的像素宽度yp,所述纵向分辨率调整参数ys为0.835。

22.可选地,所述通过所述距离p2和所述目标物相对于无人机的垂直偏角计算出目标物和所述无人机的视觉吊舱之间的高度差hp,包括:

23.判断所述目标物的垂直投影像素坐标(u1,v1)与所述图像中心坐标(uc,vc)是否为同一点,若是同一点,则所述高度差hp的计算公式为:

24.hp=p2*sin(gama)

25.若不是,则所述高度差hp的计算公式为:

26.hp=p2*cos(alfa)*tan(gama)

27.相比于现有技术,本发明具有如下有益效果:

28.本发明基于具有激光测距功能的视觉吊舱,获取可实现测量目标物和无人机的距离以及实时图像画面,同时获取无人机的实时参数,并采用平面定位方法,基于无人机的实时参数、目标物和无人机的距离以及实时图像画面来实现对目标物高度和经纬度的计算,本发明通过图像一次即可实现目标的三维坐标定位,定位过程简单,能够轻易满足无人机的日常航拍任务。

附图说明

29.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本发明的实施例,并与说明书一起用于解释本发明的原理。

30.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,对于本领域普通技术人员而言,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

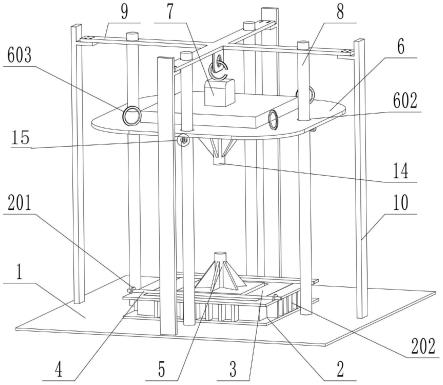

31.图1所示为本发明的流程示意图。

具体实施方式

32.为使本技术实施例的目的、技术方案和优点更加清楚,下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本技术的一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动的前提下所获得的所有其他实施例,都属于本技术保护的范围。本发明实例中相同标号的功能单元具有相同和相似的结构和功能。

33.参见图1,本发明提供了一种基于航拍实时图像的空间目标定位方法,包括如下步骤:

34.s1、无人机基于含有激光测距功能的视觉吊舱获取实时图像画面,并基于所述视觉吊舱获取目标物和无人机的距离p2;

35.s2、获取所述无人机的实时参数,所述实时参数至少包括飞行高度h、视觉吊舱俯仰角alfa、视觉吊舱的横摆角belta、视觉吊舱的横向视场角wangle、纵向视场角hangle、图像中心坐标(uc,vc)以及焦距f;

36.s3、于所述实时图像画面分别选取目标物像素坐标(u,v)及目标物的垂直投影像素坐标(u1,v1);

37.s4、通过所述距离p2和所述目标物相对于无人机的垂直偏角计算出目标物和所述无人机的视觉吊舱之间的高度差hp,根据所述无人机的飞行高度和所述高度差获得目标物的高度ht;

38.s5、利用平面定位方法,结合所述高度差hp、目标物像素点坐标(u,v)及所述实时参数求出所述目标物的经纬度。

39.本实施例中,利用基于具有激光测距功能的视觉吊舱,获取可实现测量目标物和无人机的距离以及实时图像画面,同时获取无人机的实时参数,并采用平面定位方法,基于无人机的实时参数、目标物和无人机的距离以及实时图像画面来实现对目标物高度和经纬度的计算,本发明通过图像一次即可实现目标的三维坐标定位,无需对三维地图进行构建,定位过程简单,能够轻易满足无人机的日常航拍任务。

40.可选地,所述目标物相对于无人机的垂直偏角,包括:

41.根据所述视觉吊舱俯仰角alfa、目标物像素坐标(u,v)、图像中心坐标(uc,vc)、所述图像画面中每个像素的尺寸及焦距f计算无人机的垂直偏角,所述垂直偏角的计算公式为:

42.gama=-alfa actan((v-vc)*yp/f)

43.其中,yp为所述图像画面中每个像素的宽度。

44.可选地,所述图像画面中每个像素的尺寸,包括:

45.所述像素的尺寸包括像素长度xp和像素宽度yp,所述像素长度xp由焦距f和视觉吊舱的横向视场角wangle计算,所述像素长度xp的计算公式为:

46.xp=2*f*tan(wangle/2)/像素列数

47.所述像素宽度yp由焦距f和纵向视场角hangle计算,所述像素宽度yp的计算公式为:

48.yp=2*f*tan(hangle/2)/像素行数

49.本实施例中,所述视觉吊舱获取的实时画面分辨率为1920x1080,则像素列数为1920,像素行数为1080。

50.可选地,所述像素宽度yp,包括:

51.通过纵向分辨率调整参数ys对所述像素宽度yp进行调整形成新的像素宽度yp,所述纵向分辨率调整参数ys为0.835。

52.本实施例中,针对前述1920x1080分辨率的实时画面,对像素的宽度进行调整,通过将所述像素宽度yp乘以纵向分辨率调整参数ys得到新的像素宽度yp,以实现替代之前的

像素宽度yp,即yp(新)=yp(旧)*ys,所述纵向分辨率调整参数ys是经过测试实验数据得出的系数,有利于提高定位精度。

53.可选地,所述通过所述距离p2和所述目标物相对于无人机的垂直偏角计算出目标物和所述无人机的视觉吊舱之间的高度差hp,包括:

54.判断所述目标物的垂直投影像素坐标(u1,v1)与所述图像中心坐标(uc,vc)是否为同一点,若是同一点,则所述高度差hp的计算公式为:

55.hp=p2*sin(gama)

56.若不是,则所述高度差hp的计算公式为:

57.hp=p2*cos(alfa)*tan(gama)

58.本实施例中,所述视觉吊舱反馈的实时画面可以反馈至后台的显示单元,后台的控制人员可以通过鼠标点击显示单元上的实时画面以确定目标物像素坐标(u,v)及目标物的投影在所述实时图像中的像素坐标(u1,v1),其中,目标物的垂直投影像素坐标(u1,v1)通常是所述图像中心坐标(uc,vc),如果目标物的垂直投影像素坐标(u1,v1)不是中心点,可将目标物的垂直投影像素坐标(u1,v1)当作中心点计算,目标物像素坐标(u,v)与中心的像素坐标偏差可换为与目标物的垂直投影像素坐标(u1,v1)的偏差;

59.若目标物的垂直投影像素坐标(u1,v1)与图像中心坐标(uc,vc)为同一点,若是同一点,则所述高度差hp的计算公式为:

60.hp=p2*sin(gama)

61.若不是,例如目标物的垂直投影像素坐标(u1,v1)为建筑表面,即目标物的垂直投影像素坐标(u1,v1)与图像中心坐标(uc,vc)在同一墙面,但不是同一点,则所述高度差hp的计算公式为:

62.hp=p2*cos(alfa)*tan(gama)

63.其实两个公式是一样的,如果测距点与目标点为同一点是gama=alfa,其他点则不相同。再根据无人机的实时高度h,即可求出目标物的高度ht:

64.ht=h-hp

65.至于所述目标物的经纬度的计算过程如下:

66.计算目标物对中心点的纵向偏角vgama,即:

67.vgama=actan((v-vc)*yp/f)

68.计算目标物与无人机的距离在吊舱纵轴方向的分量y,即:

69.y=h/tan(gama)

70.计算图像中与目标物同一排像素的焦距px,即:

71.px=f/cos(vgama)

72.计算目标物的水平偏角delta,即:

73.delta=actan((u-uc)*xp/px)

74.计算目标物与无人机的距离在吊舱横轴方向的分量x,即:

75.x=y*tan(delta)

76.计算目标物与无人机在地面投影的距离p(即目标物的投影),即:

77.p=sqrt(x*x y*y)

78.计算目标偏离视觉吊舱方向的航向偏角coureangle,即:

79.coureangle=tan(x/y)

80.通过无人机自带传感器反馈的经纬度(lon,lat)、地球半径r、无人机航向角airplanecoa、视觉吊舱的横摆角belta、目标物与无人机在地面投影的距离distance=p,则无人机与目标物的航向偏角bring=airplanecoa belta coureangle,则可以计算出目标物的经纬度(lon2,lat2),计算公式为:

81.lat2=acsin(sin(lat)*cos(distance/r) cos(lat)*sin(distance/r)*cos(bring))

82.lon2=(lon actan2(sin(bring)*sin(distance/r)*cos(lat),cos(distance/r)-sin(lat)*sin(lat2)))

83.根据目标物的经纬度(lon2,lat2)和目标物的高度ht实现对目标物的空间定位。

84.需要说明的是,在本文中,诸如“第一”和“第二”等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

85.以上所述仅是本发明的具体实施方式,使本领域技术人员能够理解或实现本发明。对这些实施例的多种修改对本领域的技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所申请的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。