1.本发明属于车辆重检测技术领域,尤其涉及一种基于无人机拍摄夜间低对比度的车辆重检测方法。

背景技术:

2.车辆重识别是计算机视觉领域中非常活跃的研究领域,目前,车辆重识别包含车辆的分类、车辆的检测和车辆的分割等场景,车辆重识别旨在通过给定的车辆图片,查找与当前车辆图片属于相同车辆的图片,车辆重识别的研究越来越多,与人员重识别的研究具有相同的目的,然而,车辆重识别的研究更加复杂,目前大多数的车辆重识别算法依赖于车辆的外观信息,但是,采用这种基于车辆外观的方式具有非常大的局限性,因为车辆的外观经常具有非常相似的外形和颜色,而且车辆可能在夜间出现,这种情况下,如果基于外表和颜色信息将出现失效问题。

3.随着多模态传感器的普及,目前,基于可见光热红外的车辆重检测将在车辆温度信息的指导下实现更高的性能,但是当前车辆重检测的算法仅仅针对于裁剪好的车辆区域,并进行车辆之间的相似度度量,在复杂场景下的车辆重检测的相关研究非常少,而针对于无人机的车辆重检测相关研究更少。

技术实现要素:

4.为解决上述问题,本发明设计提供一种新的基于无人机拍摄夜间低对比度的车辆重检测方法,针对无人机拍摄车辆进行重识别,实现查找车辆的检测与跟踪,从而实现定位查找车辆。

5.为实现上述目的,本发明实现车辆重检测的具体过程为:(1)数据集构建:采用无人机拍摄的视频数据构建数据集,无人机拍摄的视频包含集rgb信息和数据;(2)视觉信息和红外信息特征提取:将视频数据划分为单帧的数据,每帧数据包含rgb图片数据和图片数据两种数据,将rgb图片和图片分别输入多尺度特征提取网络vggnet中,从rgb图片数据中提取视觉信息特征,从图片数据中提取红外信息特征;(3)弱监督车辆定位:采用基于弱监督车辆定位的方式生成车辆位置区域;(4)基于局部区域增强的分辨率提升:将弱监督车辆定位结果输入gan网络(generative adversarial nets,生成对抗网络)中,采用基于局部区域增强的方式将图片的分辨率增加,得到高质量的视觉信息和高质量的红外信息,保证车辆在输入到网络中时,有充分的特征用于后续的车辆重检测过程;(5)分辨率提升后的视觉信息和红外信息特征提取:采用与步骤(2)相同的方式提取分辨率提升后的视觉信息特征和红外信息特征;

(6)基于注意力机制的特征融合:根据视觉特征以及红外特征其自身蕴含的像素级互信息,先计算像素级特征相似性并加权初始特征,得到视觉特征和及热红外特征的自注意力机制结果,再采用基于语义信息特征相似性的特征交互模式,将增强后的车辆区域用来加权初始车辆特征得到跨注意力结果;(7)结果输出:将步骤(6)得到的自注意力和跨注意力结果进行跨层融合并输出高维度车辆特征向量,即为车辆重识别结果;(8)网络训练和测试:为训练车辆重识别网络,从无人机拍摄的视频数据中采用跳帧挑选的方式选择图片数据,然后将图片数据输入到多尺度特征提取网络中,训练二分类网络并输出图片中是否包含车辆,在训练网络拟合后测试网络,如果包含车辆,则通过cam机制将输出车辆的定位信息,不存在车辆的帧将被舍弃,再将低质量的车辆局部区域块输入到gan网络中,并朝着高质量、高分辨率的车辆区域块方向拟合,直到生成的质量与真实的质量之间达到无法分辨真假,得到高质量的更高分辨率的车辆区域块,然后将高质量、高分辨率的车辆区域(rgb数据和数据)输入到多尺度特征提取网络中,并将二者充分发挥出互补特性,从而生成计算相似度量的高维度向量,从而确定车辆是否为查找的车辆。

6.作为本发明的进一步技术方案,步骤(2)提取的视觉信息和红外信息特征为:作为本发明的进一步技术方案,步骤(2)提取的视觉信息和红外信息特征为:作为本发明的进一步技术方案,步骤(2)提取的视觉信息和红外信息特征为:定义如下:其中代表可见光热红外图像;代表包含视觉信息的图片;代表提取得到的特征,i代表不同网络层输出的特征信息;代表采集的多尺度车辆信息,3,4,5代表第3,4,5层的输出特征,代表sigmoid函数。

7.作为本发明的进一步技术方案,步骤(3)的具体过程为:(31)先增强多尺度视觉特征和热红外特征,得到增强的多尺度视觉特征和热红外特征:特征:其中,代表reshape操作,将特征转化为单一维度向量;代表softmax函数,表示将矩阵之间的关系矩阵映射到0-1之间;代表对矩阵的值进行排序,代表concat操

作,代表取k个最大的相似矩阵的值;(32)采用车辆类别信息约束的方式,即将和输入到全局池化层中,提取高维度特征向量,从而达到精细化车辆特征区域信息的目的,详细操作如下,征向量,从而达到精细化车辆特征区域信息的目的,详细操作如下,征向量,从而达到精细化车辆特征区域信息的目的,详细操作如下,其中,,,代表是否存在车辆,和代表线性层,代表在此处产生的特征将被输出;代表特征叠加。

8.作为本发明的进一步技术方案,步骤(4)的具体过程如下:先确定车辆区域,其中,代表类别激活映射机制,通过类别激活映射机制将车辆区域定位出来;将车辆类别置信度更强的区域检测出来,采用注意力增强的方式将车辆类别置信度更强的区域检测出来,得到车辆位置的粗定位信息;基于车辆的粗定位信息,通过外围连接的方式得到外围边界框基于外围边界框,裁剪得到车辆区域;再将车辆区域进行增强得到高质量的车辆区域,其中代表低质量的车辆区域;代表车辆区域增强模块,车辆区域增强模块采用gan网络中判别网络的方式,详细操作如下,其中,代表判别网络,代表真实的高质量的车辆区域;代表判断当前车辆区域是真实的车辆区域还是生成的车辆区域。

9.作为本发明的进一步技术方案,步骤(5)的具体过程如下:

其中,和分别代表基于车辆区域增强模块提取的视觉特征和红外特征。

10.作为本发明的进一步技术方案,步骤(6)得到的自注意力机制结果为:作为本发明的进一步技术方案,步骤(6)得到的自注意力机制结果为:跨注意力结果为:其中,代表融合的视觉特征和热红外特征。

11.作为本发明的进一步技术方案,步骤(7)的具体过程为:作为本发明的进一步技术方案,步骤(7)的具体过程为:为最终输出的高维度车辆特征向量。

12.与现有技术相比,本发明具有以下优点:一是能够克服夜晚和复杂条件下的车辆重检测,相对于传统的车辆检测方法不受应用场景的限制,只需要无人机拍摄相关视频即可;二是不仅能够实现车辆重检测,对于行人重检测等都具有非常大的借鉴意义;三是运用的数据标注方式能够节省人力财力物力,同时,即使是高空拍摄的分辨率小的问题也能很好的解决。

附图说明

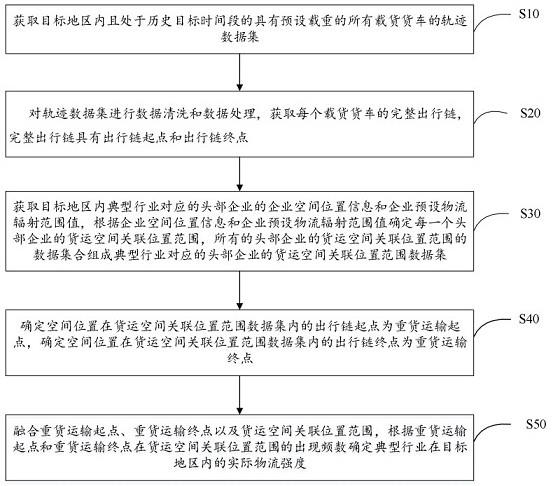

13.图1为本发明实现车辆重检测的结流程框架示意图。

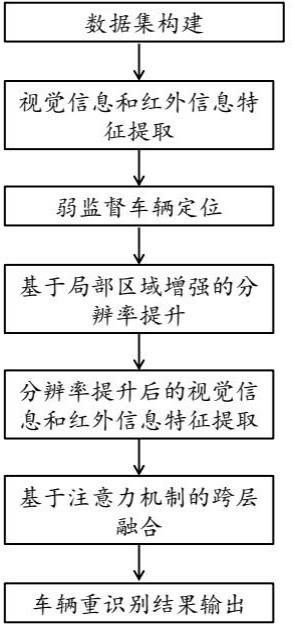

14.图2为本发明实现车辆重检测所采用的网络框架示意图。

具体实施方式

15.下面结合附图,通过实施例进一步描述本发明,但不以任何方式限制本发明的范围。

16.实施例:本实施例采用如图1所示的流程和图2所示的网络实现车辆重检测,具体包括如下步骤:(1)构建数据集:为收集基于无人机拍摄夜间低对比度的车辆重检测数据,本实施例采用无人机拍摄的方式采集车辆在不同的场景下的视频数据,无人机不仅采集rgb信息,同时还采集数据,为实现弱监督的车辆定位,将包含车辆的视频设置为类别1,而未包含车辆的类别设置为0,如果夜晚拍摄的视频过于黑暗,且不存在任何车辆的数据将被去除掉,在弱监督车辆定位的结果上,采用人工划分相同车辆的方式标注相同车辆的数据,从而实现车辆重识别算法的数据集收集;(2)视觉信息和红外信息特征提取:通过收集的视频数据,将视频数据划分为单帧的数据,每帧数据包含两种类型的数据,即rgb图片数据和图片数据,从rgb图片数据中提取视觉信息,而从图片数据中提取红外信息,无人机拍摄将包含不同尺寸的车辆信息,如果能够在网络设计过程中,捕获不同尺寸的车辆信息将非常有助于车辆信息的充分挖掘,因此,本实施例采用多尺度特征提取网络vggnet提取不同尺寸的车辆信息,提取的视觉信息和红外信息特征如下,觉信息和红外信息特征如下,觉信息和红外信息特征如下,定义如下:其中代表可见光热红外图像;代表包含视觉信息的图片;代表提取得到的特征,i代表不同网络层输出的特征信息;代表采集的多尺度车辆信息,3,4,5代表第3,4,5层的输出特征,选择3,4,5层的输出特征是因为3,4,5层输出的特征语义特征为高维度信息,不仅精确定位,还包含丰富的细节信息;代表sigmoid函数;(3)弱监督车辆定位:目前车辆定位检测主要的困难在于标注数据的过程太费时费力,虽然通过标注外围框的方式能够极大的节省时间,但是,标注大量数据的时候,还是需要花费大量的时间,为解决上述问题,本实施例采用基于弱监督车辆定位的方式生成车

辆位置区域,主要的操作如下,辆位置区域,主要的操作如下,其中,和代表经过增强的多尺度视觉特征和热红外特征;代表reshape操作,将特征转化为单一维度向量,代表softmax函数,表示将矩阵之间的关系矩阵映射到0-1之间,代表对矩阵的值进行排序,代表concat操作,代表取k个最大的相似矩阵的值,通过这种方式能够实现矩阵的稀疏化;经过上述方式增强后的特征包含车辆位置信息,但是,其中包含大量的背景信息,为将背景信息滤除,同时保留车辆信息,本实施例采用车辆类别信息约束的方式,即将和输入到全局池化层(gap)中,提取高维度特征向量,从而达到精细化车辆特征区域信息的目的,详细操作如下,化车辆特征区域信息的目的,详细操作如下,化车辆特征区域信息的目的,详细操作如下,其中,,,代表是否存在车辆。和代表线性层,代表在此处产生的特征将被输出;代表特征叠加;(4)基于局部区域增强的分辨率提升:拍摄的视频数据为基于高空无人机拍摄,其拍摄的车辆的尺寸将非常受限制,如果将车辆区域裁剪出来,车辆分辨率将会非常低,即使将车辆区域输入到网络中,并充分挖掘车辆信息,仍然不足以支撑车辆重识别的需要的信息隐刺采用基于局部区域增强的方式将图片的分辨率增加,从而保证车辆在输入到网络中时,能够有充分的特征用于后续的车辆重检测过程,具体过程如下,先确定车辆区域,

其中,代表类别激活映射机制,其能够将车辆区域定位出来;为将车辆类别置信度更强的区域检测出来,采用注意力增强的方式,通过上述方式,能够得到车辆位置的粗定位信息;基于车辆的粗定位信息,通过外围连接的方式得到外围边界框基于外围边界框,裁剪得到车辆区域;再将车辆区域进行增强得到高质量的车辆区域,其中代表低质量的车辆区域;代表车辆区域增强模块,车辆区域增强模块采用gan网络(generative adversarial nets,生成对抗网络)中判别网络的方式,详细操作如下,其中,代表判别网络,代表真实的高质量的车辆区域;代表判断当前车辆块是真实的车辆区域还是生成的车辆区域,此模块训练时采用车辆重识别数据将降低分辨率作为(5)分辨率提升后的视觉信息和红外信息特征提取:根据步骤(5)后得到高质量的视觉信息和高质量的红外信息提取高质量的视觉信息特征和红外信息特征,同时,本实施例采用与步骤(2)相同的网络,且网络参数为共享,通过这种方式能够增加网络输入的多样性,同时增强网络的处理不同数据的能力,详细的操作如下,能够增加网络输入的多样性,同时增强网络的处理不同数据的能力,详细的操作如下,其中,和分别代表基于车辆区域增强模块提取的视觉特征和红外特征,其他的符号定义如步骤(2)所定义的相同;(6)基于注意力机制的特征融合:为充分挖掘视觉特征以及红外特征其自身蕴含的像素级互信息,首先计算像素级特征相似性,并加权初始特征,得到自注意力机制结果为,

虽然上述步骤能够充分挖掘车辆图片中蕴含的特征信息,但是其二者之间存在的强互补特征没有充分挖掘,因此需要将视觉信息和红外信息特征进行融合,从而充分发挥二者的互补特性,为充分将二者融合,本实施例采用基于语义信息特征相似性的特征交互模式,并将增强后的车辆区域用来加权初始车辆特征,得到跨注意力结果为,其中,代表融合的视觉特征以及热红外特征; (7)结果输出:得到步骤(6)的自注意力和跨注意力结果后,需要将注意力结果进行跨层融合并输出车辆重识别结果,为计算车辆之间的相似性度量,本实施例采用将特征转化为高维度向量的方式将车辆信息映射到统一维度的向量,其详细的操作如下,其中,代表步骤(6)中得到的结果,为最终输出的高维度车辆特征向量;(8)网络训练和测试:为训练车辆重识别网络,从无人机拍摄的视频数据中采用跳帧挑选的方式选择图片数据,然后将图片数据输入到多尺度特征提取网络中,训练二分类网络并输出图片中是否包含车辆,在训练网络拟合后测试网络,如果包含车辆,则通过cam机制将输出车辆的定位信息,不存在车辆的帧将被舍弃,再将低质量的车辆局部区域块输入到gan网络中,并朝着高质量、高分辨率的车辆区域块方向拟合,直到生成的质量与真实的质量之间达到无法分辨真假,得到高质量的更高分辨率的车辆区域块,然后将高质量、高分辨率的车辆区域(rgb数据和数据)输入到多尺度特征提取网络中,并将二者充分发挥出互补特性,从而生成计算相似度量的高维度向量,从而确定车辆是否为查找的车辆。

17.本文中为详细公开的网络结构、函数及算法均为本领域通用技术。

18.需要注意的是,公布实施例的目的在于帮助进一步理解本发明,但是本领域的技术人员可以理解:在不脱离本发明及所附权利要求的精神和范围内,各种替换和修改都是

可能的。因此,本发明不应局限于实施例所公开的内容,本发明要求保护的范围以权利要求书界定的范围为准。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。