1.本发明涉及深度学习技术领域,具体地,涉及神经网络的训练方法、系统及神经网络模型的评价方法,更为具体地,涉及一种在目标检测任务中使用回放、知识蒸馏、正则化等融合手段的持续学习方法,能有效抵抗遗忘性和提升可塑性。

背景技术:

2.当前的深度学习往往遵循先构建静态数据集,然后在此基础上进行模型设计和训练的范式,这与人类在学习生涯中不断积累和学习新知识的过程有很大差别。

3.在现实任务的场景中,由于隐私、数据存储或者算力限制等问题,无法充分保存旧的样本,例如:在边缘和个人设备上部署的人工智能系统,同时受到隐私保护、计算能力和存储空间的约束,无论是保存旧有数据,还是积累新数据都不可行。持续学习的愿景则是,在新的数据以流式到达,同时出现新的类别或者新的任务的情况下,人工智能系统能够做到持续学习,在保留旧的知识的情况,能够较好地适应新的领域,学习新的知识。实际上,在开放世界场景中,尤其是互联网世界中,新的数据和知识源源不断涌现。持续学习期望提升当前的人工智能系统,使其在开放世界场景中,以与人类更加相近的方式,调整和学习新的知识,适应动态变化的世界。

4.现有的神经网络模型在持续学习新知识时往往会遭遇“灾难性遗忘”(catastrophic forgetting),在学习新任务之后,模型在旧任务上性能灾难性下降。这个问题指向了神经网络模型所面临的普遍问题:稳定性-可塑性困境(stability-plasticity dilemma),其中可塑性代表调整以整合新知识的能力,稳定性则代表在调整过程中保留旧知识的能力。如何提高模型的可塑性,同时兼顾稳定性,在两者间取得平衡,是持续学习研究所面临的挑战。

5.在上文对于持续学习的两大挑战的分析中,持续学习要求模型的优化方案既能考虑之前任务的影响,也能在当下的任务上表现良好。而在训练的过程中,负迁移是导致灾难性遗忘的可能问题:有一些数据学到的特征适用于所有的任务,而有些数据学到的特征则会对其他任务有负面影响。基于这些结论,我们可以得到一些解决方案,比如可以通过构建一个存储器保留之前的梯度信息,从而重现“拔河拉锯”;我们也可以对数据进行过滤,给予那些正迁移的数据较高的权重,过滤那些会导致负迁移的数据。

6.因此,可以将持续学习的方法划分为以下三类:基于回放(replay)的方法,基于正则化(regularization)的方法以及基于模型结构(architecture-based)的方法。其中基于正则化和回放的范式受到的关注更多,也更接近持续学习的真实目标,而模型结构则需要引入较多的参数和计算量,因此通常只能用于较简单的任务。

7.当前行业研究还只集中于在简单数据集上的分类任务,对于复杂数据集上的目标检测研究较少较浅,不利于实际生产情况的应用。

技术实现要素:

8.针对现有技术中的缺陷,本发明的目的是提供一种神经网络的训练方法、系统及神经网络模型的评价方法。

9.根据本发明提供的一种神经网络的训练方法,包括:

10.步骤s1:获取原始任务数据集,将其编号为第零任务数据集,在其上训练神经网络,训练完成后得到第零基准神经网络模型;

11.步骤s2:获取新的任务数据集,根据获取次序,将其编号为第i任务数据集(i=1,2,3,

…

),利用第i任务数据集重新训练所述神经网络,训练完成后得到第i基准神经网络模型;

12.步骤s3:采用回放方法,从第零任务数据集至第i-1任务数据集中分别抽取一定比例的数据,与第i任务数据集的全部数据合在一起,构成第i训练数据集;

13.步骤s4:融合知识蒸馏方法和正则化方法,在第i训练数据集上重新训练所述神经网络,训练完成后得到第i目标神经网络模型,重复触发步骤s2至步骤s4。

14.优选地,所述步骤s4包括:

15.依次将第i训练数据集中的数据输入所述神经网络,得到对应的输出结果;

16.针对单个训练轮次,根据预测值与真实值之间的差距计算基础损失lb;利用第零基准神经网络模型(当i=1时)或者第i-1目标神经网络模型(当i》1时)进行知识蒸馏得到蒸馏损失ld,使用正则化方法得到正则损失lr;计算总损失l

t

=lb ld lr;利用总损失l

t

对所述神经网络进行反向传播,对神经网络参数进行调节;

17.在训练一定轮次后,选择总损失l

t

最低的轮次所对应的神经网络模型为第i目标神经网络模型。

18.优选地,所述神经网络采用yolov5架构,所述yolov5架构包括:主干网络、特征融合网络以及检测头网络;

19.所述主干网络采用cspdarknet53 focus结构;

20.所述特征融合网络采用fpn pan结构;

21.所述检测头网络则输出三个特征图;

22.数据经过预处理后输入到主干网络中进行特征提取,生成不同大小的特征图;特征融合网络将生成的特征图进行相互融合,使得每一层的特征图都能获得其他不同层特征图的信息,特征融合网络输出的特征图的个数、大小与主干网络输出的一致;检测头网络在特征融合的基础上再加一个卷积层得到输出,输出的个数、大小与骨干网络和特征融合网络输出的均一致。

23.优选地,第一目标神经网络模型直至第i目标神经网络模型,均能够部署在实际应用场合中,执行包括目标检测、图像分类在内的任务。

24.根据本发明提供的一种神经网络的训练系统,包括:

25.原始数据处理单元:获取原始任务数据集,将其编号为第零任务数据集,在其上训练神经网络,训练完成后得到第零基准神经网络模型;

26.任务数据处理单元:获取新的任务数据集,根据获取次序,将其编号为第i任务数据集(i=1,2,3,

…

),利用第i任务数据集重新训练所述神经网络,训练完成后得到第i基准神经网络模型;

27.训练数据构建单元:采用回放方法,从第零任务数据集至第i-1任务数据集中分别抽取一定比例的数据,与第i任务数据集的全部数据合在一起,构成第i训练数据集;

28.目标模型训练单元:融合知识蒸馏方法和正则化方法,在第i训练数据集上重新训练所述神经网络,训练完成后得到第i目标神经网络模型。

29.优选地,所述目标模型训练单元包括:

30.依次将第i训练数据集中的数据输入所述神经网络,得到对应的输出结果;

31.针对单个训练轮次,根据预测值与真实值之间的差距计算基础损失lb;利用第零基准神经网络模型(当i=1时)或者第i-1目标神经网络模型(当i》1时)进行知识蒸馏得到蒸馏损失ld,使用正则化方法得到正则损失lr;计算总损失l

t

=lb ld lr;利用总损失l

t

对所述神经网络进行反向传播,对神经网络参数进行调节;

32.在训练一定轮次后,选择总损失l

t

最低的轮次所对应的神经网络模型为第i目标神经网络模型。

33.优选地,所述神经网络采用yolov5架构,所述yolov5架构包括:主干网络、特征融合网络以及检测头网络;

34.所述主干网络采用cspdarknet53 focus结构;

35.所述特征融合网络采用fpn pan结构;

36.所述检测头网络则输出三个特征图;

37.数据经过预处理后输入到主干网络中进行特征提取,生成不同大小的特征图;特征融合网络将生成的特征图进行相互融合,使得每一层的特征图都能获得其他不同层特征图的信息,特征融合网络输出的特征图的个数、大小与主干网络输出的一致;检测头网络在特征融合的基础上再加一个卷积层得到输出,输出的个数、大小与骨干网络和特征融合网络输出的均一致。

38.优选地,第一目标神经网络模型直至第i目标神经网络模型,均能够部署在实际应用场合中,执行包括目标检测、图像分类在内的任务。

39.根据本发明提供的一种神经网络模型的评价方法,使用超参数配置文件,先计算第零至第i基准神经网络模型的基准平均精度均值p

bj

(j=0,1,2,

…

,i),再基于p

bj

计算第i目标神经网络模型的稳定性精度、可塑性精度以及总精度。

40.优选地,

41.p

total

=(p

stability

p

plasticity

)/2

42.其中,p

total

为总精度,p

stability

为稳定性精度,p

plasticity

为可塑性精度;

43.对于在第i训练数据集上进行训练得到的第i目标神经网络模型m,p

stability

和p

plasticity

的计算式分别为

[0044][0045][0046]

其中,p

bk

(k=0,1,2,

…

,i-1)表示第k基准神经网络模型的基准平均精度均值,

表示模型m在第零原始数据集上的平均精度均值,(k=1,2,

…

,i-1)表示模型m在第k任务数据集上的平均精度均值;p

bi

表示第i基准神经网络模型的基准平均精度均值,表示模型m在第i任务数据集上的平均精度均值。

[0047]

与现有技术相比,本发明具有如下的有益效果:

[0048]

1、本发明提出了一种神经网络模型训练方法效果的评价标准p

total

,可以同时关注神经网络模型的稳定性和可塑性,可以清晰地比较出不同训练方法的优劣;

[0049]

2、本发明在不改变模型本身的基础上融合多种持续学习的方法,包括回放、知识蒸馏以及正则化,比现有的fintune方法的结果0.256提升了将近0.6,比目前最好的回放方法er提升了0.08个点,本技术所提供的训练方法平均map达到了0.85以上,可以应用到实际生产情况当中;

[0050]

3、回放方法能有效抵抗遗忘性,且知识蒸馏能在回放的基础上略微有所提升,结合正则化方法则可以在抵抗遗忘性的同时,却大幅降低对其模型可塑性的影响,因此本发明结合回放方法、知识蒸馏和正则化方法能在大幅提升训练模型稳定性效果的同时保持可塑性。

附图说明

[0051]

通过阅读参照以下附图对非限制性实施例所作的详细描述,本发明的其它特征、目的和优点将会变得更明显:

[0052]

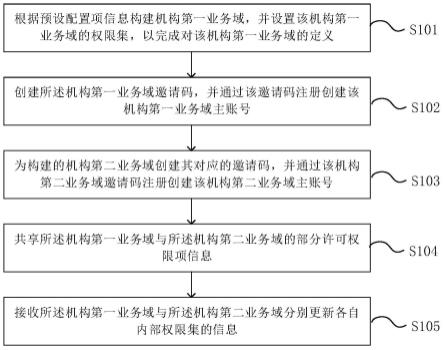

图1为本发明训练方法流程图。

[0053]

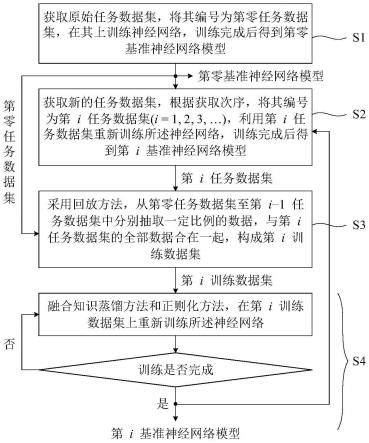

图2为基于改进持续学习的神经网络训练方法流程图。

[0054]

图3为precision-recall曲线图。

具体实施方式

[0055]

下面结合具体实施例对本发明进行详细说明。以下实施例将有助于本领域的技术人员进一步理解本发明,但不以任何形式限制本发明。应当指出的是,对本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变化和改进。这些都属于本发明的保护范围。

[0056]

实施例1

[0057]

根据本发明提供的一种神经网络的训练方法,如图1所示,包括:

[0058]

步骤s1:获取原始任务数据集,将其编号为第零任务数据集,在其上训练神经网络,训练完成后得到第零基准神经网络模型;

[0059]

其中,yolov5结构如图2所示,主干网络(backbone)采用了cspdarknet53 focus的结构,特征融合网络(neck)采用了fpn pan结构,检测头网络(head)则是输出3个特征图(feature map)。整体结构流程如图1所示,图片经过预处理(归一化)后输入到主干网络中进行特征提取,生成不同大小的特征图。以640

×

640分辨率的图片为例,分别生成下采样8倍的80

×

80、16倍的40

×

40和32倍的20

×

20大小的三个特征图。特征融合网络将上述生成的不同大小的特征图进行相互融合,使得每一层的特征图都能获得其他不同层特征图的信息,此网络输出的特征图个数和大小与骨干网络输出的一致。检测头网络在特征融合的基

础上再加一个卷积层即可得到输出,输出的个数和尺度均与骨干网络,特征融合网络一致。

[0060]

步骤s2:获取新的任务数据集,根据获取次序,将其编号为第i任务数据集(i=1,2,3,

…

),利用第i任务数据集重新训练所述神经网络,训练完成后得到第i基准神经网络模型;

[0061]

步骤s3:采用回放方法,从第零任务数据集至第i-1任务数据集中分别随机抽取一定比例的数据,与第i任务数据集的全部数据合在一起,构成第i训练数据集;

[0062]

步骤s4:融合知识蒸馏方法和正则化方法,在第i训练数据集上重新训练所述神经网络,训练完成后得到第i目标神经网络模型,重复触发步骤s2至步骤s4。

[0063]

具体地,所述步骤s4采用:依次将第i训练数据集中的数据输入所述神经网络,得到对应的输出结果;针对单个训练轮次,根据预测值与真实值之间的差距计算基础损失lb;利用第零基准神经网络模型(当i=1时)或者第i-1目标神经网络模型(当i》1时)进行知识蒸馏得到蒸馏损失ld,使用正则化方法得到正则损失lr;计算总损失l

t

=lb ld lr;利用总损失l

t

对所述神经网络进行反向传播,对神经网络参数进行调节;在训练一定轮次后,选择总损失l

t

最低的轮次所对应的神经网络模型为第i目标神经网络模型。

[0064]

其中,知识蒸馏采用:

[0065][0066]

其中,ls表示蒸馏损失;fp

new

表示第i目标神经网络得到的特征图;fp

old

表示第零基准神经网络模型或者第i-1目标神经网络模型得到的特征图;表示在两幅图得到均方差后求其平均。

[0067]

其中,正则化方法采用:

[0068]

使用正则化方法得到第i目标神经网络参数的权重,将得到的权重进行归一化处理;将第零基准神经网络模型或者第i-1目标神经网络模型参数与第i目标神经网络参数进行均方差计算,再跟相应的归一化处理后的权重相乘得到正则损失lr;

[0069]

所述归一化处理包括均值方差归一化处理、最大值归一化处理或绝对值归一化处理。

[0070]

其中,所述正则化方法包括l2、ewc以及mas。

[0071]

具体地,第一目标神经网络模型直至第i目标神经网络模型,均能够部署在实际应用场合中,执行包括目标检测、图像分类在内的任务。

[0072]

根据本发明提供的一种神经网络的训练系统,包括:

[0073]

原始数据处理单元:获取原始任务数据集,将其编号为第零任务数据集,在其上训练神经网络,训练完成后得到第零基准神经网络模型;

[0074]

其中,yolov5结构如图1所示,主干网络(backbone)采用了cspdarknet53 focus的结构,特征融合网络(neck)采用了fpn pan结构,检测头网络(head)则是输出3个特征图(feature map)。整体结构流程如图1所示,图片经过预处理(归一化)后输入到主干网络中进行特征提取,生成不同大小的特征图。以640

×

640分辨率的图片为例,分别生成下采样8倍的80

×

80、16倍的40

×

40和32倍的20

×

20大小的三个特征图。特征融合网络将上述生成的不同大小的特征图进行相互融合,使得每一层的特征图都能获得其他不同层特征图的信

息,此网络输出的特征图个数和大小与骨干网络输出的一致。检测头网络在特征融合的基础上再加一个卷积层即可得到输出,输出的个数和尺度均与骨干网络,特征融合网络一致。

[0075]

任务数据处理单元:获取新的任务数据集,根据获取次序,将其编号为第i任务数据集(i=1,2,3,

…

),利用第i任务数据集重新训练所述神经网络,训练完成后得到第i基准神经网络模型;

[0076]

训练数据构建单元:采用回放方法,从第零任务数据集至第i-1任务数据集中分别随机抽取一定比例的数据,与第i任务数据集的全部数据合在一起,构成第i训练数据集;

[0077]

目标模型训练单元:融合知识蒸馏方法和正则化方法,在第i训练数据集上重新训练所述神经网络,训练完成后得到第i目标神经网络模型。

[0078]

具体地,在所述目标模型训练单元中,依次将第i训练数据集中的数据输入所述神经网络,得到对应的输出结果;针对单个训练轮次,根据预测值与真实值之间的差距计算基础损失lb;利用第零基准神经网络模型(当i=1时)或者第i-1目标神经网络模型(当i》1时进行知识蒸馏得到蒸馏损失ld,使用正则化方法得到正则损失lr;计算总损失l

t

=lb ld lr;利用总损失l

t

对所述神经网络进行反向传播,对神经网络参数进行调节;在训练一定轮次后,选择总损失l

t

最低的轮次所对应的神经网络模型为第i目标神经网络模型。

[0079]

其中,知识蒸馏采用:

[0080][0081]

其中,ld表示蒸馏损失;fp

new

表示第i目标神经网络得到的特征图;fp

old

表示第一基准神经网络模型或者第i-1目标神经网络模型得到的特征图;表示在两幅图得到均方差后求其平均。

[0082]

其中,正则化方法采用:

[0083]

使用正则化方法得到第i目标神经网络参数的权重,将得到的权重进行归一化处理;将第一基准神经网络模型或者第i-1目标神经网络模型参数与第i目标神经网络参数进行均方差计算,再跟相应的归一化处理后的权重相乘得到正则损失;

[0084]

所述归一化处理包括均值方差归一化处理、最大值归一化处理或绝对值归一化处理。

[0085]

其中,所述正则化方法包括l2、ewc以及mas。

[0086]

具体地,第一目标神经网络模型直至第i目标神经网络模型,均能够部署在实际应用场合中,执行包括目标检测、图像分类在内的任务。

[0087]

实施例2

[0088]

根据本发明提供的一种神经网络模型的评价方法,包括:

[0089]

步骤s1:将coco数据集中80个类别分为8个任务,其中0-9类为基任务,后连续每10类为一个新增任务;在本实施例中,coco数据集为任务数据集的优选例;

[0090]

步骤s2:对基任务数据集进行预处理,利用预处理后的基任务数据集输入到yolov5进行训练,得到第零基准神经网络模型,计算此模型的基准平均精度均值p

b0

;

[0091]

其中,yolov5结构如图1所示,主干网络(backbone)采用了cspdarknet53 focus的结构,特征融合网络(neck)采用了fpn pan结构,检测头网络(head)则是输出3个特征图

(feature map)。整体结构流程如图1所示,图片经过预处理(归一化)后输入到主干网络中进行特征提取,生成不同大小的特征图。以640

×

640分辨率的图片为例,分别生成下采样8倍的80

×

80、16倍的40

×

40和32倍的20

×

20大小的三个特征图。特征融合网络将上述生成的不同大小的特征图进行相互融合,使得每一层的特征图都能获得其他不同层特征图的信息,此网络输出的特征图个数和大小与骨干网络输出的一致。检测头网络在特征融合的基础上再加一个卷积层即可得到输出,输出的个数和尺度均与骨干网络,特征融合网络一致。

[0092]

步骤s3:获取新的任务数据集,根据获取次序,将其编号为第i任务数据集(i=1,2,3,

…

),利用第i任务数据集重新训练所述神经网络,训练完成后得到第i基准神经网络模型,计算此模型的基准平均精度均值p

bi

;

[0093]

步骤s4:采用回放方法,从第零任务数据集至第i-1任务数据集中分别随机抽取一定比例的数据,与第i任务数据集的全部数据合在一起,构成第i训练数据集;其中,使用随机的数据选取方法在第零任务数据集至第i-1任务数据集中分别随机抽取一定数量(约为原始数据量的1/10)的数据进行保存,在新任务训练(即coco数据集新增类别)的过程中包含新任务的全部数据和旧任务的抽取数据。

[0094]

步骤s5:融合知识蒸馏方法和正则化方法,在第i训练数据集上重新训练所述神经网络,训练完成后得到第i目标神经网络模型;

[0095]

所述步骤s5采用:依次将第i训练数据集中的数据输入所述神经网络,得到对应的输出结果;针对单个训练轮次,根据预测值与真实值之间的差距计算基础损失lb;利用第零基准神经网络模型(当i=1时)或者第i-1目标神经网络模型(当i》1时)进行知识蒸馏得到蒸馏损失ld,使用正则化方法得到正则损失lr;计算总损失l

t

=lb ld lr;利用总损失l

t

对所述神经网络进行反向传播,对神经网络参数进行调节;在训练一定轮次后,选择总损失l

t

最低的轮次所对应的神经网络模型为第i目标神经网络模型。

[0096]

其中,知识蒸馏采用:

[0097][0098]

其中,ld表示蒸馏损失;fp

new

表示第i目标神经网络得到的特征图;fp

old

表示第一基准神经网络模型或者第i-1目标神经网络模型得到的特征图;表示在两幅图得到均方差后求其平均,最后将三个特征图的平均相加即为蒸馏损失ld。

[0099]

其中,正则化方法采用:

[0100]

使用正则化方法得到第i目标神经网络参数的权重,将得到的权重进行归一化处理;将第零基准神经网络模型或者第i-1目标神经网络模型参数与第i目标神经网络参数进行均方差计算,再跟相应的归一化处理后的权重相乘得到正则损失;

[0101]

所述归一化处理包括均值方差归一化处理、最大值归一化处理或绝对值归一化处理。

[0102]

其中,所述正则化方法包括l2、ewc以及mas。不同的正则化方法在于求解权重的过程不同。l2正则使用固定值,所有参数权重都为1;ewc以预测值与真实值的差作为损失,反向传播后各个参数的更新梯度作为权重;mas以预测值作为损失,反向传播后各个参数的更新梯度作为权重。

[0103]

步骤s6:使用yolov5的超参数配置文件,先计算第零至第i基准神经网络模型的基准平均精度均值p

bj

(j=0,1,2,

…

,i),再基于p

bj

计算第i目标神经网络模型的稳定性精度、可塑性精度以及总精度;

[0104]

使用yolov5自带的参数文件,建立各个任务的baseline map(计算iou为0.5-0.95各阈值下的map,再求其平均,后续map均为此定义);

[0105]

map计算公式如下(以iou阈值0.5为例):

[0106][0107][0108][0109][0110]

在目标检测中,预测边界框与真实边界框的重叠程度(iou)大于阈值0.5即为正例,反之为负例。上述公式中其中tp是正例判定为正例、fp是负例判定为正例、fn是正例判定为负例、tn是负例判定为负例。precision为模型给出的所有预测结果中命中真实目标的比例。recall为型给出的预测结果最多能覆盖多少真实目标。ap(average precision):平均精度,即为pr曲线图的面积,在不同recall下的最高precision的均值(一般会对各类别分别计算各自的ap),如图3所示。map(mean ap):平均精度均值,各类别的ap的均值;c表示类别数;n、ri、p

inter

都是常数。

[0111]

基准任务i的map表示为pi,模型在i-1的任务上的map表示为

[0112][0113][0114]

p

total

=(p

stability

p

plasticity

)/2

[0115]

其中,p

total

为总精度,p

stability

为稳定性精度,p

plasticity

为可塑性精度。

[0116]

现有的评价标准往往只评价稳定性即p

stability

,且只关注上一个任务的稳定性,而不是之前的所有任务的稳定性,评价公式为与之相比,本发明的评价标准不仅清晰明了,在稳定性上关注之前的所有任务,且综合稳定性和可塑性两个因素,更符合实际的应用状况。

[0117]

在baseline上微调后训练的结果如表1所示:

[0118]

表1

[0119]

coco类别10-1920-2930-3940-4950-5960-6970-79p

stability

0.0000.0000.0000.0000.0000.0000.000p

plasticity

1.0441.0421.0561.0271.0221.0181.089p

total

0.5220.3470.2640.2050.1700.1450.136

[0120]

本发明方法训练后的结果如表2所示:

[0121]

表2

[0122]

coco类别10-1920-2930-3940-4950-5960-6970-79p

stability

0.8040.8230.8270.8310.8270.7900.791p

plasticity

0.9851.0170.9630.9620.9710.9461.039p

total

0.8950.8880.8610.8570.8510.8130.822

[0123]

本发明与其他方法比较结果(p

total

)如表格3所示:

[0124]

表3

[0125]

coco类别10-1920-2930-3940-4950-5960-6970-79avgfintune0.5220.3470.2640.2050.1700.1450.1360.256er0.8300.8130.8030.7760.7600.7200.7230.775gss0.8310.8110.7940.7870.7500.7150.7220.773er kd0.8400.8130.7960.7700.7740.7360.7250.779er kd l20.8990.8850.8630.8320.8210.7920.8070.833er kd ewc0.8960.8950.8620.8450.8330.8160.8350.854er kd mas0.8950.8880.8610.8570.8510.8130.8220.856

[0126]

表格3中er和gss分别表示随机选取和基于梯度选取回放的数据,然后进行联合训练的方法;kd表示结合知识蒸馏的方法;l2/ewc/mas分别表示不同的正则化方法。

[0127]

本发明不仅可以将多种方法无序组合进行使用,包括回放(er)方法、正则(l2/ewc/mas)方法和知识蒸馏(kd)方法等。并且可以单独选择其中一种或几种进行使用。每一种方法有不同的实现方法,以正则化方法为例,l2、ewc、mas等皆是其实现方法。

[0128]

本发明提供的基于改进持续学习的神经网络训练方法的评估系统,可以通过本发明提供的基于改进持续学习的神经网络训练方法的评估方法中的步骤流程实现。本领域技术人员,可以将所述基于改进持续学习的神经网络训练方法的评估方法理解为基于改进持续学习的神经网络训练方法的评估系统的一个优选例。

[0129]

本领域技术人员知道,除了以纯计算机可读程序代码方式实现本发明提供的系统、装置及其各个模块以外,完全可以通过将方法步骤进行逻辑编程来使得本发明提供的系统、装置及其各个模块以逻辑门、开关、专用集成电路、可编程逻辑控制器以及嵌入式微控制器等的形式来实现相同程序。所以,本发明提供的系统、装置及其各个模块可以被认为是一种硬件部件,而对其内包括的用于实现各种程序的模块也可以视为硬件部件内的结构;也可以将用于实现各种功能的模块视为既可以是实现方法的软件程序又可以是硬件部件内的结构。

[0130]

以上对本发明的具体实施例进行了描述。需要理解的是,本发明并不局限于上述特定实施方式,本领域技术人员可以在权利要求的范围内做出各种变化或修改,这并不影

响本发明的实质内容。在不冲突的情况下,本技术的实施例和实施例中的特征可以任意相互组合。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。