一种基于三判别器生成对抗网络的pet和mri图像融合方法

技术领域

1.本发明涉及图像处理领域,具体为一种基于三判别器生成对抗网络的pet和mri图像融合方法。

背景技术:

2.随着现代传感器与成像技术的不断发展,多种多样的医学成像设备也随之产生,不同的医学成像设备通过各种不同的成像策略采集人体信息,从而产生多类不同模态的医学影像。现存的多模态医学影像从总体上可以分为解剖型图像与功能型图像。磁共振成像(magnetic resonance image,mri)作为解剖型图像能够提供人体的软组织信息,表现为纹理细节和致密结构信息丰富的图像。正电子发射断层扫描(positron emission tomography,pet)作为功能型图像,能够反映肿瘤与人体细胞代谢等人体信息。在临床应用中,仅使用单一模态的医学影像通常无法较为完整地获得所需的人体信息,这就要求在临床应用同时使用多种模态的医学影像,然而同时观测不同模态的影像将极大的耗费时间。通过采用一定的技术手段将mri与pet图像进行融合,使得一幅融合影像能够同时体现mri与pet图像中的人体结构与功能信息,以便能够更好地在临床应用中提供客观的人体参考信息,从而有助于临床医生做出准确的诊断。

3.针对mri与pet图像各自的特性,研究人员提出了不同的融合方法和策略,其中基于深度学习的融合方法是当前较热门的多模态医学图像融合方法。采用深度学习方法进行图像融合,能够在一定程度上避免传统图像融合中所需要进行的复杂融合规则的设计,从而降低图像融合的计算复杂度。在基于深度学习方法的医学图像融合领域中,基于生成对抗网络(generative adversarial network,gan)的方法是较常使用的。gan模型主要包括两部分:生成器与判别器。其中生成器旨在生成具有pet图像组织信息并附加mri图像结构信息的图像;判别器旨在迫使生成的图像具有更多的结构细节信息,使得融合得到图像既具有mri图像的纹理细节又具有pet图像清晰的组织信息。基于gan的融合方法通常是通过建立生成器与判别器之间的对抗博弈来进行无监督的训练,从而不断提升融合图像的效果。

4.实际中,现有的基于gan的融合策略存在以下不足:

5.1、在单一判别器的gan模型中,判别器仅判断融合图像与单一源图像,存在生成图像随网络训练而偏向单一图像的局限;

6.2、在双判别器的gan模型中,采用双判别器结构对不同的输入图像进行判别,从而对生成图像起到了信息平衡作用,消除了融合图像伴随训练对源图像产生的偏移问题;然而在生成器中采用的编码器-解码器网络,容易导致对源图像中的浅层特征的利用不足。

技术实现要素:

7.本发明的目的是针对现有技术的缺陷,提供一种基于三判别器生成对抗网络的pet和mri图像融合方法,以解决上述背景技术提出的问题。

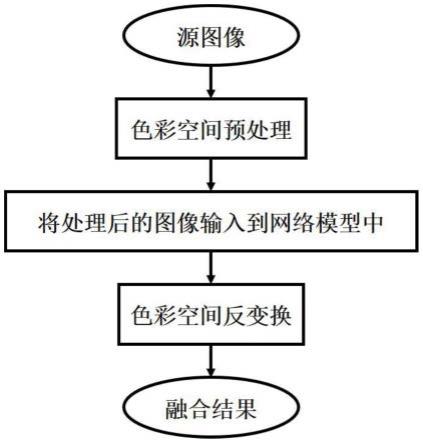

8.为实现上述目的,本发明提供如下技术方案:一种基于三判别器生成对抗网络的pet和mri图像融合方法,具体步骤如下:

9.s1:ycbcr色彩空间转换;

10.将pet图像由rgb彩色空间变换为ycbcr彩色空间,经过彩色空间变换后的pet图像包含三个图像分量,分别为y,cb和cr图像分量,其中y图像分量包含能够反映pet图像整体结构与亮度变化的亮度信息,cb与cr图像分量则分别表现了pet图像中对蓝色与红色的浓度偏移量成份;

11.s2:y分量图像的融合;

12.对pet图像的y分量和mri图像进行差分操作,所得到的差分图像与pet图像的y分量和mri图像进行联结操作后输入到所提出的网络模型中,得到融合的y分量图像;

13.s3:rgb图像的重构;

14.将生成器生成的y分量图像与相应的源pet图像的cb,cr分量进行ycbcr颜色空间到rgb彩色空间的反变换,从而得到最终的融合图像。

15.作为本发明的一种优选技术方案,所述s1的ycbcr色彩空间转换中,将pet图像i

p

进行rgb彩色空间到ycbcr彩色空间的变换,分别得到i

p

的y,cb,cr三个通道的分量图像i

p-y

,i

p-cb

和i

p-cr

;pet图像由rgb彩色空间至ycbcr彩色空间的变换过程如下:

[0016][0017]

作为本发明的一种优选技术方案,所述s2的y分量图像的融合,将mri图像im与pet图像y分量i

p-y

进行差分并取绝对值,得到差分图像id,然后将mri图像im、pet图像y分量i

p-y

、差分图像i

d“联结”后输入到生成器网络中;

[0018]

生成器提取所输入图像的特征信息并进行特征选择,然后融合生成i

f-y

,此步骤需要在融合前完成对生成器-判别器网络的训练。

[0019]

作为本发明的一种优选技术方案,所述生成器-判别器网络的训练过程为:

[0020]

首先,将im、i

p-y

与计算得到的id图像输入到生成器网络,生成器采用3条不同的支路进行图像特征的提取,3条支路基于所提取的图像特征信息的特点可分别称为梯度支路,对比度支路与差分支路;

[0021]

其次,将生成器网络所生成的i

f-y

分别与im、i

p-y

、id输入到对应的判别器dm、d

p-y

与dd中进行鉴别;

[0022]

最后,依据生成器与判别器的输出结果,通过损失函数对生成器和判别器的网络进行对抗训练和交替更新,直至达到网络平衡,此时训练得到的生成器网络就是我们所需的用于pet和mri图像融合的生成器。

[0023]

作为本发明的一种优选技术方案,所述损失函数包括损失函数的权重、生成器损失函数和判别器损失函数。

[0024]

作为本发明的一种优选技术方案,所述损失函数的权重采用基于权重的方法对输入的三类图像间的信息进行平衡,具体地,分别对pet的y分量、mri图像和差分图像进行信息熵度量、显著性度量以及梯度度量,然后依据度量结果综合生成权重参数,此外,结合pet

与mri图像的信息表现特点,设置增强和衰减参数对不同类别的损失函数进行平衡;

[0025]

所述信息熵度量是通过计算源图像的信息熵来衡量图像所含有信息的多少,以此作为损失函数的权重参考,具体为:

[0026][0027]

其中i

en

为图像i的信息熵;l为灰度级别数,设置为256;p

l

为对应灰度级别的概率;

[0028]

所述显著性度量,对源图像中含有的高亮信息的多少进行衡量,以此作为权重的参考,具体为:

[0029][0030]

其中i

sal

为图像i的显著信度量;sign(

·

)为符号函数;τ为筛选显著区域的阈值;h,w为图像i的高度与宽度;i

ij

为图像i中坐标为(i,j)处像素点的灰度值;

[0031]

所述梯度度量是采用拉普拉斯算子进行衡量,度量值越高表明图像中含有更多的纹理细节,从而作为损失权重的衡量,具体为:

[0032][0033]

其中i

grad

为图像i的梯度度量;为拉普拉斯算子;

[0034]

总的损失函数的权重定义为:

[0035]

ηi=λ1i

en

λ2i

sal

λ3i

grad

[0036][0037]

其中ηi为对应图像i的总体度量,λ1,λ2,λ3为控制不同度量的比例参数;类似的,分别为mri图像、pet图像的y分量和差分图像的总体度量;ω1,ω2,ω3分别为mri图像、pet图像的y分量和差分图像的损失参数权重。

[0038]

作为本发明的一种优选技术方案,所述生成器损失函数采用混合损失,即通过图像表层信息的损失结合通过网络挖掘出的深层语义信息的损失对网络施加约束;生成器的损失函数定义如下:

[0039]

lg=l

adv

αl

ssim

βl

grad

γl

per

[0040]

其中lg为生成器的总损失,l

adv

为对抗损失,l

ssim

为结构相似性损失,l

grad

为梯度损失,l

per

为感知损失;α、β、γ分别为调整不同损失的比例参数。

[0041]

作为本发明的一种优选技术方案,所述对抗损失是判别器对生成器生成的图像所施加的深层约束,由三部分构成,分别源于三个判别器,生成器需要在训练过程中,保证其所生成的图像能够在三类图像的信息保留中取得平衡,当对抗损失的取值较低时,表明生成的图像能够同时保留3类输入图像的原始信息,从而使得判别器无法对生成的图像做出准确的判断,对抗损失定义为:

[0042]

l

adv

=e(log(1-dm(i

f-y

))) e(log(1-d

p-y

(i

f-y

))) e(log(1-dd(i

f-y

)))

[0043]if-y

=g(im,i

p-y

,id)

[0044]

其中i

f-y

为生成器所生成的图像(生成的pet图像的y分量),im为原始mri图像,i

p-y

为源pet图像经过ycbcr变换得到的y分量,id为差分图像;g为生成器,dm为鉴别生成器所生成的图像与原始mri图像的判别器,d

p-y

为鉴别生成器所生成的图像与源pet图像的y分量的判别器,dd为鉴别生成器所生成的图像与差分图像id的判别器;e(

·

)表示取平均值操作。

[0045]

作为本发明的一种优选技术方案,所述结构相似性损失项通过亮度、对比度和结构方面对三支路生成器进行约束,使得生成器在生成图像时在输入的mri图像、pet图像的y分量和差分图像之间取得平衡,从而使得生成的融合图像拥有一定的相似结构,具体定义为:

[0046]

l

ssim

=ω1(1-l

ssim

(i

f-y

,im)) ω2(1-l

ssim

(i

f-y

,i

p-y

)) ω3(1-l

ssim

(i

f-y

,id))

[0047]

其中l

ssim

(

·

)表示对输入的两幅图像进行结构相似性计算,其输出值为介于0和1的标量,值越大表明两幅图像所拥有的相似结构越多;

[0048]

所述梯度损失是衡量融合得到的图像与输入图像间结构纹理等信息的差异,由于原始mri图像中通常含有较多的密集结构性信息,因此对其施加一个增强系数;差分图像作为辅助信息对其施加一个衰减系数,通过该项约束使得融合图像尽可能多地包含源图像的细节和纹理信息,梯度损失定义如下:

[0049][0050]

其中||

·

||

tv

为tv范数;s1、s2分别为增强与衰减系数。

[0051]

作为本发明的一种优选技术方案,所述感知损失是衡量融合图像中对输入图像的深层特征信息的保留情况,以此在图像的深层语义层面对生成器进行约束;

[0052]

所述判别器损失函数由三部分组成,分别为对mri与融合图像(融合得到的pet的y分量)进行判别的损失,对pet的y分量和融合图像进行判别的损失,以及对差分图像与融合图像进行判别的损失。

[0053]

本发明的有益效果是:本发明目的在于为了更好地弥补现有基于gan的医学图像融合方法存在的不足,即因判别器的局限性导致融合图像信息保留不充分的问题,以达到在尽可能保留原始图像信息的情况下能够更好地辅助临床疾病的诊断。

[0054]

本方法采用的是端到端的网络模型,无需设置复杂的图像融合策略;模型整体由一个生成器与三个判别器组成;生成器的输入除pet和mri图像外还额外引入了差分图像;特征提取部分采用三支路结构,分别通过直连对应的图像(源mri、pet的y分量、差分图像)使得各支路都有自己的信息偏向,并且在各支路中均采用跳跃连接以提高传递图像特征信息的效率,从而提升图像融合的效果;此外,通过与三个结构相同的patchgan判别器的相互对抗而不断地提升生成器的性能,损失函数方面,采用混合损失,且通过利用信息熵、显著性、梯度等对三类输入图像所包含的信息量进行度量来设置损失函数的权重;此外,所采用的结构相似性、梯度、感知与对抗等损失能够对生成器同时进行表层及深层约束;

[0055]

在公开的数据集上进行的实验结果表明,本文方法在主观视觉效果方面更加迎合人眼视觉倾向,客观的定量评价方面均取得了较优的结果,其中结构相似性ssim优于性能次好者(dsagan算法)约14.28%,基于梯度的融合性能指标q

ab/f

优于性能次好者约26.67%,相关系数cc优于性能次好者约11.43%,空间频率sf优于性能次好者约8.33%,人类视觉敏感度指标q

cb

优于性能次好者约11.29%。

附图说明

[0056]

图1为本发明方法的流程图;

[0057]

图2为本发明用于pet和mri图像融合的总框架图;

[0058]

图3为本发明用于pet和mri图像融合的模型对抗训练框架图;

[0059]

图4为本发明的生成器网络结构图;

[0060]

图5为本发明的判别器网络结构图。

具体实施方式

[0061]

下面结合附图对本发明的较佳实施例进行详细阐述,以使本发明的优点和特征能更易被本领域人员理解,从而对本发明的保护范围做出更为清楚明确的界定。

[0062]

实施例:请参阅图1-3,本发明提供一种技术方案:一种基于三判别器生成对抗网络的pet和mri图像融合方法,具体步骤如下:

[0063]

s1:ycbcr色彩空间转换;

[0064]

将pet图像由rgb彩色空间变换为ycbcr彩色空间,经过彩色空间变换后的pet图像包含三个图像分量,分别为y,cb和cr图像分量,其中y图像分量包含能够反映pet图像整体结构与亮度变化的亮度信息,cb与cr图像分量则分别表现了pet图像中对蓝色与红色的浓度偏移量成份;

[0065]

s2:y分量图像的融合;

[0066]

对pet图像的y分量和mri图像进行差分操作,所得到的差分图像与pet图像的y分量和mri图像进行联结操作后输入到所提出的网络模型中,得到融合的y分量图像;

[0067]

s3:rgb图像的重构;

[0068]

将生成器生成的y分量图像与相应的源pet图像的cb,cr分量进行ycbcr颜色空间到rgb彩色空间的反变换,从而得到最终的融合图像。

[0069]

所述s1的ycbcr色彩空间转换中,将pet图像i

p

进行rgb彩色空间到ycbcr彩色空间的变换,分别得到i

p

的y,cb,cr三个通道的分量图像i

p-y

,i

p-cb

和i

p-cr

;pet图像由rgb彩色空间至ycbcr彩色空间的变换过程如下:

[0070][0071]

所述s2的y分量图像的融合,将mri图像im与pet图像y分量i

p-y

进行差分并取绝对值,得到差分图像id,然后将mri图像im、pet图像y分量i

p-y

、差分图像i

d“联结”后输入到生成器网络中;

[0072]

生成器提取所输入图像的特征信息并进行特征选择,然后融合生成i

f-y

,此步骤需要在融合前完成对生成器-判别器网络的训练。

[0073]

所述生成器-判别器网络的训练过程为:

[0074]

首先,将im、i

p-y

与计算得到的id图像输入到生成器网络,生成器采用3条不同的支路进行图像特征的提取,3条支路基于所提取的图像特征信息的特点可分别称为梯度支路,对比度支路与差分支路;

[0075]

3条支路所采用的网络层级与具体参数都是相同的,不同支路间的区别在于,在支路卷积层中所直连的源图像不同,各个支路均采用跳跃连接提取图像特征以提升信息的利用;具体地,首先通过3条不同的特征提取支路对输入图像进行特征提取;然后将不同支路所提取的特征进行联结,汇总各支路特征;最后经过两个卷积层选择不同支路所提取的图像特征,并进行决策从而生成图像。生成器网络中卷积层的步长均为1,生成器具体结构如图4所示;

[0076]

其次,将生成器网络所生成的i

f-y

分别与im、i

p-y

、id输入到对应的判别器dm、d

p-y

与dd中进行鉴别;

[0077]

在判别器网络中,总共包含4个卷积层,均采用4*4大小的卷积核,并且都采用bn(batchnormalization)层进行归一化操作;判别器中前三层卷积对所输入的图像进行特征的提取,最后一层卷积则依据前层卷积所提取的特征,对感受野进行决策,判别器中所有卷积层的步长均为2,前三层进行特征提取的卷积层中填充大小为1,激活函数选择为relu函数;最后一层进行决策的卷积层的填充大小为0,选择非线性函数tanh生成最终的决策图,最后一层卷积层输出为4*4大小的决策图,再将输出的决策图进行取平均值操作,得到一个0到1间的标量值,该值即为判别器对所输入图像的最终鉴别结果,判别器具体结构如图5所示;

[0078]

最后,依据生成器与判别器的输出结果,通过损失函数对生成器和判别器的网络进行对抗训练和交替更新,直至达到网络平衡,此时训练得到的生成器网络就是我们所需的用于pet和mri图像融合的生成器。

[0079]

所述损失函数包括损失函数的权重、生成器损失函数和判别器损失函数;

[0080]

由于本方法中输入到生成器的数据同时包括mri图像、pet图像的y分量和差分图像(mri与pet的y分量间的差分),因此不同图像间的损失权重对融合结果具有非常重要的影响;为此,本发明采用基于权重的方法对输入的三类图像间的信息进行平衡,具体地,分别对pet的y分量、mri图像和差分图像进行信息熵度量、显著性度量以及梯度度量,然后依据度量结果综合生成权重参数,此外,结合pet与mri图像的信息表现特点,设置增强和衰减参数对不同类别的损失函数进行平衡;

[0081]

所述信息熵度量是通过计算源图像的信息熵来衡量图像所含有信息的多少,以此作为损失函数的权重参考,具体为:

[0082][0083]

其中i

en

为图像i的信息熵;l为灰度级别数,设置为256;p

l

为对应灰度级别的概率;

[0084]

所述显著性度量,对源图像中含有的高亮信息的多少进行衡量,以此作为权重的参考,具体为:

[0085][0086]

其中i

sal

为图像i的显著信度量;sign(

·

)为符号函数;τ为筛选显著区域的阈值;h,w为图像i的高度与宽度;i

ij

为图像i中坐标为(i,j)处像素点的灰度值;

[0087]

所述梯度度量是采用拉普拉斯算子进行衡量,度量值越高表明图像中含有更多的

纹理细节,从而作为损失权重的衡量,具体为:

[0088][0089]

其中i

grad

为图像i的梯度度量;为拉普拉斯算子;

[0090]

总的损失函数的权重定义为:

[0091]

ηi=λ1i

en

λ2i

sal

λ3i

grad

[0092][0093]

其中ηi为对应图像i的总体度量,λ1,λ2,λ3为控制不同度量的比例参数;类似的,分别为mri图像、pet图像的y分量和差分图像的总体度量;ω1,ω2,ω3分别为mri图像、pet图像的y分量和差分图像的损失参数权重。

[0094]

所述生成器损失函数采用混合损失,即通过图像表层信息的损失结合通过网络挖掘出的深层语义信息的损失对网络施加约束;生成器的损失函数定义如下:

[0095]

lg=l

adv

αl

ssim

βl

grad

γl

per

[0096]

其中lg为生成器的总损失,l

adv

为对抗损失,l

ssim

为结构相似性损失,l

grad

为梯度损失,l

per

为感知损失;α、β、γ分别为调整不同损失的比例参数。

[0097]

所述对抗损失是判别器对生成器生成的图像所施加的深层约束,由三部分构成,分别源于三个判别器,生成器需要在训练过程中,保证其所生成的图像能够在三类图像的信息保留中取得平衡,当对抗损失的取值较低时,表明生成的图像能够同时保留3类输入图像的原始信息,从而使得判别器无法对生成的图像做出准确的判断,对抗损失定义为:

[0098]

l

adv

=e(log(1-dm(i

f-y

))) e(log(1-d

p-y

(i

f-y

))) e(log(1-dd(i

f-y

)))

[0099]if-y

=g(im,i

p-y

,id)

[0100]

其中i

f-y

为生成器所生成的图像(生成的pet图像的y分量),im为原始mri图像,i

p-y

为源pet图像经过ycbcr变换得到的y分量,id为差分图像;g为生成器,dm为鉴别生成器所生成的图像与原始mri图像的判别器,d

p-y

为鉴别生成器所生成的图像与源pet图像的y分量的判别器,dd为鉴别生成器所生成的图像与差分图像id的判别器;e(

·

)表示取平均值操作。

[0101]

所述结构相似性损失项通过亮度、对比度和结构方面对三支路生成器进行约束,使得生成器在生成图像时在输入的mri图像、pet图像的y分量和差分图像之间取得平衡,从而使得生成的融合图像拥有一定的相似结构,具体定义为:

[0102]

l

ssim

=ω1(1-l

ssim

(i

f-y

,im)) ω2(1-l

ssim

(i

f-y

,i

p-y

)) ω3(1-l

ssim

(i

f-y

,id))

[0103]

其中l

ssim

(

·

)表示对输入的两幅图像进行结构相似性计算,其输出值为介于0和1的标量,值越大表明两幅图像所拥有的相似结构越多;

[0104]

所述梯度损失是衡量融合得到的图像与输入图像间结构纹理等信息的差异,由于原始mri图像中通常含有较多的密集结构性信息,因此对其施加一个增强系数;差分图像作为辅助信息对其施加一个衰减系数,通过该项约束使得融合图像尽可能多地包含源图像的细节和纹理信息,梯度损失定义如下:

[0105][0106]

其中||

·

||

tv

为tv范数;s1、s2分别为增强与衰减系数。

[0107]

所述感知损失是衡量融合图像中对输入图像的深层特征信息的保留情况,以此在图像的深层语义层面对生成器进行约束;由于本发明所选用的训练用医学图像数据尺寸较小,且网络中的池化层会一定程度上减少所提取的图像信息,因此本发明在选择vgg19网络作为图像信息感知网络时,仅选择该网络不同位置的四层卷积层作为图像的感知特征层,其分别位于该网络前四个池化层的前一层;具体的:

[0108]

i)将生成器生成的融合图像(融合得到的pet图像的y分量)分别与三类输入图像(源mri、pet的y分量和差分图像)输入到预训练好的vgg19网络中;

[0109]

ii)通过vgg19网络对输入图像进行图像深层特征信息的提取,获取输入图像在不同特征层级的深层语义表现;

[0110]

iii)采用均方误差计算融合图像与输入图像在深层语义表示上的差异,以此衡量原始图像特征信息在融合图像中的保留情况;pet图像能够提供丰富的功能型信息,因此对其施加一个增强系数;同样的对差分图像施加一个衰减系数;感知损失具体定义为:

[0111][0112][0113][0114]

l

per

=ω1l

per

(im) s3×

ω2l

per

(i

p-y

) s4×

ω3l

per

(id)

[0115]

其中φ

t

表示经由预训练完成的vgg19网络第t层感知特征层进行图像特征图的计算;h

t

、w

t

与t

t

分别表示对应第t层感知特征层的图像特征图的高,宽与通道数目;为frobenius范数;s3、s4分别为增强与衰减系数。

[0116]

所述判别器损失函数由三部分组成,分别为对mri与融合图像(融合得到的pet的y分量)进行判别的损失,对pet的y分量和融合图像进行判别的损失,以及对差分图像与融合图像进行判别的损失;

[0117]

采用三个网络结构相同的基于patchgan的判别器,并且不同判别器所采用的损失函数也是相似的,以此来对生成器所生成的图像与原始输入的三类图像进行区分,进而通过判别器的输出结果来优化生成器,使得生成器能够生成符合输入图像纹理与强度的融合图像;具体的,判别器的损失函数为:

[0118]

ld=ld(im) ld(i

p-y

) ld(id)

[0119]

ld(im)=e(-log(dm(im))) e(-log(1-dm(i

f-y

)))

[0120]

ld(i

p-y

)=e(-log(d

p-y

(i

p-y

))) e(-log(1-d

p-y

(i

f-y

)))

[0121]

ld(id)=e(-log(dd(id))) e(-log(1-dd(i

f-y

)))。

[0122]

所述rgb图像的重构,将生成器生成的pet分量i

f-y

与相应的pet图像的cb,cr分量i

p-cb

,i

p-cr

进行ycbcr颜色空间到rgb彩色空间的反变换,从而得到最终的融合图像if。

[0123]

以上实施例仅表达了本发明的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变形和改进,这些都属于本发明的保护范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。