1.本发明涉及图像处理领域,具体涉及一种基于激光雷达和相机信息融合的目标定位检测方法。

背景技术:

2.无人渣罐吊运系统中,采用目标检测技术,可以准确感知渣罐的实际位置,进而实现渣罐的自动吊运,可以减少人工辅助,特别是避免人工介入危险性较大的作业环境。在钢铁公司中,钢铁产量是其关键的技术指标,包含造渣、出渣、精炼、出钢等一系列工艺,这其中涉及了大量的钢渣转运操作。钢渣转运是钢铁生产中的突出环节,目前绝大部分钢渣的运输过程主要采用人工操作和监测的方法。一方面因为高温环境和钢渣飞溅,存在极大安全风险;另一方面,人工操作主要依靠人眼观测,存在误判的可能,导致行车不必要的启停,而且某些操作需要多次尝试才能完成,效率十分低下。为了提高钢铁公司的生产效率,加强工人的安全保障,最好是减少和无需地面辅助及监控人员的参与。因此,在智能钢渣处理流程中,能够自动确认板钩的状态,识别渣罐位置,实现钢渣转运的智能化是未来的发展趋势,具有很强的现实意义和经济价值。因此迫切需要一种能够自动准确识别渣灌和挂钩的位置、缩短数据采集周期,来高效安全地完成挂钩的检测与定位的方法,从而实现钢渣转运的无人化作业。

技术实现要素:

3.针对现有技术中存在的问题和不足,本发明的目的旨在提供一种基于激光雷达和相机信息融合的目标定位检测方法。

4.为实现发明目的,本发明采用的技术方案如下:

5.一种基于激光雷达和相机信息融合的目标定位检测方法,其特征在于,包括以下步骤:

6.s1、对获取的检测场景的3d点云数据进行预处理,消除点云噪声,滤除场景中非目标景物,得到可视化场景点云图;

7.s2、采用基于发线夹角的欧式聚类点云分割算法对步骤s1得到的可视化场景点云图进行点云分割处理,将目标物体与非目标景物分割,得到3d目标物体区域点云图;

8.s3、从步骤s2得到的3d目标物体区域点云图中挑选包含完整目标物体几何信息和语义信息特征的点云图,并将其作为模板目标物体点云图;

9.s4、实时采集检测场景的3d点云数据和2d图像,得到待检测3d点云数据和待检测2d图像,按所述步骤s1、s2的操作对待检测3d点云数据进行处理,得到待检测3d目标物体区域点云图;采用深度卷积神经网络对待检测2d图像进行目标物体检测,生成目标物体检测检测结果图,所述目标物体检测结果图包含目标物体的边界框、目标物体类别和置信度;

10.s5、将所述目标物体检测结果图与待检测3d目标物体区域点云图进行融合,对待检测3d目标物体区域点云图进行点云着色,得到具有精确坐标信息的待检目标物体区域融

合点云图;

11.s6、采用基于局部特征的全局配准算法将待检目标物体区域融合点云图与模板目标物体点云图进行配准,根据配准信息,得到待检目标物体区域融合点云图中目标物体的位姿信息。

12.根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,采用基于发线夹角的欧式聚类点云分割算法对步骤s1得到的可视化场景点云图进行点云分割处理的步骤为:

13.s21、计算可视化场景点云图中在半径为r的范围内点云之间的平均距离和均方差;

14.s22、计算可视化场景点云图不同半径范围r内邻近点之间的法线夹角均值;

15.s23、利用点云法线夹角在突兀重叠、接触区域变化较大的差异,根据计算得到的不同半径范围下的邻域法线夹角均值判断点云是否为目标物体点云的边界点,然后根据目标物体点云的边界点,将可视化场景点云图中的目标物体与非目标景物进行分割。

16.根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s21的具体操作为:

17.s211、对于可视化场景点云图vq中的任意一个点vqi,vqi∈vq,遍历与其最近的k个邻近点,得到由k个点构成的集合,记作{vq

i1

,vq

i2

,...,vq

ik

},按式1计算{vq

i1

,vq

i2

,...,vq

ik

}集合中每个点与qi的平均距离di;

[0018][0019]

式1中,di表示{vq

i1

,vq

i2

,

…

,vq

ik

}集合中每个点与vqi的平均距离,

[0020]

s212、按照步骤s21所述的操作计算可视化场景点云图vq中所有点的平均距离di,然后利用式2、式3分别计算点云在不同半径r邻域下的平均距离均值d和均方差σ;

[0021][0022][0023]

其中,n表示可视化场景点云图vq的点云大小。

[0024]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s22的具体操作为:

[0025]

s221、计算不同半径范围r内邻近点之间的法线夹角均值:

[0026]

对于可视化场景点云图vq中的任意一个点vqi,vqi∈vq,以vqi作为搜索起点,搜索半径为r内的所有邻近点,得到由k个点构成的集合,记作{vq

i1

,vq

i2

,

…

,vq

ik

},然后采用最小二乘法按式4、式5拟合出搜索起点vqi的最小二乘平面,

[0027][0028][0029]

其中,q(n,d)中d表示搜索半径为r邻域下的平均距离,n表示最小二乘平面的单位法向量,q表示质心值,q

xi

表示第i个点vqi的x方向上的质心值,q

yi

表示第i个点vqi的y方向上的质心值,q

zi

表示第i个点vqi的z方向上的质心值;

[0030]

s222、将点vqi的法线值记作vi,搜索点vqi的k个邻近点的法向量值,记作{v

i1

,v

i2

,

…

,v

ik

},采用式6、式7分别计算点vqi在r的半径范围内邻近点法线夹角值αi以及法线夹角均值

[0031][0032][0033]

其中,αi表示法线夹角值,表示法线夹角均值,g表示半径r范围内邻近点的数量,n表示半径r范围内邻近点的法线夹角的数量。

[0034]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s6中采用基于局部特征的全局配准算法将待检目标物体区域融合点云图与模板目标物体点云图进行配准的具体步骤为:

[0035]

s61、分别采用sift算法提取模板目标物体点云图、待检目标物体区域融合点云图中的关键点,并采用fpfh对提取的关键点进行特征描述,得到关键点特征;

[0036]

s62、采用全局配准算法将待检目标物体区域融合点云图中的关键点与模板目标物体点云图的关键点进行配对,得到关键点对;

[0037]

s63、依次采用互换一致性测试、三点测试、空间位置测试剔除关键点对中的错误匹配,并设置误差函数对关键点对进行验证,得到匹配关键点对;根据匹配关键点对信息,得到待检目标物体区域融合点云图中目标物体的位姿信息。

[0038]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s63中依次采用互换一致性测试、三点测试、空间位置测试剔除关键点对中的错误匹配,并设置误差函数对关键点对进行验证,得到匹配关键点对,其具体操作为:

[0039]

s631、对于待检目标物体区域融合点云图p的任意一个关键点pi,采用fpfh提取的关键点特征表示为f(pi),则待检目标物体区域融合点云图p的关键点fpfh特征集合可定义为:f(p)={f(pi):pi∈p};对于模板目标物体点云图q的任意一个关键点qi,采用fpfh提取的关键点特征表示为f(qi),则模板目标物体点云图q的关键点fpfh特征集合可定义为:f(q)={f(qi):qi∈q},设c1为f(p)和f(q)对应关系的集合;

[0040]

s632、互换一致性测试:对于关键点对(pi,qi),当且仅当f(pi)是f(qi)在f(p)中的最近邻,且仅当f(qi)是f(pi)在f(q)中的最近邻时,关键点对(pi,qi)被保留在结果点对c

11

中;

[0041]

s633、三点测试:从结果点对c

11

中随机选取三个关键点对(p1,q1)、(p2,q2)、(p3,q3),检验(p1,p2,p3)与(q1,q2,q3)是否符合式8所示的验证关系,满足验证关系的关键点对被保存在结果点对c

111

中;

[0042][0043]

其中,τ=0.9;

[0044]

s634、空间位置测试:按照式9计算结果点对c

111

中所有关键点对中所有关键点qi的点云重心centriod,按照式10计算c

111

中所有关键点对中每一个关键点qi与点云重心centriod的位置关系c(qi),并计算所有关键点qi的c(qi)的平均值,将每一个关键点qi的c(qi)与c(qi)平均值进行比较,删除c(qi)大于c(qi)平均值的关键点对;

[0045][0046][0047]

s635、误差函数验证:采用误差函数计算经步骤s54处理后的结果点对c

111

中每一个关键点对两个关键点之间的误差,得到每个关键点对的误差;然后求取结果点对c

111

中所有关键点对的误差平均值μ和误差方差δ2,若μ<δ2,则验证完成,结果点对c

111

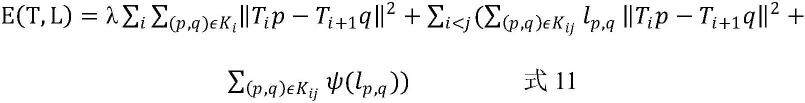

中剩余的关键点对即为匹配关键点对;其中,误差函数e(t,l)的计算公式如式11所示;

[0048][0049]

其中,λ表示随机数,其范围为:λ∈[0,1],ti表示第i个关键点对的刚体变换矩阵,t

i 1

表示第i 1个关键点对的刚体变换矩阵,p表示待检目标物体区域融合点云图中的关键点云集,q表示模板目标物体点云图中的关键点点云集,ψ(l

p,q

)表示关键点对关系。

[0050]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s1中所述预处理为直通滤波算法处理、基于距离的半径滤波算法处理、体素化滤波网格滤波算法处理中的至少一种。

[0051]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,所述目标为渣罐和用于吊挂渣罐的吊钩。

[0052]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,步骤s5中将所述目标物体检测结果图与待检测3d目标物体区域点云图进行融合的具体操作为:

[0053]

s51、标定采集待检测2d图像的相机设备的内参矩阵;

[0054]

s52、根据步骤s4中目标物体检测检测结果图中的边界框信息,从目标物体检测结果图选取目标物体的轮廓边缘角点并记录轮廓边缘角点的位置坐标;从待检测3d目标物体区域点云图中获取目标物体的边缘角点并记录其位置坐标;

[0055]

s53、将从目标物体检测结果图选取目标物体的轮廓边缘角点与从待检测3d目标物体区域点云图中获取目标物体的边缘角点进行对应点迭代计算,得到包含残差和重投影误差的外参矩阵;

[0056]

s54、根据待检测3d目标物体区域点云图中点云的位置坐标、步骤s51得到的内参矩阵和步骤s53得到的外参矩阵计算出所述相机设备的相机像素坐标,然后将目标物体检测检测结果图的rgb信息赋给待检测3d目标物体区域点云图中的点云,完成点云着色,得到具有精确坐标信息的待检目标物体区域融合点云图。

[0057]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,采用激光扫描系统来获取检测场景的3d点云数据,所述激光扫描系统包括2d线性激光扫描仪和智能云台设备,所述2d线性激光扫描仪安装智能云台上。

[0058]

根据上述的基于激光雷达和相机信息融合的目标定位检测方法,优选地,采用相机设备来采集检测场景的2d图像,所述相机设备为红外数字高清高速智能球机。

[0059]

与现有技术相比,本发明取得的积极有益效果如下:

[0060]

(1)本发明基于发线夹角的欧式聚类点云分割算法对点云进行分割处理,该点云

分割算法既可以实现离群点和冗余点的去除,又可以实现对待测物体的分割需求,而且,在分割过程中能实现点云搜索距离的自调节,有效地将目标物体与非目标景物分割,点云分割准确率高,分割速度快,为后续点云配准提供良好的基础;同时也克服了传统的欧式聚类分割算法易出现欠分割和过分割的缺陷。

[0061]

(2)本发明采用基于局部特征的全局配准算法将待检目标物体区域融合点云图中的关键点与模板目标物体点云图的关键点进行配对,该算法不仅计算成本低,且能够在复杂的现场工作场景中精准识别和计算目标物体的位姿矩阵;与粗配准sac算法相比,本发明基于局部特征的全局配准算法不需要初始化,计算成本较低,解决了sac算法迭代次数多、算法速度慢的问题;与精配准icp算法相比,本发明基于局部特征的全局配准算法具有更高的精度和可靠性。

[0062]

(3)本发明先采用深度卷积神经网络对待检测2d图像进行目标物体检测,生成目标物体检测检测结果图,然后将目标物体检测结果图与待检测3d目标物体区域点云图进行融合,使得目标定位更加精确,极大地提高了目标检测结果的准确度,鲁棒性更强。

[0063]

(4)本发明在筛选匹配关键点对时,引入了误差函数进行验证,误差函数的设置能够保证待检目标物体区域融合点云图与模板目标物体点云图进行自动验证,极大提升了配准算法的速度。

[0064]

(5)本发明在进行关键点配对之前,先构建了模板目标物体点云图,该模板目标物体点云图能够为之后的目标物体识别与定位建立准确的模型库。

[0065]

(6)本发明深度融合了3d点云和2d图像数据,能够达到实时性准确检测,提升定位精度,分类精准,提升工作效率;同时能够准确的检测出钢渣转运过程中渣灌和挂钩的位置及相对位姿,实现钢渣转运的智能感知和无人化目标,降低安全事故发生概率,进一步缩减钢渣装卸和转运成本,准确地检测钢渣和挂钩目标抓钩与脱钩的智能决策,构建了一个兼具有效性与实用性的自动化系统。

附图说明

[0066]

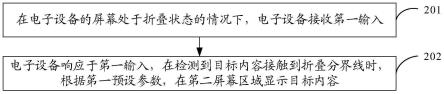

图1为本发明基于发线夹角的欧式聚类点云分割算法步骤图;

[0067]

图2为本发明基于发线夹角的欧式聚类点云分割算法进行点云分割的效果图;

[0068]

图3为本发明采用深度卷积神经网络yolov3对待检测2d图像进行目标物体检测的示意图;

[0069]

图4为本发明基于局部特征的全局配准算法的配准效果图。

具体实施方式

[0070]

以下结合具体的实施例对本发明作进一步详细说明,但并不限制本发明的范围。

[0071]

实施例1:

[0072]

一种基于激光雷达和相机信息融合的目标定位检测方法,包括以下步骤:

[0073]

s1、采用安装在行车上的激光扫描系统采集检测场景的3d点云数据,所述激光扫描系统包括智能云台设备和安装在智能云台设备上的2d线性激光扫描仪;对获取的检测场景的3d点云数据进行预处理,消除点云噪声,滤除场景中非目标景物,得到可视化场景点云图。

[0074]

所述预处理为直通滤波算法处理、基于距离的半径滤波算法处理、体素化滤波网格滤波算法处理中的至少一种,可以根据具体情况选择其中一种算法进行处理,也可以多种算法相结合进行处理。本发明优选的预处理具体操作为:

[0075]

(1)采用直通滤波算法去除冗余点:由于处理数据时,采用的是直角坐标系,所以需要将球坐标系转换成直角坐标系,因为激光扫描仪不是垂直于z轴安装,所以需要考虑激光安装倾角带来的影响,具体转换公式如下所示:

[0076][0077][0078]

其中激光坐标系中xoy平面定义为云台所在平面,z轴为垂直于旋转云台的方向,因此r,θ分别定义为物体与坐标原点的距离值、物体与z轴的夹角、物体在xoy投影与x轴正方向的夹角;最终分别在x轴与z轴坐标方向上应用直通滤波算法过滤掉目标场景中左侧围栏点云、地面噪声点云;

[0079]

(2)基于距离的半径滤波算法过滤去除孤立噪声点云和悬空点云;

[0080]

(3)虽然上述两个步骤滤除了各种干扰噪声,但是由此来进行点云分割,分割较耗时,因此考虑对稠密的点云进行降采样以获得稀疏的点云,来提高点云处理速度。由于需要保证原始点云的特征,应用体素化网格滤波的方法,借助点云法向量和距离值计算点云重心,设置体素边长为1.0cm,近似代替邻域的点云数据,达到数据精简的目的。

[0081]

s2、采用基于发线夹角的欧式聚类点云分割算法(算法步骤图如图1所示)对步骤s1得到的可视化场景点云图进行点云分割处理,将目标物体与非目标景物分割,得到3d目标物体区域点云图。采用基于发线夹角的欧式聚类点云分割算法对步骤s1得到的可视化场景点云图进行点云分割处理的步骤为:

[0082]

s21、计算可视化场景点云图中在半径为r的范围内点云之间的平均距离和均方差。具体操作为:

[0083]

s211、对于可视化场景点云图vq中的任意一个点vqi,vqi∈vq,遍历与其最近的k个邻近点,得到由k个点构成的集合,记作{vq

i1

,vq

i2

,

…

,vq

ik

},按式1计算{vq

i1

,vq

i2

,

…

,vq

ik

}集合中每个点与qi的平均距离di;

[0084][0085]

式1中,di表示{vq

i1

,vq

i2

,

…

,vq

ik

}集合中每个点与vqi的平均距离,

[0086]

s212、按照步骤s21所述的操作计算可视化场景点云图vq中所有点的平均距离di,然后利用式2、式3分别计算点云在不同半径r邻域下的平均距离均值d和均方差σ;

[0087][0088][0089]

其中,n表示可视化场景点云图vq的点云大小。

[0090]

优选地,不同r邻域下点云的平均距离均值、均方差和运行时间如表1所示。

[0091]

表1 不同r邻域下点云的平均距离均值、均方差和运行时间

[0092][0093]

s22、计算可视化场景点云图不同半径范围r内邻近点之间的法线夹角均值。点云中法线夹角的计算采用主成分分析的方法,具体操作为:

[0094]

s221、计算不同半径范围r内邻近点之间的法线夹角均值:

[0095]

对于可视化场景点云图vq中的任意一个点vqi,vqi∈vq,以vqi作为搜索起点,搜索半径为r内的所有邻近点,得到由k个点构成的集合,记作{vq

i1

,vq

i2

,

…

,vq

ik

},然后采用最小二乘法按式4、式5拟合出搜索起点vqi的最小二乘平面,

[0096][0097][0098]

其中,q(n,d)中d表示搜索半径为r邻域下的平均距离,n表示最小二乘平面的单位法向量,q表示质心值,q

xi

表示第i个点vqi的x方向上的质心值,q

yi

表示第i个点vqi的y方向上的质心值,q

zi

表示第i个点vqi的z方向上的质心值;

[0099]

s222、将点vqi的法线值记作vi,搜索点vqi的k个邻近点的法向量值,记作{v

i1

,v

i2

,

…

,v

ik

},采用式6、式7分别计算点vqi在r的半径范围内邻近点法线夹角值αi以及法线夹角均值

[0100][0101][0102]

其中,αi表示法线夹角值,表示法线夹角均值,g表示半径r范围内邻近点的数量,n表示半径r范围内邻近点的法线夹角的数量。

[0103]

经计算,不同近邻点r数目下对应的法线夹角均值结果如表2所示。

[0104]

表2 不同近邻点r数目下对应的法线夹角均值

[0105][0106]

s23、利用点云法线夹角在突兀重叠、接触区域变化较大的差异,根据计算得到的不同半径范围下的邻域法线夹角均值判断点云是否为目标物体点云的边界点(将计算得到的邻域法线夹角均值与表2中对应knumber的averagenormalangle进行比较,如果计算得到的邻域法线夹角均值对应的averagenormalangle范围内,则判断为边界点),然后根据目标物体点云的边界点,将可视化场景点云图中的目标物体与非目标景物进行分割。

[0107]

进一步地,为了检验本发明提出的基于发线夹角的欧式聚类点云分割算法的有效性,分别采用传统欧式聚类算法和本发明基于发线夹角的欧式聚类点云分割算法对同一张螺栓数据图像进行处理,比较两种算法对目标点云的分割效果,结果如图2所示。

[0108]

由图2可知,本发明基于法线夹角的欧式聚类点云分割算法比传统的欧式聚类方法可以多识别出三个螺栓物体,识别准确率达到81.8%,且比传统欧式聚类方法的准确率高出12.7%。因此,本发明先采用滤波算法进行预处理,再使用基于法线夹角的欧式聚类算法对点云进行分割,既可以实现离群点和冗余点的去除又可以实现对待测物体的分割需求;另一方面本发明的算法在速度和鲁棒性方面较原始的欧式聚类方法有明显提高。

[0109]

s3、从步骤s2得到的3d目标物体区域点云图中挑选包含完整目标物体几何信息和语义信息特征的点云图,并将其作为模板目标物体点云图。

[0110]

s4、采用激光扫描系统实时采集检测场景的3d点云数据,采用相机设备(红外数字高清高速智能球机)采集检测场景的左右视角2d图像对,得到待检测3d点云数据和待检测2d图像。按所述步骤s1、s2的操作对待检测3d点云数据进行处理,得到待检测3d目标物体区域点云图;采用深度卷积神经网络yolov3对待检测2d图像进行目标物体检测(采用深度卷积神经网络yolov3对待检测2d图像进行目标物体检测的示意图如图3所示),生成目标物体检测检测结果图,所述目标物体检测结果图包含目标物体的边界框、目标物体类别和置信度。

[0111]

s5、将所述目标物体检测结果图与待检测3d目标物体区域点云图进行融合,对待检测3d目标物体区域点云图进行点云着色,得到具有精确坐标信息的待检目标物体区域融合点云图。

[0112]

所述目标物体检测结果图与待检测3d目标物体区域点云图进行融合的具体操作为:

[0113]

s51、标定采集待检测2d图像的相机设备的内参矩阵(intrinsicmatrix),将获取的包含目标物体的文本格式的雷达点云转换成pcd格式;

[0114]

s52、根据步骤s4中目标物体检测检测结果图中的边界框信息,从目标物体检测结果图选取目标物体的轮廓边缘角点,记录轮廓边缘角点的位置坐标,并存储在data/corner_photo.txt;从待检测3d目标物体区域点云图中获取目标物体的边缘角点,记录其位置坐标,并存储在data/corner_lidar.txt;

[0115]

s53、读取data/corner_photo.txt和data/corner_lidar.txt中的数据,将从目标物体检测结果图选取目标物体的轮廓边缘角点与从待检测3d目标物体区域点云图中获取目标物体的边缘角点进行对应点迭代计算,得到包含残差和重投影误差的外参矩阵;

[0116]

s54、根据待检测3d目标物体区域点云图中点云的位置坐标、步骤s51得到的内参矩阵和步骤s53得到的外参矩阵计算出所述相机设备的相机像素坐标,然后将目标物体检测检测结果图的rgb信息再赋给待检测3d目标物体区域点云图中的点云,完成点云着色,得到具有精确坐标信息的待检目标物体区域融合点云图。

[0117]

s6、采用基于局部特征的全局配准算法将待检目标物体区域融合点云图与模板目标物体点云图进行配准,根据配准信息,得到待检目标物体区域融合点云图中目标物体的位姿信息。具体步骤为:

[0118]

s61、分别采用sift(scaleinvariantfeaturetransform)算法提取模板目标物体

点云图、待检目标物体区域融合点云图中的关键点,并采用fpfh(fast point feature histogram)算法对提取的关键点进行特征描述,得到关键点特征;

[0119]

s62、采用全局配准算法将待检目标物体区域融合点云图中的关键点与模板目标物体点云图的关键点进行配对,得到关键点对;

[0120]

s63、依次采用互换一致性测试、三点测试、空间位置测试剔除关键点对中的错误匹配,并设置误差函数对关键点对进行验证,得到匹配关键点对;根据匹配关键点对信息,得到待检目标物体区域融合点云图中目标物体的位姿信息。

[0121]

步骤s63中采用互换一致性测试、三点测试、空间位置测试剔除关键点对中的错误匹配,并设置误差函数对关键点对进行验证,得到匹配关键点对,其具体操作为:

[0122]

s631、对于待检目标物体区域融合点云图p的任意一个关键点pi,采用fpfh提取的关键点特征表示为f(pi),则待检目标物体区域融合点云图p的关键点fpfh特征集合可定义为:f(p)={f(pi):pi∈p};对于模板目标物体点云图q的任意一个关键点qi,采用fpfh提取的关键点特征表示为f(qi),则模板目标物体点云图q的关键点fpfh特征集合可定义为:f(q)={f(qi):qi∈q},设c1为f(p)和f(q)对应关系的集合;

[0123]

s632、互换一致性测试:对于关键点对(pi,qi),当且仅当f(pi)是f(qi)在f(p)中的最近邻,且仅当f(qi)是f(pi)在f(q)中的最近邻时,关键点对(pi,qi)被保留在结果点对c

11

中;

[0124]

s633、三点测试:从结果点对c

11

中随机选取三个关键点对(p1,q1)、(p2,q2)、(p3,q3),检验(p1,p2,p3)与(q1,q2,q3)是否符合式8所示的验证关系,满足验证关系的关键点对被保存在结果点对c

111

中;

[0125][0126]

其中,τ=0.9;

[0127]

s634、空间位置测试:按照式9计算结果点对c

111

中所有关键点对中所有关键点qi的点云重心centriod,按照式10计算c

111

中所有关键点对中每一个关键点qi与点云重心centriod的位置关系c(qi),并计算所有关键点qi的c(qi)的平均值,将每一个关键点qi的c(qi)与c(qi)平均值进行比较,删除c(qi)大于c)qi)平均值的关键点对;

[0128][0129][0130]

s635、误差函数验证:采用误差函数计算经步骤s54处理后的结果点对c

111

中每一个关键点对两个关键点之间的误差,得到每个关键点对的误差;然后求取结果点对c

111

中所有关键点对的误差平均值μ和误差方差δ2,若μ<δ2,则验证完成,结果点对c

111

中剩余的关键点对即为匹配关键点对;其中,误差函数e(t,l)的计算公式如式11所示;

[0131][0132]

其中,λ表示随机数,其范围为:λ∈[0,1],ti表示第i个关键点对的刚体变换矩阵,

t

i 1

表示第i 1个关键点对的刚体变换矩阵,p表示待检目标物体区域融合点云图中的关键点云集,q表示模板目标物体点云图中的关键点点云集,ψ(l

p,q

)表示关键点对关系。

[0133]

误差函数e(t,l)的推导过程为:

[0134]

依次选取待检目标物体区域融合点云图p中的关键点,利用最近邻搜索算法(flann)在模板目标物体点云图q中找到其对应点的索引,在后续对关键点进行法线估计的时候使用;为了找到模板目标物体点云图q和与待检目标物体区域融合点云图p对齐的刚体变换矩阵t,设定目标公式e(t)如12所示。

[0135]

e(t)=∑

(p,q)∈k

ρ(||p-tq||)

ꢀꢀꢀꢀ

式12

[0136]

这里ρ(

·

)是一个估算器,使用健壮的误差函数是至关重要的,因为公式12中的许多项都是由假约束贡献的,通过设定一个可以自动执行验证的估算器ρ(计算公式如式13所示),而不增加额外的计算成本。

[0137][0138]

我们假设l={l

p,q

}对应过程是线性的,在t和l上优化以下联合目标:

[0139]

e(t,l)=∑

(p,q)∈k

l

p,q

||p-tq||2 ∑

(p,q)∈k

ψ(l

p,q

)

ꢀꢀꢀꢀꢀ

式14

[0140]

点对关系为:

[0141][0142]

为了最小化e(t,l)对公式求偏导得到:

[0143][0144]

计算出结果为:

[0145][0146]

利用式17的结果计算式14中的l

p,q

,就可以计算出e(t)的值。但是当l固定时,这种解决方案不能扩展到多个曲面的配准情况,因此我们提出了更灵活的办法,将变换矩阵中的旋转变量w和变换向量t定义为六个参数的向量:ξ=(ω,t)=(α,β,γ,a,b,c),变换矩阵就可以线性表示为:

[0147][0148]

公式18中是上一次迭代中的位姿估计结果,公式7是ξ的误差平方和优化目标,采用牛顿迭代法将其转化为线性关系来求解ξ,其中残差为r,jr是其雅可比行列式。通过将ξ映射到来计算得到变换矩阵t。

[0149]

为了验证本发明基于局部特征的全局配准算法的配准效果,采用分别本发明基于局部特征的全局配准算法、现有sac icp算法对检测目标物体(渣罐和吊钩)进行配准(配准前的具体操作参见步骤s1-s5),配准效果的对比结果如表3和图4所示。

[0150]

表3 不同配准算法的目标物体位姿偏差

[0151][0152]

由表3和图4可知,本发明基于局部特征的全局配准算法能够在复杂的现场工作场景中精准识别和计算目标物体渣罐和吊钩的位姿,与sac icp算法相比具有更高的精度和可靠性。

[0153]

以上所述仅为本发明的较佳实施例而已,但不仅限于上述实例,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。