1.本发明涉及多源遥感影像场景识别领域,具体涉及一种基于变形卷积选择分配网络的多源遥感影像场景识别方法。

背景技术:

2.随着我国遥感事业的不断发展,越来越多的遥感数据可以被公开获取。其中利用遥感数据进行特定区域内的场景识别已经成为了遥感领域的重要研究方向之一,其目的在于有效识别所给图像中的特定场景,精准定位并有效分类其所属的场景类别,这一工作对于指导生产生活、防止违法扩建或矿产开采以及为相关单位提供决策辅助具有重要意义。

3.而在遥感影像场景识别任务中,由于复杂环境下不同场景的类内差异以及特定传感器在极端条件下观测受限等问题,因此单独使用一类遥感影像,如高光谱图像、多光谱图像、光学图像等已经很难满足实际应用中的日益增长的精度需求。因此,利用多源遥感影像进行场景识别任务已经逐渐吸引了更多研究人员的注意力。近年来,深度学习的出现与发展为各行各业都提供了新的发展模式和方法,其中卷积神经网络由于其强大的学习能力和泛化性,已经被广泛应用于各个研究领域。然而,由于卷积核固定的形状和大小,在处理实际任务中面对各种复杂多变的场景表现就显得有些不足。

4.此外,由于多源遥感影像观测优势的差异,如何更加有效地利用多源遥感影像各自的优势,并实现优势互补也成为了多源遥感影像场景识别任务中必须要考虑的问题。

技术实现要素:

5.本发明针对现有方法的问题,在充分考虑了多源遥感场景识别任务中不同场景的特征,模型对于不同尺度、不同形状的场景表现的处理能力,以及模型对于异源遥感影像应有不同的关注程度,在yolov3模型的基础上提出了一种基于变形卷积选择分配网络的多源遥感影像场景识别方法,利用可变性卷积处理多尺度、多形状的场景表现,并且通过一个选择性分配模块有效融合多源遥感影像。

6.为了实现以上发明目的,本发明采取的技术方案如下:

7.一种基于变形卷积选择分配网络的多源遥感影像场景识别方法,包括以下步骤:

8.步骤1:构建特征提取基础网络。由于yolov3中的特征提取基础网络仅包含普通卷积,在处理多尺度、多形状的场景表现时特征提取能力欠缺,因此本发明在yolov3的卷积神经网络中引入变形卷积代替普通卷积,从而获取多尺度、多形状的场景空间结构信息。此外,由于多源遥感影像特征差异性,本发明为每一类遥感数据提供了一个特有的特征提取基础网络。

9.步骤2:融合异源遥感影像特征金字塔上对应尺度分支的目标特征。在yolov3的特征金字塔各尺度分支上引入选择性分配融合模块用以融合多源遥感影像,对于不同影像的特征分配不同的融合权重。

10.步骤3:融合后的特征重新构成了新的不同尺度的特征表示,利用yolov3模型的损

失函数,以最小化损失为优化目标,利用反向传播优化模型参数,训练场景识别模型。

11.步骤4:模型训练完成后保存,采集并输入所要进行场景识别任务的遥感影像,加载步骤3中训练完成的场景识别模型,利用上述模型识别影像中的不用场景,得到目标场景的位置和类型,可视化输出。

12.进一步地,步骤1包括如下子步骤:

13.步骤1.1:构建变形卷积。对于普通的卷积操作来说,针对输入特征图u,其正常的卷积输出包含n个通道。而变形卷积在u上使用2n个普通卷积,从而得到包含2n个通道的特征图。之后将得到的通道数为2n的特征图(形状为b,h,w,2n)与输入特征图(形状为b,h,w,n)相加,从而得到实际的采样位置。

14.步骤1.2:以yolov3的darknet53特征提取网络为基础,将darknet53网络中普通卷积替换为变形卷积,在不改变特征图大小的前提下获取多尺度,多形状的空间特征,提高场景定位精度。

15.进一步地,步骤2包括如下子步骤:

16.步骤2.1:步骤1中的特征提取基础网络会通过卷积-下采样操作来得到不同尺度的特征图,这里对于这些特征图进行反向的上采样操作,并与基础网络中得到的相同尺度的特征图进行拼接,从而构成特征金字塔的结构。

17.步骤2.2:构建选择性分配融合模块。针对异源特征输入xa和xb,首先将两者相加,得到x。之后利用全局平均池化以及多个全连接层,得到两个特征加权的注意力向量αa和αb。将注意力向量与原有的特征输入相乘得到加权后的特征输出x'a和x'b,这样就可以为不用的遥感数据分配不同的融合权重。之后,将两者相加得到融合增强后的特征输出。

18.步骤2.3:在步骤1构建的多尺度特征金字塔上引入选择性分配融合模块。将不同类别的遥感数据对应尺度的特征作为输入,得到融合后的多源多尺度特征金字塔。

19.进一步地,步骤3包括如下子步骤:

20.步骤3.1:输入多源遥感训练影像,训练场景识别模型,模型的输出为s

×s×

(a*(4 class))维的特征,具体含义为预测的输入的影像中场景边界框的位置,大小以及所包含的场景类别的概率。其中s

×

s为场景识别模型预测的网络个数,a为特征金字塔中每一个尺度分支中每个网络对应的先验框的个数,class表示场景类别数。

21.步骤3.2:将模型输出的场景识别结果与先验标签进行比较,计算他们之间的损失,利用tolov3的损失函数,以最小化损失为目标,优化网络参数,并将训练好的场景识别模型保存。

22.进一步地,步骤4包括如下子步骤:

23.步骤4.1:采集并输入目标区域的多源遥感影像,读取步骤3所保存的训练好的场景识别模型,预测得到场景的位置坐标及所属类别,输出并显示多源遥感影像场景识别结果。

24.与现有方法相比,本发明的优点在于:

25.充分考虑了多源遥感影像的特点,模型对于不同尺度、不同形状的场景表现有了更好的特征提取能力,以及充分利用多源数据的互补优势,有效地融合了多源遥感影像;在yolov3模型的基础上采用变形卷积获取多尺度、多形状的场景空间结构信息,在多源数据构建的特征金字塔对应尺度引入选择性分配融合模块使得模型可以有选择性地为异源影

像特征分配不同的融合权重,从而更好地实现多源遥感影像优势互补;提出了一种基于变形卷积选择分配网络的多源遥感影像场景识别方法,实现了目标区域内较高精度的场景识别任务。

附图说明

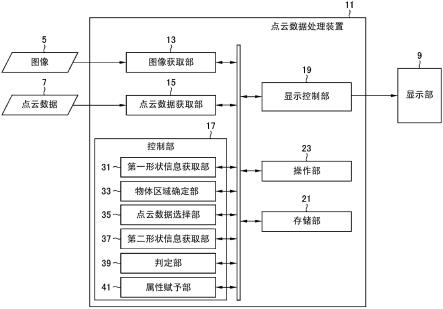

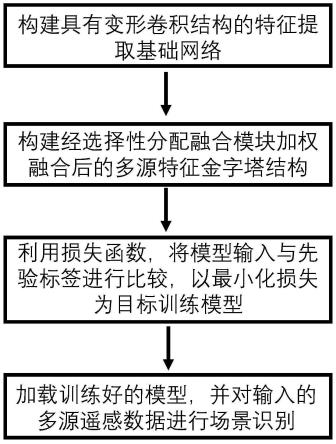

26.图1是本发明种基于变形卷积选择分配网络的多源遥感影像场景识别方法的流程图;

27.图2是本发明所构建的变形卷积改进的yolov3特征提取基础网络结构图;

28.图3是本发明构建的用以融合异源遥感影像特征的选择性分配融合模块;

29.图4是本发明实施例中所提的基于变形卷积选择分配网络的多源遥感影像场景识别在多源遥感影像数据集上的场景识别流程图。

具体实施方式

30.为使本发明的目的、技术方案及优点更加清楚明白,以下根据附图并列举实施例,对本发明做进一步详细说明。

31.如图1所示,一种基于变形卷积选择分配网络的多源遥感影像场景识别方法,包括以下步骤:

32.步骤1:构建特征提取基础网络,在yolov3的卷积神经网络中引入变形卷积代替普通卷积,从而获取多尺度、多形状的场景空间结构信息。对于所接受到的多源遥感影像,每一类数据拥有一个独立的特征提取基础网络。

33.步骤2:融合多源遥感影像特征金字塔上对应尺度分支的目标特征。在yolov3的特征金字塔各尺度分支上引入选择性分配融合模块用以融合多源遥感影像,对于不同影像的特征分配不同的融合权重;

34.步骤3:融合后的特征重新构成了新的不同尺度的特征表示,利用yolov3模型的损失函数,以最小化损失为优化目标,利用反向传播优化模型参数,训练场景识别模型;

35.步骤4:模型训练完成后保存,采集并输入所要进行场景识别任务的遥感影像,加载步骤3中训练完成的场景识别模型,利用上述模型识别影像中的不用场景,得到目标场景的位置和类型,可视化输出。

36.具体而言,步骤1包括如下步骤:

37.步骤1.1:构建变形卷积。对于普通的卷积操作来说,针对输入特征图u,其正常的卷积输出包含n个通道。而变形卷积在u上使用2n个普通卷积,从而得到包含2n个通道的特征图。之后将得到的通道数为2n的特征图(形状为b,h,w,2n)与输入特征图(形状为b,h,w,n)相加,从而得到实际的采样位置。

38.步骤1.2:以yolov3的darknet53特征提取网络为基础,将darknet53网络中普通卷积替换为变形卷积,在不改变特征图大小的前提下获取多尺度,多形状的空间特征,提高场景定位精度。

39.所构建的新基础特征提取网络中,具有变形卷积的残差模块结构如图2所示。

40.步骤2包括如下步骤:

41.步骤2.1:步骤1中的特征提取基础网络会通过卷积-下采样操作来得到不同尺度

的特征图,这里对于这些特征图进行反向的上采样操作,并与基础网络中得到的相同尺度的特征图进行拼接,从而构成特征金字塔的结构。

42.步骤2.2:构建选择性分配融合模块。针对异源特征输入xa和xb,首先将两者相加,得到x。之后利用全局平均池化以及多个全连接层,得到两个特征加权的注意力向量αa和αb。将注意力向量与原有的特征输入相乘得到加权后的特征输出x'a和x'b,这样就可以为不用的遥感数据分配不同的融合权重。之后,将两者相加得到融合增强后的特征输出。

43.步骤2.3:在步骤2.1构建的多尺度特征金字塔上引入选择性分配融合模块。将不同类别的遥感数据对应尺度的特征作为输入,得到融合后的多源多尺度特征金字塔。

44.所构建的选择性分配融合模块结构如图3所示。

45.步骤3包括如下步骤:

46.步骤3.1:输入多源遥感训练影像,训练场景识别模型,模型的输出为s

×s×

(a*(4 class))维的特征,具体含义为预测的输入的影像中场景边界框的位置,大小以及所包含的场景类别的概率。其中s

×

s为场景识别模型预测的网络个数,a为特征金字塔中每一个尺度分支中每个网络对应的先验框的个数,class表示场景类别数。

47.步骤3.2:将模型输出的场景识别结果与先验标签进行比较,计算他们之间的损失,利用yolov3的损失函数,以最小化损失为目标,优化网络参数,并将训练好的场景识别模型保存。

48.步骤4包括如下步骤:

49.步骤4.1:采集并输入目标区域的多源遥感影像,读取步骤3所保存的训练好的场景识别模型,预测得到场景的位置坐标及所属类别,输出并显示多源遥感影像场景识别结果。

50.实施例1

51.实施例实现在目标区域内多源遥感影像中多场景的识别,其具体实施流程如图4所示。

52.步骤1:采集多源遥感影像,对影像中的目标场景进行标注并构建多源遥感影像场景识别数据集,对数据集中的样本进行预处理,包括辐射校正、光谱矫正、多源配准等一系列操作。此外,对训练图像进行随机的选择、平移、增加随机噪声等操作来进行数据增强,提升训练样本的多样性。对于获取到的遥感影像,对影像中的场景位置和类别进行标注,得到适用于场景识别模型训练的样本的对应标签。

53.步骤2:在yolov3的特征提取基础网络中引入变形卷积来提取和保留多尺度、多形状的场景表现的空间结构信息。普通卷积的输出特征图包含n个通道,而变形卷积通过利用2n个卷积来得到通道数为2n的特征图,这里的特征图代表的是对应位置上x和y方向上的偏移量,通过将这些偏移量与原始特征图相加,从而得到实际的采样位置。

54.步骤3:构建具有不同尺度特征的三层特征金字塔结构。根据多源遥感影像的各自优势,为每一类特征构造一个独有的特征金字塔。将多源遥感特征金字塔的对应尺度的特征送入选择性个分配融合模块,将多源数据融合,从而得到融合增强后的多尺度特征输出。

55.步骤4:加载数据集,将训练样本送入场景识别模型,得到的场景识别结果与先验标签进行比较,利用yolov3的损失函数,不断循环迭代直至损失函数收敛,从而得到训练好的场景识别模型。

56.步骤5:采集并输入待测区域的多源遥感影像,加载根据步骤4训练好的模型进行场景识别,得到影像中各场景的位置坐标和所属类别,输入多源遥感影像场景识别结果。

57.本领域的普通技术人员将会意识到,这里所述的实施例是为了帮助读者理解本发明的实施方法,应被理解为本发明的保护范围并不局限于这样的特别陈述和实施例。本领域的普通技术人员可以根据本发明公开的这些技术启示做出各种不脱离本发明实质的其它各种具体变形和组合,这些变形和组合仍然在本发明的保护范围内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。