1.本发明涉及图像检测技术领域,尤其涉及一种智能驾驶前视图像的检测方法。

背景技术:

2.自动驾驶技术发展如火如荼,高级驾驶辅助系统(adas)也逐渐成为汽车标配。人们对其中的前视感知技术的要求也越来越高,希望前视摄像头能“看”得更远、更清晰,因此,超高清摄像头被逐渐应用于汽车感知系统中。超高清摄像头采集到的高清图像进行检测后,可以被识别出图像中的人、物等特征,为自动驾驶提供车辆提供前方障碍信息,提高自动驾驶的安全性。

3.目前,卷积神经网络被广泛应用于对高清图像的检测,相比传统视觉算法,卷积神经网络对芯片运算能力要求更高。通常来说,卷积神经网络的网络模型越大,输入的图片分辨率越大,那么检测结果对识别小目标的效果越好。但是,目前市场上车载芯片运算能力普遍不高,常规的做法是设计一个轻量化网络模型,然后将输入网络模型的图片尺寸固定为60万像素左右,主要有切图和不切图两种方式:

4.(1)不切图:假设超高清摄像头采集到一张800万(3840

×

2160)像素的图片,则需要先将800万像素的图片缩小到60万像素左右,然后送入卷积神经网络模型中计算,这样导致无法有效利用超高清图片中小目标的局部信息,从而影响小目标的检测效果。

5.(2)切图:首先将原图依次切出多张相同尺寸的小图,小图的尺寸跟网络模型输入尺寸一致,接着每张小图送入卷积神经网络模型中进行检测,再将超高清原图缩小到网络模型的输入尺寸送入网络检测,得到最终的检测结果。以上面3840

×

2160的图片为例,原图需要切出16张60万像素左右的小图,最终需要检测16 1=17次。这种切图检测方式,虽然远处小目标的检出能力得到提升,但带来的计算次数显著增加,即使降低网络模型大小,总的检测时间也会远高于不切图检测的方式,检测效率低。

技术实现要素:

6.本发明要解决的技术问题是:为了解决现有技术中对超高清图片的检测方法无法兼顾检测准确率和检测效率效率的技术问题,本发明提供一种智能驾驶前视图像的检测方法,不仅能够提升小目标的检测准确率,而且检测次数更少,能够提高检测效率。

7.本发明解决其技术问题所采用的技术方案是:一种智能驾驶前视图像的检测方法,包括以下步骤:s1、获取前视摄像头采集到的前视图像;s2、从所述前视图像中获取多张第一图片xi和多张第二图片yj,第二图片yj的尺寸大于第一图片xi的尺寸;s2、将所述第二图片yj处理后得到第三图片yj’;s4、将所述第一图片xi和第三图片yj’输入卷积神经网络模型中,输出多个第一检测结果;s5、将所述第一检测结果映射至所述前视图像中,得到第二检测结果;s6、将多个第二检测结果进行融合处理,得到最终检测结果。

8.进一步的,所述第一检测结果为目标检测结果或语义分割检测结果。

9.进一步的,所述第一图片xi的尺寸为w

×

h,所述第二图片yj的尺寸为2w

×

2h。

10.进一步的,所述相邻两张第一图片xi之间重叠0.2w,所述第一图片xi和第二图片yj之间重叠0.2h,相邻两张第二图片yj之间重叠0.6w。

11.进一步的,将所述前视图像的尺寸缩小为w

×

h输入卷积神经网络模型中,输出第一检测结果;所述第一检测结果为目标检测结果。

12.进一步的,当所述第一检测结果为目标检测结果时,步骤s6中的融合处理具体包括:

13.遍历所有的第二检测结果,判断是否存在边缘矩形框;

14.若否,则对所述第二检测结果进行非极大值抑制处理,得到最终检测结果;

15.若是,则计算所述边缘矩形框与其他矩形框之间的iog值;若iog值大于阈值roi_threshold,则判断该边缘矩形框为冗余框,删除该冗余框;直至所有的冗余框被删除后,对第二检测结果进行非极大值抑制处理,得到最终检测结果。

16.进一步的,当所述第一检测结果为语义分割检测结果时,步骤s6中的融合处理具体包括:

17.当相邻两张第一图片xi的第二检测结果融合时,重叠区域会得到两个类别概率值,取两个类别概率值中最大值为重叠区域的最终类别概率值;

18.当第一图片xi的第二检测结果和第二图片yj的第二检测结果融合时,重叠区域会得到两个以上的类别概率值,取第一图片xi的类别概率中的最大值为重叠区域的最终类别概率值。

19.进一步的,所述第一图片xi为所述前视图像的上方区域;所述第二图片yj为所述前视图像的下方区域。

20.进一步的,所述第三图片yj’的尺寸为w

×

h。

21.进一步的,设第一图片xi的数量为n,第二图片yj的数量为m,则所述检测方法的检测次数为n m 1或n m。

22.本发明的有益效果是,本发明的智能驾驶前视图像的检测方法通过对切图方式的改进,再结合融合策略,不仅能够提升对图像中的远处小目标的检测能力和检测准确率,还能够减少检测次数,提升检测效率。

附图说明

23.下面结合附图和实施例对本发明进一步说明。

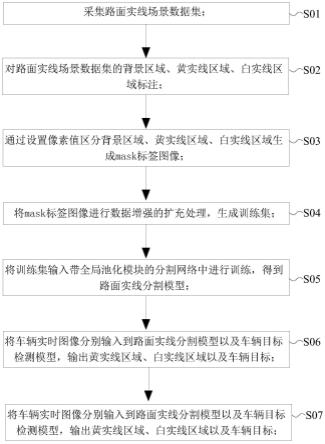

24.图1是本发明的智能驾驶前视图像的检测方法的流程图。

25.图2是本发明的对前视图像切图的示意图。

26.图3是现有技术切图不重叠的示意图。

27.图4是本发明的目标检测的检测过程示意图。

28.图5是本发明的坐标变换的示意图。

29.图6是本发明的目标检测结果融合的流程图。

30.图7是本发明的冗余框的示意图。

31.图8是本发明的语义分割检测的检测过程示意图。

具体实施方式

32.现在结合附图对本发明作进一步详细的说明。这些附图均为简化的示意图,仅以示意方式说明本发明的基本结构,因此其仅显示与本发明有关的构成。

33.在本发明的描述中,需要理解的是,术语“中心”、“纵向”、“横向”、“长度”、“宽度”、“厚度”、“上”、“下”、“前”、“后”、“左”、“右”、“竖直”、“水平”、“顶”、“底”“内”、“外”、“顺时针”、“逆时针”、“轴向”、“径向”、“周向”等指示的方位或位置关系为基于附图所示的方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的装置或元件必须具有特定的方位、以特定的方位构造和操作,因此不能理解为对本发明的限制。此外,限定有“第一”、“第二”的特征可以明示或者隐含地包括一个或者更多个该特征。在本发明的描述中,除非另有说明,“多个”的含义是两个或两个以上。

34.在本发明的描述中,需要说明的是,除非另有明确的规定和限定,术语“安装”、“相连”、“连接”应做广义理解,例如,可以是固定连接,也可以是可拆卸连接,或一体地连接;可以是机械连接,也可以是电连接;可以是直接相连,也可以通过中间媒介间接相连,可以是两个元件内部的连通。对于本领域的普通技术人员而言,可以具体情况理解上述术语在本发明中的具体含义。

35.如图1所示,本发明的智能驾驶前视图像的检测方法,包括以下步骤:

36.s1、获取前视摄像头采集到的前视图像。

37.s2、从前视图像中获取多张第一图片xi和多张第二图片yj,第二图片yj的尺寸大于第一图片xi的尺寸。

38.s2、将第二图片yj处理后得到第三图片yj’。

39.s4、将第一图片xi和第三图片yj’输入卷积神经网络模型中,输出多个第一检测结果。

40.s5、将第一检测结果映射至前视图像中,得到第二检测结果。

41.s6、将多个第二检测结果进行融合处理,得到最终检测结果。

42.需要说明的是,前视图像是超高清图像,前视图像的尺寸例如是3.4w

×

2.8h。从前视图像中可以分割出多张第一图片xi和多张第二图片yj,换言之,第一图片xi和第二图片yj是前视图像的局部图像。其中,第二图片yj的尺寸大于第一图片xi的尺寸,第一图片xi为前视图像的上方区域,第二图片yj为前视图像的下方区域。因为在前视感知场景中,远处小目标是位于图像的上半部,近处大目标是位于图像的下半部,由于远处小目标的像素信息比近处大目标的像素信息要更少,如果远处小目标的图片再次进行缩小,会导致像素信息进一步缺失;而近处大目标的图片即使长、宽分别缩小两倍,还是能判断出目标原有的特征、类别。因此,在切图时,将前视图像的上方区域用第一图片xi(即小图)切割,前视图像x的下方区域用第二图片yj(即中图)切割。例如,第一图片xi的尺寸为w

×

h,第二图片yj的尺寸为2w

×

2h,即,第二图片yj的尺寸是第一图片xi的四倍。在进行检测之前,还需要将第二图片yj的尺寸缩小为与第一图片xi相同,即,第三图片yj’的尺寸也为w

×

h。然后将第一图片xi和第三图片yj分别输入卷积神经网络模型中进行检测。这样,能够在提升远处小目标检出能力的同时,可以降低检测运算量,提高检测效率。需要说明的是,本发明中所用的卷积神经网络是已经提前训练好的。

43.具体的,相邻两张第一图片xi之间重叠0.2w,第一图片xi和第二图片yj之间重叠

0.2h,相邻两张第二图片yj之间重叠0.6w。换言之,小图和小图之间是有20%的区域是重叠的,小图和中图之间也有20%的区域重叠,中图和中图之间有30%的区域是重叠的。例如,以图2为例,前视图像被分为了四张小图和两张中图,分别记为x1、x2、x3、x4、y1和y2,小图x1和小图x2之间有20%区域重叠,小图x2和小图x3之间有20%区域重叠,小图x3和小图x4之间有20%区域重叠,并且,小图x1、x2、x3、x4均位于前视图像的上半部分。中图y1和中图y2之间有30%的区域重叠,且,中图y1的上部与小图x1、x2、x3的下部均有重叠,中图y2的上部与小图x2、x3、x4的下部均有重叠。本发明在切图时,设置重叠区域是为了提高图片边缘处目标的检出率以及检测准确率,例如,请参考图3,假设目标刚好位于切线处,此时目标的像素信息一半位于小图x1中,另一半位于小图x2中,如果不设置重叠区域,那么卷积神经网络模型在小图x1和x2中都会把这个目标检测出来,但是无法判断出这两个检测结果为同一个目标还是两个目标,导致最终的检测结果与实际不符合。

44.需要说明的是,本发明的第一检测结果为目标检测结果或语义分割检测结果。换言之,本发明可以对前视图像进行两种检测,即,目标检测和语义分割检测。目标检测是指在图像中将目标用矩形框框出来,语义分割检测是指在图像中将属于同一类别的像素点赋予相同的颜色。本发明采用的卷积神经网络模型可以同时具备目标检测功能和语义分割检测功能。目标检测和语义分割检测的区别在于,目标检测任务需要将前视图像也输入卷积神经网络模型中,输出第一检测结果。下面分别介绍两种检测的具体过程。

45.(一)目标检测

46.如图4所示,在目标检测任务中,首先将获取的前视图像分割出n张第一图片xi和m张第二图片yj,i=1,2,...,n;j=1,2,...,m。将m张第二图片yj的尺寸缩小为与第一图片xi相同,得到m张第三图片yj’,将前视图像(即原图)的尺寸缩小为与第一图片xi相同,得到缩小图。将n张第一图片xi、m张第二图片yj以及一张前视图像的缩小图分别输入卷积神经网络模型中,得到n m 1个目标检测结果。将n张第一图片xi和m张第二图片yj的目标检测结果进行坐标变换映射至前视图像中,得到n m个第二检测结果。最后将n m个第二检测结果(即目标检测结果)和前视图像的第一检测结果进行融合处理,得到最终的目标检测结果。在目标检测任务中,将前视图像的缩小图也输入卷积神经网络中,最后一起做融合处理,是为了提升卷积神经网络模型的全局预测能力,同时也可以避免超大目标检测不准的情况。

47.请参考图5,将n张第一图片xi和m张第二图片yj的目标检测结果(即第一检测结果)进行坐标变换映射至前视图像中,坐标变换具体包括:以图片(包括第一图片xi和第二图片yj)左上角为原点,水平向右为x轴正方向,竖直向下为y轴正方向建立二维坐标系,这样就能获得图片中每个像素点的坐标(x,y)。第一检测结果即为矩形框,矩形框也是由多个像素点组成的,由此可以获得矩形框的所有像素点坐标。将第一图片xi和第二图片yj的矩形框映射至前视图像即为点坐标

→

点坐标之间的映射。每一张第一图片xi和每一张第二图片yj均可以建立自己的二维坐标系,由于每一张图片在前视图像中位置不同,因此,点坐标的映射关系也有所不同。

48.例如,n张第一图片xi从左至右依次为x1、x2、x3,...,xn,设第一图片xi中的某个像素点u的坐标为(x

ai

,y

ai

),将该u点映射至前视图像中的映射公式(1)为:

49.x'

ai

=0.8w

×

(i-1) x

ai

50.y'

ai

=y

ai

51.其中,a表示小图的像素点数量,i表示小图的序号,(x'

ai

,y'

ai

)表示映射后u点在前视图像中位置。通过该映射公式(1)可以将所有小图的矩形框映射至原图中。

52.例如,m张第二图片yj从左至右依次为y1、...、ym,设第二图片yj中的某个像素点r的坐标为(x

bj

,y

bj

),将r点映射至前视图像中的映射公式(2)为:

53.x'

bj

=1.4w

×

(j-1) x

bj

54.y'

bj

=0.8h

×

(j-1) y

bj

55.其中,b表示中图的像素点数量,j表示中图的序号,(x'

bj

,y'

bj

)表示映射后r点在前视图像中位置。通过该映射公式(2)可以将所有中图的矩形框映射至原图中。

56.根据映射公式(1)和(2)可知,小图、中图与原图之间的映射关系是不同的,这是由于切图的特殊性,使得小图和中图在原图中所处的位置不同,为了能够将矩形框准确反映在原图中,需要将小图和中图分别做坐标映射。

57.请参考图6,在目标检测任务中,将小图和中图的第二检测结果(即映射后的矩形框)与原图的第一检测结果做融合处理的具体过程包括:遍历所有的第二检测结果,判断是否存在边缘矩形框。若否,则对第二检测结果进行非极大值抑制处理,得到最终检测结果。若是,则计算边缘矩形框与其他矩形框之间的iog值;若iog值大于阈值roi_threshold,则认为该边缘矩形框为冗余框,删除该冗余框;直至所有的冗余框被删除后,对第二检测结果进行非极大值抑制处理,得到最终检测结果。

58.由于本发明在切图时是有重叠区域的,在对小图和中图做检测时,相当于重叠部分的区域会做两次检测,并且,在切图时,切线有可能会穿过目标,导致有的图片只能检测到目标的一部分,从而导致对目标的识别不准确。因此,在做融合处理时,需要对第二检测结果进行筛选,排除冗余框。例如图7所示,小图1和小图2有20%重叠,小图1只能检测到目标的左半部分(abef),而小图2检测到了目标的全部(acdf),此时,小图1对目标(abef)的检测结果是多余的。

59.在做融合处理时,首先遍历所有的第二检测结果,判断是否存在边缘矩形框。边缘矩形框是指该矩形框位于图片切线附近。例如可以计算出第二检测结果与其所在的图片的切线之间的距离d,并设定距离判断阈值side_threshold,若距离d小于距离判断阈值side_threshold(距离判断阈值例如为5,单位:像素),则标记该第二检测结果为边缘矩形框;若距离d大于或等于距离判断阈值side_threshold,则标记该第二检测结果为正常矩形框。识别出边缘矩形框后,需要判断该边缘矩形框是否为冗余框。计算该边缘矩形框与其他矩形框之间的iog值,iog值的计算公式为iog(g,p)=(g∩p)/g,g表示边缘矩形框的面积,p表示其他矩形框的面积,g∩p表示两个面积的交集。若iog值大于阈值roi_threshold(阈值roi_threshold例如为0.8),则认为该边缘矩形框为冗余框。以图为例,g=abef的面积,p=acdf的面积,g∩p等于g,则iog值等于1(大于0.8)。因此,该边缘矩形框为冗余框,需要删除。直到所有第二检测结果中的冗余框被删除后,对剩余的第二检测结果做非极大值抑制(non-maximum suppression,nms)处理,得到最终检测结果。由于剩余的第二检测结果(即非冗余框)中可能会存在相交的情况(即同一目标位置处存在多个矩形框),通过非极大值抑制处理后,在相交的矩形框中只保留置信度最高的一个矩形框,其他没有相交的矩形框直接保留,得到最终的检测结果,这样可以进一步提升目标检测的准确度。

60.(二)语义分割检测

61.如图8所示,在语义分割检测任务中,首先将获取的前视图像分割出n张第一图片xi和m张第二图片yj,i=1,2,...,n;j=1,2,...,m。将m张第二图片yj的尺寸缩小为与第一图片xi相同,得到m张第三图片yj’。将n张第一图片xi和m张第二图片yj分别输入卷积神经网络模型中,得到n m个语义分割检测结果。然后将n m个第二检测结果(即语义分割检测结果)进行融合处理,得到最终的目标检测结果。

62.在语义分割检测任务中,得到的检测结果为将同类别的特征用相同的颜色显示出来,将n张第一图片xi和m张第二图片yj的语义分割检测结果进行坐标变换映射至前视图像中,也就是对像素点做坐标变换。具体的坐标映射公式可采用映射公式(1)和(2)进行处理,此处不再赘述。

63.由于语义分割检测是对特征类别的判断,融合处理具体包括两种情况:(1)当相邻两张第一图片xi的第二检测结果融合时,重叠区域会得到两个类别概率值,取两个类别概率值中最大值为重叠区域的最终类别概率值。(2)当第一图片xi的第二检测结果和第二图片yj的第二检测结果融合时,重叠区域会得到两个以上的类别概率值,取第一图片xi的类别概率中的最大值为重叠区域的最终类别概率值。换言之,由于在切图时,图和图之间是有重叠区域的,因此,在融合处理时,需要对重叠区域检测出的类别进行判断选择。例如,小图和小图的重叠区域检测出了两个类别概率,例如,小图x1检测出的是“人”,小图x2检测出的是“车”,那么在做融合处理时,选择“人”和“车”中概率值更大的一者作为该特征的最终类别。例如,小图和中图之间的重叠区域,该重叠区域由于是多张小图和中图重叠,所以检测时可以得到两个以上(包含两个)的类别概率值,因为,在输入卷积神经网络模型的小图是没有经过缩放的,而中图经过缩小的,因此,在融合处理时,在同一重叠区域的多个类别概率值中,选择小图的类别概率值的最大者作为该特征的最终类别,这样能够提高检测的准确性。例如,小图x1检测出的是“人”,小图x2检测出的是“车”,小图x3检测出的是“路障”,中图y1检测出的是“车”,假设小图x1得到的概率值是最大的,那么确定最终的检测类别为“人”。

64.例如,前视图像的尺寸为3840

×

2160(与背景技术一致),采用本方法可以切出四张小图和两张中图,小图像素为60万左右(符合卷积神经网络模型的计算要求),执行目标检测任务时,一共进行了4 2 1次检测,在执行语义分割任务时,一共进行了4 2次检测,检测次数远远少于现有技术。采用本发明的检测方法,不仅可以提升图像中远处小目标的检出率和检测准确率,还能够减少检测次数,缩短检测时间,提升检测效果。

65.以上述依据本发明的理想实施例为启示,通过上述的说明内容,相关工作人员完全可以在不偏离本项发明技术思想的范围内,进行多样的变更以及修改。本项发明的技术性范围并不局限于说明书上的内容,必须要如权利要求范围来确定其技术性范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。