1.本发明涉及计算机视觉技术领域,尤其涉及一种多视觉特征融合的室内定位方法、装置、设备及存储介质。

背景技术:

2.基于视觉特征的slam定位算法通过使用相机传感器采集图像数据,相较于使用激光传感器,相机不仅体积小、重量轻、功耗低、价格低廉,图像数据的表示更贴近于人眼习惯,并且能够提供丰富的特征数据,目前视觉slam定位逐渐成为slam定位的主流方向。

3.现有的基于视觉特征的室内slam定位算法在室内环境下,大多是以人造场景居多,如窗台、地板等,这些低纹理区域,其定位成功率较低。

技术实现要素:

4.基于此,本发明提供一种多视觉特征融合的室内定位方法、装置、设备及存储介质。采用基于深度学习的点特征与线特征、面特征相融合,有效提高了室内定位的精度。

5.根据本技术的一些实施例的第一方面,提供了一种多视觉特征融合的室内定位方法,应用于携带有rgb-d相机的机器人,该方法包括以下步骤:

6.获取所述rgb-d相机采集的每帧图像,并进行预处理;

7.将预处理后的每帧图像输入至superpoint网络得到所述每帧图像的点特征及点描述子,对预处理后的每帧图像进行lsd算法处理得到所述每帧图像的线特征和线描述子,对预处理后的每帧图像进行cape算法处理得到所述每帧图像的面特征;

8.计算帧间图像的点描述子之间的距离,根据所述距离得到帧间图像的点特征匹配关系;计算帧间图像的线描述子之间的距离,根据所述距离得到帧间图像的线特征匹配关系;计算帧间图像的面特征之间的距离和夹角,得到帧间图像的面特征匹配关系,其中,帧间图像的面特征通过hassion参数化形式表达;

9.选取当前帧和参考帧的所述点特征匹配关系构建所述点特征的重投影误差函数,选取当前帧和参考帧的所述线特征匹配关系构建所述线特征的重投影误差函数,选取当前帧和参考帧的所述面特征匹配关系构建所述面特征的误差函数;

10.根据所述点特征的重投影误差函数、所述线特征的重投影误差函数和所述面特征的误差函数,构建联合误差函数,并对所述联合误差函数进行lm算法处理,求解得到所述当前帧与所述参考帧的所述目标图像之间的位姿变换情况。

11.据本技术的一些实施例的第二方面,提供了一种多视觉特征融合的室内定位的装置,包括:

12.数据处理模块,用于获取所述rgb-d相机采集的每帧图像,并进行预处理;

13.特征提取模块,用于将预处理后的每帧图像输入至superpoint网络得到每帧所述预处理图像的点特征及点描述子,对预处理后的每帧图像进行lsd算法处理得到所述预处理图像的线特征和线描述子,对预处理后的每帧图像进行cape算法处理得到所述预处理图

像的面特征;

14.特征匹配模块,用于计算帧间图像的点描述子之间的距离,根据所述距离得到所述不同帧的点特征匹配关系;计算帧间图像的线描述子之间的距离,根据所述距离得到所述不同帧的线特征匹配关系;计算帧间图像的面特征之间的距离和夹角,得到帧间图像的面特征匹配关系,其中,帧间图像的面特征通过hassion参数化形式表达;

15.数据关联模块,用于选取当前帧和参考帧的所述点特征匹配关系构建所述点特征的重投影误差函数,选取当前帧和参考帧的所述线特征匹配关系构建所述线特征的重投影误差函数,选取当前帧和参考帧的所述面特征匹配关系构建所述面特征的误差函数;

16.求解位姿模块,用于根据所述点特征的重投影误差函数、所述线特征的重投影误差函数和所述面特征的误差函数,构建联合误差函数,并对所述联合误差函数进行lm算法处理,求解得到所述当前帧与所述参考帧的所述目标图像之间的位姿变换情况。

17.根据本技术的一些实施例的第三方面,提供了一种设备,包括:

18.至少一个存储器和至少一个处理器;

19.所述存储器,用于存储一个或多个程序;

20.当所述一个或多个程序被所述至少一个处理器执行,使得所述至少一个处理器实现如第一方面任一项所述的多视觉特征融合的室内定位方法的步骤。

21.根据本技术的一些实施例的第四方面,提供了一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现如第一方面任一项所述方法的步骤。

22.本技术基于点线面多种特征融合,避免了在室内低纹理区域因单一特征提取数量不足导致定位失败的问题。采用基于深度学习提取到的点特征分别与线特征和面特征相融合,有效提高了室内定位的精度。且通过对图像的线特征提取所使用的lsd算法进行改进,将本属于一条线段的零散线段进行合并,剔除过短线段,提升了线特征的鲁棒性,提高了室内定位精度。最后,本技术使用tum公开室内低纹理数据集上进行对比测试,使用绝对轨迹误差(ate)作为评价标准。结果表明,基于单一点特征的算法在此环境跟踪丢失、定位失败,比之现有的基于点线面特征融合算法,定位精度有效提高了21%。

23.为了更清楚地说明本技术实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

附图说明

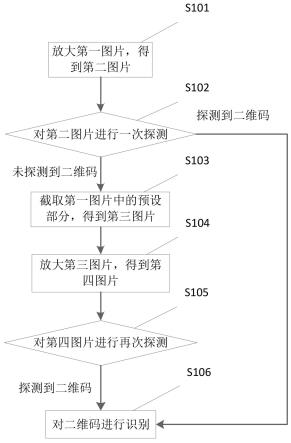

24.图1为本技术实施例中的一种多视觉特征融合的室内定位方法的流程图;

25.图2为本技术实施例中的一种多视觉特征融合的室内定位方法的步骤示意图;

26.图3为本技术实施例中的一种多视觉特征融合的室内定位装置的线特征的重投影示意图;

27.图4为本技术实施例中的一种多视觉特征融合的室内定位装置的结构示意图。

具体实施方式

28.为使本技术的目的、技术方案和优点更加清楚,下面将结合附图对本技术实施例方式作进一步地详细描述。

29.应当明确,所描述的实施例仅仅是本技术实施例一部分实施例,而不是全部的实施例。基于本技术实施例中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本技术实施例保护的范围。

30.在本技术实施例使用的术语是仅仅出于描述特定实施例的目的,而非旨在限制本技术实施例。在本技术实施例和所附权利要求书中所使用的单数形式的“一种”、“所述”和“该”也旨在包括多数形式,除非上下文清楚地表示其他含义。还应当理解,本文中使用的术语“和/或”是指并包含一个或多个相关联的列出项目的任何或所有可能组合。

31.下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本技术相一致的所有实施方式。相反,它们仅是如所附权利要求书中所详述的、本技术的一些方面相一致的装置和方法的例子。在本技术的描述中,需要理解的是,术语“第一”、“第二”、“第三”等仅用于区别类似的对象,而不必用于描述特定的顺序或先后次序,也不能理解为指示或暗示相对重要性。对于本领域的普通技术人员而言,可以根据具体情况理解上述术语在本技术中的具体含义。

32.此外,在本技术的描述中,除非另有说明,“多个”是指两个或两个以上。“和/或”,描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。

33.针对背景技术中涉及的基于单一点、线、面特征的定位算法会遇到特征不足所带来的定位失败问题。

34.请参阅图1和图2,本技术提供一种多视觉特征融合的室内定位方法,应用于携带有rgb-d相机的机器人,该方法包括以下步骤:

35.步骤s1:获取所述rgb-d相机采集的每帧图像,并进行预处理。

36.rgb-d相机又称深度相机,它最大的特点是可以通过红外结构光或time-of-flight(tof)原理,像激光传感器那样,通过主动向物体发射光并接收返回的光,测出物体离相机的距离。因此,它比传统相机能够提供更丰富的信息,也不必像单目或双目那样费时费力地计算深度。

37.在一个具体的实施例中,在步骤s1,获取所述rgb-d相机采集的每帧图像前,该方法还包括:

38.对所述rgb-d相机进行标定,获得所述rgb-d相机的内部参数,所述内部参数包括相机焦距和像平面原点的像素坐标。该标定指示对rgb-d相机的参数进行调整。

39.在一个具体的实施例中,获取所述rgb-d相机采集的每帧图像,并进行预处理,包括:

40.对每帧所述图像进行去噪处理,得到含有彩色图和深度图的rgb-d图像,并把彩色图转化为灰度图。

41.步骤s2:将预处理后的每帧图像输入至superpoint网络得到每帧图像的点特征及点描述子,对预处理后的每帧图像进行lsd算法处理得到每帧图像的线特征和线描述子,对预处理后的每帧图像进行cape算法处理得到每帧图像的面特征。

42.分别获取相机拍摄到的不同帧的预处理图像的点特征,线特征和面特征,全面获取该图像的各个特征,保证了后续处理中,数据的完整性。

43.点特征由关键点和描述子组成。关键点是指该特征点在图像中的位置,是有代表性的像素点,其像素值与其周围像素点的像素值有较大的区别。描述子是按照外观相似的特征应该有相似的描述子原则设计的,一般有很多维的0,1向量组成,理论上同一个特征点在不同图像上其描述子也是相同的。superpoint是一种先进的用于特征点检测以及计算描述符的自监督框架,由magicpoint和homographic两部分组成。前者是用于特征点检测的基于vgg神经网络,后者是用于生成特征点的描述子。superpoint对环境光照和视点变化的鲁棒性使其更加稳定。

44.cape是proenca和gao提出的一种快速的平面提取算法,将点云分割成平面的网络,通过主成分分析(pca)来计算每个网络的模型参数,再利用平面的法向量进行直方图的统计,从而通过每个网格的区域增长来完成平面的分割,与现有的平面提取方法相比,cape方法更快且平面分割结果更具有一致性。

45.lsd算法核心思路是将梯度方向相近的像素点合并。使用lsd提取线特征的主要缺点有:其在区域增长步骤中设置了每个像素点是否使用的标志,因此每个像素点只属于一条直线,当图像上两直线相交时,则至少有一条直线被分为两段。另外由于存在遮挡,原本的一条线段会被分割为多个。因此,为了避免上述情况,在一个优选的实施例中,对预处理的每帧图像进行lsd算法处理得到所述预处理图像的线特征和线描述子,包括:

46.步骤s21:利用lsd算法对不同帧所述预处理图像进行线段检测,并计算所述线段的梯度值和梯度方向,拟合得到多个所述线特征并形成线特征集。

47.步骤s22:获取所述每帧图像的线特征集中任意两个线段的第一夹角、两个所述线段的中点构成的直线与两个所述线段的第二夹角以及两个所述线段端点最小距离。

48.步骤s23:当所述第一夹角和第二夹角小于1

°

,所述最小距离小于三个像素时,确定两个所述线段合并为一条线段。

49.步骤s24:剔除所述每帧图像的线特征集中长度小于五个像素的线段,得到不同帧所述预处理图像的线特征和线描述子。

50.步骤s3:计算帧间图像的点描述子之间的距离,根据所述距离得到所述不同帧的点特征匹配关系;计算帧间图像的线描述子之间的距离,根据所述距离得到所述帧间图像的线特征匹配关系;帧间图像的面特征通过hassion参数化形式表达,计算帧间图像的面特征之间的距离和夹角,得到帧间图像的面特征匹配关系,其中,帧间图像的面特征通过hassion参数化形式表达。

51.预处理的帧间图像,具有各不相同的点特征、线特征和面特征。为了确认帧间图像的位置关系,可以通过不同帧之间的特征匹配关系来表达,点与点特征、线与线特征、面与面特征,相互之间匹配程度越高,表明其对应的预处理图像相互之间的位置关系越接近。

52.点特征之间和线特征之间的匹配通常是通过计算对应的描述子之间的距离来完成特征的匹配。描述子距离表示了两个特征之间的相似程度。描述子之间的距离越小,相似程度越近,其匹配关系越紧密。

53.面特征由于没有描述子,不能计算描述子距离来完成面特征的匹配。通常是通过hassion参数化形式表达,匹配关系和参数表达密切相关。

54.在一个具体的实施例中,步骤s3:计算帧间图像的点描述子之间的距离,根据所述距离得到所述不同帧的点特征匹配关系,包括;

55.利用knn算法计算帧间图像所述点描述子相互之间的距离,并利用ransac算法剔除误所述误差距离,得到帧间图像的所述点特征的匹配关系,其中,所述距离通过汉明距离描述。

56.计算帧间图像的线描述子之间的距离,根据所述距离得到所述不同帧的线特征匹配关系,包括:

57.利用knn算法计算不同帧所述线描述子相互之间的距离,并利用ransac算法剔除误所述误差距离,得到不同帧的所述线特征的匹配关系,其中,所述距离通过汉明距离描述。

58.计算帧间图像的面特征之间的距离和夹角,得到帧间图像的面特征匹配关系,其中,帧间图像的面特征通过hassion参数化形式表达,包括;

59.面特征记作π=(n

t

,d),n=(n

x

,ny,nz)

t

是图像中面特征所在平面的单位法向量,d(d》0)是相机原点到所述平面的距离;

60.获取两个所述预处理图像中的面特征所在平面的平面法向量夹角,以及所述相机原点到两个所述平面的第一距离和第二距离;

61.当所述平面法向量夹角小于10

°

,且所述第一距离与所述第二距离之差小于0.1米时,确定两帧之间的所述面特征建立了匹配关系。

62.步骤s4:选取当前帧和参考帧的所述点特征匹配关系构建所述点特征的重投影误差函数。选取当前帧和参考帧的所述线特征匹配关系构建所述线特征的重投影误差函数。选取当前帧和参考帧的所述面特征匹配关系构建所述面特征的误差函数。

63.在多数情况下,参考帧的选取为当前帧的前一帧。但如果当前帧和前一帧匹配不上,此时距离当前帧最近的关键帧作为参考帧进行匹配,该关键帧的选取标准参考orbslam2。

64.其中,构建所述点特征的重投影误差函数具体的包括:

65.步骤s411:获取所述参考帧的空间三维坐标点,公式如下:

66.sp

k-1

=kp,其中,p为所述参考帧的空间三维坐标点、k为所述相机的内部参数、s为所述预处理图像的深度信息、p

k-1

为所述参考帧的像素点坐标;

67.步骤s412:获取所述当前帧的空间三维坐标点,公式如下:

68.spk=k(rp t),其中,pk为与所述参考帧同一像素坐标的所述当前帧的像素点坐标、r为所述参考帧与所述当前帧之间的旋转位姿变换、t为所述参考帧与所述当前帧之间的平移位姿变换:

69.步骤s413:所述点特征的重投影误差函数构建为:

70.e

p

=p

k-π(rp t),其中,π(.)为与k,s相关的投影函数。

71.为了便于理解,请参阅图2,构建所述线特征的重投影误差函数。具体的包括以下步骤:

72.步骤s421:获取空间线段l,并使用两端点l1=(x1,y1,z1,r1)

t

和l2=(x2,y2,z2,r2)

t

表示此线段,记l

u1

,l

u2

为其非齐次坐标,采用普朗克坐标表示所述空间线段l为:

73.其中,v为所述空间线段l的方向向量、n是所述空间线段l与坐标原点构成平面的法向量,并且过坐标原点;

74.步骤s422:将所述参考帧中的线段根据所述相机的内部参数k和所述深度信息s投影到三维空间中,得到空间线段l及两端点ls、le,将l重投影到所述当前帧中,得到投影线段l及两端点ls、le,公式如下:

[0075][0076]

步骤s423:匹配l的投影线段l,得到当前帧的线段l

′

及两端点ls′

、le′

;

[0077]

步骤s424:使用ls′

,le′

到投影线段l的距离表示空间线段l的重投影误差为:

[0078]

其中,d(l

′

,l)代表直线l

′

与l间的距离

[0079]

构建所述面特征的误差函数,包括:

[0080]

步骤s431:将所述当前帧和参考帧的面特征的表示方法最小参数化,表示为:

[0081]

其中,φ和ψ是法线的方位角和仰角,n

x

、ny、nz分别为x、y、z轴的单位法向量;

[0082]

步骤s432:所述参考帧的平面特征与所述当前帧的平面特征之间的误差函数表示为:

[0083]

其中,为所述参考帧到所述当前帧的位姿变换。

[0084]

步骤s5:根据所述点特征的重投影误差函数、所述线特征的重投影误差函数和所述面特征的误差函数,构建联合误差函数,并对所述联合误差函数进行lm算法处理,求解得到所述当前帧与所述参考帧的所述目标图像之间的位姿变换情况。

[0085]

具体的,联合误差函数为:

[0086][0087]

其中,p、l、π分别表示点、线、面特征的集合,∑p-1

、∑l-1

、∑π-1

分别表示点、线、面特征的协方差矩阵,ρ

p

、ρ

l

、ρ

π

分别表示点、线、面特征使用鲁棒的huber核函数设定的代价值。

[0088]

上述问题是一个最小二乘问题,使用lm(levenberg-marquart)算法最小化联合误差函数et,求解后即可得到两帧之间的位姿变换情况。

[0089]

根据位姿变换情况,依次迭代不同帧的位置,从而实现定位。具体的,携带相机的机器人初始位置是已知的,即第一帧图像的位置是已知的。第二帧图像作为当前帧,第一帧

作为参考帧,根据算法得到第一帧到第二帧之间的位姿变换,即可得到第二帧的位置。因此,得到当前帧和参考帧之间的位姿变换情况,则当前帧的位置都能够确定,如此迭代下去,每一帧的位置都能够确定,即实现了定位。

[0090]

与上述的一种多视觉特征融合的室内定位方法相对应,如图4所示,本技术还提供一种多视觉特征融合的室内定位装置400,包括:

[0091]

数据处理模块410,用于获取所述rgb-d相机采集的每帧图像,并进行预处理。

[0092]

特征提取模块420,用于将预处理后的每帧图像输入至superpoint网络得到所述每帧图像的点特征及点描述子,对预处理后的每帧图像进行lsd算法处理得到所述每帧图像的线特征和线描述子,对预处理后的每帧图像进行cape算法处理得到所述每帧图像的面特征。

[0093]

特征匹配模块430,用于计算帧间图像的点描述子之间的距离,根据所述距离得到帧间图像的点特征匹配关系;计算帧间图像的线描述子之间的距离,根据所述距离得到帧间图像的线特征匹配关系;计算帧间图像的面特征之间的距离和夹角,得到帧间图像的面特征匹配关系,其中,帧间图像的面特征通过hassion参数化形式表达。

[0094]

数据关联模块440,用于选取当前帧和参考帧的所述点特征匹配关系构建所述点特征的重投影误差函数,选取当前帧和参考帧的所述线特征匹配关系构建所述线特征的重投影误差函数,选取当前帧和参考帧的所述面特征匹配关系构建所述面特征的误差函数。

[0095]

求解位姿模块450,用于根据所述点特征的重投影误差函数、所述线特征的重投影误差函数和所述面特征的误差函数,构建联合误差函数,并对所述联合误差函数进行lm算法处理,求解得到所述当前帧与所述参考帧的所述目标图像之间的位姿变换情况。

[0096]

在一个可选的例子中,特征提取模块420包括:

[0097]

线端检测单元,用于利用lsd算法对每帧图像进行线段检测,并计算所述线段的梯度值和梯度方向,拟合得到多个所述线特征并形成线特征集。

[0098]

线段选取单元,用于获取所述线特征集中任意两个线段的第一夹角、两个所述线段的中点构成的直线与两个所述线段的第二夹角以及两个所述线段端点最小距离。

[0099]

线段合并单元,用于当所述第一夹角和第二夹角小于1

°

,所述最小距离小于三个像素时,确定两个所述线段合并为一条线段。

[0100]

线特征提取单元,用于剔除所述线特征集中长度小于五个像素的线段,得到不同帧所述预处理图像的线特征和线描述子。

[0101]

在一个可选的例子中,特征匹配模块430包括:

[0102]

点特征匹配单元,用于利用knn算法计算帧间图像点描述子相互之间的距离,并利用ransac算法剔除误所述误差距离,得到帧间图像的所述点特征的匹配关系,其中,所述距离通过汉明距离描述;

[0103]

线特征匹配单元,用于利用knn算法计算帧间图像所述线描述子相互之间的距离,并利用ransac算法剔除误所述误差距离,得到帧间图像的所述线特征的匹配关系,其中,所述距离通过汉明距离描述;

[0104]

面特征匹配单元,用于所述面特征记作π=(n

t

,d),n=(n

x

,ny,nz)

t

是帧间图像的面特征所在平面的单位法向量,d(d》0)是相机原点到所述平面的距离;获取两个所述预处理图像中的面特征所在平面的平面法向量夹角,以及所述相机原点到两个所述平面的第一距

离和第二距离;当所述平面法向量夹角小于10

°

,且所述第一距离与所述第二距离之差小于0.1米时,确定两帧之间的所述面特征建立了匹配关系。

[0105]

在一个可选的例子中,数据关联模块440包括:

[0106]

点特征关联单元,用于获取所述参考帧的空间三维坐标点,公式如下:

[0107]

sp

k-1

=kp,其中,p为所述参考帧的空间三维坐标点、k为所述相机的内部参数、s为所述预处理图像的深度信息、pk-1为所述参考帧的像素点坐标。

[0108]

获取所述当前帧的空间三维坐标点,公式如下:

[0109]

spk=k(rp t),其中,pk为与所述参考帧同一像素坐标的所述当前帧的像素点坐标、r为所述参考帧与所述当前帧之间的旋转位姿变换、t为所述参考帧与所述当前帧之间的平移位姿变换。

[0110]

所述点特征的重投影误差函数构建为:

[0111]ep

=p

k-π(rp t),其中,π(.)为与k,s相关的投影函数。

[0112]

线特征关联单元,用于获取空间线段l,并使用两端点l1=(x1,y1,z1,r1)

t

和l2=(x2,y2,z2,r2)

t

表示此线段,记lu1,lu2为其非齐次坐标,采用普朗克坐标表示所述空间线段l为:

[0113]

其中,v为所述空间线段l的方向向量、n是所述空间线段l与坐标原点构成平面的法向量,并且过坐标原点;

[0114]

将所述参考帧中的线段根据所述相机的内部参数k和所述深度信息s投影到三维空间中,得到空间线段l及两端点ls、le,将l重投影到所述当前帧中,得到投影线段l及两端点ls、le,公式如下:

[0115][0116]

匹配l的投影线段l,得到当前帧的线段l

′

及两端点ls′

、le′

;

[0117]

使用ls′

,le′

到投影线段l的距离表示空间线段l的重投影误差为:

[0118]

其中,d(l

′

,l)代表直线l

′

与l间的距离;

[0119]

面特征关联单元,用于将所述当前帧和参考帧的面特征的表示方法最小参数化,表示为:

[0120]

其中,φ和ψ是法线的方位角和仰角,n

x

、ny、nz分别为x、y、z轴的单位法向量;

[0121]

所述参考帧的平面与所述当前帧的平面之间的误差函数表示为:

[0122]

其中,为所述参考帧到所述当前帧的位姿变换。

[0123]

在一个可选的例子中,求解位姿模块450包括:

[0124]

求解位姿单元,用于联合误差函数为:

[0125][0126]

其中,p、l、π分别表示点、线、面特征的集合,∑p-1

、∑l-1

、∑π-1

分别表示点、线、面特征的协方差矩阵,ρ

p

、ρ

l

、ρ

π

分别表示点、线、面特征使用鲁棒的huber核函数设定的代价值。

[0127]

在一个可选的例子中,该装置400还包括:

[0128]

标定模块,用于对所述rgb-d相机进行标定,获得所述rgb-d相机的内部参数,包括相机焦距和像平面原点的像素坐标。

[0129]

在一个可选的例子中,该装置400还包括:

[0130]

预处理模块,用于对每帧图像进行去噪处理,得到含有彩色图和深度图的rgb-d图像,并把彩色图转化为灰度图。

[0131]

与上述的一种多视觉特征融合的室内定位方法相对应,本技术还提供一种设备,包括至少一个存储器和至少一个处理器;

[0132]

所述存储器,用于存储一个或多个程序;

[0133]

当所述一个或多个程序被所述至少一个处理器执行,使得所述至少一个处理器实现上述任一项所述的多视觉特征融合的室内定位方法的步骤。

[0134]

上述设备中各个组件的功能和作用的实现过程具体详见上述方法中对应步骤的实现过程,在此不再赘述。对于设备实施例而言,由于其基本对应于方法实施例,所以相关之处参见方法实施例的部分说明即可。以上所描述的设备实施例仅仅是示意性的,其中所述作为分离部件说明的组件可以是或者也可以不是物理上分开的,作为单元显示的部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本公开方案的目的。本领域普通技术人员在不付出创造性劳动的情况下,即可以理解并实施。

[0135]

与上述的多视觉特征融合的室内定位方法相对应,本技术还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现如上述任一项所述方法的步骤。

[0136]

本公开可采用在一个或多个其中包含有程序代码的存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。计算机可用存储介质包括永久性和非永久性、可移动和非可移动媒体,可以由任何方法或技术来实现信息存储。信息可以是计算机可读指令、数据结构、程序的模块或其他数据。计算机的存储介质的例子包括但不限于:相变内存(pram)、静态随机存取存储器(sram)、动态随机存取存储器(dram)、其他类型的随机存取存储器(ram)、只读存储器(rom)、电可擦除可编程只读存储器(eeprom)、快闪记忆体或其他内存技术、只读光盘只读存储器(cd-rom)、数字多功能光盘(dvd)或其他光学存储、磁盒式磁带,磁带磁磁盘存储或其他磁性存储设备或任何其他非传输介质,可用于存储可以被计算设备访问的信息。

[0137]

本技术基于点线面多种特征融合,避免了在室内低纹理区域因单一特征提取数量不足导致定位失败的问题。采用基于深度学习提取到的点特征分别与线特征和面特征相融

合,有效提高了室内定位的精度。且通过对图像的线特征提取所使用的lsd算法进行改进,将本属于一条线段的零散线段进行合并,剔除过短线段,提升了线特征的鲁棒性,提高了室内定位精度。最后,本技术使用tum公开室内低纹理数据集上进行对比测试,使用绝对轨迹误差(ate)作为评价标准。结果表明,基于单一点特征的算法在此环境跟踪丢失、定位失败,比之现有的基于点线面特征融合算法,定位精度有效提高了21%。

[0138]

应当理解的是,本技术实施例并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本技术实施例的范围仅由所附的权利要求来限制。以上所述实施例仅表达了本技术实施例的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术实施例构思的前提下,还可以做出若干变形和改进,这些都属于本技术实施例的保护范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。