基于紧框标的眼底图像的测量方法、装置及网络训练

1.本技术是申请日为2021年10月19日、申请号为202111216625.8、发明名称为基于紧框标的深度学习的眼底图像的测量方法及测量装置的专利申请的分案申请。

技术领域

2.本公开大体涉及基于深度学习的识别技术领域,具体涉及一种基于紧框标的眼底图像的测量方法、装置及网络训练。

背景技术:

3.眼底图像中常常包括各种目标的信息,基于图像处理技术识别眼底图像中目标的信息可以自动对眼底的目标进行分析。例如可以对眼底图像中的视杯和/或视盘进行识别,进而能够测量视杯和/或视盘的尺寸以监测视杯和/或视盘的变化。

4.近年,以深度学习为代表的人工智能技术得到了显著地发展,其在目标识别或测量等方面的应用也越来越得到关注。研究者们利用深度学习技术对图像中的目标进行识别或进行进一步地测量。具体而言,在一些基于深度学习的研究中,常常利用标注数据对基于深度学习的神经网络进行训练以对眼底图像中的视杯和/或视盘进行识别并分割出该视杯和/或视盘,进而能够对该视杯和/或视盘进行测量。

5.然而,上述的目标识别或测量的方法常常需要精确的像素级别的标注数据用于神经网络的训练,而采集像素级别的标注数据常常需要耗费大量的人力和物力。另外,一些目标识别的方法虽然不是基于像素级别的标注数据,但仅仅是识别眼底图像中的视杯和/或视盘,对视杯和/或视盘的边界识别还不够精确或在靠近眼底图像中的视杯和/或视盘的边界位置往往精度较低,不适用于要求精确测量的场景。在这种情况下,对眼底图像中的视杯和/或视盘进行测量的精确性还有待于提高。

技术实现要素:

6.本公开是有鉴于上述的状况而提出的,其目的在于提供一种能够识别视杯和/或视盘且能够精确地对视杯和/或视盘进行测量的基于紧框标的深度学习的眼底图像的测量方法及测量装置。

7.为此,本公开第一方面提供了一种基于紧框标的深度学习的眼底图像的测量方法,是利用基于目标的紧框标进行训练的网络模块对眼底图像中的至少一个目标进行识别从而实现测量的测量方法,所述至少一个目标为视杯和/或视盘,所述紧框标为所述目标的最小外接矩形,所述测量方法包括:获取眼底图像;将所述眼底图像输入所述网络模块以获取第一输出和第二输出,所述第一输出包括所述眼底图像中的各个像素点属于视杯和/或视盘的类别的概率,所述第二输出包括所述眼底图像中各个像素点的位置与每个类别的目标的紧框标的偏移,将所述第二输出中的偏移作为目标偏移,其中,所述网络模块包括骨干网络、基于弱监督学习的图像分割的分割网络、以及基于边框回归的回归网络,所述骨干网络用于提取所述眼底图像的特征图,所述分割网络将所述特征图作为输入以获得所述第一

输出,所述回归网络将所述特征图作为输入以获得所述第二输出,其中,所述特征图与所述眼底图像的分辨率一致;基于所述第一输出和所述第二输出对所述目标进行识别以获取所述眼底图像中的视杯和/或视盘的紧框标从而实现测量。

8.在本公开中,构建包括骨干网络、基于弱监督学习的图像分割的分割网络和基于边框回归的回归网络的网络模块,网络模块是基于目标的紧框标进行训练的,骨干网络接收眼底图像并提取与眼底图像分辨率一致的特征图,将特征图分别输入分割网络和回归网络以获取第一输出和第二输出,然后基于第一输出和第二输出获取眼底图像中视杯和/或视盘的紧框标从而实现测量。在这种情况下,基于视杯和/或视盘的紧框标训练的网络模块能够精确地预测眼底图像中视杯和/或视盘的紧框标,进而能够基于视杯和/或视盘的紧框标进行精确地测量。

9.另外,在本公开第一方面所涉及的测量方法中,可选地,基于所述眼底图像中的视杯的紧框标和/或所述眼底图像中的视盘的紧框标对视杯和/或视盘进行测量以获取视杯和/或视盘的尺寸。由此,能够对视杯和/或视盘的尺寸进行精确地测量。

10.另外,在本公开第一方面所涉及的测量方法中,可选地,基于所述眼底图像中的视杯和视盘的尺寸获取视杯和视盘的比值。在这种情况下,基于紧框标获取视杯和视盘的比值,进而能够对杯盘比进行精确地测量。

11.另外,在本公开第一方面所涉及的测量方法中,可选地,所述网络模块通过如下方法训练:构建训练样本,所述训练样本的眼底图像数据包括多张待训练图像,所述多张待训练图像包括包含视杯和视盘中的至少一种目标的图像,所述训练样本的标签数据包括所述目标所属的类别的金标准和所述目标的紧框标的金标准,其中,所述待训练图像为待训练的眼底图像;通过所述网络模块基于所述训练样本的眼底图像数据,获得所述训练样本对应的由所述分割网络输出的预测分割数据和由所述回归网络输出的预测偏移;基于所述训练样本对应的标签数据、所述预测分割数据和所述预测偏移确定所述网络模块的训练损失;并且基于所述训练损失对所述网络模块进行训练以优化所述网络模块。由此,能够获得已优化的网络模块。

12.另外,在本公开第一方面所涉及的测量方法中,可选地,所述基于所述训练样本对应的标签数据、所述预测分割数据和所述预测偏移确定所述网络模块的训练损失,包括:基于所述训练样本对应的预测分割数据和标签数据,获取所述分割网络的分割损失;基于所述训练样本对应的预测偏移和基于标签数据对应的真实偏移,获取所述回归网络的回归损失,其中,所述真实偏移为所述待训练图像的像素点的位置与标签数据中的目标的紧框标的金标准的偏移;并且基于所述分割损失和所述回归损失,获取所述网络模块的训练损失。在这种情况下,能够通过分割损失使分割网络的预测分割数据近似标签数据,且能够通过回归损失使回归网络的预测偏移近似真实偏移。

13.另外,在本公开第一方面所涉及的测量方法中,可选地,所述目标偏移为基于各个类别的目标的平均大小进行归一化后的偏移。由此,能够提高对尺寸变化不大的目标进行识别或测量的精确性。

14.另外,在本公开第一方面所涉及的测量方法中,可选地,按类别对所述标签数据中目标的紧框标的宽度和高度分别求平均以获取平均宽度和平均高度,然后对所述平均宽度和所述平均高度求平均以获得各个类别的目标的平均大小。由此,能够通过训练样本获取

目标的平均大小。

15.另外,在本公开第一方面所涉及的测量方法中,可选地,利用多示例学习,按类别基于各个待训练图像中的目标的紧框标的金标准获取多个待训练包,基于各个类别的多个待训练包获取所述分割损失,其中,所述多个待训练包包括多个正包和多个负包,将连接所述目标的紧框标的金标准相对的两个边的多条直线中的各条直线上的全部像素点划分为一个正包,所述多条直线包括至少一组相互平行的第一平行线和分别与每组第一平行线垂直的相互平行的第二平行线,所述负包为一个类别的所有目标的紧框标的金标准之外的区域的单个像素点。由此,能够基于多示例学习的正包和负包获取分割损失。

16.另外,在本公开第一方面所涉及的测量方法中,可选地,所述第一平行线的角度为所述第一平行线的延长线与所述目标的紧框标的金标准的任意一个未相交的边的延长线的夹角的角度,所述第一平行线的角度大于-90

°

且小于90

°

。在这种情况下,能够划分不同角度的正包对分割网络进行优化。由此,能够提高分割网络的预测分割数据的准确性。

17.另外,在本公开第一方面所涉及的测量方法中,可选地,所述分割损失包括一元项和成对项,所述一元项描述每个待训练包属于各个类别的金标准的程度,所述成对项描述所述待训练图像的像素点与该像素点相邻的像素点属于同类别的程度。在这种情况下,能够通过一元损失使紧框标同时通过正包和负包进行约束,且能够通过成对损失使预测分割结果平滑。

18.另外,在本公开第一方面所涉及的测量方法中,可选地,从所述待训练图像中选择至少落入一个目标的紧框标的金标准内的像素点作为正样本对所述回归网络进行优化。在这种情况下,基于落入至少一个目标的真实紧框标内的像素点对回归网络进行优化,能够提高回归网络优化的效率。

19.另外,在本公开第一方面所涉及的测量方法中,可选地,按类别从所述待训练图像中选择至少落入一个目标的紧框标的金标准内的像素点作为各个类别的正样本并获取该正样本对应的匹配紧框标以基于所述匹配紧框标对各个类别的正样本进行筛选,然后利用筛选后的各个类别的正样本对所述回归网络进行优化,其中,所述匹配紧框标为所述正样本落入的紧框标的金标准。由此,能够利用基于匹配紧框标筛选后的各个类别的正样本对回归网络进行优化。

20.另外,在本公开第一方面所涉及的测量方法中,可选地,令像素点的位置表示为(x,y),该像素点对应的一个目标的紧框标表示为 b=(xl,yt,xr,yb),所述目标的紧框标b相对该像素点的位置的偏移表示为t=(tl,tt,tr,tb),则tl,tt,tr,tb满足公式:tl=(x-xl)/sc, tt=(y-yt)/sc,tr=(xr-x)/sc,tb=(yb-y)/sc,其中,xl,yt表示目标的紧框标的左上角的位置,xr,yb表示目标的紧框标的右下角的位置,sc表示第c个类别的目标的平均大小。由此,能够获得归一化后的偏移。

21.另外,在本公开第一方面所涉及的测量方法中,可选地,按类别并利用所述待训练图像的像素点对应的期望交并比从所述待训练图像的像素点筛选出所述期望交并比大于预设期望交并比的像素点对所述回归网络进行优化。由此,能够获得符合预设期望交并比的正样本。

22.另外,在本公开第一方面所涉及的测量方法中,可选地,以所述待训练图像的像素点为中心点构建的不同尺寸的多个边框,获取所述多个边框分别与该像素点的匹配紧框标

的交并比中的最大值并作为所述期望交并比,其中,所述匹配紧框标为所述待训练图像的像素点落入的紧框标的金标准。由此,能够获得期望交并比。

23.另外,在本公开第一方面所涉及的测量方法中,可选地,所述期望交并比满足公式:其中,r1,r2为所述待训练图像的像素点在所述匹配紧框标的相对位置, 0《r1,r2《1,iou1(r1,r2)=4r1r2,iou2(r1,r2)=2r1/(2r1(1-2r2) 1), iou3(r1,r2)=2r2/(2r2(1-2r1) 1),iou4(r1,r2)=1/(4(1-r1)(1-r2))。由此,能够获得期望交并比。

24.另外,在本公开第一方面所涉及的测量方法中,可选地,所述回归损失满足公式:其中,c表示所述类别的数量,mc表示第c个类别的正样本的数量,t

ic

表示第c个类别的第i个正样本对应的真实偏移,v

ic

表示第c个类别的第i个正样本对应的预测偏移,s(x)表示x中所有元素的smooth l1损失之和。由此,能够获取回归损失。

25.另外,在本公开第一方面所涉及的测量方法中,可选地,所述基于所述第一输出和所述第二输出对所述目标进行识别以获取所述眼底图像中的视杯和/或视盘的紧框标从而实现测量为:从所述第一输出中获取属于各个类别的概率最大的像素点的位置作为第一位置,基于所述第二输出中与所述第一位置对应的位置且对应类别的目标偏移获取各个类别的目标的紧框标。由此,能够识别出视杯和/或视盘。

26.另外,在本公开第一方面所涉及的测量方法中,可选地,所述骨干网络包括编码模块和解码模块,所述编码模块配置为在不同尺度上提取的图像特征,所述解码模块配置为将在不同尺度上提取的图像特征映射回所述眼底图像的分辨率以输出所述特征图。由此,能够获取与眼底图像分辨率一致的特征图。

27.本公开第二方面提供了一种基于紧框标的深度学习的眼底图像的测量装置,是利用基于目标的紧框标进行训练的网络模块对眼底图像中的至少一个目标进行识别从而实现测量的测量装置,所述至少一个目标为视杯和/或视盘,所述紧框标为所述目标的最小外接矩形,所述测量装置包括获取模块、网络模块和识别模块:所述获取模块配置为获取眼底图像;所述网络模块配置为接收所述眼底图像并基于所述眼底图像获取第一输出和第二输出,所述第一输出包括所述眼底图像中的各个像素点属于视杯和/或视盘的类别的概率,所述第二输出包括所述眼底图像中各个像素点的位置与每个类别的目标的紧框标的偏移,将所述第二输出中的偏移作为目标偏移,其中,所述网络模块包括骨干网络、基于弱监督学习的图像分割的分割网络、以及基于边框回归的回归网络,所述骨干网络用于提取所述眼底图像的特征图,所述分割网络将所述特征图作为输入以获得所述第一输出,所述回归网络将所述特征图作为输入以获得所述第二输出,其中,所述特征图与所述眼底图像的分辨率一致;以及所述识别模块配置为基于所述第一输出和所述第二输出对所述目标进行识别以获取所述眼底图像中的视杯和/ 或视盘的紧框标从而实现测量。

28.在本公开中,构建包括骨干网络、基于弱监督学习的图像分割的分割网络和基于边框回归的回归网络的网络模块,网络模块是基于目标的紧框标进行训练的,骨干网络接收眼底图像并提取与眼底图像分辨率一致的特征图,将特征图分别输入分割网络和回归网络以获取第一输出和第二输出,然后基于第一输出和第二输出获取眼底图像中视杯和/或

视盘的紧框标从而实现测量。在这种情况下,基于视杯和/或视盘的紧框标训练的网络模块能够精确地预测眼底图像中视杯和/或视盘的紧框标,进而能够基于视杯和/或视盘的紧框标进行精确地测量。

29.根据本公开,提供一种能够识别视杯和/或视盘且能够精确地对视杯和/或视盘进行测量的基于紧框标的深度学习的眼底图像的测量方法及测量装置。

附图说明

30.现在将仅通过参考附图的例子进一步详细地解释本公开,其中:

31.图1是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的应用场景的示意图。

32.图2(a)是示出了本公开示例所涉及的眼底图像的示意图。

33.图2(b)是示出了本公开示例所涉及的眼底图像的识别结果的示意图。

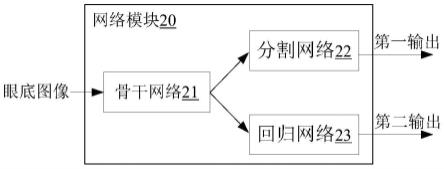

34.图3是示出了本公开示例所涉及的网络模块的一个示例的示意图。

35.图4是示出了本公开示例所涉及的网络模块的另一个示例的示意图。

36.图5是示出了本公开示例所涉及的网络模块的训练方法的流程图。

37.图6是示出了本公开示例所涉及的正包的示意图。

38.图7是示出了本公开示例所涉及的以像素点为中心构建的边框的示意图。

39.图8(a)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的流程图。

40.图8(b)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的另一种示例的流程图。

41.图9(a)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置的框图。

42.图9(b)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置的另一个示例的框图。

43.图9(c)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置的另一个示例的框图。

具体实施方式

44.以下,参考附图,详细地说明本公开的优选实施方式。在下面的说明中,对于相同的部件赋予相同的符号,省略重复的说明。另外,附图只是示意性的图,部件相互之间的尺寸的比例或者部件的形状等可以与实际的不同。需要说明的是,本公开中的术语“包括”和“具有”以及它们的任何变形,例如所包括或所具有的一系列步骤或单元的过程、方法、系统、产品或设备不必限于清楚地列出的那些步骤或单元,而是可以包括或具有没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它步骤或单元。本公开所描述的所有方法可以以任何合适的顺序执行,除非在此另有指示或者与上下文明显矛盾。

45.本公开涉及的基于紧框标的深度学习的眼底图像的测量方法及测量装置,其能够识别目标且能够提高目标测量的精确性。例如,能够识别眼底图像中的视盘或视盘的紧框标,进而能够基于紧框标对视盘或视盘的尺寸进行测量。本公开涉及的基于紧框标的深度

学习的眼底图像的测量方法还可以称为识别方法、紧框标测量方法、紧框标识别方法、自动测量方法、辅助测量方法等。本公开涉及的测量方法可以适用于任何对图像中的目标的宽度和/或高度进行精确测量的应用场景。

46.本公开涉及的测量方法是利用基于目标的紧框标进行训练的网络模块对目标进行识别从而实现测量的测量方法。紧框标可以为目标的最小外接矩形。在这种情况下,目标与紧框标的四个边相接触且不与紧框标之外的区域互相重叠(也即目标与紧框标的四个边相切)。由此,紧框标能够表示目标的宽度和高度。另外,基于目标的紧框标对网络模块进行训练,能够降低收集像素级的标注数据(也可以称为标签数据)的时间和人力成本且网络模块能够精确地识别目标的紧框标。

47.图1是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的应用场景的示意图。图2(a)是示出了本公开示例所涉及的眼底图像的示意图。图2(b)是示出了本公开示例所涉及的眼底图像的识别结果的示意图。

48.在一些示例中,本公开涉及的测量方法可以应用于如图1所示的应用场景中。在应用场景中,可以通过采集设备52(例如相机)采集眼底51的眼底图像(参见图1),将眼底图像输入网络模块20以识别眼底图像中的视杯和/或视盘并获取视杯和/或视盘的紧框标b(参见图1),进而可以基于紧框标b对视杯和/或视盘进行测量。例如,将图2(a)所示的眼底图像输入网络模块20可以获得图2(b)所示的识别结果,识别结果可以中包括视杯和视盘这两种类别的目标的紧框标,其中,紧框标b11为视盘的紧框标,紧框标b12为视杯的紧框标。在这种情况下,能够基于紧框标对视杯和视盘进行测量。

49.本公开涉及的网络模块20可以是基于多任务的。在一些示例中,网络模块20可以是基于深度学习的神经网络。在一些示例中,网络模块20可以包括两个任务,一个任务可以是基于弱监督学习的图像分割的分割网络22(稍后描述),另一个任务可以是基于边框回归的回归网络23(稍后描述)。

50.在一些示例中,分割网络22可以对眼底图像进行分割以获得目标(例如视杯和/或视盘)。在一些示例中,分割网络22可以基于多示例学习(multiple-instancelearning,mil)并用于监督紧框标。在一些示例中,分割网络22解决的问题可以是多标签分类(multi-labelclassification)问题。在一些示例中,眼底图像可以包含至少一种感兴趣的类别(可以简称为类别)的目标。例如,眼底图像中目标可以为视杯和/或视盘,也即可以对眼底图像中类别为视杯和/或视盘的目标进行识别。由此,分割网络22能够对包含至少一种感兴趣的类别的目标的眼底图像进行识别。在一些示例中,眼底图像也可以不存在任何目标。

51.在一些示例中,回归网络23可以用于按类别预测紧框标。在一些示例中,回归网络23可以通过预测紧框标相对眼底图像的各个像素点的位置的偏移,进而预测紧框标。

52.在一些示例中,网络模块20还可以包括骨干网络21。骨干网络21可以用于提取眼底图像(也即输入网络模块20的原始图像)的特征图。在一些示例中,骨干网络21可以提取高层次的特征用于对象表示。在一些示例中,特征图的分辨率可以与眼底图像一致(也即,特征图可以是单尺度且与眼底图像的大小一致)。由此,能够提高对尺寸变化不大的目标进行识别或测量的精确性。在一些示例中,可以通过不断地融合不同尺度的图像特征以获得与眼底图像的尺度一致的特征图。在一些示例中,特征图可以作为分割网络22和回归网络23的输入。

53.在一些示例中,骨干网络21可以包括编码模块和解码模块。在一些示例中,编码模块可以配置为在不同尺度上提取的图像特征。在一些示例中,解码模块可以配置为将在不同尺度上提取的图像特征映射回眼底图像的分辨率以输出特征图。由此,能够获取与眼底图像分辨率一致的特征图。

54.图3是示出了本公开示例所涉及的网络模块20的一个示例的示意图。

55.在一些示例中,如图3所示,网络模块20可以包括骨干网络21、分割网络22和回归网络23。骨干网络21可以接收眼底图像并输出特征图。特征图可以作为分割网络22和回归网络23的输入以获取相应的输出。具体地,分割网络22可以将特征图作为输入以获得第一输出,回归网络23可以将特征图作为输入以获得第二输出。在这种情况下,能够将眼底图像输入网络模块20以获取第一输出和第二输出。

56.在一些示例中,第一输出可以是图像分割预测的结果。在一些示例中,第二输出可以是边框回归预测的结果。

57.在一些示例中,第一输出可以包括眼底图像中的各个像素点属于各个类别的概率。在一些示例中,各个像素点属于各个类别的概率可以通过激活函数获得。在一些示例中,第一输出可以是矩阵。在一些示例中,第一输出对应的矩阵的大小可以为m

×n×

c,其中,m

×

n 可以表示眼底图像的分辨率,m和n可以分别对应眼底图像的行和列,c可以表示类别的数量。例如,对于目标为视杯和视盘这两种类别的眼底图像,第一输出对应的矩阵的大小可以为m

×n×

2。

58.在一些示例中,眼底图像中的每个位置的像素点在第一输出中对应的值可以为向量,向量中的元素数量可以与类别数量一致。例如,对于眼底图像中的第k个位置的像素点,在第一输出中对应的值可以为向量pk,向量pk可以包括c个元素,c可以为类别的数量。在一些示例中,向量pk的元素值可以为0至1的数值。

59.在一些示例中,第二输出可以包括眼底图像中各个像素点的位置与每个类别的目标的紧框标的偏移。也即,第二输出可以包括明确类别的目标的紧框标的偏移。换而言之,回归网络23预测的可以是明确类别的目标的紧框标的偏移。在这种情况下,在不同类别的目标重叠度较高时能够区别相应类别的目标的紧框标,进而能够获取相应类别的目标的紧框标。由此,能够兼容不同类别的目标重叠较高的目标的识别或测量。在一些示例中,可以将第二输出中的偏移作为目标偏移。

60.在一些示例中,目标偏移可以是归一化后的偏移。在一些示例中,目标偏移可以是基于各个类别的目标的平均大小进行归一化后的偏移。目标偏移和预测偏移(稍后描述)可以与真实偏移(稍后描述)对应。也即,若对训练网络模块20时(可以简称为训练阶段)的真实偏移进行归一化,则利用网络模块20进行预测(可以简称为测量阶段)的目标偏移(对应测量阶段)和预测偏移(对应训练阶段)也可以自动进行相应的归一化。由此,能够提高对尺寸变化不大的目标进行识别或测量的精确性。

61.在一些示例中,目标的平均大小可以通过对目标的平均宽度和平均高度求平均获得。在一些示例中,目标的平均大小可以是经验值(也即平均宽度和平均宽度可以是经验值)。在一些示例中,目标的平均大小可以通过对采集眼底图像对应的样本进行统计获得。具体地,可以按类别对样本的标签数据中目标的紧框标的宽度和高度分别求平均以获取平均宽度和平均高度,然后对平均宽度和平均高度求平均以获得该类别的目标的平均大小。

在一些示例中,样本可以为训练样本(稍后描述),也即,目标的平均大小可以通过对训练样本进行统计获得。由此,能够通过训练样本获取目标的平均宽度和平均宽度、或目标的平均大小。

62.在一些示例中,第二输出可以是矩阵。在一些示例中,第二输出对应的矩阵的大小可以为m

×n×

a,其中,a可以表示全部目标偏移的大小,m

×

n可以表示眼底图像的分辨率,m和n可以分别对应眼底图像的行和列。在一些示例中,若一个目标偏移的大小是4

×

1的向量(也即可以用4个数进行表示),则a可以为c

×

4,c可以表示类别的数量。例如,对于目标为视杯和视盘这两种类别的眼底图像,第二输出对应的矩阵的大小可以为m

×n×

8。

63.在一些示例中,眼底图像中的每个位置的像素点在第二输出中对应的值可以为向量。例如,眼底图像中的第k个位置的像素点,在第二输出中对应的值可以表示为:vk=[v

k1

,v

k2

,

…

,v

kc

]。其中,c可以为类别的数量,vk中的各个元素可以表示为每个类别的目标的目标位移。由此,能够方便地表示目标位移以及对应的类别。在一些示例中,vk的元素可以为4维的向量。

[0064]

在一些示例中,骨干网络21可以是基于u-net网络。在本实施方式中,骨干网络21的编码模块可以包括单元层和池化层(poolinglayers)。骨干网络21的解码模块可以包括单元层、上采样层 (up-samplinglayers,up-sampling)和跳跃连接单元(skipconnectionunits, skip-connection)。

[0065]

在一些示例中,单元层可以包括卷积层、批标准化层和修正线性单元层(rectified linear unit layers,relu)。在一些示例中,池化层 (pooling layers,pooling)可以是最大池化层(max pooling layers, max-poooling)。在一些示例中,跳跃连接单元可以用于组合来自深层的图像特征和来自浅层的图像特征。

[0066]

另外,分割网络22可以是前向型神经网络。在一些示例中,分割网络22可以包括多个单元层。在一些示例中,分割网络22可以包括多个单元层和卷积层(convolutional layers,conv)。

[0067]

另外,回归网络23可以包括膨胀卷积层(dilated convolutionlayers, dilated conv)和修正线性单元层(batch normalizationlayers,bn)。在一些示例中,回归网络23可以包括膨胀卷积层、修正线性单元层和卷积层。

[0068]

图4是示出了本公开示例所涉及的网络模块20的另一个示例的示意图。需要说明的是,为了更清楚地描述网络模块20的网络结构,在图4中,通过箭头中的数字对网络模块20中的网络层进行区分,其中,箭头1表示卷积层、批标准化层和修正线性单元层组成的网络层(也即单元层),箭头2表示膨胀卷积层和修正线性单元组成的网络层,箭头3表示卷积层,箭头4表示最大池化层,箭头5表示上采样层,箭头6表示跳跃连接单元。

[0069]

作为网络模块20的一个示例。如图4所示,可以将分辨率为256

ꢀ×

256的眼底图像输入到网络模块20,经过编码模块的不同层级的单元层(参见箭头1)和最大池化层(参见箭头4)提取图像特征,并通过解码模块的不同层级的单元层(参见箭头1)、上采样层(参见箭头 5)和跳跃连接单元(参见箭头6)不断地融合不同尺度的图像特征以获得与眼底图像的尺度一致的特征图221,然后将特征图221分别输入的分割网络22和回归网络23以获取第一输出和第二输出。

[0070]

另外,如图4所示,分割网络22可以依次由单元层(参见箭头1) 和卷积层(参见箭

头3)组成,回归网络23可以依次由多个由膨胀卷积层和修正线性单元层组成的网络层(参见箭头2)、以及卷积层(参见箭头3)组成。其中,单元层可以由卷积层、批标准化层和修正线性单元层组成。

[0071]

在一些示例中,网络模块20中的卷积层的卷积核的大小可以设置为3

×

3。在一些示例中,网络模块20中的最大池化层的卷积核的大小可以设置为2

×

2,卷积步长可以设置为2。在一些示例中,网络模块 20中的上采样层的放大比例系数(scale-factor)可以设置为2。在一些示例中,如图4所示,网络模块20中的多个膨胀卷积层的膨胀系数 (dilation-factor)可以依次设置为1、1、2、4、8和16(参见箭头2 上面的数字)。在一些示例中,如图4所示,最大池化层的数量可以为 5。由此,能够使眼底图像的大小被32(32可以为2的5次方)除尽。

[0072]

如上所述,本公开涉及的测量方法是利用基于目标的紧框标进行训练的网络模块20对目标进行识别从而实现测量的测量方法。以下,结合附图详细描述本公开涉及的网络模块20的训练方法(可以简称为训练方法)。图5是示出了本公开示例所涉及的网络模块20的训练方法的流程图。

[0073]

在一些示例中,可以基于端对端的方式同时训练网络模块20中的分割网络22和回归网络23。

[0074]

在一些示例中,网络模块20中的分割网络22和回归网络23可以通过联合训练以同时优化分割网络22和回归网络23。在一些示例中,通过联合训练,分割网络22和回归网络23可以通过反向传播调整骨干网络21的网络参数,以使骨干网络21输出的特征图能够更好的表达眼底图像的特征并输入分割网络22和回归网络23。在这种情况下,分割网络22和回归网络23均基于骨干网络21输出的特征图进行处理。

[0075]

在一些示例中,可以利用多示例学习对分割网络22进行训练。在一些示例中,可以利用待训练图像的像素点对应的期望交并比筛选用于训练回归网络23的像素点(稍后描述)。

[0076]

在一些示例中,如图5所示,训练方法可以包括构建训练样本(步骤s120)、将训练样本输入网络模块20以获取预测数据(步骤s140)、以及基于训练样本和预测数据确定网络模块20的训练损失并基于训练损失对网络模块20进行优化(步骤s160)。由此,能够获得已优化(也可以称为已训练)的网络模块20。

[0077]

在一些示例中,在步骤s120中,可以构建训练样本。训练样本可以包括眼底图像数据和标签数据。在一些示例中,眼底图像数据可以包括多张待训练图像。待训练图像可以为待训练的眼底图像。

[0078]

在一些示例中,多张待训练图像可以包括包含目标的图像。对于眼底图像,目标可以为视杯和视盘中的至少一种。也即,目标可以属于视杯和视盘中的至少一种类别。在一些示例中,多张待训练图像中可以包括包含目标的图像和不包含目标的图像。对于眼底图像,若是对视杯和视盘进行识别或测量,则眼底图像中的目标可以为一个视盘和一个视杯。也即,眼底图像中存在两种需要进行识别或测量的目标,且各个目标的数量可以为1;若是对视杯或视盘中的一种目标进行识别或测量,则眼底图像中的目标可以为一个视杯或一个视盘。

[0079]

在一些示例中,标签数据可以包括目标所属的类别的金标准(类别的金标准有时

也可以称为真实类别)和目标的紧框标的金标准(紧框标的金标准有时也可以称为真实紧框标)。也即,标签数据可以为待训练图像中的目标所属的真实类别和目标的真实紧框标。需要说明的是,除非特别说明,训练方法中标签数据中的目标的紧框标或目标所属的类别均可以默认是金标准。

[0080]

在一些示例中,可以对待训练图像进行标注以获取标签数据。在一些示例中,可以利用标注工具例如线标注系统对待训练图像进行标注。具体地,可以利用标注工具对待训练图像中的目标的紧框标(也即,最小外接矩形)进行标注,并针对紧框标设置相应的类别以表示目标所属的真实类别。

[0081]

在一些示例中,为了抑制网络模块20过拟合,可以对训练样本进行数据扩增处理。在一些示例中,数据扩增处理可以包括但不限于翻转(例如上下翻转或左右翻转)、放大、旋转、调整对比度、调整亮度或色彩均衡。在一些示例中,可以对训练样本中的眼底图像数据和标签数据进行相同的数据增广处理。由此,能够使眼底图像数据和标签数据保持一致。

[0082]

在一些示例中,在步骤s140中,可以将训练样本输入网络模块20 以获取预测数据。如上所述,网络模块20可以包括分割网络22和回归网络23。在一些示例中,通过网络模块20可以基于训练样本的眼底图像数据,获得训练样本对应的预测数据。预测数据可以包括由分割网络22输出的预测分割数据和由回归网络23输出的预测偏移。

[0083]

另外,预测分割数据可以与第一输出对应,预测偏移可以与第二输出对应(也即,可以与目标偏移对应)。也即,预测分割数据可以包括待训练图像中的各个像素点属于各个类别的概率,预测偏移可以包括待训练图像中各个像素点的位置与每个类别的目标的紧框标的偏移。在一些示例中,与目标偏移对应,预测偏移可以为基于各个类别的目标的平均大小进行归一化后的偏移。由此,能够提高对尺寸变化不大的目标进行识别或测量的精确性。

[0084]

为了更清楚地描述像素点的位置与目标的紧框标的偏移、以及归一化后的偏移,以下结合公式进行描述。需要说明的是预测偏移、目标偏移和真实偏移属于偏移的一种,同样适用于下面的公式(1)。

[0085]

具体地,可以令像素点的位置表示为(x,y),该像素点对应的一个目标的紧框标表示为b=(xl,yt,xr,yb),目标的紧框标b相对该像素点的位置的偏移(也即像素点的位置与目标的紧框标的偏移)表示为 t=(tl,tt,tr,tb),则tl,tt,tr,tb可以满足公式(1):

[0086]

tl=(x-xl)/sc,

[0087]

tt=(y-yt)/sc,

[0088]

tr=(xr-x)/sc,

[0089]

tb=(yb-y)/sc,

[0090]

其中,xl,yt可以表示目标的紧框标的左上角的位置,xr,yb可以表示目标的紧框标的右下角的位置,c可以表示目标所属的类别的索引, sc可以表示第c个类别的目标的平均大小。由此,能够获得归一化后的偏移。但本公开的示例不限于此,在另一些示例,也可以通过左下角的位置和右上角的位置表示目标的紧框标,或通过任意一个角的位置、长度和宽度表示目标的紧框标。另外,在另一些示例中,也可以利用其他方式进行归一化,例如,可以利用目标的紧框标的长度和宽度对偏移进行归一化。

[0091]

另外,公式(1)中的像素点可以为待训练图像或眼底图像的像素点。也即,公式(1)可以适用训练阶段的待训练图像对应的真实偏移、以及测量阶段的眼底图像对应的目标偏

移。

[0092]

具体地,对于训练阶段,像素点可以为待训练图像中的像素点,目标的紧框标b可以为待训练图像的目标的紧框标的金标准,则偏移t 可以为真实偏移(也可以称为偏移的金标准)。由此,后续能够基于预测偏移和真实偏移获取回归网络23的回归损失。另外,若像素点为待训练图像中的像素点,偏移t为预测偏移,则可以根据公式(1)反推预测的目标的紧框标。

[0093]

另外,对于测量阶段,像素点可以为眼底图像中的像素点,偏移t 可以为目标偏移,则可以根据公式(1)和目标偏移反推眼底图像中的目标的紧框标(也即,可以将目标偏移和像素点的位置代入公式(1) 以获取目标的紧框标)。由此,能够获得眼底图像中的目标的紧框标。

[0094]

在一些示例中,在步骤s160中,可以基于训练样本和预测数据确定网络模块20的训练损失并基于训练损失对网络模块20进行优化。在一些示例中,基于训练样本对应的标签数据、预测分割数据和预测偏移可以确定网络模块20的训练损失,然后基于训练损失对网络模块 20进行训练以优化网络模块20。

[0095]

如上所述,网络模块20可以包括分割网络22和回归网络23。在一些示例中,训练损失可以包括分割网络22的分割损失和回归网络23 的回归损失。也即,可以基于分割损失和回归损失,获取网络模块20 的训练损失。由此,能够基于训练损失对网络模块20进行优化。在一些示例中,训练损失可以为分割损失和回归损失之和。在一些示例中,分割损失可以表示预测分割数据中待训练图像中的像素点属于各个真实类别的程度,回归损失可以表示预测偏移与真实偏移的接近程度。

[0096]

图6是示出了本公开示例所涉及的正包的示意图。

[0097]

在一些示例中,可以基于训练样本对应的预测分割数据和标签数据,获取分割网络22的分割损失。由此,能够通过分割损失使分割网络22的预测分割数据近似标签数据。在一些示例中,可以利用多示例学习获取分割损失。在多示例学习中,可以按类别基于各个待训练图像中的目标的真实紧框标获取多个待训练包(也即,各个类别可以分别对应多个待训练包)。基于各个类别的多个待训练包可以获取分割损失。在一些示例中,多个待训练包可以包括多个正包和多个负包。由此,能够基于多示例学习的正包和负包获取分割损失。需要说明的是,除非特别说明,以下正包和负包均是针对各个类别的。

[0098]

在一些示例中,可以基于目标的真实紧框标内的区域获取多个正包。如图6所示,待训练图像p1中区域a2为目标t1的真实紧框标 b21内的区域。

[0099]

在一些示例中,可以将连接目标的真实紧框标相对的两个边的多条直线中的各条直线上的全部像素点划分为一个正包(也即,一条直线可以对应一个正包)。具体地,各条直线的两端可以在真实紧框标的上端和下端、或左端和右端。作为示例,如图6所示,直线d1、直线 d2、直线d3、直线d4、直线d5、直线d6、直线d7和直线d8上的像素点可以分别划分为一个正包。但本公开的示例不限于此,在另一些示例中,也可以使用其他方式划分正包。例如,可以将真实紧框标的特定位置的像素点划分为一个正包。

[0100]

在一些示例中,多条直线可以包括至少一组相互平行的第一平行线。例如,多条直线可以包括一组第一平行线、两组第一平行线、三组第一平行线或四组第一平行线等。在一些示例中,第一平行线中的直线的数量可以大于等于2。

[0101]

在一些示例中,多条直线可以包括至少一组相互平行的第一平行线和分别与每组第一平行线垂直的相互平行的第二平行线。具体地,若多条直线包括一组第一平行线,则多条直线还可以包括与该组第一平行线垂直的一组第二平行线,若多条直线包括多组第一平行线,则多条直线还可以包括分别与每组第一平行线垂直的多组第二平行线。如图6所示,一组第一平行线可以包括平行的直线d1和直线d2,与该组第一平行线对应的一组第二平行可以包括平行的直线d3和直线 d4,其中,直线d1可以与直线d3垂直;另外一组第一平行线可以包括平行的直线d5和直线d6、与该组第一平行线对应的一组第二平行线可以包括平行的直线d7和直线d8,其中,直线d5可以与直线d7 垂直。在一些示例中,第一平行线和第二平行线的中的直线的数量可以大于等于2。

[0102]

如上所述,在一些示例中,多条直线可以包括多组第一平行线(也即,多条直线可以包括不同角度的平行线)。在这种情况下,能够划分不同角度的正包对分割网络22进行优化。由此,能够提高分割网络22 的预测分割数据的准确性。

[0103]

在一些示例中,第一平行线的角度可以为第一平行线的延长线与真实紧框标的任意一个未相交的边的延长线的夹角的角度,第一平行线的角度可以大于-90

°

且小于90

°

。例如夹角的角度可以为-89

°

、-75

ꢀ°

、-50

°

、-25

°

、-20

°

、0

°

、10

°

、20

°

、25

°

、50

°

、75

°

或89

ꢀ°

等。具体地,若通过未相交的边的延长线顺时针旋转小于90

°

到第一平行线的延长线构成的夹角的角度可以大于0

°

且小于90

°

,若通过未相交的边的延长线逆时针旋转小于90

°

(也即,顺时针旋转大于 270

°

)到第一平行线的延长线构成的夹角的角度可以大于-90

°

且小于 0

°

,若未相交的边与第一平行线平行,则夹角的角度可以为0

°

。如图6所示,直线d1、直线d2、直线d3和直线d4的角度可以为0

°

,直线d5、直线d6、直线d7和直线d8的角度(也即角度c1)可以为 25

°

。在一些示例中,第一平行线的角度可以为超参数,在训练过程可以进行优化。

[0104]

另外,也可以以待训练图像旋转的方式描述第一平行线的角度。第一平行线的角度可以为旋转的角度。具体地,第一平行线的角度可以为将待训练图像旋转以使待训练图像的与第一平行线不相交的任意边与第一平行线平行的旋转角度,其中,第一平行线平行的角度可以大于-90

°

且小于90

°

,顺时针旋转的旋转角度可以为正度数,逆时针旋转的旋转角度可以为负度数。

[0105]

但本公开的示例不限于此,在另一些示例中,根据第一平行线的角度的描述的方式不同,第一平行线的角度也可以为其他范围。例如,若基于与第一平行线相交的真实紧框的边进行描述,第一平行线的角度也可以大于0

°

且小于180

°

。

[0106]

在一些示例中,可以基于目标的真实紧框标之外的区域获取多个负包。如图6所示,待训练图像p1中区域a1为目标t1的真实紧框标b21之外的区域。在一些示例中,负包可以为一个类别的所有目标的真实紧框标之外的区域的单个像素点(也即,一个像素点可以对应一个负包)。

[0107]

如上所述,在一些示例中,基于各个类别的多个待训练包可以获取分割损失。在一些示例中,分割损失可以包括一元项(也可以称为一元损失)和成对项(也可以称为成对损失)。在一些示例中,一元项可以描述每个待训练包属于各个真实类别的程度。在这种情况下,能够通过一元损失使紧框标同时通过正包和负包进行约束。在一些示例中,成对项可以描述待训练图像的像素点与该像素点相邻的像素点属于同类别的程度。在这种情况下,成对损失使预测分割结果平滑。

[0108]

在一些示例中,可以按类别获得类别的分割损失,基于类别的分割损失获取分割损失(也即总分割损失)。在一些示例中,总分割损失 l

seg

可以满足公式:

[0109][0110]

其中,lc可以表示类别c的分割损失,c可以表示类别的数量。例如,若对眼底图像中的视杯和视盘进行识别,则c可以为2,若仅对视杯或仅对视盘进行识别,则c可以为1。

[0111]

在一些示例中,类别c的分割损失lc可以满足公式:

[0112][0113]

其中,φc可以表示一元项,可以表示成对项,p可以表示分割网络22预测的每个像素点属于各个类别的程度(也可以称为概率),bc 可以表示多个正包的集合,b

c-可以表示多个负包的集合,λ可以表示权重因子。权重因子λ可以为超参数,在训练过程可以进行优化。在一些示例中,权重因子λ可以用于切换两个损失(也即一元项和成对项)。

[0114]

一般而言,在多示例学习中,若一个类别的各个正包中至少包括一个像素点属于该类别,则可以将各个正包中属于该类别的概率最大的像素点作为该类别的正样本;若一个类别的各个负包中不存在属于该类别的像素点,则负包中即使概率最大的像素点也是该类别的负样本。基于这种情况,在一些示例中,类别c对应的一元项φc可以满足公式:

[0115][0116]

其中,pc(b)可以表示一个待训练包属于类别c的概率(也可以称为属于类别c的程度或待训练包的概率),b可以表示一个待训练包,可以表示多个正包的集合,可以表示多个负包的集合,max可以表示最大值函数,可以表示多个正包的集合的基数(也即集合的元素个数),β可以表示权重因子,γ可以表示聚焦参数(focusing parameter)。在一些示例中,当正包对应的pc(b) 等于1且负包对应的pc(b)等于0时一元项的值最小。也即,一元损失最小。

[0117]

在一些示例中,权重因子β可以在0至1之间。在一些示例中,聚焦参数γ可以大于等于0。

[0118]

在一些示例中,pc(b)可以为一个待训练包的像素点中属于类别c 的最大概率。在一些示例中,pc(b)可以满足公式:pc(b)=max

k∈b

(p

kc

),其中,p

kc

可以表示待训练包b的第k个位置的像素点属于类别c的概率。

[0119]

在一些示例中,可以基于最大值平滑近似函数(smooth maximumapproximation)获取一个待训练包的像素点中属于一个类别的最大概率 (也即获取pc(b))。由此,能够获得较稳定的最大概率。

[0120]

在一些示例中,最大值平滑近似函数可以为α-softmax函数和α-quasimax函数中的至少一种。

[0121]

在一些示例中,对于最大值函数f(x)=max

1≤i≤n

xi,max可以表示最大值函数,n可以表示元素个数(可以对应待训练包中的像素点的个数), xi可以表示元素的值(可以对应待训练包的第i个位置的像素点属于一个类别的概率。在这种情况下,α-softmax函数可以

满足公式:

[0122][0123]

其中,α可以为常量。在一些示例中,α越大,越接近最大值函数的最大值。

[0124]

另外,α-quasimax函数可以满足公式:

[0125][0126]

其中,α可以为常量。在一些示例中,α越大,越接近最大值函数的最大值。

[0127]

如上所述,在一些示例中,成对项可以描述待训练图像的像素点与该像素点相邻的像素点属于同类别的程度。也即,成对项可以评估相邻的像素点属于同类别的概率的接近程度。在一些示例中,类别c对应的成对项可以满足公式:

[0128][0129]

其中,ε可以表示所有相邻像素点对的集合,(k,k')可以表示一对相邻像素点,k和k'可以分别表示相邻像素点对的两个像素点的位置, p

kc

可以表示第k个位置的像素点属于类别c的概率,p

k'c

可以表示第k' 个位置的像素点属于类别c的概率。

[0130]

在一些示例中,相邻像素点可以为八邻域或四邻域的像素点。在一些示例中,可以获取待训练图像中的各个像素点的相邻像素点以获得相邻像素点对的集合。

[0131]

如上所述,训练损失可以包括回归损失。在一些示例中,可以基于训练样本对应的预测偏移和基于标签数据对应的真实偏移,获取回归网络23的回归损失。在这种情况下,能够通过回归损失使回归网络 23的预测偏移近似真实偏移。

[0132]

在一些示例中,真实偏移可以为待训练图像的像素点的位置与标签数据中的目标的真实紧框标的偏移。在一些示例中,与预测偏移对应,真实偏移可以是基于各个类别的目标的平均大小进行归一化后的偏移。具体内容可以参见上述公式(1)的关于偏移的相关描述。

[0133]

在一些示例中,可以从待训练图像中的像素点选择相应的像素点作为正样本对回归网络23进行训练。也即,可以利用正样本对回归网络23进行优化。具体地,可以基于正样本获取回归损失,然后利用回归损失对回归网络23进行优化。

[0134]

在一些示例中,回归损失可以满足公式:

[0135][0136]

其中,c可以表示类别的数量,mc可以表示第c个类别的正样本的数量,t

ic

可以表示第c个类别的第i个正样本对应的真实偏移,v

ic

可以表示第c个类别的第i个正样本对应的预测偏移,s(x)可以表示x中所有元素的smooth l1损失之和。在一些示例中,对于x为t

ic-v

ic

, s(t

ic-v

ic

)可以表示利用smooth l1损失计算第c个类别的第i个正样本对应的预测偏移与第i个正样本对应的真实偏移一致的程度。这里,正样本可以为被选择用于对回归网络23进行训练(也即,用于计算回归损失)的待训练图像中的像素点。由此,能够获取回归损失。在

一些示例中,正样本对应的真实偏移可以为真实紧框标对应的偏移。

[0137]

在一些示例中,smooth l1损失函数可以满足公式:

[0138][0139]

其中,σ可以表示超参数,用于smooth l1损失函数与smooth l2 损失函数之间的切换,x可以表示smooth l1损失函数的变量。

[0140]

如上所述,在一些示例中,可以从待训练图像中的像素点选择相应的像素点作为正样本对回归网络23进行训练。

[0141]

在一些示例中,正样本可以是待训练图像中至少落入一个目标的真实紧框标内的像素点(也即,可以从待训练图像中选择至少落入一个目标的真实紧框标内的像素点作为正样本)。在这种情况下,基于落入至少一个目标的真实紧框标内的像素点对回归网络23进行优化,能够提高回归网络23优化的效率。在一些示例中,可以按类别从待训练图像中选择至少落入一个目标的真实紧框标内的像素点作为各个类别的正样本。在一些示例中,基于各个类别的正样本可以获取各个类别的回归损失。

[0142]

如上所述,可以按类别从待训练图像中选择至少落入一个目标的真实紧框标内的像素点作为各个类别的正样本。在一些示例中,可以对上述的各个类别的正样本进行筛选,并基于筛选后的正样本对回归网络23进行优化。也即,用于计算回归损失的正样本可以是筛选后的正样本。

[0143]

在一些示例中,在获取各个类别的正样本后(也即,从待训练图像中选择至少落入一个目标的真实紧框标内的像素点作为正样本后),可以获取该正样本对应的匹配紧框标,然后基于匹配紧框标对各个类别的正样本进行筛选。由此,能够利用基于匹配紧框标筛选后的各个类别的正样本对回归网络23进行优化。

[0144]

在一些示例中,可以对像素点(例如正样本)落入的真实紧框标进行筛选以获取该像素点的匹配紧框标。在一些示例中,对于眼底图像,匹配紧框标可以为像素点落入的真实紧框标。对于正样本,匹配紧框标可以为正样本落入的真实紧框标。也即,可以将真实紧框标作为像素点(例如正样本)的匹配紧框标。

[0145]

在一些示例中,可以利用像素点(例如正样本)对应的期望交并比对各个类别的正样本进行筛选。在这种情况下,能够筛除远离真实紧框标或匹配紧框标的中心的像素点。由此,能够降低远离中心的像素点对回归网络23优化的不利影响且能够提高回归网络23优化的效率。

[0146]

在一些示例中,可以基于匹配紧框标获取正样本对应的期望交并比并基于期望交并比对各个类别的正样本进行筛选。具体地,在获取各个类别的正样本后,可以获取该正样本对应的匹配紧框标,然后基于匹配紧框标获取正样本对应的期望交并比并基于期望交并比对各个类别的正样本进行筛选,最后可以利用筛选后的各个类别的正样本对回归网络23进行优化。但本公开的示例不限于此,在一些示例中,可以按类别并利用待训练图像的像素点对应的期望交并比对待训练图像的像素点进行筛选(也即,可以不先从待训练图像中选择至少落入一个目标的真实紧框标内的像素点作为正样本情况下,利用期望交并比对待训

≤0.5,像素点m1对应的四个边界条件可以分别为:

[0156]

w1=2r1w,h1=2r2h;

[0157]

w2=2r1w,h2=2(1-r2)h;

[0158]

w3=2(1-r1)w,h3=2r2h;

[0159]

w4=2(1-r1)w,h4=2(1-r2)h;

[0160]

其中,w1和h1可以表示第一个边界条件的宽度和高度,w2和h2可以表示第二个边界条件的宽度和高度,w3和h3可以表示第三个边界条件的宽度和高度,w4和h4可以表示第四个边界条件的宽度和高度。

[0161]

其次,计算各个边界条件下的边框与匹配紧框标的交并比。具体地,上述四个边界条件对应的交并比可以满足公式(2):

[0162]

iou1(r1,r2)=4r1r2,

[0163]

iou2(r1,r2)=2r1/(2r1(1-2r2) 1),

[0164]

iou3(r1,r2)=2r2/(2r2(1-2r1) 1),

[0165]

iou4(r1,r2)=1/(4(1-r1)(1-r2)),

[0166]

其中,iou1(r1,r2)可以表示第一个边界条件对应的交并比, iou2(r1,r2)可以表示第二个边界条件对应的交并比,iou3(r1,r2)可以表示第三个边界条件对应的交并比,iou4(r1,r2)可以表示第四个边界条件对应的交并比。在这种情况下,能够获得各个边界条件对应的交并比。

[0167]

最后,多个边界条件的交并比中最大的交并比即为期望交并比。在一些示例中,对于r1,r2满足条件:0《r1,r2≤0.5,期望交并比可以满足公式(3):

[0168]

另外,对于位于其他区域(也即,右上区域、左下区域和右下区域)的像素点的期望交并比可以基于左上区域类似的方法获得。在一些示例中,对于r1满足条件:0.5≤r1《1,可以将公式(3)的r1替换为1-r1,对于r2满足条件:0.5≤r2《1,可以将公式(3)的r2替换为1-r2。由此,能够获得位于其他区域的像素点的期望交并比。也即,位于其他区域的像素点通过坐标转换可以映射至左上区域,进而可以基于以左上区域一致的方式获取期望交并比。因此,对于r1,r2满足条件:0《r1,r2《1,期望交并比可以满足公式(4):

[0169][0170]

其中,iou1(r1,r2)、iou2(r1,r2)、iou2(r1,r2)和iou2(r1,r2)可以由公式(2)获得。由此,能够获得期望交并比。

[0171]

如上所述,在一些示例中,可以基于像素点(例如正样本)的匹配紧框标获取像素点对应的期望交并比。但本公开的示例不限于此,在另一些示例中,在对各个类别的正样本或对待训练图像的像素点进行筛选过程中,也可以不获取匹配紧框标。具体地,可以基于像素点 (例如正样本)对应的真实紧框标获取像素点对应的期望交并比并基于期望交并比对各个类别的像素点进行筛选。在这种情况下,期望交并比可以为各个真实紧框标对应的期望交并比中的最大值。基于真实紧框标获取像素点对应的期望交并比中可以参考基于像素点的匹配紧框标获取像素点对应的期望交并比的相关描述。

[0172]

以下,结合附图详细描述本公开涉及的测量方法。测量方法涉及的网络模块20可以由上述的训练方法进行训练。图8(a)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的流程图。

[0173]

本实施方式涉及的针对眼底图像的测量方法,可以利用基于目标的紧框标进行训练的网络模块20对眼底图像中的至少一个目标进行识别从而实现测量。眼底图像可以包括至少一个目标,至少一个目标可以为视杯和/或视盘。也即,可以基于目标的紧框标进行训练的网络模块20对眼底图像中的视杯和/或视盘进行识别从而实现视杯和/或视盘的测量。由此,能够基于紧框标对眼底图像中的视杯和/或视盘进行测量。在另一些示例中,也可以针对眼底图像中的微血管瘤进行识别从而实现微血管瘤的测量。

[0174]

在一些示例中,如图8(a)所示,测量方法可以包括获取眼底图像(步骤s420)、将眼底图像输入网络模块20以获取第一输出和第二输出(步骤s440)、以及基于第一输出和第二输出对目标进行识别以获取眼底图像中的视杯和/或视盘的紧框标从而实现测量(步骤s460)。

[0175]

在一些示例中,在步骤s420中,可以获取眼底图像。在一些示例中,眼底图像可以包括至少一个目标。在一些示例中,可以对至少一个目标进行识别以识别出目标以及目标所属的类别(也即,感兴趣的类别)。对于眼底图像,感兴趣的类别可以为视杯和/或视盘。各个类别的目标可以为视杯或视盘。具体地,若对眼底图像中的视盘或视杯中的一种目标进行识别,则感兴趣的类别可以为视杯或视盘,若对眼底图像中的视盘和视杯进行识别,则感兴趣的类别可以为视杯和视盘。在一些示例中,眼底图像也可以不包括视盘或视杯。在这种情况下,能够对不存在视盘或视杯的眼底图像进行判断。

[0176]

在一些示例中,在步骤440中,可以将眼底图像输入网络模块20 以获取第一输出和第二输出。在一些示例中,第一输出可以包括眼底图像中的各个像素点属于各个类别(也即视杯和/或视盘)的概率。在一些示例中,第二输出可以包括眼底图像中各个像素点的位置与每个类别的目标的紧框标的偏移。在一些示例中,可以将第二输出中的偏移作为目标偏移。在一些示例中,网络模块20可以包括骨干网络21、分割网络22和回归网络23。在一些示例中,分割网络22可以是基于弱监督学习的图像分割的。在一些示例中,回归网络23可以是基于边框回归的。在一些示例中,骨干网络21可以用于提取眼底图像的特征图。在一些示例中,分割网络22可以将特征图作为输入以获得第一输出,回归网络23可以将特征图作为输入以获得第二输出。在一些示例中,特征图的分辨率可以与眼底图像一致。具体内容参见网络模块20 的相关描述。

[0177]

在一些示例中,在步骤s460中,可以基于第一输出和第二输出对目标进行识别以获取眼底图像中的视杯和/或视盘的紧框标从而实现测量。由此,后续能够基于紧框标对视杯和/或视盘进行精确地测量。在一些示例中,可以基于第一输出从第二输出中选择相应位置的像素点对应类别(也即,视杯和/或视盘)的目标偏移,并基于该目标偏移获取视杯和/或视盘的紧框标。

[0178]

在一些示例中,可以从第一输出中获取属于各个类别的局部概率最大的像素点的位置作为第一位置,基于第二输出中与第一位置对应的位置且对应类别的目标偏移获取各个类别的目标的紧框标。在这种情况下,能够识别出各个类别的一个目标或多个目标。在一些示例中,可以采用非极大值抑制法(non-maximum suppression,nms)获取第一位置。在一

些示例中,各个类别对应的第一位置的数量可以大于等于1。对于眼底图像,优选地,可以从第一输出中获取属于各个类别的概率最大的像素点的位置作为第一位置,基于第二输出中与第一位置对应的位置且对应类别的目标偏移获取视杯和/或视盘的紧框标。由此,能够识别出视杯和/或视盘。在一些示例中,可以利用极大值法获取第一位置。在一些示例中,可以利用极大值法获取属于各个类别的概率最大的像素点的位置。在一些示例中,还可以利用平滑极大值抑制法获取第一位置。

[0179]

在一些示例中,可以基于第一位置和目标偏移获取各个类别的目标的紧框标。在一些示例中,可以将第一位置和目标偏移代入公式(1) 以反推目标的紧框标。具体地,可以将第一位置作为公式(1)的像素点的位置(x,y)并将目标偏移作为偏移t以获取目标的紧框标b。

[0180]

图8(b)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量方法的另一种示例的流程图。在一些示例中,如图8 (b)所示,测量方法还可以包括基于眼底图像中的视杯和视盘的紧框标获取视杯和视盘的比值(步骤s480)。由此,能够基于视杯和视盘的紧框标对视杯和视盘的比值进行精确地测量。

[0181]

在一些示例中,在步骤s460获取视杯和/或视盘的紧框标后,可以基于眼底图像中的视杯的紧框标和/或视盘的紧框标对视杯和/或视盘进行测量以获取视杯和/或视盘的尺寸(尺寸例如可以为垂直直径和水平直径)。由此,能够对视杯和/或视盘的尺寸进行精确地测量。在一些示例中,可以将紧框标的高度作为视杯和/或视盘的垂直直径,将紧框标的宽度作为视杯和/或视盘的水平直径以获取视杯和/或视盘的尺寸。

[0182]

在一些示例中,基于紧框标获取视杯和视盘的尺寸后可以获取视杯和视盘的比值(也可以简称为杯盘比)。在这种情况下,基于紧框标获取视杯和视盘的比值,进而能够对杯盘比进行精确地测量。

[0183]

在一些示例中,杯盘比可以包括垂直杯盘比和水平杯盘比。垂直杯盘比可以为视杯和视盘的垂直直径的比值。水平杯盘比可以为视杯和视盘的水平直径的比值。

[0184]

在一些示例中,令眼底图像中的视杯的紧框标为 b

oc

=(xl

oc

,yt

oc

,xr

oc

,yb

oc

),视盘的紧框标为b

od

=(xl

od

,yt

od

,xr

od

,yb

od

),其中,b

oc

和b

od

的前两个数值可以表示紧框标的左上角的位置,后两个数值可以表示紧框标的右下角的位置,则

[0185]

垂直杯盘比可以满足公式:vcdr=(yb

oc-yt

oc

)/(yb

od-yt

od

),

[0186]

水平杯盘比可以满足公式:hcdr=(xr

oc-xl

oc

)/(xr

od-xl

od

)。

[0187]

以下,结合附图详细描述本公开涉及的基于紧框标的深度学习的眼底图像的测量装置200。测量装置200还可以称为识别装置、紧框标测量装置、紧框标识别装置、自动测量装置、辅助测量装置等。本公开涉及的测量装置200用于实施上述的测量方法。图9(a)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置 200的框图。

[0188]

如图9(a)所示,在一些示例中,测量装置200可以包括获取模块50、网络模块20和识别模块60。

[0189]

在一些示例中,获取模块50可以配置为获取眼底图像。在一些示例中,眼底图像可以包括至少一个目标。在一些示例中,可以对至少一个目标进行识别以识别出目标以及目标所属的类别(也即,感兴趣的类别)。对于眼底图像,感兴趣的类别(也可以简称为类别)可以为视杯和/或视盘。各个类别的目标可以为视杯或视盘。具体内容参见步骤s420中的相关

描述。

[0190]

在一些示例中,网络模块20可以配置为接收眼底图像并基于眼底图像获取第一输出和第二输出。在一些示例中,第一输出可以包括眼底图像中的各个像素点属于各个类别的概率。在一些示例中,第二输出可以包括眼底图像中各个像素点的位置与每个类别的目标的紧框标的偏移。在一些示例中,可以将第二输出中的偏移作为目标偏移。在一些示例中,网络模块20可以包括骨干网络21、分割网络22和回归网络23。在一些示例中,分割网络22可以是基于弱监督学习的图像分割的。在一些示例中,回归网络23可以是基于边框回归的。在一些示例中,骨干网络21可以用于提取眼底图像的特征图。在一些示例中,分割网络22可以将特征图作为输入以获得第一输出,回归网络23可以将特征图作为输入以获得第二输出。在一些示例中,特征图的分辨率可以与眼底图像一致。具体内容参见网络模块20的相关描述。

[0191]

在一些示例中,识别模块60可以配置为基于第一输出和第二输出对目标进行识别以获取眼底图像中的视杯和/或视盘的紧框标从而实现测量。具体内容参见步骤s460中的相关描述。

[0192]

图9(b)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置200的另一个示例的框图。图9(c)是示出了本公开示例所涉及的基于紧框标的深度学习的眼底图像的测量装置200 的另一个示例的框图。

[0193]

如图9(b)和图9(c)所示,在一些示例中,测量装置200还可以包括杯盘比模块70。杯盘比模块70可以配置为基于眼底图像中的视杯和视盘的紧框标获取视杯和视盘的比值。具体内容参见步骤s480中的相关描述。

[0194]

本公开涉及的测量方法及测量装置200,构建包括骨干网络21、基于弱监督学习的图像分割的分割网络22和基于边框回归的回归网络 23的网络模块20,网络模块20是基于目标的紧框标进行训练的,骨干网络21接收眼底图像并提取与眼底图像分辨率一致的特征图,将特征图分别输入分割网络22和回归网络23以获取第一输出和第二输出,然后基于第一输出和第二输出获取眼底图像中视杯和/或视盘的紧框标从而实现测量。在这种情况下,基于视杯和/或视盘的紧框标训练的网络模块20能够精确地预测眼底图像中视杯和/或视盘的紧框标,进而能够基于视杯和/或视盘的紧框标进行精确地测量。另外,通过回归网络 23预测归一化后的偏移,能够提高对尺寸变化不大的视杯和/或视盘进行识别或测量的精确性。另外,利用期望交并比筛选用于优化回归网络23的像素点,能够降低远离中心的像素点对回归网络23优化的不利影响且能够提高回归网络23优化的效率。另外,回归网络23预测的是明确类别的偏移,能够进一步地提高视杯和/或视盘识别或测量的精确性。

[0195]

虽然以上结合附图和示例对本公开进行了具体说明,但是可以理解,上述说明不以任何形式限制本公开。本领域技术人员在不偏离本公开的实质精神和范围的情况下可以根据需要对本公开进行变形和变化,这些变形和变化均落入本公开的范围内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。