1.本发明属于人工智能领域,具体涉及一种基于语音深度表征映射的语音翻译方法及系统。

背景技术:

2.机器翻译,又称为自动翻译,是利用计算机将一种自然语言(源语言)转换为另一种自然语言(目标语言)的过程,机器翻译广泛应用于影视、外交、外贸等各个领域。

3.当前主流的机器翻译方法是基于深度学习的文本翻译,其翻译水平已经在特定领域已经超过了人类,此种翻译方法通常采用基于序列到序列的神经网络模型,通过将源语言的文本表征映射成目标语言的文本表征,再通过目标语言文本表征转换成目标文本的方法实现文本的机器翻译;但是目前这种基于深度学习的文本翻译方法在用于语音翻译时,通常需要先将语音通过语音识别模型转换成文本,再通过文本机器翻译方法转换成目标语言文本,最后再通过语音合成方法转换成目标语言语音,流程复杂,而且由于多了语音识别和语音合成的步骤,一方面由于语音识别的误差导致翻译质量下降,另外一方面,由于合成的语音通常为某些预设的特定音色,导致翻译的语音存在与原始语音发音不协调的情况,从而使得翻译产品用户体验不佳。

技术实现要素:

4.为了解决上述文本翻译方法在语音翻译上存在的问题,本发明基于深度神经网络的表征学习方法及表征映射方法,提供了一种基于语音深度表征映射的直接语音到语音的翻译方法,本方法基于海量无标注的源语言语音及目标语言语音数据训练深度神经网络模型wav2vec2.0,学习出语音表征,然后基于成对的源语言语音与目标语言语音数据,通过自注意力机制神经网络模型,学习源语言语音表征与目标语音语音表征的映射,最后通过嵌入说话人表征的神经网络声码器模型,实现翻译后的高质量的目标语音生成。本发明方法具体技术方案如下:一种基于语音深度表征映射的语音翻译方法,包括如下步骤:s1:通过网络收集语音数据并保存,调整语音数据的长度,最后将语音数据转换成格式统一的数据集;s2:将s1得到的数据集训练wav2vec2.0网络,得到语音表征模型;s3:通过网络收集源语言语音数据和对应的目标翻译语言语音数据并保存,调整源语言语音数据和目标翻译语言语音数据的长度,最后将源语言语音数据和目标翻译语言语音数据转换成格式统一的数据集,其中源语言语音数据集表示为,目标翻译语言语音数据集表示为;

s4:将s3得到的源语言语音数据集,输入到s2得到的语音表征模型,得到源语言语音的深度表征;s5:将s3得到的目标翻译语言语音数据集,输入到s2得到的语音表征模型,得到目标翻译语言的深度表征;s6:将s4得到的源语言语音的深度表征,作为特征映射网络的输入,s5得到的目标翻译语言的深度表征作为特征映射网络的监督数据,训练特征映射网络,得到预测表征;s7:将将s3得到的源语言语音数据集输入到开源的训练好的声纹识别模型,输入到开源的训练好的声纹识别模型,得到发音人的深度表征;s8:将s6得到的预测表征和s7得到的发音人的深度表征在时间维度进行拼接,作为神经网络声码器的输入,将s3得到的目标翻译语言语音数据集作为神经网络声码器的监督数据,训练神经网络声码器,从而得到最终生成预测的翻译语音。

5.作为优选,所述的步骤s1通过网络收集语音数据,源语言语音数据和目标语言语音数据,语音数据按句子进行保存,并用语谱能量评估方法,去除语音句子前后静音,并保证每条语音数据控制在2秒到10秒长度,最后将语音通过ffmpeg软件转换成格式统一的数据集。

6.作为优选,所述的步骤s3通过网络收集源语言语音数据和对应的目标翻译语言语音数据,源语言语音数据和目标翻译语言语音数据按句子进行保存,并用语谱能量评估方法,去除语音句子前后静音,并保证每条源语言语音数据和目标翻译语言语音数据控制在2秒到10秒长度,最后将源语言语音数据和目标翻译语言语音数据通过ffmpeg软件转换成格式统一的数据集,其中源语言语音数据集表示为,目标翻译语言语音数据集表示为。

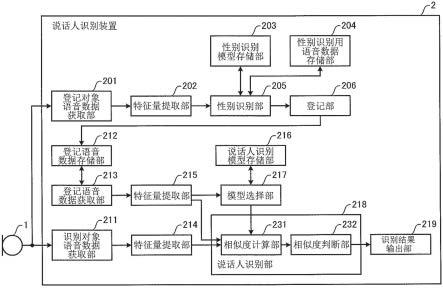

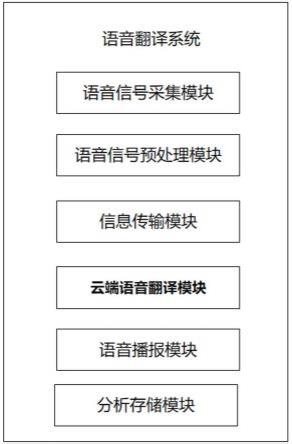

7.一种基于语音深度表征映射的语音翻译系统,包括按顺序依次连接的如下模块:语音信号采集模块,用于采集待翻译语音信号;语音信号预处理模块,用于将采集到的语音信号进行预处理,对语音进行人声检测,去除非人声部分,生成可用于神经网络处理的数据;信息传输模块,将预处理模块处理好的信息传输到云端后台处理,以及从云端获取翻译好的语音数据;云端语音翻译模块,采用上述一种基于语音深度表征映射的语音翻译方法训练好的翻译模型处理上传的语音数据,翻译成目标语言语音数据,并回传终端;语音播报模块,用于播放云端返回的语音信号;分析存储模块,用于利用mysql等数据库,存储用户的语音数据以及翻译好的语音数据。

8.进一步的,所述语音信号采集模块采用高保真单麦克风或者麦克风阵列或者本地

音频文件搜索算法。

9.进一步的,所述预处理,包括:预加重、分帧、加窗、短时傅里叶变换、静音去除,人声检测操作,将语音信号从时域信号转换到频域信号,即从音频采样转换成声谱谱特征;进一步的,所述静音去除采用谱减法,所述短时傅里叶变换用于对语音进行声谱特征提取,所述人声检测采用基于短时能量和过零率的方法进行。

10.进一步的,所述云端语音翻译模块,采用上述一种基于语音深度表征映射的语音翻译方法训练好的翻译模型处理上传的语音数据,翻译成目标语言语音数据,并通过音频流方式分段回传终端,达到实时播放的目的;本发明的优点如下:1、本发明的基于语音深度表征映射的语音翻译方法,通过对采集的数据集训练wav2vec2.0网络得到语音表征模型,再通过语音表征模型实现源语言语音和目标翻译语言语音的转化,能够实现直接语音到语音的翻译,简化了语音翻译的流程,提高了语音翻译的精度。

11.2、收集的语音数据基于海量无标注数据和大量成对数据训练深度学习模型,可以方便的使用海量影视等媒体数据进行模型训练,可方便的应用于各种语言语音的互译,提供了一种便捷通用的语音互译方案,实现语音直接翻译任务,适用于口语翻译、电视剧翻译配音、外语教学等场景。

12.3、将预测表征和发音人的深度表征在时间维度进行拼接,作为神经网络声码器的输入,将目标翻译语言语音数据作为神经网络声码器的监督数据,训练神经网络声码器,可实现语音翻译发音音色指定可控,并且基于深度学习神经网络的声码器能够使得合成的语音保真度更高。

附图说明

13.图1为本发明的基于语音深度表征映射的语音翻译系统的结构示意图;图2为本发明的基于语音深度表征映射的语音翻译方法的流程示意图;图3为本发明的基于语音深度表征映射的语音翻译方法的网络结构示意图。

具体实施方式

14.为了使本发明的目的、技术方案和技术效果更加清楚明白,以下结合说明书附图,对本发明作进一步详细说明。

15.如图1所示,一种基于语音深度表征映射的语音翻译系统,包括按顺序依次连接的以下模块:语音信号采集模块,用麦克风或者本地音频搜索方法采集待翻译语音信号;语音信号预处理模块,采用预加重、分帧、加窗、短时傅里叶变换、静音去除,人声检测操作,将语音信号从时域信号转换到频域信号,即从音频采样转换成声谱谱特征;其中采用谱减法对语音进行静音去噪,采用z变换方法对语音进行预加重,采用短时傅里叶变换方法对语音进行声谱特征提取,采用基于短时能量和过零率的方法进行人声检测,最终生成可用于神经网络处理的数据;信息传输模块,将预处理模块处理好的信息传输到云端后台处理,以及从云端获

取翻译好的语音数据。

16.云端语音翻译模块,采用上述一种基于语音深度表征映射的语音翻译方法训练好的翻译模型处理上传的语音数据,翻译成目标语言语音数据,并回传终端;语音播报模块,用于播放云端返回的语音信号。

17.分析存储模块,用于利用mysql等数据库,存储用户的语音数据以及翻译好的语音数据。

18.如图2所示,一种基于语音深度表征映射的语音翻译方法,包括如下步骤:s1:通过网络收集语音数据并保存,调整语音数据的长度,最后将语音数据转换成格式统一的数据集;s2:将s1得到的数据集训练wav2vec2.0网络,得到语音表征模型;s3:通过网络收集源语言语音数据和对应的目标翻译语言语音数据并保存,调整源语言语音数据和目标翻译语言语音数据的长度,最后将源语言语音数据和目标翻译语言语音数据转换成格式统一的数据集,其中源语言语音数据集表示为,目标翻译语言语音数据集表示为;s4:将s3得到的源语言语音数据集,输入到s2得到的语音表征模型,得到源语言语音的深度表征;s5:将s3得到的目标翻译语言语音数据集,输入到s2得到的语音表征模型,得到目标翻译语言的深度表征;s6:将s4得到的源语言语音的深度表征,作为特征映射网络的输入,s5得到的目标翻译语言的深度表征作为特征映射网络的监督数据,训练特征映射网络,得到预测表征;s7:将将s3得到的源语言语音数据集输入到开源的训练好的声纹识别模型,输入到开源的训练好的声纹识别模型,得到发音人的深度表征;s8:将s6得到的预测表征和s7得到的发音人的深度表征在时间维度进行拼接,作为神经网络声码器的输入,将s3得到的目标翻译语言语音数据集作为神经网络声码器的监督数据,训练神经网络声码器,从而得到最终生成预测的翻译语音。

19.其中,所述的步骤s1通过网络收集语音数据,源语言语音数据和目标语言语音数据,语音数据按句子进行保存,并用语谱能量评估方法,去除语音句子前后静音,并保证每条语音数据控制在2秒到10秒长度,最后将语音通过ffmpeg软件转换成格式统一的数据集。

20.所述的步骤s3通过网络收集源语言语音数据和对应的目标翻译语言语音数据,源语言语音数据和目标翻译语言语音数据按句子进行保存,并用语谱能量评估方法,去除语

音句子前后静音,并保证每条源语言语音数据和目标翻译语言语音数据控制在2秒到10秒长度,最后将源语言语音数据和目标翻译语言语音数据通过ffmpeg软件转换成格式统一的数据集,其中源语言语音数据集表示为,目标翻译语言语音数据集表示为。

21.实施例1本实施例1网络结构如图3所示,具体操作如下:s1:通过网络收集10000小时以上的源语言(例如中文)语音数据,及10000小时以上的目标语言(例如英语)语音数据,语音数据按句子进行保存,并用语谱能量评估方法,去除语音句子前后静音,并保证每条语音数据控制在2秒到10秒长度,最后将语音通过ffmpeg软件转换成统一的16khz,16bits的.wav格式文件,表示为;s2:通过s1得到的数据集训练wav2vec2.0网络,得到语音表征模型;具体的:所使用的wav2vec2.0的网络为领域内研究人员所知,在具体参数设置上,所用wav2vec2.0在特征提取层采用了7层步长为(5,2,2,2,2,2,2),卷积核宽度为(10,3,3,3,3,2,2)的一维卷积,在编码器层采用了12层的transformer块。

22.s3:通过网络收集1000小时以上的源语言(例如中文)语音数据,及其对应的目标翻译(例如英语)语音数据,语音数据按句子进行保存,并用语谱能量评估方法,去除语音句子前后静音,并保证每条语音数据控制在2秒到10秒长度,最后将语音通过ffmpeg软件转换成统一的16khz,16bits的.wav格式文件,其中源语言语音数据表示为,目标翻译语言语音数据表示为;s4:将s3得到的源语言语音数据,输入到s2得到的,得到源语言语音的深度表征;s5:将s3得到的源语言语音数据,输入到s2得到的,得到源语言语音的深度表征;s6:将s4得到的,作为特征映射网络的输入,s5得到的作为特征映射网络的监督数据,训练特征映射网络,得到预测表征;具体的:特征映射网络由3层单向长短期记忆网络,和注意力网络构成,其中注意力网络集成在第一层长短期记忆网络中,特征映射网络的计算可用以下公式表示:其中,,分别表示第一层,第二层和第三层长短期记忆网络,注意力网络的计算方式如下:其中,为网络维度,这里设置为256,另外,

其中,、、分别表示三个维度为256的全连接层网络的网络权重参数。

23.另外,为经过两层维度为256的全连接网络层处理后的特征,可以表示如下:其中,和分别表示第一层全连接层和第二层全连接层。

24.s7:将s3得到的源语言语音数据,输入到开源的训练好的声纹识别模型(例如百度提出的deepspeeker网络模型,此模型为该领域研究人员所熟知),得到得到发音人的的深度表征;s8:将s6得到的预测表征,和s7得到的发音人特征在时间维度进行拼接,作为神经网络声码器的输入,将s3得到的原始目标语音作为神经网络声码器的监督数据,训练神经网络声码器,从而得到最终生成预测的翻译语音,具体的:s8.1:首先,在时间维度上,将和进行拼接,得到特征;其中,表示拼接函数;s8.2:将s8.1得到的输入到声码器网络中,得到最终合成的翻译语音,可以表示如下:其中表示声码器网络,它由7层步长分别为(2,2,2,2,2,2,5),卷积核宽度为(2,2,3,3,3,3,3,10)的一维反卷积网络构成。

25.以上所述,仅为本发明的优选实施案例,并非对本发明做任何形式上的限制。虽然前文对本发明的实施过程进行了详细说明,对于熟悉本领域的人员来说,其依然可以对前述各实例记载的技术方案进行修改,或者对其中部分技术特征进行同等替换。凡在本发明精神和原则之内所做修改、同等替换等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。