1.本发明涉及自然语言处理技术领域,提出并公布了融入源语言词级信息的汉越低资源跨语言摘要方法。

背景技术:

2.跨语言摘要任务是一种将源语言文档自动理解、归纳和生成目标语言摘要的信息压缩技术。现有的跨语言摘要可以将其分为基于流程化(pipeline)的方法和基于端到端神经网络的方法。基于流程化(pipeline)的方法是将源语言文本翻译到目标语言,然后对翻译后的文本进行摘要;或先对源语言文本进行摘要,然后将源语言摘要翻译到目标语言。然而,目前机器翻译性能仍不能达到预期效果,存在结果错误传播的问题,尤其针对越南语等低资源语言,错误传播更为显著。随着深度学习的发展,基于端到端神经网络的跨语言摘要方法逐渐成为主流的研究方法。目前,基于端到端的跨语言摘要方法主要集中在富资源(high-resourced)和低资源(low-resourced)两种场景下。在富资源场景下,基于transformer并利用大量的跨语言摘要标注语料训练跨语言摘要模型,取得了不错的效果。但这种方法依赖超大规模跨语言摘要标注数据。在低资源场景下,基于机器翻译模型和单语摘要模型,将两者作为教师模型来教授跨语言摘要的学生模型,学生模型模拟教师模型的摘要词分布和注意权重。nguyen提出了一种基于知识蒸馏的跨语言摘要方法,该方法通过教师-学生模型来构建不同语言之间的相关性,将单语摘要教师模型的知识蒸馏到跨语言摘要学生模型中,在一定程度上有效提高了跨语言摘要性能。dou提出了一种端到端的跨语言摘要方法,其核心思想是利用强化学习将生成的目标语言摘要和源语言摘要的语义相似度作为奖励,来指导跨语言摘要的生成。以上方法在一定程度上解决了由于标注的跨语言摘要数据稀缺,较难实现跨语言语义对齐的问题。然而,由于汉语和越南语之间的语言差异较大,上述的模型在汉越跨语言摘要任务上生成的摘要效果不佳。在汉越低资源语言的情况下,模型无法很好的识别原文中重要信息,通常会造成生成的摘要和原文之间的内容偏差问题。因此,本发明提出了融入源语言词级信息的汉越低资源跨语言摘要的方法,通过融入源语言文档的关键信息来改善摘要和原文之间的内容偏差问题。

技术实现要素:

3.本发明提出了融入源语言词级信息的汉越低资源跨语言摘要方法。通过融入源语言词级信息有效的解决了模型无法很好的识别原文中重要信息,生成的摘要和原文之间的内容偏差问题。

4.发明技术方案:融入源语言词级信息的汉越低资源跨语言摘要方法,所述方法的具体步骤如下:

5.step1、语料预处理:进行越南语数据采集,采集到的数据通过预处理得到不同规模的平行训练语料、验证语料和测试语料,用于模型训练、参数调优和效果测试;

6.step2、源语言词级信息提取:提取器对源语言文档的每个词进行一个打分,提取

器首先使用卷积神经网络对每个词进行表征,接着利用循环神经网络对表征后的词进行打分,提取出重要的、关键的词级信息;

7.step3、融入源语言词级信息的汉越跨语言摘要模型构建:将机器翻译和单语摘要任务与跨语言摘要任务联合训练,并将提取器提取出源语言词级信息融入到跨语言摘要的生成过程中,使用step1的语料作为模型输入,产生最终的摘要。

8.作为本发明的进一步方案,所述step1的具体步骤为:

9.step1.1、把越南新闻网站作为数据来源进行越南语数据采集;

10.step1.2、而对应汉语摘要的构建,首先利用谷歌翻译工具将采集到的越南语摘要s

vi

翻译成汉语摘要s

zh

,然后将翻译的结果反向翻译回越南语摘要s0

vi

;处理后的数据对满足rouge-1(s

vi

,s0

vi

)>t1和rouge-2(s

vi

,s0

vi

)>t2,t1设置为0.5,t2设置为0.2;最后,构建伪平行语料对的训练集、伪平行语料对的验证集、伪平行语料对的测试集。

11.作为本发明的进一步方案,所述step2的具体步骤如下:

12.step2.1、提取器的目标是将源语言文本里的词级信息提取出来,即根据每个词对摘要生成的影响,给每个词进行一个权重分配,将一篇源语言文本输入到提取器,首先使用时间卷积神经网络模型得到每个词的表征rj,将每个词的表征rj输入到双向lstm-rnn即lstm-decoder得到每个词进一步的表征hj;然后,提取器添加了另一个lstm-rnn即lstm-decoder来训练指针网络,最终,每个词的得分qi计算如下:

[0013][0014][0015]

其中,公式里e

t

是通过glimpse operation的输出得到的:

[0016][0017][0018][0019]

在公式(3)中,z

t

为lstm-decoder的输出,v

p

、w

p1

、w

p2

、vg、w

g1

、w

g2

均是提取器模型可训练的参数;在每t个时间步,lstm-decoder执行2-hop注意机制:首先通过关注hj获得上下文表征e

t

,然后再次通过关注hj以获得每个词最终的得分,其中,j

t

表示在时间步长t时选择的词,jk表示在时间步长k时选择的词。

[0020]

作为本发明的进一步方案,所述step3的具体步骤如下:

[0021]

step3.1、将越南语源语言文本输入编码器,得到越南语文本的表征;为了使编码器能够识别与摘要最相关的信息,首先,使用提取器来预测输入的源语言文章的每个词成为摘要的概率权重,即每个词的得分qi;然后,在模型的编码器e上附加了一个额外的输出层,它预测了在摘要中包含第i个词的概率pi;为了使提取器提取的源语言词级信息融入到跨语言摘要的生成过程中,采取的策略是最大限度地减少qi和pi之间的差异;对于模型编码器和提取器之间的交互,使用以下损失函数:

[0022][0023]

其中,l表示源语言文章中词的个数;

[0024]

step3.2、解码器的目标是生成中文摘要为了更好的联合训练单语摘要任务和跨语言摘要任务,共享整个解码器d1的参数;具体而言,将源语言摘要和目标语言摘要拼接起来一同输入解码器中:

[0025][0026]

其中,[bos]和[eos]分别是输出摘要的开始和结束标签,[lsep]是将源语言摘要和目标语言摘要区分的分隔符;解码器首先生成源语言摘要y

src

在此基础上,生成目标语言摘要这样,将不同语言摘要之间的关系联系起来,实现知识的转移;使用以下损失函数:

[0027][0028]

在公式(8)中,n和表示源语言摘要中词的个数,n

′

表示目标语言摘要中词的个数,m表示每个样本的编号,表示源语言摘要中第i个词,表示源语言摘要中前i个词(不包括第i个词);表示目标语言摘要中第i个词,表示目标语言语言摘要中前i个词(不包括i个词);

[0029]

step3.3、由于跨语言摘要被认为是一种特殊的机器翻译,机器翻译的信息压缩比是1:1,跨语言摘要的信息压缩比是n:1;所以把机器翻译作为联合训练任务,这样在跨语言摘要生成的过程中,更好的解决“跨”的过程;用构建的源语言摘要和目标语言摘要作为训练编码器e和解码器d2的训练集;使用如下的损失函数:

[0030][0031]

为了更好的利用机器翻译任务来帮助跨语言摘要生成,做了两方面的工作;第一,共享了两个解码器d1和d2的底层参数,顶层参数则分别进行了训练;第二,采用交替训练策略,用固定数量的小批量数据优化每个任务,以联合训练跨语言摘要和机器翻译;

[0032]

step3.4、最终的损失函数如下:

[0033]

l

θ

=l

cls

l

mt

λl

dis

ꢀꢀꢀ

(10)

[0034]

这里,λ是个超参数,在实验里,设置为10,最终的训练目标由两个部分构成;第一,在构建的语料库中抽取一个批次用l

mt

来训练编码器e和解码器d2;第二,在构建的语料库中抽取一个批次利用l

mt

λl

dis

来训练e和解码器d1。

[0035]

本发明的有益效果是:

[0036]

(1)本发明通过融入源语言词级信息,有效的解决了模型无法很好的识别原文中

重要信息,生成的摘要和原文之间的内容偏差问题;

[0037]

(2)通过在互联网上爬取,基于“round-trip translation strategy”策略进行数据去噪,获取了10万对质量较高的越-汉跨语言摘要数据集。

[0038]

(3)改进传统跨语言摘要模型方法。使模型在尽力利用高质量源语言关键信息的同时,削弱噪声数据对模型的负面影响,最终提高低资源场景下的跨语言摘要模型性能,同时生成的跨语言摘要更流畅、更准确、更相关。

附图说明

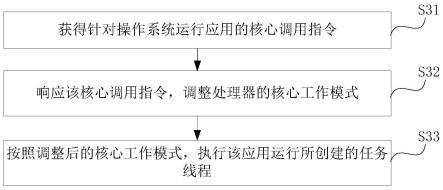

[0039]

图1是本发明提出的融入源语言词级信息的汉越低资源跨语言摘要方法的具体结构示意图。

具体实施方式

[0040]

实施例1:如图1所示,融入源语言词级信息的汉越低资源跨语言摘要方法,step1、语料预处理:进行越南语数据采集,采集到的数据通过预处理得到不同规模的平行训练语料、验证语料和测试语料,用于模型训练、参数调优和效果测试;

[0041]

step2、源语言词级信息提取:提取器对源语言文档的每个词进行一个打分,提取器首先使用卷积神经网络对每个词进行表征,接着利用循环神经网络对表征后的词进行打分,提取出重要的、关键的词级信息;

[0042]

step3、融入源语言词级信息的汉越跨语言摘要模型构建:将机器翻译和单语摘要任务与跨语言摘要任务联合训练,并将提取器提取出源语言词级信息融入到跨语言摘要的生成过程中,使用step1的语料作为模型输入,产生最终的摘要。

[0043]

作为本发明的进一步方案,所述step1的具体步骤为:

[0044]

step1.1、把越南新闻网站作为数据来源进行越南语数据采集;

[0045]

step1.2、而对应汉语摘要的构建,首先利用谷歌翻译工具将采集到的越南语摘要s

vi

翻译成汉语摘要s

zh

(正向翻译),然后将翻译的结果反向翻译回越南语摘要s0

vi

(反向翻译);处理后的数据对满足rouge-1(s

vi

,s0

vi

)>t1和rouge-2(s

vi

,s0

vi

)>t2,t1设置为0.5,t2设置为0.2;最后,构建伪平行语料对的训练集、伪平行语料对的验证集、伪平行语料对的测试集,表1为实验数据信息。

[0046]

表1为越-汉数据集统计结果

[0047][0048]

作为本发明的进一步方案,所述step2的具体步骤如下:

[0049]

step2.1、提取器的目标是将源语言文本里的词级信息提取出来,即根据每个词对

摘要生成的影响,给每个词进行一个权重分配,将一篇源语言文本输入到提取器,首先使用时间卷积神经网络模型得到每个词的表征rj,将每个词的表征rj输入到双向lstm-rnn即lstm-decoder得到每个词进一步的表征hj;然后,提取器添加了另一个lstm-rnn即lstm-decoder来训练指针网络,最终,每个词的得分qi计算如下:

[0050][0051][0052]

其中,公式里e

t

是通过glimpse operation的输出得到的:

[0053][0054][0055][0056]

在公式(3)中,z

t

为lstm-decoder的输出,v

p

、w

p1

、w

p2

、vg、w

g1

、w

g2

均是提取器模型可训练的参数;在每t个时间步,lstm-decoder执行2-hop注意机制:首先通过关注hj获得上下文表征e

t

,然后再次通过关注hj以获得每个词最终的得分,其中,j

t

表示在时间步长t时选择的词,jk表示在时间步长k时选择的词。

[0057]

作为本发明的进一步方案,所述step3的具体步骤如下:

[0058]

step3.1、将越南语源语言文本输入编码器,得到越南语文本的表征;为了使编码器能够识别与摘要最相关的信息,首先,使用提取器来预测输入的源语言文章的每个词成为摘要的概率权重,即每个词的得分qi;然后,在模型的编码器e上附加了一个额外的输出层,它预测了在摘要中包含第i个词的概率pi;为了使提取器提取的源语言词级信息融入到跨语言摘要的生成过程中,采取的策略是最大限度地减少qi和pi之间的差异;对于模型编码器和提取器之间的交互,使用以下损失函数:

[0059][0060]

其中,l表示源语言文章中词的个数;

[0061]

step3.2、解码器的目标是生成中文摘要为了更好的联合训练单语摘要任务和跨语言摘要任务,共享整个解码器d1的参数;具体而言,将源语言摘要和目标语言摘要拼接起来一同输入解码器中:

[0062][0063]

其中,[bos]和[eos]分别是输出摘要的开始和结束标签,[lsep]是将源语言摘要和目标语言摘要区分的分隔符;解码器首先生成源语言摘要y

src

在此基础上,生成目标语言摘要这样,将不同语言摘要之间的关系联系起来,实现知识的转移;使用以下损失函数:

[0064][0065]

在公式(8)中,n和表示源语言摘要中词的个数,n

′

表示目标语言摘要中词的个数,m表示每个样本的编号,表示源语言摘要中第i个词,表示源语言摘要中前i个词(不包括第i个词);表示目标语言摘要中第i个词,表示目标语言语言摘要中前i个词(不包括i个词);

[0066]

step3.3、由于跨语言摘要被认为是一种特殊的机器翻译,机器翻译的信息压缩比是1:1,跨语言摘要的信息压缩比是n:1;所以把机器翻译作为联合训练任务,这样在跨语言摘要生成的过程中,更好的解决“跨”的过程;用构建的源语言摘要和目标语言摘要作为训练编码器e和解码器d2的训练集;使用如下的损失函数:

[0067][0068]

为了更好的利用机器翻译任务来帮助跨语言摘要生成,做了两方面的工作;第一,共享了两个解码器d1和d2的底层参数,顶层参数则分别进行了训练;第二,采用交替训练策略,用固定数量的小批量数据优化每个任务,以联合训练跨语言摘要和机器翻译;

[0069]

step3.4、最终的损失函数如下:

[0070]

l

θ

=l

cls

l

mt

λl

dis

ꢀꢀꢀ

(10)

[0071]

这里,λ是个超参数,在实验里,设置为10,最终的训练目标由两个部分构成;第一,在构建的语料库中抽取一个批次用l

mt

来训练编码器e和解码器d2;第二,在构建的语料库中抽取一个批次利用l

mt

λl

dis

来训练e和解码器d1。

[0072]

为了说明本发明的效果,采用基线系统和本发明的方法进行对比,表2为在本发明构建的语料上的提升结果。

[0073]

表2为不同摘要生成方法实验对比结果

[0074][0075]

从表2可以看出,本发明的方法在rg-1、rg2和rg-l三种评价指标上都明显优于其他基线模型。也表明了通过融入单语关键信息,能更好的抽取原文的核心思想来指导摘要的生成,从而促进模型的性能。首先在自己构建的汉-越跨语言摘要数据集上进行了实验,ours模型与ncls mt模型相比,rg-1提高了15.32,rg-2提高了9.53,rg-l提高了10.43,这表明了本发明提出的模型在在汉越这样的低资源环境下对摘要的生成是有效的。ours模型与mclas模型相比,rg-1提高了8.77,rg-2提高了4.31,rg-l提高了5.10,这表明本发明的模型可以更好的获取原文的核心要义,生成的摘要包含原文更多的核心词汇。为了验证模型的泛化性,在自己构建的100000对汉-越跨语言摘要数据集上的实验表明。本发明的模型与其他的基线模型相比,模型性能得到了大幅度的提升。这也说明了本发明的模型在汉越语言上,对于跨语言摘要生成任务是非常有效的。

[0076]

本发明通过几个不同的消融实验来验证每个模块的有效性,实验结果如表2所示,w/o translating表示去机器翻译联合任务模块,w/o extracting表示去抽取重要句子模块,w/o merging表示去融入单语摘要知识,解码器直接输入目标语言摘要。

[0077]

表3为消融实验结果

[0078][0079]

从表3可以看出,与本发明提出的模型比,所有消融实验的结果都有不同程度的下降,这也表明了每个模块是有效的和必要的。此外,值得注意的是,在三个消融实验中,w/o merging模型性能下降最为严重,rg-1、rg-2和rg-l三个指标分别下降了14.43、9.17和9.99。这表明了联合单语摘要任务,并共享整个解码器的参数对于跨语言摘要的生成起着至关重要的作用,解码器可以更好的将不同语言摘要之间的关系联系起来,实现了知识的迁移。对于机器翻译联合任务模块,w/o translating模型的rg-1、rg-2和rg-l三个指标分别下降了6.05、2.31和3.30,这说明了通过与机器翻译联合训练,能有效的帮助跨语言摘要的生成。而对于抽取源语言词级信息模块,w/o extracting模型的rg-1、rg-2和rg-l三个指标分别下降了5.68、2.26和3.73,可能的原因是抽取源语言词级信息模块能更好的建模抽取器和编码器之间复杂的交互关系,能够帮助模型更好的理解源语言文章中重要信息。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。