1.本发明涉及计算机视觉和服务型移动机械臂智能抓取领域,特别是涉及一种应用于无人化生物检测实验室场景下移动机械臂的分步式抓取检测方法。

背景技术:

2.随着全球新冠肺炎疫情爆发和不断地反复,生物科学领域获得了全世界研究学者的特别关注。由于需要大量的人工实验和海量的数据分析,较低的自动化渗透率成为限制该行业发挥更大效能的主要因素。机械臂作为自动化关键领域,目前正处于快速发展的爬坡阶段。为了适应卫生安全等领域的不同工作要求,机械臂必须变得越来越智能。其中服务型移动机械臂能否自主完成智能抓取任务被赋予了更高的期望,成为各方关注的重点问题。如何将服务型移动机械臂在医疗服务领域完成推广,利用更多的服务型移动机械臂去代替人工,完成各项复杂的生物实验任务成为了亟待解决的问题。无人化生物检测实验室项目也就应运而生。利用机器代人不但可以缩短检测时间,还可以提高安全系数,避免对医护人员造成接触感染。

3.为了能够在无人化生物检测实验室此类现实中无训练场景下进行良好的移动任务和抓取操作,服务型移动机器人应具备以下功能:(1)对复杂场景内的各类物体都有所感知,并且要求这个感知实时性能要好,对静止和移动的物体都有良好的识别能力。(2)针对感受野内所有的物体计算抓取位姿,同时区分开场景内固有物体和待操作物体,只对感兴趣的物体进行抓取操作。(3)在不稳定的动态环境中依然可以正常工作,此类环境主要包括:外界光线的强弱变化,工作空间场景不断变化、传感器受噪声及误差影响、机器人自身的扰动和控制不精确的影响。

技术实现要素:

4.为了克服上述已有技术的缺陷,解决无人化生物检测实验室服务型移动机械臂面临的物体抓取和操作等问题。本发明的目的是,提出一种应用于服务型移动机械臂的分步式识别抓取检测方法。通过下述技术方案实现:

5.步骤s1,依据无人化生物检测检测实验室常见仪器,分别构建目标检测和抓取检测的数据集,其中用于目标检测数据集以彩色图像为主,抓取检测的数据集以深度图像为主。

6.步骤s2,构建抓取检测神经网络,设计的全卷积抓取检测算法(gdfcn)是一种以单张物体深度图像作为神经网络输入,用于在深度图像上实时生成抓取位姿

7.步骤s3,利用优化过后的yolo v5s目标检测算法分析预处理过后的rgb图像,识别待抓取物体并完成分类的同时排除场景内的不应该被操作的固有物体,输出边界框信息。

8.步骤s4,利用边界框的映射将目标识别算法(yolov5)和全卷积抓取检测算法(gdfcn)进行结合与改进,提出一种适用于无训练场景下陌生物体的机械臂实时抓取检测算法。

9.进一步地,所述步骤s1的具体过程如下:

10.s1-1,利用借助python脚本在各类搜索引擎图片库中获取目标图像和第二种方式基于无人化生物实验室真实场景进行人工拍摄,采用单一拍摄和组合拍摄相结合的方式。

11.s1-2,根据人类通常的抓取经验在数据集待抓取目标上标注可以抓取的区域,在这个区域内所有的点都是可抓取点,包含相同的抓取角度和宽度。每个抓点都对应一种菱形抓取表示。此外增加了抓取置信度表示来执行抓取的概率。

12.s1-3,针对无人化生物检测实验室下常用的实验器材进行拍摄。将实验器材预定义共分为20个类别。采用labelimg完成标注工作。对于数据集进行yolo格式的标注。

13.进一步地,所述步骤s2的具体过程如下:

14.s2-1,为了保证物体深度信息的可应用性,必须先对深度图像进行填充修复。

15.s2-2,gdfcn评估将进行修复处理和裁剪缩放之后的深度图像输入到gdfcn神经网络模型之中。同时使用高斯滤波器对抓取置信度进行过滤处理和预处理操作。

16.s2-3,通过gdfcn对深度图像上的评估,产生的动态抓取效果热力图grasp map。将最佳抓取点在ros系统下以topic的形式进行发布。

17.进一步地,所述步骤s3的具体过程如下:

18.s3-1,为了满足本发明要求移动机械臂抓取系统实时性能好,可以满足动态抓取的特点,尝试多种的识别检测算法,通过准确度和处理帧率的比较,选出适合本发明方法应用的最优算法yolov5s。

19.s3-2,利用深度相机完成对场景内物体信息的实时采集。为了避免场景内噪声的干扰,使用相应的滤波算法完成预处理工作。进而进行缩放剪裁处理,满足yolov5s目标检测算法的输入要求。

20.s3-3,利用目标检测算法完成场景内目标物体的识别与分类,同时移除场景内无法抓取的固有物体。

21.进一步地,所述步骤s4的具体过程如下:

22.s4-1,利用深度相机完成对场景内物体视觉信息的实时采集。为了避免场景内噪声的干扰,完成预处理。进而进行缩放剪裁处理,满足yolo v5s目标检测算法的输入要求。

23.s4-2,利用优化过后的yolo v5s目标检测算法分析预处理过后的rgb图像,识别待抓取物体的同时排除场景内的不应该被机器人操作的固有物体,直接生成边界框信息,包括边界框两角的坐标信息,从而确定识别框高度宽度和中心位置。

24.s4-3,通过ros控制系统下的service模块选择待抓取目标的种类,如果没有出现待抓取目标,则直接对整张深度图像完成抓取检测,选择置信度最高的抓取点,执行抓取任务,完成对其余物体的去除工作,直到目标物体出现在视野中。

25.s4-4,利用二阶段目标检测的结果将边界框的位置信息映射到深度图像之上。利用映射的复选框为深度图像重新建立约束,通过目标检测标签,如果约束中只包含感兴趣的对象,标记为正确边界框,进行裁剪操作,生成过滤后的局部深度图像。

26.s4-5,对局部深度图像进行填充,将过滤后的局部深度图像的尺寸统一为256

×

256像素。进而输入到训练后的网络之中,在局部深度图像上迅速产生像素级的的抓取位姿预测,主要包括抓取置信度,以及抓取点的像素坐标,夹持器旋转角度和抓取宽度。

27.为克服单一抓取检测不能区分场景内固有物体和可操作物体的缺陷,本文方法首

先采用yolo v5执行目标检测,然后将目标识别框映射下的局部深度图像输入进轻量级的全卷积神经网络中,将可行的机器人抓取表示为菱形抓取,形成一种新的分步式级联抓取算法。

28.本发明的优点:

29.本发明方法对比已有技术,能够辅助机械臂实现更快速稳定的识别和抓取操作,在满足实时性的要求下,可以有效的完成物体分类任务,并增强了抓取检测的稳定性和准确度。

附图说明

30.图1为gdfcn上采样阶段网络示意图

31.图2为gdfcn抓取检测神经网络下采样阶段示意图

32.图3为神经网络采用的跳级连接策略

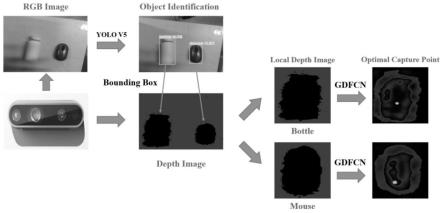

33.图4为分步式视觉检测算法工作原理图

34.图5为仿真环境下的抓握流程图

35.图6为真实场景下基于该方法的抓取流程图

具体实施方式

36.为了更好的理解上述技术方案,下面将结合说明书附图以及仿真环境和真实场景下具体的实施方式对上述技术方案进行详细的说明。

37.步骤s1,依据无人化生物检测实验室常见仪器,利用三维传感器构建目标检测和抓取检测的数据集,前者以彩色图像为主,后者以深度图像为主。

38.步骤s2,构建如图1和图2所示抓取检测神经网络,设计的全卷积抓取检测算法(gdfcn)是一种以单张物体深度图像作为神经网络输入,用于在深度图像上实时生成抓取位姿,采用图3所示的跳级连接策略。

39.步骤s3,利用优化过后的yolo v5s目标检测算法分析预处理过后的rgb图像,识别待抓取物体并完成分类的同时排除场景内的不应该被操作的固有物体,输出边界框信息。

40.步骤s4,利用边界框的映射将目标识别算法(yolov5)和全卷积抓取检测算法(gdfcn)进行结合与改进,提出一种适用于无训练场景下陌生物体的机械臂实时抓取检测算法。

41.进一步地,所述步骤s1的具体过程如下:

42.s1-1,借助python脚本在各类搜索引擎图片库中获取目标图像以及基于无人化生物实验室真实场景进行人工拍摄,采用单一拍摄和组合拍摄相结合的方式。

43.s1-2,根据人类通常的抓取经验在数据集待抓取目标上标注可以抓取的区域,区域内所有的点都是可抓取点,拥有相同的抓取角度和宽度。每个抓点都对应一种菱形抓取表示。此外增加了抓取置信度表示来执行抓取的概率。

44.s1-3,针对无人化生物检测实验室下常用的实验器材进行拍摄。将实验器材预定义共分为20个类别。由于数据集很大,为了节省效率,采用labelimg完成标注工作。对于数据集进行yolo格式的标注

45.进一步地,所述步骤s2的具体过程如下:

46.s2-1,为了保证物体深度信息的可应用性,必须先对深度图像进行填充修复。

47.s2-2,gdfcn评估将进行修复处理和裁剪缩放之后的深度图像输入到gdfcn神经网络模型之中。同时使用高斯滤波器对抓取置信度进行过滤处理。作为一种线性滤波方式,其核心思想是借助高斯二维分步函数作为滤波器中的模板系数,进行预处理操作。

48.s2-3,通过gdfcn对深度图像上的评估,产生的动态抓取效果热力图grasp map。

49.进一步地,所述步骤s3的具体过程如下:

50.s3-1,为了满足本发明要求移动机械臂抓取系统实时性能好,可以满足动态抓取的特点,尝试了很多种的识别检测算法,通过准确度和处理帧率的比较,选出适合本发明应用的最优算法yolov5s。

51.s3-2,利用深度相机完成对场景内物体信息的实时采集。为了避免场景内噪声的干扰,使用相应的滤波算法完成预处理工作。进而进行缩放剪裁处理,满足yolov5s目标检测算法的输入要求。

52.s3-3,利用目标检测算法完成场景内目标物体的识别与分类。

53.进一步地,所述步骤s4分步式级联抓取检测算法的整体工作流程如图4所示,具体过程如下:

54.s4-1,利用深度相机完成对场景内物体视觉信息的实时采集。为了避免场景内噪声的干扰,完成预处理。进而进行缩放剪裁处理,满足yolo v5s目标检测算法的输入要求。

55.s4-2,利用优化过后的yolo v5s目标检测算法分析预处理过后的rgb图像,识别待抓取物体的同时排除场景内的不应该被机器人操作的固有物体。生成边界框信息,包括边界框两角的坐标信息,从而确定识别框高度宽度和中心位置。

56.s4-3,通过ros控制系统下的service模块选择待抓取目标的种类,选择置信度最高的抓取点,执行抓取任务,完成对其余物体的去除工作,直到目标物体出现在视野中。仿真环境下的操作流程如图5所示。

57.s4-4,利用二阶段目标检测的结果将边界框的位置信息映射到深度图像之上。利用映射的复选框为深度图像重新建立约束,通过目标检测标签,标记目标边界框,进行裁剪操作,生成过滤后的局部深度图像。

58.s4-5,对局部深度图像进行填充,将过滤后的局部深度图像的尺寸统一为256

×

256像素。进而输入到训练后的网络之中,在局部深度图像上迅速产生像素级的的抓取位姿预测,主要包括抓取置信度,以及抓取点的像素坐标,夹持器旋转角度和抓取宽度。红色的部分代表抓取置信度较高的峰值点,绿色圆点代表通过gdfcn网络模型评估出来的最佳抓取点,该像素点的抓取置信度最高。

59.s4-6,在ros系统中以topic的形式输出该点的位置信息,以及对应的抓取角度和宽度,作为图像空间下的最佳抓取位姿,用于后续机械臂抓取任务。整体机械臂抓取流程如图6所示。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。