1.本发明涉及稀疏群智感知用户招募方法技术领域,特别是一种基于强化学习的稀疏群智感知在线用户招募方法。

背景技术:

2.稀疏群智感知旨在招募用户来收集部分子区域的感知数据,并推断剩余子区域的感知数据,这具有广泛的应用,包括环境感知和交通监测等。现有的技术方案通常以离线方式招募用户,缺点是依赖于提前知道或准确预测用户的轨迹,无法在用户轨迹出现偏差时做出调整,从而可能错过一些重要子区域的数据。另外,现有的技术方案无法依据物理世界的一些不确定性因素(例如,用户轨迹的不确定性)自适应地分割预算,从而进行意外追偿。

技术实现要素:

3.有鉴于此,本发明的目的在于提供一种基于强化学习的稀疏群智感知在线用户招募方法,实现自适应预算分割,并在预算和时间限制下获得一个近似最优的用户集合。

4.为实现上述目的,本发明采用如下技术方案:一种基于强化学习的稀疏群智感知在线用户招募方法,包括以下步骤:

5.步骤s1:划分目标感知区域,获取历史感知数据;

6.步骤s2:构建用户的历史轨迹数据;

7.步骤s3:利用强化学习构建用户招募模型和预算保留模型;

8.步骤s4:利用历史数据训练用户招募模型和预算保留模型;

9.步骤s5:利用预算保留模型判断是否在当前周期保留预算,若判断为“是”,则等待下一个周期到来再重复步骤s5,否则,跳转至步骤s6;

10.步骤s6:利用用户招募模型招募贡献大的一个用户,支付其相应的报酬后回到步骤s5;

11.步骤s7:重复步骤s5和s6,直到预算不足或所有周期结束;

12.步骤s8:利用招募到的用户收集部分感知数据,结合推断算法推断完整的数据。

13.在一较佳的实施例中:所述步骤s1中划分目标感知区域,获取历史感知数据的操作过程为:

14.步骤s101:将完整目标感知区域利用网格法划分,划分为m个子区域;

15.步骤s102:连接历史感知数据库,获取m个子区域中的历史感知数据。

16.在一较佳的实施例中:所述步骤s2中构建用户的历史轨迹数据的操作过程为:

17.步骤s201:连接并读取原始的gps轨迹数据库,获取所有候选用户的历史gps轨迹;

18.步骤s202:将所有候选用户的历史gps轨迹转变为位置点轨迹;

19.步骤s203:将所有位置点轨迹转化为向量表示,作为用户最终的历史轨迹;其中,如果位置点在步骤s1划分的m个子区域范围内,则用相应的子区域编号表示,否则,用-1表示;最后,得到所有候选用户的历史轨迹数据。

20.在一较佳的实施例中:所述步骤s3中利用强化学习构建用户招募模型和预算保留模型的具体实现过程为:

21.步骤s301:构建基于强化学习的用户招募模型,包括建模状态、动作和奖励;其中,用户招募模型的状态sr:包含多种影响用户招募模型执行下一个动作的因素,具体包括历史招募情况、当前招募情况、子区域覆盖情况、当前任务时段属于星期几和当前任务时段五种因素;用户招募模型的动作ar:表示下一个被招募的用户;用户招募模型的奖励rr:表示招募某一个用户后对当前任务时段数据推断精度的影响程度,奖励的计算公式如下:

[0022][0023]

其中,和分别是招募一个用户之前和之后的数据推断误差;

[0024]

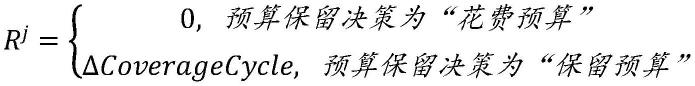

步骤s302:构建基于强化学习的预算保留模型,包括建模状态、动作和奖励;其中,预算保留模型的状态sj:包含多种影响预算保留模型执行下一个动作的因素,具体包括周期覆盖情况、剩余预算百分比、当前任务时段属于星期几和当前剩余时间四种因素;预算保留模型的动作aj:表示是否保留预算至下一个周期;预算保留模型的奖励rj:表示执行预算保留决策后对当前招募的影响程度,奖励的计算公式如下:

[0025][0026]

式中,δcoveragecycle表示保留预算至下一个周期后,该周期招募到的用户相比上一个周期的周期覆盖增量。

[0027]

在一较佳的实施例中:所述步骤s4中训练用户招募模型和预算保留模型的具体实现过程为:

[0028]

步骤s401:利用历史数据,使用dqn算法来训练用户招募模型和预算保留模型,dqn算法通过学习一个两层的全连接神经网络来估计每个状态-动作对的q值q(s,a):

[0029][0030]

其中,r是在状态s下执行动作a所获得的奖励;动作a

′

是使用贪婪法在当前状态s所对应q值中选择的对应动作,s

′

是执行完动作a

′

所产生的状态s

′

,γ是折现因子,表示dqn算法对未来奖励的短视;是综合奖励的期望;

[0031]

步骤s402:根据各状态因素的特点,混合多种方式对用户招募模型的状态进行编码,其中,历史招募情况和当前招募情况表示为用户编号的排列组合,每个用户编号用二进制编码,子区域覆盖情况通过统计被招募的用户历史上覆盖每个子区域的次数,以统计结果作为编码,当前任务时段属于星期几和当前任务时段用二进制编码;

[0032]

步骤s403:根据各状态因素的特点,混合多种方式对预算保留模型的状态进行编码,其中,周期覆盖情况通过统计被招募的用户历史上覆盖每个周期的次数,以统计结果作为编码,剩余预算百分比、当前任务时段属于星期几和当前任务时段用二进制编码;

[0033]

步骤s404:分别将编码后的状态输入用户招募模型和预算保留模型,使用随机梯

度下降算法来学习它们各自最佳的模型参数,损失函数l(θ

t

)为:

[0034][0035]

在一较佳的实施例中:所述步骤s8中利用推断算法推断完整的数据的具体实现过程为:

[0036]

步骤s801:通过招募到的用户收集部分感知数据,得到不完整的感知矩阵e

′

;

[0037]

步骤s802:对于不完整的感知矩阵e

′

,利用低秩性来得到推断矩阵

[0038][0039]

由于上述非凸优化问题难以求解,进而通过奇异值分解,创建近似矩阵在某些条件下,最小化的秩等价于最小化从而可将上式调整为:

[0040][0041]

进一步加入时空约束,从而更好地捕捉感知数据中的时空相关性:

[0042][0043]

式中,λ

t

和λs分别为时间权重和空间权重;为时间约束矩阵,控制同一感知区域不同时刻的数据相关性;为空间约束矩阵,控制同一时刻不同感知区域的数据相关性,|| ||f为frobenius范数;

[0044]

步骤s803:利用交替最小二乘法对l和r进行迭代,得到即推断的完整数据,式中l和r是步骤s802中近似矩阵的奇异值分解结果。

[0045]

与现有技术相比,本发明具有以下有益效果:

[0046]

本发明提供的是一种基于强化学习的稀疏群智感知在线用户招募方法,主要用于求解具有时空约束、预算限制以及时间限制的稀疏群智感知任务中的在线用户招募问题。该问题要求在任务预算和时间限制内,动态地求解一个近似最优的用户集合,来收集部分子区域的感知数据,并推断剩余子区域的感知数据,使得数据推断误差最小。该问题本质上是一种在不知道用户未来轨迹的情况下的在线用户招募方法。该方法通过利用用户历史轨迹数据和感知数据离线训练招募模型,实际使用时则能够以在线的方式招募一组近似最优的用户,在预算和时间限制下完成具有时空限制的稀疏群智感知任务。

附图说明

[0047]

图1为本发明优选实施例的方法流程示意图。

具体实施方式

[0048]

下面结合附图及实施例对本发明做进一步说明。

[0049]

应该指出,以下详细说明都是例示性的,旨在对本技术提供进一步的说明。除非另有指明,本文使用的所有技术和科学术语具有与本技术所属技术领域的普通技术人员通常理解的相同含义。

[0050]

需要注意的是,这里所使用的术语仅是为了描述具体实施方式,而非意图限制根据本技术的示例性实施方式;如在这里所使用的,除非上下文另外明确指出,否则单数形式也意图包括复数形式,此外,还应当理解的是,当在本说明书中使用术语“包含”和/或“包括”时,其指明存在特征、步骤、操作、器件、组件和/或它们的组合。

[0051]

一种基于强化学习的稀疏群智感知在线用户招募方法,如图1所示,包括以下步骤:

[0052]

步骤s1:划分目标感知区域,获取历史感知数据;

[0053]

步骤s2:构建用户的历史轨迹数据;

[0054]

步骤s3:利用强化学习构建用户招募模型和预算保留模型;

[0055]

步骤s4:利用历史数据训练用户招募模型和预算保留模型;

[0056]

步骤s5:利用预算保留模型判断是否在当前周期保留预算,若判断为“是”,则等待下一个周期到来再重复步骤s5,否则,跳转至步骤s6;

[0057]

步骤s6:利用用户招募模型招募可能贡献最大的一个用户,支付其相应的报酬后回到步骤s5;

[0058]

步骤s7:重复步骤s5和s6,直到预算不足或所有周期结束;

[0059]

步骤s8:利用招募到的用户收集部分感知数据,结合推断算法推断完整的数据。

[0060]

在本实施例中,步骤s1中构建用户与目标点的覆盖关系集合的操作过程为:

[0061]

步骤s101:将完整目标感知区域利用网格法划分,划分为m个子区域;

[0062]

步骤s102:连接历史感知数据库,获取m个子区域中的历史感知数据。

[0063]

在本实施例中,所述步骤s2中构建用户的历史轨迹数据的操作过程为:

[0064]

步骤s201:连接并读取原始的gps轨迹数据库,获取所有候选用户的历史gps轨迹;

[0065]

步骤s202:将所有候选用户的历史gps轨迹转变为位置点轨迹;

[0066]

步骤s203:将所有位置点轨迹转化为向量表示,作为用户最终的历史轨迹。其中,如果位置点在步骤s1划分的m个子区域范围内,则用相应的子区域编号表示,否则,用-1表示。最后,得到所有候选用户的历史轨迹数据。

[0067]

在本实施例中,所述步骤s3中利用强化学习构建用户招募模型和预算保留模型的具体实现过程为:

[0068]

步骤s301:构建基于强化学习的用户招募模型,包括建模状态、动作和奖励。其中,用户招募模型的状态sr:包含多种影响用户招募模型执行下一个动作的因素,包括历史招募情况、当前招募情况、子区域覆盖情况、当前任务时段属于星期几和当前任务时段五种因素;用户招募模型的动作ar:表示下一个被招募的用户;用户招募模型的奖励rr:表示招募了某一个用户后对当前任务时段数据推断精度的影响程度,奖励的计算公式如下:

[0069][0070]

其中,和分别是招募一个用户之前和之后的数据推断误差。

[0071]

步骤s302:构建基于强化学习预算保留模型,包括建模状态、动作和奖励。其中,预算保留模型的状态sj:包含多种影响预算保留模型执行下一个动作的因素,包括周期覆盖

情况、剩余预算百分比、当前任务时段属于星期几和当前剩余时间四种因素;预算保留模型的动作aj:表示是否保留预算至下一个周期;预算保留模型的奖励rj:表示执行了预算保留决策后对当前招募的影响程度,奖励的计算公式如下:

[0072][0073]

式中,δcoveragecycle表示保留预算至下一个周期后,该周期招募到的用户相比上一个周期的周期覆盖增量。

[0074]

在本实施例中,所述步骤s4中训练用户招募模型和预算保留模型的具体实现过程为:

[0075]

步骤s401:利用历史数据,使用deep q-network(dqn)算法来训练用户招募模型和预算保留模型,dqn通过学习一个两层的全连接神经网络来估计每个状态-动作对的q值:

[0076][0077]

其中,r是在状态s下执行动作a所获得的奖励;动作a

′

是使用贪婪法在当前状态s所对应q值中选择的对应动作,s

′

是执行完动作a

′

所产生的状态s

′

,γ是折现因子,表示dqn算法对未来奖励的短视;e是综合奖励的期望。

[0078]

步骤s402:根据各状态因素的特点,混合多种方式对用户招募模型的状态进行编码,其中,历史招募情况和当前招募情况表示为用户编号的排列组合,每个用户编号用二进制编码,子区域覆盖情况通过统计被招募的用户历史上覆盖每个子区域的次数,以统计结果作为编码,当前任务时段属于星期几和当前任务时段用二进制编码;

[0079]

步骤s403:根据各状态因素的特点,混合多种方式对预算保留模型的状态进行编码,其中,周期覆盖情况通过统计被招募的用户历史上覆盖每个周期的次数,以统计结果作为编码,剩余预算百分比、当前任务时段属于星期几和当前任务时段用二进制编码;

[0080]

步骤s404:分别将编码后的状态输入用户招募模型和预算保留模型,使用随机梯度下降算法来学习它们各自最佳的模型参数,损失函数为:

[0081][0082]

所述步骤s8中利用推断算法推断完整的数据的具体实现过程为:

[0083]

步骤s801:通过招募到的用户收集部分感知数据,得到不完整的感知矩阵e

′

。

[0084]

步骤s802:对于不完整的感知矩阵e

′

,利用低秩性来得到推断矩阵

[0085][0086]

由于上述非凸优化问题难以求解,进而通过奇异值分解,创建近似矩阵在某些条件下,最小化的秩等价于最小化从而可将上式调整为:

[0087][0088]

进一步加入时空约束,从而更好地捕捉感知数据中的时空相关性:

[0089][0090]

式中,λ

t

和λs分别为时间权重和空间权重。为时间约束矩阵,控制同一感知区域不同时刻的数据相关性。为空间约束矩阵,控制同一时刻不同感知区域的数据相关性,|| ||f为frobenius范数。

[0091]

步骤s803:利用交替最小二乘法对l和r进行迭代,得到即推断的完整数据,式中l和r是步骤s802中近似矩阵的奇异值分解结果。

[0092]

以上所述仅为本发明的较佳实施例,凡依本发明申请专利范围所做的均等变化与修饰,皆应属本发明的涵盖范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。