1.本发明属多源遥感匹配技术领域,具体涉及一种基于多源影像匹配的无人机视觉定位方法。

背景技术:

2.无人机定位通常使用卫星导航来实现,然而作为一种被动的信号接收方式,导航信号在特殊场景下容易被干扰。当失去信号时,随着时间的推移,惯性测量单元的累积误差会越来越大。计算机视觉通过计算机系统对视觉信息进行处理、分析,实现对目标的检测、识别、跟踪、定位等功能,具有较强的抗干扰能力。因此,基于视觉匹配的无人机定位可以很好地解决卫星拒止条件下的无人机定位问题。

3.无人机视觉定位方法大致分为三种:无地图定位方法(如视觉里程法)、基于构建地图的定位方法(如同步定位与构图方法)和基于已有地图的定位方法(如影像匹配方法)。这三种视觉定位方法各有优缺点和适用范围:基于构建地图和无地图定位的方法只需要安装在uav(unmanned aerial vehicle,无人驾驶空中飞行器)上的摄像头,但帧间运动的估计误差会严重累积;基于影像匹配方法需要额外的预先记录的地理参考图像库,但可以获得uav的绝对位置,且不会累积误差。

4.基于影像匹配方法主要分为传统方法和深度学习方法。传统方法基于人工设计的描述符提取特征来实现遥感影像匹配,主要通过描述符相似性和/或空间几何关系来寻求局部特征(区域、线、点)之间的对应关系。局部显著特征的使用使这类方法可以快速运行,并且对噪声、复杂的几何变形和显著的辐射度差异具有鲁棒性。但是,由于更高分辨率和更大尺寸数据的普及,方法无法满足更多对应性、更高准确性和更灵活应用的要求。随着大量的标记数据集的提出,深度学习方法,特别是卷积神经网络(cnn),在图像匹配领域取得了非常好的效果。cnn的主要优点是其在标签数据的引导下,能够自动学习有利于影像匹配的特征。与人工设计的描述符相比,基于深度学习的特征不仅包含低级空间信息,还包含高级语义信息。由于强大的自动提取特征的能力,深度学习方法能获得较高的匹配准确率。

5.尽管基于影像匹配的无人机视觉定位方法具有显著的优势,但仍有一些问题需要解决:首先,带有地理信息的参考图像和无人机图像成像条件不同,而这种多源影像匹配存在异质性问题;另外,难以利用少量的标注数据适应丰富多样的应用场景;最后,无人机的平台也对实时性提出了严苛的要求。

技术实现要素:

6.为了克服现有技术的不足,本发明提供一种基于多源影像匹配的无人机视觉定位方法。首先,分别利用已有的多源匹配图像和真实无人机场景影像对特征提取网络进行训练;然后,利用训练好的网络对无人机影像进行特征提取,并利用位置点信息对无人机进行位置估计,减小定位搜索范围;接着,对估计位置范围内的卫星图像进行特征提取,并利用相似性度量对无人机影像与卫星图像进行特征匹配,得到无人机定位结果。本发明能够较

好地解决卫星图像与无人机影像之间的异质性匹配问题,可用于多种应用场景,且计算量小,能够较好地满足无人机平台的实时性定位需求。

7.一种基于多源影像匹配的无人机视觉定位方法,其特征在于步骤如下:

8.步骤1:采用google earth pro上采集的卫星和虚拟无人机匹配图像对用于特征提取的孪生网络进行训练,保存网络参数;利用带标签的真实场景无人机起飞位置影像对网络进行再训练,得到训练好的适应现实无人机工作场景的特征提取网络;所述的用于特征提取的孪生网络包括顺序连接的卷积层1、最大池化层1、卷积层2、最大池化层2、卷积层3、卷积层4、卷积层5、最大池化层3、卷积层6和卷积层7,其中,卷积层1的卷积核大小为7

×7×

24,步长为1,卷积层2的卷积核大小为5

×5×

24,步长为1,卷积层3和卷积层4的卷积核大小为3

×3×

96,步长为1,卷积层5的卷积核大小为3

×3×

64,步长为1,卷积层6的卷积核大小为3

×3×

128,步长为1,卷积层7的卷积核大小为8

×8×

128,步长为1,最大池化层1和最大池化层2的核大小为3

×

3,最大池化层3的核大小为6

×

6;

9.步骤2:将无人机影像在横向和纵向分别均匀切成三份,形成九宫格,将每一小格下采样到128

×

128,并利用步骤1训练好的网络进行特征提取,提取的9个特征共同构成整张无人机图像的描述i'k;

10.步骤3:取无人机当前时刻最近的前n个定位位置点进行位置估计,根据这些位置点所处的经纬度和每两个位置点之间的飞行时长,分别计算无人机在经纬两个方向的n-1个位置区间内的飞行速度,记在经度方向的n-1个位置区间内的飞行速度序列为v

long

,在纬度方向的n-1个位置区间内的飞行速度序列为v

lat

,将无人机的运动轨迹视为匀速运动,序列v

long

和v

lat

内的速度均值服从t分布,在经度或纬度方向上的速度范围为其中,和s

*2

分别代表经度或纬度方向速度的均值和方差,α是t分布的置信度参数,t

α/2

(n-2)表示在置信度为1-α的情况下利用n-1个采样区间的t分布侧分位数,通过查t分布表得到,n的取值范围为3~6,α的取值为0.005;初始时刻的前n个定位位置点利用起飞位置进行初始化;

11.以速度范围乘以当前时刻与上述第n个位置点飞行时刻的时间差,得到在该时段内的位移范围,如果得到的位移范围小于20m,保留其为20m,再与第n个位置点的坐标相加,得到无人机当前所处的位置范围;

12.步骤4:对步骤3得到的位置范围内的卫星图像每10m进行一次切割,每次将卫星图像在横向和纵向分别均匀切成三份,形成九宫格,将每一小格下采样到128

×

128,并利用步骤1训练好的网络进行特征提取,将提取的每张卫星图像的9个特征及其位置标签放入待匹配库;

13.步骤5:遍历待匹配库,计算每张卫星图像的9个特征与步骤2得到的无人机图像上九宫格对应位置的特征之间的l2范数,以得到的9个l2范数值的和作为整张图像的相似性度量值,如此待匹配库中每张卫星图像得到一个与无人机图像的相似性度量值,将相似性度量值最小的卫星图像的位置标签作为当前无人机定位结果;如果最小的两个相似性度量值之差大于阈值β,认为当前定位结果可信,将当前无人机定位结果作为一个定位位置点;所述的阈值β的取值为0.25;

14.步骤6:重复执行步骤2到步骤5,直到视觉导航飞行任务结束。

15.本发明的有益效果是:由于采用虚拟数据集图像和真实场景图像对网络分别进行训练的方式,使网络能够更好地用于提取全局高阶语义特征,解决多源图像之间存在的异质性问题;由于采用位置估计方法,能够有效的缩小匹配搜索范围,提高定位的精度的同时保证系统的实时性。

附图说明

16.图1是本发明基于多源影像匹配的无人机视觉定位方法流程图;

17.图2是本发明位置估计流程图;

18.图3是采用本发明方法在西北工业大学长安校区进行无人机视觉定位的结果图像。

具体实施方式

19.下面结合附图和实施例对本发明进一步说明,本发明包括但不仅限于下述实施例。

20.如图1所示,本发明提供了一种基于多源影像匹配的无人机视觉定位方法,其具体实现过程如下:

21.步骤1:采用google earth pro上采集的卫星和虚拟无人机匹配图像对用于特征提取的孪生网络进行训练,保存网络参数;利用带标签的真实场景无人机起飞位置影像对网络进行再训练,得到训练好的适应现实无人机工作场景的特征提取网络;所述的用于特征提取的孪生网络的具体结构如表1所示,其中,conv表示卷积层名称,pooling表示池化层名称,c代表卷积操作,mp代表最大池化操作。

22.表1

23.结构类型输出尺寸核尺寸步幅conv1c128

×

128

×

247

×7×

241pooling1mp64

×

64

×

243

×

32conv2c64

×

64

×

645

×5×

241pooling2mp32

×

32

×

643

×

32conv3c32

×

32

×

963

×3×

961conv4c32

×

32

×

963

×3×

961conv5c32

×

32

×

643

×3×

641pooling3mp8

×8×

646

×

64conv6c8

×8×

1283

×3×

1281conv7c1

×1×

1288

×8×

1281

24.步骤2:将无人机影像在横向和纵向分别均匀切成三份,形成九宫格,将每一小格下采样到128

×

128,并利用步骤1训练好的网络进行特征提取,提取的9个特征共同构成整张无人机图像的描述i'k。

25.步骤3:取无人机当前时刻最近的前n个可信的定位位置点进行位置估计(无人机在放飞位置默认已知该区域的位置信息,可以在起飞位置直接初始化最早的n个位置点,后期将通过飞行匹配不断迭代更新这n个可信的位置点),根据这些位置点所处的经纬度和每

两个位置点之间的飞行时长分别计算无人机在经纬两个方向的n-1个位置区间内的飞行速度,记在经度方向的n-1个位置区间内的飞行速度序列为v

long

,在纬度方向的n-1个位置区间内的飞行速度序列为v

lat

,将无人机的运动轨迹视为匀速运动,序列v

long

和v

lat

内的速度均值服从t分布,在经度或纬度方向上的速度范围为其中,和s

*2

分别代表经度或纬度方向速度的均值和方差,α是t分布的置信度参数,t

α/2

(n-2)表示在置信度为1-α的情况下利用n-1个采样区间的t分布侧分位数,通过查t分布表得到,n的取值范围为3~6,α的取值为0.005;

26.以速度范围乘以当前时刻与上述第n个位置点飞行时刻的时间差,得到在该时段内的位移范围,当得到的位移范围值小于20m时,保留其值为20m,再与第n个位置点的坐标相加,得到无人机当前所处的位置范围;

27.上述位置估计过程如图2所示。

28.步骤4:对步骤3得到的位置范围内的卫星图像每10m进行一次切割,每次将卫星图像在横向和纵向分别均匀切成三份,形成九宫格,将每一小格下采样到128

×

128,并利用步骤1训练好的网络进行特征提取,将提取的每张卫星图像的9个特征及其位置标签放入待匹配库。

29.步骤5:遍历待匹配库,计算每张卫星图像的9个特征与步骤2得到的无人机图像上九宫格对应位置的特征之间的l2范数,以得到的9个l2范数值的和作为整张图像的相似性度量值,如此待匹配库中每张卫星图像得到一个与无人机图像的相似性度量值,将相似性度量值最小的卫星图像的位置标签作为当前无人机定位结果。如果最小的两个相似性度量值之差大于阈值β,则认为当前匹配结果有较高的可信度,在序列末尾加入更新步骤3所述的n个可信的定位位置;所述的阈值β的取值为0.25。

30.步骤6:重复执行步骤2到步骤5,直到视觉导航飞行任务结束。

31.为验证本发明方法的有效性,在中央处理器为e5-2680 v4 2.40ghz cpu、内存64g、显卡nvidia rtx 3090,ubuntu16.04操作系统上,基于pytorch1.7.1、python3.8.5语言环境进行仿真实验。以google earth pro软件的3d建模功能构建虚拟数据中洛杉矶的中心部分作为实验区域,面积为4942

×

3408m2。区域内有典型的城市景观,有连栋房屋、街道和车辆,并且在郊区也较为空旷。以此获得无人机仿真影像。对于转化好的航空图像和切割好的卫星图片,利用各个图片的坐标标记图片的位置,生成两种异源图像的匹配对,虚拟数据共10000张。同时利用航拍获得无人机真实影像,并进行人工标注,生成对应匹配的卫星图像。真实数据各个场景共600对样本,同时模拟实际的应用场景,对一段长距离的无人机视频进行标注,时长4分钟,飞行距离2公里,无人机飞行高度为170m,视频质量为1920x1080,每秒30帧。

32.使用随机梯度下降法stochastic gradient descent(sgd)作为优化器来优化网络参数,优化器sgd的参数为:学习率0.01,冲量为0.9,共学习50个epoch。虚拟数据训练阶段每隔20个epoch学习率减小10倍,微调阶段取30张影像通过旋转进行数据增强,学习率不变。

33.表2给出了分别采用google earth pro制作的虚拟数据和真实航拍数据对网络进

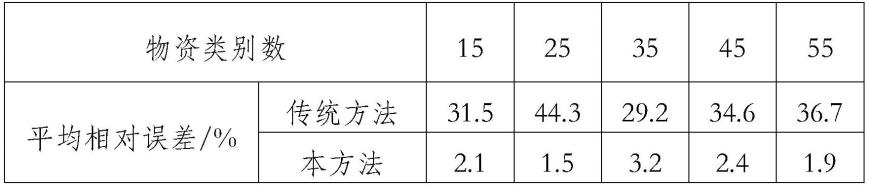

行训练后得到的匹配精度计算结果。可以看出,在虚拟数据上进行训练后网络已经具备了初步的异源匹配能力,但是直接迁移到真实数据上效果较低,只有36.4%;网络模型经过在真实数据再训练微调之后,匹配效果得到了显著的提升,在真实数据上的表现有了大幅度的提升,达到61.5%。表3给出了加入对图像进行九宫格切割处理后的计算结果。可以看出,加入九宫格之后各个阶段的测试精度都有了显著的提高。图3给出了该方法在西北工业大学长安校区进行视觉定位的结果图像,图中,灰色实心位置点代表实际飞行位置,白色空心为支点表示该位置视觉定位结果。可以看出,视觉定位的结果基本在真实位置的周围,具备较好的定位精度。

34.表2

[0035] 虚拟数据训练虚拟数据训练 真实数据微调后虚拟数据测试66.3%48.7%真实数据测试36.4%61.5%

[0036]

表3

[0037] 虚拟数据训练后测试虚拟数据训练 真实数据微调后测试不采用9宫格66.3%61.5%采用9宫格75.4%69.7%

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。