1.本发明属于人工智能技术领域,尤其涉及一种基于联合学习的个人信用模型维护方法、装置和电子设备。

背景技术:

2.信用评分在金融等各领域是一个非常重要指标,尤其是个人信用。目前如果要查询个人的信用,需要到指定的部门经个人授权才能查询;或者,其他机构如果想要了解用户个人的信用,往往都是根据自己指定的规则来进行评价和判断。因此,在实际中会出现不同的机构对于个人信用评价各不相同,或者需要用户自己去申请信用报告等情况。

3.由此可见,是否有方法能够使不同企业对于相同客户的个人信用的评分能够尽可能的一致和准确,这是目前本领域的一个技术难题。

技术实现要素:

4.有鉴于此,本发明实施例提供了一种基于联合学习的个人信用模型维护方法、装置和电子设备,以解决如何利用人工智能技术来实现个人信用进行评估的问题。

5.本发明实施例的第一方面,提供了一种基于联合学习的个人信用模型维护方法,其包括步骤:s01:初始化全局模型;s02:随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务;s03:将全局模型分别发送给加入训练任务的k个设备;s04:接收k个设备利用自身数据训练模型后上传的局部模型;s05:聚合局部模型,并更新全局模型。

6.在一些可选方案中,在上述步骤s05之后,还包括步骤:基于迭代循环步骤s02-s05创建用于对个人信息进行评估的个人信用模型,并发送所述个人信用模型至各个参与联合学习的设备中进行个人信息评估维护。

7.在一些可选方案中,所述随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务,包括:确定参与到当前轮训练任务中设备的数量k;判断数量k是否小于所有设备的数据m:若是,则基于对所有设备的排列顺序,从m个设备中循环选择k个设备加入当前轮的训练任务中;若否,则将所有设备加入当前轮的训练任务中。

8.在一些可选方案中,所述确定参与到当前轮训练任务中设备的数量k,包括:根据服务器当前的网络承载能力确定参与到当前轮训练任务中设备的数量k;或者,根据服务器的最大计算能力确定参与到当前轮训练任务中设备的数量k。

9.在一些可选方案中,所述随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务,包括:获取所有参与联合学习的设备中所拥有的数据集大小;根据所述数据集大小对所有参与联合学习的设备进行分类,并对所述分类中依次循环选择一个分类对应的设备加入到当前轮次的训练任务。

10.在一些可选方案中,所述接收k个设备利用自身数据训练模型后上传的局部模型,包括:检测局部模型目录;判断k个设备中是否有设备产生新的局部模型;若有,则接收所述局部模型;若无,则返回检测局部模型目录。

11.在一些可选方案中,所述聚合局部模型,并更新全局模型,具体包括:基于所述新上传的全局模型与前次聚合后的全局模型进行聚合计算,并更新全局模型。

12.本发明实施例的第二方面,提供了一种基于联合学习的个人信用模型维护装置,其包括:模型初始化模块,用于初始化全局模型;设备数据选择模块,用于随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务;全局模型发送模块,用于将全局模型分别发送给加入训练任务的k个设备;局部模型接收模块,用于接收k个设备利用自身数据训练模型后上传的局部模型;全局模型更新模块,用于聚合局部模型,并更新全局模型。

13.本发明实施例的第三方面,提供了一种终端设备,包括存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现如上述第一方面中所述方法的步骤。

14.本发明实施例的第四方面提供了一种存储介质,所述存储介质存储有计算机程序,所述计算机程序被处理器执行时实现如上述第一方面中所述方法的步骤。

15.本发明实施例与现有技术相比存在的有益效果是:本发明利用联合学习的方法来解决了目前一些结构无法基于自己拥有的数据来建立对个人信用评估的人工智能模型的问题,实现了在保护个人隐私的情况下,为更多的机构提供了实现个人信用评估的便捷性和准确性。

附图说明

16.为了更清楚地说明本发明实施例中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其它的附图。

17.图1是可以应用本发明以下实施例的一个联合学习架构;

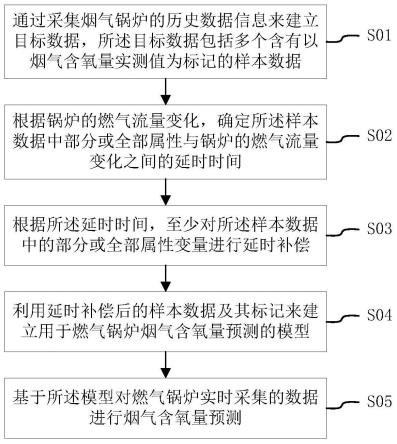

18.图2是本发明在实施例一提供的基于联合学习的个人信用模型维护方法流程图;

19.图3是本发明在实施例二提供的基于联合学习的个人信用模型维护装置的结构图。

具体实施方式

20.以下描述中,为了说明而不是为了限定,提出了诸如特定系统结构、技术之类的具体细节,以便透彻理解本发明实施例。然而,本领域的技术人员应当清楚,在没有这些具体细节的其它实施例中也可以实现本发明。在其它情况中,省略对众所周知的系统、装置、电路以及方法的详细说明,以免不必要的细节妨碍本发明的描述。

21.图1为可以应用本发明以下实施例的一个联合学习架构,如图1所示,在该联合学习架构中,包括:服务器101和多个客户端102、103、104,所述多个客户端102、103、104分别与服务器通信连接。其中,服务器101是联合学习中的信任中心,因此也被称为中央服务器;客户端102、103、104是联合学习中的数据持有方,因此也被称为数据节点或客户机等。

22.一般的,联合学习中客户端的数量可以为k个,k≥2,且为正整数,例如,图1中的client-1、client-2

…

client-k。当然,客户端越多,意味着数据越多,数据多更利于训练模型的准确性;同时,如果客户端太多,则也有可能会超出服务器的负荷能力,容易出现通信

阻塞或计算速度下降等问题。

23.具体的,所述客户端可以具体包括但不限于计算机、服务器、工作站等电子设备。示例性的,所述电子设备,可以具体包括:存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,当所述处理器执行所述计算机程序时,实现如下列实施例一中任一完整方法的步骤。

24.其中,所述存储器可以为一种存储介质,例如,所述提供一种存储介质,所述存储介质存储有计算机程序,所述计算机程序被处理器执行时,实现如下列实施例一中任一完整方法的步骤。

25.所述联合学习架构用于允许多个用户协作训练共享的全局模型,而无需分享本地设备中的数据,由中央服务器协调完成多轮联合学习以得到最终的全局模型。其中,在每一轮开始时,中央服务器将当前的全局模型发送给参与联合学习的客户机;每个客户机根据其本地数据训练所接收到的全局模型,训练完毕后将更新后的模型返回中央服务器;中央服务器收集到所有客户机返回的更新后,对全局模型进行一次更新,进而完成一轮更新。

26.由于联合学习可以在不共享自己数据的情况下,联合其他用户的数据来训练机器学习模型,从而提升模型的准确度。至此,本发明在以下实施例中将联合学习方法应用于个人信用模型的训练,以解决当前用户在不同机构的信用评分存在巨大差异,导致很多机构对用户的个人信用作出准确评估,从而影响用户在该机构的业务办理。

27.实施例一

28.图2为本发明在实施例一提供的基于联合学习的个人信用模型维护方法流程图。

29.结合图2所示,所述基于联合学习的个人信用模型维护方法,包括以下步骤s01-s05。

30.s01:初始化全局模型。

31.在任务开启时,服务器进行全局模型初始化,然后将初始化后的全局模型下发给参与联合学习的客户端。需要说明的是,在联合学习过程中,服务器向客户端下发的全局模型,或者,客户端下载的全局模型,是全局模型的参数。例如,模型的平均梯度等参数;而客户端上次的局部模型,也同样为局部模型的参数。

32.考虑到现有联合学习中,对于全局模型的初始化是由服务器在开启任务前,根据每个参与联合学习的客户端中安装的算法模型、数据结构等进行衡量之后统一进行的参数初始化。由于这种初始化全局模型是在全部参与方完成接入的情况下进行的,在面对系统异构的情况下,初始化的效率往往不高。为此,在一个示例一中,针对步骤s01,还可以具体包括:在任务开始时,将第一个加入任务的模型初始化为全局模型。这样不用考虑所有参与方完成接入后再进行全局模型的初始化,可以有效提升全局模型初始化的效率,同时也可以避免在系统异构下由于个别客户端出现异常中央服务器无法正常初始化全局模型的情况。

33.s02:随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务。

34.在联合学习每一轮训练开始前,通过随机选择与服务器连接的设备(即客户端,下文也一样)加入每轮的训练任务中来执行联合学习。例如,与服务器连接的客户端有m个,那么可以从这m个客户端中选择k个客户端加入到当前轮的训练任务中,显然,m≥k≥2,m、k都属于正整数。由此可见,在每一轮的训练任务中,加入训练任务的设备可能都不一样,这样

做的目的在于可以根据平衡服务器的承载能力,防止由于参与联合学习的设备过多导致全局模型出现阻塞的问题。

35.在一个示例二中,步骤s02,可以具体包括:

36.步骤s211:确定参与到当前轮训练任务中设备的数量k;

37.步骤s212:判断数量k是否小于所有设备的数据m:

38.步骤s213:若是,则基于对所有设备的排列顺序,从m个设备中循环选择k个设备加入当前轮的训练任务中;

39.步骤s214:若否,则将所有设备加入当前轮的训练任务中。

40.其中,确定参与到当前轮训练任务中设备的数量k,可以具体是根据服务器当前的网络承载能力或者最大计算能力来确定加入训练任务的设备数量k。

41.具体的,假设所有设备的数量m=10个,即连接于服务器参与联合学习的客户端有10个,对所有设备的排序顺序为1、2、3、4、5、6、7、8、9、10。此时,假设确定加入当前轮训练任务的设备数据k=4个,那么可以按照1234、2345、5678、6789、78910、10123

……

顺序依次循环选择4个设备加入每一轮训练任务进行联合学习。

42.本示例既可以保证参与联合学习任务的客户端不会导致网络阻塞,同时也能够使所有客户端中的数据都参与到联合学习中。

43.此外,由于数据异构的原因,不同的设备所拥有的数据集的大小,即用于训练模型的数据数量。如果在依次轮询中的两个设备的数据数量差异较大,那么会导致局部模型上传时间差异过大,从而导致全局模型更新效率较低,从而拉低整个联合学习的效率。

44.在一个示例三中,步骤s02,可以具体包括:

45.步骤s221,获取所有参与联合学习的设备中所拥有的数据集大小;

46.步骤s222,根据所述数据集大小对所有参与联合学习的设备进行分类,并对所述分类中依次循环选择一个分类对应的设备加入到当前轮次的训练任务。

47.具体的,设备拥有的数据集大小一般各不相同,假设参与联合学习的设备有10个,其中每个设备的数据数量为2、4、6、7、9、11、15、25、5、6千个。由此,可以按照一个预设范围来对这些数据进行分类,例如0-5000为第一类,5000-10000为第二类,10000-15000为第三类,15000-20000为第四类,20000-25000为第五类,以此类推。那么,前述设备拥有的数据可以划分为4个分类,其中,第一类包括数据数量2、4、5千个对应的3个设备,第二类包括数据数量6、6、7、9千个对应的4个设备,第三类包括11、15千个对应的2个设备,还有第五类包括数据数量25千个对应的1个设备。因此,在每一轮训练任务中,循环选择其中一个分类对应的设备加入训练任务。例如,在第一轮训练任务中选择第一类包括的3个设备;在第二轮训练任务中选择第二类包括的4个设备;在第三轮训练任务中选择第三类包括的2个设备;在第四轮训练任务中选择第五类包括的1个设备;在第五轮训练任务中选择第一类包括的3个设备

……

,如此循环选择下去,直至完成联合训练为止。

48.本示例三通过上述方法即保证了所有设备都能够参与到联合学习中,同时也可以保证每一轮训练任务的效率最优。

49.s03:将全局模型分别发送给加入训练任务的k个设备。

50.加入训练任务的设备将利用自身拥有的数据对该模型进行训练,然后得新的局部模型,之后再将该局部模型上传至服务器中进行聚合,来更新全局模型。

51.s04:接收k个设备利用自身数据训练模型后上传的局部模型。

52.具体的,本步骤s04,可以具体包括:

53.步骤s411:检测局部模型目录;

54.步骤s412:判断k个设备中是否有设备产生新的局部模型;

55.步骤s413:若有,则接收所述局部模型。

56.步骤s414:若无,则返回检测局部模型目录。

57.其中,在训练任务过程中,客户端有可能因为异常中断或退出本轮的训练任务。因此,通过检查局部模型目录,可以确定当前参与联合学习的客户端的情况,从而判断是否有新的局部模型上传。

58.再结合3所示,在判断是否产生新的局部模型之后,如果没有检查到新的局部模型上传,则返回步骤s411,继续检测。相反,则进入下列步骤s05。

59.s05:聚合局部模型,并更新全局模型。

60.具体的,聚合局部模型,可以采用联合平均方法,即对所有上传的局部模型进行计算平均值,例如,对所有局部模型的梯度参数去均值。

61.此外,考虑到系统异构的因素,为了保证全局模型的更新效率,聚合局部模型还可以采用异步联合平均的方法。

62.在一个示例四中,步骤s05,可以具体包括:

63.步骤s511:基于所述新上传的全局模型与前次聚合后的全局模型进行聚合计算,并更新全局模型。

64.其中,本示例中的聚合计算,同样可以采用平均局部模型和前次聚合的全局模型来进行本次聚合更新。本示例不需要等所有的设备上传完局部模型才进行聚合来更新全局模型,只要有局部模型上传就更新全局模型,利用这种异步更新全局模型的方法,可以进一步提高全局模型更新的效率。

65.需要说明的是,在异步计算全局模型的情况下,虽然异步聚合了多次,但都属于同一轮训练任务,只有等所有的设备都上传完局部设备并进行聚合之后,在进行入下一轮训练任务。此外,通过循环迭代上述步骤s02-s05直到创建完成个人信用模型为止。当利用以上联合学习方法创建得到个人信用模型之后,参与联合学习的设备将下载所述个人信用模型进行个人信用评估维护。

66.应理解,上述实施例中各步骤的序号的大小并不意味着执行顺序的先后,各过程的执行顺序应以其功能和内在逻辑确定,而不应对本发明实施例的实施过程构成任何限定。

67.实施例二

68.在同一发明构思,本实施例还提供了一种基于联合学习的个人信用模型维护装置。

69.请参见图3,为本发明在实施例二提供的基于联合学习的个人信用模型维护装置的结构图。如图3所示,该于联合学习的个人信用模型维护装置300,具体包括:模型初始化模块301,用于初始化全局模型;设备数据选择模块302,用于随机从所有接入的设备中选择k个子设备参与到当前轮的训练任务;全局模型发送模块303,用于将全局模型分别发送给加入训练任务的k个设备;局部模型接收模块304,用于接收k个设备利用自身数据训练模型

后上传的局部模型;全局模型更新模块305,用于聚合局部模型,并更新全局模型。

70.以上所述实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。