1.本发明涉及表情自动识别技术领域,涉及一种表情识别算法,具体涉及一种基于注意力调制上下文空间信息的表情识别方法。

背景技术:

2.面部表情具有丰富的特征信息,人脸表情识别在人机交互、心理健康评估等方面得到了广泛的应用。传统的表情识别方法可以分为两类,一类是基于面部动作单元(action unit,au)的表情识别方法,通常将人脸表情识别(facial expression recognition,fer)任务转化为au检测任务,au是与表情相关的微小但可辨别的肌肉动作,然而使用该方法难以检测人脸的局部变化,而且光照或姿势变化等因素也会降低au检测的性能;另一类是通过人工设计特征来表征人脸图像并训练表情分类器来实现表情识别。然而,在自然场景中,受不可控因素的影响,基于人工设计特征的人脸表情识别方法性能有限。近年来,基于深度学习的人脸表情识别成为研究的热点,相关工作已经从受控的实验室场景转向自然场景,并取得了一定的进展。卷积神经网络(convolutional neural network,cnn)是表情识别的主流模型,cnn在表情识别任务中具有很强的泛化性。其后出现了各种改进方法。在这些方法中,一方面,为了解决表情特征不完备的问题,zhao z等人设计了一种对称结构来学习残差块中的多尺度特征,在粒度级别上保留人脸表情信息;li y等人提出了滑动块(slide-patch,sp),在每个特征图上进行窗口滑动,提取面部表情的全局特征;fan x等人提出了一种分层尺度卷积神经网络(hierarchical scale net,hsnet)用于人脸表情识别,其中添加了膨胀起始块来增强核尺度信息提取。liang x等人采用双分支网络进行表情识别,其中一个分支利用cnn捕捉局部边缘信息,另一个分支应用视觉transformer来获得更好的全局表示;毛君宇等人提出使用大小不同的卷积核组成金字塔卷积单元提取表情特征,提高模型的非线性表达能力。然而,上述方法通过增加辅助网络层或采用分支结构的方式来改善所提取表情特征的完备性,另一方面,为了解决表情类间分类边界模糊的问题,xie s等人提出了一个名为显著表情区域描述(salient expressional region descriptor,serd)的模块,突出与表情相关的显著特征,提高特征表征能力;gera d等人提出一种新的空间通道注意网络(spatio-channel attention net,scan)获得每个通道及每个空间位置的局部和全局注意,在空间和通道维度上处理表情特征,而不是直接进行特征降维压缩;wang z等人采用类似于u-net的体系结构设计了一个注意力分支,用于突出细微的局部表情信息。宋玉琴等在提取多尺度特征之后使用cbam注意力机制对表情特征进行筛选,提升有效表情特征的表达。上述方法通过增加网络辅助层或使用分支结构的方式来提取更细微的深层人脸表情特征,从而使模型性能得到提升。然而,这些方法忽略了人脸局部区域间潜在的上下文关系,而且复杂的网络结构不利于模型轻量化。

3.中国专利文献(申请号:202010537198.2)公开了一种基于深度残差网络的人脸表情识别方法,首先通过深度残差网络模型对放大的人脸表情图像进行多尺度特征提取,然后对提取的特征进行降维压缩处理,将处理后的特征用于表情分类。该方法存在三个缺陷:

①

在残差网络中使用具有固定感受野的标准卷积核,无法获取广泛的人脸表情信息;

②

通过降维压缩特征方案去除冗余信息的同时丢失了部分与表情相关的重要信息;

③

在实验室受控数据集上表现良好,但在非受控数据集上的识别性能有待验证。以上几点致使该方法所提取表情特征的完备性受限,特征的表征能力还有待提高。

4.中国专利文献(申请号:202110133950.1)公开了一种基于表征流嵌入网络的动态表情识别方法及系统,在卷积神经网络中嵌入可微分的表征流层从视频序列中提取动态表情特征,并使用空间注意力权重对输出特征进行加权。该方法有两个缺陷:

①

仅使用了空间注意力,没有从通道维度上进行特征优选;

②

涉及视频数据的采集和处理,工作步骤复杂,导致操作成本较高。

5.现有方法存在以下不足:1)在特征提取阶段,仅考虑人脸表情全局或局部特征,致使特征完备性受限;2)在特征处理阶段,对特征进行降维压缩,导致类间分类边界模糊。

技术实现要素:

6.本发明提供一种基于注意力调制上下文空间信息的表情识别方法,提出了一种新的自然场景人脸表情识别模型,称为注意力调制上下文空间信息(attention-modulated contextual spatial information,acsi)模型,利用上下文卷积替换残差网络中的标准卷积,构建上下文卷积残差网络coresnet18和coresnet50用于提取多尺度特征,在不增加网络复杂度的情况下获得更细微的表情信息;在coresnet中的每个残差块内嵌入协调注意力以关注显著特征,增强输入特征图中与表情相关的有用信息和抑制冗余信息,有效降低深层卷积对人脸遮挡和姿势变化的敏感性。

7.为了解决上述技术问题,本发明采用的技术方案是:该基于注意力调制上下文空间信息的表情识别方法,具体包括以下步骤:

8.s1:获取待训练的自然场景人脸表情图像公共数据集,对人脸表情图像进行预处理;

9.s2:构建用于自然场景人脸表情识别的注意力调制上下文空间信息网络模型;

10.s3:利用预处理过的人脸表情图像对上下文空间信息(acsi)网络模型进行训练;

11.s4:重复步骤s3的模型训练,直至达到设定的训练次数,得到训练后的深度残差网络模型,利用训练后的深度残差网络模型进行人脸表情识别。

12.采用上述技术方案,构建了基于注意力调制上下文空间信息的表情识别模型该模型,首先使用具有较低膨胀率的卷积核捕获局部上下文信息,其次使用具有较高膨胀率的卷积核合并全局上下文信息,提取人脸的辨别性局部特征和相关性全局特征,保证表情特征信息的互补性,最后使用协调注意力机制为提取的特征分配注意力权重,增大表情类间特征差异,强化特征表征能力,在affectnet-7和raf_db数据集上进行实验,验证了acsi模型的有效性,且与同类模型相比,所提模型具有更好的识别性能。

13.作为本发明的优选技术方案,所述步骤s2具体包括以下步骤:

14.s21:利用上下文卷积块替换残差块的中间卷积层,形成上下文卷积残差模块构建上下文卷积残差网络;

15.s22:使用协调注意力(coordinate attention,ca)构建协调注意力模块对coresnet提取的多尺度特征分配注意力权重以强化特征表征能力。

16.采用上述技术方案,首先,利用上下文卷积替换卷积残差块中的标准卷积,构建上下文卷积残差网络(coresnet)作为特征提取部分,以不同膨胀率大小的卷积核捕获局部和合并全局上下文信息;其次,将协调注意力模块嵌入coresnet作为特征处理部分,为所提取特征分配注意权重,突出显著特征,增大表情类间特征差异,最终构成acsi模型用于人脸表情识别。

17.作为本发明的优选技术方案,所述步骤s21具体为:

18.s211:上下文卷积块接收输入特征图m

in

,其在不同层级l={1,2,3,...,n}应用具有不同膨胀率的卷积核d={d1,d2,d3,...,dn},即leveli(leveli表示上下文卷积块中第i个级别的上下文卷积)上的卷积核具有膨胀率

19.s212:在不同上下文卷积的级别level上,上下文卷积均输出多个特征图对于所有i∈l,每个图具有宽度w

out

和高度h

out

;

20.s213:保持残差结构将层间的相关性结合起来,得到上下文卷积残差模块;

21.s214:根据特征图的尺寸调整每层中上下文卷积块的级别(level),从而构建上下文卷积残差网络。所述步骤s2中构建的上下文卷积残差网络(coresnet)包括coresnet18和coresnet50;在coresnet18中,每个上下文残差模块由一个上下文卷积残差模块和一个构成1*1标准卷积层构成;在coresnet50中,每个上下文残差模块由一个上下文卷积残差模块和两个1*1标准卷积层构成;上下文卷积残差模块用于多尺度特征提取,1*1标准卷积层用于通道变换;根据输入特征图的尺寸,在每个上下文残差模块使用不同级别的上下文卷积块。在第一个上下文卷积残差模块使用级别为4(level=4)的上下文卷积块,第一个上下文卷积残差模块中level=3,第三个上下文卷积残差模块中level=2,最后一个上下文卷积残差模块中level=1。这里,当level=n时,上下文卷积块中有膨胀率大小di=i,i=1,

…

,n-1,n的卷积核。

22.作为本发明的优选技术方案,所述步骤s21中上下文卷积的可学习参数和浮点运算的数量采用公式(1)和(2)进行计算;

23.params=m

in

·kw

·

kh·mout

ꢀꢀ

(1);

24.flops=m

in

·

kh·kw

·mout

·wout

·hout

ꢀꢀ

(2);

25.其中,m

in

和m

out

表示输入和输出特征映射的数量,kw和kh表示卷积核的宽度和高度,最后,w

out

和h

out

表示输出特征映射的宽度和高度。

26.作为本发明的优选技术方案,所述步骤s22具体为:

27.s221:将coresnet提取的特征记为x,首先使用尺寸(h,1)和(1,w)的平均池化核沿着水平坐标方向和竖直坐标方向对每个通道进行编码,高度为h的第c个通道的编码输出由公式(3)计算:

[0028][0029]

其中,(h,1)和(1,w)分别表示沿着水平坐标方向和竖直坐标方向所用池化核的尺寸;h表示沿着水平坐标方向所用平均池化核的高度;w表示沿着竖直坐标方向所用平均池化核的宽度;在数值上,h和w也等于输入特征图的高度和宽度;该公式(3)计算水平坐标方

向上高度为h时的第c个通道的编码输出,沿宽度i,对输入特征进行求和运算;

[0030]

宽度为w的第c个通道的编码输出由公式(4)计算:

[0031][0032]

该公式(4)计算竖直坐标方向上高度为w时的第c个通道的编码输出,沿高度j,0≤j≤h对输入特征进行求和运算;

[0033]

s222:将步骤s221中的两个变换沿着两个空间方向进行特征聚合,返回一对方向感知注意力图;

[0034]

s223:将所述步骤s222中生成的一对方向感知注意力图连接起来,将其送入一个1

×

1的卷积变换函数f中;

[0035]

f=δ(f([yh,yw]))

ꢀꢀ

(5);

[0036]

其中,[,]表示沿着空间维度的拼接操作,δ为非线性的sigmoid激活函数,f∈r

c/r

×

(h w)

为水平方向和垂直方向对空间信息进行编码的中间特征映射;为了降低模型的复杂性,采用适当的减小率r来减少f的通道数;

[0037]

s224:继续沿着空间维把f分解成两个单独的张量fh∈r

c/r

×h和fw∈r

c/r

×w,对其使用两个1

×

1卷积变换fh和fw将fh和fw分别变换为相同通道数的张量,采用公式(6)和(7);

[0038]

mh=δ(fh(fh))

ꢀꢀ

(6);

[0039]mw

=δ(fw(fw))

ꢀꢀ

(7);

[0040]

其中,δ为sigmoid函数,输出的mh和mw作为注意力权值,最后协调注意力模块的输出z,由公式(8)所示:

[0041][0042]

其中zc(i,j)为输出,xc(i,j)为输入,和为注意力权值。

[0043]

采用上述技术方案,是为了关注显著特征和增强表情类间特征差异,从而采用协调注意力机制,在上下文卷积残差网络中嵌入协调注意力模块(ca)进行特征处理,以实现对输入特征图中表情相关信息的增强和冗余信息的抑制。在网络中嵌入协调注意力,可以沿着一个空间方向捕获输入特征间的远程依赖性,并在另一个空间方向上保留表情相关人脸区域的位置信息,然后将得到的特征图编码成一对方向感知和位置敏感的注意力图,将其应用于输入特征图以增强细微的表情信息;在每个上下文卷积块和coresnet后添加ca模块,筛选关键尺度特征和强调显著人脸区域以增强特征表征能力,从而提高识别性能。

[0044]

作为本发明的优选技术方案,所述步骤s1具体为:首先将输入图像尺寸调整为256

×

256,然后对其进行上下左右以及中心的裁剪,获得五张224

×

224的人脸图像,它们拥有相同的表情标签,再以0.5的概率对其进行随机水平翻转。

[0045]

作为本发明的优选技术方案,所述步骤s3的具体步骤为:

[0046]

s31:通过上下文卷积残差网络(coresnet)对输入的人脸表情图像进行多尺度特征提取和上下文空间信息整合;

[0047]

s32:在每个上下文卷积残差模块中嵌入注意力模块以关注显著尺度特征,对coresnet输出特征使用协调注意力对提取的特征进行注意力加权,分别在两个空间方向上

捕捉到表情信息的相关性和保留精确的人脸关键区域信息;

[0048]

s33:将注意力加权后的特征进行下采样操作,对下采样后的特征进行分类处理。

[0049]

作为本发明的优选技术方案,所述步骤s3中的上下文空间信息网络模型(acsi)包括依次相连的卷积层、bn层、relu层、maxpool层、四个上下文残差模块、协调注意力(ca)模块、全局平均池化层、fc层和softmax分类层;所述卷积层将输入的人脸表情图像经过3*3标准卷积操作提取特征;bn层对提取的特征进行批量归一化防止梯度消失或爆炸;然后所述relu层对其进行非线性激活;最大池化层用于特征降维;四个上下文卷积模块用于从降维的特征中提取到多尺度的人脸特征;嵌入上下文卷积模块的协调注意力(ca)模块用于关注不同尺度的特征;所述coresnet输出特征层后的ca模块对输出特征进行注意力加权;全局平均池化层和fc层进行下采样操作,下采样后的人脸表情特征再经过softmax分类器进行分类。

[0050]

作为本发明的优选技术方案,所述softmax分类器的输入的是一个任意实数的向量,输出的是一个向量,其中每个元素的取值在(0,1)之间,且其和为1,设有一个数组,其softmax的计算公式为式(9):

[0051][0052]

其中,xi表示第i个元素,softmax(xi)表示softmax的取值中为第i个元素的输出值,i为元素个数,即分类的类别个数;通过softmax函数就可以将多分类的输出值转换为范围在[0,1]且其和为1的概率分布。

[0053]

作为本发明的优选技术方案,所述步骤s3中在利用人脸表情数据集对注意力调制上下文空间信息网络模型(acsi)训练前,采用超过1000万数据的大型人脸数据集ms-celeb-1m(包含近10万个受试者的1000万张人脸图像)作为训练集,预先训练了acsi,然后分别将人脸表情数据集affectnet-7和raf_db输入预训练后的acsi模型中,经过前向传播得到输出值(预测类别概率),根据输出值采用交叉熵损失函数计算acsi模型的损失值;交叉熵损失函数计算公式为式(10)所示:

[0054][0055]

其中,p(x)是指真实的类别概率,q(x)是模型的预测类别概率;

[0056]

所述步骤s4根据式(10)计算得到的acsi模型的损失值进行反向传播更新网络权值,重复训练,直至达到设定的训练次数时结束训练,得到训练好的注意力调制上下文空间信息网络模型acsi模型。

[0057]

与现有技术相比,本发明基于注意力调制上下文空间信息的表情识别方法具有的有益效果:

[0058]

(1)利用具有不同膨胀率大小的卷积核组成的上下文卷积块替换残差网络中的部分卷积层,在多个网络层上访问人脸图像的上下文空间信息,提取更鲁棒的多尺度表情特征,同时保持与同等大小的标准卷积层相似的参数量和计算成本;

[0059]

(2)使用了一种新的注意力机制,即协调注意力,它可以沿一个空间方向捕获辨别

性局部特征间的依赖关系,同时沿另一个空间方向保留关键人脸区域的精确位置信息,从而以降低深层网络对遮挡和姿势变化的敏感性,强化特征表征能力;

[0060]

(3)在两个大型自然环境人脸表情图像数据集上验证了所构建的模型在非受控环境下进行人脸表情识别的有效性和可靠性。

附图说明

[0061]

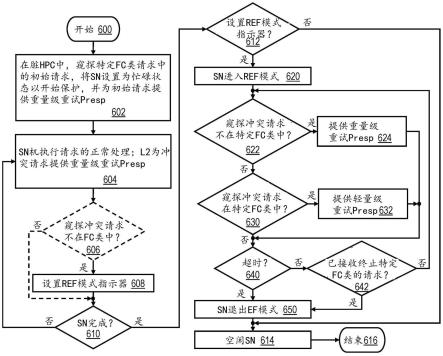

图1是本发明基于注意力调制上下文空间信息的表情识别方法的流程图;

[0062]

图2是本发明基于注意力调制上下文空间信息的表情识别方法中的注意力协调上下文空间信息网络(acsi)模型框图;

[0063]

图3是本发明基于注意力调制上下文空间信息的表情识别方法中的上下文卷积块示意图;

[0064]

图4是本发明基于注意力调制上下文空间信息的表情识别方法中的协调注意力模块结构示意图;

[0065]

图5是基线方法和acsi50模型在affectnet-7数据集上提取特征的t-sne可视化结果;其中(a)是基线方法在affectnet-7数据集上提取特征的t-sne可视化示意图;(b)是acsi50模型在affectnet-7数据集上提取特征的t-sne可视化示意图;

[0066]

图6是本发明基于注意力调制上下文空间信息的表情识别方法中的基线方法和acsi50模型在raf-db上提取特征的t-sne可视化结果;其中(a)是基线方法在在raf-db上提取特征的t-sne可视化示意图;(b)是acsi50模型在在raf-db上提取特征的t-sne可视化结果示意图;

[0067]

图7是本发明基于注意力调制上下文空间信息的表情识别方法中的raf_db数据集中示例表情图像上的注意力可视化结果示意图。

具体实施方式

[0068]

下面将结合本发明的实施例图中的附图,对本发明实施例中的技术方案进行清楚、完整的描述。

[0069]

实施例:如图1所示,该基于注意力调制上下文空间信息的表情识别方法,具体包括以下步骤:

[0070]

s1:获取待训练的自然场景人脸表情图像公共数据集,对人脸表情图像进行预处理;

[0071]

所述步骤s1具体为:首先将输入图像尺寸调整为256

×

256,然后对其进行上下左右以及中心的裁剪,获得五张224

×

224的人脸图像,它们拥有相同的表情标签,再以0.5的概率对其进行随机水平翻转;

[0072]

s2:构建用于自然场景人脸表情识别的注意力调制上下文空间信息网络模型;首先,利用上下文卷积替换卷积残差块中的标准卷积,构建上下文卷积卷积残差网络(coresnet)作为特征提取部分,以不同膨胀率大小的卷积核捕获局部和合并全局上下文信息;其次,将协调注意力模块嵌入coresnet作为特征处理部分,为所提取特征分配注意权重,突出显著特征,增大表情类间特征差异,最终构成acsi模型用于人脸表情识别;

[0073]

所述步骤s2具体包括以下步骤:

[0074]

s21:利用上下文卷积块替换残差块的中间卷积层,形成上下文卷积残差模块构建上下文卷积残差网络;在深度人脸表情识别任务中,多尺度特征非常重要,它在描述全局语义信息的同时能够捕获更丰富的局部细节信息,上下文卷积块包含不同膨胀率的卷积核,可通过不同大小的感受野提取多尺度特征;在cnn中,标准卷积仅使用具有固定感受野的卷积核,其卷积核大小通常为,因为增加卷积核大小会带来参数量和计算时间的增加;标准卷积的可学习参数(权重)和浮点运算的数量可用公式(1)和(2)进行计算;和标准卷积层一样,上下文卷积块中的所有卷积核都是独立的,允许并行执行,与标准卷积层不同的是,相同大小的下上文卷积在保持相似数量的参数和计算成本的同时具备了整合上下文信息的能力;所以,上下文卷积块能够作为标准卷积层的直接替代来更好地完成特征提取;

[0075]

如图2所示,所述步骤s21具体为:

[0076]

s211:上下文卷积块接收输入特征图m

in

,其在不同层级l={1,2,3,...,n}应用具有不同膨胀率的卷积核d={d1,d2,d3,...,dn},即leveli(leveli表示上下文卷积块中第i个级别的上下文卷积)上的卷积核具有膨胀率从level1到leveln膨胀率依次增大,这样的操作可以提取越来越广泛的上下文信息,其中,具有较低膨胀率的卷积核负责从输入特征图中捕获有关人脸局部细节的信息,而具有较高膨胀率的卷积核负责合并全局上下文信息,从而帮助整个表情识别过程;

[0077]

s212:在不同上下文卷积的级别level上,上下文卷积均输出多个特征图m

outi

,对于所有i∈l,每个图具有宽度w

out

和高度h

out

;

[0078]

s213:保持残差结构将层间的相关性结合起来,得到上下文卷积残差模块;

[0079]

s214:根据特征图的尺寸调整每层中上下文卷积块的级别(level),从而构建上下文卷积残差网络;所述步骤s2中构建的上下文卷积残差网络(coresnet)包括coresnet18和coresnet50;在coresnet18中,每个上下文残差模块由一个上下文卷积残差模块和一个构成1*1标准卷积层构成;在coresnet50中,每个上下文残差模块由一个上下文卷积残差模块和两个1*1标准卷积层构成;上下文卷积残差模块用于多尺度特征提取,1*1标准卷积层用于通道变换;根据输入特征图的尺寸,在每个上下文残差模块使用不同级别的上下文卷积块;上下文卷积块的示意图如图3所示,在第一个上下文卷积残差模块使用级别为4(level=4)的上下文卷积块,第一个上下文卷积残差模块中level=3,第三个上下文卷积残差模块中level=2,最后一个上下文卷积残差模块中level=1;这里,当level=n时,上下文卷积块中有膨胀率大小di=i,i=1,

…

,n-1,n的卷积核;与以往网络级联的工作不同,该技术方案,直接将上下文卷积集成到广泛使用的残差网络中,分别对resnet18和resnet50中的残差块进行改进,得到相应的coresnet18和coresnet50;coresnet主要由4个网络层组成,每层中有不同级别的上下文卷积残差块,因为特征图的大小会随着网络层离输入越远而减小,所以本文根据特征图的尺寸调整每层中上下文卷积块的级别,在第一层中使用coconv4,即level=4的上下文卷积块,第二层中为coconv3,第三层为coconv2,而由于输入最后一层的特征图分辨率已经降低到了7

×

7,此时使用上下文卷积不再合理,所以只使用一个标准卷积,同样记为coconv1;不同级别coconv的卷积参数情况如表1所示。

[0080]

表1上下文卷积残差块的卷积参数情况

[0081][0082]

所述步骤s21中上下文卷积的可学习参数和浮点运算的数量采用公式(1)和(2)进行计算;

[0083]

params=m

in

·kw

·

kh·mout

ꢀꢀ

(1);

[0084]

flops=m

in

·

kh·kw

·mout

·wout

·hout

ꢀꢀ

(2);

[0085]

其中,m

in

和m

out

表示输入和输出特征映射的数量,kw和kh表示卷积核的宽度和高度,最后,w

out

和h

out

表示输出特征映射的宽度和高度;

[0086]

s22:使用协调注意力(coordinate attention,ca)构建协调注意力模块(其结构如图4所示)对coresnet提取的多尺度特征分配注意力权重以强化特征表征能力;

[0087]

所述步骤s22具体为:

[0088]

s221:将coresnet提取的特征记为x,首先使用尺寸(h,1)和(1,w)的平均池化核沿着水平坐标方向和竖直坐标方向对每个通道进行编码,高度为h的第c个通道的编码输出由公式(3)计算:

[0089][0090]

其中,(h,1)和(1,w)分别表示沿着水平坐标方向和竖直坐标方向所用池化核的尺寸;h表示沿着水平坐标方向所用平均池化核的高度;w表示沿着竖直坐标方向所用平均池化核的宽度;在数值上,h和w也等于输入特征图的高度和宽度;该公式(3)计算水平坐标方向上高度为h时的第c个通道的编码输出,沿宽度i,对输入特征进行求和运算;

[0091]

宽度为w的第c个通道的编码输出由公式(4)计算:

[0092][0093]

该公式(4)计算竖直坐标方向上高度为w时的第c个通道的编码输出,沿高度j,0≤j≤h对输入特征进行求和运算;

[0094]

s222:将步骤s221中的两个变换沿着两个空间方向进行特征聚合,返回一对方向感知注意力图;

[0095]

s223:将所述步骤s222中生成的一对方向感知注意力图连接起来,将其送入一个1

×

1的卷积变换函数f中;

[0096]

f=δ(f([yh,yw]))

ꢀꢀ

(5);

[0097]

其中,[,]表示沿着空间维度的拼接操作,δ为非线性的sigmoid激活函数,f∈r

c/r

×

(h w)

为水平方向和垂直方向对空间信息进行编码的中间特征映射;为了降低模型的复杂性,采用适当的减小率r来减少f的通道数;

[0098]

s224:继续沿着空间维把f分解成两个单独的张量fh∈r

c/r

×h和fw∈r

c/r

×w,对其使用两个1

×

1卷积变换fh和fw将fh和fw分别变换为相同通道数的张量,采用公式(6)和(7);

[0099]

mh=δ(fh(fh))

ꢀꢀ

(6);

[0100]mw

=δ(fw(fw))

ꢀꢀ

(7);

[0101]

其中,δ为sigmoid函数,输出的mh和mw作为注意力权值,最后协调注意力模块的输出z,由公式(8)所示:

[0102][0103]

其中zc(i,j)为输出,xc(i,j)为输入,和为注意力权值;

[0104]

为了关注显著特征和增强表情类间特征差异,从而采用协调注意力机制,在上下文卷积残差网络中嵌入协调注意力模块(ca)进行特征处理,以实现对输入特征图中表情相关信息的增强和冗余信息的抑制。如图在网络中嵌入协调注意力,可以沿着一个空间方向捕获输入特征间的远程依赖性,并在另一个空间方向上保留表情相关人脸区域的位置信息,然后将得到的特征图编码成一对方向感知和位置敏感的注意力图,将其应用于输入特征图以增强细微的表情信息;在每个上下文卷积块和coresnet后添加ca模块,筛选关键尺度特征和强调显著人脸区域以增强特征表征能力,从而提高识别性能。

[0105]

s3:利用预处理过的人脸表情图像对上下文空间信息(acsi)网络模型进行训练;所述步骤s3中的上下文空间信息网络模型(acsi)包括依次相连的卷积层、bn层、relu层、maxpool层、四个上下文残差模块、协调注意力(ca)模块、全局平均池化层、fc层和softmax分类层;所述卷积层将输入的人脸表情图像经过3*3标准卷积操作提取特征;bn层对提取的特征进行批量归一化防止梯度消失或爆炸;然后所述relu层对其进行非线性激活;最大池化层用于特征降维;四个上下文卷积模块用于从降维的特征中提取到多尺度的人脸特征;嵌入上下文卷积模块的协调注意力(ca)模块用于关注不同尺度的特征;所述coresnet输出特征层后的ca模块对输出特征进行注意力加权;全局平均池化层和fc层进行下采样操作,下采样后的人脸表情特征再经过softmax分类器进行分类;

[0106]

所述步骤s3的具体步骤为:

[0107]

s31:通过上下文卷积残差网络(coresnet)对输入的人脸表情图像进行多尺度特征提取和上下文空间信息整合;

[0108]

s32:在每个上下文卷积残差模块中嵌入注意力模块以关注显著尺度特征,对coresnet输出特征使用协调注意力对提取的特征进行注意力加权,分别在两个空间方向上捕捉到表情信息的相关性和保留精确的人脸关键区域信息;

[0109]

s33:将注意力加权后的特征进行下采样操作,对下采样后的特征采用softmax分类器进行分类处理;

[0110]

所述softmax分类器的输入的是一个任意实数的向量,输出的是一个向量,其中每

个元素的取值在(0,1)之间,且其和为1,设有一个数组,其softmax的计算公式为式(9):

[0111][0112]

其中,xi表示第i个元素,softmax(xi)表示softmax的取值中为第i个元素的输出值,i为元素个数,即分类的类别个数;通过softmax函数就可以将多分类的输出值转换为范围在[0,1]且其和为1的概率分布;

[0113]

所述步骤s3中在利用人脸表情数据集对注意力调制上下文空间信息网络模型(acsi)训练前,采用超过1000万数据的大型人脸数据集ms-celeb-1m(包含近10万个受试者的1000万张人脸图像)作为训练集,预先训练了acsi,然后分别将人脸表情数据集affectnet-7和raf_db输入预训练后的acsi模型中,经过前向传播得到输出值(预测类别概率),根据输出值采用交叉熵损失函数计算ascp模型的损失值;交叉熵损失函数计算公式为式(10)所示:

[0114][0115]

其中,p(x)是指真实的类别概率,q(x)是模型的预测类别概率;

[0116]

s4:重复步骤s3的模型训练,直至达到设定的训练次数,得到训练后的深度残差网络模型,利用训练后的深度残差网络模型进行人脸表情识别;所述步骤s4根据式(10)计算得到的acsi模型的损失值进行反向传播更新网络权值,重复训练,直至达到设定的训练次数时结束训练,得到训练好的注意力调制上下文空间信息网络模型acsi模型。

[0117]

具体应用实施例:采用上述技术方案,为了验证本文所提ascp模型的有效性,在两个公共面部表情数据库affectnet和raf-db进行实验,这两个数据库都提供了自然场景下的人脸图像。其中,affectnet数据库是人脸情感计算研究领域中最大的数据库之一,大约有44万张人脸图像,包含affectnet-7和affectnet-8(增加了“蔑视”类别);raf-db数据库包括7种基本面部表情和12种复合面部表情,总共大约30000张人脸图像。如表2所示,本文实验使用affectnet-7和raf-db数据库中的7类基本面部表情(快乐、惊讶、悲伤、愤怒、厌恶、恐惧和中性)的人脸图像作为训练集,由于测试集不可用,所以在相应的验证集上进行了测试,以评估所提出的模型性能。

[0118]

步骤s1中在图像预处理阶段,首先将输入图像尺寸调整为256

×

256,然后对其进行上下左右以及中心的裁剪,获得五张224

×

224的人脸图像,它们拥有相同的表情标签,再以0.5的概率对其进行随机水平翻转;模型使用pytorch实现,在nvidia geforce gtx 1650gpu上进行模型训练,训练过程中采用sgd算法进行优化,设置动量为0.9,初始学习率为0.01,每迭代20次将学习率下降为原来的0.1,总迭代次数为60,批处理大小为16。

[0119]

表2实验数据集的详细信息,包括表情类别、训练集和测试集数量

[0120][0121]

采用该基于注意力调制上下文空间信息的表情识别方法在affectnet-7和raf-db验证集上的实验结果如表3所示,其中coresnet18和coresnet50(本文的基线模型)为上下文卷积残差网络,而coresnet18_ca_a和coresnet50_ca_a分别是在coresnet18和coresnet50的特征输出层后嵌入协调注意力模块;coresnet18_ca_b和coresnet50_ca_b是在相应coresnet的每个上下文卷积残差块中嵌入协调注意力模块;

[0122]

表3 acsi模型在affectnet-7和raf-db验证集上的识别准确率

[0123][0124]

从表3可以看出,在affectnet-7验证集上,acsi18的表情识别准确率相比于coresnet18增加了1.70%,相比于coresnet18_ca_a和coresnet18_ca_b分别增加了1.36%和1.30%。acsi50的表情识别准确率相比coresnet50增加了2.03%,相比于coresnet50_ca_a和coresnet50_ca_b分别增加了0.80%和0.25%。在raf_db验证集上,acsi18的表情识别准确率相比于coresnet18增加了1.89%,相比于coresnet18_ca_a和coresnet18_ca_b分别增加了1.23%和1.14%;acsi50的表情识别准确率相比coresnet50增加了1.79%,相比于coresnet50_ca_a和coresnet50_ca_b分别增加了0.35%和0.06%;以上实验结果表明了本文算法的有效性和泛化性。

[0125]

为进一步说明该基于注意力调制上下文空间信息的表情识别方法中所构建的上下文空间信息(acsi)网络模型的有效性,将构建的上下文空间信息(acsi)网络模型与近年

来其它同类模型在数据集affectnet-7和raf-db上进行了性能对比,如表4、表5所示;从表4可以看出,本文所提出的acsi50在affectnet-7上相比于fmpn提高了1.61%,相比于oadn提高了0.97%。相比于ensemble cnn提高了0.75%,相比于dda-loss方法提高了0.52%;从表5可以看出,本文所提出的acsi50在raf_db上相比于fsn提高了2.5%,相比于cnn提高了0.91%,相比于dlp-cnn提高了0.76%,相比于pacnn提高了0.33%。结果表明本文所提模型在affectnet-7和raf-db上的识别准确率均有一定的提升,相比同类模型具有一定的竞争性。由于这些模型没能很好地解决特征完备性受限或类间分类边界模糊的问题,所以识别性能较低,本文所提模型使用上下文卷积能够提取多尺度的人脸表情特征,在网络中嵌入协调注意力模块能够使网络关注更具判别性的表情特征,通过残差结构能够将层间的相关性更好地结合起来,最终使识别性能得以提高。

[0126]

表4 affectnet-7上模型的性能比较

[0127]

methodacc.%fmpn61.25oadn61.89ensemble cnn62.11dda-loss62.34acsi1862.36acsi5062.86

[0128]

表5 raf-db上模型的性能比较

[0129]

methodacc.%fsn81.10cnn82.69dlp-cnn82.84pacnn83.27acsi1883.47acsi5083.60

[0130]

为了证明acsi模型提取表情特征的类间差异性,本节对acsi50模型在affectnet-7和raf-db验证集上提取的特征进行t-sne可视化,结果如图5和图6所示。图2-6中均显示了7种基本人脸表情分类,包括愤怒(anger)、厌恶(digust)、恐惧(fear)、快乐(happiness)、悲伤(sadness)、惊讶(surprise)和中立(neutral),从图中可以看到,相比基线模型,由acsi50模型所提取的特征具有类间相对分散,类内相对聚集的分布特点。

[0131]

为了进一步研究模型中注意力模块的作用,使用类激活图(cam,class activation map)方法来可视化本文注意力所产生的注意力图;类激活图方法用于可视化不同表情的激活部分,将输出层的权重映射到卷积特征图,以识别人脸图像不同区域的重要性,具体为通过cam为所提网络acsi可视化面部激活区域,得到注意力图,为了在原始图像上显示注意力区域,一般是将注意力图调整为与输入图像相同的大小,并通过colormap_jet颜色映射将注意力图可视化到原始图像。该技术方案在使用时具体步骤为:首先将可视化注意力图调整为与输入图像相同的大小,并通过颜色映射将注意力图可视化到原始图像;图7显示了raf_db中不同表情图像的注意图,该图中有7列,每列显示七种表情中的一

种,自左向右的分别是愤怒(anger)、厌恶(digust)、恐惧(fear)、快乐(happiness)、悲伤(sadness)、惊讶(surprise)和中立(neutral),第1行显示原始对齐的面部图像,第2行为acsi50模型对相应表情图像的注意力可视化,从图7中可以明显看到,在存在遮挡和姿势变化的情况下,本文所用注意力模块使网络聚焦于更具辨别力的人脸区域;结果表明,上下文卷积和协调注意力的联合可以显著提高表情识别性能。在公开的表情数据集上,与同类的算法相比,acsi具有更高的识别性能。

[0132]

以上所述仅为本发明的较佳实施例而已,并不用于限制本发明,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。