1.本发明涉及图像篡改检测的多媒体技术领域和信息安全领域,特别是基于级联两阶段神经网络的图像拼接篡改痕迹检测方法。

背景技术:

2.随着现代技术的发展,任何人都可以对图像进行编辑。虽然这方便了人们的生活,但是凡事都有两面性:当被恶意篡改的图像经过传播,就会影响人们对客观事物的判断,有时甚至会对社会和国家造成不良的影响。据我们所知,已有的图像拼接篡改检测方法都是瞄准篡改区域的检测,这在特定情况下会产生二义性。而且,大多数方法都仅仅依赖某一特定线索来实现篡改区域的检测,如颜色、边缘纹理、噪声等,它们无法较好地应用于其它篡改图像,因此,它们的检测效果和鲁棒性都较差。所以难以满足图像拼接篡改检测的需求。此外,现有方法多为图像篡改区域的检测方法,基本无法精确的判断图像篡改的精确边缘,对于某些具体的应用领域造成了较大的困难。

3.近年来,论文图像造假的现象时有发生。学术造假问题是一个客观存在且社会影响十分恶劣的问题,其中很大一部分造假文章的图片会经过图像拼接篡改操作,而编辑部无法对数以万计的论文图片进行逐一筛选。同时,在司法取证过程中,也存在图像物证篡改的问题。证据的篡改很容易遮蔽案件的真相,让犯罪分子逍遥法外。犯罪分子想要篡改一张照片使其对自己有利其实并不难,但是人工检测篡改图的工程量巨大的。每年每天,我国花费在司法图像证据的鉴伪工作上的人力时间不计其数。针对人工检测图像是否经过篡改的检测效率低的这个问题,一个高效的图像拼接篡改痕迹检测算法不可缺少,具有很好的应用前景。

技术实现要素:

4.本发明的目的是提供一种基于级联两阶段神经网络的图像拼接篡改痕迹检测方法。该篡改痕迹是由篡改区域内部的内边缘和篡改区域外部的外边缘构成的篡改双边缘。

5.本发明采用的技术方案如下:

6.一种基于级联两阶段神经网络的图像拼接篡改痕迹检测方法,包括以下步骤:

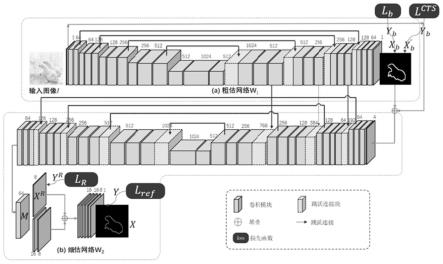

7.s1,设计基于深度学习的w型两阶段卷积神经网络,它由两个具有u型网络结构的粗估网络w1和细估网络w2级联而成,而且粗估网络w1和细估网络w2通过跳跃连接方式将中间特征层加以传递;

8.s2,图像预处理,将训练图像的rgb颜色值进行数据标准化;

9.s3,训练参数设置;

10.s4,训练模型,将输入图像输入步骤s1中设计的神经网络,通过神经网络模型计算得到输出图像,通过损失函数优化神经网络模型参数;

11.所述步骤s4在深度学习框架pytorch中实现和训练;

12.其中,在计算机视觉中用于训练神经网络模型的图像数据被称为训练图像,此处

的训练图像包括一张输入图像和一张标记了输入图像上篡改边缘的目标图像。输入图像通过神经网络模型计算会产生一个输出图像,通过计算反映输出图像和目标图像之间差距的损失函数,更新神经网络的模型参数,实现模型参数调优和网络学习的目标,这就是神经网络模型的训练过程。

13.本发明的检测方法:首先,将输入图像i进行数据标准化,将其rgb三通道的颜色值标准化至[0,1]的范围;然后,将经过标准化的输入图像i

′

输入神经网络;将传统的具有二义性的篡改单边缘更正为由篡改区域内部的内边缘和篡改区域外部的外边缘构成的篡改双边缘,制作成拼接篡改图像对的数据集,用于对w型两阶段卷积神经网络模型的训练过程;最后,使用三个训练过程训练神经网络模型,即粗估训练过程t1、优化训练过程t2、细估训练过程t3,其中粗估训练过程t1和优化训练过程t2为对粗估网络w1的训练,细估训练过程t3为对细估网络w2的训练。

[0014]

拼接篡改图像对的数据集中的双边缘目标图像y作为细估训练过程t3的目标图像,对双边缘目标图像y进行形态学膨胀操作生成条带目标图像yb作为粗估训练过程t1和优化训练过程t2的目标图像;

[0015]

yb=dilate(y,ks)

ꢀꢀ

(1)

[0016]

其中dilate(

·

,

·

)表示形态学膨胀算子,ks表示卷积核大小,在此取值ks=3;y为双边缘目标图像;yb为条带目标图像;

[0017]

(1)粗估训练过程t1,输入经过标准化的输入图像i

′

,经过粗估训练过程t1,粗估网络w1在粗估训练过程t1的输出图像xb,公式如下

[0018][0019]i′

表示经过标准化的输入图像;xb表示粗估网络w1在粗估训练过程t1的输出图像,表示粗估网络w1在粗估训练过程t1的运算函数;

[0020]

通过条带目标图像yb对粗估网络w1在粗估训练过程t1的输出图像xb进行约束,粗估训练过程t1的损失函数为粗估损失lb中的对抗损失l

can

和粗估损失lb中的带权重的交叉熵损失以及粗估损失lb中的集合相似度度量损失的加权和,记为粗估损失lb;

[0021][0022]

λ1、λ2、λ3分别表示粗估损失lb中的对抗损失l

can

、粗估损失lb中的带权重的交叉熵损失以及粗估损失lb中的集合相似度度量损失的权重,分别取值0.1、0.3、0.4;

[0023]

表示粗估损失lb中的带权重的交叉熵损失,具体公式如下

[0024][0025]

其中n表示双边缘目标图像y中的像素总数;log(

·

)为对数运算函数,取底数为2;∑为求和运算符;表示条带目标图像yb中属于篡改条带像素的样本权重,表示条带目标图像yb中不属于篡改条带像素的样本权重,公式如下

[0026][0027]

[0028]

其中,l1(

·

)表示一范数函数,l1(yb)表示统计条带目标图像yb中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数;

[0029]

表示粗估损失lb中的集合相似度度量损失,具体公式如下

[0030][0031]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示求交运算;xb表示粗估网络w1在粗估训练过程t1的输出图像;yb表示条带目标图像;

[0032]

l

can

表示粗估损失lb中的对抗损失,具体公式如下

[0033][0034]

其中,mar为常数0.1;l2(

·

,

·

)代表两个图像的欧式距离计算函数,计算方法为两图像逐像素相减的平方和;∩表示求交运算;表示对粗估网络w1在粗估训练过程t1的输出图像xb进行取反操作的结果;表示对条带目标图像yb进行取反操作的结果;

[0035]

(2)优化训练过程t2,使用过渡性强化损失l

cts

对粗估网络w1在粗估训练过程t1的输出图像xb进行进一步的矫正,粗估网络w1在优化训练过程t2的输出图像为x

′b,将双边缘目标图像y作为优化训练过程t2的目标图像;过渡性强化损失l

cts

由过渡性强化损失l

cts

中的带权重的交叉熵损失l

wce

和过渡性强化损失l

cts

中的集合相似度度量损失l

dice

组成,根据过渡区域掩膜mask对粗估网络w1在优化训练过程t2的输出图像x

′b中双边缘目标图像y上标注的双边缘像素、条带目标图像yb上标注的条带像素以及其他像素施加不同的损失权重;优化训练过程t2和粗估训练过程t1都是针对粗估网络w1进行的,粗估训练过程t1必须先训练收敛,优化训练过程t2才能进行;

[0036][0037]i′

表示经过标准化的输入图像;x

′b表示粗估网络w1在优化训练过程t2的输出图像;表示粗估网络w1在优化训练过程t2的运算函数;

[0038]

l

cts

为过渡性强化损失,具体公式如下

[0039]

l

cts

=mask*λ4*l

wce

mask*λ5*l

dice

ꢀꢀ

(10)

[0040]

λ4、λ5表示过渡性强化损失l

cts

中的带权重的交叉熵损失l

wce

和过渡性强化损失l

cts

中的集合相似度度量损失l

dece

的权重,分别取值0.3、0.4;mask表示过渡区域掩膜,它由双边缘目标图像y和条带目标图像yb计算得到,具体计算公式如下

[0041]

mask=1-(y

b-y) y*17

ꢀꢀ

(11)

[0042]

l

wce

为过渡性强化损失l

cts

中的带权重的交叉熵损失,具体公式如下

[0043][0044]

其中,n表示双边缘目标图像y中的像素总数;log(

·

)为对数运算函数,取底数为2;∑为求和运算符;表示条带目标图像yb中属于篡改条带像素的样本权重,表示条带目标图像yb中不属于篡改条带像素的样本权重,公式如下

[0045][0046]

[0047]

其中,l1(

·

)表示一范数函数,l1(yb)表示统计条带目标图像yb中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数;

[0048]

l

dice

为过渡性强化损失l

cts

中的集合相似度度量损失,具体公式如下

[0049][0050]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示求交运算;x

′b表示粗估网络w1在优化训练过程t2的输出图像;yb表示条带目标图像;

[0051]

(3)细估训练过程t3,在训练细估网络w2的细估训练过程t3,固定粗估网络w1的网络参数为粗估网络w1在优化训练过程t2完成后得到的网络参数,使用粗估网络w1在优化训练过程t2的输出图像x

′b和粗估网络w1输出的特征图f作为细估网络w2的输入参数[x

′b,f],其中粗估网络w1输出的特征图f具体是指粗估网络w1中4个上采样块u

p

输出的特征图;细估网络w2的输出图像x=w2(x

′b,f),通过双边缘目标图像y进行约束,细估训练过程t3训练至网络收敛;本发明加入了细估损失l

ref

中的信息熵损失l

ie

、细估损失l

ref

中的关系图损失lr、细估损失l

ref

中的带权重的交叉熵损失l

wce

和细估损失l

ref

中的集合相似度度量损失l

dice

作为损失函数,这些损失函数的加权和记为细估损失l

ref

;

[0052]

x=w2(x

′b,f)

ꢀꢀ

(16)

[0053]

其中f为粗估网络w1输出的特征图,具体是指粗估网络w1中4个上采样块up输出的特征图;x

′b表示粗估网络w1在优化训练过程t2的输出图像;x表示细估网络w2的输出图像;

[0054]

l

ref

为细估损失,具体公式如下

[0055][0056]

其中,λ6、λ7、λ8、λ9为细估损失l

ref

中的信息熵损失l

ie

、细估损失l

ref

中的带权重的交叉熵损失细估损失l

ref

中的集合相似度度量损失和细估损失l

ref

中的关系图损失lr的权重,取值分别为0.2、0.6、0.4、0.4;漏检惩罚掩膜mask

′

对粗估网络w1在优化训练过程t2的输出图像x

′b与双边缘目标图像y上像素值相同、细估网络w2的输出图像x与双边缘目标图像y上像素值不同的像素施加的权重为2,其他像素的权重设置为1;漏检惩罚掩膜mask

′

的具体计算公式如下

[0057][0058]

其中mask

′

(p)表示漏检惩罚掩膜mask

′

上像素p的掩膜值;x

′b(p)表示粗估网络w1在优化训练过程t2的输出图像x

′b上像素p的像素值;x(p)表示细估网络w2的输出图像x上像素p的像素值;y)p)表示双边缘目标图像y上像素p的像素值;r(

·

)表示取整运算函数,使用四舍五入法保留整数部分;

[0059]

lr为细估损失l

ref

中的关系图损失,具体公式如下

[0060][0061]

其中,λ

10

和λ

11

分别为细估损失l

ref

中的带权重的交叉熵损失和细估损失l

ref

中的集合相似度度量损失的权重,分别取值0.6和0.4;

[0062]

为关系图损失lr中的集合相似度度量损失,具体公式如下

[0063][0064]

其中,xr表示网络中间特征m的八邻域关系图,它是由网络中间特征m通过8个不同的卷积核计算得到的8通道特征图;网络中间特征m具体是指位于细估网络w2末端的最后一个64层特征;关系图目标图像yr为双边缘目标图像y的八邻域关系图;表示网络中间特征m的八邻域关系图xr的第d个图像通道;表示关系图目标图像yr的第d个图像通道;∑为求和运算符;∩表示求交运算;l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;遍历双边缘目标图像y中的每一个像素p得到8通道的关系图目标图像yr,关系图目标图像yr的第d个图像通道的具体公式如下

[0065][0066]

其中,y(pd)表示双边缘目标图像y上像素p的八邻域像素中第d个方向的像素pd的像素值;y(p)表示双边缘目标图像y上像素p的像素值;表示关系图目标图像yr的第d个图像通道上像素p的像素值;对于像素p的八邻域像素中第d个方向的像素pd,d的取值[0,7]分别对应方向为左上、正上、右上、正右、右下、正下、左下、正左的先后顺序,并与关系图目标图像yr中通道下标d的取值一一对应;

[0067]

为关系图损失lr中的带权重的交叉熵损失,具体公式如下

[0068][0069]

其中,xr表示网络中间特征m的八邻域关系图,它是由网络中间特征m通过8个不同的卷积核计算得到的8通道特征图;网络中间特征m具体是指位于细估网络w2末端的最后一个64层特征;关系图目标图像yr为双边缘目标图像y的八邻域关系图;表示网络中间特征m的八邻域关系图xr的第d个图像通道;表示关系图目标图像yr的第d个图像通道;关系图目标图像yr为双边缘目标图像y的八邻域关系图;n表示双边缘目标图像y或条带目标图像yb中的像素数量;log(

·

)为对数运算符号,取底数为2;∑为求和运算符;表示关系图目标图像yr的第d个图像通道中属于篡改条带的像素的样本权重,表示关系图目标图像yr的第d个图像通道中不属于篡改条带的像素的样本权重,具体公式如下

[0070][0071][0072]

其中,l1(

·

)表示一范数函数,表示统计关系图目标图像yr的第d个图像通道中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数;

[0073]

l

ie

为细估损失l

ref

中的信息熵损失,具体公式如下

[0074]

l

ie

=-∑(x*log(x) (1-x)*log(1-x))

ꢀꢀ

(25)

[0075]

其中,log(

·

)为对数运算符号,取底数为2;x表示细估网络w2的输出图像;∑为求和运算符;

[0076]

为细估损失l

ref

中的集合相似度度量损失,具体公式如下

[0077][0078]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示交运算;y表示双边缘目标图像;x表示细估网络w2的输出图像;

[0079]

为细估损失l

ref

中的带权重的交叉熵损失,具体公式如下

[0080][0081]

其中,n表示双边缘目标图像y或条带目标图像yb中的像素数量;log(

·

)为对数运算符号,取底数为2;x表示细估网络w2的输出图像;∑为求和运算符;w

pos

表示双边缘目标图像y中属于篡改双边缘像素的样本权重,w

neg

表示双边缘目标图像y中不属于篡改双边缘像素的样本权重,公式如下

[0082][0083][0084]

其中,l1(

·

)表示一范数函数,l1(y)表示统计双边缘目标图像y中像素值为1的像素数量;y表示双边缘目标图像;n表示双边缘目标图像y中的像素总数;

[0085]

图像二值化,固定粗估网络w1的网络参数为粗估网络w1在优化训练过程t2完成后得到的网络参数,固定细估网络w2的网络参数为细估网络w2在细估训练过程t3完成后得到的网络参数,通过映射函数

[0086][0087]

将细估网络w2的输出图像x进行二值化,即若细估网络w2的输出图像x上像素p的像素值x(p)大于等于0.5,细估网络w2的预测图像x

out

上像素p的像素值x

out

(p)置为1,否则细估网络w2的预测图像x

out

上像素p的像素值x

out

(p)置为0;细估网络w2的预测图像x

out

上像素p的像素值为1表示对应像素p为篡改边缘像素,细估网络w2的预测图像x

out

上像素p的像素值为0表示对应像素p不是篡改边缘像素。

[0088]

本发明的目的是在于提供一种由粗到细的图像拼接篡改痕迹检测算法,是一种基于篡改区域和被篡改区域的图像特征不一致性提出的图像拼接篡改痕迹检测算法。它可以应用于司法物证取证领域和科技论文检测领域等。本发明创新地将图像拼接篡改边缘作为线索进行检测,因为篡改边缘两侧的不一致性难以消除这一特征,这使得本发明拥有较高的鲁棒性,并取得优于现有方法的准确率。本发明创新性地设计了双边缘的表示方法,更符合实际情况。本发明生成了篡改区域与非篡改区域特征相似的、肉眼难以分辨的拼接篡改数据集,提高了训练样本的难度,使本发明有比较好的检测能力。本发明基于深度学习框架设计,整体网络由粗估网络和细估网络两个部分组成。可以较为精准的定位出图像中不一致边缘,在司法物证取证领域和科技论文检测领域有较大的应用价值。

[0089]

本发明将篡改痕迹定义为篡改区域内部的内边缘和外部的外边缘构成的篡改双边缘,解决了通常图像拼接篡改检测算法可能存在的二义性问题,并通过级联两阶段神经网络进行逐级的优化,图像拼接篡改痕迹检测的精确度有明显提高。

附图说明

[0090]

图1是本发明设计的w型两阶段卷积神经网络模型结构,其中上半部分为粗估网络w1的主要结构,下半部分为细估网络w2的主要结构。

具体实施方式

[0091]

在实现对于图像拼接篡改痕迹的检测过程中,直接使用本方法即可。

[0092]

1)首先,将输入图像i进行数据标准化,将其rgb三通道的颜色值标准化至[0,1]的范围,然后将经过标准化的输入图像i

′

输入神经网络。在casia i数据集、coco数据集、cod10k数据集和纹理填充数据集等公开数据集基础上,将传统的具有二义性的篡改单边缘更正为由篡改区域内部的内边缘和篡改区域外部的外边缘构成的篡改双边缘,制作完成了包含7.2万个拼接篡改图像对的数据集,用于对w型两阶段卷积神经网络模型的训练过程。

[0093]

2)如图1所示,本发明提出的w型两阶段卷积神经网络分为两个阶段,即粗估网络w1和细估网络w2。所述w型两阶段卷积神经网络的内部的连接方式如图1所示,表1、表2中同级的下采样块down和上采样块up的图像特征使用跳跃连接传递。本发明使用三个训练过程训练神经网络模型,即粗估训练过程t1、优化训练过程t2、细估训练过程t3,其中粗估训练过程t1和优化训练过程t2为对粗估网络w1的训练,细估训练过程t3为对细估网络w2的训练。本发明使用包含了7.2万个拼接篡改图像对的数据集中的双边缘目标图像y作为细估训练过程t3的目标图像,对双边缘目标图像y进行形态学膨胀操作生成条带目标图像yb作为粗估训练过程t1和优化训练过程t2的目标图像。

[0094]

yb=eilate(y,ks)

ꢀꢀ

(1)

[0095]

其中dilate(

·

,

·

)表示形态学膨胀算子,ks表示卷积核大小,在此取值ks=3。y为双边缘目标图像;yb为条带目标图像。

[0096]

3)粗估训练过程t1,输入经过标准化的输入图像i

′

,经过粗估训练过程t1,粗估网络w1在粗估训练过程t1的输出图像xb,公式如下

[0097][0098]i′

表示经过标准化的输入图像;xb表示粗估网络w1在粗估训练过程t1的输出图像,表示粗估网络w1在粗估训练过程t1的运算函数。

[0099]

通过条带目标图像yb对粗估网络w1在粗估训练过程t1的输出图像xb进行约束,粗估训练过程t1的损失函数为粗估损失lb中的对抗损失l

can

和粗估损失lb中的带权重的交叉熵损失以及粗估损失lb中的集合相似度度量损失的加权和,记为粗估损失lb。

[0100][0101]

λ1、λ2、λ3分别表示粗估损失lb中的对抗损失l

can

、粗估损失lb中的带权重的交叉熵损失以及粗估损失lb中的集合相似度度量损失的权重,分别取值0.1、0.3、0.4。

[0102]

表示粗估损失lb中的带权重的交叉熵损失,具体公式如下

[0103][0104]

其中n表示双边缘目标图像y中的像素总数;log(

·

)为对数运算函数,取底数为2;∑为求和运算符;表示条带目标图像yb中属于篡改条带像素的样本权重,表示条

带目标图像yb中不属于篡改条带像素的样本权重,公式如下

[0105][0106][0107]

其中,l1(

·

)表示一范数函数,l1(yb)表示统计条带目标图像yb中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数。

[0108]

表示粗估损失lb中的集合相似度度量损失,具体公式如下

[0109][0110]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示求交运算;xb表示粗估网络w1在粗估训练过程t1的输出图像;yb表示条带目标图像。

[0111]

l

can

表示粗估损失lb中的对抗损失,具体公式如下

[0112][0113]

其中,mar为常数0.1;l2(

·

,

·

)代表两个图像的欧式距离计算函数,计算方法为两图像逐像素相减的平方和;∩表示求交运算;表示对粗估网络w1在粗估训练过程t1的输出图像xb进行取反操作的结果;表示对条带目标图像yb进行取反操作的结果。

[0114]

粗估网络w1使用的网络参数和主要结构如表1所示。粗估网络w1中的各个模块间的具体连接方式如图1所示。

[0115]

4)优化训练过程t2,使用过渡性强化损失l

cts

对粗估网络w1在粗估训练过程t1的输出图像xb进行进一步的矫正,粗估网络w1在优化训练过程t2的输出图像为x

′b,将双边缘目标图像y作为优化训练过程t2的目标图像。过渡性强化损失l

cts

由过渡性强化损失l

cts

中的带权重的交叉熵损失l

wce

和过渡性强化损失l

cts

中的集合相似度度量损失l

dice

组成,根据过渡区域掩膜mask对粗估网络w1在优化训练过程t2的输出图像x

′b中双边缘目标图像y上标注的双边缘像素、条带目标图像yb上标注的条带像素以及其他像素施加不同的损失权重。优化训练过程t2和粗估训练过程t1都是针对粗估网络w1进行的,粗估训练过程t1必须先训练收敛,优化训练过程t2才能进行。

[0116][0117]i′

表示经过标准化的输入图像;x

′b表示粗估网络w1在优化训练过程t2的输出图像;表示粗估网络w1在优化训练过程t2的运算函数。

[0118]

l

cts

为过渡性强化损失,具体公式如下

[0119]

l

cts

=maxk*λ4*l

wce

maxk*λ5*l

dice (10)

[0120]

λ4、λ5表示过渡性强化损失l

cts

中的带权重的交叉熵损失l

wce

和过渡性强化损失l

cts

中的集合相似度度量损失l

dice

的权重,分别取值0.3、0.4;mask表示过渡区域掩膜,它由双边缘目标图像y和条带目标图像yb计算得到,具体计算公式如下

[0121]

mask=1-(y

b-y) y*17

ꢀꢀ

(11)

[0122]

l

wce

为过渡性强化损失l

cts

中的带权重的交叉熵损失,具体公式如下

[0123]

[0124]

其中,n表示双边缘目标图像y中的像素总数;log(

·

)为对数运算函数,取底数为2;∑为求和运算符;表示条带目标图像yb中属于篡改条带像素的样本权重,表示条带目标图像yb中不属于篡改条带像素的样本权重,公式如下

[0125][0126][0127]

其中,l1(

·

)表示一范数函数,l1(yb)表示统计条带目标图像yb中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数。

[0128]

l

dice

为过渡性强化损失l

cts

中的集合相似度度量损失,具体公式如下

[0129][0130]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示求交运算;x

′b表示粗估网络w1在优化训练过程t2的输出图像;yb表示条带目标图像。

[0131]

5)细估训练过程t3,在训练细估网络w2的细估训练过程t3,固定粗估网络w1的网络参数为粗估网络w1在优化训练过程t2完成后得到的网络参数,使用粗估网络w1在优化训练过程t2的输出图像x

′b和粗估网络w1输出的特征图f作为细估网络w2的输入参数[x

′b,f],其中粗估网络w1输出的特征图f具体是指粗估网络w1中4个上采样块up输出的特征图。细估网络w2的输出图像x=w2(x

′b,f),通过双边缘目标图像y进行约束,细估训练过程t3训练至网络收敛。本发明加入了细估损失l

ref

中的信息熵损失l

ie

、细估损失l

ref

中的关系图损失lr、细估损失l

ref

中的带权重的交叉熵损失l

wce

和细估损失l

ref

中的集合相似度度量损失l

dice

作为损失函数,这些损失函数的加权和记为细估损失l

ref

。细估网络w2与粗估网络w1的网络结构不同,细估网络w2的网络参数如表2所示,细估网络w2的网络结构如图1所示。

[0132]

x=w2(x

′b,f)(16)

[0133]

其中f为粗估网络w1输出的特征图,具体是指粗估网络w1中4个上采样块up输出的特征图;x

′b表示粗估网络w1在优化训练过程t2的输出图像;x表示细估网络w2的输出图像。

[0134]

l

ref

为细估损失,具体公式如下

[0135][0136]

其中,λ6、λ7、λ8、λ9为细估损失l

ref

中的信息熵损失l

ie

、细估损失l

ref

中的带权重的交叉熵损失细估损失l

ref

中的集合相似度度量损失和细估损失l

ref

中的关系图损失lr的权重,取值分别为0.2、0.6、0.4、0.4。漏检惩罚掩膜mask

′

对粗估网络w1在优化训练过程t2的输出图像x

′b与双边缘目标图像y上像素值相同、细估网络w2的输出图像x与双边缘目标图像y上像素值不同的像素施加的权重为2,其他像素的权重设置为1。漏检惩罚掩膜mask

′

的具体计算公式如下

[0137][0138]

其中mask

′

(p)表示漏检惩罚掩膜mask

′

上像素p的掩膜值;x

′b(p)表示粗估网络w1在优化训练过程t2的输出图像x

′b上像素p的像素值;x(p)表示细估网络w2的输出图像x上像素p的像素值;y(p)表示双边缘目标图像y上像素p的像素值;r(

·

)表示取整运算函数,使用

四舍五入法保留整数部分。

[0139]

lr为细估损失l

ref

中的关系图损失,具体公式如下

[0140][0141]

其中,λ

10

和λ

11

分别为细估损失l

ref

中的带权重的交叉熵损失和细估损失l

ref

中的集合相似度度量损失的权重,分别取值0.6和0.4。

[0142]

为关系图损失lr中的集合相似度度量损失,具体公式如下

[0143][0144]

其中,xr表示网络中间特征m的八邻域关系图,它是由网络中间特征m通过8个不同的卷积核计算得到的8通道特征图。网络中间特征m具体是指位于细估网络w2末端的最后一个64层特征。网络中间特征m的八邻域关系图xr和网络中间特征m在细估网络w2中的位置如图1所示。关系图目标图像yr为双边缘目标图像y的八邻域关系图。表示网络中间特征m的八邻域关系图xr的第d个图像通道;表示关系图目标图像yr的第d个图像通道。∑为求和运算符;∩表示求交运算;l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量。遍历双边缘目标图像y中的每一个像素p得到8通道的关系图目标图像yr,关系图目标图像yr的第d个图像通道的具体公式如下

[0145][0146]

其中,y(pd)表示双边缘目标图像y上像素p的八邻域像素中第d个方向的像素pd的像素值;y(p)表示双边缘目标图像y上像素p的像素值;表示关系图目标图像yr的第d个图像通道上像素p的像素值。对于像素p的八邻域像素中第d个方向的像素pd,d的取值[0,7]分别对应方向为左上、正上、右上、正右、右下、正下、左下、正左的先后顺序,并与关系图目标图像yr中通道下标d的取值一一对应。

[0147]

为关系图损失lr中的带权重的交叉熵损失,具体公式如下

[0148][0149]

其中,xr表示网络中间特征m的八邻域关系图,它是由网络中间特征m通过8个不同的卷积核计算得到的8通道特征图。网络中间特征m具体是指位于细估网络w2末端的最后一个64层特征。关系图目标图像yr为双边缘目标图像y的八邻域关系图;表示网络中间特征m的八邻域关系图xr的第d个图像通道;表示关系图目标图像yr的第d个图像通道。关系图目标图像yr为双边缘目标图像y的八邻域关系图;n表示双边缘目标图像y或条带目标图像yb中的像素数量;log(

·

)为对数运算符号,取底数为2;∑为求和运算符;表示关系图目标图像yr的第d个图像通道中属于篡改条带的像素的样本权重,表示关系图目标图像yr的第d个图像通道中不属于篡改条带的像素的样本权重,具体公式如下

[0150]

[0151][0152]

其中,l1(

·

)表示一范数函数,表示统计关系图目标图像yr的第d个图像通道中像素值为1的像素数量;n表示双边缘目标图像y中的像素总数。

[0153]

l

ie

为细估损失l

ref

中的信息熵损失,具体公式如下

[0154][0155]

其中,log(

·

)为对数运算符号,取底数为2;x表示细估网络w2的输出图像;∑为求和运算符。

[0156]

为细估损失l

ref

中的集合相似度度量损失,具体公式如下

[0157][0158]

其中,l1(

·

)表示一范数函数,在此用于统计图像中像素值为1的像素数量;∩表示交运算;y表示双边缘目标图像;x表示细估网络w2的输出图像。

[0159]

为细估损失l

ref

中的带权重的交叉熵损失,具体公式如下

[0160][0161]

其中,n表示双边缘目标图像y或条带目标图像yb中的像素数量;log(

·

)为对数运算符号,取底数为2;x表示细估网络w2的输出图像;∑为求和运算符;w

pos

表示双边缘目标图像y中属于篡改双边缘像素的样本权重,w

neg

表示双边缘目标图像y中不属于篡改双边缘像素的样本权重,公式如下

[0162][0163][0164]

其中,l1(

·

)表示一范数函数,l1(y)表示统计双边缘目标图像y中像素值为1的像素数量;y表示双边缘目标图像;n表示双边缘目标图像y中的像素总数。

[0165]

6)图像二值化,固定粗估网络w1的网络参数为粗估网络w1在优化训练过程t2完成后得到的网络参数,固定细估网络w2的网络参数为细估网络w2在细估训练过程t3完成后得到的网络参数,通过映射函数

[0166][0167]

将细估网络w2的输出图像x进行二值化,即若细估网络w2的输出图像x上像素p的像素值x(p)大于等于0.5,细估网络w2的预测图像x

out

上像素p的像素值x

out

(p)置为1,否则细估网络w2的预测图像x

out

上像素p的像素值x

out

(p)置为0;细估网络w2的预测图像x

out

上像素p的像素值为1表示对应像素p为篡改边缘像素,细估网络w2的预测图像x

out

上像素p的像素值为0表示对应像素p不是篡改边缘像素。

[0168]

7)本发明使用的框架为pytorch框架,在带有nvidia geforce 2080ti gpu和intel core i7-97003.00ghz cpu的pc上实现本发明的框架。w型两阶段卷积神经网络在自主合成数据集上进行训练,在casia ii和coverage公开数据集上进行测试。整个网络由

adam优化器进行优化,初始学习率设置为1e-2。经过每4个epoch,学习率调整为原来的10%。

[0169]

8)以上显示和描述了本发明的基本原理、主要特点和本发明的优点。本行业内的技术人员应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是本发明的原理,在不脱离本发明精神和范围的前提下本发明还会有各种变化和改进,这些变化和改进都落入保护的本发明范围内。本发明要求范围由所附权力要求书及其等同物界定。

[0170]

表1粗估网络w1的主要结构和参数

[0171]

[0172]

[0173]

[0174][0175]

表2细估网络w2的主要结构和参数

[0176]

[0177]

[0178]

[0179]

[0180]

[0181]

。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。