1.本公开涉及显示终端设备。

背景技术:

2.显示终端设备已被开发用于使用增强现实(ar)技术实现服务。显示终端设备的示例包括头戴式显示器(hmd)。hmd包括例如光学透视(see-through)型hmd和视频透视型hmd。

3.在光学透视型hmd中,例如,使用半反射镜或透明导光板的虚拟图像光学系统被保持在用户的眼前。在虚拟图像光学系统内侧显示图像。因此,佩戴光学透视型hmd的用户即使在观看显示在虚拟图像光学系统内侧的图像时也可以观看用户周围的风景。从而,采用ar技术的光学透视型hmd能够根据光学透视型hmd的位置和姿势以各种模式(诸如文本、图标和动画等)在真实空间中存在的对象的光学图像上叠加虚拟对象(以下,可称为“虚拟对象”)的图像(以下,可称为“虚拟对象图像”)。

4.相反,视频透视型hmd由用户佩戴以覆盖用户的眼睛,并且视频透视型hmd的显示器被保持在用户的眼前。此外,视频透视型hmd包括用于捕获用户前面的风景图像的相机模块,并且由相机模块捕获的风景图像被显示在显示器上。因此,虽然佩戴视频透视型hmd的用户难以直接观看用户前面的风景,但用户可以利用显示器上的图像看到用户前面的风景。此外,采用ar技术的视频透视型hmd可以使用用户前面的风景的图像作为真实空间中的背景的图像(以下简称“背景图像”),以根据视频透视型hmd的位置和姿势将虚拟对象图像叠加在背景图像上。在下文中,通过将虚拟对象图像叠加在背景图像上获得的图像可以称为“合成图像”。

5.引用列表

6.专利文献

7.专利文献1:jp2018-517444a

8.专利文献2:jp2018-182511a

技术实现要素:

9.技术问题

10.这里,在视频透视型hmd中使用的ar技术中,虚拟对象图像在背景图像上的叠加是通过软件处理来进行的,这相对需要时间,包括对背景图像的分析等。因此,在视频透视型hmd中,在已经捕获背景图像的时间点和显示包括背景图像的合成图像的时间点之间发生的延迟增加了。此外,背景图像会随着视频透视型hmd的移动而随时改变。

11.从而,当佩戴视频透视型hmd的用户的面部朝向改变时,显示器上背景图像的更新速度有时无法跟随用户面部朝向的变化速度。从而,例如,如图1所示,当佩戴视频透视型hmd的用户的面部朝向从朝向d1改变为朝向d2时,甚至在朝向d2的时间点,有时也在显示器上显示在朝向d1时所捕获的背景图像bi。因此,在用户的面部朝向到达朝向d2的时间点,显示器上显示的背景图像bi与用户前面的实际风景fv不同,从而增加了用户的违和感。

12.此外,在合成图像中包括的背景图像和虚拟对象图像中,虚拟对象图像被叠加在背景图像上,同时如上所述背景图像随着视频透视型hmd的移动而改变。因此,当视频透视型hmd移动时,用户难以识别在已经捕获背景图像的时间点与显示或更新要叠加在背景图像上的虚拟对象图像的时间点之间的延迟,而用户容易识别更新背景图像的延迟。即用户对虚拟对象图像的显示延迟不敏感,而对背景图像的更新延迟敏感。从而,背景图像的所增加的更新延迟增加了用户的违和感。

13.因此,本公开提出了能够减少佩戴诸如采用ar技术的视频透视型hmd的显示终端设备的用户的违和感的技术。

14.问题的解决方案

15.根据本公开,显示终端设备包括cpu、成像单元、合成器和显示器。cpu通过软件处理确定虚拟对象在真实空间中的布置位置,并输出第一图像和指示布置位置的信息,该第一图像是虚拟对象的图像。成像单元捕获第二图像,其是真实空间的图像。合成器基于布置位置通过硬件处理来组合第一图像和第二图像,从而生成合成图像。显示器直接连接到合成器并显示合成图像。

附图说明

16.图1图示了本公开的问题。

17.图2图示了根据本公开实施例的显示终端设备的配置示例。

18.图3图示了根据本公开实施例的显示终端设备中的处理过程的一个示例。

19.图4图示了根据本公开的实施例的图像合成处理。

20.图5图示了根据本公开的实施例的图像合成处理。

21.图6图示了本公开的技术的效果。

具体实施方式

22.下面将参照附图描述本公开的实施例。注意,在以下实施例中,相同的附图标记被附加到相同的部分或相同的处理以省略重复描述。

23.此外,将按照以下项目顺序描述本公开的技术。

24.《显示终端设备的配置》

25.《显示终端设备中的处理过程》

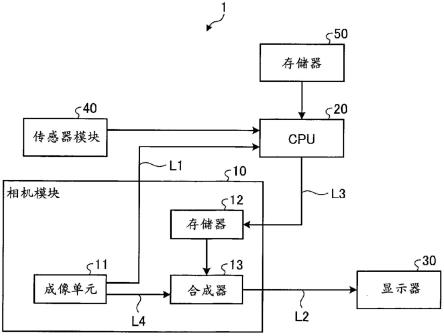

26.《图像合成处理》

27.《公开的技术的效果》

28.《显示终端设备的配置》

29.图2图示了根据本公开实施例的显示终端设备的配置示例。在图2中,显示终端设备1包括相机模块10、中央处理单元(cpu)20、显示器30、传感器模块40和存储器50。相机模块10包括成像单元11、存储器12、以及合成器13。显示终端设备1由显示终端设备1的用户佩戴以覆盖用户的眼睛。显示终端设备1的示例包括视频透视型hmd以及诸如智能手机和平板终端之类的智能设备。当显示终端设备1为智能设备时,该智能设备由该智能设备的用户佩戴,该智能设备带有用于该智能设备的头戴式仪器,以覆盖该用户的眼睛。

30.相机模块10包括线路l1、l2、l3和l4。成像单元11经由线路l1连接到cpu 20,同时

经由线路l4连接到合成器13。存储器12经由线路l3连接到cpu 20。合成器13经由线路l2连接到显示器30。

31.成像单元11包括透镜单元和图像传感器。成像单元11捕获佩戴显示终端设备1的用户前面的风景的图像,使得用户的眼睛由显示终端设备1作为背景图像覆盖。成像单元11将所捕获的背景图像输出到合成器13和cpu 20。成像单元11以预定帧率捕获背景图像。成像单元11一方面经由线路l4将在同一时间点所捕获的相同背景图像输出到合成器13,另一方面经由线路l1将该相同背景图像输出到cpu20。也就是说,相机模块10包括线路l1,由相机模块10捕获的背景图像通过该线路l1从相机模块10输出到cpu 20。

32.传感器模块40检测显示终端设备1的加速度和角速度,以检测显示终端设备1的位置和姿势的变化,并将指示所检测的加速度和角速度的信息(在下文中,可以称为“传感器信息”)输出到cpu 20。传感器模块40的示例包括惯性测量单元(imu)。

33.cpu 20以预定周期基于背景图像和传感器信息执行同步定位与建图(slam)。也就是说,cpu 20基于背景图像和传感器信息在slam中生成环境地图和姿态图。cpu 20利用环境地图识别显示终端设备1所存在的真实空间。cpu 20利用姿态图识别显示终端设备1在所识别的真实空间中的位置和姿势。此外,cpu 20基于生成的环境地图和姿态图确定虚拟对象在真实空间中的布置位置,即,虚拟对象图像在背景图像中的布置位置(以下,可称为“虚拟对象布置位置”)。cpu 20与虚拟对象图像相关联地向存储器12输出指示所确定的虚拟对象布置位置的信息(在下文中,可以称为“布置位置信息”)。cpu20经由线路l3将虚拟对象图像和布置位置信息输出到存储器12。

34.存储器50存储由cpu 20执行的应用和由cpu 20使用的数据。例如,存储器50存储关于虚拟对象的数据(例如,用于再现虚拟对象的形状和颜色的数据)。cpu 20通过使用存储在存储器50中的关于虚拟对象的数据来生成虚拟对象图像。

35.存储器12将从cpu 20以预定周期输入的虚拟对象图像和布置位置信息存储预定时间。

36.合成器13基于存储在存储器12中的虚拟对象图像以及多条布置位置信息中的最新的虚拟对象图像和布置位置信息,通过将虚拟对象图像叠加在背景图像上来生成合成图像。也就是说,合成器13通过将最新的虚拟对象图像叠加在从成像单元11输入的最新背景图像上由布置位置信息指示的位置处来生成合成图像。合成器13经由线路l2将生成的合成图像输出到显示器30。也就是说,相机模块10包括线路l2,由相机模块10生成的合成图像通过该线路l2从相机模块10输出到显示器30。

37.合成器13被实现为硬件,并且通过例如由有线逻辑创建的电子电路来实现。即,合成器13通过硬件处理,通过组合背景图像和虚拟对象图像来生成合成图像。此外,合成器13和显示器30经由线路l2通过硬件直接相互连接。

38.显示器30显示从合成器13输入的合成图像。这使得通过将虚拟对象图像叠加在背景图像上获得的合成图像被显示在佩戴显示终端设备1的用户的眼前。

39.这里,相机模块10和显示器30两者符合相同的接口标准,例如,移动工业处理器接口(mipi)标准。当相机模块10和显示器30两者符合mipi标准时,由成像单元11捕获的背景图像通过根据mipi标准的相机串行接口(csi)被串行传输到合成器13。由合成器13生成的合成图像通过根据mipi标准的显示器串行接口(dsi)被串行传输到显示器30。

40.《显示终端设备中的处理过程》

41.图3图示了根据本公开实施例的显示终端设备中的处理过程的一个示例。

42.图3中的相机模块驱动器、传感器模块驱动器、slam应用和ar应用是存储在存储器50中并由cpu 20执行的软件。相比之下,相机模块10、传感器模块40和显示器30是硬件。图3中的相机模块驱动器是相机模块10的驱动器。图3中的传感器模块驱动器是传感器模块40的驱动器。

43.在图3中,在步骤s101中,相机模块10将背景图像输出到cpu20。在步骤s103中,输入到cpu 20的背景图像经由相机模块驱动器被传递给slam应用。

44.此外,与步骤s101中的处理并行地,在步骤s105中传感器模块40将传感器信息输出到cpu 20。在步骤s107中,输入到cpu 20的传感器信息经由传感器模块驱动器被传递给slam应用。

45.然后,在步骤s109中,slam应用基于背景图像和传感器信息执行slam,以在slam中生成环境地图和姿态图。

46.然后,在步骤s111中,slam应用将在步骤s109中生成的环境地图和姿态图传递给ar应用。

47.然后,在步骤s113中,ar应用基于环境地图和姿态图确定虚拟对象布置位置。

48.然后,在步骤s115中,ar应用将虚拟对象图像和布置位置信息输出到相机模块10。将输入到相机模块10的虚拟对象图像和布置位置信息相互关联,并且存储在存储器12中。

49.在步骤s117中,相机模块10基于存储在存储器12中的虚拟对象图像以及多条布置位置信息中的最新的虚拟对象图像和布置位置信息,通过将虚拟对象图像叠加在背景图像上来生成合成图像。

50.然后,在步骤s119中,相机模块10将在步骤s117中生成的合成图像输出到显示器30。

51.然后,在步骤s121中,显示器30显示在步骤s119中输入的合成图像。

52.《图像合成处理》

53.图4和图5示出了根据本公开实施例的图像合成处理。

54.如图4所示,合成器13通过针对在每帧的背景图像bi的水平方向(行方向)上的每一行将虚拟对象图像vi叠加在背景图像bi上来生成合成图像ci。

55.例如,成像单元11、合成器13和显示器30如图5所示基于垂直同步信号vsync和水平同步信号hsync操作。在图5中,“vsync 1”指示在垂直同步信号vsync0的后一个信号输入的垂直同步信号,并且“vsync-1”指示在垂直同步信号vsync0的前一个信号输入的垂直同步信号。此外,图5作为一个示例示出了输入五个水平同步信号hsync同时输入一个垂直同步信号vsync的情况。

56.在图5中,成像单元11根据水平同步信号hsync将针对背景图像bi的每一行的yuv数据(一行yuv)输出到合成器13。

57.合成器13将从成像单元11输入的yuv数据转换成rgb数据。此外,合成器13针对每一行根据水平同步信号hsync和布置位置信息,将虚拟对象图像vi的rgb数据(vi rgb)叠加在背景图像bi的rgb数据上。从而,在虚拟对象图像vi存在的行中,合成图像的rgb数据(合成rgb)从合成器13输出到显示器30并显示。在虚拟对象图像vi不存在(无图像)的行中,背

景图像bi的rgb数据(一行rgb)从合成器13原样输出到显示器30并显示。

58.上面已经描述了本公开的技术的实施例。

59.注意,图2图示了显示终端设备1的配置。在该配置中,相机模块10包括存储器12和合成器13。然而,显示终端设备1也可以采用其中存储器12和合成器13之一或两者设置在相机模块10外部的配置。

60.《公开的技术的效果》

61.如上所述,根据本公开的显示终端设备(根据实施例的显示终端设备1)包括cpu(根据实施例的cpu 20)、成像单元(根据实施例的成像单元11)、合成器(根据实施例的合成器13)和显示器(根据实施例的显示器30)。cpu通过软件处理确定虚拟对象在真实空间中的布置位置(根据实施例的虚拟对象布置位置),并输出作为虚拟对象的图像的第一图像(根据实施例的虚拟对象图像)以及指示布置位置的信息(根据实施例的布置位置信息)。成像单元捕获第二图像(根据实施例的背景图像),其是真实空间的图像。合成器通过基于布置位置通过硬件处理组合第一图像和第二图像来生成合成图像。显示器直接连接到合成器,并显示合成图像。

62.例如,包括成像单元和合成器的相机模块包括第一线路(根据实施例的线路l1)和第二线路(根据实施例的线路l2)。第一图像通过第一线路从相机模块输出到cpu。合成图像通过第二线路从相机模块输出到显示器。

63.此外,例如,合成器针对第二图像的水平方向上的每一行组合第一图像和第二图像。

64.此外,例如,相机模块和显示器两者符合mipi标准。

65.此外,例如,cpu通过基于第二图像执行slam来生成环境地图和姿态图,并且基于环境地图和姿态图来确定布置位置。

66.根据上述配置,由成像单元捕获的背景图像被输出到被直接连接到合成器的显示器,而不经过由cpu执行的软件处理,使得背景图像被成像单元捕获后立即被显示在显示器上。因此,可以减少在已经捕获背景图像的时间点与显示包括背景图像的合成图像的时间点之间发生的延迟。因此,当佩戴根据本公开的显示终端设备的用户的面部朝向改变时,显示器上的背景图像可以被更新以跟随用户面部朝向的改变。从而,例如,如图6所示,当佩戴根据本公开的显示终端设备的用户的面部朝向从朝向d1改变为朝向d2时,在用户的面部朝向达到朝向d2时所捕获的背景图像bi在朝向d2时被显示在显示器上。因此,在用户的面部朝向到达朝向d2的时间点,在显示器上显示的背景图像bi与用户面前的实际风景fv之间的差异减小到用户难以识别该差异的程度。从而,根据上述配置,可以减少佩戴显示终端设备的用户的违和感。

67.注意,说明书中阐述的效果仅仅是示例而非限制。可能会表现出其他效果。

68.此外,本公开的技术还可以采用如下配置。

69.(1)一种显示终端设备,包括:

70.cpu,通过软件处理确定虚拟对象在真实空间中的布置位置,并输出第一图像和指示所述布置位置的信息,所述第一图像是虚拟对象的图像;

71.捕获第二图像的成像单元,所述第二图像是真实空间的图像;

72.合成器,基于所述布置位置通过硬件处理来组合第一图像和第二图像,从而生成

合成图像;和

73.直接连接到合成器并显示所述合成图像的显示器。

74.(2)根据(1)所述的显示终端设备,还包括

75.包括所述成像单元和所述合成器的相机模块,

76.其中,相机模块包括:第一线路,第一图像通过所述第一线路从相机模块输出到cpu;和第二线路,合成图像通过所述第二线路从相机模块输出到显示器。

77.(3)根据(1)或(2)所述的显示终端设备,

78.其中,合成器针对第二图像的水平方向上的每一行组合第一图像和第二图像。

79.(4)根据(2)所述的显示终端设备,

80.其中,相机模块和显示器两者符合mipi标准。

81.(5)根据(1)至(4)中任一项所述的显示终端设备,

82.其中,cpu通过基于第二图像执行slam来生成环境地图和姿态图,并基于环境地图和姿态图确定所述布置位置。

83.附图标记列表

84.1显示终端设备

85.10相机模块

86.11成像单元

87.13合成器

88.20cpu

89.30显示器

90.40传感器模块

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。