:

1.本发明涉及智能网联汽车和智能交通系统领域,具体地说是一种对智能网联汽车的高精度定位技术和车路协同的智能网联汽车用路基视觉定位图像处理算法及系统。

背景技术:

2.目前,无人驾驶汽车在室外环境下的定位主要依赖于高精度gps、多线激光雷达、摄像头等传感器进行感知定位。高精度gps在室外空旷条件下可得到较高精度的全局定位,但在室内或者室外遮挡环境下存在局部定位精度差或丢失定位的问题,无法满足无人驾驶汽车的定位要求。

3.地图匹配定位技术也可用于无人驾驶汽车的定位,当车辆在结构化室外环境或者室内环境时,可提前建立该环境的二维栅格地图,车辆行驶时将激光雷达扫描点云数据与已知二维栅格地图进行地图匹配,从而得到车辆在局部环境下的高精度定位。但地图匹配需要提前对行驶环境进行建图,对行驶环境条件有要求,只能用于无人驾驶汽车局部定位。

技术实现要素:

4.本发明针对现有技术中智能网联汽车的高精度定位问题,提出了一种能够解决大范围室内外复杂场景下的车辆定位问题,同时可提高车辆的定位精度,相比传统gps定位方法具有定位范围广、定位精度高的优点的基于路基摄像头与特征点提取匹配的智能网联汽车用路基视觉定位图像处理算法及系统。

5.本发明通过以下措施达到:

6.一种智能网联汽车用路基视觉定位图像处理算法,其特征在于,包括以下步骤:

7.步骤1:读取当前时刻的每个摄像头的视频图像;

8.步骤2:对每个摄像头的视频信息前后景分离;

9.步骤3:对前景图像进行特征点提取和卷积神经网络目标检测,对同一时刻(k时刻)的各个摄像头前景图像采用oriented fast算法进行特征点提取和卷积神经网络目标检测;

10.步骤4:对各摄像头图像进行特征点匹配;采用steered brief多目匹配算法对同时刻的多幅图像进行特征点匹配,图像旋转时每个关键点所在图像块中的质心也会跟着旋转从而做到这个坐标方向会随着图像旋转而旋转,也就是说实现了旋转不变性,具体公式如下,首先定义一个二进制操作:

[0011][0012]

其中p(x)代表在x处的强度p,因此描述子就是n个二进制操作结果的组合,如下所示:

[0013]

[0014]

对于长度为n的描述子,挑选得到n个匹配对,定义为2

×

n的矩阵

[0015][0016]

得到关键点的旋转方向后得到对应的旋转矩阵,之后构造一个旋转的匹配对矩阵

[0017]sθ

=r

θs[0018]

则描述子公式如下:

[0019]gn

(p,θ):=fn(p)|(xi,yi)∈s

θ

[0020]

利用汉明距离小于最小距离的两倍为筛选的依据结合去除误匹配的算法实现特征点的匹配,之后对摄像头进行内外参数的标定将匹配成功的特征点进行二维到三维的转换,从而实现车辆三维空间求解进而形成对应的特征点云;由小孔成像模型可知像素坐标系与相机坐标系的转换关系如下:

[0021][0022]

f为焦距,dx和dy分别是每个像素在图像平面x和y方向上的物理尺寸,矩阵k即为相机的内参矩阵,其参数由相机自身的参数决定;对于现实空间中已知的坐标系上的点,通过刚体变换将其坐标转移到相机坐标系下,刚体变换包括旋转变换和平移变换,设世界坐标系中点的坐标为(xw,yw,zw)

t

,相机坐标系中点的坐标为(xc,yc,zc)

t

则二者之间的变换关系如下:

[0023][0024]

其中,r是一个3

ⅹ

3的旋转矩阵,t是一个3

ⅹ

1的平移向量,[r t]称为相机的外参矩阵,相机的外参矩阵和相机的属性没有关系,只表示坐标系的刚体变换,则像素坐标系与世界坐标系的关系为:

[0025][0026]

步骤5:将卷积神经网络对图像的检测结果和特征点云数据融合,去除误匹配和飞点数据;

[0027]

步骤6:根据多摄像头特征点匹配的结果和摄像头内外参数进行多目视觉特征点坐标转换,获取三维空间特征点云;

[0028]

步骤7:对连续的多个时刻的融合后数据进行滤波和多目标跟踪,获得视野内所有车辆的高精度定位信息、运行状态和车辆外观特征信息;

[0029]

步骤8:通过车载网络终端和路基车联网终端的通讯获得视野内所有车辆的低精度gps/bd定位信息、运行状态和车辆外观特征信息,采用最小二乘法实现所有车辆信息的匹配;

[0030]

步骤9:根据匹配的结果将高精度定位信息发送给对应的车载网络终端,为车辆提供高精度定位服务。

[0031]

本发明步骤3中特征点的尺度不变性由构建图像金字塔并在金字塔的每一层上检测角点来实现,而特征的旋转是由灰度质心法实现,质心是指以图像块灰度值作为权重的中心,具体的操作步骤如下:

[0032]

步骤3-1:在一个小的图像块b中,定义图像块的矩为:

[0033][0034]

步骤3-2:通过矩找到图像块的质心:

[0035][0036]

步骤3-3:连接图像块的几何中心o与质心c,得到一个方向向量于是特征点的方向可定义为:

[0037]

θ=arctan(m

01

/m

10

)

[0038]

通过提取出来的特征点便具有尺度与旋转的描述,大大提升它们在不同图像之间表述的鲁棒性。

[0039]

本发明步骤2中对每个摄像头的视频信息前后景分离包括:首先对连续的三帧图片进行平滑去噪,在分别做帧差法处理,用第k帧图片减去第k-1帧图片,得到二值图像d1(x,y),再用第k 1帧图片减去第k帧图片,得到二值图像d2(x,y),最后用d1(x,y)和d2(x,y)进行“与”运算,即可得到三帧差法图像d(x,y),具体公式表示为:

[0040][0041][0042][0043]

式中,t为预先设定的阈值,根据经验选取,若t选取过大,则检测目标可能出现较大的空洞或者是漏检,若t选取过小,将会出现大量噪声。

[0044]

本发明还提出了一种智能网联汽车用路基视觉定位图像处理系统,其特征在于,设有路基摄像头、边缘计算终端、路基车辆网终端和车载车联网终端,其中路基摄像头包含两个以上的摄像机,路基摄像头同步采集同一区域内不同角度的视觉图像后,将每一帧图像及图像时间标记发送给边缘计算终端;

[0045]

边缘计算终端运行上述智能网联汽车用路基视觉定位图像处理方法,实现对视野内所有车辆的实时定位测量和特征提取,获得高精度的车辆信息,包括位置、运行状态、车型、外观;

[0046]

路基车联网终端与视野内的所有智能网联汽车的车载网络终端实现动态组网,并接收智能网联汽车的实时低精度gps位置、运行状态和车辆外观信息;

[0047]

边缘计算终端从路基车联网终端获取组网范围内所有智能网联汽车的低精度gps位置、运行状态和车辆外观信息,并于自身视觉测量获取的所有车辆信息进行对比和匹配,实现高精度车辆信息和智能网联汽车的配对;

[0048]

根据配对的结果,路基车联网终端将每个智能网联汽车对应的高精度定位信息发送给对应的车载网络终端,为智能网联汽车提供定位服务。

[0049]

本发明采用多目视觉和卷积神经网络算法,可以实时的实现摄像头视野内的车辆位置和运行状态测量。在5g车联网的高速通讯技术的支持下,可以为智能网联汽车实时的提供高精度的定位信息服务。

附图说明:

[0050]

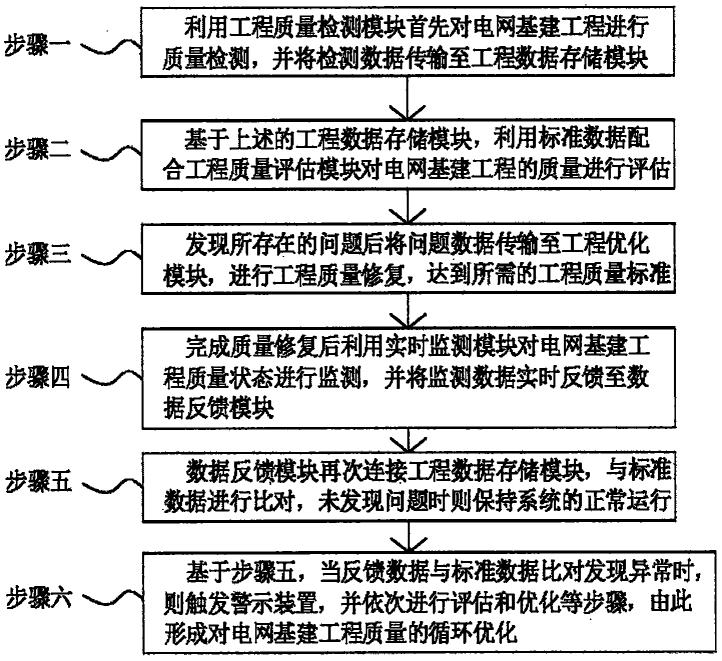

附图1是本发明的流程图。

[0051]

附图2是本发明的系统图。

具体实施方式:

[0052]

下面结合附图对本发明做进一步的说明。

[0053]

本发明提出了一种服务于智能网联汽车的路基视觉定位系统及图像处理算法,包括路基摄像头(多个)、边缘计算终端、路基车联网终端、车载网络终端共四个部分组成。其特征在于摄像头用于获取同一区域内多角度的图像信息;边缘计算终端用于运行核心算法,用于图像处理及车辆定位;路基车联网终端和车载网络终端用于车路协同中的信息通讯;

[0054]

用于车辆定位的图像信息来自于路基的多个固定摄像头,摄像头的图像采集由同一个信号同步控制。通过对同一区域的多角度图像进行特征点提取、跟踪和匹配,最终实现车辆的识别和高精度定位;

[0055]

采用边缘计算实现快速的图像处理和高吞吐量的网络信息传输,以满足智能网联汽车高实时性的要求;

[0056]

其核心算法实现车辆定位服务的步骤如下:

[0057]

步骤1:对每个摄像头的视频信息前后景分离,取出所有前景图像数据;

[0058]

步骤2:对同一时刻(k时刻)的各个摄像头前景图像进行特征点提取和卷积神经网络目标检测;

[0059]

步骤3:采用多目匹配算法对同时刻的多幅图像进行特征点匹配,对匹配成功的特征点进行三维空间求解,形成特征点云;

[0060]

步骤4:将卷积神经网络对图像的检测结果和特征点云数据融合,去除误匹配和飞点数据;

[0061]

步骤5:对连续的多个时刻的融合后数据进行滤波和多目标跟踪,获得视野内所有

车辆的高精度定位信息、运行状态和车辆外观特征等信息;

[0062]

步骤6:通过车载网络终端和路基车联网终端的通讯获得视野内所有车辆的低精度gps/bd定位信息、运行状态和车辆外观特征信息,采用最小二乘法实现所有车辆信息的匹配;

[0063]

步骤7:根据匹配的结果将高精度定位信息发送给对应的车载网络终端,为车辆提供高精度定位服务。

[0064]

算法的主要计算部分都运行于摄像头附近的边缘计算终端,每个边缘计算终端负责若干个摄像头,所有的边缘计算终端通过高速网络连接,形成分布式边缘计算系统,从而可以提供全路段的车辆高精度定位服务。

[0065]

所述的视觉定位系统和核心算法,gps/bd数据不是必须的。在无gps/bd信号的隧道或遮挡场景下,依然可以通过车辆速度和外观信息等完成车辆信息和视觉定位系统信息的匹配,提供智能网联汽车的高精度定位。

[0066]

实施例1:

[0067]

本例提供了一种智能网联汽车用路基视觉定位图像处理算法及系统,其中系统组成如图1所示,定位系统主要由四部分组成:路基摄像头,边缘计算终端,路基车辆网终端和车载车联网终端;定位系统基本工作过程描述如下:

[0068]

(1)路基摄像头同步采集同一区域内不同角度的视觉图像;

[0069]

(2)摄像头将每一帧图像及图像时间标记发送给边缘计算终端;

[0070]

(3)边缘计算终端运行本发明提出的核心算法,实现对视野内所有车辆的实时定位测量和特征提取,获得高精度的车辆信息,包括位置、运行状态、车型、外观等;

[0071]

(4)路基车联网终端与视野内的所有智能网联汽车的车载网络终端实现动态组网,并接收智能网联汽车的实时低精度gps位置、运行状态和车辆外观等信息;

[0072]

(5)边缘计算终端从路基车联网终端获取组网范围内所有智能网联汽车的低精度gps位置、运行状态和车辆外观信息,并于自身视觉测量获取的所有车辆信息进行对比和匹配,实现高精度车辆信息和智能网联汽车的配对;

[0073]

(6)根据配对的结果,路基车联网终端将每个智能网联汽车对应的高精度定位信息发送给对应的车载网络终端,为智能网联汽车提供定位服务。

[0074]

在以上的系统组成及工作过程中,其关键技术特征有以下内容:

[0075]

(1)多个路基摄像头视野重叠区域为本系统可提供精确定位服务的区域;

[0076]

(2)多个路基摄像头的图像采集具有同步采集能力;

[0077]

(3)边缘计算终端对同时刻的多角度图像进行多目视觉运算获得特征点云,并对不同时刻的特征点云进行匹配和跟踪,从而获得高精度三维空间定位;

[0078]

(4)边缘计算终端通过车联网获取智能车辆的外观特征和运行状态,并对比通过路基摄像头获取的高精度三维定位信息,从而实现车辆信息的匹配。

[0079]

在本例中,路基摄像头的图像处理算法在边缘计算终端中运行,其算法流程如图2所示,具体的步骤表述如下:

[0080]

步骤1:读取当前时刻的每个摄像头的视频图像;

[0081]

步骤2:对每个摄像头的视频信息前后景分离。首先对连续的三帧图片进行平滑去噪,在分别做帧差法处理,用第k帧图片减去第k-1帧图片,得到二值图像d1(x,y),再用第k

1帧图片减去第k帧图片,得到二值图像d2(x,y),最后用d1(x,y)和d2(x,y)进行“与”运算,即可得到三帧差法图像d(x,y),具体公式表示为:

[0082][0083][0084][0085]

式中,t为预先设定的阈值,根据经验选取,若t选取过大,则检测目标可能出现较大的空洞或者是漏检,若t选取过小,将会出现大量噪声。

[0086]

步骤3:对前景图像进行特征点提取和卷积神经网络目标检测,对同一时刻(k时刻)的各个摄像头前景图像采用oriented fast算法进行特征点提取和卷积神经网络目标检测,特征点的尺度不变性由构建图像金字塔并在金字塔的每一层上检测角点来实现。而特征的旋转是由灰度质心法实现,质心是指以图像块灰度值作为权重的中心,具体的操作步骤如下:

[0087]

1.在一个小的图像块b中,定义图像块的矩为:

[0088][0089]

2.通过矩可以找到图像块的质心:

[0090][0091]

3.连接图像块的几何中心o与质心c,得到一个方向向量于是特征点的方向可以定义为:

[0092]

θ=arctan(m

01

/m

10

)

[0093]

通过上述方法提取出来的特征点便具有尺度与旋转的描述,大大提升他们在不同图像之间表述的鲁棒性。

[0094]

步骤4:对各摄像头图像进行特征点匹配;采用steered brief多目匹配算法对同时刻的多幅图像进行特征点匹配,图像旋转时每个关键点所在图像块中的质心也会跟着旋转从而做到这个坐标方向会随着图像旋转而旋转,也就是说实现了旋转不变性。具体公式如下,首先定义一个二进制操作:

[0095][0096]

其中p(x)代表在x处的强度p,因此描述子就是n个二进制操作结果的组合,如下所示:

[0097][0098]

对于长度为n的描述子,我们需要挑选得到n个匹配对,定义为2

×

n的矩阵

[0099][0100]

得到关键点的旋转方向后可以得到对应的旋转矩阵,之后构造一个旋转的匹配对矩阵

[0101]sθ

=r

θs[0102]

则描述子公式如下:

[0103]gn

(p,θ):=fn(p)|(xi,yi)∈s

θ

[0104]

利用汉明距离小于最小距离的两倍为筛选的依据结合去除误匹配的算法实现特征点的匹配,之后对摄像头进行内外参数的标定将匹配成功的特征点进行二维到三维的转换,从而实现车辆三维空间求解进而形成对应的特征点云。由小孔成像模型可知像素坐标系与相机坐标系的转换关系如下:

[0105][0106]

f为焦距,dx和dy分别是每个像素在图像平面x和y方向上的物理尺寸,矩阵k即为相机的内参矩阵,其参数由相机自身的参数决定。

[0107]

对于现实空间中已知的坐标系(世界坐标系)上的点,可以通过刚体变换将其坐标转移到相机坐标系下,刚体变换包括旋转变换和平移变换。设世界坐标系中点的坐标为(xw,yw,zw)

t

,相机坐标系中点的坐标为(xc,yc,zc)

t

则二者之间的变换关系如下。

[0108][0109]

其中,r是一个3

ⅹ

3的旋转矩阵,t是一个3

ⅹ

1的平移向量,[r t]称为相机的外参矩阵。相机的外参矩阵和相机的属性没有关系,只表示坐标系的刚体变换,则像素坐标系与世界坐标系的关系为:

[0110][0111]

步骤5:将卷积神经网络对图像的检测结果和特征点云数据融合,去除误匹配和飞点数据;

[0112]

步骤6:根据多摄像头特征点匹配的结果和摄像头内外参数进行多目视觉特征点坐标转换,获取三维空间特征点云;

[0113]

步骤7:对连续的多个时刻的融合后数据进行滤波和多目标跟踪,获得视野内所有车辆的高精度定位信息、运行状态和车辆外观特征等信息;

[0114]

步骤8:通过车载网络终端和路基车联网终端的通讯获得视野内所有车辆的低精度gps/bd定位信息、运行状态和车辆外观特征信息,采用最小二乘法实现所有车辆信息的匹配;

[0115]

步骤9:根据匹配的结果将高精度定位信息发送给对应的车载网络终端,为车辆提供高精度定位服务。

[0116]

本发明提出的基于路基摄像头的高精度车辆定位系统,采用多目视觉和卷积神经网络算法,可以实时的实现摄像头视野内的车辆位置和运行状态测量。在5g车联网的高速通讯技术的支持下,可以为智能网联汽车实时的提供高精度的定位信息服务。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。