用于远程控制环境中的设备的系统和方法

1.相关申请的交叉引用

2.本技术要求2019年11月25日提交的第62/940,121号美国临时专利申请的优先权和权益,该美国临时专利申请通过引用以其整体并入本文。

发明领域

3.本技术总体涉及能够与其中对象可以被远程控制的环境进行交互的系统和方法。环境可以是真实世界环境或扩展现实(xr)环境,诸如增强现实(ar)环境、虚拟现实(vr)环境和/或混合现实(mr)环境。更具体地,本技术涉及使得能够基于用户的神经肌肉活动生成环境的三维(3d)地图的系统和方法,以及利用这样的3d地图使得用户能够经由用户的神经肌肉活动在环境中执行控制操作以及经由用户的神经肌肉活动与环境中的对象和/或一个或更多个其他人执行交互的系统和方法。

4.背景

5.真实世界的环境可以经由所谓的“物联网”(iot)技术来远程控制。通常,可控对象(本文称为“智能设备”)连接到网络(例如因特网或环境的专用局域网(lan)),并通过经由网络(无线地或经由硬连线)传递到智能设备的信号来控制。在不物理触碰智能设备的情况下,用户可以经由输入到计算机、智能手机、平板电脑等的指令和/或经由例如(美国加利福尼亚州库比蒂诺的apple公司)、(美国华盛顿州西雅图amazon.com公司)等(本文统称为“siri/alexa”)的语音命令来控制智能设备。为了输入指令,可能需要执行多个步骤以访问特定的控制接口,从而可以为智能设备输入指令。如将理解的,对不同智能设备的控制可能需要访问不同的控制接口。还要理解的是,在背景噪声(例如,在喧闹的聚会上)需要大声喊出语音命令以便被siri/alexa接收的情况下,或者在期望安静的情况下(例如,在录制钢琴演奏时),语音指令可能是不方便的。

6.xr环境系统为用户提供真实世界环境的补充有虚拟信息的交互体验,其中在真实世界环境的多个方面上叠加计算机生成的感知信息或虚拟信息。存在用于控制用于产生xr环境的xr系统的操作以及用于与xr环境交互的各种技术。用于控制xr系统的操作和/或与xr环境交互的当前技术具有许多缺陷,因此需要改进技术。

7.概述

8.根据本发明,提供了一种用于对设备进行远程控制的计算机化系统。该系统包括:多个神经肌肉传感器;至少一个相机;以及至少一个计算机处理器。多个神经肌肉传感器被配置成感测来自用户的神经肌肉信号,并被布置在至少一个可穿戴设备上,该至少一个可穿戴设备被构造成由用户穿戴以获得神经肌肉信号。至少一个相机被配置成捕获关于环境的信息。至少一个计算机处理器被编程为基于由至少一个相机捕获的关于所述环境的信息来访问环境的地图信息。地图信息包括用于控制环境中的至少一个可控对象的信息。至少一个计算机处理器还被编程为响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别的神经肌肉活动(可选地,预定的神经肌肉活动或目标神经肌肉活动),控制至少一个可控对象从第一状态改变到第二状态。

9.可选地,将环境的地图信息存储在存储器中。可选地,至少一个计算机处理器基于从由至少一个相机捕获的关于环境的信息中辨别的信息从存储器中检索地图信息。

10.可选地,辨别的信息在环境中是可见的。可选地,辨别的信息包括以下至少一个:qr码;图形符号;字母数字文本串;具有特定形状的3d对象;和/或至少两个对象之间的物理关系。

11.可选地,辨别的信息包括环境的参考对象。

12.可选地,地图信息包括表示环境中两个或更多个可控对象之间的物理关系的地图数据。

13.可选地,地图数据是环境中的对象的3d全景数据,对象包括至少一个可控对象。可选地,3d全景数据包括环境的360

°

表示。可选地,3d全景数据包括相对于单个旋转轴的数据。可选地或附加地,3d全景数据可以包括环境的局部视图的表示。

14.可选地,环境是包括虚拟对象和真实世界对象的扩展现实(xr)环境。可选地,至少一个计算机处理器被编程为根据地图信息确定虚拟对象的位置信息和真实世界对象的位置信息,并可选地,根据由至少一个照相机捕获的关于环境的信息确定环境中的参考对象。可选地,地图信息包括至少一个可控对象相对于参考对象的位置信息。

15.可选地,从由多个神经肌肉传感器感测的神经肌肉信号中辨别的神经肌肉活动是当用户在环境中时由用户相对于至少一个可控对象激活特定运动单位(motor-unit)引起的。

16.可选地,从由多个神经肌肉传感器感测的神经肌肉信号中辨别的神经肌肉活动是当用户在环境中时由用户相对于至少一个可控对象执行至少一个姿态(gesture)引起的。

17.可选地,至少一个姿态可以包括以下中的一个或更多个:用户相对于至少一个可控对象移动至少一个手指;用户相对于至少一个可控对象移动手腕;用户相对于至少一个可控对象移动手臂;用户施加力但相对于至少一个可控对象不移动;和/或用户激活运动单位但相对于至少一个可控对象不移动并且没有相对于至少一个可控对象的力。

18.可选地,至少一个姿态包括以下中的至少一个:用户使用两个或更多个手指执行相对于至少一个可控对象的捏合动作(pinching motion);用户相对于至少一个可控对象向上或向下倾斜手腕;和/或用户相对于至少一个可控对象向上或向下移动至少一个手指。

19.可选地,至少一个可控对象包括多个可控对象。可选地,至少一个姿态包括相对于多个可控对象中的一个可控对象的姿态。可选地,至少一个计算机处理器被编程为响应于控制信号,控制多个可控对象中的每一个可控对象从第一状态改变到第二状态。

20.根据本发明,还提供了一种可穿戴电子设备,其包括:被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器,该多个神经肌肉传感器被布置在被构造成由用户穿戴以获得神经肌肉信号的至少一个可穿戴设备上;能够捕获关于环境的信息的至少一个相机;以及至少一个计算机处理器,该至少一个计算机处理器被编程为基于由至少一个相机捕获的关于环境的信息来访问环境的地图信息,该地图信息包括用于控制环境中的至少一个可控对象的信息,并且该至少一个计算机处理器被编程为响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别的神经肌肉活动,控制至少一个可控对象从第一状态改变到第二状态。

21.可选地,环境至少是以下中的至少一个:家中的房间;公司里的房间;多层建筑的

楼层;和/或室外区域。

22.可选地,至少一个可控对象包括以下中的至少一个:显示设备;电子游戏机(game);窗帘;灯;音响系统;锁;和/或食品或饮料制备设备。

23.根据本发明,还提供了一种计算机实现的方法,该方法包括:激活被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器,该多个神经肌肉传感器被布置在被构造成由用户穿戴以获得所述神经肌肉信号的至少一个可穿戴设备上;激活能够捕获关于环境的信息的至少一个相机;基于由至少一个相机捕获的关于环境的信息来访问环境的地图信息,该地图信息包括用于控制环境中的至少一个可控对象的信息;以及响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别的神经肌肉活动,控制至少一个可控对象从第一状态改变到第二状态。

24.一种电子装置,其可选地包括:可穿戴载体;附着于所述载体的多个神经肌肉传感器;相机系统;以及至少一个计算机处理器,该至少一个计算机处理器被配置成与多个神经肌肉传感器和相机系统进行电子通信。

25.根据本文描述的技术的各方面,提供了一种用于执行交互的计算机化系统。该系统包括:多个神经肌肉传感器、相机系统以及至少一个计算机处理器。多个神经肌肉传感器可以被配置成感测来自用户的神经肌肉信号,并且可以被布置在由用户穿戴以获得神经肌肉信号的至少一个可穿戴设备上。相机系统可以被配置成捕获关于环境的信息,并且可以包括成像部分和深度确定部分。至少一个计算机处理器可以被编程为:从相机系统接收捕获的信息并且从多个神经肌肉传感器接收神经肌肉信号;从捕获的信息中辨别环境;访问与从捕获的信息中辨别的环境相关联的控制信息,控制信息包括用于执行与环境相关联的至少一个功能的信息;以及,响应于从神经肌肉信号中辨别的预定的神经肌肉活动或目标神经肌肉活动,使得所述至少一个功能被执行。针对这些方面还提供了方法和存储有用于实现这些方法的可执行代码的计算机可读存储介质。

26.一种用于获得3d地图的计算机化系统,其可选地包括:多个神经肌肉传感器;至少一个相机;以及至少一个计算机处理器。多个神经肌肉传感器可以被配置成感测来自用户的神经肌肉信号,并且可以被布置在被构造成由用户穿戴以获得神经肌肉信号的至少一个可穿戴设备上。至少一个相机可以被配置成捕获关于环境中的对象的信息。至少一个计算机处理器可耦合到存储器,并可被编程为:基于由至少一个相机捕获的信息生成环境的3d地图,并使3d地图存储在所述存储器中。3d地图可以包括识别环境中的对象的信息。例如,识别的对象可以是智能设备。描述了与用于获得3d地图的计算机化系统相对应的方法和存储有用于实现这些方法的可执行代码的计算机可读存储介质。

27.应当认识到,前述概念和下面较详细讨论的另外的概念的所有组合(假设这样的概念不是相互不一致的)被设想为本文公开的创造性技术的一部分。此外,在本说明书最终所主张的主题的所有组合被设想为本文公开的创造性技术的一部分。

28.附图简述

29.参考下面的附图来描述技术的各种非限制性实施例。应当认识到,附图不一定按比例绘制。

30.图1是根据本文所述技术的一些实施例的用于处理传感器数据和相机数据(诸如从神经肌肉传感器获得的感测信号和从相机获得的图像数据)的基于计算机的系统的框

图;

31.图2a-图2d示意性地示出了根据本文所述技术的一些实施例的贴片型可穿戴系统,其上结合有传感器电子器件;

32.图3示出了根据本文所述技术的一些实施例的具有布置在可调节带上的神经肌肉传感器的可穿戴系统;

33.图4a示出了根据本文所述技术的一些实施例的具有围绕带周向地布置的16个神经肌肉传感器的可穿戴系统;以及图4b是穿过图4a所示的16个神经肌肉传感器中的一个的横截面图;

34.图5是示出根据本文所述技术的一些实施例的基于计算机的系统的部件的框图,该基于计算机的系统包括可穿戴部分和加密狗部分;

35.图6示意性地示出了根据本文所述技术的一些实施例的可在一个或更多个系统中使用的相机;

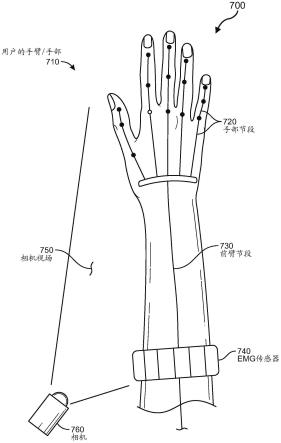

36.图7是示意性地示出了根据本文所述技术的一些实施例的相机和具有布置在臂上的神经肌肉传感器的可穿戴系统的示例实现方式的图示;

37.图8a是示意性地示出了根据本文所述技术的一些实施例的具有布置在臂上的相机和神经肌肉传感器的可穿戴系统的另一示例实现方式的图;

38.图8b和图8c示意性地示出了根据本文所述技术的一些实施例的图8a的相机的垂直取向和轴向取向;

39.图8d示出了根据本文所述技术的一些实施例的包括可以旋转的相机的可穿戴系统;

40.图9示意性地示出了根据本文所述技术的一些实施例智能设备位于其中的客厅环境;

41.图10是根据本文中所述技术的一些实施例的基于分布式计算机的系统的框图,该基于分布式计算机的系统将xr系统与神经肌肉活动系统集成在一起;

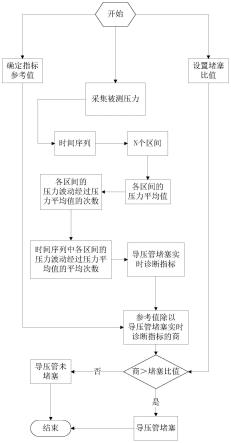

42.图11示出了根据本文所述技术的一些实施例的过程的流程图,其中神经肌肉信号和相机数据被用于捕获环境的信息以生成环境的3d地图;

43.图12示出了根据本文所述的技术的一些实施例的用于生成可用于控制环境中的智能设备的3d地图的过程的流程图;

44.图13示出了根据本文所述技术的一些实施例的过程的流程图,其中神经肌肉信号和相机数据与环境的3d地图结合使用以控制环境中的智能设备;以及

45.图14a和图14b示出了根据本文所述技术的一些实施例的过程的流程图,其中神经肌肉信号和相机数据用于控制环境中的交互,包括与环境中的另一个人的交互。

46.图15是可以结合本公开的实施例使用的示例性增强现实眼镜的图示。

47.图16是可以结合本公开的实施例使用的示例性虚拟现实头戴装置(headset)的图示。

48.图17是可以结合本公开的实施例使用的示例性触觉设备的图示。

49.图18是根据本公开的实施例的示例性虚拟现实环境的图示。

50.图19是根据本公开的实施例的示例性增强现实环境的图示。

51.详细描述

52.本文公开的本技术提供了使用户能够通过神经肌肉感测技术和成像技术的组合来创建环境的电子3d地图的绘图系统和绘图方法。可以生成其中对象在环境中被绘制的3d地图。如下所述,3d地图可以包括图像信息以及关于对象的位置和深度信息。3d地图还可以包括附加信息,例如识别哪些对象是远程可控对象(即智能设备)的信息。3d地图还可以包括自我识别信息,其中环境中的对象可以用作环境的参考对象,并且还可以用作用于识别对应于环境的3d地图的可搜索对象。

53.在本技术的一些实施例中,3d地图可以是真实世界环境的地图,并且可以用于经由用户的神经肌肉活动来控制真实世界环境中的一个或更多个智能设备。在一些实施例中,3d地图可以包括xr环境的地图,并且可以包括关于虚拟对象以及xr环境中的真实世界对象的信息。

54.本技术还提供了利用环境的3d地图以使用户能够经由用户的神经肌肉活动远程控制环境中的一个或更多个对象或与其交互的系统和方法。例如,在包含多个对象的真实世界环境的情况下,用户的某些神经肌肉活动(例如,用户的手指的指向、用户的手闭合形成拳头、用户的手腕的转动等)可以针对或被用于选择待控制的智能设备(例如,远程可控的窗帘),并且还可以用于控制智能设备(例如,升高或降低窗帘)。

55.在另一示例中,环境的3d地图可以与基于xr的系统一起使用,如下所述,使得环境是xr环境。xr环境可以是ar环境、或vr环境、或mr环境、或使用户能够体验真实世界环境的方面结合虚拟环境的方面的任何其他类型的环境。在xr环境中,用户可以经由某些神经肌肉活动与虚拟对象交互(例如,在虚拟画布上绘画),并且还可以与真实世界的智能设备交互(例如,以调整远程可控的窗帘)。在一些实施例中,用户可以经由用户执行的神经肌肉活动在真实世界环境中或在xr环境中与另一个人交互。

56.在本技术的一些实施例中,与用户的神经肌肉活动相对应的神经肌肉信号可由用户穿戴的一个或更多个可穿戴传感器感测,如下面更详细描述的。神经肌肉信号可用于确定关于用户期望的与环境中的一个或更多个对象的远程交互的信息。如上所述,环境可以是真实世界的环境,或者是由基于xr的系统生成的环境,或者是两者的组合。本文这种神经肌肉信号也可称为“感测的信号”。感测的信号可以被直接用作针对环境的控制系统的输入(例如,通过使用运动单位动作电位作为输入信号),和/或感测的信号可以被处理(包括通过使用如本文所述的推理模型),以用于确定用户的身体的一个部位(例如,手指、手部、手腕等)的移动、力和/或定位的目的。

57.例如,由布置在由用户穿戴的可穿戴设备上的神经肌肉传感器获得的神经肌肉信号可用于确定由用户施加到物理对象的力(例如,抓取力)。可以从感测的信号中和/或从由感测的信号导出的信息中识别用户的多个肌肉激活状态,以提供在环境中的改进的用户体验。肌肉激活状态可以包括但不限于:用户执行的静态姿态或姿势、用户执行的动态姿态或动作、用户的肌肉下激活状态、用户执行的肌肉绷紧或放松、或前述的任何组合。用户与环境中的一个或更多个对象的交互可以采取多种形式,包括但不限于:选择一个或更多个对象、控制一个或更多个对象、激活或停用一个或更多个对象、调整与一个或更多个对象有关的设置或特征等。用户也可以与环境中的另一个人交互。

58.要理解的是,用户的交互可以采取控制系统针对环境所允许的其他形式,并且不一定是本文特别列出的交互。例如,在环境中执行的控制操作可以包括基于一个或更多个

单独的运动单位的激活的控制,例如,基于感测的或检测的用户的肌肉下激活状态(诸如感测的肌肉绷紧)的控制。

59.应当理解的是,短语“感测的”、“检测的”、“获得的”、“收集的”、“感测的和记录的”、“测量的”、“记录的”等当在本文与来自神经肌肉传感器的感测的信号结合使用时包括由传感器检测的信号。还要理解的是,感测的信号可以在被处理之前存储在非易失性存储器中,或者在被存储在非易失性存储器中之前被处理。感测的信号可以在被处理之前被缓存。例如,在检测之后,可以将感测的信号在神经肌肉传感器的存储器中存储为“检测的”(即,原始),或在将感测的信号存储和/或将处理的信号存储在神经肌肉传感器的存储器中之前,在神经肌肉传感器处可以对感测的信号进行处理,或可以将感测的信号(例如,经由无线技术、直接有线连接和/或其他已知的通信技术)传送到外部设备以进行处理和/或存储,或前述的任何组合。可选地,可以处理和利用感测的信号而不存储在非易失性存储器中。

60.对用户的一个或更多个肌肉激活状态的识别可以允许与环境中的对象远程交互的分层或多级方法。例如,在xr环境中,在第一层/级,一个肌肉激活状态可以指示用户正在或打算与对象(例如,窗户的窗帘)交互;在第二层/级,另一肌肉激活状态可以指示期望的控制操作(例如,要打开窗帘);在第三层/级,又一激活状态可以指示用户想要激活针对对象的一组虚拟控件和/或特征(例如,关于不同季节的一组虚拟风景图像以出现在窗户的窗格上);以及在第四层/级,又一肌肉激活状态可以指示当与对象(例如,关于夏季的虚拟风景图像)交互时用户想要使用激活的一组虚拟控件和/或特征中的哪一个。应当理解的是,在不脱离本公开的范围的情况下,可以使用任何数量的肌肉激活状态和层。例如,在一些实施例中,一个或更多个肌肉激活状态可以对应于基于一个或更多个运动单位的激活的并发姿态,例如,用户的手部在手腕处弯曲,同时食指指向对象。在一些实施例中,一个或更多个肌肉激活状态可以对应于基于一个或更多个运动单位的激活的姿态的序列,例如,用户的手部抓取对象并将对象举起。在一些实施例中,单个肌肉激活状态可以指示用户期望与对象交互以及激活用于与对象交互的一组控件和/或特征。

61.例如,神经肌肉传感器可以感测用户神经肌肉活动的信号。感测的信号可以被输入到控制系统的计算机处理器,其可以使用例如经训练的推理模型来识别或检测用户的第一肌肉激活状态,如下所述。第一肌肉激活状态可以对应于例如由用户执行的第一姿态,并且可以指示用户正在或打算与环境中的特定对象(例如灯)交互。可选地,响应于检测到第一肌肉激活状态,可提供反馈以识别由第一肌肉激活状态指示的与对象的交互。神经肌肉传感器可以继续感测用户的神经肌肉活动的信号,并且可以从感测的信号中确定第二肌肉激活状态。响应于识别到第二肌肉激活状态(例如,对应于第二姿态,其可以与第一姿态相同或不同),控制系统可以激活对象的一组虚拟控件(例如,用于打开或关闭灯、选择灯光亮度级别、选择灯光颜色等的控件)。神经肌肉传感器可以继续感测用户的神经肌肉活动的信号,并且可以确定第三肌肉激活状态,等等。

62.在本技术的一些实施例中,肌肉激活状态可以至少部分地根据由一个或更多个可穿戴传感器收集的原始(例如,未处理的)传感器信号来识别。在一些实施例中,可以至少部分地从基于原始传感器信号的信息或从其导出的信息(例如,经处理的传感器信号)中识别肌肉激活状态,其中使用一种或更多种技术(例如,放大、滤波、整流和/或其他形式的信号

处理)来处理由一个或更多个可穿戴传感器收集的原始传感器信号。在一些实施例中,可以至少部分地从接收传感器信号(传感器信号的原始或经处理的版本)作为输入的经训练的推理模型的一个或更多个输出中识别肌肉激活状态。

63.在本技术的一些实施例中,根据本文描述的一种或更多种技术,基于感测的信号确定的用户的肌肉激活状态可用于与环境中的一个或更多个对象交互,而不要求用户依赖繁琐、低效和/或不便的输入设备。例如,可以从由用户穿戴或安装在用户上的神经肌肉传感器获得传感器数据(例如,感测的信号或从这些信号导出的数据),并且可以根据传感器数据来识别肌肉激活状态,而无需用户携带控制器和/或其他输入设备,且无需用户记住复杂的按钮或按键操纵序列。而且,可以根据传感器数据相对快速地执行对肌肉激活状态(例如,姿势、姿态等)的识别,从而减少与向控制系统发出控制信号相关联的响应时间和延迟,进而使用户能够在环境中进行实时或几乎实时的交互。

64.如上所述,由放置在用户的身体上的位置处的神经肌肉传感器获得的感测信号可以作为输入提供给一个或更多个推理模型,该一个或更多个推理模型被训练以生成用于人体的多段铰接刚体模型(即,人类肌肉骨骼系统的模型)的刚体段的空间信息。空间信息可以包括例如一个或更多个节段的定位信息、一个或更多个节段的取向信息、节段之间的关节角,等等。人类肌肉骨骼系统的全部或部分可以被建模为多节段铰接刚体系统(multi-segment articulated rigid body system),其中关节形成不同节段之间的接合部(interface),并且关节角定义在模型中连接的节段之间的空间关系。基于输入,并且由于训练,推理模型可以隐式表示在定义的移动约束下铰接刚体的推断运动。经训练的推理模型可以输出可用于多种应用,诸如用于在xr游戏环境中渲染用户的身体或其一部分的表示的应用、和/或利用某些肌肉激活状态来控制真实世界环境中的智能设备的应用。

65.例如,由被定位在用户身上(例如,在用户的手腕或手臂上)的单个移动传感器获得的移动数据可以作为输入数据被提供给经训练的推理模型。由经训练的推理模型生成的相对应的输出数据可以被用于确定关于用户的多段铰接刚体模型的一个或更多个节段的空间信息。例如,输出数据可以用于确定用户的通过肘关节连接的上臂节段和下臂节段的定位和/或取向。输出数据可以用于经由用户的多段铰接刚体模型来确定这两个连接的节段之间的角度。不同类型的传感器可以用于向经训练的推理模型提供输入数据,如下所述。

66.在本技术的一些实施例中,提供给一个或更多个经训练的推理模型的感测的信号可以确定用户正站着伸出前臂指向前方。经训练的推理模型还可以确定伸出的前臂的手指已经从放松的弯曲定位移动到挠曲和指向定位,或者伸出的前臂的手腕已经向上或向下弯曲,或者伸出的前臂已经顺时针或逆时针旋转,等等。如下所述,从感测的信号识别的肌肉激活状态可以与环境的3d地图结合使用,以使用户能够例如进入环境并经由神经肌肉信号远程地与智能设备交互。此外,如下所述,通过在环境中定向用户(例如,经由相对于用户定位环境中的参考对象),用户可以单独地(例如,通过使用手指指向环境中的智能设备的窗帘并向上弯曲手腕以打开窗帘)或共同地(例如,通过使用手指指向环境中的多个智能设备灯中的一个并用两个或更多个手指执行捏合动作以使环境中的所有灯变暗)控制多个不同的智能设备和/或与多个不同的智能设备交互。要理解的是,来自经训练的推理模型的输出数据可以被用于除本文中具体识别的那些应用以外的其他应用。

67.在本技术的一些实施例中,可以直接从感测的信号中识别各种肌肉激活状态。在

其他实施例中,如上所述,可以至少部分地基于使用一个或更多个经训练的推理模型处理感测的信号的结果来识别肌肉激活状态,该肌肉激活状态可以包括(下面描述的)手部状态、姿态、姿势等。例如,经训练的推理模型可以输出计算机生成的肌肉骨骼模型的节段的运动单位或肌肉激活和/或定位、取向和/或力估计。如本文所用,术语“姿态(gesture)”可以指一个或更多个身体部位的静态或动态外形,包括一个或更多个身体部位的定位以及与该外形相关联的力。例如,姿态可以包括分立的姿态(例如将手掌向下放置或按压在实体表面上或抓住球)、连续的姿态(例如来回挥动手指,抓住并投掷球)或分立姿态和连续姿态的组合。姿态可以包括隐蔽的姿态,隐蔽的姿态对另一个人来说可能是无法察觉的,诸如通过共收缩对立的肌肉或使用肌肉下激活来稍微绷紧关节。在训练推理模型时,可以使用被配置成提示用户执行姿态的应用来定义姿态,或者替代地,姿态可以由用户任意定义。用户执行的姿态可以包括象征性的姿态(例如,基于指定映射的姿态词汇,映射到其他姿态、交互或命令的姿态)。在某些情况下,根据文化标准,手部姿态和手臂姿态可能是象征性的,并且被用于交流。

68.在本技术的一些实施例中,感测的信号可用于预测关于用户手臂和/或用户手部的一部分的定位和/或移动的信息,用户手臂和/或用户手部的一部分可被表示为多段铰接刚体系统,其具有连接刚体系统的多个节段的关节。例如,在手部移动的情况下,由放置在用户的身体上(例如,用户的手臂和/或手腕)的位置处的神经肌肉传感器获得的感测的信号可以被提供作为推理模型的输入,该推理模型被训练为当用户执行一个或更多个手部移动时预测与和手部相关联的基于计算机的肌肉骨骼表示中的多个刚性节段相关联的定位(例如,绝对定位、相对定位、取向)和力的估计。与关联于手部的肌肉骨骼表示的节段相关联的定位信息和力信息的组合在本文中可以被称为肌肉骨骼表示的“手部状态(handstate)”。当用户执行不同的移动时,经训练的推理模型可以将神经肌肉信号解释为定位和力估计(手部状态信息),该定位和力估计可以作为控制信号输出,以控制环境中的智能设备或者与环境中的智能设备或与环境中的另一个人进行交互。因为可以连续感测用户的神经肌肉信号,所以可以实时更新用户手部状态,并且可以基于用户手部状态的当前估计实时渲染用户手部(例如,在xr环境内)的视觉表示。要理解的是,用户手部状态的估计可以用于确定用户正在执行的姿态和/或预测用户将执行的姿态。

69.关节处移动的限制由连接节段的关节类型和可限制关节处移动范围的生物结构(例如,肌肉、肌腱、韧带)决定。例如,将上臂节段连接到受试人躯干的肩关节和将大腿节段连接到躯干的髋关节是允许伸展和弯曲移动以及旋转移动的球窝关节。相比之下,连接上臂节段和下臂节段(或前臂)的肘关节,以及连接受试人的大腿节段和小腿节段的膝关节,允许更有限的运动范围。在该示例中,多节段铰接刚体系统可用于对人体肌肉骨骼系统的部分进行建模。然而,应当理解,尽管人体肌肉骨骼系统的一些节段(例如,前臂)可以近似为铰接刚体系统中的刚体,但是这些节段可以各自包括多个刚性结构(例如,前臂可以包括尺骨和桡骨),这可以使得能够在该节段内进行刚体模型可能没有明确考虑的更复杂的运动。因此,与本文所描述技术的一些实施例一起使用的铰接刚体系统的模型可以包括表示不是严格刚体的身体部位的组合的节段。应当理解,在不脱离本公开的范围的情况下,可以使用除本文讨论的多节段铰接刚体系统之外的物理模型来对人体肌肉骨骼系统的部分进行建模。

70.继续上面的示例,在运动学中,刚体是表现出各种运动属性(例如,定位、定向、角速度、加速度)的对象。知道刚体一个节段的运动属性使得刚体其他节段的运动属性能够基于节段如何连接的约束来确定。例如,手可以被建模为多节段铰接体,每个手指和手腕中的关节形成模型中多个节段之间的接合部。在一些实施例中,刚体模型中节段的移动可以被模拟为铰接刚体系统,其中节段相对于模型中其他节段的定位(例如,实际定位、相对定位或定向)信息使用经训练的推理模型进行预测。

71.对于本技术的一些实施例,由肌肉骨骼表示近似的人体的部分可以是手部或手部与一个或更多个手臂节段的组合。如上所述,在肌肉骨骼表示中,用于描述节段之间的定位关系、各个节段或节段组合的力关系、以及节段之间的肌肉和运动单位激活关系的当前状态的信息被称为肌肉骨骼表示的手部状态。然而,应当理解,本文描述的技术也适用于除了手部之外的身体部位的肌肉骨骼表示,这些身体部位包括但不限于手臂、腿、脚、躯干、颈部或前述的任何组合。

72.除了空间(例如,定位和/或定向)信息,本技术的一些实施例能够预测与肌肉骨骼表示的一个或更多个节段相关联的力信息。例如,可以估计由一个或更多个节段施加的线性力或旋转(扭矩)力。线性力的示例包括但不限于手指或手部按压在诸如桌子的实体对象上的力,以及当两个节段(例如,两个手指)被捏合在一起时施加的力。旋转力的示例包括但不限于当(诸如手腕或手指中的)节段相对于另一个节段扭曲或弯曲时产生的旋转力。在一些实施例中,被确定为当前手部状态估计的一部分的力信息包括下列各项中的一项或更多项:捏合力信息、抓握力信息和关于由肌肉骨骼表示所表示的肌肉之间的共收缩力的信息。在一些实施例中,力信息可以用于设置用于控制智能设备的速度。例如,在前述窗帘的示例中,两个手指的轻触可以用作缓慢关闭窗帘的指令,而两个手指的更有力或更强的捏合可以用作快速关闭窗帘的指令。

73.现在转到附图,图1示意性地示出了根据本文中所述技术的一些实施例的系统100(例如神经肌肉活动系统)。系统100可以包括一个或更多个传感器110,该一个或更多个传感器被配置成感测由在人体的一个或更多个部分内的运动单位的激活引起的信号。传感器110可以包括被配置成感测从人体的骨骼肌中的神经肌肉活动产生的信号的一个或更多个神经肌肉传感器。本文中所使用的术语“神经肌肉活动”是指支配肌肉的脊髓运动神经元或单位的神经激活、肌肉激活、肌肉收缩或神经激活、肌肉激活和肌肉收缩的任何组合。一个或更多个神经肌肉传感器可以包括一个或更多个肌电图(emg)传感器,一个或更多个肌动图(mmg)传感器,、一个或更多个声肌图(smg)传感器,emg传感器、mmg传感器和smg传感器中两种或更多种类型的组合,和/或能够检测神经肌肉信号的任何合适类型的一个或更多个传感器。在一些实施例中,可以从由一个或更多个神经肌肉传感器感测的神经肌肉信号中确定与用户在对应于3d地图的环境中的交互有关的信息。当用户随时间与环境交互时,可以基于感测的信号来预测与移动(容易看见的或隐蔽的移动)有关的空间信息(例如,定位和/或取向信息)和力信息。在一些实施例中,神经肌肉传感器可以感测与由外部对象引起的移动(例如,被外部对象推动的用户的手部的移动)相关的肌肉活动。

74.传感器110可以包括一个或更多个惯性测量单元(imu),该一个或更多个imu使用例如加速度计、陀螺仪、磁力计、或者一个或更多个加速度计、陀螺仪和磁力计的任意组合来测量运动的物理方面的组合。在一些实施例中,imu可以用于感测关于用户附接有一个或

多个imu的身体部位的移动的数据,并且当用户随时间移动时,从感测到的imu数据导出的信息(例如,定位和/或定向信息)可以被跟踪。例如,当用户随时间的推移而移动时,一个或更多个imu可用于跟踪用户身体靠近用户躯干的部分(例如,手臂、腿)相对于imu的移动。

75.在包括至少一个imu和一个或更多个神经肌肉传感器的实施例中,imu和神经肌肉传感器可以被布置成检测人体不同部位的移动。例如,imu可以被设置成检测用户躯干附近的一个或更多个身体节段的运动(例如上臂的运动),而神经肌肉传感器可以被布置成检测用户躯干远端的一个或更多个身体节段内运动单位活动(例如下臂(前臂)或手腕的运动)。(术语“下臂”和“前臂”在这里可以互换使用)。然而,应当理解,传感器(即,imu和神经肌肉传感器)可以以任何合适的方式布置,并且本文描述的技术的实施例不限于基于任何特定的传感器布置。例如,在一些实施例中,至少一个imu和多个神经肌肉传感器可以共同位于用户的一个体段上,以使用不同类型的测量来跟踪体段的运动单位活动和/或移动。在一个实施方式中,imu和多个emg传感器可以被布置在被构造成围绕用户的下臂或手腕穿戴的可穿戴设备上。在这样的布置中,imu可以被配置为随着时间的推移而跟踪与一个或更多个手臂节段相关联的移动信息(例如,定位和/或定向),以确定例如用户是否已经举起或放下了他/她的手臂,而emg传感器可以被配置为确定与手腕和/或手部的肌肉或肌肉中的肌肉下结构的激活相关联的更细粒度或更精细的移动信息和/或肌肉下信息。

76.在执行运动任务期间,随着肌肉张力的增加,活跃神经元的放电率(firing rates)增加并且额外的神经元可能变得活跃,这一过程可以被称为运动单位募集。神经元变得活跃并增加其放电率的模式是定型的,使得预期的运动单位募集模式可以定义与标准或正常移动相关联的活动流形(manifold)。在本发明技术的一些实施例中,因为运动单位激活的模式与预期或典型的运动单位募集模式不同,所以感测的信号可以识别“偏离流形(off-manifold)”的单个运动单位或一组运动单位的激活。本文中可将这种非流形的激活称为“肌肉下激活”或“肌肉下结构的激活”,其中肌肉下结构是指单个运动单位或一组与非流形的激活相关联的运动单位。偏离流形运动单位募集模式的示例包括但不限于选择性地激活较高阈值的运动单位,而不激活通常在募集顺序中较早被激活的较低阈值运动单位,以及跨相当大的范围调节运动单位的放电率,而不调节通常在典型运动单位募集模式中被共同调节的其他神经元的活动。在一些实施例中,一个或更多个神经肌肉传感器可以相对于用户的身体布置,并用于在没有可观察到的移动的情况下,即在没有可容易观察到的用户的身体相对应的移动的情况下,感测肌肉下激活。根据本技术的一些实施例,可以至少部分地使用肌肉下激活来与真实世界环境以及xr环境中的对象交互。

77.一些或所有的传感器110可以各自包括被配置成感测关于用户的信息的一个或更多个感测部件。在imu的情况下,imu的感测部件可以包括以下任何一个或它们的任何组合:加速度计、陀螺仪、磁力计,其可以用于测量或感测用户的身体运动的特征,用户的身体运动的特征的示例包括但不限于加速度、角速度和在用户的身体运动期间围绕身体的磁场。在神经肌肉传感器的情况下,感测部件可以包括但不限于:检测体表上的电位的电极(例如,用于emg传感器的电极)、测量皮肤表面振动的振动传感器(例如,用于mmg传感器的振动传感器)、测量由肌肉活动引起的超声波信号的声学感测部件(例如,用于smg传感器的声学感测部件)或它们的任何组合。可选地,传感器110可以包括以下中的任一项或它们的任何组合:测量用户皮肤温度的热传感器(例如,热敏电阻器);测量用户脉搏和/或心率的心电

传感器;测量用户出汗状态的水分传感器;等等。根据本文中公开的技术的一些实施例,可以用作一个或更多个传感器110的一部分的示例性传感器在标题为“methods and apparatus for inferring user intent based on neuromuscular signals”的第10,409,371号美国专利中更详细地进行了描述,该美国专利通过引用并入本文。

78.在一些实施例中,一个或更多个传感器110可以包括多个传感器110,并且该多个传感器110中的至少一些可以被布置为可穿戴设备的一部分,该可穿戴设备被构造成穿戴在用户身体的一个部位上或围绕用户身体的一个部位穿戴。例如,在一个非限制性示例中,imu和多个神经肌肉传感器可以周向布置在可调节的带(例如,弹性的带)上,例如被构造成围绕用户手腕或手臂穿戴的腕带或臂带,如下面更详细描述的。在一些实施例中,多个可穿戴设备(每个可穿戴设备具有在其上包括的一个或更多个imu和/或一个或更多个神经肌肉传感器)可以被用于基于来自肌肉下结构的激活和/或基于涉及身体多个部位的移动,确定与用户和对象的交互有关的信息。可选地,至少多个传感器110中的一些可以被布置在可穿戴贴片上,该可穿戴贴片被构造成附着到用户的身体的一部分。

79.图2a至图2d示出了各种类型的可穿戴贴片。图2a示出了可穿戴贴片22,其中用于电子传感器的电路可以被印刷在柔性基板上,该柔性基板被构造成粘附到手臂,例如在静脉附近,以感测用户体内的血流。可穿戴贴片22可以是rfid类型的贴片,其可以在外部设备进行询问时无线传输感测到的信息。图2b示出了可穿戴贴片24,其中电子传感器可以被结合在被构造成穿戴在用户的额头上的基板上,例如,以测量来自汗水的水分。可穿戴贴片24可以包括用于无线通信的电路,或可以包括被构造成可连接到线缆(例如,附接到头盔(helmet)、头戴式显示器或另一个外部设备的线缆)的连接器。可穿戴贴片24可以被构造成粘附到用户的前额,或者通过例如头带、无边帽等紧贴用户的前额。图2c示出了可穿戴贴片26,其中用于电子传感器的电路可以被印刷在被构造成粘附到用户的颈部,例如,在用户的颈动脉附近的基板上,以感测流向用户大脑的血流。可穿戴贴片26可以是rfid类型的贴片,或可以包括被构造成可以连接到外部电子器件的连接器。图2d示出了可穿戴贴片28,其中电子传感器可以被结合在被构造成穿戴在用户心脏附近的基板上,例如,以测量用户的心率或测量流向/流出用户心脏的血流。如将要理解的,无线通信不限于rfid技术,并且可以采用其他通信技术。而且,如将要理解的,传感器110可以被结合在其他类型的可穿戴贴片上,该其他类型的可穿戴贴片可以与图2a至图2d中所示的那些可穿戴贴片不同地被构造。

80.在本技术的一些实现方式中,传感器110可以包括围绕被构造成围绕用户的下臂(例如,环绕用户的前臂)穿戴的条带(例如,弹性条带等、可调节条带)周向布置的十六个神经肌肉传感器。例如,图3示出了可穿戴系统300的实施例,其中神经肌肉传感器304(例如,emg传感器)布置在可调节条带302上。应理解的是,可以使用任何合适数量的神经肌肉传感器,而且所使用的神经肌肉传感器的数量和布置可以取决于可穿戴系统300所用于的特定应用。例如,可穿戴臂带或腕带可以被用于感测用于控制机器人、控制车辆、滚动文本、控制虚拟化身或任何其它合适的控制任务的信息。在一些实施例中,可调节条带302还可以包括一个或更多个imu(未示出)。

81.图4a、图4b、图5a和图5b示出了本技术的可穿戴系统的其它实施例。特别地,图4a示出了可穿戴系统400,其包括围绕被构造成围绕用户的下臂或手腕穿戴的弹性条带420周向布置的多个传感器410。传感器410可以是神经肌肉传感器(例如,emg传感器)。如图所示,

可以有以规则的间距围绕弹性条带420周向布置的十六个传感器410。应理解的是,可以使用任何合适数量的传感器410,并且间距不一定是规则的。传感器410的数量和布置可以取决于可穿戴系统所用于的特定应用。例如,当可穿戴系统要穿戴在手腕上时,与穿戴在大腿上相比,传感器410的数量和布置可以是不同的。如上所述,可穿戴系统(例如,臂带、腕带、大腿带等)可以被用于感测用于控制机器人、控制车辆、滚动文本、控制虚拟化身和/或执行任何其他合适的控制任务的信息。

82.在本技术的一些实施例中,传感器410可以仅包括一组神经肌肉传感器(例如,emg传感器)。在其它实施例中,传感器410可以包括一组神经肌肉传感器和至少一个辅助设备。辅助设备可以被配置为连续地或间歇地收集一个或多个辅助信号。辅助设备的示例包括但不限于imu、麦克风、成像设备(例如相机)、用于与辐射生成设备(例如激光扫描设备)一起使用的基于辐射的传感器、心率监测器和可以捕获用户的状况或用户的其他特征的其它类型的设备。如图4a所示,传感器410可以使用被结合到可穿戴系统中的柔性电子器件1430耦合在一起。图4b示出了穿过图4a中示出的可穿戴系统的传感器410中的一个的横截面视图。

83.在本技术的一些实施例中,传感器410的一个或更多个感测部件的输出可以可选地使用硬件信号处理电路进行处理(例如,进行放大、滤波和/或整流)。在其它实施例中,可以使用软件对感测部件的输出进行至少一些信号处理。因此,对由传感器410检测到的感测信号的信号处理可以由硬件或软件来执行,或由硬件和软件的任何合适组合来执行,而本文中所述技术的多个方面在这点上不受限制。下面结合图5a和图5b更详细地讨论用于处理来自传感器410的记录的数据的信号处理过程的非限制性示例。

84.图5是根据本文中所述技术的一些实施例示出具有十六个传感器(例如emg传感器)的可穿戴系统500的内部部件的框图。如图所示,可穿戴系统500包括可穿戴部分510和加密狗部分(dongle portion)520。尽管没有具体示出,但加密狗部分520与可穿戴部分510(例如,经由蓝牙或另一种合适的短程无线通信技术)进行通信。可穿戴部分510可以包括传感器410,其示例在上面结合图4a和图4b进行了描述。传感器410向模拟前端530提供输出(例如,感测信号),该模拟前端对感测信号执行模拟处理(例如,降噪、滤波等)。然后,由模拟前端530产生的经处理的模拟信号被提供给模数转换器532,该模数转换器532将经处理的模拟信号转换为可以被一个或更多个计算机处理器处理的数字信号。根据一些实施例可以被使用的计算机处理器的示例是微控制器(mcu)534。mcu 534也可以接收来自其他传感器(例如,imu 540)和来自电源和电池模块542的输入。如将要理解的,mcu 534可以从未被具体示出的其他设备接收数据。mcu 534的处理输出可以被提供给天线550以用于传输到加密狗部分520。

85.加密狗部分920包括与可穿戴部分510的天线550通信的天线952。天线550和552之间的通信可以使用任何合适的无线技术和协议进行,无线技术和协议的非限制性示例包括射频信号发送和蓝牙。如图所示,由加密狗部分520的天线552接收的信号可以被提供给主计算机,以用于进一步处理、用于显示和/或用于实现对一个或多个特定的对象的控制(例如,以在对于在环境的3d地图中可识别智能设备和其他可控对象的环境中执行控制操作)。尽管参照图4a、图4b和图5提供的示例是在与emg传感器接合(interface)的情境下讨论的,但应理解,本文中所述的可穿戴系统也可以用其它类型的传感器来实现,其他类型的传感器包括但不限于肌动图(mmg)传感器、声肌图(smg)传感器和电阻抗断层成像(eit)传感器。

86.回到图1,在一些实施例中,由传感器110获得的感测信号可以可选地被处理以计算额外的导出的测量结果,该额外导出的测量结果然后可以作为输入被提供给推理模型,如下面更详细地描述的以上所述。例如,从imu获得的感测信号可以被处理以导出取向信号,该取向信号规定了刚体的节段随时间推移的取向。传感器110可以使用与传感器110的感测部件集成的部件来实现信号处理,或者信号处理中的至少一部分可以由与传感器110的感测部件通信但不与该感测部件直接集成的一个或更多个其他部件执行。

87.系统100还包括被编程为与传感器110通信的一个或更多个计算机处理器112。例如,由传感器110中的一个或更多个获得的感测信号可从传感器110(如上所述以原始形式或以处理形式)输出并被提供给处理器112,处理器112可以被编程为执行一个或更多个机器学习算法以处理感测信号。算法可以处理感测信号以训练(或重新训练)一个或更多个推理模型114,并且经训练(或重新训练)的推理模型114可以被存储以供后续用于生成选择信号和/或控制信号以控制3d地图的环境中的对象,如下所述。如将理解的,在一些实施例中,推理模型114可以包括至少一个统计模型。

88.在本技术的一些实施例中,推理模型114可以包括神经网络,并且例如可以是循环神经网络(recurrent neural network)。在一些实施例中,循环神经网络可以是长短期记忆(lstm)神经网络。然而,应理解的是,循环神经网络不限于是lstm神经网络,并且可以具有任何其他合适的架构。例如,在一些实施例中,循环神经网络可以是以下中的任一项或任何组合:全循环神经网络(fully recurrent neural network)、门控循环神经网络(gated recurrent neural network)、递归神经网络、hopfield神经网络、联想记忆神经网络(associative memory neural network)、elman神经网络、jordan神经网络、回声状态神经网络(echo state neural network)、和二阶递归神经网络(second order recurrent neural network)和/或其他合适类型的循环神经网络。在其他实施例中,可以使用不是循环神经网络的神经网络。例如,可以使用深度神经网络、卷积神经网络和/或前馈神经网络。

89.在本技术的一些实施例中,推理模型114可以产生离散输出。例如,当所期望的输出是为了知道特定的激活模式(包括个别神经尖峰事件)是否在感测到的神经肌肉信号中被检测到时,可以使用离散输出(例如,离散分类)。例如,推理模型114可以被训练以估计用户是否正在激活特定运动单位、以特定定时激活特定运动单位、以特定的激发模式激活特定运动单位或者激活运动单位的特定组合。在较短的时间尺度内,离散分类可以在一些实施例中被用于估计特定运动单位是否在给定的时间量内激发了动作电位。在此种情况下,这些估计则可以被累积,以获得该运动单位的估计激发率。

90.在其中推理模型被实现为被配置为输出离散输出(例如,离散信号)的神经网络的实施例中,该神经网络可以包括是归一化指数层的输出层,使得推理模型的输出加起来为1,并可以被解释为概率。例如,归一化指数层的输出可以是对应于一组相应控制信号的一组值,其中每个值指示用户想要执行特定控制动作的概率。作为一个非限制性示例,归一化指数层的输出可以是一组三个概率(例如,0.92,0.05和0.03),指示检测到的活动模式是三个已知模式中的一个的相应概率。

91.然而,应理解的是,当推理模型是被配置为输出离散输出(例如,离散信号)的神经网络时,不需要神经网络产生加起来为1的输出。例如,神经网络的输出层可以是s型层(sigmoid layer),而不是归一化指数层,这并不将输出限制为加起来为1的概率。在此类实

施例中,神经网络可以用s型交叉熵成本(sigmoid cross-entropy cost)进行训练。此种实现方式在以下情况下可能是有利的:其中例如在阈值时间量内可能发生多个不同的控制动作,并且区分这些控制动作发生的顺序并不重要(例如,用户可以在阈值时间量内激活两种神经活动模式)。应该理解的是,可以使用任何其他合适的非概率性多类分类器,本文中所述技术的多个方面在这点上不受限制。

92.在本技术的一些实施例中,推理模型114的输出可以是连续信号,而不是离散输出(例如,离散信号)。例如,推理模型114可以输出每个运动单位的激发率的估计值,或推理模型114可以输出对应于每个运动单位或肌肉下结构的时间序列电信号。

93.应理解的是,本文中所述技术的多个方面并不限于使用神经网络,在一些实施例中也可以采用其他类型的推理模型。例如,在一些实施例中,推理模型114可以包括隐马尔可夫模型(hmm)、切换hmm(其中切换允许在不同的动态系统之间转换(toggling))、动态贝叶斯网络和/或具有时间分量的其他合适的图形模型。此类推理模型中的任一个可以使用由传感器110获得的感测信号进行训练。

94.作为另一个示例,在一些实施例中,推理模型114可以是或可以包括分类器,其将从由传感器110获得的感测信号导出的特征作为输入。在此类实施例中,分类器可以使用从感测信号提取的特征进行训练。分类器可以是例如支持向量机、高斯混合模型、基于回归的分类器、决策树分类器、贝叶斯分类器和/或其他合适的分类器,本技术在这点上不受限制。向分类器提供的输入数据可以以任何合适的方式从感测信号导出。例如,可以使用小波分析技术(如连续小波变换、离散时间小波变换等)、傅里叶分析技术(如短时傅里叶变换、傅里叶变换等)和/或其他合适类型的时频分析技术将感测信号作为时间序列数据进行分析。作为一个非限制性示例,感测信号可以使用小波变换进行变换,并且所产生的小波系数可以作为输入数据被提供给分类器。

95.在本技术的一些实施例中,推理模型114的参数值可以根据训练数据进行估计。例如,当推理模型114是或包括神经网络时,神经网络的参数(例如,权重)可以根据训练数据进行估计。在一些实施例中,推理模型114的参数可以使用梯度下降、随机梯度下降和/或其他合适的迭代优化技术来估计。在其中推理模型114是或包括循环神经网络(例如,lstm)的实施例中,推理模型114可以使用随机梯度下降和时间反向传播(backpropagation through time)进行训练。训练可以采用交叉熵损失函数和/或其他合适的损失函数,本技术的各方面在这点上不受限制。

96.系统100还可以包括一个或更多个控制器116。例如,控制器116可以包括显示控制器,其被配置为在显示设备(例如,显示监视器)上显示视觉表示(例如,手的表示)。如本文中所讨论,一个或更多个计算机处理器112可以实现一个或更多个推理模型114,其接收由传感器110获得的感测信号作为输入,并提供可以用于生成可用于控制例如在由3d地图定义的环境中的智能设备或其他可控对象的控制信号的信息(例如,预测的手部状态信息)作为输出。

97.系统100还可以可选地包括用户界面118。基于由传感器110获得并由处理器112处理的感测信号确定的反馈可以经由用户界面118向用户提供,以促进用户理解系统100如何解释用户的肌肉活动(例如,预期的肌肉移动)。用户界面118可以以任何合适的方式实现,包括但不限于音频界面、视频界面、触觉界面和电刺激界面、或前述的任何组合。

98.系统100可以具有可以采取任何合适的形式的架构。本技术的一些实施例可以采用薄架构(thin architecture),其中处理器112是或被包括作为与可以布置在一个或更多个可穿戴设备上的传感器110分开并与之通信的设备的一部分。传感器110可以被配置为以无线方式基本上实时地将(原始或处理形式的)感测信号和/或从感测信号中导出的信息流式传输给处理器112以进行处理。与传感器110分开并与之通信的设备可以是例如以下中的任一项或任何组合:远程服务器、台式计算机、笔记本计算机、智能手机、可穿戴电子设备(诸如智能手表)、健康监测设备、智能眼镜、基于xr的系统和其3d地图可以用于识别环境中的智能设备或其他可控对象的环境的控制系统。

99.本技术的一些实施例可以采用厚架构(thick architecture),其中处理器112可以与其上布置了传感器110的一个或更多个可穿戴设备集成在一起。在又一些实施例中,由传感器110获得的感测到的信号的处理可以在多个处理器之间进行划分,其中至少一个处理器可与传感器110集成在一起,并且其中至少一个处理器可以被包括作为与传感器110分开并与之通信的设备的一部分。在这样的实现方式中,传感器110可以被配置为将感测到的信号中的至少一些传输到远离传感器110定位的第一计算机处理器。第一计算机处理器可以被编程为基于传输到第一计算机处理器的感测信号,训练推理模型114中的至少一个推理模型。然后,第一计算机处理器可以被编程为将经训练的至少一个推理模型传输到与其上布置了传感器110的一个或更多个可穿戴设备集成在一起的第二计算机处理器。第二计算机处理器可以被编程为使用从第一计算机处理器传输的经训练的至少一个推理模型来确定与穿戴一个或更多个可穿戴设备的用户和在3d地图的环境中的对象之间的交互有关的信息。这样,训练过程和利用经训练的至少一个推理模型的实时过程可以通过使用不同的处理器来独立地被执行。

100.在本技术的一些实施例中,控制器116可以指示模拟xr环境的xr系统的计算机应用通过显示虚拟对象来提供视觉表示。例如,虚拟对象可以是角色(例如,化身)、想象图像(例如,表示期望季节的场景)、工具(例如,画笔)。在一个示例中,可以基于经训练的至少一个推理模型的输出来显示在xr环境内的虚拟角色的部分的定位、移动和/或施加的力。视觉表示可以通过以下方式来动态更新:使用由传感器110获得的并且由经训练的推理模型114处理的连续感测的信号,以提供实时更新的角色的移动的计算机生成的表示。

101.由系统100获得的或提供给系统100的信息(例如,从照相机获得的输入、从传感器110获得的输入等)可用于改善当用户与3d地图的环境交互时的用户体验,包括交互和/或控制操作的准确性、反馈、推理模型、校准功能以及系统100的其他方面。为此,对于由与系统100一起操作的xr系统生成的xr环境,xr系统可以包括至少一个处理器、至少一个相机和至少一个显示器,该至少一个显示器在用户的视野内提供xr信息。至少一个显示器可以是用户界面118、经由ar眼镜提供给用户的显示界面、或用户可观看的另一观看设备。系统100可以包括将xr系统与基于计算机的系统耦合的系统元件,该基于计算机的系统基于传感器数据(例如,来自至少一个神经肌肉传感器的感测信号)生成肌肉骨骼表示。在本技术的一些实施例中,这些系统可以合并为系统100的子系统。在其他实施例中,这些系统可以经由专用计算机系统或其他类型的计算机系统耦合,该专用计算机系统或其他类型的计算机系统接收来自xr系统和基于计算机的系统的输入,并根据输入生成xr肌肉骨骼表示。这种系统可以包括游戏系统、机器人控制系统、个人计算机或能够解释xr信息和肌肉骨骼信息的

另一个系统。在一些实施例中,xr系统和基于计算机的系统可以被配置成彼此直接通信,使得基于计算机的系统生成关于xr环境的xr肌肉骨骼表示。在这点上,信息可以使用任何数量的接口、协议和/或介质进行通信。

102.在本技术的一些实施例中,系统100可包括一个或更多个相机120,一个或更多个相机120可与来自传感器110的感测信号结合使用,以提供在包含智能设备的环境中的增强的用户体验。在多个实施例中,这样的智能设备可以经由环境的3d地图来识别。在多个其它实施例中,如下面更详细地讨论的,可以经由感测信号和由相机120获得的信息来识别这样的智能设备,以使得能够生成这样的环境的3d地图。

103.如上所述,在本技术的一些实施例中,推理模型可以被用于预测被用于生成基于计算机的肌肉骨骼表示和/或实时更新基于计算机的肌肉骨骼表示的信息。例如,预测的信息可以是预测的手部状态信息。推理模型可用于基于imu信号、神经肌肉信号(例如,emg、mmg和/或smg信号)、相机信号、外部或辅助设备信号(例如,激光扫描信号)或当在用户执行一个或更多个移动和/或在用户进行其他类型的神经肌肉活动时检测到这些信号时这些信号的组合来预测信息。例如,相机120可与xr系统一起使用,以捕获用户手部的实际定位的数据。捕获的数据可用于生成用户手部的基于计算机的肌肉骨骼表示,并且该实际定位信息可以由推理模型使用以提高表示的准确性并在由xr系统产生的xr环境中生成视觉表示(例如,虚拟手部)。例如,肌肉群激发、正在施加的力、经由用户的移动而被举起的对象、和/或与基于计算机的肌肉骨骼表示相关的其他信息的视觉表示可以在xr系统的xr环境中的视觉显示中被渲染。

104.在本技术的一些实施例中,可以使用推理模型来将肌肉激活状态信息映射到控制信号,该肌肉激活状态信息是从神经肌肉传感器获得的感测神经肌肉信号中识别的信息。推理模型可以接收当用户执行一个或更多个肌肉下激活、一个或更多个移动和/或一个或多个姿态时被检测和/或捕获到的imu信号、神经肌肉信号(例如,emg、mmg和smg信号)、相机信号、外部或辅助设备信号或这些信号的组合作为输入。推理模型可用于预测控制信息,而无需用户必须进行可感知的移动。

105.根据本技术的一些实施例,相机120可用于捕获信息以改善神经肌肉信号及其与运动、定位和力生成的关系的解释,从而响应于特定神经肌肉信号捕获信息,捕获可用于识别对应于3d地图的环境的信息,和/或捕获用于生成环境的3d地图的信息。要理解的是,捕获的信息可以是例如对应于由相机120捕获的图像的图像信号。相机120可以包括静止相机、摄像机、红外相机、立体相机、全景相机等,其是或能够捕获用户的一个或更多个3d图像和/或用户感兴趣的环境或用户周围的一个更或多个3d图像。可选地,相机120可配备有一个或更多个滤镜,使得相机120可以仅捕获在特定波长范围内的光的3d图像。

106.由相机120捕获的信息可以包括静止3d图像的序列(图像序列)和/或一个或更多个3d移动图像的序列(视频序列),序列可以被捕获作为一个或更多个信号;因此,对捕获图像的引用应理解为包括捕获图像信号。术语“相机信息”、“相机数据”和“相机信号”在本文可以用来表示相机可以捕获的关于用户的信息和/或关于用户环境的信息。应当理解的是,尽管多个实施例可能提到“一个”相机或“该”相机,但是这些实施例可以利用两个或更多个相机来代替一个相机。此外,相机信息可以涉及以下任何一个或它们的任何组合:由可见光产生的3d图像、由非可见(例如,红外)光产生的3d图像、由特定波长范围的光产生的3d图

像、由两个或更多个不同波长范围的光产生的3d图像、使用立体技术产生的3d图像、通过提供具有深度信息的2d图像而产生的3d图像等。例如,可以使用非可见光来捕获用户的身体的具有相对于其他附近的对象(例如,散热器)的不同热分布的对象的3d图像,该3d图像可提供用户体内血流的指示,该指示又可用于推断用户的状况(例如,由用户的手指正在施加的力可具有与未施加力的手指不同的血流模式)。

107.在一些实施例中,相机120可以包括如在图6中示意性地示出的相机600。相机600可以包括成像部分602,该成像部分602被配置成捕获包括图像数据的多个像素的一幅或更多幅数字图像。例如,成像部分602可以包括红绿蓝(rgb)相机和/或近红外(nir)相机。相机600还可以包括深度部分604,该深度部分604被配置成检测从相机600到相机视场中的一个或更多个表面的距离。例如,深度部分604可以包括被配置成发射ir光的照明设备604a(例如,红外(ir)二极管)和被配置成接收从视场中的表面反射的ir光的检测器604b。可以使用已知的飞行时间的技术来确定距离或深度。深度部分604和成像部分602可以被布置成捕获图像数据并检测在相同的视场中的深度数据,使得图像数据的每个像素可以被提供相对应的深度数据。

108.相机600可以安装在用户的头部上(例如,在头带、帽子(hat)、帽子(cap)、头盔、眼镜等上),使得用户的头部可以用于在期望的方向上瞄准相机600以捕获图像。可替代地,相机600可以安装在用户的手臂上(例如,在手套、腕带、臂带等上),使得用户的手臂可以用于在期望的方向上瞄准相机600以捕获图像。图像可以被捕获作为静止图像或作为视频图像的扫描。相机600还可以包括其他类型的灯(light)、灯泡或灯(lamp),包括但不限于卤素灯、uv、黑光灯(black)、白炽灯、金属卤素灯、日光灯、霓虹灯和/或发光二极管(led)。相机600可以与板载处理器和/或远程处理器通信,使得捕获的图像可以在例如用户穿戴的臂带上或经由与臂带通信的远程计算机或处理单元来处理。

109.相机120(例如,相机600)可以包括电路(例如,控制器),该电路被配置成基于从感测信号确定的一个或更多个神经肌肉激活状态从处理器112接收控制信号。例如,第一激活状态可以被处理器112辨别为用户期望捕获图像或发起视频扫描;第二激活状态可以被处理器112辨别为用户期望停止视频扫描;第三激活状态可以被处理器112辨别为用户期望识别特定对象(例如,智能设备或其他对象中的可控对象);第四激活状态可以被处理器112辨别为用户期望控制指定的智能设备或可控对象以执行特定功能;第五激活状态可以被处理器112辨别为用户期望执行与另一个人的交互。上述激活状态可以是任意顺序的,或者可以是独立的步骤。要理解的是,相机120和处理器可以无线通信(例如,经由蓝牙技术、近场通信(nfc)技术等)或通过有线连接通信。

110.图7是示出根据本文所述技术的一些实施例的利用一个或更多个emg传感器740和相机760的系统700的示例实现方式的示意图。例如,系统700可以包括系统100。用户的手臂702和用户的手部704连接并且可以包括用户身体的手臂/手部部分710。手臂/手部部分710包括多个关节和节段,其可被描绘为肌肉骨骼表示。更具体地,用户的手部节段720通过关节连接。手臂702和手部704的手臂定位、手部定位和节段长度中的任何一个或它们的任何组合可以由系统700确定,并被定位在手臂/手部部分210的模型肌肉骨骼表示的三维空间内。此外,除了手部节段720之外,用户的手臂/手部部分710的肌肉骨骼表示可包括前臂节段730。系统700可以用于确定用户的手臂/手部部分710的一个或更多个肌肉骨骼表示,该

一个或更多个肌肉骨骼表示可以用于确定手臂/手部部分710的一个或更多个定位。为此,用户可以穿戴包括emg传感器740的带,emg传感器740感测用于确定肌肉骨骼表示的用户的神经肌肉信号。在emg传感器740感测神经肌肉信号的同时,相机760可用于捕获相机的视场750内的对象。例如,在图7中,相机的视场750可以在用户的手臂/手部部分710的相同的总的延伸方向上,并且可以包括用户的手臂/手部部分710的一部分。在该示例中,如上所述,相机760可以安装在用户的头部上,使得用户可以经由头部运动来改变相机的视场750。除了由emg传感器740获得的感测信号之外,由相机760捕获的数据可用于生成环境的3d地图、识别环境中的智能设备、控制环境中的一个或更多个智能设备、与环境中的另一个人交互等。此外,系统700可以基于感测信号来诸如在ar环境内渲染用户的手臂/手部部分710的表示。

111.图8a-图8d示意性地示出了本技术的实施例,其中可穿戴系统800包括多个神经肌肉传感器810(例如,emg传感器)和布置在臂带812上的相机820(例如,相机600),臂带812被构造成穿戴在用户的手臂814上。可选地,imu、gps和/或其他辅助设备(未示出)可与照相机820和神经肌肉传感器810一起布置在臂带812上。

112.在图8b中,相机820以垂直取向示出,以捕获垂直于用户的手臂814的图像。当用户站在地面上时,用户的手臂814从用户的躯干直接向外保持,使得用户的臂814平行于地面时,臂带812可以在用户的手臂上旋转,使得相机820可以面向上以捕获环境的天花板的图像,即,相机820可以具有从用户的手臂814向上指向的视场。基于对环境的绘制(其可包括天花板和用户上方、旁边、下方和/或前方的特征),本文公开的实施例可以采用几何技术来在环境中定向臂带812和相机820,并因此能够识别在任何给定时间(用户周围的环境中例如,甚至当相机正交于用户的手臂形成的平面指向时在用户前方)的特定空间位置。

113.在本技术的一些实施例中,相机820可被布置成围绕铰链816或其它类型的枢转设备枢转。例如,铰链816可以使相机820能够从图8b所示的垂直取向(也参见图8a)调整至图8c中所示的轴向取向,该轴向取向与垂直取向相差90

°

。在轴向取向上,当用户站在地面上时用户的手臂814从用户的躯干直接向外保持,使得用户的手臂814平行于地面时,相机820的视场可以大致与用户的手臂814的纵向方向对齐。因此,当相机820处于轴向取向时,用户可以容易地使用手臂814上的手指来向前指向相机820的视场中的对象。图8d中的双向箭头示出了包括相机820的可穿戴系统800可以围绕用户的手臂814旋转。

114.在示例实现方式中,用户可以通过执行以下任何一项或它们的任何组合来使用相机820捕获图像和/或视频以生成环境(例如,在图9中示意性地示出的客厅900)的3d地图:在环境内部站在中心位置处,并且在躯干处于固定定位时以弧形扫描手臂814;将手臂814保持在相对于躯干的固定定位处,并将躯干在中心位置处通过0

°

至360

°

的角度旋转到位;在相机820的视场背向环境周边向内瞄准时围绕该周边行走;以及在环境中漫步时相机的视场随机变化。由相机820捕获的图像/视频可以包括具有标准纵横比的静止图像;全景、广角或其他非标准纵横比的静止图像;和/或一个或更多个视频扫描。如上所述,经由神经肌肉传感器810,用户可以使用各种姿态来控制相机820,以告知要用于生成客厅900的3d地图的信息,该3d地图可以包括整个客厅900(包括墙壁、天花板和地板)。例如,可执行对应于第一激活状态的第一姿态,以使相机820捕获静止图像或启动视频扫描;可以执行对应于第二激活状态的第二姿态,以使相机820停止视频扫描;可以执行对应于第三激活状态的第三姿

态,以使相机820的视场中的特定对象(例如,灯902、电视机904、窗帘908等)在对应于客厅900的捕获的相机数据中被识别为智能设备;可以执行对应于第四激活状态的第四姿态,以使相机820的视场中的对象被指定为客厅900的参考对象906。要理解的是,可基于参考对象906来识别关于客厅900生成的3d地图。可选地,对于3d地图的环境可以指定多个参考对象(例如,主要参考对象和次要参考对象,以确保环境和3d地图之间的正确相关性)。

115.在本技术的一些实施例中,当用户在环境中时由相机120捕获的图像/视频可以通过计算机处理器112处理,以确定环境中的一个或更多个参考对象。如果辨别出环境的参考对象,则处理器可以访问储存装置设备122以检索辨别的环境的3d地图。此外,处理器112还可以激活用于辨别的环境的控制接口,以使用户能够经由神经肌肉激活状态(例如,姿态、移动等)与辨别的环境中的智能设备交互。因此,当环境的参考对象被辨别出并且对应的3d地图被检索时,可以通过用户的神经肌肉活动来控制环境中的智能设备,代替使用传统接口来控制辨别的环境中的智能设备(例如,传统的物联网类型智能手机接口)。在实施例中,储存装置设备122可以存储关于多个不同环境的多个不同地图。在另一实施例中,储存装置设备122可以存储关于单个环境的多个地图,其中每个地图识别用户可使用的不同的智能设备集合。例如,可以允许用户a经由对应于控制接口a的地图a通过神经肌肉活动来控制灯和音响系统,而允许用户b经由对应于控制接口b的地图b通过神经肌肉活动控制灯、音响系统和电视。

116.在本技术的一些实施例中,3d地图可以被利用用于xr环境。图10示出了基于xr的系统1000的示意图,该系统可以是将xr系统1001与神经肌肉活动系统1002集成在一起的基于分布式计算机的系统。神经肌肉活动系统1002可以与上面参照图1描述的系统100相同或与之相似。

117.xr系统201可以采取一副护目镜或眼镜、或者护眼装置、或者向用户显示可以叠加在用户的“现实”上的显示元素的其他类型的显示设备的形式。在某些情况下,该现实可以是用户对环境的观察(例如,通过用户的眼睛观看),或者是用户对环境的观察的捕获版本。例如,xr系统1001可以包括一个或更多个相机1004,该一个或更多个相机1004可以安装在用户穿戴的设备内,捕获用户在用户环境中经历的一个或更多个观察。xr系统1001可以包括一个或更多个处理器1005,处理器1005在用户穿戴的设备内和/或外围设备或计算机系统内操作,并且这样的处理器1005可以能够发送和接收视频信息和其他类型的数据(例如,传感器数据)。

118.xr系统1001还可以包括一个或更多个传感器1007,诸如以下中的任何一种或它们的任何组合:麦克风、gps元件、加速度计、红外探测器、触觉反馈元件,等等。在本技术的一些实施例中,xr系统1001可以是基于音频的或听觉的xr系统,并且传感器1007还可以包括一个或更多个耳机或扬声器。此外,xr系统1001还可以包括一个或更多个显示器1008,除了向用户提供由xr系统1001呈现的用户环境的视图之外,显示器1008还允许xr系统1001向用户覆盖和/或显示信息。xr系统1001还可以包括一个或更多个通信接口1006,其使得信息能够被传送到一个或更多个计算机系统(例如,游戏系统或能够渲染或接收xr数据的其他系统)。xr系统可以采取多种形式,可以从许多不同的制造商那里获得。例如,各种实施例可以与一种或更多种类型的xr系统或平台相关联地实现,诸如可从微软公司(美国华盛顿州雷德蒙)获得的hololens全息现实眼镜、可从magic leap(美国佛罗里达州plantation)获得

的lightwear ar头戴装置、可从alphabet(美国加利福尼亚州山景城)获得的google glassar眼镜、可从osterhout design group(也称为odg;美国加利福尼亚州旧金山)获得的r-7smartglasses system、可从facebook(美国加利福尼亚州menlo park)获得的oculus quest、oculus rift s和spark ar studio或任何其他类型的xr设备。

119.xr系统1001可以通过一种或更多种通信方案或方法可操作地耦合到神经肌肉活动系统1002,通信方案或方法包括但不限于蓝牙协议、wi-fi、类似以太网的协议或任何数量的无线和/或有线连接类型。应当理解,例如,系统1001和1002可以直接连接或通过一个或更多个中间计算机系统或网络元件耦合。图10中的双箭头表示系统1001和1002之间的通信耦合。

120.如上所述,神经肌肉活动系统1002可以在结构和功能上系统100。具体而言,神经肌肉活动系统1002可以包括一个或更多个神经肌肉传感器1009、一个或更多个推理模型1010,并且可以创建、维护和存储一个或更多个肌肉骨骼表示1011。在一个示例性实施例中,类似于上面讨论的实施例,神经肌肉活动系统1002可以包括或者可以实现为可穿戴设备,诸如可以由用户穿戴的带子,以便收集(即获得)和分析来自用户的神经肌肉信号。此外,神经肌肉活动系统1002可以包括一个或更多个通信接口1012,其允许神经肌肉活动系统1002诸如通过蓝牙、wi-fi或其他通信手段与xr系统1001通信。值得注意的是,xr系统1001和神经肌肉活动系统1002可以传送可用于增强用户体验和/或允许xr系统1001更准确和有效地运行的信息。

121.在一些实施例中,xr系统1001或神经肌肉活动系统1002可以包括一个或更多个辅助传感器,其被配置为记录辅助信号,该辅助信号也可以作为输入提供给一个或更多个经训练的推理模型,如上所述。辅助传感器的示例包括imu、gps、成像设备、辐射检测设备(例如,激光扫描设备)、心率监视器或能够在一个或更多个肌肉激活的执行期间感测来自用户的生物物理信息的任何其他类型的生物传感器。此外,应当理解,本技术的一些实施例可以使用执行骨骼跟踪的基于相机的系统来实现,例如,可从微软公司(美国华盛顿州雷蒙德市)获得的kinect系统和可从leap motion公司(美国加利福尼亚州旧金山市)获得的leapmotion系统。还应当理解,可以使用硬件和/或软件的任何组合来实现本文描述的各种实施例。

122.虽然图10示出了将xr系统1001与神经肌肉活动系统1002集成在一起的基于分布式计算机的系统1000,但是应当理解的是,这些系统1001和1002的集成本质上可以是非分布式的。在一些实施例中,神经肌肉活动系统1002可以集成到xr系统1001中,使得神经肌肉活动系统1002的各个部件可以被认为是xr系统1001的一部分。例如,来自于由神经肌肉传感器1009感测的神经肌肉信号的输入可以被视为对xr系统1001的输入中的另一个(例如,来自相机1004、来自传感器1007)。此外,可以将从神经肌肉传感器1009获得的对输入(例如,感测信号)的处理集成到xr系统1001中(例如,由处理器1005执行)。

123.如上所述,本技术在某些方面涉及计算机化的地图系统。地图系统可以生成环境(例如,房屋中的房间、建筑物的办公室、仓库室内环境等)的电子三维(3d)地图,并且3d地图可以识别环境中可以远程控制的对象。地图系统可以包括多个神经肌肉传感器、一个或更多个相机、一个或更多个计算机处理器以及一个或更多个存储器设备。神经肌肉传感器可附接到可穿戴设备上,可穿戴设备可以由用户穿戴以感测来自用户的神经肌肉信号。如

本文所讨论的,可以处理神经肌肉信号以确定用户的神经肌肉活动。神经肌肉活动可以由用户的容易可见的移动或用户身体上可能不易可见的肌肉下的变化引起。计算机处理器可以基于由多个神经肌肉传感器感测的神经肌肉信号和由相机捕获的图像信息来生成3d地图,并且可以将3d地图存储在存储器设备中。可以基于由计算机处理器从神经肌肉信号中辨别出的神经肌肉活动来控制相机以捕获一个或更多个图像和/或一个或更多个视频扫描。可使用已知的图像处理的技术将两个或更多个图像和/或两个或更多个视频序列拼接在一起。

124.例如,地图系统可以通过捕获房间的视频扫描和/或捕获房间的一个或更多个静止图像(统称为“捕获的视频/图像”)来生成真实世界房间的3d地图。捕获的视频/图像可以存储在存储器设备中。在捕获的视频/图像中的各种真实世界对象中,用户可以识别一个或更多个可控对象(即,智能设备),该一个或更多个可控对象可以被远程控制为所谓的“物联网”(iot)对象。例如,房间可以包括iot可控灯、iot可控音响系统和iot可控视频游戏监控器。用户可以经由在对捕获的视频/图像进行捕获期间或之后检测到的神经肌肉活动来识别这些iot可控对象。在一个示例中,在视频扫描的情况下,在捕获视频扫描期间,用户可以将他/她的食指指向每个iot可控对象。在另一示例中,用户可以通过经由神经肌肉活动识别iot可控对象来更新房间的先前存在的3d地图。

125.更具体地,多个神经肌肉传感器和相机可以附接到穿戴在用户手臂上的可穿戴设备上。计算机处理器可以被编程为当例如用户食指进行指向时,控制相机捕获静止图像或视频扫描。在该示例中,用户可以用食指进行指向以启动对房间的视频捕获或记录,并且可以移动手臂(以及因此移动相机)以扫描房间的各个部分从而进行视频捕获。可选地,用户可以通过在视频捕获期间执行另一个神经肌肉活动来识别房间中感兴趣的特定对象(例如,iot可控对象)。例如,用户可以上下移动食指以识别房间中感兴趣的对象。每个感兴趣的对象可以被电子标记或打标签,以使对象能够在房间的3d地图中被识别。

126.神经肌肉传感器可以向计算机处理器和/或存储器设备输出一个或更多个信号。这些信号可以由计算机处理器处理,以确定在视频扫描期间用户上下移动他/她的食指的每个指向实例,并将每个这样的实例与iot可控对象相关联。如要理解的,每个iot可控对象可以具有计算机处理器可访问的对应的iot控制系统(例如,对应的iot控制接口),使得计算机处理器可以经由iot控制系统向iot可控对象传送指令信号。

127.为了获得深度信息,相机可以包括红外(ir)距离传感器,该红外(ir)距离传感器包括用于ir发射和ir接收的电路。ir距离传感器可以被配置成向外发射ir光并接收由发射的ir光照射到表面(即,反射表面)上并反射回ir距离传感器而引起的反射ir光。使用已知技术,ir距离传感器中的处理器和/或计算机处理器可以基于ir光的发射和反射ir光的接收之间经过的时间来确定每个反射表面和ir距离传感器之间的距离。要理解的是,ir距离传感器和相机可以对齐,使得相机的成像区域可以与来自ir距离传感器的距离信息相关联。使用已知技术,由相机捕获的图像的像素阵列中的每个像素可与该像素的深度或距离信息相关联。

128.可替代地,相机可以包括能够记录3d静止图像或3d视频的立体相机,或者可以包括相对于彼此被安装成获得可以被组合以产生立体信息的图像信息或视频信息的多个相机。

129.在某些方面,本技术还涉及使用对用户的辨别出的神经肌肉活动来控制支持iot的环境中的智能设备。在这点上,提供了一种iot交互系统,其可包括多个神经肌肉传感器、一个或更多个相机、一个或更多个计算机处理器以及一个或更多个存储器设备。iot交互系统可以是真实世界的系统或基于xr的系统。神经肌肉传感器可附接到可穿戴设备上,可穿戴设备可由用户穿戴以感测来自用户的神经肌肉信号。计算机处理器可以处理由相机捕获的图像数据,以确定图像数据中的对象是否对应于存储在存储器设备中的3d地图的参考对象。如果找到匹配,则可以访问对应于参考对象的3d地图,并且可以激活用于对应于3d地图的环境中的智能设备的控制接口。

130.计算机处理器可以处理来自神经肌肉传感器的感测信号,以确定当用户处于对应于3d地图的环境中时用户的神经肌肉活动。辨别出的神经肌肉活动可以被用于控制环境中的智能设备。如果iot交互系统是基于xr的系统,则可以使其能够具有关于真实世界对象的虚拟体验。例如,用户可以经由神经肌肉活动与房间的真实世界的窗户交互,例如,打开遮蔽窗户的窗帘。交互可以经由对用户指向窗帘的检测和/或经由用户手指的相对移动来指示窗帘将被打开。辨别出的预定神经肌肉活动可以指示用户期望通过窗户看到动画的视图(例如,用户手腕的顺时针转动可以导致动画鸟出现在窗口,用户手腕的逆时针转动可以导致秋天的树叶场景出现在窗口,等等)。

131.在某些方面,本技术还涉及使用对用户的辨别出的神经肌肉活动来与环境(例如,xr环境)中的人交互。在这点上,提供了一种基于xr的系统,其可包括多个神经肌肉传感器、一个或更多个相机、一个或更多个计算机处理器以及一个或更多个存储器设备。神经肌肉传感器可附接到可穿戴设备上,其可由用户穿戴以感测来自用户的神经肌肉信号。计算机处理器可以处理由相机捕获的图像数据以确定环境中的对象是否是人。这种确定可以基于形状、移动、面部特征等。可选地,计算机处理器可以配备有被配置成检测从环境中的人穿戴的设备发出的信号的检测器。如果计算机处理器确定人存在,则计算机处理器可以确定人的身份。例如,可以对捕获的图像数据中的面部特征执行面部识别处理。在另一示例中,从由用户穿戴的设备发出的信号可以提供人的识别。一旦人被识别出,用户就可以使用神经肌肉活动与环境中的人进行交互。

132.例如,辨别出的神经肌肉活动可能被用来与环境中的人玩游戏,向人的智能手机发送信息,向人发送触觉信号等。

133.实现方式a——3d地图的生成

134.根据本技术的实现方式的一些实施例,提供了一种用于获得环境的3d地图的计算机化系统,该计算机化系统可以是系统100。系统可以包括多个神经肌肉传感器、至少一个相机、以及至少一个计算机处理器。多个神经肌肉传感器可以被配置成感测来自用户的神经肌肉信号。例如,多个神经肌肉传感器可以被布置在被构造成由用户穿戴的至少一个可穿戴设备上,以获得神经肌肉信号。至少一个相机可以被配置成基于或响应于来自多个神经肌肉传感器的信号来捕获关于环境中的对象的信息。至少一个计算机处理器可耦合到存储器,并且可被编程为:基于或响应于来自多个神经肌肉传感器的信号或从来自多个神经肌肉传感器的信号中获得的信息,生成环境的3d地图,并使3d地图存储在存储器中。3d地图可以包括识别环境中的对象的信息。

135.在该实现方式的多个实施例中,系统可包括gps电路,该gps电路可提供与3d地图

相关联的gps数据。例如,gps电路可以被配置成基于或响应于来自多个神经肌肉传感器的信号来提供关于环境中的对象的gps坐标。

136.在该实现方式的多个实施例中,来自多个神经肌肉传感器的神经肌肉信号可使环境的多个图像被捕获和/或可以使环境的至少一个视频扫描被捕获。至少一个计算机处理器可以通过将多个图像关联在一起或将至少一个视频扫描的多个部分关联在一起来生成3d地图。例如,至少一个计算机处理器可以被编程为“闭环模式”并使用同时定位与地图创建(slam)技术(例如,视觉slam或vslam、orb-slam、dynaslam等)和/或基于外观的实时建图(rtab-map)技术来“闭合循环”并将多个图像关联在一起或将至少一个视频扫描的多个部分关联在一起。特征跟踪算法(例如,尺度不变特征转换(sift)、加速鲁棒特征(surf)、良好特征跟踪(gftt)、二进制鲁棒独立基本特征(brife)等)可以与slam技术结合使用。要理解的是,可以使用本领域中已知的其他图像关联技术来代替或与本文所标识的技术结合使用。

137.可以理解的是,本文描述的本技术的一些实施例可以生成或利用从预定旋转轴看到的环境的3d地图,其中相机可以旋转通过角扇区(例如,90

°

、180

°

、270

°

、360

°

,等等)以捕获视频和/或图像,并且其中深度可以是一个维度;这些实施例可以涉及可能是部分地图的3d地图。在本技术的其他实施例中,3d地图可以涉及通过多个不同旋转轴(例如,三个相互正交的轴)的旋转;这些实施例的地图可以由沿着多个不同旋转轴从多个不同中心点以任何角度拍摄的视频和/或图像产生,其中多个不同中心点之间建立了几何关系。

138.用于生成3d地图的至少一个计算机处理器可以包括在被绘图的环境的位置处的一个或更多个本地处理器和/或在远离被绘图的环境的位置处的一个或更多个远程处理器。在一些实施例中,本地处理器可以位于相机和神经肌肉传感器位于其上的可穿戴设备上(例如,在图8a的在可穿戴系统800上),或者可以位于可穿戴设备所属的局域网(lan)的一个或更多个服务器内。要理解的是,lan内的通信可以经由以下任何一种或它们的任何组合:wi-fi、3g、4g、5g、蓝牙、其他流媒体传输技术以及还有传统的硬线连接。在一些实施例中,远程处理器可以位于离可穿戴设备较远的设施处(例如,在不同的城市、不同的州、不同的国家等),并且可以经由全球通信网络(例如,因特网)与可穿戴设备通信。要理解的是,尽管用于生成3d地图的一些计算可能相对简单,并且因此可能需要相对少量的计算能力,并且因此可以在可穿戴设备上携带的简单处理器上执行,但其他计算可能需要明显更大量的计算能力,并且因此简单处理器可能不够。因此,用于生成3d地图的一些或全部计算在配备有可以执行的一个或更多个图形处理单元(gpu)的一个或更多个专用(例如,高计算能力)绘图计算机上执行可能是有利的。例如,来自神经肌肉传感器和相机的数据可以流传输或上传到远程云设施,在远程云设施中数据可以由专用计算机访问以根据数据生成3d地图。

139.在该实现方式的多个实施例中,至少一个计算机处理器可以被编程为从神经肌肉信号中识别第一神经肌肉活动。第一神经肌肉活动的每次发生可以使环境的图像将会被捕获或环境的视频扫描将会被捕获。至少一个计算机处理器可以被进一步编程为从神经肌肉信号中确定第二神经肌肉活动,并将第二神经肌肉活动与环境中的可控对象(例如,智能设备)相关联。可以生成3d地图,使得3d地图包括关于环境中的哪个对象是可控对象的信息,使得可控对象可以从3d地图中被识别。即,在环境包括多个可控对象的情况下,可在3d地图上识别可控对象中的每一个。

140.在该实现方式的多个实施例中,第一神经肌肉活动和/或第二神经肌肉活动可以包括以下任何一项或它们的任何组合:用户手指的指向、用户手指的取消指向(unpointing)、用户握拳、用户取消握拳、用户顺时针手腕运动、用户逆时针手腕运动、用户手掌向上姿态和用户手掌向下姿态或任何其他合适的手臂、手指、手部或手腕移动或姿态。要理解的是,至少一种计算机处理器可被编程为针对第一神经肌肉活动和/或第二神经肌肉活动辨别一种或更多种其他类型的神经肌肉活动。

141.在该实现方式的多个实施例中,捕获的关于环境中的对象的信息可以包括以下任何一项或它们的任何组合:环境中的每个对象的视觉图像、环境中的每个对象的一个或更多个深度值以及环境中的每个对象的一个或更多个角度值。例如,对于环境中的每个对象,对象的角度值可以对应于对象与用于3d地图的预定原点之间的角度。该角度的顶点可以对应于在捕获关于环境中的对象的信息期间的至少一个相机的相机位置。环境中的对象的深度值可以是至少一个相机与对象之间的视线距离(line-of-sight distance)。根据环境中的各种对象的尺寸,一个或更多个深度值和/或角度值可以用于本文公开的多个实施例。

142.在该实现方式的多个实施例中,至少一个相机可以布置在至少一个可穿戴设备上。例如,至少一个相机可以包括布置在头戴式设备上的相机。头戴式设备可以是以下中的一个:头带、帽子、头盔和眼镜。在另一示例中,至少一个可穿戴设备可以包括被构造成环绕用户的手腕或前臂的带子。多个神经肌肉传感器可以周向地布置在带子上,并且至少一个相机可以包括被安装在带子上并径向地布置在多个神经肌肉传感器中的一个或更多个的外部的相机。

143.在该实现方式的多个实施例中,至少一个相机可以包括能够捕获3d图像/视频的立体相机。

144.在该实现方式的多个实施例中,至少一个相机可以包括:成像部分和深度确定部分。成像部分可以包括rgb相机。成像部分可以包括至少两个光路。深度确定部分可以包括红外光发射器和接收器。发射器可以被配置成将红外光发射到一个或更多个表面,并且接收器可以被配置成接收来自表面的反射的红外光。

145.在该实现方式的多个实施例中,由至少一个相机捕获的关于环境中的对象的信息可以包括多个图像,其中每个图像由像素阵列形成。像素阵列的每个像素可以包括深度数据和视觉数据。

146.在该实现方式的多个实施例中,至少一个计算机处理器可以被编程为:识别和标记3d地图中的对象中的特定对象作为环境的参考对象,并且识别和标记3d地图中相对于参考对象的其他对象,使得对3d地图中的参考对象的物理位置的识别能够识别3d地图中的其他对象的物理位置。

147.在该实现方式的多个实施例中,环境的参考对象可以基于以下任何一项或它们的任何组合来确定:参考对象的形状、参考对象的颜色或颜色的组合、参考对象上的符号和参考对象上的表面浮雕结构。例如,当发现在关于3d地图识别的参考对象和由相机捕获的图像中的对象之间匹配时,可以从存储器设备中检索3d地图。

148.图11示出了用于该实现方式的实施例的处理流程1100的流程图。在s1102处,用户身上的神经肌肉传感器感测用户的神经肌肉信号,并且处理感测信号。例如,神经肌肉传感器可以附接到围绕用户的手臂穿戴的带子上。在s1104处,如果确定神经肌肉信号包括对应

于第一神经肌肉活动的一个或更多个信号,则处理流程1100进行到s1106处;如果否,则处理流程1100返回到s1102处。例如,第一神经肌肉活动可以是用户握拳以开始对用户的当前环境进行成像。在s1106处,捕获3d图像/视频,同时继续感测和处理用户的神经肌肉信号。例如,图像/视频可以由附接到围绕用户的手臂穿戴的带子上的3d相机捕获。

149.在s1108处,如果确定神经肌肉信号包括对应于第二神经肌肉活动的一个或更多个信号,则处理流程1100进行到s1110处;如果否,则处理流程1100返回到s1106处。例如,第二神经肌肉活动可以是用户将拇指和食指捏合在一起。在s1110处,标记当第二神经肌肉活动发生时出现在图像/视频中的对象。例如,用户可以执行第二神经肌肉活动以指示环境的参考对象。参考对象可以是用于相对于其他环境来识别环境的对象。环境可以具有一个参考对象或多个参考对象。要理解的是,3d相机的视场可以与用户手臂的方向对齐,或者可以与该方向正交,或者与该方向成某种其他角度,使得用户的手部或其一部分可以在图像中被捕获或可以在图像中不被捕获。可选地,如果在图像中被捕获,用户的手部可以促进将对象识别为参考对象;然而,如本文所述,不需要捕获用户的手部来知道手的手指指向何处,因为可以将经由用户穿戴的可穿戴系统上的一个或更多个神经肌肉传感器(例如,emg传感器)从用户获得的神经肌肉信号和从可穿戴系统上的相机获得的图像信息提供给经训练的推理模型,以确定用户手部的手指何时指向何地。应当理解的是,可以通过将用户手指的指向方向外推到根据图像信息确定的对象来实现对特定对象的识别。当环境中具有彼此相隔很远的对象时,单次的外推就足以识别特定对象。另一方面,当环境中有多个彼此接近的对象时,可能使用多次外推来识别特定对象。例如,在多次外推的情况下,每次外推可以来自从不同视角指向对象的用户的手指,并且外推的交点可以用于识别特定对象。

150.然后处理流程进行到s1112,在s1112确定神经肌肉信号是否包括对应于第三神经肌肉活动的一个或更多个信号。如果是,则处理流程1100进行到s1114;如果否,则处理流程1100返回到s1106。例如,第三神经肌肉活动可以是用户指向手指。在s1114处,标记当发生第三神经肌肉活动时出现在图像中的对象。例如,第三神经肌肉活动可由用户执行以指示环境中的智能设备。然后,处理流程进行到s1116,在s1116确定神经肌肉信号是否包括对应于第四神经肌肉活动的一个或更多个信号,对应于第四神经肌肉活动的一个或更多个信号可以指示用户期望停止捕获关于环境的信息。如果否,则处理流程1100返回到s1106,以使另一个参考对象和/或另一个智能设备能够被标记。如果是,处理流程1100进行到s1118,在s1118停止感测和处理神经肌肉信号,停止捕获图像,并存储对应于感测的和经处理的神经肌肉信号的传感器数据和对应于图像的相机数据。存储的传感器数据和/或存储的相机数据可以包括原始数据或经处理的数据、或者原始数据和经处理的数据两者。数据可以被存储,使得可以基于标记的参考对象来搜索数据。

151.图11的处理流程1100可用于获得关于环境的信息以产生环境的3d地图。

152.图12示出了用于该实现方式的另一实施例的处理流程1200的流程图。在s1202处,环境的多个捕获的图像或环境的一个或更多个视频扫描的部分被拼接在一起以形成环境的3d地图。例如,来自图11的处理流程1100的图像可用于这方面。在s1204处,更新环境的3d地图以(例如,基于在图11的s1114处的第三神经肌肉活动)识别被标记为智能设备的每个对象。在s1206处,对于在3d地图上识别的每个智能设备,在智能设备和用于该智能设备的控制接口之间形成链接。因此,当访问环境的3d地图以进行使用时,激活在3d地图中识别的

每个智能设备以实现远程可控。在s1208处,更新环境的3d地图以(例如,基于在图11中的s1110处的第二神经肌肉活动)识别被标记为参考对象的每个对象。在s1210处,更新的3d地图被存储在存储器设备中,使得基于在3d地图上识别的环境的参考对象可搜索3d地图。要理解的是,到智能设备的链接可以是用于使用iot技术远程控制智能设备的任何手段。在一些实施例中,链接可以是本领域中已知的用户接口,其使得能够进行经由处理指令并将控制信号传输到智能设备的服务器将指令从用户到智能设备的通信。例如,通信可以经由wi-fi、蓝牙、lan、wan和/或用于将指令发送到服务器的任何合适的有线或无线技术。服务器可以被编程为从用户接口接收指令,并向智能设备传输适当的控制信号。传输可以经由wi-fi、蓝牙、lan、wan和/或用于将控制信号发送到智能设备的任何合适的有线或无线技术。因此,当访问环境的3d地图以进行使用时,用于环境中的智能设备的用户接口可以被访问并被激活以供使用,使得从对用户的辨别出的神经肌肉活动确定的指令可以经由用户接口传输到对应于智能设备的一个或更多个服务器,以类似于传统上通过经由例如平板计算机、智能手机和/或一个或更多个其他输入设备接收的指令来控制智能设备的方式来处理指令并控制环境中的智能设备。

153.实现方式b——3d地图的使用

154.根据本技术的实现方式的一些实施例,提供了一种用于对设备进行远程控制的计算机化系统,该计算机化系统可以是系统100、或系统1000、或这些系统100、1000的变体。系统可以包括多个神经肌肉传感器、至少一个相机、以及至少一个计算机处理器。多个神经肌肉传感器可以被布置在被构造成由用户穿戴的至少一个可穿戴设备上,以感测来自用户的神经肌肉信号。至少一个相机可以被配置成捕获关于用户感兴趣的环境的信息。至少一个计算机处理器可以被编程为基于由至少一个相机捕获的关于环境的信息来访问环境的地图信息。地图信息可以包括用于控制环境中的至少一个可控对象的信息。至少一个计算机处理器还可以被编程为响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的神经肌肉活动,控制至少一个可控对象从第一状态改变到第二状态。

155.在该实现方式的多个实施例中,环境的地图信息可以存储在存储器中,并且至少一个计算机处理器可以被编程为基于从由至少一个相机捕获的关于环境的信息中辨别出的信息从存储器中检索地图信息。例如,辨别出的信息可以在环境中可见,并且可以包括以下中任何一项或它们的任何组合:qr码、图形符号、字母数字文本串、具有特定形状的3d对象和至少两个对象之间的物理关系。辨别出的信息可以包括环境的参考对象。例如,如果相机检测到小桌子和/或小办公灯,系统可以使用该信息并帮助将给定环境识别为家庭办公环境;如果相机检测到沙发和/或搁脚凳,系统可以使用该信息并帮助将该环境识别为客厅或者家庭房间;如果相机检测到建筑照明和/或天花板装置,则系统可以使用该信息并帮助将环境识别为办公空间或仓库;如果相机检测到一定波长范围内的自然光和/或检测到机动交通工具,则系统可以使用该信息并帮助将环境识别为室外;等等。

156.在该实现方式的多个实施例中,地图信息可以包括关于环境中两个或更多个可控对象之间的物理关系的地图数据。例如,地图数据可以包括一个或多个已建立的中心点,并且环境中的两个或更多个可控对象之间的物理关系可以从已建立的中心点确定。地图数据可以包括环境中的对象的3d全景数据。在一个示例中,3d全景数据可以包括环境的局部视图。在另一示例中,3d全景数据可以包括通过单个旋转轴或多个不同旋转轴的环境的表示。

157.在该实现方式的多个实施例中,环境可以是包括虚拟对象和真实世界对象的xr环境。至少一个计算机处理器可以被编程为:根据由至少一个相机捕获的关于环境的信息确定环境中的参考对象;以及根据地图信息确定虚拟对象的位置信息和真实世界对象的位置信息。地图信息可以包括至少一个可控对象相对于参考对象的位置信息。

158.在该实现方式的多个实施例中,从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的神经肌肉活动由当用户在环境中时相对于至少可控对象执行至少一个姿态引起。至少一个姿态可以包括以下任何一项或它们的任何组合:用户相对于至少一个可控对象移动至少一个手指(例如,用户相对于至少一个可控对象向上或向下移动至少一个手指);用户相对于至少一个可控对象移动手腕(例如,用户相对于至少一个可控对象向上或向下倾斜手腕);用户相对于至少一个可控对象移动手臂(例如,用户相对于至少一个可控对象向上或向下移动手臂);以及用户使用两个或更多个手指执行相对于至少一个可控对象的捏合动作。

159.在本实现方式的多个实施例中,至少一个可控对象可以包括多个可控对象。至少一个姿态可以包括相对于多个可控对象中的一个可控对象的姿态。至少一个计算机处理器可被编程为响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的神经肌肉活动,控制多个可控对象中的每一个可控对象从第一状态改变到第二状态。

160.在本实现方式的多个实施例中,环境可以是以下中的任何一个或它们的任何组合:家庭中的一个或更多个房间;企业中的一个或更多个房间;多层建筑物的一层或更多层;以及室外区域。

161.在本实现方式的多个实施例中,至少一个可控对象包括以下中的任何一个或它们的任何组合:灯、显示设备、电子游戏机、窗帘、音响系统、锁和食品或饮料制备设备。

162.图13示出了用于该实现方式的实施例的处理流程1300的流程图。在s1302处,由相机捕获环境的图像/视频。例如,图像/视频可以由附接到围绕用户手臂穿戴的带子上的相机捕获。在s1304处,处理图像/视频以确定是否可以辨别出参考对象。如果否,则处理流程1300返回到s1302。如果是,则在s1306处,基于辨别出的参考对象访问环境的3d地图。此外,在s1306处,为环境中的一个或更多个智能设备识别一个或更多个控制接口。例如,控制接口可以链接到3d地图(例如,参见图12中的s1206)。在s1308处,由神经肌肉传感器连续感测用户的神经肌肉信号,并且继续捕获图像/视频。例如,神经肌肉传感器可以附接到相机所附接的带子上。处理流程1300进行到s1310,在s1310处确定神经肌肉信号是否包括对应于第一神经肌肉活动的一个或更多个信号。如果是,则处理流程1300进行到s1312;如果否,则处理流程1300返回到s1308。例如,第一神经肌肉活动可以是用户用手指进行指向。在s1312处,利用3d地图来识别对应于第一神经肌肉活动的智能设备,并且(例如,经由到3d地图的链接)访问用于被识别的智能设备的控制接口。3d相机的视场可以与用户手臂的方向对齐,使得用户的手指可以被捕获在图像/视频中,以促进对智能设备的识别。例如,智能设备可以是窗帘(例如,图9中的908)。

163.在s1314处,确定神经肌肉信号是否包括对应于第二神经肌肉活动的一个或更多个信号。如果否,则处理流程1300进行到s1318。如果是,则处理流程1300进行到s1316,在s1316处,根据第二神经肌肉活动来控制被识别的智能设备。继续窗帘的先前示例,如果第二神经肌肉活动是用户将拇指和食指捏合在一起,则可以经由链接到3d地图的控制接口激

活的电子机构来控制窗帘以关闭窗帘。在s1318处,确定神经肌肉信号是否包括对应于第三神经肌肉活动的一个或更多个信号。如果否,则处理流程1300返回到s1308。如果是,则处理流程1300进行到s1320,在s1320处对神经肌肉信号的感测和处理停止,并且对图像的捕获停止。

164.在该实现方式的一些实施例中,当用户处于环境中时,用户可以穿戴可穿戴系统800,该可穿戴系统800可以连续地流传输图像数据,或者周期性地流传输图像数据(例如,abab中的a秒成像“打开”然后b秒成像“关闭”,等等,重复序列),或者偶尔流传输图像数据(例如,c秒“打开”然后“关闭”,直到检测到神经肌肉事件)。在这些实施例中,图像数据可用于连续地或周期性地或偶尔地“定位”或确定用户在环境中的位置和/或取向。在偶尔流传输图像数据的情况下,当用户例如在环境中用他或她的手指指向时,c秒图像数据可以被存储(例如,在高速缓存中)并用新的c秒图像数据更新;因此,当用户执行活动时,可以一起执行对新的c秒图像数据和神经肌肉信号的处理,但除此之外,处理被推迟以节省处理资源的使用。在这点上,为了节省处理资源,可以使用差分技术来存储例如多个图像帧之间的不同信息,而不是存储它们全部的图像帧。例如,如果用户在环境中缓慢移动,并且当用户移动时图像帧显示墙的缓慢变化,则可以存储对应于变化的数据而不是图像帧的全部的数据。

165.在该实现方式的一些实施例中,用户穿戴的可穿戴系统800可包括imu传感器,imu传感器可帮助将用户在环境中定位(即,确定用户的定位和定向)。例如,来自imu传感器的数据可以通过考虑人类手臂限制(上面讨论的)来改进定位处理,以给出对用户的手臂定向(例如,角度)的更精确的确定。通过使用已知的人类手臂限制来消除将不可能的手臂定位作为定位处理的一部分,可以更快地确定用户的定位。例如,典型的人类手臂可以旋转通过例如

±

135

°

的弧线(基于对应于完整圆的

±

180

°

的最大可能弧线)。对用户手臂定位/定向的限制将消除用户指向需要用户的手臂旋转大于

±

135

°

的对象的可能性,从而消除不必要的计算。

166.实现方式c——硬件,包括编程硬件

167.根据本技术的实现方式的一些实施例,提供了一种电子装置。装置可以包括:可穿戴载体;附接于载体的多个神经肌肉传感器;相机系统;以及被配置成与多个神经肌肉传感器和相机系统进行电子通信至少一个计算机处理器。装置还可以包括通信接口,该通信接口被配置成在多个神经肌肉传感器、相机系统和至少一个计算机处理器之间传输信号。通信接口可以包括以下中的任何一项或它们的任何组合:将多个神经肌肉传感器和相机系统直接互连的布线;将多个神经肌肉传感器和至少一个计算机处理器直接互连的布线;将相机系统和至少一个计算机处理器直接互连的布线;互连多个神经肌肉传感器、相机系统和至少一个计算机处理器的有线通信总线;无线信号发射器;以及无线信号接收器。

168.在该实现方式的多个实施例中,至少一个处理器可以附接到载体上,并且可以被配置成访问存储器设备以检索信息并存储信息。存储器设备可附接到载体上。

169.在该实现方式的实施例中,相机系统可以包括至少两个光路。例如,相机系统可以包括立体相机。

170.在该实现方式的多个实施例中,相机系统可以包括:成像部分和深度确定部分。成像部分可以包括以下中的任何一项或它们中的任何组合:静止图像相机、rgb相机、全景相机和视频相机。成像部分可以配备有多种类型的透镜和/或滤镜。例如,成像部分可以配备

有广角或鱼眼镜头,其可以使成像部分能够捕获环境的更大区域,这在某些情况下用于加速对环境中对象的跟踪。深度确定部分可以包括光束发射器和接收器。例如,光束发射器和接收器可以是红外光束发射器和接收器。至少一个计算机处理器可以包括被配置成控制成像部分和深度确定部分以同时捕获数据的控制器。

171.在该实现方式的多个实施例中,至少一个计算机处理器可以被编程为:从成像部分接收图像信号;从深度确定部分接收深度信号;生成将图像信号的至少一部分与深度信号的至少一部分相关联的相关数据;并且使存储器设备存储相关数据。

172.在该实现方式的多个实施例中,载体可以被构造成由用户穿戴。在一个示例中,载体可以被构造成穿戴在用户的手上(例如手套)。在另一示例中,载体可以是被构造成穿戴在用户手臂上的臂带(例如,松紧带、可调节带)。在该示例中,臂带的尺寸可以被设置成环绕用户的手腕或前臂部分,并且多个神经肌肉传感器周向地布置在臂带上。多个神经肌肉传感器可以包括emg传感器。

173.在该实现方式的多个实施例中,相机系统可以与多个神经肌肉传感器一起周向布置在臂带上。例如,相机系统可以径向布置在多个神经肌肉传感器中的一个或更多个神经肌肉传感器的外部的臂带上。相机系统可以布置在臂带上以可以在垂直定向和轴向定向上往返移动,在垂直取向上当臂带穿戴在用户的臂上时相机系统从臂带径向向外指向,在轴向取向上当臂带穿戴在用户的臂上时相机系统轴向指向平行于臂带的中心轴线的方向。相机系统可以附接到被构造成将相机系统从垂直定向枢转到轴向定向的铰链上,以使相机系统能够在垂直定向、或轴向定向、或垂直定向和轴向定向之间的定向上捕获图像信息。

174.在本实现方式多个实施例中,装置还可以包括被构造成穿戴在用户的头部上的第二载体。相机系统可以附接到第二载体。

175.在本实现方式的多个实施例中,装置还可以包括附接到可穿戴载体或第二可穿戴载体的辅助设备。辅助设备可以包括以下中的任何一项或它们中的任何组合:imu、gps、辐射检测器、心率监测器、水分(例如,排汗)检测器等。

176.实现方式d——经由神经肌肉活动的交互

177.根据本技术的实现方式的一些实施例,提供了一种用于经由神经肌肉活动执行交互的计算机化系统。系统可包括:多个神经肌肉传感器、相机系统以及至少一个计算机处理器。可以被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器可以被布置在由用户穿戴的至少一个可穿戴设备上以获得神经肌肉信号。可以被配置成捕获关于用户感兴趣的环境的信息的相机系统可以包括成像部分和深度确定部分。至少一个计算机处理器可以被编程为:从相机系统接收捕获的信息并且从多个神经肌肉传感器接收神经肌肉信号;从捕获的信息中辨别环境;访问与从捕获的信息中辨别的环境相关联的控制信息,控制信息包括用于执行与环境相关联的至少一个功能的信息;并且,响应于从神经肌肉信号中辨别出的神经肌肉活动,使得至少一个功能被执行。

178.在该实现方式的多个实施例中,环境可以是室外区域,并且控制信息可以包括用于执行室外功能的信息。室外功能可以是与运输相关的功能。在一个示例中,与运输相关的功能可以是启动汽车。在另一示例中,与运输相关的功能可以是使得在室外区域发送用于拾取的请求。至少一个计算机处理器可以被编程为经由互联网传输向运输服务供应商发送请求。

179.在该实现方式的多个实施例中,至少一个计算机处理器可以被编程为基于捕获的信息来确定环境中是否存在人。例如,至少一个计算机处理器可以被编程为基于以下中的一项或它们的任何组合来确定人存在于环境中:辨别出的人的大体形状、辨别出的人身上的至少一个肢体的存在、辨别出的人的面部特征、辨别出的人的移动、以及辨别出的人携带的物体。至少一个计算机处理器还可以被编程为使得如果确定人在环境中,则可以基于辨别出的人的面部特征来确定人的身份。

180.在该实现方式的多个实施例中,系统还可以包括被配置成向外部设备发射电子信号并从外部设备接收电子信号的通信接口。外部设备可以是以下中任何一项或它们的任何组合:智能设备、智能手机、触觉设备、游戏机以及显示设备。在一些实施例中,至少一个计算机处理器可被编程为基于辨别出的人的面部特征来确定环境中的人的身份;基于人的身份访问交互式控制应用;以及利用交互式控制应用使得以下中的任何一项或它们的任何组合被执行:将个人消息传输到人的智能手机、在由人玩的电子游戏机中执行游戏移动、激活由人穿戴的触觉设备、在环境中的人可观看的显示设备上显示图像、以及允许人控制环境的功能。至少一个计算机处理器可以被编程为使许可被授予人以控制以下中的任何一项或它们的任何组合:电子游戏机、显示设备、用户的智能手机以及用户穿戴的触觉设备。

181.在该实现方式的多个实施例中,至少一个计算机处理器可以被编程为利用交互式控制应用来生成用户和人可以在其中交互的xr环境。在一个示例中,至少一个计算机处理器可以被编程以使用户能够基于从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的神经肌肉活动与xr环境中的人交互。在另一示例中,至少一个计算机处理器可以被编程为利用交互式控制应用来:打开可由用户和人操作的电子设备,并且响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的一个或更多个神经肌肉活动,控制电子设备的至少一个操作。例如,电子设备可以是用户和个人可玩的游戏机,并且响应于从神经肌肉信号中辨别出的一个或更多个神经肌肉活动,至少一个计算机处理器控制以下中的任何一项或它们的任何组合:游戏玩家移动、游戏效果和游戏设置。

182.图14a和图14b示出了用于该实现方式的实施例的处理流程1400的流程图。在s1402处,由相机捕获环境的图像/视频。例如,图像/视频可以由附接到围绕用户的手臂穿戴的带子上的相机捕获。在s1404处,处理图像/视频以确定是否可以辨别参考对象。如果否,则处理流程1400返回到s1402。如果是,则在s1406处,基于辨别出的参考对象访问环境的3d地图。此外,在s1406处,针对环境识别一个或更多个控制接口。例如,控制接口可以用于链接到3d地图的环境的通信功能。在s1408处,通过神经肌肉传感器连续感测用户的神经肌肉信号,并且继续捕获图像/视频。例如,神经肌肉传感器可以附接到相机所附接的带子上。处理流程1400进行到s1410,在s1410确定是否在环境中检测到人。例如,检测可以经由图像/视频中的对象的形状像人的确定。如果检测到人,则处理流程1400进行到s1412;如果否,则处理流程1400返回到s1408。

183.在s1412处,执行处理以识别人。例如,如果人携带智能手机或其他电子设备(例如,另一神经肌肉臂带或腕带),则来自智能手机或其他电子设备的信号可由附接到相机附接在其上的带子上的电子电路(例如,nfc电路、rfid电路等)检测。在另一示例中,面部检测可用于从图像/视频中识别人。在又一示例中,人可以穿戴可穿戴系统(例如,图8a中的可穿戴系统800),可穿戴系统可以提供可用于识别人的识别信号。在s1414处,如果不能识别到

人,则处理流程1400返回到s1408。如果在s1414处识别到人,则处理流程1400进行到s1416,在s1416识别或访问与被识别的人相关联的一个或更多个控制接口以进行使用。

184.在s1418处,确定神经肌肉信号是否包括对应于针对环境中的动作或与被识别的人的交互的神经肌肉活动的一个或更多个信号。如果是,则处理流程1400进行到s1422;如果否,则处理流程1400经由s1420返回到s1418,在s1420处继续感测和处理用户的神经肌肉信号,以确定是否存在针对环境中的动作或与被识别的人的交互的神经肌肉活动。

185.在s1422处,使用与被识别的人相关联的控制接口和/或与环境相关联的控制接口以与被识别的人交互(例如,向被识别的人的智能手机发送文本消息)和/或用于控制环境中的动作(例如,启动环境中的xr功能)。在s1424处,确定神经肌肉信号是否包括对应于神经肌肉活动以退出在环境中的控制操作和交互的一个或更多个信号。如果否,则处理流程1400经由s1420前进到s1418。如果是,则处理流程1400进行到s1426,在s1426处对神经肌肉信号的感测和处理停止,并且图像/视频的捕获停止。如果系统与被识别的人交互,这种交互可以包括以下中的任何一项或它们的任何组合:向被识别的人的移动电话或计算机发送离散的文本或电子邮件消息,在用户和被识别的人之间同步一个或更多个智能设备,在xr环境中发送被识别的人可以在xr环境中看到的消息或通信,等等。

186.在一些实施例中,两个或更多个用户可以与xr环境交互。每个用户(例如,用户a和用户b)可以对于xr系统通过可穿戴设备(例如,图8a中的可穿戴系统800)被唯一地识别。在这种情况下,不需要面部辨别,因为每个用户的可穿戴设备将被注册到xr系统中的不同账户,使得每个可穿戴设备对于xr系统将唯一地识别用户。因此,每个用户可以独立于另一个用户与xr环境中的对象交互,并且还可以与xr环境中的另一个用户交互。此外,每个用户可以与用于相同xr环境的不同3d地图相关联(例如,用户a可以是儿童并且可以仅具有对用户a的3d地图的xr环境中的灯的控制,而用户b可以具对用户b的3d地图的xr环境中的电视和视频游戏系统的控制)。在实施例中,当多个用户同时处于同一xr环境中时,xr系统可以使所有用户能够共享对彼此的可控对象的控制(例如,用户a和用户b都可执行关于视频游戏系统的控制操作)。在这点上,当用户a和用户b二者在同一xr环境中时,用户a的3d地图可以与用户b的3d地图合并或拼接在一起。

187.在基于云的实施例中,环境可以与多个用户相关联,并且每个用户可以配备有可用于控制环境中的一个或更多个对象的可穿戴带(例如,图8a中的可穿戴系统800)。例如,环境可以是具有多个不同区域的工作场所,并且多个用户可以是工作场所的雇员。雇员a和雇员c可以与环境的区域a的地图a1和区域c的地图c相关联。雇员b和雇员d可以与环境的区域a的地图a2和区域b的地图b相关联。地图a1、地图a2、地图b和地图c可以远程存储在云设施中,云设施可以由工作场所管理人员控制。因此,工作场所管理人员可以授权第一组雇员具有经由地图a1控制区域a内的第一组对象的许可,并且可以授权第二组雇员具有经由地图a2控制同一区域a内的第二组对象的许可。

188.工作场所管理人员可以经由雇员可穿戴带控制每个雇员的授权细节,并且可以经由雇员的可穿戴带改变雇员的授权。每个可穿戴带可以与识别码相关联,识别码可用于将可穿戴带与环境的区域的一个或更多个3d地图相关联。例如,环境可以是具有多个库存室的仓库,并且地图a1可以允许一组雇员在区域a中操作重型机械,而地图a2可以允许另一组雇员在区域a中操作轻型机械。要理解的是,一些雇员可以与地图a1和a2相关联,并且因此

可以被允许操作轻型机械和重型机械。要理解的是,工作场所管理人员可以使用关于环境的区域的3d地图针对环境的区域设置各种其他类型的控制,并且上面的描述仅是一个示例的说明。

189.当处于环境中时,每个可穿戴带可以(例如,使用rfid技术、nfc技术、gps技术等)发出识别信号。这样的信号可用于确定哪个雇员在环境中,以及大致确定雇员在环境中的哪里(例如,环境的哪个区域);上面描述的定位技术(例如,使用视频流)可用于确定用户的更精确位置(例如,雇员位于环境的区域内的位置)。在一些实施例中,可以使用这样的信号来访问一个或更多个3d地图,这可以使对应于该信号的雇员能够控制环境中的对象或能够以其他方式与环境交互(例如,使环境中的第一雇员能够经由指示想要将控制授权从第一雇员转移到第二雇员的神经肌肉动作与该环境中的第二雇员交互;使第一雇员能够向第二雇员发送触觉警告信号等)。

190.要理解的是,3d地图和可由管理人员使用的其他信息的基于云的存储可以实现对工作场所环境的集中监督,该工作场所环境可以包括多个城市和/或多个州和/或多个国家中的区域。例如,管理人员可以通过控制授予每个雇员的授权或许可来控制雇员,基于每个员工的可穿戴带和与每个员工的可穿戴带相关联的3d地图,在员工之间授权或许可可以相互不同。

191.示例实施例

192.示例1:一种用于对设备进行远程控制的计算机化系统可以包括被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器,其中多个神经肌肉传感器被布置在被构造成由用户穿戴的至少一个可穿戴设备上以获得神经肌肉信号。系统还可以包括能够捕获关于环境的信息的至少一个相机和至少一个计算机处理器,该至少一个计算机处理器被编程为:基于由至少一个相机捕获的关于环境的信息访问环境的地图信息,地图信息包括用于控制环境中的至少一个可控对象的信息,并且响应于从由多个神经肌肉传感器感测的神经肌肉信号中辨别出的神经肌肉活动,控制至少一个可控对象从第一状态改变到第二状态。

193.示例2:根据示例1所述的系统,其中:环境的地图信息存储在存储器中,并且至少一个计算机处理器基于从由至少一个相机捕获的关于环境的信息中辨别出的信息从存储器中检索地图信息。

194.示例3:根据示例1或2所述的系统,其中,辨别出的信息在环境中是可见的,并且包括以下中的至少一项:qr码、图形符号、字母数字文本串、具有特定形状的3d对象或至少两个对象之间的物理关系。

195.示例4:根据示例1-3中任一项所述的系统,其中,辨别出的信息包括环境的参考对象。

196.示例5:根据示例1-4中任一项所述的系统,其中,所述地图信息包括表示环境中两个或更多个可控对象之间的物理关系的地图数据。

197.示例6:根据示例1-5中任一项所述的系统,其中,所述地图数据是环境中的对象的3d全景数据,对象包括至少一个可控对象。

198.示例7:根据示例1-6中任一项所述的系统,其中,所述3d全景数据包括环境的360

°

表示。

199.示例8:根据示例1-7中任一项所述的系统,其中,所述3d全景数据包括相对于单个

旋转轴的数据。

200.示例9:根据示例1-8中任一项的系统,其中,所述3d全景数据包括环境的局部视图的表示。

201.示例10:根据示例1-9中任一项所述的系统,其中,所述地图信息包括多个已建立的中心点,并且其中,从所述已建立的中心点确定所述环境中的两个或更多个可控对象之间的物理关系。

202.示例11:根据示例1-10中任一项所述的系统,其中,所述环境是包括虚拟对象和真实世界对象的扩展现实(xr)环境,其中,所述至少一个计算机处理器被编程为:根据所述地图信息确定所述虚拟对象的位置信息和所述真实世界对象的位置信息,以及根据由所述至少一个相机捕获的关于所述环境的信息确定所述环境中的参考对象,并且其中,所述地图信息包括所述至少一个可控对象相对于所述参考对象的位置信息。

203.示例12:根据示例1-11中任一项所述的系统,其中,从由所述多个神经肌肉传感器感测的所述神经肌肉信号中辨别出的所述神经肌肉活动由当所述用户在所述环境中时所述用户相对于所述至少可控对象执行至少一个姿态引起。

204.示例13:示例1-12中任一项所述的系统,其中,所述至少一个姿态包括以下中任何一项或它们的任何组合:所述用户相对于所述至少一个可控对象移动至少一个手指;所述用户相对于所述至少一个可控对象移动手腕;所述用户相对于所述至少一个可控对象移动手臂;所述用户施加力但相对于所述至少一个可控对象不移动;以及所述用户激活运动单位但相对于所述至少一个可控对象不移动并且没有相对于所述至少一个可控对象的力。

205.示例14:根据示例1-13中任一项所述的系统,其中,从由所述多个神经肌肉传感器感测的所述神经肌肉信号中辨别出的神经肌肉活动由当所述用户在所述环境中时所述用户相对于所述至少可控对象执行运动单位激活电位(muap)活动。

206.示例15:根据示例1-14中任一项所述的系统,其中,所述至少一个姿态包括以下中的至少一项:所述用户使用两个或更多个手指执行相对于所述至少一个可控对象的捏合动作,所述用户相对于所述至少一个可控对象向上或向下倾斜手腕,所述用户相对于所述至少一个可控对象向上或向下移动手臂,或者所述用户相对于所述至少一个可控对象向上或向下移动至少一个手指。

207.示例16:根据示例1-15中任一项所述的系统,其中:所述至少一个可控对象包括多个可控对象,所述至少一个姿态包括相对于所述多个可控对象中的一个可控对象的姿态,并且所述至少一个计算机处理器被编程以响应于所述控制信号,控制所述多个可控对象中的每一个可控对象从第一状态改变到第二状态。

208.示例17:根据示例1-16中任一项所述的系统,其中,所述环境是以下中的至少一个:家庭中的房间、企业中的房间、多层建筑物的楼层或室外区域。

209.示例18:根据示例1-17中任一项所述的系统,其中,所述至少一个可控对象包括以下中的任何一项或它们的任何组合:显示设备、灯、电子游戏机、窗帘、音响系统、锁和食品或饮料制备设备。

210.示例19:一种计算机实现的方法,包括:激活被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器,所述多个神经肌肉传感器被布置在被构造成由所述用户穿戴的至少一个可穿戴设备上以获得所述神经肌肉信号;激活能够捕获关于环境的信息的至少一

个相机;基于由所述至少一个相机捕获的关于所述环境的信息访问所述环境的地图信息,所述地图信息包括用于控制所述环境中的至少一个可控对象的信息;以及响应于从由所述多个神经肌肉传感器感测的所述神经肌肉信号中辨别出的神经肌肉活动,控制所述至少一个可控对象从第一状态改变到第二状态。

211.示例20:一种可穿戴电子设备,包括:被配置成感测来自用户的神经肌肉信号的多个神经肌肉传感器,所述多个神经肌肉传感器被布置在被构造成由所述用户穿戴的至少一个可穿戴设备上以获得所述神经肌肉信号;能够捕获关于环境的信息的至少一个相机;以及至少一个计算机处理器,所述至少一个计算机处理器被编程为基于由所述至少一个相机捕获的关于所述环境的信息来访问所述环境的地图信息,所述地图信息包括用于控制所述环境中的至少一个可控对象的信息,并且响应于从由所述多个神经肌肉传感器感测的所述神经肌肉信号中辨别出的神经肌肉活动,控制所述至少一个可控对象从第一状态改变到第二状态。

212.本公开的实施例可以包括各种类型的人工现实系统或者结合各种类型的人工现实系统来实现。人工现实是一种在呈现给用户之前已经以某种方式调整过的现实形式,其可以包括例如虚拟现实、增强现实、混合现实、混杂现实或其某种组合和/或衍生物。人工现实内容可以包括完全由计算机生成的内容或与捕获(例如,真实世界)内容组合的计算机生成的内容。人工现实内容可以包括视频、音频、触觉反馈或它们的某种组合,它们中的任何一个可以在单个通道或多个通道中呈现(例如向观看者产生三维(3d)效果的立体视频)。此外,在一些实施例中,人工现实也可以与应用、产品、配件、服务或其一些组合相关联,这些应用、产品、配件、服务或其一些组合用于例如在人工现实中创建内容和/或以其他方式用于人工现实(例如,以在人工现实中执行活动)。

213.人工现实系统可以以各种不同的形状因子和配置来实现。一些人工现实系统可以被设计成在没有近眼显示器(ned)的情况下工作。其他的人工现实系统可以包括ned,该ned也提供对真实世界的可视性(诸如,例如,图15中的增强现实系统1500),或者使用户在视觉上沉浸在人工现实中(诸如,例如,图16中的虚拟现实系统1600)。虽然一些人工现实设备可以是独立的系统,但是其他人工现实设备可以与外部设备通信和/或协调以向用户提供人工现实体验。这样的外部设备的示例包括手持控制器、移动设备、台式计算机、由用户穿戴的设备、由一个或更多个其他用户穿戴的设备、和/或任何其他合适的外部系统。

214.转到图15,增强现实系统1500可以包括具有框架1510的眼镜设备1502,框架3210被配置成将左显示设备1515(a)和右显示设备1515(b)保持在用户的眼睛前方。显示设备1515(a)和1515(b)可以一起或独立地起作用来向用户呈现图像或一系列图像。虽然增强现实系统1500包括两个显示器,但是本公开的实施例可以在具有单个ned或多于两个ned的增强现实系统中实现。

215.在一些实施例中,增强现实系统1500可以包括一个或更多个传感器,例如传感器1540。传感器1540可以响应于增强现实系统1500的运动产生测量信号,并且可以位于框架1510的基本上任何部分上。传感器1540可以代表多种不同感测机构中的一种或更多种,例如位置传感器、惯性测量单元(imu)、深度相机组件、结构光发射器和/或检测器或其任意组合。在一些实施例中,增强现实系统1500可以包括或不包括传感器1540,或者可以包括多于一个传感器。在传感器1540包括imu的实施例中,imu可以基于来自传感器1540的测量信号

来生成校准数据。传感器1540的示例可以包括但不限于加速度计、陀螺仪、磁力计、检测运动的其他合适类型的传感器、用于imu的误差校正的传感器或其某种组合。

216.在一些示例中,增强现实系统1500还可以包括具有多个声换能器1520(a)-1520(j)(统称为声换能器1520)的麦克风阵列。声换能器1520可以代表检测由声波引起的气压变化的换能器。每个声换能器1520可以被配置成检测声音并将检测到的声音转换成电子格式(例如,模拟或数字格式)。图15中的麦克风阵列可以包括,例如,十个声学换能器:1520(a)和1520(b),其可以被设计成放置在用户的相应耳朵内;声换能器1520(c)、1520(d)、1520(e)、1520(f)、1520(g)和1520(h),其可以位于框架1510上的不同位置;和/或声换能器1520(i)和1520(j),其可以位于相应的颈带1505上。

217.在一些实施例中,声换能器1520(a)-(j)中的一个或更多个可以用作输出换能器(例如,扬声器)。例如,声换能器1520(a)和/或1520(b)可以是耳塞式耳机(earbud)或任何其他合适类型的耳机(headphone)或扬声器。

218.麦克风阵列的声换能器1520的配置可以变化。虽然增强现实系统1500在图15中显示为具有十个声换能器1520,但是声换能器1520的数量可以大于或小于十个。在一些实施例中,使用更多数量的声换能器1520可以增加所收集的音频信息量和/或音频信息的灵敏度和准确性。相反,使用更低数目的声换能器1520可降低由相关联控制器1550处理收集的音频信息所需的计算能力。此外,麦克风阵列的每个声换能器1520的位置可以变化。例如,声换能器1520的位置可包括在用户上定义的位置、框架1510上的定义的坐标、与每个声换能器1520相关联的取向或其某种组合。

219.声换能器1520(a)和1520(b)可以位于用户耳朵的不同部位,例如耳廓(pinna)后面、耳屏后面和/或耳廓(auricle)或窝(fossa)内。或者,除了耳道内的声换能器1520之外,在耳朵上或耳朵周围可以存在另外的声换能器1520。将声换能器1520定位在用户的耳道附近可以使麦克风阵列能够收集关于声音如何到达耳道的信息。通过将至少两个声换能器1520定位在用户头部的任一侧(例如,作为双耳麦克风),增强现实设备1500可以模拟双耳听觉并捕获用户头部周围的3d立体声声场。在一些实施例中,声换能器1520(a)和1520(b)可以经由有线连接1530连接到增强现实系统1500,并且在其他实施例中,声学换能器1520(a)和1520(b)可以经由无线连接(例如,蓝牙连接)连接到增强现实系统1500。在其他实施例中,声换能器1520(a)和1520(b)可以根本不与增强现实系统1500结合使用。

220.框架1510上的声换能器1520可以以各种不同的方式定位,包括沿着镜腿的长度、跨过镜梁、在显示设备1515(a)和1515(b)的上方或下方、或它们的某种组合。声换能器1520也可以被定向成使得麦克风阵列能够检测穿戴增强现实系统1500的用户周围的大范围方向上的声音。在一些实施例中,可以在增强现实系统1500的制造期间执行优化过程,以确定麦克风阵列中每个声换能器1520的相对定位。

221.在一些示例中,增强现实系统1500可以包括或连接至外部设备(例如,配对设备),所述外部设备例如为颈带1505。颈带1505通常代表任何类型或形式的配对设备。因此,下面关于颈带1505的讨论也可以应用于各种其他配对设备,诸如充电盒、智能手表、智能电话、腕带、其他可穿戴设备、手持控制器、平板计算机、膝上型计算机、其他外部计算设备等。

222.如图所示,颈带1505可以通过一个或更多个连接器耦合到眼镜设备1502。连接器可以是有线的或无线的,并且可以包括电气和/或非电气(例如,结构)部件。在一些情况下,

眼镜设备1502和颈带1505可以独立操作,而它们之间没有任何有线或无线连接。虽然图15图示了在眼镜设备1502和颈带1505上的示例位置中的眼镜设备1502和颈带1505的部件,但是这些部件可以位于眼镜设备1502和/或颈带1505上的其他地方和/或在眼镜设备902和/或颈带1505上不同地分布。在一些实施例中,眼镜设备1502和颈带1505的部件可以位于与眼镜设备1502、颈带1505或其某种组合配对的一个或更多个附加外围设备上。

223.将外部设备(例如颈带1505)与增强现实眼镜设备配对,可使眼镜设备能够达到一副眼镜的形状因子,同时仍能提供足够的电池和计算能力以扩展功能。增强现实系统1500的电池功率、计算资源和/或另外的特征中的一些或全部可以由配对设备提供,或者在配对设备和眼镜设备之间共享,因此总体上减少了眼镜设备的重量、热分布(heat profile)和形状因子,同时仍然保持期望的功能。例如,颈带1505可以允许原本将被包括在眼镜设备上的部件被包括在颈带1505中,因为用户可以在他们的肩膀上容忍比在他们的头上将容忍的重量负荷更重的重量负荷。颈带1505也可以具有更大的表面积,以在该表面积上将热量扩散并分散到周围环境中。因此,颈带1505可以允许比以其他方式在独立眼镜设备上可能可行的电池和计算容量更大的电池和计算能力。由于在颈带1505中承载的重量可以比眼镜设备1502中承载的重量对用户的侵入性更小,因此用户可以忍受穿戴较轻的眼镜设备,并且携带或穿戴配对设备持续比用户将忍受穿戴较重的独立眼镜设备更长的时间,从而使得用户能够将人工现实环境更充分地结合到他们的日常活动中。

224.颈带1505可以与眼镜设备1502和/或其他设备通信地耦合。这些其他设备可以向增强现实系统1500提供某些功能(例如,跟踪、定位、深度映射、处理、存储等)。在图15的实施例中,颈带1505可以包括两个声换能器(例如,1520(i)和1520(j)),它们是麦克风阵列的一部分(或者潜在地形成它们自己的麦克风子阵列)。颈带1505还可以包括控制器1525和电源1535。

225.颈带1505的声换能器1520(i)和1520(j)可以被配置成检测声音并将检测到的声音转换成电子格式(模拟或数字的)。在图15的实施例中,声换能器1520(i)和1520(j)可以被定位在颈带1505上,从而增加颈带声换能器1520(i)和1520(j)与定位在眼镜设备1502上的其他声换能器1520之间的距离。在一些情况下,增加麦克风阵列的声换能器1520之间的距离可以提高经由麦克风阵列执行的波束成形的准确性。例如,如果声换能器1520(c)和1520(d)检测到声音,并且声换能器1520(c)和1520(d)之间的距离大于例如声换能器1520(d)和1520(e)之间的距离,则确定的检测到的声音的源位置可能比声换能器1520(d)和1520(e)检测到声音的情况更准确。

226.颈带1505的控制器1525可以处理由颈带1505上的传感器和/或由增强现实系统1500生成的信息。例如,控制器1525可以处理来自麦克风阵列的描述由麦克风阵列检测到的声音的信息。对于每个检测到的声音,控制器1525可以执行到达方向(doa)估计,以估计检测到的声音到达麦克风阵列的方向。当麦克风阵列检测到声音时,控制器1525可以用该信息填充音频数据集。在增强现实系统1500包括惯性测量单元的实施例中,控制器1525可以从位于眼镜设备1502上的imu计算所有惯性和空间计算。连接器可以在增强现实系统1500和颈带1505之间以及增强现实系统1500和控制器1525之间传递信息。信息可以是光数据、电数据、无线数据的形式或任何其他可传输数据形式。将对由增强现实系统1500生成的信息的处理移动到颈带1505可以减少眼镜设备1502中的重量和热量,使其对用户更加舒

适。

227.颈带1505中的电源1535可以向眼镜设备1502和/或颈带1505提供电力。电源1535可以包括但不限于锂离子电池、锂聚合物电池、一次锂电池、碱性电池或任何其他形式的电力储存装置。在一些情况下,电源1535可以是有线电源。在颈带1505上而不是在眼镜设备1502上包括电源1535可以帮助更好地分配由电源1535产生的重量和热量。

228.如所提到的,一些人工现实系统可以用虚拟体验基本上代替用户对真实世界的一个或更多个感官知觉,而不是将人工现实与实际现实混合。这种类型系统的一个示例是头戴式显示系统,例如图16中的虚拟现实系统1600,其主要或完全覆盖用户的视野。虚拟现实系统1600可以包括前刚体1602和形状适于围绕用户头部的带1604。虚拟现实系统1600还可以包括输出音频换能器1606(a)和1606(b)。此外,虽然在图16中未示出,但是前刚性主体1602可以包括一个或更多个电子元件,其包括一个或更多个电子显示器、一个或更多个惯性测量单元(imu)、一个或更多个跟踪发射器或检测器、和/或用于创建人工现实体验的任何其他合适的设备或系统。

229.人工现实系统可以包括多种类型的视觉反馈机构。例如,增强现实系统1500和/或虚拟现实系统1600中的显示设备可以包括一个或更多个液晶显示器(lcd)、发光二极管(led)显示器、有机led(oled)显示器、数字光投影(dlp)微显示器、硅上液晶(lcos)微显示器和/或任何其他合适类型的显示屏。这些人工现实系统可以包括用于双眼的单个显示屏,或者可以为每只眼睛提供显示屏,这可以提供对变焦调节或对于校正用户的屈光不正的附加的灵活性。这些人工现实系统中的一些还可以包括具有一个或更多个透镜(例如,传统的凹透镜或凸透镜、菲涅尔透镜、可调整液体透镜等)的光学子系统,用户可以通过这些透镜观看显示屏。这些光学子系统可用于多种目的,包括准直(例如,使物体看起来处于比其物理距离更远处)、放大(例如,使物体看起来比其实际尺寸更大)和/或传递光(例如,将光传递到观看者的眼睛)。这些光学子系统可以用于非光瞳形成架构(例如直接准直光但导致所谓枕形失真的单透镜配置)和/或光瞳形成架构(例如产生所谓桶形失真以抵消枕形失真的多透镜配置)。

230.除了使用显示屏之外或代替使用显示屏,本文描述的一些人工现实系统可以包括一个或更多个投影系统。例如,增强现实系统1500和/或虚拟现实系统1600中的显示设备可以包括(使用例如波导)将光投射到显示设备中的微led投影仪,例如允许环境光通过的透明组合透镜。显示设备可以朝向用户的瞳孔折射所投射的光,并且可以使用户能够同时观看人工现实内容和真实世界两者。显示设备可以使用各种不同光学部件中的任何一个来实现这一点,包括波导部件(例如全息、平面、衍射、偏振和/或反射波导元件)、光操纵表面和元件(诸如衍射、反射和折射元件和光栅)、耦合元件等。人工现实系统还可以被配置成具有任何其他合适类型或形式的图像投影系统,诸如在虚拟视网膜显示器中使用的视网膜投影仪。

231.本文中描述的人工现实系统也可以包括各种类型的计算机视觉部件和子系统。例如,增强现实系统1500和/或虚拟现实系统1600可以包括一个或更多个光学传感器,例如二维(2d)或3d相机、结构光发射器和检测器、飞行时间深度传感器、单光束或扫描激光测距仪、3d lidar传感器和/或任何其他合适类型或形式的光学传感器。人工现实系统可以处理来自这些传感器中的一个或更多个的数据以识别用户的位置、绘制真实世界的地图、向用

户提供关于真实世界周围环境的背景、和/或执行多种其他功能。

232.本文中描述的人工现实系统还可以包括一个或更多个输入和/或输出音频换能器。输出音频换能器可以包括音圈扬声器、带状扬声器、静电扬声器、压电扬声器、骨传导换能器、软骨传导换能器、耳屏振动换能器和/或任何其他合适类型或形式的音频换能器。类似地,输入音频换能器可包括电容式麦克风、动圈式麦克风、带式麦克风和/或任何其他类型或形式的输入换能器。在一些实施例中,单个换能器可以用于音频输入和音频输出两者。

233.在一些实施例中,本文描述的人工现实系统还可以包括触感(即触觉)反馈系统,其可以被结合到头饰、手套、紧身衣裤、手持控制器、环境设备(例如椅子、地板垫等)、和/或任何其他类型的设备或系统中。触觉反馈系统可以提供各种类型的皮肤反馈,包括振动、力、牵引力、纹理和/或温度。触觉反馈系统还可以提供各种类型的动觉反馈,例如运动和顺应性。可以使用电机、压电致动器、射流系统和/或各种其他类型的反馈机构来实现触觉反馈。可以独立于其他人工现实设备、在其他人工现实设备内、和/或与其他人工现实设备结合来实现触觉反馈系统。

234.通过提供触觉感觉、可听内容和/或视觉内容,人工现实系统可以创建整个虚拟体验或者增强用户在多种背景和环境中的真实世界体验。例如,人工现实系统可以帮助或扩展用户在特定环境内的感知、记忆或认知。一些系统可以增强用户与在真实世界中的其他人的交互,或者可以实现用户与虚拟世界中的其他人的更沉浸式的交互。人工现实系统也可用于教育目的(例如,用于学校、医院、政府组织、军事组织、商业企业等中的教学或培训)、娱乐目的(例如,用于玩视频游戏、听音乐、观看视频内容等)和/或无障碍目的(例如,作为助听器、助视器等)。本文公开的实施例可以在这些背景和环境中的一个或更多个中和/或在其他背景和环境中实现或增强用户的人工现实体验。

235.如上所述,增强现实系统1500和1600可以与各种其他类型的装置一起使用,以提供更引人注目的人工现实体验。这些设备可以是具有换能器的触觉接口,该换能器提供触觉反馈和/或收集关于用户与环境的交互的触觉信息。本文公开的人工现实系统可以包括检测或传达各种类型的触觉信息的各种类型的触觉接口,包括触感反馈(例如,用户通过皮肤中的神经检测的反馈,也可以称为皮肤反馈)和/或动觉反馈(例如,用户通过位于肌肉、关节和/或肌腱中的感受器检测的反馈)。

236.触觉反馈可以由位于用户环境内的接口(例如,椅子、桌子、地板等)和/或用户可以穿戴或携带的物品上的接口(例如手套、腕带等)提供。作为示例,图17示出了可穿戴手套(触觉设备1710)和腕带(触觉设备1720)形式的振动触觉(vibrotactile)系统1700。触觉设备1710和触觉设备1720被示为可穿戴设备的示例,其包括柔性的、可穿戴的纺织材料1730,该纺织材料1730被成形和配置成分别抵靠用户的手和手腕定位。本公开还包括振动触觉系统,该振动触觉系统可以被成形和配置成抵靠其他人体部位(例如手指、手臂、头部、躯干、脚或腿)定位。作为示例而非限制,根据本公开的各种实施例的振动触觉系统也可以是手套、头带、臂带、袖子、头套、袜子、衬衫或裤子等形式,并存在其他的可能性。在一些示例中,术语“纺织品”可以包括任何柔性的、可穿戴的材料,包括编织织物、非编织织物、皮革、布、柔性聚合物材料、复合材料等。

237.一个或更多个振动触感设备1740可以至少部分地位于振动触感系统1700的纺织材料1730中形成的一个或更多个相应的口袋内。振动触觉设备1740可以定位在向振动触觉

系统1700的用户提供振动感觉(例如触觉反馈)的位置。例如,振动触觉设备1740可以抵靠用户的手指、拇指或手腕定位,如图17所示。在一些示例中,振动触觉设备1740可以是足够柔性的以顺应用户的相应身体部位或随着用户的相应身体部位弯曲。

238.用于向振动触觉设备1740施加电压以激活它的电源1750(例如,电池)可以诸如经由导线1752电耦合到振动触觉设备1740。在一些示例中,每个振动触觉设备1740可以独立地电耦合到电源1750,用于单独激活。在一些实施例中,处理器1760可以可操作地耦合到电源1750,并被配置(例如,编程)来控制振动触觉设备1740的激活。

239.振动触觉系统1700可以以多种方式实现。在一些示例中,振动触觉系统1700可以是独立的系统,其具有独立于其他设备和系统运行的集成子系统和部件。作为另一个示例,振动触觉系统1700可以被配置成与另一个设备或系统1770交互。例如,在一些示例中,振动触感系统1700可以包括通信接口1780,用于接收信号和/或向其他设备或系统1770发送信号。另一个设备或系统1770可以是移动设备、游戏机、人工现实(例如,虚拟现实、增强现实、混合现实)设备、个人计算机、平板计算机、网络设备(例如,调制解调器、路由器等)、手持控制器等。通信接口1780可以经由无线(例如,wi-fi、蓝牙、蜂窝、无线电等)链路或有线链路实现振动触觉系统1700和另一个设备或系统1770之间的通信。如果存在,通信接口1780可以与处理器1760通信,例如向处理器1760提供信号以激活或去激活一个或更多个振动触觉设备1740。

240.振动触觉系统1700可以可选地包括其他子系统和部件,例如触敏垫1790、压力传感器、运动传感器、位置传感器、照明元件和/或用户接口元件(例如,开/关按钮、振动控制元件等)。在使用期间,振动触觉设备1740可以被配置成出于各种不同的原因被激活,例如响应于用户与用户接口元件的交互、来自运动或位置传感器的信号、来自触敏垫1790的信号、来自压力传感器的信号、来自另一个设备或系统1770的信号等。

241.尽管电源1750、处理器1760和通信接口1780在图17中被示为位于触觉设备1720中,但是本公开不限于此。例如,电源1750、处理器1760或通信接口1780中的一个或更多个可以被定位于触觉设备1710内或另一可穿戴纺织品内。

242.触觉可穿戴设备,例如结合图17示出和描述的那些,可以在各种类型的人工现实系统和环境中实现。图18示出了包括一个头戴式虚拟现实显示器和两个触觉设备(即,手套)的示例人工现实环境1800,并且在其他实施例中,这些部件和其他部件的任意数量和/或组合可以被包括在人工现实系统中。例如,在一些实施例中,可能存在多个头戴式显示器,每个头戴式显示器具有相关联的触觉设备,每个头戴式显示器和每个触觉设备与相同的控制台、便携式计算设备或其它计算系统通信。

243.头戴式显示器1802通常表示任何类型或形式的虚拟现实系统,例如图16中的虚拟现实系统1600。触觉设备1804通常表示由人工现实系统的用户穿戴的任何类型或形式的可穿戴设备,其向用户提供触觉反馈,以给予用户他或她正在物理上与虚拟对象接触的感觉。在一些实施例中,触觉设备1804可以通过向用户施加振动、运动和/或力来提供触觉反馈。例如,触觉设备1804可以限制或增加用户的移动。举一个具体的示例,触觉设备1804可以限制用户的手向前移动,使得用户具有他或她的手已经与虚拟墙壁物理接触的感觉。在该特定示例中,触觉装置内的一个或更多个致动器可以通过将流体泵入触觉设备的可膨胀囊来实现物理运动限制。在一些示例中,用户也可以使用触觉设备1804向控制台发送动作请求。

动作请求的示例包括但不限于启动应用和/或结束应用的请求和/或在应用内执行特定动作的请求。

244.虽然触觉接口可以与虚拟现实系统一起使用,如图18所示,但是触觉接口也可以与增强现实系统一起使用,如图19所示。图19是用户1910与增强现实系统1900交互的透视图。在该示例中,用户1910可以穿戴一副增强现实眼镜1920,该眼镜可以具有一个或更多个显示器1922并且与触觉设备1930配对。在该示例中,触觉设备1930可以是腕带,该腕带包括多个带元件1932和将带元件1932彼此连接的张紧机构1934。

245.一个或更多个带元件1932可以包括适于提供触觉反馈的任何类型或形式的致动器。例如,带元件1932中的一个或更多个带元件可以被配置成提供各种类型的皮肤反馈中的一种或更多种皮肤反馈,包括振动、力、牵引力、纹理和/或温度。为了提供这样的反馈,带元件1932可以包括各种类型的致动器中的一种或更多种。在一个示例中,带元件1932中的每一个可以包括振动触觉器(vibrotactor)(例如,振动触觉致动器),其被配置成一致地(in unison)或独立地振动以向用户提供各种类型的触觉中的一种或更多种。替代地,只有单个带元件或带元件的子集可以包括振动触觉器。

246.触觉设备1710、1720、1804和1930可以包括任何合适数量和/或类型的触觉换能器、传感器和/或反馈机构。例如,触觉设备1710、1720、1804和1930可以包括一个或更多个机械换能器、压电换能器和/或流体换能器。触觉设备1710、1720、1804和1930还可以包括不同类型和形式的换能器的各种组合,这些换能器一起或独立地工作以增强用户的人工现实体验。在一个示例中,触觉设备1930的每个带元件1932可以包括振动触觉器(例如,振动触觉致动器),该振动触觉器被配置成一致地或独立地振动,以向用户提供各种类型的触觉感觉中的一种或更多种。

247.上述实施例可以以多种方式中的任一种实现。例如,实施例可以使用硬件、软件或其组合来实现。当使用软件实现时,包括软件的代码可以在任何合适的处理器或处理器集合上执行,无论是设置在单台计算机中还是分布在多台计算机中。应理解的是,执行上述功能的任何部件或部件集合可以被笼统地视为控制上述功能的一个或更多个控制器。一个或更多个控制器可以以多种方式实现,诸如通过专用硬件或通过使用微码或软件编程的一个或更多个处理器来执行上述功能。

248.在这点上,应理解的是,本发明的实施例的一个实现方式包括至少一个非暂时性计算机可读存储介质(例如,计算机存储器、便携式存储器、光盘等),其用计算机程序(即多个指令)编码,该计算机程序当在处理器上执行时执行本文中所述技术的实施例的上面讨论的功能。计算机可读存储介质可以是可传输的,使得存储在其上的程序可以加载到任何计算机资源上,以实现本文中讨论的本发明的各方面。此外,应理解的是,提到在执行时执行上面讨论的功能的计算机程序,并不限于在主机上运行的应用程序。相反,术语计算机程序在本文中是以通用的意义来指任何类型的计算机代码(例如,软件或微代码),其可以用于对处理器进行编程以实现本发明的上面讨论的方面。

249.本文中呈现的技术的各个方面可以单独使用、组合使用或以在上述实施例中没有具体讨论的各种布置使用,并因此在其应用中不限于前述描述和/或附图中阐述的部件的细节和布置。

250.而且,上述实施例中的一些可以实现为一个或更多个方法,其中已提供了一些示

例。作为一个或更多个方法的一部分执行的动作可以以任何合适的方式排序。因此,可以构建实施例,其中动作的执行顺序与本文中示出或描述的不同,即使在说明性实施例中示出为顺序动作,也可以包括同时执行一些动作。本文中使用的短语和术语是为了描述的目的,并且不被视为限制性的。使用“包括(including)”、“包括(comprising)”、“具有”、“包含”、“涉及”以及它们的变体意图包括其后列出的项目和附加项目。

251.在详细描述了本发明的若干实施例后,本领域的技术人员将容易做出各种修改和改进。此类修改和改进意图在本发明的精神和范围内。因此,前述描述仅是举例说明,并不意味着是限制性的。本发明仅限于由所附权利要求书及其等同形式定义。

252.前述特征可以单独地或一起以任何组合被用于本文中讨论的实施例中的任一个。

253.此外,尽管可以指示本发明的优点,但应理解的是,并非本发明的每个实施例都将包括每个描述的优点。一些实施例可能没有实现本文中描述为有利的任何特征。因此,前述描述和附图仅是举例说明。

254.对所公开的实施例进行变化是可能的。例如,本技术的各个方面可以单独使用、组合使用或以在前述的实施例中没有具体讨论的各种布置使用,并因此其在应用中不限于前述描述中阐述或附图中示出的部件的细节和布置。一个实施例中描述的方面可以以任何方式与其他实施例中描述的方面组合。

255.在描述和/或权利要求书中使用序数术语(诸如“第一”、“第二”、“第三”等)来修饰元素,其本身并不意味着一个元素对另一个元素的任何优先级、优先权或顺序,或方法的动作被执行的时间顺序,而只是用作标签来区分具有一定名称的一个元素或动作与具有相同名称(但使用序数术语)的另一个元素或动作,以区别这些元素或动作。

256.在本说明书和权利要求书中使用的不定冠词“一个(a)”和“一个(an)”,除非明确相反指示,否则应理解为“至少一个”。

257.短语“至少一个”的任何使用,在提到一个或更多个元素的列表时,应理解为意味着从元素列表中的任何一个或更多个元素中选择的至少一个元素,但不一定包括元素列表内具体列出的每一个元素中的至少一个,且也不排除要素列表中元素的任何组合。该定义也允许元素可以可选地存在,而不是短语“至少一个”所指的元素列表内具体标识的元素,而不管与这些具体标识的元素相关还是无关。

258.对短语“相等”或“相同”的任何使用来提到两个值(如距离、宽度等)都意味着两个值在制造公差范围内是相同的。因此,两个值相等或相同,可能意味着这两个数值彼此之间的差异为

±

5%。

259.在本说明书和权利要求书中使用的短语“和/或”,应被理解为意思是这样连在一起的元素的“任一个或两个”,即在一些情况下连在一起的元素和在其他情况下不连在一起的元素。用“和/或”列出的多个元素应以相同方式来理解,即如此连结的元素中的“一个或更多个”。除了由“和/或”条款具体标识的元素外,其他元素也可以可选地存在,而不管与具体标识的这些元素相关还是无关。因此,作为非限制性示例,提到“a和/或b”,当与开放式语言诸如“包括”结合使用时,在一个实施例中,可以仅指a(可选地包括b以外的元素);在另一个实施例中,仅指b(可选地包括a以外的元素);在又一个实施例中,指a和b两者(可选地包括其他元素);等等。

260.如本说明书和权利要求书中所用,“或”应理解为具有与上面定义的“和/或”相同

的含义。例如,当分离列表中的项目时,“或”或“和/或”将被解释为包括,即包括多个要素或要素列表中的至少一个,而且包括一个以上,以及可选的附加未列出项目。只有相反地明确指示的术语,诸如“...中的仅一个”或“...中的正好一个”,或在权利要求书中使用时,“由...构成”将指代正好包括多个元素或要素列表中的一个元素。一般来说,当前面有排他性的术语,诸如“任一个”、“...中的一个”、“...中的仅一个”或“...中的正好一个”时,本文中使用的术语“或”将仅解释为指示排他性的选择(即“一个或另一个,但不是两者”)。“基本上由...构成”在权利要求书中使用时应具有其在专利法领域中使用的普通含义。

261.而且,本文中使用的短语和术语是为了描述的目的,并且不应视为限制性的。使用术语诸如“包括(including)”、“包括(comprising)”、“由...组成"、“具有”、“包含”和“涉及”以及它们在本文中的变型,意思是包括此后列出的项目和它们的等同形式、以及附加项目。

262.术语“大约”和“约”如果在本文中使用,可以理解为意思是在一些实施例中在目标值的

±

20%以内、在一些实施例中在目标值的

±

10%以内、在一些实施例中在目标值的

±

5%以内、以及在一些实施例中在目标值的

±

2%以内。术语“大约”和“约”可以等于目标值。

263.术语“基本上”如果在本文中使用,可以理解为意思是在一些实施例中在目标值的95%以内、在一些实施例中在目标值的98%以内、在一些实施例中在目标值的99%以内、以及在一些实施例中在目标值的99.5%以内。在一些实施例中,术语“基本上”可以等于目标值的100%。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。