1.本发明涉及盲人出行辅助技术领域,具体为基于移动端快速深度神经网络的盲人日常出行辅助方法。

背景技术:

2.近些年来,随着计算机视觉技术和语音识别等技术的快速发展,盲人日常出行辅助技术能够帮助盲人判断路径方向和障碍物位置等更全面的环境信息,在人机交互方面更加智能化。已有的技术包括电子式行进辅具eta的工作原理是将激光或超声波束沿空间的特定方向发射,遇到物体时会反射回来。传感器会检测反射的光束,计算物体的距离,通过听觉或触觉信号反映物体的相关信息,这种技术实现的功能较为单一;移动式导盲机器人通过多种传感器对周围环境进行探测,然后将探测到的信息反馈给盲人,这种技术软硬件开发成本也比较高,不易推广;智能手杖能够及时检测到周围环境的障碍物并发出警告,但是在使用的过程中,盲人需要不断的探测才能确定障碍物,需要长期的训练才能熟练使用。

技术实现要素:

3.针对现有技术的不足,本发明提供了基于移动端快速深度神经网络的盲人日常出行辅助方法,解决了上述背景技术中提出的问题。

4.为实现以上目的,本发明通过以下技术方案予以实现:基于移动端快速深度神经网络的盲人日常出行辅助方法,包括以下步骤:s1、采集图像数据:移动端摄像头采集实时场景信息,通过调用修改android系统底层对相机的处理获取摄像头采集到的图像信息;s2、图像数据处理:将场景信息输入到快速神经网络,并配合损失函数预测检测结果;s3、语音提示:将网络输出的检测结果转换成语音提示用户,将检测到的目标框按照重要程度排序,凝练成简短的一句话,当场景信息发生变化时及时提示用户注意。

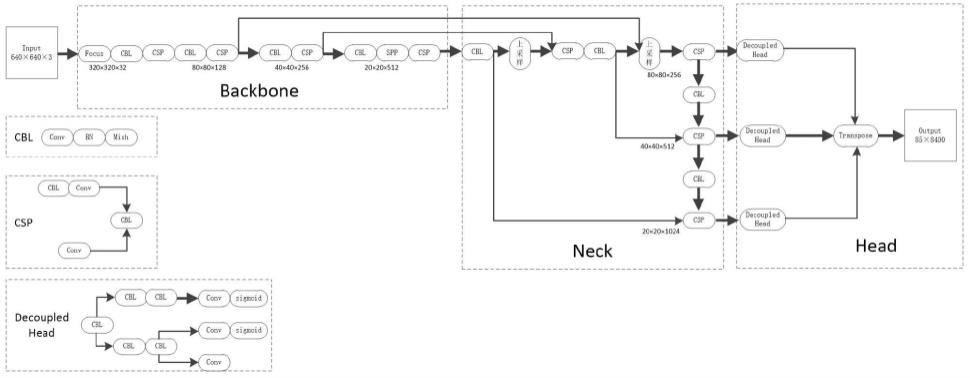

5.可选的,所述步骤s2中的神经网络主要由backbone、neck和head三部分组成,其中,backbone负责提取图像特征,借鉴了darknet-53和csp结构,neck部分结构实现backbone特征的多尺度融合提取,head部分借鉴decoupledhead处理分类与回归问题之间的冲突,优化了网络的整体性能。

6.可选的,所述步骤s2中的损失函数是分类损失,回归损失以及置信度损失的加权求和,回归损失应用的是ciou损失函数;求和,回归损失应用的是ciou损失函数;求和,回归损失应用的是ciou损失函数;。

7.可选的,所述步骤s1中的移动端摄像头的采集范围包括树、杆、自行车、摩托车、轿车、斑马线、障碍物和信号灯8类。

8.本发明提供了基于移动端快速深度神经网络的盲人日常出行辅助方法,具备以下有益效果:使用方便,在移动端实现盲人日常出行辅助技术,盲人及视障人士可通过android操作系统的talkback辅助功能进行屏幕朗读,使用过程中只需要将移动设备挂在胸前,无需其他设备的辅助设备。

9.实时性好,设计的深度神经网络可在移动端上达到实时性的要求,无需借助远程服务器。

10.成本较低,只需要在移动端安装相关的软件,无需硬件设备的辅助。

附图说明

11.图1为本发明快速深度神经网络架构图。

具体实施方式

12.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。

13.请参阅图1,本发明提供一种技术方案:基于移动端快速深度神经网络的盲人日常出行辅助方法,包括,包括以下步骤:s1、采集图像数据:移动端摄像头采集实时场景信息,其中,移动端摄像头的采集范围包括树、杆、自行车、摩托车、轿车、斑马线、障碍物和信号灯8类,并通过调用修改android系统底层对相机的处理获取摄像头采集到的图像信息;s2、图像数据处理:将场景信息输入到快速神经网络,并配合损失函数预测检测结果,其中,网络的检测类别包括树、杆、自行车、摩托车、轿车、斑马线、障碍物和信号灯8类,数据集自行标注,涵盖了多种路面情况,光照环境,场景等,并可以通过腾讯开发的ncnn计算框架实现;s3、语音提示:将网络输出的检测结果转换成语音提示用户,将检测到的目标框按照重要程度排序,凝练成简短的一句话,当场景信息发生变化时及时提示用户注意。

14.进一步优选的,步骤s2中的神经网络主要由backbone、neck和head三部分组成,其中,backbone负责提取图像特征,借鉴了darknet-53和csp结构,neck部分结构实现backbone特征的多尺度融合提取,head部分借鉴decoupledhead处理分类与回归问题之间的冲突,优化了网络的整体性能。

15.进一步优选的,步骤s2中的损失函数是分类损失,回归损失以及置信度损失的加权求和,回归损失应用的是ciou损失函数;ou损失函数;ou损失函数;。

16.以上,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,根据本发明的技术方案及其发明构思加以等同替换或改变,都应涵盖在本发明的保护范围之内。

技术特征:

1.基于移动端快速深度神经网络的盲人日常出行辅助方法,包括以下步骤:s1、采集图像数据:移动端摄像头采集实时场景信息,通过调用修改android系统底层对相机的处理获取摄像头采集到的图像信息;s2、图像数据处理:将场景信息输入到快速神经网络,并配合损失函数预测检测结果;s3、语音提示:将网络输出的检测结果转换成语音提示用户,将检测到的目标框按照重要程度排序,凝练成简短的一句话,当场景信息发生变化时及时提示用户注意。2.根据权利要求1所述的基于移动端快速深度神经网络的盲人日常出行辅助方法,其特征在于:所述步骤s2中的神经网络主要由backbone、neck和head三部分组成,其中,backbone负责提取图像特征,借鉴了darknet-53和csp结构,neck部分结构实现backbone特征的多尺度融合提取,head部分借鉴decoupledhead处理分类与回归问题之间的冲突,优化了网络的整体性能。3.根据权利要求1所述的基于移动端快速深度神经网络的盲人日常出行辅助方法,其特征在于:所述步骤s2中的损失函数是分类损失,回归损失以及置信度损失的加权求和,回归损失应用的是ciou损失函数;ou损失函数;ou损失函数;。4.根据权利要求1所述的基于移动端快速深度神经网络的盲人日常出行辅助方法,其特征在于:所述步骤s1中的移动端摄像头的采集范围包括树、杆、自行车、摩托车、轿车、斑马线、障碍物和信号灯8类。

技术总结

本发明公开了基于移动端快速深度神经网络的盲人日常出行辅助方法,涉及盲人出行辅助技术领域,具体为基于移动端快速深度神经网络的盲人日常出行辅助方法,包括以下步骤:S1、采集图像数据:移动端摄像头采集实时场景信息,通过调用修改Android系统底层对相机的处理获取摄像头采集到的图像信息;S2、图像数据处理:将场景信息输入到快速神经网络,并配合损失函数预测检测结果;S3、语音提示:将网络输出的检测结果转换成语音提示用户,将检测到的目标框按照重要程度排序,凝练成简短的一句话,当场景信息发生变化时及时提示用户注意。本发明实时性好,设计的深度神经网络可在移动端上达到实时性的要求,无需借助远程服务器。无需借助远程服务器。无需借助远程服务器。

技术研发人员:王钦 何坚

受保护的技术使用者:北京工业大学

技术研发日:2022.03.02

技术公布日:2022/7/5

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。