1.本发明属于步态识别技术领域,具体涉及一种基于两个正交视角方向的特征分开提取的深度学习的多视角步态识别方法及系统。

背景技术:

2.步态识别的准确率容易受衣着、拍摄视角、速度、光照强度等因素的影响,研究人员的工作主要着眼于更好地提取出与协变量无关的、更有效的步态特征。

3.目前,步态识别算法主要分为非深度学习和深度学习的步态识别两大类。

4.非深度学习的步态识别算法的相关研究主要通过手工设计特征,技术人员从图像中提取人体的轮廓,采用不同的人体步态表示方法构建模型来表示轮廓序列,紧接着使用不同的学习方法提取特征信息,最后通过邻近算法(k-nearestneighbor,knn)等分类器识别出主体的身份。

5.2015年后,深度学习兴起,步态识别领域也引入深度学习的概念。目前的步态识别领域大多是利用深度学习的方法搭建模型。按照输入类型的不同,深度学习的步态识别算法可分为三类:基于合成图的算法、基于视频帧序列的算法以及基于骨骼模型的算法。

6.基于合成图的算法的输入一般是步态能量图(gait energy image,gei),它是由目标一个步态周期的所有轮廓图相加取平均得到。下式为一个步态周期为n帧的步态能量图,其中x

t

表示t时刻的图像:

[0007][0008]

基于合成图的算法忽略了时间维度的信息,精度不高,但它将步态信息集成在一张图中,所构建的模型简单,模型的参数量更少。

[0009]

基于视频帧序列的算法是目前的主流算法,它包含了时序的步态信息以及空间的步态信息,能够得到较高的识别精度,但仍有提高的空间,且它极易受到诸如穿着情况等的协变量因素的影响。

[0010]

基于骨骼模型的算法没有将步态识别看做图像分类,它通过对人体建模来达到获取步态信息的目的,因此该类算法对穿着的变化、遮挡等问题具有更强的鲁棒性,但目前的识别准确率达不到基于视频帧序列的算法的识别准确率。

技术实现要素:

[0011]

针对现有技术存在的上述缺陷,本发明以提高识别准确率为目的,基于矢量分解的数学原理,提出了一种基于两个正交视角方向的特征分开提取的深度学习的多视角步态识别方法及系统,并根据输入类型的不同,构建了输入为步态能量图的模型以及输入为视频帧序列的模型。

[0012]

本发明提供的一种基于矢量分解的多视角步态识别方法及系统,将某视角下的步

态视频帧图像分解为90

°

和0

°

两个视角方向的帧图像进行步态特征提取,然后将得到的步态特征做加权拼接处理。

[0013]

为实现上述目的,本发明采取如下技术方案:

[0014]

一种多视角步态识别方法,按照如下步骤进行:

[0015]

s1.采集得到多视角、多协变量情况的步态视频数据集,并对数据集进行预处理;

[0016]

s2.将预处理后的数据输入特征提取网络,提取、得到90

°

和0

°

两个视角方向成分的特征向量;

[0017]

s3.与步骤s2并行进行,根据输入的样本识别出样本的协变量,并得到协变量向量。本步负责识别出输入的协变量,并得到相应的协变量向量。常见的协变量有两类,分别为视角的不同以及携带物状态的不同。

[0018]

s4.根据得到的协变量向量,对步骤s2得到特征向量做加权处理,得到最终的步态特征向量;

[0019]

s5.对注册集进行设置,使其包含每个目标完整的步态信息。不同于现有的注册集包含各个视角的样本,本发明的注册集中只含有90

°

和0

°

两个视角方向的样本。

[0020]

s6.通过对比网络输出的步态特征与注册集的步态特征,分类得到输入的身份信息。优选使用分类器对特征向量分类,从而得到样本的身份信息(identification,id)。

[0021]

根据输入的不同,本发明构建了输入为步态能量图的步态识别模型以及输入为视频帧序列的步态识别模型,两种模型的框图如图2和图3所示。

[0022]

本发明技术方案有效地实现了多视角、多种携带物情况下的步态识别。

[0023]

作为优选方案,步骤s1具体包括:

[0024]

对采集的步态数据集中的视频帧进行帧级分解,得到帧级步态图像,并对帧级步态图像做二值化、裁剪处理,得到步态剪影图。对于模型2,得到的步态剪影图序列即可作为输入进入模型网络中。对于模型1,还需要将一个周期的步态轮廓图进行gei归一化处理,才能作为输入进入模型网络中。

[0025]

作为优选方案,步骤s2是本发明的核心,它的任务是提取出90

°

和0

°

两个视角方向的特征向量,针对输入的不同,本发明提出了两种不同的思路:

[0026]

对于模型1,由于输入为步态能量图,因此特征提取网络可以构建得相对简单一些。受gaitnet的启发,本发明使用一个编码器-解码器(encoder-decoder)模型来提取出90

°

和0

°

两个视角方向的256

×

1维的特征向量。其中,前128维为90

°

视角方向成分的步态特征,后128维为0

°

视角方向成分的步态特征。该encoder-decoder模型的训练损失函数包括重建损失、身份识别损失和特征划分损失三个部分:

[0027]

①

重建损失

[0028]

该损失为encoder-decoder模型的常用损失。对于本发明,输入的步态能量图x,经过编码器e后得到90

°

视角方向成分的步态特征f

90

°

和0

°

视角方向成分的步态特征f0°

,解码器负责将f

90

°

和f0°

两个步态特征还原为输入的步态能量图x

′

:

[0029]

(f

90

°

,f0°

)=e(x)

[0030]

x

′

=d(f

90

°

,f0°

)

[0031]

解码出来的输出x

′

应该与原始输入x相似,因此,重构损失表示为:

[0032]

[0033]

其中,表示欧式距离(euclidean distance)度量。

[0034]

②

身份识别损失

[0035]

为了保证encoder-decoder模型能够有效提取出身份信息,本发明在训练阶段加入一个线性分类器ck辅助训练,以保证提取出的特征向量能够提取出目标的身份信息,使用交叉熵损失函数并将它视作身份识别损失:

[0036]

l

identify

=-log(ck(f

90

°

,f0°

))

[0037]

③

特征划分损失

[0038]

为了确保90

°

和0

°

视角成分的特征有效分离,考虑:

[0039]

当输入为90

°

视角的训练样本时,将后128维的特征向量置为0,解码器输出的x

′

:

[0040]

x

′

=d(f

90

°

,0)

[0041]

应与原输入x

′

相似,即:

[0042][0043]

当输入为0

°

视角的训练样本时,将前128维的特征向量置为0,解码器输出的x

′

:

[0044]

x

′

=d(0,f0°

)

[0045]

应与原输入x

′

相似,即:

[0046][0047]

当输入为并非90

°

视角和0

°

视角的训练样本时,分别做如下两种操作:(1)将后128维的特征向量置为0;(2)将后128维的特征向量置为0。并且根据输入视角v的不同,在欧式距离度量前赋予不同的权值λ1和λ2,以此得到特征划分损失:

[0048][0049]

由此,整个特征提取网络的训练损失函数为:

[0050]

l=l

recon

l

identify

l

divide

[0051]

对于模型2,由于输入为视频帧序列,网络模型比模型1要复杂。将输入分别送入90

°

视角方向的特征提取网络和0

°

视角方向的特征提取网络中,得到两个视角方向的、维数为128

×

62的分量特征,然后拼接得到256

×

62维的步态特征。

[0052]

模型2的特征提取网络使用gaitset骨干网络,使用改进的三元组损失函数进行训练。原三元组损失函数如下式:

[0053][0054]

其中,是anchor的特征表达,是正例的特征表达,是负例的特征表达,α是三元组损失函数的间距(margin),这是一个超参数。α的取值越大,越能区分相似的图像,但同时也会导致网络的不收敛。

[0055]

为了提取出90

°

和0

°

两个视角方向的特征向量,三元组损失函数改进如下:

[0056]

[0057][0058]

并且,对anchor的取法做了改变,在90

°

特征提取网络的训练过程中,只以90

°

轮廓图的特征为anchor,在0

°

特征提取网络的训练过程中,只以0

°

轮廓图特征为anchor。

[0059]

作为优选方案,步骤s3具体包括:

[0060]

①

识别出输入样本的协变量,协变量可以为相互独立作用的若干类,如输入样本的视角、携带物情况、光照强度等。

[0061]

②

在识别出协变量后,获取对应的协变量向量,不同的协变量对应不同的协变量向量。

[0062]

作为优选方案,步骤s4具体是:根据识别出的协变量的差异,对特征向量做加权处理,得到最终的步态特征向量。

[0063]

步骤s3是为了在步骤s2的基础上,更好地识别出目标的身份。能够看出:视角的变化与携带物的不同会影响输入样本的步态特征。本发明假设视角的变化与携带物的不同是两种独立的情况,即,视角的不同对于步态特征的影响与携带物的不同对于步态特征的影响相互独立,则他们对应的协变量向量是不相关的。

[0064]

本发明的协变量向量用于对该注册集的特征向量进行加权。

[0065]

需要注意的是,协变量向量需要提前训练得到。以casia-b数据库为例,该数据库包含11种视角以及3种携带物情况(无携带物状态(nm)、背包状态(bg)以及穿着大衣状态(cl)),因此,需要训练出11种视角的协变量向量以及2种携带物的协变量向量。

[0066]

作为优选方案,步骤s5是对注册集的特征处理。

[0067]

本发明设置注册集是由无其它协变量干扰的视角为90

°

的样本的特征向量和无其它协变量干扰的视角为0

°

的样本的特征向量拼接而成,作为一个目标的完整的步态特征。

[0068]

步骤s5具体如下:视角为90

°

的、无其它协变量干扰的样本送入训练好的90

°

特征提取网络,得到视角为0

°

的、无其它协变量干扰的样本送入训练好的0

°

特征提取网络,得到再将二者拼接得到一个注册集样本最终得到包含n个目标的注册集f:

[0069][0070]

作为优选方案,步骤s6采用分类器对网络输出的特征向量进行身份识别。

[0071]

作为优选方案,模型1中输入的步态能量图尺寸均为64

×

64;模型2中输入的步态轮廓图序列的尺寸均为64

×

44。

[0072]

本发明提出了对多视角的步态剪影图进行90

°

和0

°

两个视角方向提取步态信息的分解方法。本发明提出了协变量向量的概念,将协变量向量作用于注册集特征向量上,使得识别准确率得到极大的提升。

[0073]

本发明重新设置了注册集,舍弃了除去90

°

和0

°

两个视角之外的注册集样本,极大地降低了注册集的储存量;同时,90

°

和0

°

两个视角所包含的特征信息是最接近不相关的——本发明将二者视作不相关——将这两个不相关的步态特征信息拼接作为注册集的样本,便能得到每一个目标的完整的步态特征信息。

[0074]

本发明实现了多视角、多携带物状态的步态识别的目的,有效降低了协变量对步

态识别的影响。

附图说明

[0075]

图1是本发明方法流程框图;

[0076]

图2是本发明构建的模型1的流程框图;

[0077]

图3是本发明构建的模型2的流程框图;

[0078]

图4是gaitset网络的流程框图;

[0079]

图5是本发明系统框图。

具体实施方式

[0080]

以下通过优选实施例对本发明的技术方案作进一步解释说明,具体分为模型1和模型2两大类型。

[0081]

为描述方便,设置两种协变量:多视角以及多种携带物情况。

[0082]

本发明实施例基于两个正交视角方向的特征分开提取的多视角步态识别方法,针对模型1,如图2所示,包含以下步骤:

[0083]

s1.采集得到多视角、多协变量情况的步态数据集,并对步态数据集做预处理操作,并对得到的步态剪影图进行对齐、裁剪、归一化操作,得到步态能量图。

[0084]

s2.将初始步态能量图输入训练好的编码器中,提取出包含90

°

(前128维)和0

°

(后128维)两个视角方向成分的特征向量f

p

′

,它是一个256

×

1维的特征向量。

[0085]

s3.将初始的步态能量图输入协变量分类网络中,得到输入的协变量信息,记为view和condition。根据两种协变量分类情况选用对应的协变量向量p

view

和p

condition

,并将这两个不相关的向量相加得到:

[0086]

p

view condition

=p

view

p

condition

[0087]

以此作为输入的步态能量图的协变量向量。p

view

和p

condition

均为256

×

1维的向量,得到的p

view condition

也是256

×

1维的向量。

[0088]

s4.对步骤s2输出的特征向量f

p

′

做加权处理:

[0089]fp

=f

p

′

·

p

view condition

[0090]

得到最终的步态特征向量f

p

。

[0091]

s5.模型1设置注册集的方式:

[0092]

对于某一目标的注册集样本:90

°

视角、无携带物的样本输入编码器中,取输出特征向量的前128维向量,0

°

视角、无携带物的样本输入编码器中,取输出特征向量的后128维向量,把二者拼接得到该目标的256维的特征向量。若总共有n个目标,则注册集中共有n个特征向量。

[0093]

s6.使用最近邻分类器分类得到输入样本的身份信息。

[0094]

本发明实施例基于两个正交视角方向的特征分开提取的多视角步态识别方法,针对模型2,如图3所示,包含以下步骤:

[0095]

s1.采集得到多视角、多协变量情况的步态数据集,并对步态数据集做二值化处理后得到步态剪影图,并对步态剪影图进行对齐、裁剪操作后即可作为整个网络的输入。

[0096]

s2.将预处理后的输入送入训练好的特征提取网络,分别提取出90

°

和0

°

两个视角

方向成分的、维数均为128

×

62的特征向量f

p-90

°

′

和f

p-0

°

′

,并将二者拼接得到维数为256

×

62的特征向量f

p

′

。

[0097]

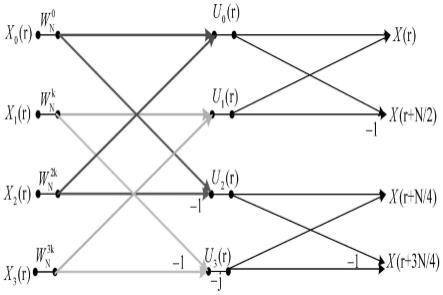

特征提取网络选用gaitset的骨干网络。它是2016年由复旦大学提出的一个灵活、高效的步态识别网络。如图4所示,gaitset的输入是一系列大小为64

×

44的预处理过的剪影图,将它们视为一个序列组,主分支是一个用于对每一帧图片进行卷积处理的卷积神经网络,在这个过程中,每经过两层就使用多特征集合池化(set pooling,sp)模块将k帧剪影图的步态特征聚合成序列级特征;主分支并联一个全流程管线(multilayer global pipeline,mgp)模块,用于整合不同层的序列级特征。最后,经过水平金字塔池化(horizontal pyramid pooling,hpp)模块汇集多尺度的鉴别特征,通过独立的全接连层以便于分类,最终输出步态特征。

[0098]

s3.为了使得协变量分类网络尽量简单,协变量分类网络的输入设置为不包含时间维度信息的步态能量图。

[0099]

对s1的步态剪影图序列做均一化操作,得到步态能量图之后的操作与模型1的s3、s4具体实施细节一致。需要注意的是,模型2中的p

view

和p

condition

均为256

×

62维的向量,得到的p

view condition

也是256

×

62维的向量。

[0100]

s5.模型2设置注册集的方式:

[0101]

对于某一目标的注册集样本:90

°

视角、无携带物的样本输入90

°

特征提取网络中,0

°

视角、无携带物的样本0

°

特征提取网络中,分别得到128

×

62维的特征向量,把二者拼接得到该目标的256

×

62维特征向量。若总共有n个目标,则注册集中共有n个特征向量。

[0102]

s6.通过计算输出与注册集样本之间的欧式距离,得到输入的身份信息。

[0103]

从上可以看出,模型1的网络结构简单,训练参数少,训练时间快,但是由于输入是步态能量图,准确率较模型2低。模型2比较复杂,参数量多,训练时间长,但是识别准确率更高。

[0104]

如图5所示,本实施例公开了一种多视角步态识别系统,其包括以下依次相连的模块:

[0105]

预处理模块:采集得到多视角、多协变量情况的步态数据集,并对数据集进行预处理;

[0106]

协变量向量识别模块:将预处理后的输入送入训练好的特征提取网络,提取出90

°

和0

°

两个视角方向成分的特征向量;同时,根据输入的样本识别出样本的协变量,并得到协变量向量;

[0107]

加权处理模块:根据得到的协变量向量,对特征向量做加权处理,得到最终的步态特征向量;

[0108]

注册集设置模块:设置注册集,注册集中只含有90

°

和0

°

两个视角方向的样本;

[0109]

身份信息获取模块:通过对比网络输出的步态特征与注册集的步态特征,分类得到输入的身份信息。

[0110]

本实施例的其他内容可以参考前述实施例。

[0111]

综上,本发明基于两个正交视角方向的特征分开提取的多视角步态识别方法及系统,输入经过预处理之后并行进入两个网络分支。首先是特征提取网络,它负责提取出两个正交视角方向的特征向量;其次是协变量识别网络,它负责识别出输入的协变量状态。将特

征提取网络所得到的两个视角方向上的特征向量进行拼接,得到了输入的步态特征。同时,根据识别出的协变量对注册集的特征做加权处理,再对比输入样本的步态特征与处理后的注册集特征,由此进行步态识别。本发明实现了多视角、多携带物状态的步态识别的目的,有效降低了协变量对步态识别的影响。

[0112]

以上显示和描述了本发明的基本原理和主要特征和本发明的优点。本行业的技术人员应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是说明本发明的原理,在不脱离本发明精神和范围的前提下,本发明还会有各种变化和改进,这些变化和改进都落入要求保护的本发明范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。