一种基于transformer结构的预训练方法及装置

技术领域

1.本发明涉及模型训练技术领域,尤其涉及一种基于transformer结构的预训练方法及装置。

背景技术:

2.目前,基于超声图像或视频的任务(例如分类、分割或检测任务)中大都依赖大量的数据,且对于超声数据的标注工作较为繁琐,不同的任务需要标注不同的内容。预训练是一种将大量低成本收集的训练数据放在一起,通过模型训练去学习其中的共性,然后将其中的共性“移植”到特定任务中的一种方法。自监督学习是一种利用输入数据本身作为监督,并使几乎所有类型的下游任务受益的一种学习方式。

3.transformer是自然语言处理领域的主要网络结构,并在不同的神经语言程序学(neuro-linguistic programming,缩写nlp)任务中取得了巨大的成功。其中最为关键的模型是bert预训练,这是最成功的预训练任务之一,它对于损坏文本掩码标记的预测、情感预测、句子分类等都有不错的效果。其中将句子中的某些词遮盖,不断训练来预测遮盖词的特征符号,基于这种自监督学习的方式使模型学到丰富的特征,从而使得该模型可以为下游任务提供预训练模型。

4.然而,在计算机视觉领域,与超声图像不同,超声视频描绘了目标对象如何随时间移动和交互。首先,这种动态特性给表征学习带来了额外的困难;其次,让模型从头开始学习视频表示的计算成本很高,并且需要具有数百万个样本的超大规模数据集,而超声视频的标注工作内容繁多且专业,这将耗费巨大的人力物力。

技术实现要素:

5.为了解决上述现有技术存在的问题,本发明实施例提供一种基于transformer结构的预训练方法及装置,在不对样本进行标签标注的情况下,能够使得模型同时学习到视频数据的空间特征和时间特征,从而为下游任务提供很好的预训练模型。

6.为实现上述目的,根据本发明实施例第一方面,提供一种基于transformer结构的预训练方法,所述方法包括:获取目标对象的图像和视频;其中,所述图像和所述视频分别被分割成若干分割区域;针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的标签;对所述图像的部分分割区域进行掩膜处理,得到第一训练样本;对所述视频的部分分割区域进行掩膜处理,得到第二训练样本;基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;基于所述初始模型的模型参数初始化预训练模型,得到初始预训练模型;利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型。

7.可选的,所述基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,生成初始模型,包括:对所述第一训练样本中所有分割区域进行图

像特征提取,得到第一训练样本对应的图像特征;对所述第一训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和所述第一训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第一融合特征;对所述第一融合特征进行空间上采样处理,得到第一训练样本的最终特征;基于所述第一训练样本的最终特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第一损失函数;当所述第一损失函数趋于最小时,对模型参数进行调节,生成初始模型。

8.可选的,所述对所述第一训练样本中所有分割区域进行图像特征提取,得到第一训练样本对应的图像特征,包括:针对所述第一训练样本中的任一所述分割区域:利用线性嵌入层对所述分割区域进行拉伸降维处理;将拉伸降维处理后特征依次经过两个连续的transformer block,对所述分割区域进行特征提取,得到第一特征;利用空间下采样层对若干所述第一特征进行拼接降维处理,得到第一图像特征;将所述第一图像特征依次经过六个连续的transformer block,对所述分割区域进行特征提取,得到第二特征;利用空间下采样层对若干所述第二特征进行拼接降维处理,得到第二图像特征;将所述第二图像特征依次经过四个连续的transformer block,对所述分割区域进行特征提取,得到第一训练样本对应的图像特征。

9.可选的,所述利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型,包括:利用所述初始预训练模型,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第一损失函数;利用所述初始预测模型,对所述第二训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第二损失函数;对所述第一损失函数和所述第二损失函数进行加权处理,得到总损失函数;迭代调节所述初始预训练模型的模型参数,当所述总损失函数趋于最小时,得到最终预训练模型。

10.可选的,所述利用所述初始预测模型,对所述第二训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第二损失函数,包括:对所述第二训练样本进行时间下采样处理;对下采样后第二训练样本中分割区域进行图像特征提取,得到第二训练样本对应的图像特征;对所述第二训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和所述第二训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第二融合特征;将所述第二融合特征依次经过时间上采样和空间上采样,得到采样后特征;基于所述采样后特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第二损失函数。

11.可选的,所述对所述视频的部分分割区域进行掩膜处理,得到第二训练样本,包括:从所述视频中连续选取若干帧图像,并在选取的每帧图像相同位置所对应的分割区域进行掩膜处理;基于所述视频中掩膜处理后的帧图像和未掩膜处理的帧图像,得到第二训练样本。

12.可选的,所述针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的真实标签;包括:针对所述图像中任一分割区域:利用视觉标记器模型对所述分割区域进行处理,得到对应的图像特征符号;将所述图像特征符号作为所述分割区域的标签;针对所述视频中任一分割区域:利用视觉标记器模型对所述分割区域进行处理,得到对应的视频特征符号;将所述视频特征符号作为所述分割

区域的标签。

13.为实现上述目的,根据本发明实施例第二方面提供一种基于transformer结构的预训练装置,所述装置包括:第一获取模块,用于获取目标对象的图像和视频;其中,所述图像和所述视频分别被分割成若干分割区域;第二获取模块,用于针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的标签;掩膜处理模块,用于对所述图像的部分分割区域进行掩膜处理,得到第一训练样本;对所述视频的部分分割区域进行掩膜处理,得到第二训练样本;初始化模块,用于基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;基于所述初始模型的模型参数初始化预训练模型,得到初始预训练模型;联合训练模块,用于利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型。

14.可选的,所述初始化模块包括:特征提取单元,用于对所述第一训练样本中所有分割区域进行图像特征提取,得到第一训练样本对应的图像特征;融合单元,用于对所述第一训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和所述第一训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第一融合特征;上采样单元,用于对所述第一融合特征进行空间上采样处理,得到第一训练样本的最终特征;监督学习单元,用于基于所述第一训练样本的最终特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第一损失函数;模型生成单元,用于当所述第一损失函数趋于最小时,对模型参数进行调节,生成初始模型。

15.为实现上述目的,根据本发明实施例第三方面,还提供一种计算机可读介质,其上存储有计算机程序,所述程序被处理器执行时实现如第一方面所述的方法。

16.与现有技术相比,本发明实施例提供一种基于transformer结构的预训练方法及装置,该方法首先获取目标对象的图像和视频;其中,所述图像和所述视频分别被分割成若干分割区域;并针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的标签;其次,对所述图像的部分分割区域进行掩膜处理,得到第一训练样本;对所述视频的部分分割区域进行掩膜处理,得到第二训练样本;并基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;之后,基于所述初始模型的模型参数初始化预训练模型,得到初始预训练模型;最后,利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型。

17.本发明实施例基于图像数据进行掩码图像建模,并基于建模参数初始化预训练模型生成初始预训练模型;之后利用图像数据和视频数据联合训练初始预训练模型;由此,相比从头开始训练视频数据,该方法大大缩小了计算压力;而且通过对两个数据流的掩码建模任务联合训练,从而使得模型同时学习到视频数据的空间特征和时间特征,进而为下游任务提供了很好的预训练模型。

18.理解的是,本发明的教导并不需要实现上面所述的全部有益效果,而是特定的技术方案可以实现特定的技术效果,并且本发明的其他实施方式还能够实现上面未提到的有益效果。

附图说明

19.附图用于更好地理解本发明,不构成对本发明的不当限定。其中在附图中,相同或对应的标号表示相同或对应的部分。

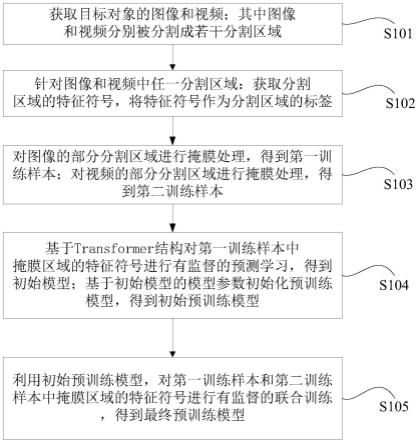

20.图1为本发明一实施例基于transformer结构的预训练方法的示意性流程图;

21.图2为本发明一实施例基于transformer结构对第一训练样本进行有监督的预测学习的示意性流程图;

22.图3为本发明一实施例基于transformer结构对第二训练样本进行有监督的预测学习的示意性流程图;

23.图4为本发明一实施例基于transformer block结构进行图像特征提取方法的示意性流程图;

24.图5为本发明一实施例中确定图像分割区域特征符号的示意图;

25.图6为本发明一实施例中对原始图像和原始视频进行掩膜处理的过程示意图;

26.图7为本发明一实施例中基于transformer结构的预训练装置的示意图。

具体实施方式

27.以下结合附图对本发明的示范性实施例做出说明,其中包括本发明实施例的各种细节以助于理解,应当将它们认为仅仅是示范性的。因此,本领域普通技术人员应当认识到,可以对这里描述的实施例做出各种改变和修改,而不会背离本发明的范围和精神。同样,为了清楚和简明,以下的描述中省略了对公知功能和结构的描述。

28.如图1所示,为本发明一实施例基于transformer结构的预训练方法的示意性流程图;如图5所示,为本发明一实施例中确定图像分割区域的特征符号的示意图;如图6所示,为本发明一实施例中对原始图像和原始视频进行掩膜处理的过程示意图。

29.一种基于transformer结构的预训练方法,至少包括如下操作流程:

30.s101,获取目标对象的图像和视频;其中图像和视频分别被分割成若干分割区域;

31.s102,针对图像和视频中任一分割区域:获取分割区域的特征符号,将特征符号作为分割区域的标签;

32.s103,对图像的部分分割区域进行掩膜处理,得到第一训练样本;对视频的部分分割区域进行掩膜处理,得到第二训练样本;

33.s104,基于transformer结构,对第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;基于初始模型的模型参数初始化预训练模型,得到初始预训练模型;

34.s105,利用初始预训练模型,对第一训练样本和第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型;

35.在s101中,目标对象的图像例如乳腺超声图像,或者甲状腺超声图像,或者其他病灶的ct影像图像等;目标对象的视频例如乳腺超声视频,或者甲状腺超声视频,或者其他病灶的视频等。在这里,对于图像或者视频的形式不作任何限定,任何形式的图像和视频均属于本发明的保护范畴。

36.图像或视频所对应的若干分割区域可以是相同大小尺寸的分割区域,也可以是不同大小尺寸的分割区域。例如:图像或者视频的分割过程如下所述:先设置分割区域尺寸,

而后基于分割区域的预设尺寸,将目标对象的图像或视频划分成若干分割区域,每个分割区域具有相同的尺寸。

37.在s102中,利用已训练好的视觉标记器模型对图像分割区域进行处理,得到图像分割区域对应的特征符号(token);其中,每个图像分割区域对应一个特征符号。

38.如图5,原始图像尺寸为384*384,分割区域的尺寸为64*64,先将原始图像分割成36个相同的分割区域;然后视觉标记器模型将原始图像的分割区域转化成分布有36个特征符号的视觉标记。其中,视觉标记和图像的36个分割区域具有相同的维度。

39.或者,利用已训练好的视觉标记器模型对视频分割区域进行处理,得到视频分割区域对应的特征符号;其中,每个视频分割区域对应一个特征符号。

40.在s103中,如图6所示,采用随机的方式将原始图像的分割区域进行逐块掩膜,直至掩膜处理40%的原始图像,得到图像数据组,并将该图像数据组作为第一训练样本;

41.从所述视频中连续选取若干帧图像,并在选取的每帧图像相同位置所对应的分割区域进行掩膜处理;基于视频中掩膜处理后的帧图像和未掩膜处理的帧图像,得到第二训练样本。例如:从所述视频中连续选取若干帧图像,并在选取的每帧图像相同位置所对应的分割区域进行视频通道掩膜;得到视频数据组;基于视频数据组和未掩膜处理的帧图像,得到第二训练样本。

42.需要注意的是,对于视频做3d掩膜处理的规则是:假设给定输入是一个包含t帧的视频片段,首先随机选取一个起始帧t和帧长度l,对t l区间内的每一帧图像掩膜相同的分割区域,重复这个过程直至每个掩膜处理的帧图像的遮盖率为40%,其中长度l的区间为[0.5t,t]。

[0043]

在s104中,若干个第一训练样本形成第一训练样本数据,针对第一训练样本数据中任一第一训练样本:利用transformer结构预测第一训练样本中掩膜区域的特征符号;基于若干个第一训练样本进行反复训练预测,得到初始模型。由此,使得模型能够学习到更丰富的图像特征。

[0044]

具体地,transformer结构包括encoder模块和decoder模块;第一训练样本输入encoder模块,进行图像特征提取,输出第一训练样本对应的图像特征;之后将图像特征输入decorder模块,进一步进行图像特征提取,输出与图像对应的视觉标记尺寸相同的最终特征;最后将最终特征输入softmax分类器,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第一损失函数;对模型进行迭代训练,当第一损失函数趋于最小时,生成初始模型。最后获取初始模型的模型参数,并利用模型参数初始化空白的预训练模型,得到初始预训练模型。

[0045]

由此,相比于传统卷积神经网络的模型训练,采用transformer结构对图像进行模型训练,不仅能够减少计算量,而且提高了模型的计算效率。

[0046]

在s105中,将第一训练样本和第二训练样本共同作为下一次训练的训练样本;利用第一训练样本和第二训练样本,对初始预训练模型进行有监督的联合训练,生成最终预训练模型。例如:利用所述初始预训练模型,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第一损失函数loss

img

;利用所述初始预测模型,对所述第二训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第二损失函数loss

vid

;对所述第一损失函数和所述第二损失函数进行加权处理,得到总损失函数;迭代调节所述初始预训

练模型的模型参数,当所述总损失函数趋于最小时,得到最终预训练模型。

[0047]

总损失函数的公式如下式(1)所示:

[0048]

loss=loss

img

σloss

vid

ꢀꢀꢀ

式(1);

[0049]

其中,σ为超参数用来平衡两个数据流的权重。

[0050]

本发明实施例将视频的表征学习解耦为空间特征学习和时间动态学习;首先基于图像数据进行掩码图像建模,然后基于建模参数初始化预训练模型生成初始预训练模型;最后利用图像数据和视频数据联合训练初始预训练模型;由此,相比从头开始训练视频数据,该方法大大缩小了计算压力;并且通过对两个数据流的掩码建模任务联合训练,从而使得模型同时学习到视频数据的空间特征和时间特征,从而为下游任务提供了很好的预训练模型;而且,本实施例的预训练方法相对于完全监督学习,省去了标签标注的过程。

[0051]

在这里,下游任务如下游任务如乳腺、甲状腺结节分类,病灶检测、分割等提供预训练模型。这些下游任务只需在最终预训练模型后添加相应的任务层,并提供较少的标注数据,通过有监督的训练方式微调模型即可。

[0052]

如图2所示,为本发明一实施例基于transformer结构对第一训练样本进行有监督的预测学习的示意性流程图;本实施例的方法是在前述实施例的基础上进一步优化得到的。基于transformer结构对第一训练样本进行有监督的预测学习,至少包括如下操作流程:

[0053]

s201,针对第一训练样本中的任一分割区域:利用线性嵌入层对分割区域进行拉伸降维处理;将拉伸降维处理后特征依次经过两个连续的transformer block,对分割区域进行特征提取,得到第一特征;

[0054]

s202,利用空间下采样层对若干第一特征进行拼接降维处理,得到第一图像特征;

[0055]

s203,将第一图像特征依次经过六个连续的transformer block,对分割区域进行特征提取,得到第二特征;利用空间下采样层对若干第二特征进行拼接降维处理,得到第二图像特征;

[0056]

s204,将第二图像特征依次经过四个连续的transformer block,对分割区域进行特征提取,得到第一训练样本对应的图像特征;

[0057]

s205,对第一训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和第一训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第一融合特征;

[0058]

s206,对第一融合特征进行空间上采样处理,得到第一训练样本的最终特征;

[0059]

s207,基于第一训练样本的最终特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第一损失函数;

[0060]

s208,当第一损失函数趋于最小时,对模型参数进行调节,生成初始模型。

[0061]

具体实现过程如下所述:首先,利用线性嵌入层将分割区域拉伸成一维并调整通道数为c;然后输入两个连续的transformer block,进行特征提取,得到第一特征;之后将第一特征输入一层空间下采样,它将每组2*2个分割区域的特征连接起来并将特征维度降为之前的一半;随后再依次经过六个连续的transformer block、一层空间下采样和四个transformer block;最后输出第一训练样本对应的图像特征fe,图像特征fe的尺寸为2xh/32xw/32x4c。其次,采用空间上采样对图像特征fe进行处理,得到特征f1;之后,将特征f1与

同尺寸特征fe拼接后输入简单的线性层进行空间特征恢复,得到第一融合特征f

′1;之后,使用空间上采样对第一融合特征f

′1进行处理,得到与图像视觉标记尺寸相同的特征f;最后使用softmax分类器来预测每一个掩膜位置(i,j)的特征符号,得到第一损失函数loss

img

。第一损失函数使用最大化每个掩码位置的真实token的对数似然,具体如式(2)和式(3)所示:

[0062][0063]

p

i,j

=softmax(wf

i,j

b)

ꢀꢀꢀ

式(3);

[0064]

其中,f

i,j

是输出特征图f在位置(i,j)的特征向量,p

i,j

表示相应的概率向量。w和b是线性层的权重和偏差;m

img

代表所有掩膜分割区域的位置(i,j)表示集合,对应位置的token为z

i,j

。

[0065]

对模型进行迭代训练,当第一损失函数趋于最小时,生成初始模型。

[0066]

如图3所示,为本发明一实施例基于transformer结构对第二训练样本进行有监督的预测学习的示意性流程图;本实施例的方法是在前述实施例的基础上进一步优化得到的。基于transformer结构对第二训练样本进行有监督的预测学习,至少包括如下操作流程:

[0067]

s301,针对第二训练样本中的任一所述分割区域:先将分割区域输入时间下采样层,以降低输出特征的维度;然后再输入线性嵌入层,进行拉伸降维处理;之后将拉伸降维处理后特征依次经过两个连续的transformer block,对分割区域进行特征提取,得到第三特征;

[0068]

s302,利用空间下采样层对若干第三特征进行拼接降维处理,得到第三图像特征;

[0069]

s303,将第三图像特征依次经过六个连续的transformer block,对分割区域进行特征提取,得到第四特征;利用空间下采样层对若干第四特征进行拼接降维处理,得到第四图像特征;

[0070]

s304,将第四图像特征依次经过四个连续的transformer block,对分割区域进行特征提取,得到第二训练样本对应的图像特征;

[0071]

s305,对第二训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和第二训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第二融合特征;

[0072]

s306,对第二融合特征依次进行时间上采样处理和空间上采样处理,得到第二训练样本的最终特征;

[0073]

s307,基于第二训练样本的最终特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第二损失函数。

[0074]

具体实现过程与图2所述具体实现过程相类似,不同的地方有两处:一是在利用线性嵌入层进行拉伸降维处理前,需要先利用时间下采样层对分割区域进行处理;二是对第二融合特征依次进行时间上采样处理和空间上采样处理,得到第二训练样本的最终特征。

[0075]

第二损失函数loss

vid

的计算过程如式(4)和式(5)所示:

[0076]

p

t,i,j

=softmax(wf

t,i,j

b)

ꢀꢀꢀ

式(4);

[0077]

[0078]

其中,f

t,i,j

是输出特征图f在位置(t,i,j)的特征向量,p

t,i,j

表示相应的概率向量;w和b是线性层的权重和偏差;m

vid

代表所有掩膜分割区域的位置(t,i,j)表示集合,对应位置的token为z

t,i,j

。

[0079]

如图4所示,为本发明一实施例基于transformer block结构进行图像特征提取方法的示意性流程图。本实施例的方法是在前述实施例的基础上进一步优化得到的。基于transformer block结构进行图像特征提取方法,至少包括如下步骤:

[0080]

首先,将输入transformer block的特征z

l-1

首先应用layer normalization(ln)层进行归一化后输入window multi-head self-attention(wmsa)层进行特征提取,然后将提取的特征与z

l-1

相加得到特征z

′

l

;之后将z

′

l

再进行归一化后进入两层前馈网络,包括第一个全连接层fc1 gelu非线性操作和第二层全连接层fc2,得到特征z

l

。

[0081]

其次,将特征z

l

继续应用layer normalization(ln)层进行归一化后输入shifted window multi-head self-attention层进行特征提取,然后将提取的特征与z

l

相加得到特征z

′

l 1

;之后将z

′

l 1

再进行归一化后进入两层前馈网络,包括第一个全连接层fcl gelu非线性操作和第二层全连接层fc2,得到特征z

l 1

。

[0082]

由此,特征z

l-1

经过一个transformer block后得到特征z

l 1

。

[0083]

下面将结合具体应用对本发明实施例进行详细描述。

[0084]

在乳腺超声数据集上进行了实验,数据集包括1000个超声视频,5000张超声图像。首先对5000张超声图像:将每一张图像缩放到512*512的尺寸,依据上述步骤将原始图像划分成分割区域并随机掩膜处理约40%的分割区域,同时对每一个未掩膜处理的分割区域根据视觉标记器模型生成相应的特征符号。将图像的若干分割区域组成的图像数据组输入transformer结构进行有监督的学习预测,最后通过优化对应的第一损失函数loss

img

来训练模型。

[0085]

将通过上述图像数据训练好的模型作为视频数据的初始化模型,对1000个超声视频:将每一个视频的宽和高缩放到512*512的尺寸,依据上述步骤将原始视频划分成若干分割区域并随机进行掩膜处理40%分割区域,同时对每一个未掩膜处理的分割区域根据视觉标记器生成相应的特征符号。将视频分割区域组成的视频数据组输入transformer结构进行有监督的学习预测,通过优化总损失函数loss来训练模型,总损失函数中σ=1.2。

[0086]

本发明的实施例通过自我监督的学习方式来学习超声视频特征的方法,将图片(或视频)随机遮盖一些分割区域,让模型预测盖住的分割区域是什么,不断计算预测的分割区域与真实的分割区域之间的差异,利用它作为loss进行反向传播更新参数,来达到自我监督的效果,这种学习方式称为掩码图像(或视频)建模。将训练完成的模型作为其他特定任务的预训练模型。

[0087]

本发明实施例按照解耦任务设计,首先使用掩码图像建模任务在超声图像流上训练图像流,通过优化loss

img

来学习特征的空间表示;然后使用生成的初始模型来初始化超声视频流,并且通过总损失函数来联合训练两个数据流,以便模型保留空间信息,而视频流学习捕获视频中的时间动态。这样的策略不仅使模型比从头开始在规模视频数据上预训练更高效,而且满足了对不同类型的视频样本学习不同信息的需要。训练完成后生成最终预训练模型,最终预训练模型提供了可用于下游任务的不错的视频特征表示。

[0088]

如7所示,为本发明一实施例中基于transformer结构的预训练装置的示意图。基

于transformer结构的预训练装置,该装置700包括:第一获取模块701,用于获取目标对象的图像和视频;其中,所述图像和所述视频分别被分割成若干分割区域;第二获取模块702,用于针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的标签;掩膜处理模块703,用于对所述图像的部分分割区域进行掩膜处理,得到第一训练样本;对所述视频的部分分割区域进行掩膜处理,得到第二训练样本;初始化模块704,用于基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;基于所述初始模型的模型参数初始化预训练模型,得到初始预训练模型;联合训练模块705,用于利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型。

[0089]

在可选的实施例中,所述初始化模块704包括:特征提取单元,用于对所述第一训练样本中所有分割区域进行图像特征提取,得到第一训练样本对应的图像特征;融合单元,用于对所述第一训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和所述第一训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第一融合特征;上采样单元,用于对所述第一融合特征进行空间上采样处理,得到第一训练样本的最终特征;监督学习单元,用于基于所述第一训练样本的最终特征,利用softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第一损失函数;模型生成单元,用于当所述第一损失函数趋于最小时,对模型参数进行调节,生成初始模型。

[0090]

在可选的实施例中,特征提取单元包括:第一特征提取子单元,用于针对所述第一训练样本中的任一所述分割区域:利用线性嵌入层对所述分割区域进行拉伸降维处理;将拉伸降维处理后特征依次经过两个连续的transformer block,对所述分割区域进行特征提取,得到第一特征;第一拼接子单元,用于利用空间下采样层对若干所述第一特征进行拼接降维处理,得到第一图像特征;第二特征提取子单元,用于将所述第一图像特征依次经过六个连续的transformer block,对所述分割区域进行特征提取,得到第二特征;第二拼接子单元,用于利用空间下采样层对若干所述第二特征进行拼接降维处理,得到第二图像特征;第三特征提取子单元,用于将所述第二图像特征依次经过四个连续的transformer block,对所述分割区域进行特征提取,得到第一训练样本对应的图像特征。

[0091]

在可选的实施例中,联合训练模块705包括:第一预测学习单元,用于利用所述初始预训练模型,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第一损失函数;第二预测学习单元,用于利用所述初始预测模型,对所述第二训练样本中掩膜区域的特征符号进行有监督的预测学习,生成第二损失函数;加权单元,用于对所述第一损失函数和所述第二损失函数进行加权处理,得到总损失函数;参数调节单元,用于迭代调节所述初始预训练模型的模型参数,当所述总损失函数趋于最小时,得到最终预训练模型。

[0092]

在可选的实施例中,第二预测学习单元包括:图像特征提取单元,用于对所述第二训练样本进行时间下采样处理;对下采样后第二训练样本中分割区域进行图像特征提取,得到第二训练样本对应的图像特征;第二融合子单元,用于对所述第二训练样本对应的图像特征进行空间上采样处理,并将空间上采样后特征和所述第二训练样本对应的图像特征拼接后经过线性层进行融合处理,得到第二融合特征;预测学习子单元,用于将所述第二融合特征依次经过时间上采样和空间上采样,得到采样后特征;基于所述采样后特征,利用

softmax分类器对掩膜区域中每个分割区域对应的特征符号进行有监督的预测学习,生成第二损失函数。

[0093]

在可选的实施例中,掩膜处理模块703包括:掩膜处理单元,用于从所述视频中连续选取若干帧图像,并在选取的每帧图像相同位置所对应的分割区域进行掩膜处理;确定单元,用于基于所述视频中掩膜处理后的帧图像和未掩膜处理的帧图像,得到第二训练样本。

[0094]

在可选的实施例中,第二获取模块702包括:确定图像特征符号单元,用于针对所述图像中任一分割区域:利用视觉标记器模型对所述分割区域进行处理,得到对应的图像特征符号;将所述图像特征符号作为所述分割区域的标签;确定视频特征符号单元,用于针对所述视频中任一分割区域:利用视觉标记器模型对所述分割区域进行处理,得到对应的视频特征符号;将所述视频特征符号作为所述分割区域的标签。

[0095]

上述装置可执行本发明一实施例所提供的基于transformer结构的预训练方法,具备执行基于transformer结构的预训练方法相应的功能模块和有益效果。未在本实施例中详尽描述的技术细节,可参见本发明实施例所提供的基于transformer结构的预训练方法。

[0096]

根据本发明再一实施例,还提供了一种电子设备,该电子设备包括:一个或多个处理器;存储装置,用于存储一个或多个程序,当该一个或多个程序被该一个或多个处理器执行,使得该一个或多个处理器实现本发明上述实施例提供的甲状腺结节的分类方法。

[0097]

本发明实施例另一方面提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时,使得所述处理器至少执行如下所述的操作步骤:s101,获取目标对象的图像和视频;其中,所述图像和所述视频分别被分割成若干分割区域;s102,针对所述图像和所述视频中任一分割区域:获取所述分割区域的特征符号,将所述特征符号作为所述分割区域的标签;s103,对所述图像的部分分割区域进行掩膜处理,得到第一训练样本;对所述视频的部分分割区域进行掩膜处理,得到第二训练样本;s104,基于transformer结构,对所述第一训练样本中掩膜区域的特征符号进行有监督的预测学习,得到初始模型;基于所述初始模型的模型参数初始化预训练模型,得到初始预训练模型;s105,利用所述初始预训练模型,对所述第一训练样本和所述第二训练样本中掩膜区域的特征符号进行有监督的联合训练,得到最终预训练模型。

[0098]

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。此外,在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。

[0099]

此外,术语“第一”、“第二”仅用于描述目的,而不能理解为指示或暗示相对重要性或者隐含指明所指示的技术特征的数量。由此,限定有“第一”、“第二”的特征可以明示或隐含地包括至少一个该特征。在本发明的描述中,“多个”的含义是两个或两个以上,除非另有明确具体的限定。

[0100]

以上,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉

本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以权利要求的保护范围为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。