1.本发明涉及一种动车组转向架业务数据清洗方法。

背景技术:

2.动车组是主要的轨道交通装备之一,承担着旅客和货物运输的重要任务,其是否正常运行直接影响高速铁路运输的安全和效益。动车组零部件众多、结构复杂、紧密集成、生命周期数据量大,包含牵引、制动、控制、网络、运维等不同的子系统,涵盖车体、车轮、电机、转向架等多个重要部件。

3.根据动车组列车的驱动及运行方式,转向架一般可分为动车用转向架和拖车用转向架,而这两种类型转向架的主要结构形式基本上是一致的。动车组转向架需要实现诸多重要的功能,是动车组重要部件之一,其结构复杂,零部件众多,包括转向架构架装置1、基础制动装置2、一系悬挂3、轮对轴箱装置4、二系悬挂5和驱动装置6,如图1所示。

4.转向架构架装置1主要包括构架、垂向减震器座、调整阀杆座、拉杆安全吊座和地线接地座。转向架构架是动车组转向架的骨架组成,一般是由钢板焊接构成的,用来承受并传递水平力和垂向力。

5.基础制动装置2又名盘形制动装置,主要包括制动机构和空油转换制动缸,是动车组制动的执行机构。

6.一系悬挂3是设置于轮对与构架之间的轴箱悬挂系统,其作用是实现轴箱与轮对之间的作用力的传递及定位,同时还具有实现车体重量的均衡分配和实现车体及其附件振动缓冲的功能。

7.轮对轴箱装置4主要包括轴箱、车轴、车轮和制动盘。轮对轴箱装置与钢轨形成黏着状态,以具有承受车辆与线路之间相互作用而产生的载荷和冲击的功能。其产生的牵引力,通过轮对滚动使车辆具有前进运行的功能。

8.二系悬挂5是用于连接车体与构架的悬挂系统,具有均匀分配轴重及缓和振动冲击的作用,可保证列车运行的高平稳性。

9.驱动装置6主要包括齿轮箱、牵引电机和联轴节,具有传递动力的功能,拖车转向架没有驱动装置。

10.保证转向架的正常稳定运行至关重要,在动车组运行和维护过程中亟需重点监测转向架的各项运行数据,数据监测过程中,如何持续有效保证监测、采集的动车组运行和维护数据是“干净的数据”为关键问题,需要持续高效进行动车组转向架业务数据清洗。数据清洗(data cleaning)是指针对业务数据进行纠正并且发现业务数据文件中可识别的错误的一道程序,主要包括业务数据缺失值、重复值、异常值的检查和处理过程,在此基础上,通过算法模型等检查及处理业务数据缺失值、重复值、异常值等,从而为获取满足业务数据主题目标应用分析的“干净数据”筛选结果提供支持。

11.近年来,在业务数据清洗方面的研究主要有:

12.中国专利《一种数据清洗方法、装置、电子设备和介质》(202110713685.4)公开了

一种在第一计算资源信息和第二计算资源信息的基础上,优选出最优计算资源信息申请集群资源,并按照业务数据清洗策略进行数据清洗。文献“面向重复记录检测的数据清洗算法的研究,西安:西安电子科技大学,2018”,首先,提出了优化的多趟近邻排序算法(ompn),以更加贴合适用于实际问题。其次,在研究基于遗传神经网络求解重复检测问题算法的基础上,将ompn算法与神经网络相结合,得到优化的准确度更高的a-ompn算法和bp-ompn算法。

13.上述发明和研究在制造业业务数据清洗方面均具有一定的贡献和推动作用,但是将其应用于动车组转向架业务数据时,具有以下弊端:

14.1、面向动车组重要部件转向架运营及运维业务数据清洗过程中,业务数据采集方式单一,未能综合多种业务数据采集方式进行数据采集,以及业务数据采集实时性、准确性、数据质量欠佳。

15.2、业务数据预处理和业务数据清洗固定,不能自适应确定业务数据预处理和清洗方法。

16.3、针对业务数据的应用分析,缺少正常数据和异常数据的特征参数组合判定方法,通常聚焦正常数据的应用分析,而忽略异常数据的应用分析,但异常数据仍旧具有重要的数据价值。

17.因此,现有的业务数据清洗方法并不适用于对动车组转向架业务数据进行清洗。

技术实现要素:

18.为解决现有的数据清洗方法不适用于对动车组重要部件转向架业务数据进行清洗的技术问题,本发明提出了一种基于人工智能的动车组转向架业务数据清洗方法,本发明能够解决动车组转向架业务数据存在残缺、多余、错误、冲突等数据问题,提升动车组转向架业务数据质量,为动车组转向架运维业务数据应用分析提供支撑。

19.本发明的发明构思是:

20.首先,根据业务数据来源不同,采用不同的数据采集方式,以获取多源业务数据,保证采集的业务数据的完整性。其次,通过业务数据预处理自适应配置功能,对不同参数特征的业务数据进行相应的预处理。再次,通过业务数据清洗自适应配置功能,对不同参数特征的业务数据进行相应的清洗处理。最后,对清洗后的业务数据进行正异常判定,基于判定结果进行分类存储。

21.本发明的技术方案是:

22.一种基于人工智能的动车组转向架业务数据清洗方法,其特殊之处在于,包括以下步骤:

23.步骤1:数据采集、标记并传输

24.1.1从安装在动车组转向架上的传感器、动车组转向架车地信息管理系统、诊断专家和/或故障推荐修程中采集动车组转向架业务数据;

25.1.2对采集到的业务数据的数据段进行三段式标记;

26.将业务数据的数据段设置为3段特征参数组合的形式,其中第1段设置为参数的数值范围,第2段设置为参数类型标记,第3段设置为零部件名称标记;

27.1.3将三段式标记后的业务数据传输至分布式云层,在分布式云层执行步骤2;

28.步骤2:数据清洗判定

29.判断当前业务数据是否需要清洗,若是,则进入步骤3;若否,则对其存储备份;

30.步骤3:数据预处理

31.3.1根据业务数据特征,设置数据预处理方式,包括数据的读写、数据的探索、数据简单处理、时域转频域和数据归一化;所述数据的探索是指在数据集维度上探索业务数据的字段值离散度和关联性;所述数据简单处理是指去除数据中的空格和/或对数据中的大小写进行转换;

32.3.2根据业务数据数据段的三段式特征参数,自适应配置相应的数据预处理方式对其进行预处理,预处理完成后进入步骤4;

33.步骤4:数据清洗

34.4.1根据业务数据特征参数,设置数据清洗方式,包括缺失值处理、重复值处理、异常值处理、文本字符串处理和时间格式序列处理;

35.4.2根据业务数据数据段的三段式特征参数,自适应配置相应的数据清洗方式对其进行清洗;

36.步骤5:数据存储

37.对数据清洗后的业务数据进行正常、异常判定,并根据判定结果分别进行存储。

38.进一步地,步骤3.1中所述的数据的探索采用k-means聚类算法实现。

39.进一步地,步骤3.1中所述的数据归一化采用knn算法实现。

40.进一步地,步骤3.2中根据业务数据特征参数,自适应配置相应的数据预处理方式的方法具体为:

41.第一步,事先设置一个预处理算法集合b,该集合b内的每一个元素为3段特征参数组合的形式,其中第1段设置为空,第2段设置为能表征参数类型的标记,第3段设置为零部件名称 其对应的预处理方法;

42.第二步,设置一个特征参数集合a,将接收到的标记为三段式的业务数据放入其中;

43.第三步,提取特征参数集合a中的其中一个业务数据,遍历预处理算法集合b中的元素,当该业务数据中的第2段和第3段均与预处理算法集合b中某一个特征参数组合中的第2段的参数类型标记和第3段中的零部件名称一致时,该特征组合参数第3段中设置的预处理方法即为该业务数据所需要采用的预处理方法,从而实现该业务数据预处理方法的自适应配置;若遍历后未在预处理算法集合b中找到相匹配的预处理方法,则在预处理算法集合b中增加与该业务数据相匹配的元素,对集合b进行更新,并将该新增元素对应的预处理算法配置为该业务数据的预处理方法;

44.第四步,采用第三步的方法,完成特征参数集合a中其余业务数据预处理方法的自适应配置。

45.进一步地,步骤4.1中缺失值处理采用缺失值删除和/或缺失值插补的方法。

46.进一步地,步骤4.1中重复值处理采用多趟近邻排序算法实现。

47.进一步地,步骤4.1中异常值处理采用基于pca的改进型孤立森林算法实现。

48.进一步地,步骤4.2中根据业务数据特征参数,自适应配置相应的数据清洗方式的方法具体为:

49.第一步,事先设置一个清洗算法集合c,该集合c内的每一个元素为3段特征参数组

合的形式,其中第1段设置为数值范围,第2段设置为能表征参数类型的标记,第3段设置为零部件名称 其对应的清洗方法;

50.第二步,设置一个特征参数集合d,将预处理后的业务数据放入其中;

51.第三步,提取特征参数集合d中的其中一个业务数据,遍历清洗算法集合c中的元素,当该业务数据中的第1段落入清洗算法集合c中某一个特征参数组合中的第1段的数值范围内、且与第2段的参数类型标记、第3段中的零部件名称一致时,该特征组合参数第3段中设置的清洗方法即为该业务数据所需要采用的清洗方法,从而实现该业务数据清洗方法的自适应配置;若遍历后未在清洗算法集合c中找到相匹配的清洗方法,则在清洗算法集合c中增加与该业务数据相匹配的元素,对集合c进行更新,并将该新增元素对应的清洗算法配置为该业务数据的清洗方法;

52.第四步,采用第三步的方法,完成特征参数集合d中其余业务数据清洗方法的自适应配置。

53.进一步地,在算法的自适应配置过程中,对于每一条数据,优先配置其中发生异常概率大的业务数据段,忽略与异常发生无关联的业务数据段。

54.与现有技术相比,本发明的有益效果是:

55.1、本发明基于动车组转向架业务数据参数来源分类的判定机制,对于不同的数据源采用不同的数据采集方式:自动采集安装在动车组转向架上的传感器数据、主动采集动车组转向架车地信息管理系统数据、被动从诊断专家和/或故障推荐修程中采集数据,参数来源分类的判定优化了数据发生、收集、存取过程中的匹配和适应能力,使得系统在扩展性、专用性、适应性方面可运用模块化、积木化、垛堞化的插拔构件,兼顾成本和效率。

56.2、本发明根据动车组转向架业务数据特征参数,在业务数据预处理和业务数据清洗模块,采用自适应配置模型进行动车组转向架业务数据预处理和业务数据清洗方法的自适应配置,并将清洗结果存储至分布式云层,在此基础上,基于分布式云层训练模型,迭代更新优化清洗模型,使得该清洗模型可普遍适用于各种数据的清洗场景。

57.3、本发明对采集到的转向架业务数据进行三段式标记,并对预处理算法和清洗算法进行三段式标记,从而使得业务数据与预处理算法以及业务数据与清洗算法可快速匹配,一方面在设备层(即边缘层)只需存储业务数据与算法的映射关系,而不用存储算法本身,从而能在设备层以轻量级方式确定预处理算法和清洗算法,另一方面,可以将预处理算法和清洗算法存储在分布式云处理层,解决了设备层存储空间不足和算力不足的问题,同时设备层和分布式云处理层的解耦,实现了功能和性能的相互补差。

58.4、考虑到同一业务数据中不同数据段业务发生异常的概率不同(对于业务数据段发生异常的概率,可以通过动态统计得到,且可不断更新),在进行算法匹配时,本发明可以优先为发生异常概率大的业务数据段进行算法匹配,并忽略与异常发生无关联的业务数据段,这样可以达到极大简化业务数据提交到分布式云处理层进行算法匹配的过程。

59.5、本发明通过三段式标记方法实现了算法的统一和存储共享,有效节约了边缘层的存储空间和额定算力,且三段式标记在预处理过程预留了1位扩展空间,可用于知识、经验的人工标记,以实现算法的评价,该评价指标可以被用于算法提取推送到分布式云处理层,以供算法的示范推广使用,从而将所积累的知识经验转换为人工智能应用结论,提升动车组转向架的运行和维护效果,达成人力资源节约和经济效益提高的目的。

60.6、本发明通过自适应配置方式清洗业务数据,实现干净数据的获取,并分别存储干净数据和异常数据,在此基础上,有效利用“干净数据”和“异常数据”,一方面,针对“干净数据”进行业务数据应用分析,另一方面,针对“异常数据”进行业务异常数据应用分析,可进一步挖掘、提取异常数据价值,为更为完整的数据链挖掘、业务深层次数据信息提供支撑。

附图说明

61.图1是动车组转向架的结构示意图。

62.图2是本发明方法的技术路线图。

63.图3是本发明方法的总体流程图。

64.图4是本发明方法中的数据采集方式判定机制。

65.图5是本发明方法中的数据预处理自适应配置模型的原理示意图。

66.图6是本发明方法中的数据清洗自适应配置模型的原理示意图。

67.图7是本发明方法中正常异常数据判定方法的原理示意图。

68.图8是实现本发明方法的数据清洗装置的原理框图。

69.图1中附图标记说明:

70.1-转向架构架装置;2-基础制动装置;3-一系悬挂;4-轮对轴箱装置;5-71.二系悬挂;6-驱动装置。

具体实施方式

72.以下结合附图对本发明作进一步说明。

73.参照图2和图3,本发明所提供的基于人工智能的动车组转向架业务数据清洗方法,具体实现步骤如下:

74.步骤1:数据采集、标记并传输

75.1.1数据采集

76.本发明根据动车组转向架业务数据的来源不同,采用不同的数据采集方式对其进行采集并传输;参照图4,所述不同的数据采集方式包括自动数据采集、主动数据采集和被动数据采集,数据采集方式的判定机制为:

77.若动车组转向架业务数据来源于传感器(即通过传感器测得的),则采用自动采集方式采集动车组转向架业务数据;

78.若动车组转向架业务数据来源于动车组转向架车地信息管理系统,则采用主动采集方式采集动车组转向架业务数据;

79.若动车组转向架业务数据来源于诊断专家和/或故障推荐修程,则采用被动采集方式采集动车组转向架业务数据。本发明所说的被动采集方式,是相对于数据采集方而言的,对于受合同、协议、押金或环境条件制约,以及后期维护不确定性产生的相关数据,以及有些由专家分析讨论后形成的数据,不能或不易直接获取到的,为被动获取。

80.以动车组转向架系统运行及维护过程中故障发生频率较高的关键部件(轮对轴箱装置、齿轮箱、牵引电机和悬挂装置)作为研究对象为例,对于通过安装在轮对、齿轮箱、牵引电机和悬挂装置上的温度和振动加速度组合传感器采集到的轮对参数、轴箱参数、齿轮

箱参数、牵引电机参数和悬挂装置参数数据采用自动采集方式进行采集;对于动车组转向架车地信息管理系统中的轮对参数、轴箱参数、齿轮箱参数、牵引电机参数和悬挂装置参数数据,采用主动采集方式进行采集;对于诊断专家和/或故障推荐修程给出的轮对参数、轴箱参数、齿轮箱参数、牵引电机参数和悬挂装置参数数据,采用被动采集方式进行采集。

81.1.2对采集到的业务数据的数据段进行三段式标记

82.将业务数据的数据段设置为3段特征参数组合的形式,其中第1段设置为参数的数值范围,第2段设置为参数类型标记(若参数有单位则参数类型标记为参数单位,若参数无单位,则参数类型标记自定义),第3段设置为零部件名称标记;例如轮对温度特征参数的业务数据,将其第1段设置为(-40- 40),第2段设置为℃,第3段设置为ww(用参数ww表示零部件为轮对),则轮对温度特征参数可表示为(-40- 40)-℃-ww。三段式标记作用于数据段上,就是给数据段上的数据加一个已知的评判标准。这样数据在边缘层全部打标完毕,系统就可以把打完标记的数据发送给分布式云处理层,后续分布式云处理层收到这些数据,累积到一定量时,可以按三段式标记的评判标准扫描判断数据是否需要进入清洗,还是直接存储应用。

83.1.3将三段式标记后的业务数据通过消息中间件的方式传输至分布式云层,在分布式云层执行步骤2;

84.步骤2:数据清洗判定

85.判断当前业务数据是否需要清洗,若是,则进入步骤3;若否,则将当前业务数据进行存储备份;

86.业务数据是否需要清洗的判断方法为:

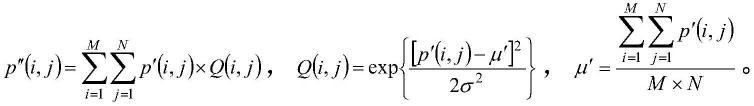

87.若当前业务数据存在缺失值、重复值和/或异常值,则表示当前业务数据需要清洗;对于异常值的判定,如图7所示,本发明采用设定阈值 单位 标记的方法判定正常异常业务数据,例如将动车组转向架轮对的温度数据阈值设定为(20-80)-℃-ww,只有业务数据的3段特征都满足阈值设定时,才判定该业务数据为正常数据,否则,判定该业务数据为异常数据,通过此组合式判定方法可提升正常异常业务数据判定准确率。

88.步骤3:数据预处理

89.3.1预处理方式设置

90.根据业务数据特征,触发数据预处理方式,包括数据的读写、数据的探索、数据简单处理、时域转频域、数据归一化;其中:

91.数据的探索,是指采用k-means聚类算法探索业务数据的字段离散度和关联性,将与转向架关键部件(包括轮对、轴箱、齿轮箱、牵引电机和悬挂装置)不相关的业务数据字段删除,保留与目标主题关联度大(通过超参数k的故障类别来确定)的业务数据字段;

92.数据的简单处理,是指去除数据中的空格和/或对数据中的大小写进行转换;

93.时域转频域,是指将时域数据转化为频域数据;对于业务数据中的振动数据,需要对其进行时域转频域预处理,而对于业务数据中的温度数据(例如轮对主轴温度、轴箱内齿轮温度、牵引电机定子和两端轴承温度等),不需要进行时域转频域预处理;

94.数据归一化,是对业务数据进行归一化处理,以消除奇异样本数据导致的不良影响,将需要预处理的业务数据被限定在一定的范围内,从而加快最优解的求解速度;本发明采用knn算法进行数据归一化处理,不但能加快梯度下降求最优解的速度,还能提高业务数

据处理精度。

95.knn算法可以采用(0,1)标准化处理方式,遍历业务数据中的每一个数据,找到业务数据里的最大值max和最小值min,并将max-min作为基数(即min=0,max=1)进行数据归一化处理:

[0096][0097]

其中,x

normalication

为归一化后的结果。此外,除了采用上述(0,1)标准化处理方式外,还可以采用其他标准化处理方式,例如(-1,1)标准化处理方式。

[0098]

3.2根据业务数据特征参数,自适应配置相应的数据预处理方式对其进行预处理,预处理完成后进入步骤4。

[0099]

数据预处理自适应配置方法的模型如图5所示:

[0100]

首先,事先设置一个预处理算法集合b,该集合b内的每一个元素为3段特征参数组合的形式,其中第1段设置为空,第2段设置为能表征参数类型的标记(对于有单位的参数该标记为单位,对于无单位的特定部件该标记为自定义参数/数字),第3段设置为零部件名称标记 其对应的预处理方法引用标记,例如将集合b中针对轮对温度特征参数处理算法的第1段设置为-,第2段设置为℃表示该参数为温度,第3段设置为wwy1(ww表示该零部件为轮对,y1为轮对的温度参数对应的预处理方法),则针对轮对温度特征参数预处理算法可表示为

‑‑

℃-wwy1。

[0101]

然后,设置一个特征参数集合a,将接收到的标记为三段式的业务数据放入其中;

[0102]

第三,提取特征参数集合a中的其中一个业务数据,遍历预处理算法集合b中的元素,当该业务数据中的第2段和第3段均与预处理算法集合b中某一个特征参数组合中的第2段的参数单位和第3段中的零部件名称一致时,该特征组合参数第3段中设置的预处理方法即为该业务数据所需要采用的预处理方法,从而实现该业务数据预处理方法的自适应配置。若遍历后未在预处理算法集合b中找到相匹配的预处理方法,则在预处理算法集合b中增加与该业务数据相匹配的元素,对集合b进行更新,并将该新增元素对应的预处理算法配置为该业务数据的预处理方法。

[0103]

第四,采用第三步的方法,完成特征参数集合a中其余业务数据预处理方法的自适应配置。

[0104]

上述预处理过程中,本发明可以优先为发生异常概率大的业务数据段进行算法匹配,并忽略与异常发生无关联的业务数据段,以提高匹配效率。

[0105]

这里数据是指采集的数据,数据段是指每条数据的多个组成部分。数据段上的数据值是设备的不同属性值的记录,有些属性是固定值,与设备故障发生完全无关系,这种属性值是我们应用中不关心的,所以可以根据实际业务设置舍弃掉,即在对数据进行预处理时,可以忽略掉这些与故障无关的数据段上的数据。

[0106]

步骤4:数据清洗

[0107]

4.1数据清洗方式设置

[0108]

根据业务数据特征参数,设置数据清洗方式,包括缺失值处理、重复值处理、异常值处理、文本字符串处理和时间格式序列处理;其中:

[0109]

缺失值处理:缺失值处理是业务数据分析、数据集成和数据建模的关键步骤之一;

缺失值主要包含空数据、0、na、null类型,缺失值处理方法包括缺失值删除和缺失值插补,其中,缺失值删除需要人为主观分析判断,缺失值插补更多针对客观数据;缺失值插补有替代方式和模型预测方式,替代方式可采用均值插补、众数插补、就近补齐或k近邻等方法,模型预测方式可采用回归、灰度理论或随机森林等方法。

[0110]

重复值处理:重复值处理是业务数据清洗的关键点之一;重复值处理是指准确地识别筛选出源数据集中的重复数据,从而达到去除重复值的目的。本发明采用多趟近邻排序算法(multi-pass sorted neighborhood,mpn)进行相似重复值处理,该算法的基本思想是独立地执行多趟近邻排序算法(sorted neighborhood method,snm):首先,分别在关键词池中选择不同的关键字和相对较小的滑动窗口大小来多趟执行snm算法;其次,采用当前数据集的固有规则知识库来生成等价判定原理,从而得到记录合并的等价判定标准;最后,根据该等价判定标准将每趟识别出的相似记录合并为同一组。其中,相似度的计算公式如下:

[0111][0112]

式中,wi为第i个权重参数,w1 w2

…

wn=1;valid

[i]

表示对应的第i个属性是否有效;sim(r1,r2)为两条记录的相似度;只有当两条记录r1和r2在第i个属性上对应的值都不为空时,才能进行字段比较,此时的valid

[i]

=1,否则valid

[i]

=0。设置相似度阈值为match_value,若tsim(r1,r2)>match_value,则r1和r2为相似重复记录。

[0113]

异常值处理:异常值处理是检验数据是否存在录入错误和/或是否存在不合常理的数据的检验过程;忽视异常值的存在是不可取的,带入异常值进行数据的计算分析、建模与集成,会对结果产生不良影响;本发明采用基于pca的改进型孤立森林(isolation forest,iforest)算法进行异常值检测,该算法在训练中不需要为业务数据设置标签,是一种典型的无监督学习算法,且能够很好地处理高维数据和海量数据,时间效率高、算法效果好。其基于pca的改进的iforest算法如下:首先,基于业务数据的主成分分析(principal component analysis,pca)方法,确定业务数据属性的关联性和独立性,进一步确定主要影响业务数据分析目标的业务数据主成分属性;其次,构建n棵itree,为每棵itree树随机做无放回采样生成训练集;最后,进行业务数据的预测,即把测试数据在itree树上沿着对应的分支往下走,走到叶子节点,同时记录此过程中经过的路径长度h(x),将路径长度h(x)带入如下异常值评分函数,从而得到异常值分数。

[0114][0115]

其中,从itree的根节点到叶子节点所经过的边的数量为路径长度h(x),树的平均路径长度c(n)=2h(n-1)-(2(n-1)/n),且h(k)=ln(k) ξ,ξ为欧拉常数。由此可知,s(x,n)即为记录x在由n个样本的训练数据构成的itree的异常指数值,其取值范围为[0,1],接近1的程度表示为异常点的可能性大,接近0的程度表示为正常点的可能性大。

[0116]

表1 iforest算法伪代码

[0117][0118]

文本字符串处理:文本字符串处理包括字符串个数统计、字符串重复行合并、文本字符串去重、文本字符串空格去除、字符串按列合并、字符串进制转化、查找文本最长字符串、字符串匹配替换功能。在实际处理过程中比较耗资源,依次利用相应正则表达式扫描处理并对处理前后结果进行比对标记,形成处理路径(比如处理前后无变化,说明这种处理无实际意义,此处理路径可标记为0,反之为1),之后对同一主题域数据,可直接调用该处理路径进行处理。

[0119]

时间格式序列处理:在使用python分析时间序列时,常常需要进行时间日期格式处理和转换,尤其在可视化分析和分时期统计方面。python常用的处理时间的库包括datetime、time、calendar。datetime库包括了date储存日期(年、月、日),time储存时间(小

时、分、秒和微秒),datetime同时包含了date储存日期和time储存时间,timedelta代表两个datetime之间的差(天、秒、微秒)。pandas库是处理时间序列的利器,pandas有着强大的日期数据处理功能,可以按日期筛选数据、按日期显示数据、按日期统计数据。pandas的实际类型主要分为timestamp(时间戳)、period(时期)和时间间隔(timedelt),常用的日期处理函数有:pd.to_datetime(),pd.to_period(),pd.date_range(),pd.period_range();pandas的resample函数还提供了对日期样本的转换,如高低频数据转化等。从而可提供时间格式处理及转换、生产日期序列、时间样本频率转换、日期数据分组统计等功能。

[0120]

表2时间格式序列处理库说明

[0121][0122]

4.2根据业务数据特征参数,自适应配置相应的数据清洗方式对其进行清洗。

[0123]

数据清洗自适应配置模型如图6所示,配置原理与预处理自适应配置原理相同:

[0124]

首先,事先设置一个清洗算法集合c,该集合c内的每一个元素为3段特征参数组合的形式,其中第1段设置为数值范围,第2段设置为能表征参数类型的标记,第3段设置为零部件名称 其对应的清洗方法,例如将集合c中针对轮对温度特征参数的清洗方法的第1段设置为25-60,第2段设置为℃表示该参数为温度,第3段设置为wwq1(ww表示该零部件为轮对,q1为轮对的温度参数对应的清洗方法),则针对轮对温度特征参数清洗方法可表示为(25-60)-℃-ww q1。

[0125]

然后,设置一个特征参数集合d,将前述步骤3预处理后的业务数据放在特征参数集合d中。

[0126]

第三,提取特征参数集合d中的其中一个业务数据,遍历清洗算法集合c中的元素,当该业务数据中的第1段落入清洗算法集合c中某一个特征参数组合中的第1段的数值范围内、第2段的参数单位且第3段中的零部件名称一致时,该特征组合参数第3段中设置的清洗方法即为该业务数据所需要采用的清洗方法,从而实现该业务数据清洗方法的自适应配置。若遍历后未在清洗算法集合c中找到相匹配的清洗方法,则在清洗算法集合c中增加与该业务数据相匹配的元素,对集合c进行更新,并将该新增元素对应的清洗算法配置为该业务数据的清洗方法。

[0127]

第四,采用第三步的方法,完成特征参数集合d中其余业务数据清洗方法的自适应配置。

[0128]

同样的,上述清洗过程中,本发明可以优先为发生异常概率大的业务数据段进行算法匹配,并忽略与异常发生无关联的业务数据段,以提高匹配效率。

[0129]

由于我国幅员辽阔、昼夜温差大,动车组转向架随车运行,其运行工作环境特殊,

存在极高温、极低温、超高速的特点,以及动车组转向架配置的不同,crh3c高速动车组为8辆编组,“4动4拖”结构。crh3c高速动车组8辆编组转向架温度业务数据如表3所示,采用以上3段特征参数组合自适应配置方法,第1段初始化为t1-动车组转向架运行温度(25-60),第2段初始化为t2-动车组转向架运行环境温度(-25-40),第3段初始化为同一列车的8个转向架z1-z8。遍历第1段t1可得业务数据概率可信度为62.5%(正常数据为z2-z6共5个,可信度=5/8=62.5%),遍历第2段t2可得业务数据概率可信度为50%(z2-z6中正常数据为z3-z6,可信度=4/8=50%),同时,可确定z1、z2、z7、z8动车组转向架温度可能异常。

[0130]

表3 crh3c高速动车组8辆编组转向架温度业务数据

[0131][0132]

步骤5:数据存储

[0133]

由于并不是所有的数据经过数据清洗的处理后都能满足预期,那些不能满足预期的数据就是异常数据,这时的异常数据有的是设备故障导致记录的数据本身出错,有的则是数据清洗算法无法对其有效处理的出错。对于清洗后的这些错误数据也需要保留,以便负责研究异常的专家去做数据挖掘。

[0134]

因此,在步骤4清洗结束后,我们进一步判断业务数据清洗完成后是正常数据还是异常数据,根据判定结果进行分别存储。对于业务数据的异常判定,采用前述步骤2相同的判定方法。图8为实现上述清洗方法的装置,包括数据采集模块、数据预处理模块、数据清洗模块、数据应用分析模块、分布式云层处理器、存储器和算法自适应配置模型。

[0135]

综上所述,本发明的清洗方法和实现该清洗方法的装置能够根据业务数据特征参数自适应地确定业务数据预处理和清洗方法。首先,根据动车组转向架不同部件或零件,不同业务数据参数的数据来源不同,以自动、主动或被动数据采集方式,采集动车组转向架运行和维护实时数据信息,并通过消息中间件传输采集的动车组转向架实时数据至业务数据预处理配置层;其次,通过业务数据预处理配置功能,根据数据预处理自适应配置模型,自适应地选择业务数据预处理方法进行预处理;再次,通过业务数据清洗配置功能,根据业务数据清洗自适应配置模型,自适应地确定业务数据清洗方法进行清洗;最后,针对清洗过的业务数据,对其进行正常与否的判定,将正常数据和异常数据分类存储,对于正常数据进行应用分析,对于异常数据进一步挖掘其数据价值。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。