1.本发明涉及联邦学习领域,尤其涉及一种基于动态契约理论的车联网联邦学习激励方法。

背景技术:

2.联邦学习作为一种安全的分布式机器学习体系结构,保障了本地数据的隐私安全问题,让车联网客户端能够在数据不出本地的情形下对联邦学习模型进行训练。车联网客户端在进行模型训练的过程中需要消耗一定的资源,理性的车联网客户端不愿意无偿的奉献其资源。因此联邦学习应该提供一种激励机制方法来促进车联网客户端的参与,然而联邦学习服务器和车联网客户端合作过程中存在信息不对称问题,车联网客户端是基于本地数据训练联邦学习任务模型,联邦学习服务器无法访问其工作的真实性。基于契约理论的激励机制是促进诚实行为的有效方法,尤其是在信息不对称的情况下。

3.当前的基于契约理论的联邦学习激励机制大多是为静态契约。然而,车联网联邦学习应用中,联邦学习服务器希望车联网边缘设备能够持续参与。但是随着合作的长期进行,合作的环境会发生变化,当前的合约可能已经不在适用于现在的合作关系,而且在资源受限的物联网场景中签署重复静态合同会造成大量的通信成本。动态契约模型支持两次或更多联邦学习培训回合的合同签署,因此一种动态的契约理论激励机制更加适用于车联网联邦学习长期合作的场景当中。

4.基于契约理论的激励机制主要是为了解决信息不对称的情况下,客户端作为理性的个体不愿意参与联邦学习模型训练的问题。该激励机制通过给与不同奖励来诱使客户端最大化的提供自身的资源。基于契约理论的激励机制在联邦学习中,主要目的是促进联邦学习服务器和客户端之间的合作,这种合作往往是长期进行的,然而契约往往是静态契约。静态契约只能为联邦学习服务器和客户端提供一次合约,这样并不能满足联邦学习服务器和客户端之间的长久合作的关系。

技术实现要素:

5.为解决现有技术存在的不足,本发明提供一种基于动态契约理论的车联网联邦学习激励方法,基于车联网为背景,为联邦学习服务器和车联网客户端建立的动态契约激励机制,解决联邦学习服务器和车联网客户端在信息不对称的情况下的长期合作激励问题。

6.本发明所采取的技术方案是:

7.一种基于动态契约理论的车联网联邦学习激励方法,包括以下步骤:

8.步骤1:建立车联网客户端和联邦学习服务器的效用模型,通过满足ir(individual rationality),ic(incentive compatibility),iir(intertemporal individually rational)和iic(intertemporal incentive compatibility)约束条件,构建两期动态契约模型,得到最优动态契约;

9.步骤2:使用步骤1得到的最优动态契约与车联网客户端进行签约;

10.步骤3:在动态契约的第一阶段,签约的车联网客户端从联邦学习服务器下载全局模型,对全局模型进行本地训练得到本地模型,将训练完成的本地模型上传到联邦学习服务器;

11.步骤4:联邦学习服务器判断车联网客户端上传的本地模型的精度是否满足设定精度阈值,若满足设定精度阈值,联邦学习服务器接收车联网客户端上传的本地模型并按照第一阶段最优动态契约发放相应的奖励,反之则不接收车联网客户端上传的本地模型并不发放奖励;

12.步骤5:在动态契约的第二阶段,签约的车联网客户端从联邦学习服务器下载全局模型,对全局模型进行本地训练得到本地模型,将训练完成的本地模型上传到联邦学习服务器;

13.步骤6:联邦学习服务器判断车联网客户端上传的本地模型的精度是否满足设定精度阈值,若满足设定精度阈值,联邦学习服务器接收车联网客户端上传的本地模型并按照第二阶段最优动态契约发放相应的奖励,反之则不接收车联网客户端上传的本地模型并不发放奖励。

14.所述步骤1的具体过程,包括以下步骤:

15.步骤1.1:建立车联网客户端的成本模型、效用模型,建立联邦学习服务器的效用模型;

16.设定类型为m的车联网客户端训练的数据大小为dm,训练截止时间为tm,其训练数据的cpu频率为fm,每轮cpu周期的消耗成本为其中,k为常数;当类型为m的车联网客户端训练的数据大小为dm时,需要消耗的cpu周期为pdm,其中,p为常数;类型为m型车辆的cpu频率具体包括以下步骤:

17.步骤1.1.1:建立类型为m的车联网客户端的成本模型,如式(1)所示:

[0018][0019]

设定μ=kp3,其中,μ为常数;将定义为类型为m的车联网客户端的私有信息,表示类型为m的车联网客户端基于训练时间的数据训练能力;类型为m的车联网客户端的成本模型,如式(2)所示:

[0020]cm

=μθm[dm]3ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0021]

步骤1.1.2:建立类型为m的车联网客户端的效用模型uv,如式(3)所示:

[0022]

uv=r

m-cm=r

m-μθm[dm]3ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0023]

其中,rm为类型为m的车联网客户端从联邦学习服务器收到的奖励;

[0024]

步骤1.1.3:联邦学习服务器从类型为m的车联网客户端上传的本地模型中获得的收益gm,如式(4)所示:

[0025]gm

=σlog(1 αdm)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0026]

其中,σ和α基于数据大小确定模型精度对联邦学习服务器收益的影响;

[0027]

建立联邦学习服务器的效用模型us,如式(5)所示:

[0028][0029]

其中,n代表有n个车联网客户端参与联邦学习训练,qm代表类型为m的车联网客户端的先验概率分布,rm为联邦学习服务器为类型为m的车联网客户端发放的奖励;

[0030]

步骤1.2:建立动态契约第二阶段和第一阶段的车联网客户端的效用模型、两阶段的最优契约模型;具体分为以下步骤:

[0031]

步骤1.2.1:建立第二阶段的类型为n的车联网客户端的效用模型,如式(6)所示:

[0032][0033]

其中,代表第一阶段类型为m第二阶段类型为n的车联网客户端的私有信息;

[0034]

第二阶段类型为n的车联网客户端在选择契约时获得非负效用,满足ir(individual rationality)约束条件,如式(7)所示:

[0035][0036]

其中,x为常数,表示第二阶段类型为n的车联网客户端最小可接受效用;

[0037]

第二阶段类型为n的车联网客户端在选择和自身类型相同的契约时获得最大效用,满足ic(incentive compatibility)约束条件,如式(8)所示:

[0038][0039]

其中,和为选取最适合自身契约情况下的第二阶段的奖励和训练数据大小;和为选取其他契约情况下第二阶段的奖励和训练数据大小;

[0040]

步骤1.2.2:建立第一阶段的类型为m的车联网客户端的跨期效用模型,如式(9)所示:

[0041][0042]

其中,为类型为m的车联网客户端在第一阶段的私有信息;δ为折扣因子;表示第二阶段先验概率分布;

[0043]

第一阶段类型为m的车联网客户端应满足iir(intertemporal individually rational)约束条件,如式(10)所示:

[0044][0045]

同时满足iic(intertemporal incentive compatibility)约束条件,如式(11)所示:

[0046][0047]

两阶段满足ir,ic,iir和iic约束条件时,两期动态合同的优化问题,如式(12)-式(16)所示:

[0048][0049][0050][0051][0052][0053]

其中,为联邦学习服务器在第一阶段的效用,为联邦学习服务器在第二阶段的效用;

[0054]

步骤1.3:放松ir、ic、iir、iic约束条件,得到联邦学习服务器和车联网客户端的最优动态合约;

[0055]

对步骤1.2中的ir约束进行放松约束,如式(17)所示:

[0056][0057]

对步骤1.2中的ic约束进行放松约束,如式(18)所示:

[0058][0059]

对步骤1.2中的iir约束进行放松约束,如式(19)所示:

[0060][0061]

对步骤1.2中中的iic约束进行放松约束,如式(20)所示:

[0062][0063]

通过放松步骤1.2中的约束条件,两期动态合同的优化问题,如式(21)-式(25)所示:

[0064][0065][0066][0067]

[0068][0069]

在放松后约束条件下,式(21)-式(25),通过拉格朗日函数可以得到最终的最优动态契约。

[0070]

所述步骤2的具体过程,包括以下步骤:

[0071]

步骤2.1:联邦学习服务器向车联网客户端广播最优动态契约;

[0072]

联邦学习服务器将步骤1.3中得到的最优动态契约广播给所有参与合作的车联网客户端;

[0073]

步骤2.2:车联网客户端选择是否签约最优动态契约,若是,则执行步骤3,若否,则退出此次合作。

[0074]

所述步骤3的具体过程,包括以下步骤:

[0075]

步骤3.1:车联网客户端从联邦学习服务器下载全局模型;

[0076]

步骤3.2:车联网客户端使用本地数据对从联邦学习服务器下载的全局模型进行训练,按照选择的契约训练相应的数据量,训练完成后执行步骤3.3;

[0077]

步骤3.3:车联网客户端将训练完成的本地模型上传给联邦学习服务器。

[0078]

所述全局模型为联邦学习服务器需要车联网客户端训练的模型。

[0079]

所述步骤4的具体过程,包括以下步骤:

[0080]

步骤4.1:联邦学习服务器将验证车联网客户端上传的本地模型,设定精度阈值ψ;若模型的测试精度大于等于精度阈值ψ,则通过验证接收模型并执行步骤4.2,若小于精度阈值ψ,则拒绝接收该模型;

[0081]

步骤4.2:联邦学习服务器对接受模型的车联网客户端按照签约的第一阶段最优动态契约发放相应的奖励。

[0082]

所述步骤5的具体过程,包括以下步骤:

[0083]

步骤5.1:车联网客户端从联邦学习服务器下载全局模型;

[0084]

步骤5.2:车联网客户端使用本地数据对从联邦学习服务器下载的全局模型进行训练,按照选择的契约训练相应的数据量,训练完成后执行步骤5.3;

[0085]

步骤5.3:车联网客户端将训练完成的本地模型上传给联邦学习服务器。

[0086]

所述步骤6的具体过程,包括以下步骤:

[0087]

步骤6.1:联邦学习服务器将验证车联网客户端上传的本地模型,设定精度阈值ψ;若模型的测试精度大于等于精度阈值ψ,则通过验证接收模型并执行步骤6.2,若小于精度阈值ψ,则拒绝接收该模型;

[0088]

步骤6.2:联邦学习服务器对接受模型的车联网客户端按照签约的第二阶段最优动态契约发放相应的奖励。

[0089]

有益技术效果

[0090]

1、本发明提供的一种基于动态契约理论的车联网联邦学习激励方法,采用了联邦学习架构,使数据在本地进行训练,保障了数据的隐私和安全。在采用联邦学习架构的基础上,为联邦学习服务器和车联网客户端建立了两期动态契约激励机制,在非对称信息的情

况下,使车联网客户端选择和自身私有信息相对应的契约才能获得最大效用,来最大化联邦学习服务器的效用,当车联网客户端选择和自身类型相对应的契约时,车联网客户端的效用最高。

[0091]

2、在长期合作下,考虑了车联网联邦学习的私有信息的动态变化,采用了动态契约激励机制,相比于静态契约激励机制更适用于联邦学习服务器和车联网边缘设备之间的长期合作,相比于静态契约,在动态契约激励机制下,联邦学习服务器和车联网边缘设备会获得更高的收益。

附图说明

[0092]

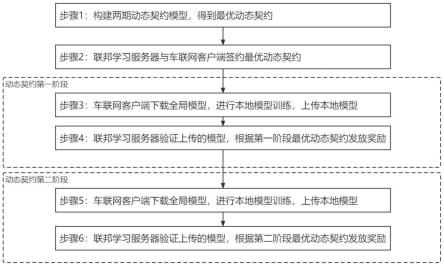

图1为本发明实施例提供的联邦学习服务器和车联网客户端合作流程图;

[0093]

图2为本发明实施例提供的车联网客户端第二阶段选择不同类型契约的效用示意图;

[0094]

图3为本发明实施例提供的车联网客户端第一阶段选择不同类型契约的效用示意图。

具体实施方式

[0095]

下面结合附图和实施例,对本发明的具体实施方式作进一步详细描述。

[0096]

为解决现有技术存在的不足,本发明提供一种基于动态契约理论的车联网联邦学习激励方法,基于车联网为背景,为联邦学习服务器和车联网客户端建立的动态契约激励机制,解决联邦学习服务器和车联网客户端在信息不对称的情况下的长期合作激励问题。

[0097]

本发明所采取的技术方案是:

[0098]

一种基于动态契约理论的车联网联邦学习激励方法,如图1所示,包括以下步骤:

[0099]

步骤1:建立车联网客户端和联邦学习服务器的效用模型,通过满足ir(individual rationality),ic(incentive compatibility),iir(intertemporal individually rational)和iic(intertemporal incentive compatibility约束条件,构建两期动态契约模型,得到最优动态契约;分为以下步骤:

[0100]

步骤1.1:联邦学习服务器为促进联邦学习服务器和车联网客户端的长期合作,建立车联网客户端的成本模型、效用模型,并建立联邦学习服务器的效用模型;

[0101]

设定类型为m的车联网客户端训练的数据大小为dm,训练截止时间为tm,其训练数据的cpu频率为fm,每轮cpu周期的消耗成本为其中,k为常数;当类型为m的车联网客户端训练的数据大小为dm时,需要消耗的cpu周期为pdm,其中,p为常数;类型为m型车辆的cpu频率具体包括以下步骤:

[0102]

步骤1.1.1:类型为m的车联网客户端训练数据大小为dm的数据的成本为cm,如式(1)所示:

[0103][0104]

设定μ=kp3,其中,μ为常数;将定义为类型为m的车联网客户端的私有信

息,表示类型为m的车联网客户端基于训练时间的数据训练能力;类型为m的车联网客户端的成本模型,如式(2)所示:

[0105]cm

=μθm[dm]3ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0106]

步骤1.1.2:类型为m的车联网客户端的效用模型uv表示为其获得的奖励rm减去其训练成本cm,如式(3)所示:

[0107]

uv=r

m-cm=r

m-μθm[dm]3ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0108]

其中,rm为类型为m的车联网客户端从联邦学习服务器收到的奖励;

[0109]

步骤1.1.3:联邦学习服务器从类型为m的车联网客户端上传的本地模型中获得的收益gm,如式(4)所示:

[0110]gm

=σlog(1 αdm)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0111]

其中,σ和α基于数据大小确定模型精度对联邦学习服务器收益的影响;

[0112]

联邦学习服务器的效用模型us表示为其获得的总收益减去其为车联网客户端发放的总奖励,如式(5)所示:

[0113][0114]

其中,n代表有n个车联网客户端参与联邦学习训练,qm代表类型为m的车联网客户端的先验概率分布,qm∈[0,1],rm为联邦学习服务器为类型为m的车联网客户端发放的奖励;

[0115]

步骤1.2:建立动态契约第二阶段和第一阶段的车联网客户端的效用模型、两阶段的最优契约模型;具体分为以下步骤:

[0116]

步骤1.2.1:基于逆向归纳法思想,首先建立第二阶段的类型为n的车联网客户端的效用模型,如式(6)所示:

[0117][0118]

其中,是第一阶段类型为m第二阶段类型为n的车联网客户端的私有信息;是第一阶段类型为m的车联网客户端的私有信息;

[0119]

为了确保第二阶段类型为n的车联网客户端在选择契约时获得非负效用,应满足ir(individual rationality)约束条件,如式(7)所示:

[0120][0121]

其中,x为常数,表示第二阶段类型为n的车联网客户端最小可接受效用;在第二阶段类型为n的车联网客户端的效用大于等于x;

[0122]

为了确保第二阶段类型为n的车联网客户端在选择契约时获得最大效用,应满足ic(incentive compatibility)约束条件,如式(8)所示:

[0123][0124]

其中,和为选取最适合自身契约情况下的第二阶段的奖励和训练数据大小;和为选取其他契约情况下第二阶段的奖励和训练数据大小;当

第二阶段类型为n的车联网客户端选择类型为n的契约时,获得最大效用,如图2所示;根据上述ic约束条件,契约可以激励车联网客户端通过选择相应的契约来反映其真实的私有信息,联邦学习服务器可以以此来了解车联网客户端的真实私有信息;

[0125]

步骤1.2.2:建立第一阶段的类型为m的车联网客户端的跨期效用模型,如式(9)所示:

[0126][0127]

其中,为类型为m的车联网客户端在第一阶段的私有信息;δ为折扣因子;表示第二阶段先验概率分布;

[0128]

为了确保第一阶段类型为m的车联网客户端在选择契约时获得非负跨期效用,应满足iir(intertemporal individually rational)约束条件,如式(10)所示:

[0129][0130]

第一阶段类型为m的车联网客户端的跨期效用大于等于x δx;

[0131]

同时为了确保第一阶段类型为m的车联网客户端在选择时获得最大跨期效用,应满足iic(intertemporal incentive compatibility)约束条件,如式(11)所示:

[0132][0133]

当第一阶段类型为m的车联网客户端选择类型为m的契约时,获得最大跨期效用,如图3所示;

[0134]

当两阶段满足ir,ic,iir和iic约束条件时,联邦学习服务器的最大预期效用,如式(12)-式(16)所示:

[0135][0136][0137][0138][0139][0140]

其中,为联邦学习服务器在第一阶段的效用,为联邦学习服务器在第二阶段的效用;

[0141]

步骤1.3:放松ir、ic、iir、iic约束条件,得到联邦学习服务器和车联网客户端的最优动态契约;

[0142]

对步骤1.2中的ir约束进行放松约束,如式(17)所示:

[0143][0144]

满足式(17)约束条件,第二阶段其他所有类型的车联网客户端都满足ir约束条件;

[0145]

对步骤1.2中的ic约束进行放松约束,如式(18)所示:

[0146][0147]

满足式(18)约束条件,第二阶段其他所有类型的车联网客户端都满足ic约束条件;

[0148]

对步骤1.2中的iir约束进行放松约束,如式(19)所示:

[0149][0150]

满足式(19)约束条件,第一阶段其他所有类型的车联网客户端都满足iir约束条件;对步骤1.2中中的iic约束进行放松约束,如式(20)所示:

[0151][0152]

满足式(20)约束条件,第一阶段其他所有类型的车联网客户端都满足iic约束条件;

[0153]

通过放松步骤1.2中的约束条件,两期动态合同的优化问题,如式(21)-式(25)所示:

[0154][0155][0156][0157][0158][0159]

在放松后约束条件下,联邦学习服务器效用函数为凸函数,式(21)-式(25),通过拉格朗日函数可以得到最终的最优动态契约;

[0160]

步骤2:使用步骤1得到的最优动态契约与车联网客户端进行签约;

[0161]

联邦学习服务器向车联网客户端广播最优动态契约;车联网客户端选择是否签约最优动态契约,若是执行步骤3,若否,则退出此次合作,具体包括以下步骤:

[0162]

步骤2.1:联邦学习服务器向车联网客户端广播最优动态契约;

[0163]

联邦学习服务器将步骤1.3中得到的最优动态契约广播给所有参与合作的车联网客户端;

[0164]

步骤2.2:车联网客户端选择是否签约最优动态契约,若是,车联网客户端将选择签约返回给联邦学习服务器,执行步骤3,若否,则退出此次合作;

[0165]

步骤3:在动态契约的第一阶段,车联网客户端从联邦学习服务器下载全局模型,车联网客户端进行本地模型训练,将训练好的本地模型上传到联邦学习服务器,具体包括以下步骤:

[0166]

步骤3.1:车联网客户端从联邦学习服务器下载全局模型;

[0167]

所述全局模型为联邦学习服务器需要车联网客户端训练的模型;

[0168]

步骤3.2:车联网客户端使用本地数据对从联邦学习服务器下载的全局模型进行训练,按照选择的契约训练相应的数据量,训练完成后执行步骤3.3;

[0169]

步骤3.3:车联网客户端将训练完成的本地模型上传给联邦学习服务器;

[0170]

步骤4:联邦学习服务器对车联网客户端上传的本地模型进行验证,联邦学习服务器按照第一阶段最优动态契约发放对应的奖励;

[0171]

步骤4.1:为了防止车联网客户端上传不真实的本地模型,联邦学习服务器将验证车联网客户端上传的本地模型,设定精度阈值ψ;若模型的测试精度大于等于精度阈值ψ,则通过验证接收模型并执行步骤4.2,若小于精度阈值ψ,则拒绝接收该模型;

[0172]

步骤4.2:联邦学习服务器对接收模型的车联网客户端按照签约的第一阶段最优动态契约发放相应的奖励;

[0173]

步骤5:在动态契约的第二阶段,车联网客户端从联邦学习服务器下载全局模型,车联网客户端进行本地模型训练,将训练好的本地模型上传到联邦学习服务器,具体包括以下步骤:

[0174]

步骤5.1:车联网客户端从联邦学习服务器下载全局模型;

[0175]

所述全局模型为联邦学习服务器需要车联网客户端训练的模型;

[0176]

步骤5.2:车联网客户端使用本地数据对从联邦学习服务器下载的全局模型进行训练,按照选择的契约训练相应的数据量,训练完成后执行步骤5.3;

[0177]

步骤5.3:车联网客户端将训练完成的本地模型上传给联邦学习服务器;

[0178]

步骤6:联邦学习服务器对车联网客户端上传的本地模型进行验证,联邦学习服务器按照第二阶段最优动态契约发放对应的奖励;

[0179]

步骤6.1:联邦学习服务器将验证车联网客户端上传的本地模型,设定精度阈值ψ;若模型的测试精度大于等于精度阈值ψ,则通过验证接收模型并执行步骤6.2,若小于精度阈值ψ,则拒绝接收该模型;

[0180]

步骤6.2:联邦学习服务器对接收模型的车联网客户端按照签约的第二阶段最优动态契约发放相应的奖励。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。