1.本发明属于视频处理技术领域,具体涉及一种人体动作的轻量化在线检测方法。

背景技术:

2.目前,人体动作在线检测任务要求在一个视频流中,根据已观测到的多帧图像结合当前时刻图像帧对该时刻的人体动作进行识别。人体动作在线检测是视频理解领域一个极具挑战性的任务,在不取得完整时空动作信息的前提下对人体动作进行实时帧级动作类别划分,要求模型更高更快的时序推理能力,这对于该领域的发展存在重大研究意义。另一方面,人体动作在线检测对于多项现实任务具有发展意义,由于该技术无需对动作完整观测即可对动作进行识别,从而使智能设备对该动作实时做出反应,在视频监控、无人驾驶与智能人机交互等技术领域存在极大的应用价值。

3.现有人体动作在线检测方法主要是基于深度循环神经网络对人体动作进行在线识别。该类方法通过将多个连续视频块提取特征后送入循环神经序列进行时序推理得到在线检测结果,该类方法受限于循环神经网络自身的序列结构特性,必须将按时间顺序进行逐步推理,计算耗时耗力,且对于长序列输入不仅推理缓慢无法做到实时检测,且推理过程随网络加深中会大量丢失时间信息。因此现有技术的人体动作在线检测效率和精度普遍较低。

技术实现要素:

4.本发明拟提供一种人体动作的轻量化在线检测方法,拟解决人体动作在线检测效率和精度较低的问题。

5.为解决上述技术问题,本发明采用的技术方案如下:

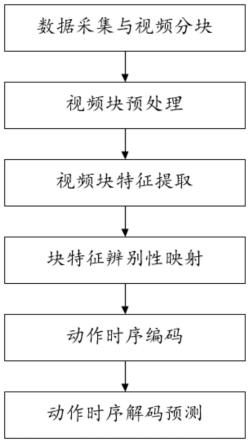

6.一种人体动作的轻量化在线检测方法,包括以下步骤:

7.步骤1:采集人体动作视频数据,对人体动作视频进行标注分块,得到作为训练样本的多个视频块序列;

8.步骤2:对步骤1中得到的所有视频块做预处理,得到视频序列数据集,并将视频序列数据集分为测试集和训练集;

9.步骤3:基于slowfast模型构建特征提取网络,并基于所构建的特征提取网络提取人体动作在线检测数据集中的每个视频块的特征,得到视频块时空特征;

10.步骤4:基于双路孪生网络设计辨别性特征映射网络,并基于所述辨别性特征映射网络对视频块时空特征进行辨别性映射,得到映射向量;

11.步骤5:基于informer模型的概率稀疏注意力与注意力蒸馏,构建时序编码器,并通过时序编码器对特征向量进行特征编码,得到编码向量序列;

12.步骤6:基于informer模型的概率稀疏注意力构建时序解码器,并通过时序解码器对编码向量序列进行时序解码,得到解码结果;将解码结果送入分类器得到人体动作在线检测结果,并基于多时态的检测结果对整体网络联合优化。

13.本发明采用孪生网络对特征序列进行映射,增加输入时序特征序列辨别性。为了减少长时信息丢失与时序推理的时间问题,本发明基于informer模型的概率稀疏注意力构建时序编码器进行时序推理,并结合注意力蒸馏进一步的提高推理效率。采用informer模型的概率稀疏注意力构建时序解码器,通过多时态融合生成式解码提升人体动作在线检测精度和速度。

14.优选的,所述步骤1包括以下步骤:

15.步骤1.1:采用影像设备采集人体动作视频数据;

16.步骤1.2:对人体动作视频数据中的人体动作做时序上的标注;

17.步骤1.3:对人体动作视频数据按预设的固定时间长度进行分块,得到视频块序列;

18.步骤1.4:设定输入时间序列长度,按时间顺序将长度为序列长度的视频块序列作为单个训练样本。

19.优选的,所述步骤2包括以下步骤:

20.步骤2.1:将训练样本中的所有视频块序列中的图像帧分辨率修改为256*256;

21.步骤2.2:对修改后的图像帧分辨率进行随机裁剪,得到图像帧分辨率为224*224的视频块序列数据集;

22.步骤2.3:将原始视频(刚采集到的视频数据)按照1:1的比例划分为训练集和测试集,分别用于训练和测试。

23.优选的,为了获取更优的特征提取能力,所述步骤3中构建特征提取网络时,还需将特征提取网络在kinetics数据集上进行训练。

24.优选的,步骤3中所述的特征提取网络结构采用slowfast模型中的date layer的时序抽取操作,以及slow pathway中的conv1到res5的卷积层和池化层。

25.优选的,所述双路孪生网络采用两层共享参数的全连接层网络构建,使用xavier初始化策略对全连接层网络的网络参数进行初始化,即:层输入维度为f

in

,层输出维度为f

out

,其初始化参数ω服从均值为0,方差为的高斯分布:

[0026][0027]

网络训练时,将步骤3中输出的视频块时空特征序列x-t 1

,

…

,x2,x1,x0中的x0与序列的其余特征{x-t 1

,

…

,x2,x1}分别配对,得到(x-t 1

,x0),

…

,(x1,x0)特征对序列,其中x0代表当前时刻的视频块时空特征;将经过配对的特征对送入辨别性特征映射网络进行训练,通过对比损失lc对辨别性特征映射网络进行优化,其表达式为:

[0028][0029]

其中w为网络参数,当x1,x2为同一类别时y=1,否则y=0,dw为两向量间的欧式距离,m为向量间距离阈值。

[0030]

优选的,所述时序编码器首先将输入的特征向量序列进行位置编码,加入序列的位置信息,基于informer编码器对z进行编码,得到编码后的向量序列h;

[0031]

h=en(z);

[0032]

利用概率稀疏自注意力层计算z的中序列间的时序自注意力,利用注意力蒸馏层对注意力序列进行蒸馏压缩;采用多个概率稀疏注意力和注意力蒸馏层级联而成,数量为n:n-1。

[0033]

优选的,所述时序解码器构建出p个可学习向量,且时序解码器所构建的向量维度与步骤4中的输出维度相同,且与步骤4中的输出向量级联,利用1个概率稀疏注意力层计算可学习向量间的自注意力后,再通过一个全注意力层计算与编码输出间的互注意力,得到过去、现在以及未来三时态解码向量。

[0034]

优选的,对整体网络联合优化的具体步骤如下:

[0035]

步骤a:对过去时刻以及未来时刻进行人体动作识别,得到预测概率pi,具体为:

[0036]

pi=classifier(yi)(i=-t 1,

…

p,i≠0);

[0037]

其中yi表示解码输出序列中第i个解码向量,classifier()表示动作识别分类器,由一个输出维度为动作类别数的全连接层和softmax函数级联而成;

[0038]

步骤b:利用标准交叉熵函数计算过去时刻预测损失l

p

以及未来时刻损失lf,具体的:

[0039][0040]

其中gi表示第i个视频块对应的动作标签,pi为该时刻预测概率;

[0041]

步骤c:对于现在时刻,将y中过去时刻与未来时刻向量平均后与y0级联得到人体动作在线预测向量y;将人体动作在线预测向量y送入分类器后得到人体在线动作检测概率p0,并用标准交叉熵计算预测损失ln:

[0042][0043]

并利用多时态联合损失函数l对整体网络参数进行优化,其表达式为:

[0044][0045]

其中λ1,λ2为人为设定的平衡系数,最后将p0中概率最大的动作类别作为在线动作检测结果。

[0046]

综上所述,由于采用了上述技术方案,本发明的有益效果是:

[0047]

本发明通过使用对比学习的孪生网络对特征序列进行映射,增加了输入时序特征序列辨别性;并且为了减少长时信息丢失与时序推理的时间问题,基于informer模型的概率稀疏注意力结构构建时序编码器进行时序推理,并结合注意力蒸馏进一步提高推理效率。采用informer模型的概率稀疏注意力构建时序解码器,通过多时态融合生成式解码提升人体动作在线检测精度与速度。

附图说明

[0048]

本发明将通过例子并参照附图的方式说明,其中:

[0049]

图1为本发明的流程示意图;

[0050]

图2为本发明的数据样本构建流程图;

[0051]

图3为本发明所构建的视频块特征提取网络结构图;

[0052]

图4为本发明的时序解码器结构图。

具体实施方式

[0053]

为使本技术实施例的目的、技术方案和优点更加清楚,下面将结合本技术实施例中附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅是本技术一部分实施例,而不是全部的实施例。通常在此处附图中描述和示出的本技术实施例的组件可以各种不同的配置来布置和设计。因此,以下对在附图中提供的本技术的实施例的详细描述并非旨在限制要求保护的本技术的范围,而是仅仅表示本技术的选定实施例。基于本技术的实施例,本领域技术人员在没有做出创造性劳动的前提下所获得的所有其他实施例,都属于本技术保护的范围。

[0054]

下面结合附图1和附图4对本发明的实施例作详细描述;

[0055]

一种人体动作的轻量化在线检测方法,包括以下步骤:

[0056]

步骤1:采集人体动作视频数据,对人体动作视频进行标注分块,得到作为训练样本的多个视频块序列;

[0057]

所述步骤1包括以下步骤:

[0058]

步骤1.1:采用影像设备采集人体动作视频数据;

[0059]

步骤1.2:对人体动作视频数据中的人体动作做时序上的标注;

[0060]

步骤1.3:对人体动作视频数据按预设的固定时间长度进行分块,得到视频块序列;

[0061]

步骤1.4:设定输入时间序列长度,按时间顺序将长度为序列长度的视频块序列作为单个训练样本。

[0062]

步骤2:对步骤1中得到的所有视频块做预处理,得到视频序列数据集,并将视频序列数据集分为测试集和训练集;

[0063]

所述步骤2包括以下步骤:

[0064]

步骤2.1:将训练样本中的所有视频块序列中的图像帧分辨率修改为256*256;

[0065]

步骤2.2:对修改后的图像帧分辨率进行随机裁剪,得到图像帧分辨率为224*224的视频块序列数据集;

[0066]

步骤2.3:将原始视频(刚采集到的视频数据)按照1:1的比例划分为训练集和测试集,分别用于训练和测试。

[0067]

步骤3:基于slowfast模型构建特征提取网络,并基于所构建的特征提取网络提取人体动作在线检测数据集中的每个视频块的特征,得到视频块时空特征;为了获取更优的特征提取能力,在构建特征提取网络时,还需将特征提取网络在kinetics数据集上进行训练。所述的特征提取网络结构采用slowfast模型中的date layer的时序抽取操作,以及slow pathway中的conv1到res5的卷积层和池化层。

[0068]

步骤4:基于双路孪生网络设计辨别性特征映射网络,并基于所述辨别性特征映射网络对视频块时空特征进行辨别性映射,得到映射向量;所述双路孪生网络采用两层共享参数的全连接层网络构建,使用xavier初始化策略对全连接层网络的网络参数进行初始

化,即:层输入维度为f

in

,层输出维度为f

out

,其初始化参数ω服从均值为0,方差为的高斯分布:

[0069][0070]

网络训练时,将步骤3中输出的视频块时空特征序列x-t 1

,

…

,x2,x1,x0中的x0与序列的其余特征{x-t 1

,

…

,x2,x1}分别配对,得到(x-t 1

,x0),

…

,(x1,x0)特征对序列,其中x0代表当前时刻的视频块时空特征;将经过配对的特征对送入辨别性特征映射网络进行训练,通过对比损失lc对辨别性特征映射网络进行优化,其表达式为:

[0071][0072]

其中w为网络参数,当x1,x2为同一类别时y=1,否则y=0,dw为两向量间的欧式距离,m为向量间距离阈值。

[0073]

步骤5:基于informer模型的概率稀疏注意力与注意力蒸馏,构建时序编码器,并通过时序编码器对特征向量进行特征编码,得到编码向量序列;所述时序编码器首先将输入的特征向量序列进行位置编码,加入序列的位置信息,基于informer编码器对z进行编码,得到编码后的向量序列h;

[0074]

h=en(z);

[0075]

利用概率稀疏自注意力层计算z的中序列间的时序自注意力,利用注意力蒸馏层对注意力序列进行蒸馏压缩;采用多个概率稀疏注意力和注意力蒸馏层级联而成,数量为n:n-1。

[0076]

步骤6:基于informer模型的概率稀疏注意力构建时序解码器,并通过时序解码器对编码向量序列进行时序解码,得到解码结果;所述时序解码器构建出p个可学习向量,且时序解码器所构建的向量维度与步骤4中的输出维度相同,且与步骤4中的输出向量级联,利用1个概率稀疏注意力层计算可学习向量间的自注意力后,再通过一个全注意力层计算与编码输出间的互注意力,得到过去、现在以及未来三时态解码向量。

[0077]

将解码结果送入分类器得到人体动作在线检测结果,并基于多时态的检测结果对整体网络联合优化。对整体网络联合优化的具体步骤如下:

[0078]

步骤a:对过去时刻以及未来时刻进行人体动作识别,得到预测概率pi,具体为:

[0079]

pi=classifier(yi)(i=-t 1,...p,i≠0);

[0080]

其中yi表示解码输出序列中第i个解码向量,classifier()表示动作识别分类器,由一个输出维度为动作类别数的全连接层和softmax函数级联而成;

[0081]

步骤b:利用标准交叉熵函数计算过去时刻预测损失l

p

以及未来时刻损失lf,具体的:

[0082]

[0083]

其中gi表示第i个视频块对应的动作标签,pi为该时刻预测概率;

[0084]

步骤c:对于现在时刻,将y中过去时刻与未来时刻向量平均后与y0级联得到人体动作在线预测向量y;将人体动作在线预测向量y送入分类器后得到人体在线动作检测概率p0,并用标准交叉熵计算预测损失ln:

[0085][0086]

并利用多时态联合损失函数l对整体网络参数进行优化,其表达式为:

[0087][0088]

其中λ1,λ2为人为设定的平衡系数,最后将p0中概率最大的动作类别作为在线动作检测结果。

[0089]

本发明采用孪生网络对特征序列进行映射,增加输入时序特征序列辨别性。为了减少长时信息丢失与时序推理的时间问题,本发明基于informer概率稀疏注意力构建时序编码器进行时序推理,并结合注意力蒸馏进一步的提高推理效率。采用informer概率稀疏注意力构建时序解码器,通过多时态融合生成式解码提升人体动作在线检测精度和速度。

[0090]

下面通过具体的实施方式对本发明作出进一步的描述:

[0091]

步骤1:利用影响设备采集原始视频,人为对视频中的人体动作进行时序上的标注,将所采集的原始视频按帧率τ进行采样后,得到该视频图像的帧序列;设定视频块长度为l,按时间顺序将每l帧图像组成一个视频块(chunk),每个视频块对应的原始视频时间的长度为特别的,对于帧序列尾部不足长度l的视频块,通过复制该视频块最后一帧图像来补足长度l。本发明使用视频块作为最小时间处理单元,形状为3

×

l

×h×

w,其中h和w表示图像的高和宽,将该视频块的中间帧(帧)所对应的动作类别作为该视频块的动作类别。

[0092]

步骤2:对经过步骤1得到的视频块进行预处理;在本实施例中,首先将视频块的图像帧分别率调整为256*256,再对图像帧进行随机裁剪得到224*224分别率的图像帧,预处理后视频块的形状为3

×

l

×

224

×

224;对原视频以随机抽取的方式,按照1:1的比例将原始视频(刚获取到未经过处理的视频)划分为训练集和测试集,对每个视频中基于预处理的视频块序列构建数据样本;具体的,按原始视频时间顺序对视频块进行排列;设定输入序列长度为t的时间窗,以步长1对视频块序列进行重叠滑窗,每次得到长度为t的视频块序列作为一个数据样本,其数据形状为t

×3×

l

×

224

×

224,具体操作步骤如图2所示。

[0093]

步骤3:为增加同类时空特征间的相似性与异类时空特征间的辨别性,基于对比学习中双路孪生网络的思想设计辨别性特征映射模块。本实施例中,利用双层全连接层进行模块构建,其输出维度分别为1024,2048,使用xavier初始化策略对该模块网络参数进行初始化,具体的,层输入维度为f

in

,层输出维度为f

out

,其初始化参数为:

[0094]

[0095]

网络训练时,将步骤3中输出的视频块时空特征序列x-t 1

,

…

,x2,x1,x0中的x0与序列特征分别配对,得到(x-t 1

,x0),

…

,(x1,x0)特征对序列,其中x0代表当前时刻的视频块时空特征,将该视频块时空特征送入映射模块进行训练,通过对比损失对该模块进行优化,其表达式为:

[0096][0097]

其中,w为网络参数,当x1,x2为同一类别时y=1,否则y=0,dw为两向量间的欧式距离,m为向量间距离阈值,在本实例中m=0.25。最后得到辨别性映射向量序列x

′

。

[0098]

步骤5:如图4所示,基于informer模型的稀疏注意力机制构建时序编码器,通过所构建的时序编码器对映射后的特征进行编码。具体的,将特征序列进行位置编码以加入序列位置信息,在本实施例中,采用固定位置编码生成编码向量,表达式如下所示:

[0099][0100]

其中,pos代表位置下标,i代表向量维度下标,d

model

表示编码向量维度,在本实例中与映射后特征序列相同,为2048。将生成位置向量与x

′

相加得到编码后向量z作为编码器输入。基于时序编码器对z进行编码,得到编码后向量序列h:

[0101]

h=en(z);

[0102]

具体的,利用概率稀疏自注意力(probattention)层计算z中序列间的时序自注意力,利用注意力蒸馏层对注意力序列进行蒸馏压缩,具体表达式如下:

[0103]hi

=distil(probatten(h

i-1

,h

i-1

,c))(h0=z);

[0104]

其中c表示稀疏系数,hi表示第i个注意力蒸馏层的输出,蒸馏层函数表达式为:

[0105]

distil(hi′

)=maxpool(elu(conv1d(hi′

)));

[0106]

其中:卷积层卷积核大小为3,步长为1,padding为1,最大池化层核大小为3,步长为2,padding为1。具体地,在本实例中c=5,注意力输出维度为1024,并使用4个概率稀疏注意力层以及3个注意力蒸馏层构成时序编码器,最后编码输出形状为

[0107]

步骤6:如图4所示,基于informer解码器结构构建时序解码器,并将时序解码器的解码结果送入分类器得到人体动作在线检测结果。设定预测长度p,首先生成p个维度为1

×

1024的可学习向量作为预测解码向量,将步骤104中所得映射向量与预测解码向量级联得到解码输入向量xd,其形状为(t p)

×

1024。基于时序解码器对xd进行时序解码,得到解码输出y。具体地,将xd送入概率稀疏注意力层计算解码序列间自注意力后再通过全注意力层计算与编码输出序列间的互注意力,其表达式为:

[0108][0109]

在本实例中,设定动作类别数量为n,构建输入维度为1024,输出维度为n的分类层。训练时,首先对过去时刻以及未来时刻进行人体动作识别,得到预测概率pi,具体为:

[0110]

pi=classifier(yi)(i=-t 1,

…

p,i≠0);

[0111]

利用标准交叉熵函数计算过去时刻预测损失l

p

以及未来时刻损失lf,具体的:

[0112][0113]

其中gi表示第i个视频块对应的动作标签。对于现在时刻,将y中过去时刻与未来时刻向量平均后与y0级联得到人体动作在线预测向量y。将预测向量y送入分类器后得到人体在线动作检测概率p0,并用标准交叉熵计算预测损失ln:

[0114][0115]

并利用多时态联合损失函数l对整体网络参数进行优化,其表达式为:

[0116][0117]

其中λ1,λ2为人为设定的平衡系数,在本实例中λ1=0.25,λ2=0.25。

[0118]

最后将p0中概率最大的动作类别作为在线动作检测结果。

[0119]

以上所述实施例仅表达了本技术的具体实施方式,其描述较为具体和详细,但并不能因此而理解为对本技术保护范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术技术方案构思的前提下,还可以做出若干变形和改进,这些都属于本技术的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。