1.本公开涉及计算机技术领域,尤其涉及一种表情识别方法及装置。

背景技术:

2.随着图像处理技术的发展,图像识别技术在越来越多的场景均得到应用。目前的图像识别技术在识别人脸表情方面取得了很好的效果,但是在复杂场景下,比如人脸的关键部位被遮挡,或者,由于身体姿势的不同(比如侧身)导致不能采集到完整的人脸,导致无法识别人脸表情或者人脸表情的识别结果不准确。因此,亟需一种新的表情识别的方案。

技术实现要素:

3.有鉴于此,本公开实施例提供了一种表情识别方法、装置、计算机设备及计算机可读存储介质,以解决现有技术中在复杂场景下,比如人脸的关键部位被遮挡,或者,由于身体姿势的不同(比如侧身)导致不能采集到完整的人脸,导致无法识别人脸表情或者人脸表情的识别结果不准确的问题。

4.本公开实施例的第一方面,提供了一种表情识别方法,所述方法包括:

5.获取待识别图像;

6.根据所述待识别图像,得到所述待识别图像的图像特征图;

7.根据所述图像特征图,确定全局特征信息和局部特征信息;

8.根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。

9.本公开实施例的第二方面,提供了一种表情识别装置,所述装置包括:

10.图像获取模块,用于获取待识别图像;

11.第一特征获取模块,用于根据所述待识别图像,得到所述待识别图像的图像特征图;

12.第二特征获取模块,用于根据所述图像特征图,确定全局特征信息和局部特征信息;

13.表情类型确定模块,用于根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。

14.本公开实施例的第三方面,提供了一种计算机设备,包括存储器、处理器以及存储在存储器中并且可以在处理器上运行的计算机程序,该处理器执行计算机程序时实现上述方法的步骤。

15.本公开实施例的第四方面,提供了一种计算机可读存储介质,该计算机可读存储介质存储有计算机程序,该计算机程序被处理器执行时实现上述方法的步骤。

16.本公开实施例与现有技术相比存在的有益效果是:本公开实施例可以先获取待识别图像;然后,可以根据所述待识别图像,得到所述待识别图像的图像特征图;接着,可以根据所述图像特征图,确定全局特征信息和局部特征信息;最后,可以根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。由于待识别图像的全局特征信息

反映人脸的整体信息,待识别图像的局部特征信息反映了人脸各个区域的细节信息,因此可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息,这样,根据所述全局特征信息和所述局部特征信息所确定的待识别图像的表情类型更加准确,即可以提高待检测图像对应的表情类型识别结果的精确度,进而提高了用户体验。

附图说明

17.为了更清楚地说明本公开实施例中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本公开的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其它的附图。

18.图1是本公开实施例的应用场景的场景示意图;

19.图2是本公开实施例提供的表情识别方法的流程图;

20.图3是本公开实施例提供表情识别模型的网络架构示意图;

21.图4是本公开实施例提供的gof调制流程的流程示意图;

22.图5是本公开实施例提供的local-global attention结构的网络架构示意图;

23.图6是本公开实施例提供的全局模型的网络架构示意图;

24.图7是本公开实施例提供的split-attention模块的网络架构示意图;

25.图8是本公开实施例提供的权重层的网络架构示意图;

26.图9是本公开实施例提供的表情识别装置的框图;

27.图10是本公开实施例提供的计算机设备的示意图。

具体实施方式

28.以下描述中,为了说明而不是为了限定,提出了诸如特定系统结构、技术之类的具体细节,以便透彻理解本公开实施例。然而,本领域的技术人员应当清楚,在没有这些具体细节的其它实施例中也可以实现本公开。在其它情况中,省略对众所周知的系统、装置、电路以及方法的详细说明,以免不必要的细节妨碍本公开的描述。

29.下面将结合附图详细说明根据本公开实施例的一种表情识别方法和装置。

30.在现有技术中,由于在复杂场景下,比如人脸的关键部位被遮挡,或者,由于身体姿势的不同(比如侧身)导致不能采集到完整的人脸,导致无法识别人脸表情或者人脸表情的识别结果不准确。因此,亟需一种新的表情识别的方案。

31.为了解决上述问题。本发明提供了一种表情识别方法,在本方法中,由于本实施例所提供的方法先获取待识别图像;然后,可以根据所述待识别图像,得到所述待识别图像的图像特征图;接着,可以根据所述图像特征图,确定全局特征信息和局部特征信息;最后,可以根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。由于待识别图像的全局特征信息反映人脸的整体信息,待识别图像的局部特征信息反映了人脸各个区域的细节信息,因此可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息,这样,根据所述全局特征信息和所述局部特征信息所确定的待识别图像的表情类型更加准确,即可以提高待检测图像对应的表情类型识别结果的精确度,进而提高了用户体验。

32.举例说明,本发明实施例可以应用到如图1所示的应用场景。在该场景中,可以包括终端设备1和服务器2。

33.终端设备1可以是硬件,也可以是软件。当终端设备1为硬件时,其可以是具有采集图像、存储图像功能且支持与服务器2通信的各种电子设备,包括但不限于智能手机、平板电脑、膝上型便携计算机、数码照像机、监控器、录像机和台式计算机等;当终端设备1为软件时,其可以安装在如上该的电子设备中。终端设备1可以实现为多个软件或软件模块,也可以实现为单个软件或软件模块,本公开实施例对此不作限制。进一步地,终端设备1上可以安装有各种应用,例如图像采集应用、图像存储应用、即时聊天应用等。

34.服务器2可以是提供各种服务的服务器,例如,对与其建立通信连接的终端设备发送的请求进行接收的后台服务器,该后台服务器可以对终端设备发送的请求进行接收和分析等处理,并生成处理结果。服务器2可以是一台服务器,也可以是由若干台服务器组成的服务器集群,或者还可以是一个云计算服务中心,本公开实施例对此不作限制。

35.需要说明的是,服务器2可以是硬件,也可以是软件。当服务器2为硬件时,其可以是为终端设备1提供各种服务的各种电子设备。当服务器2为软件时,其可以是为终端设备1提供各种服务的多个软件或软件模块,也可以是为终端设备1提供各种服务的单个软件或软件模块,本公开实施例对此不作限制。

36.终端设备1与服务器2可以通过网络进行通信连接。网络可以是采用同轴电缆、双绞线和光纤连接的有线网络,也可以是无需布线就能实现各种通信设备互联的无线网络,例如,蓝牙(bluetooth)、近场通信(near field communication,nfc)、红外(infrared)等,本公开实施例对此不作限制。

37.具体地,用户可以通过终端设备1确定待检测图像,并将待检测图像向服务器2发送。服务器2接收到该待检测图像后,服务器2可以提取待识别图像的图像特征图。然后,服务器2可以根据所述图像特征图,确定全局特征信息和局部特征信息。接着,服务器2可以根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。这样,由于待识别图像的全局特征信息反映人脸的整体信息,待识别图像的局部特征信息反映了人脸各个区域的细节信息,因此可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息,这样,根据所述全局特征信息和所述局部特征信息所确定的待识别图像的表情类型更加准确,即可以提高待检测图像对应的表情类型识别结果的精确度,进而提高了用户体验。

38.需要说明的是,终端设备1和服务器2以及网络的具体类型、数量和组合可以根据应用场景的实际需求进行调整,本公开实施例对此不作限制。

39.需要注意的是,上述应用场景仅是为了便于理解本公开而示出,本公开的实施方式在此方面不受任何限制。相反,本公开的实施方式可以应用于适用的任何场景。

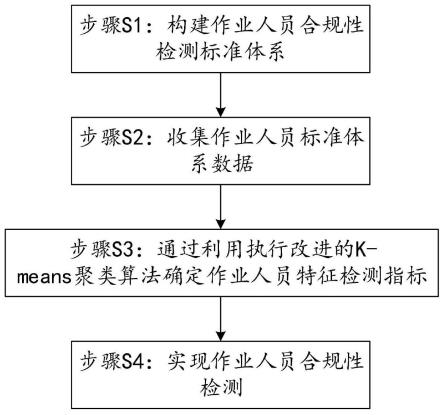

40.图2是本公开实施例提供的一种表情识别方法的流程图。图2的一种表情识别方法可以由图1的终端设备和/或服务器执行。如图2所示,该表情识别方法包括:

41.s201:获取待识别图像。

42.在本实施例中,可以将需要进行表情识别的图像或者视频帧称之为待识别图像。其中,可以将需要进行表情识别的人脸称之为目标人脸。

43.作为一种示例,终端设备可以提供一个页面,用户可以通过该页面上传图像,并点

击预设按键,以触发对该图像进行表情识别,此时,便可以将该图像作为待识别图像。当然,用户也可以通过使用终端设备进行拍照得到待识别图像。另外,用户还需要确定需要识别的目标人脸,或者系统预设了需要识别的目标人脸。

44.s202:根据所述待识别图像,得到所述待识别图像的图像特征图。

45.在获取到待识别图像后,可以针对待识别图像提取待识别图像的图像特征图。可以理解的是,待识别图像的图像特征图为从待识别图像中所提取出的完整特征图,能够反映待识别图像的整体图像特征信息。

46.s203:根据所述图像特征图,确定全局特征信息和局部特征信息。

47.由于在复杂场景下,比如人脸的关键部位被遮挡,或者,由于身体姿势的不同(比如侧身),会导致不能采集到完整的人脸,进而导致无法识别人脸的表情类型或者识别人脸的表情类型不准确。为了解决上述问题,在本实施例中,获取到待识别图像的图像特征图后,可以根据所述图像特征图,确定所述图像特征图中目标人脸的全局特征信息和局部特征信息。其中,待识别图像的全局特征信息可以反映人脸的整体信息,即待识别图像的全局特征信息可以理解为目标人脸的全局信息,如肤色,轮廓,面部器官的分布等的整体信息;待识别图像的局部特征信息可以反映人脸各个区域的细节信息,即局部特征信息描述了目标人脸的细节特征,比如器官特点、面部奇异特征,类似伤疤、黑痣、酒窝等。可以理解的是,全局特征信息用于粗略匹配,局部特征信息用于精细匹配。因此,可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息。

48.s204:根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。

49.在本实施例中,在确定全局特征信息和局部特征信息后,可以利用全局特征信息和局部特征信息恢复更多的人脸表情的图像细节信息,从而可以利用恢复的人脸表情的图像细节信息,确定目标人脸的表情类型,这样,可以使得根据全局特征信息和局部特征信息所确定的待识别图像的表情类型更加准确,从而可以提高待检测图像对应的表情类型识别结果的精确度。

50.本公开实施例与现有技术相比存在的有益效果是:本公开实施例可以先获取待识别图像;然后,可以根据所述待识别图像,得到所述待识别图像的图像特征图;接着,可以根据所述图像特征图,确定全局特征信息和局部特征信息;最后,可以根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。由于待识别图像的全局特征信息反映人脸的整体信息,待识别图像的局部特征信息反映了人脸各个区域的细节信息,因此可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息,这样,根据所述全局特征信息和所述局部特征信息所确定的待识别图像的表情类型更加准确,即可以提高待检测图像对应的表情类型识别结果的精确度,进而提高了用户体验。也就是说,在识别表情类型的过程中,关注局部特征的同时,引入了全局特征的上下文信息,还可以显著提升识别性能。

51.接下来,将介绍s202“根据所述待识别图像,得到所述待识别图像的图像特征图”的一种实现方式。在本实施例中,图2对应的方法可以应用于表情识别模型(如图3所示),所述表情识别模型可以包括第一神经网络模型,s202“根据所述待识别图像,得到所述待识别图像的图像特征图”可以包括以下步骤:

52.将所述待识别图像输入第一神经网络模型,得到所述待识别图像的图像特征图。

53.其中,所述第一神经网络模型包括若干第一卷积模块,所述若干第一卷积模块依次连接,且每个第一卷积模块包括滤波器、批标准化层、mp模型和激活函数。例如,如图3所示,第一神经网络模型包括3个第一卷积模块,其中,每个第一卷积模块包括一个滤波器(比如为gc模块)、一个批标准化层(即bn层)、一个mp模型(即mp,max pooling)和一个激活函数(即relu)。

54.其中,gc模块为添加了gabor滤波器的卷积核,需要强调的是,本实施例中,gc模块可以称之为gof(即gabor滤波器在常规卷积核上调制出的gabor方向滤波器),gof可以增强网络对方向和尺度变化的鲁棒性(方向不变性和尺度不变性)。需要说明的是,gabor滤波器具有良好的特性,其不仅可以保持图像中的频域信息,而且对方向、尺寸等几何变换具有很强的鲁棒性,而现有的卷积神经网络不具有这种特性,因此gabor滤波器适合方向和尺寸频繁变化场景下的人脸表情识别,另一方面,人脸表情识别和其它人脸任务相比,更侧重于鼻子、嘴巴等局部特征,而gabor滤波器相比与传统卷积神经网络,可以提取到更加丰富的局部特征。可以理解的是,gc模块引入gabor滤波器后,一方面可以增强网络对方向和尺度变化的鲁棒性,另一方面减少了网络层数,因此减小了模型前向推理时间。

55.在本实施例中,gof的调制过程如下:

56.gabor滤波器具有u方向和v尺度,为了将可操纵属性合并到gcn中,方向信息会在学习的过滤器中进行编码,同时尺度信息会嵌入到不同的卷积层中。由于gof中gabor滤波器捕获了方向和尺度信息,因此相应的卷积功能得到了增强。

57.通过反向传播算法来学习的滤波器称为学习滤波器。与标准卷积神经网络不同,因为要对定向通道进行编码,所以gcn中学习到的滤波器是三维的。假设学习滤波器的大小为n

×w×

w,其中w

×

w为滤波器的大小,n表示通道。如果将传统cnn中每层的权重表示为c

out

×cin

×w×

w,则gcn表示为c

out

×cin

×n×w×

w,c

out

和c

in

分别表示输出和输入特征图的通道。为了在前向卷积过程中使特征图的通道数量保持一致,将n选择为u,即用于调制此学习滤波器的gabor滤波器的方向数。在给定尺度v的基础上,通过调制过程获得gof。对于第v维度,定义:

58.其中,ci,o是一个学习过滤器。g(u,v)代表一组具有不同方向和尺度的gabor滤波器,o是g(u,v)与每个2d滤波器之间的逐元素乘积运算,调制流程如上图4所示,然后将gof定义为:

[0059][0060]

在gof中,v的值随层数的增加而增加,这意味着gof中gabor滤波器的比例会根据层数而变化。在每个尺度上,gof的大小为u

×n×w×

w。但是由于给出了gabor滤波器,因此仅保存了n

×w×

w个学习滤波器,这说明可以通过这种调制获得增强的功能,而无需增加参数的数量。

[0061]

接下来,将介绍s203“根据所述图像特征图,确定全局特征信息和局部特征信息”的一种实现方式。在本实施例中,图2对应的方法可以应用于表情识别模型,如图3所示,所述表情识别模型包括local-global attention结构;如图5所示,local-global attention

结构包括全局模型、局部模型,s203“根据所述图像特征图,确定全局特征信息和局部特征信息”可以包括以下步骤:

[0062]

s203a:将所述图像特征图输入全局模型,得到全局特征信息。

[0063]

图5中的conv和feature层具体如图6所示,即所述全局模型包括第一卷积层、h-sigmoid激活函数层(即图6中的f)、通道注意力模块(channel attention module,cam,即图6中的channel attention)、空间注意力模块(spartial attention module,sam,即图6中的spatial attention)和第二卷积层。可以理解的是,通道注意力模块和空间注意力模块可以理解一个cbam注意力结构。

[0064]

具体地,可以将所述图像特征图输入所述第一卷积层,得到第一特征图。然后,可以将所述第一特征图输入所述h-sigmoid激活函数层,得到第二特征图,需要说明的是,h-sigmoid激活函数层可以避免指数运算,所以可以提高计算速度。接着,可以将所述第二特征图输入所述通道注意力模块,得到通道注意力图;需要说明的是,通道注意力模块的作用是为每个通道学习一个权重,然后将该权重乘到对应的通道,也就是将第二特征图中不同通道的特征分别与其对应的权重相乘,得到通道注意力图。紧接着,可以将所述通道注意力图输入到所述空间注意力模块,得到空间注意力图;空间注意力模块用于对通道注意力图在特征图空间上(即宽高维度)进行注意力计算,即通道注意力图中每个空间上的局部区域学习一个权重,然后将权重乘到通道注意力图上,得到空间注意力图。最后,可以将所述空间注意力图输入到所述第二卷积层,得到所述全局特征信息。

[0065]

s203b:将所述图像特征图输入局部模型,得到局部特征信息。

[0066]

在本实施例中,如图5所示,所述局部模型可以包括n个局部特征提取卷积层(即conv层和feature层,其中,k与n为同一个数值)、注意力模块,其中,n为大于1的正整数;

[0067]

在本实施例中,可以先根据所述图像特征图,生成n个局部图像块。例如,可以在图像特征图上进行随机裁剪,得到n个不相同的局部图像块,其中,每个局部图像块包含不同区域的局部信息。然后,可以分别将各个局部图像块输入各个局部特征提取卷积层,得到n个局部特征图,即每个局部特征提取卷积层均输出一个局部特征图。

[0068]

接着,可以将所述n个局部特征图输入所述注意力模块,得到局部特征信息。需要说明的是,在本实施例中,注意力模块可以为split-attention模块,split-attention模块如图7所示,所述注意力模块可以包括池化层(即图7中的global pooling)、第二卷积模块(即图7中的conv bn relu,也就是说第二卷积模块包括一卷积层、bn层和relu函数层)、n个第三卷积层(即图7中的conv层)和归一化层(即图7中的r-softmax层)。具体地,如图7所示,可以将所述n个局部特征图进行融合,得到融合特征图。将所述融合特征图输入所述池化层,得到池化特征图。将所述池化特征图输入所述第二卷积模块,得到处理局部特征图。将所述处理局部特征图分别输入各个第三卷积层,得到n个子局部特征图,即将处理局部特征图输入各个独立的第三卷积层处理,提取到各个子局部特征图。针对每个子局部特征图,将该子局部特征图输入归一化层,得到该子局部特征图对应的权重值,以及,根据该子局部特征图对应的权重值和局部特征图,得到该子局部特征图对应的局部特征图;也就是说,利用归一化层对该子局部特征图进行r-softmax运算,得到该子局部特征图对应的权重值,然后将该子局部特征图对应的局部特征图和该子局部特征图对应的权重值进行相乘,得到该子局部特征图对应的处理后的局部特征图。将n个局部特征图(即处理后的局部特征图)进行

融合,得到局部特征信息。

[0069]

接下来,将介绍s204“根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型”的一种实现方式。在本实施例中,s204可以包括以下步骤:

[0070]

s204a:将所述全局特征信息输入第一全局平均池化层,得到全局池化特征信息。

[0071]

在本实施例中,如图5所示,全局模型还连接有第一全局平均池化层(即图5中的gap层),提取到所述全局特征信息之后,可以通过第一全局平均池化层对所述全局特征信息进行全局平均池化(global average pooling,gap)处理,得到全局池化特征信息。

[0072]

s204b:将所述局部特征信息输入第二全局平均池化层,得到局部池化特征信息。

[0073]

在本实施例中,如图5所示,局部模型还连接有第二全局平均池化层(即图5中的gap层),提取到所述局部特征信息之后,可以通过第二全局平均池化层对所述局部特征信息进行全局平均池化(global average pooling,gap)处理,得到局部池化特征信息。

[0074]

s204c:将所述全局池化特征信息和所述局部池化特征信息输入全连接层,得到所述待识别图像的表情类型。

[0075]

在本实施例中,得到所述全局池化特征信息和所述局部池化特征信息后,可以先将所述全局池化特征信息和所述局部池化特征信息进行融合,得到融合后的池化特征信息。接着,将融合后的池化特征信息输入全连接层(即图3中的fc),得到全连接层输出的待识别图像的表情类型。

[0076]

需要说明的是,在本实施例的一种实现方式中,如图3所示,所述表情识别模型还可以包括权重层(即图3中的weight branch);如图8所示,所述权重层包括两个全连接层(即图8中的fc1和fc2)和一个sigmoid激活层(即图8中的sigmoid)。具体地,图2对应的方法还包括:

[0077]

步骤1:将所述全局池化特征信息和所述局部池化特征信息输入所述权重层,得到所述待识别图像的表情类型的真实权重值。

[0078]

其中,所述待识别图像的表情类型的真实权重值用于表征所述表情类型为所述待识别图像对应的真实表情类型的概率,在一种实现方式中,真实权重值可以为介于0-1之间的权重值。可以理解的是,所述待识别图像的表情类型的真实权重值越大,说明所述表情类型为所述待识别图像对应的真实表情类型的概率越大,反之,所述待识别图像的表情类型的真实权重值越小,说明所述表情类型为所述待识别图像对应的真实表情类型的概率越小。

[0079]

步骤2:根据所述待识别图像的表情类型的真实权重值和所述待识别图像的表情类型,确定所述待识别图像对应的表情类型检测结果。

[0080]

在本实施例中,若所述待识别图像的表情类型的真实权重值满足预设条件,例如待识别图像的表情类型的真实权重值大于预设阈值,则可以将所述待识别图像的表情类型作为所述待识别图像对应的表情类型检测结果。其中,所述预设阈值可以是预先设置,比如可以是用户根据实际需求所设置的。反之,若所述待识别图像的表情类型的真实权重值不满足预设条件,例如待识别图像的表情类型的真实权重值小于或等于预设阈值,则可以不将所述待识别图像的表情类型作为所述待识别图像对应的表情类型检测结果,而可以确定所述待识别图像对应的表情类型检测结果为无结果。

[0081]

需要说明的是,现有技术人脸表情识别数据集中存在标注不确定性问题,这种不

确定性一方面是由于标注者的主观性造成的,因此同一张图片通过不同的标注人员标注后会存在差异性,另一方面是由于人脸表情图片的二义性,即一张表情图片可能包含几种不同的表情,此外,遮挡、光照、图片质量问题等因素也可能影响标注结果。通过这些不确定标注的数据训练,不仅不利于学习有效表情特征,而且会使得网络训练初期出现不收敛的现象,因此本实施例中采用attention weighted loss的损失函数对权重层进行训练。具体地,首先在提取特征后,通过添加的一个权重分支(即权重层)为每个样本学习一个权重,这个权重代表了当前样本确定性的程度,然后在计算损失时,会将训练样本的损失按照计算出的权重进行加权计算。

[0082]

在模型训练过程中,如果权重层计算出的权重值小于预设训练值,则说明当前训练样本的确定性很低,因此其不利于网络的优化,所以可以通过人工设置的阈值来对这些样本进行过滤,而权重层计算出的权重值大于或等于预设训练值,且值越高,则说明对确定性要求越严格,会将一些介于确定和不确定之间的样本剔除掉;并且,权重值越低则表示参与损失贡献的样本越多,而且不使用低确定性(即权重层计算出的权重值小于预设训练值)的样本参与损失计算,可以显著提升人脸表情识别准确率。在对训练样本过滤后,可以得到所有样本的特征和其对应的权重,因此可以为每个样本计算交叉熵之后,通过这些权重进行加权求和,或者,采用另一种加权方式,即用计算出的权重和求取的样本特征进行加权,然后用加权后的特征进行进行损失计算。

[0083]

需要说明的是,情识别模型添加权重层(即添加了一个权重分支)后,通过该分支学习出每个样本的确定性,然后可以利用attention weighted loss,通过将学习出的不确定性引入该attention weighted loss,可以抑制不确定性标注对人脸表情识别训练过程的影响。

[0084]

上述所有可选技术方案,可以采用任意结合形成本公开的可选实施例,在此不再一一赘述。

[0085]

下述为本公开装置实施例,可以用于执行本公开方法实施例。对于本公开装置实施例中未披露的细节,请参照本公开方法实施例。

[0086]

图9是本公开实施例提供的表情识别装置的示意图。如图9所示,该表情识别装置包括:

[0087]

图像获取模块901,用于获取待识别图像;

[0088]

第一特征获取模块902,用于根据所述待识别图像,得到所述待识别图像的图像特征图;

[0089]

第二特征获取模块903,用于根据所述图像特征图,确定全局特征信息和局部特征信息;

[0090]

表情类型确定模块904,用于根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。

[0091]

在一些实施例中,所述方法应用于表情识别模型,所述表情识别模型包括第一神经网络模型;第一特征获取模块902,具体用于:

[0092]

将所述待识别图像输入第一神经网络模型,得到所述待识别图像的图像特征图;

[0093]

其中,所述第一神经网络模型包括若干第一卷积模块,所述若干第一卷积模块依次连接,且每个第一卷积模块包括滤波器、批标准化层、mp模型和激活函数。

[0094]

在一些实施例中,所述方法应用于表情识别模型,所述表情识别模型包括全局模型、局部模型;所述第二特征获取模块903,具体用于:

[0095]

将所述图像特征图输入全局模型,得到全局特征信息;

[0096]

将所述图像特征图输入局部模型,得到局部特征信息。

[0097]

在一些实施例中,所述全局模型包括第一卷积层、h-sigmoid激活函数层、通道注意力模块、空间注意力模块和第二卷积层;所述第二特征获取模块903,具体用于::

[0098]

将所述图像特征图输入所述第一卷积层,得到第一特征图;

[0099]

将所述第一特征图输入所述h-sigmoid激活函数层,得到第二特征图;

[0100]

将所述第二特征图输入所述通道注意力模块,得到通道注意力图;

[0101]

将所述通道注意力图输入到所述空间注意力模块,得到空间注意力图;

[0102]

将所述空间注意力图输入到所述第二卷积层,得到所述全局特征信息。

[0103]

在一些实施例中,所述局部模型包括n个局部特征提取卷积层、注意力模块,其中,n为大于1的正整数;所述第二特征获取模块903,具体用于::

[0104]

根据所述图像特征图,生成n个局部图像块;

[0105]

分别将各个局部图像块输入各个局部特征提取卷积层,得到n个局部特征图;

[0106]

将所述n个局部特征图输入所述注意力模块,得到局部特征信息。

[0107]

在一些实施例中,所述注意力模块包括池化层、第二卷积模块、n个第三卷积层和归一化层;所述第二特征获取模块903,具体用于:

[0108]

将所述n个局部特征图进行融合,得到融合特征图;

[0109]

将所述融合特征图输入所述池化层,得到池化特征图;

[0110]

将所述池化特征图输入所述第二卷积模块,得到处理局部特征图;

[0111]

将所述处理局部特征图分别输入各个第三卷积层,得到n个子局部特征图;

[0112]

针对每个子局部特征图,将该子局部特征图输入归一化层,得到该子局部特征图对应的权重值;根据该子局部特征图对应的权重值和局部特征图,得到该子局部特征图对应的局部特征图;

[0113]

将n个局部特征图进行融合,得到局部特征信息。

[0114]

在一些实施例中,所述表情类型确定模块904,用于:

[0115]

将所述全局特征信息输入第一全局平均池化层,得到全局池化特征信息;

[0116]

将所述局部特征信息输入第二全局平均池化层,得到局部池化特征信息;

[0117]

将所述全局池化特征信息和所述局部池化特征信息输入全连接层,得到所述待识别图像的表情类型。

[0118]

在一些实施例中,所述表情识别模型还包括权重层;所述权重层包括两个全连接层和一个sigmoid激活层;所述装置还包括结果确定模块,用于:

[0119]

将所述全局池化特征信息和所述局部池化特征信息输入所述权重层,得到所述待识别图像的表情类型的真实权重值;所述待识别图像的表情类型的真实权重值用于表征所述表情类型为所述待识别图像对应的真实表情类型的概率;

[0120]

根据所述待识别图像的表情类型的真实权重值和所述待识别图像的表情类型,确定所述待识别图像对应的表情类型检测结果。

[0121]

本公开实施例与现有技术相比存在的有益效果是:本公开实施例提供的表情识别

装置包括:图像获取模块901,用于获取待识别图像;第一特征获取模块902,用于根据所述待识别图像,得到所述待识别图像的图像特征图;第二特征获取模块903,用于根据所述图像特征图,确定全局特征信息和局部特征信息;表情类型确定模块904,用于根据所述全局特征信息和所述局部特征信息,确定所述待识别图像的表情类型。由于待识别图像的全局特征信息反映人脸的整体信息,待识别图像的局部特征信息反映了人脸各个区域的细节信息,因此可以通过局部特征信息和全局特征信息有效的结合,恢复更多的人脸表情的图像细节信息,这样,根据所述全局特征信息和所述局部特征信息所确定的待识别图像的表情类型更加准确,即可以提高待检测图像对应的表情类型识别结果的精确度,进而提高了用户体验。

[0122]

应理解,上述实施例中各步骤的序号的大小并不意味着执行顺序的先后,各过程的执行顺序应以其功能和内在逻辑确定,而不应对本公开实施例的实施过程构成任何限定。

[0123]

图10是本公开实施例提供的计算机设备10的示意图。如图10所示,该实施例的计算机设备10包括:处理器1001、存储器1002以及存储在该存储器1002中并且可以在处理器1001上运行的计算机程序1003。处理器1001执行计算机程序1003时实现上述各个方法实施例中的步骤。或者,处理器1001执行计算机程序1003时实现上述各装置实施例中各模块/模块的功能。

[0124]

示例性地,计算机程序1003可以被分割成一个或多个模块/模块,一个或多个模块/模块被存储在存储器1002中,并由处理器1001执行,以完成本公开。一个或多个模块/模块可以是能够完成特定功能的一系列计算机程序指令段,该指令段用于描述计算机程序1003在计算机设备10中的执行过程。

[0125]

计算机设备10可以是桌上型计算机、笔记本、掌上电脑及云端服务器等计算机设备。计算机设备10可以包括但不仅限于处理器1001和存储器1002。本领域技术人员可以理解,图10仅仅是计算机设备10的示例,并不构成对计算机设备10的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件,例如,计算机设备还可以包括输入输出设备、网络接入设备、总线等。

[0126]

处理器1001可以是中央处理模块(central processing unit,cpu),也可以是其它通用处理器、数字信号处理器(digital signal processor,dsp)、专用集成电路(application specific integrated circuit,asic)、现场可编程门阵列(field-programmable gate array,fpga)或者其它可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件等。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。

[0127]

存储器1002可以是计算机设备10的内部存储模块,例如,计算机设备10的硬盘或内存。存储器1002也可以是计算机设备10的外部存储设备,例如,计算机设备10上配备的插接式硬盘,智能存储卡(smart media card,smc),安全数字(secure digital,sd)卡,闪存卡(flash card)等。进一步地,存储器1002还可以既包括计算机设备10的内部存储模块也包括外部存储设备。存储器1002用于存储计算机程序以及计算机设备所需的其它程序和数据。存储器1002还可以用于暂时地存储已经输出或者将要输出的数据。

[0128]

所属领域的技术人员可以清楚地了解到,为了描述的方便和简洁,仅以上述各功

能模块、模块的划分进行举例说明,实际应用中,可以根据需要而将上述功能分配由不同的功能模块、模块完成,即将装置的内部结构划分成不同的功能模块或模块,以完成以上描述的全部或者部分功能。实施例中的各功能模块、模块可以集成在一个处理模块中,也可以是各个模块单独物理存在,也可以两个或两个以上模块集成在一个模块中,上述集成的模块既可以采用硬件的形式实现,也可以采用软件功能模块的形式实现。另外,各功能模块、模块的具体名称也只是为了便于相互区分,并不用于限制本公开的保护范围。上述系统中模块、模块的具体工作过程,可以参考前述方法实施例中的对应过程,在此不再赘述。

[0129]

在上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详述或记载的部分,可以参见其它实施例的相关描述。

[0130]

本领域普通技术人员可以意识到,结合本文中所公开的实施例描述的各示例的模块及算法步骤,能够以电子硬件、或者计算机软件和电子硬件的结合来实现。这些功能究竟以硬件还是软件方式来执行,取决于技术方案的特定应用和设计约束条件。专业技术人员可以对每个特定的应用来使用不同方法来实现所描述的功能,但是这种实现不应认为超出本公开的范围。

[0131]

在本公开所提供的实施例中,应该理解到,所揭露的装置/计算机设备和方法,可以通过其它的方式实现。例如,以上所描述的装置/计算机设备实施例仅仅是示意性的,例如,模块或模块的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,多个模块或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。另一点,所显示或讨论的相互之间的耦合或直接耦合或通讯连接可以是通过一些接口,装置或模块的间接耦合或通讯连接,可以是电性,机械或其它的形式。

[0132]

作为分离部件说明的模块可以是或者也可以不是物理上分开的,作为模块显示的部件可以是或者也可以不是物理模块,即可以位于一个地方,或者也可以分布到多个网络模块上。可以根据实际的需要选择其中的部分或者全部模块来实现本实施例方案的目的。

[0133]

另外,在本公开各个实施例中的各功能模块可以集成在一个处理模块中,也可以是各个模块单独物理存在,也可以两个或两个以上模块集成在一个模块中。上述集成的模块既可以采用硬件的形式实现,也可以采用软件功能模块的形式实现。

[0134]

集成的模块/模块如果以软件功能模块的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读存储介质中。基于这样的理解,本公开实现上述实施例方法中的全部或部分流程,也可以通过计算机程序来指令相关的硬件来完成,计算机程序可以存储在计算机可读存储介质中,该计算机程序在被处理器执行时,可以实现上述各个方法实施例的步骤。计算机程序可以包括计算机程序代码,计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。计算机可读介质可以包括:能够携带计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(read-only memory,rom)、随机存取存储器(random access memory,ram)、电载波信号、电信信号以及软件分发介质等。需要说明的是,计算机可读介质包含的内容可以根据司法管辖区内立法和专利实践的要求进行适当的增减,例如,在某些司法管辖区,根据立法和专利实践,计算机可读介质不包括电载波信号和电信信号。

[0135]

以上实施例仅用以说明本公开的技术方案,而非对其限制;尽管参照前述实施例对本公开进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施

例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本公开各实施例技术方案的精神和范围,均应包含在本公开的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。