1.本发明涉及车辆识别领域,具体涉及一种基于多传感器数据融合的车辆识别方法。

背景技术:

2.近年来,高速公路实现了基于路侧门架的交通感知、监控设备的逐步全程覆盖,尽管目前基于视频的车辆检测算法成熟且成本较低,但是,视频采集的2d数据对远处的物体测距、测速、定位误差较大,同时对大雾、暴雨、夜间等恶劣天气也较为敏感,也即是无法有效地识别车辆外型轮廓。

3.而单一地基于3d激光雷达点云的车辆检测虽然能覆盖多车道,实现车辆3d轮廓高度精确的测量和车型识别分类,但其采集频率较低,短时间的数据吞吐量有限。因此,为解决上述问题,亟需一种有效的车辆识别方法。

技术实现要素:

4.有鉴于此,本发明的目的是克服现有技术中的缺陷,提供基于多传感器数据融合的车辆识别方法,能够提升在灰尘、雾霾以及光照条件等外界恶劣环境下的车辆识别鲁棒性,并能为整个交通流的车型识别提供更加丰富的目标物空间信息。

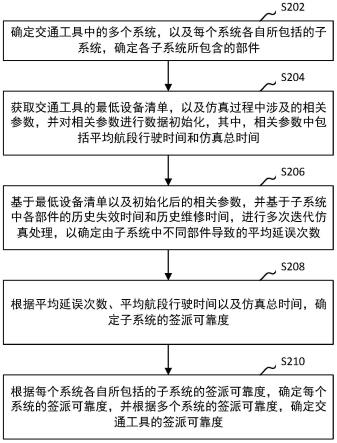

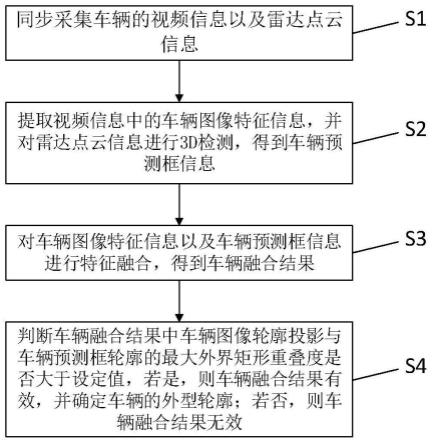

5.本发明的基于多传感器数据融合的车辆识别方法,包括如下步骤:

6.s1.同步采集车辆的视频信息以及雷达点云信息;

7.s2.提取视频信息中的车辆图像特征信息,并对雷达点云信息进行3d检测,得到车辆预测框信息;

8.s3.对车辆图像特征信息以及车辆预测框信息进行特征融合,得到车辆融合结果;

9.s4.判断车辆融合结果中车辆图像轮廓投影与车辆预测框轮廓的最大外界矩形重叠度是否大于设定值,若是,则车辆融合结果有效,并确定车辆的外型轮廓;若否,则车辆融合结果无效。

10.进一步,所述同步包括时间同步以及空间同步;

11.所述时间同步,具体包括:在采集车辆的雷达点云信息并接收雷达信号的同时,采集并接收车辆的视频信息;

12.所述空间同步,具体包括:在车辆所在的世界坐标系中,标定雷达与相机的坐标位置,获得雷达与相机的相对位置;其中,所述雷达用于采集雷达点云信息,所述相机用于采集视频信息。

13.进一步,提取视频信息中的车辆图像特征信息,具体包括:

14.构建改进的yolov5网络:在输入算法块之前,将输入的底层特征映射划分为第一部分以及第二部分;所述第一部分通过一个带权重的直连映射后进行连接处理,所述第二部分通过算法块进行推理计算;通过跨级层次结构将第一部分的处理结果与第二部分的计算结果拼接合并,得到网络输出结果;

15.将视频信息中的车辆图像输入到改进的yolov5网络中,输出车辆图像的多尺度目标检测结果。

16.进一步,对雷达点云信息进行3d检测,得到车辆预测框信息,具体包括:

17.对雷达点云信息的前景与背景进行分割,再将所有前景车辆目标点云进行自底向上的bin运算处理,得到3d预测框;

18.将3d预测框进行标准坐标细化处理,得到精细化的预测框信息,并将精细化的预测框信息作为车辆预测框信息。

19.进一步,利用前景点云分割器对雷达点云信息的前景与背景进行分割,具体包括:

20.基于k近邻的反向距离加权的平均进行插值,再将插值特征通过跨层联接进行特征堆叠,堆叠后的特征再输入到uint pointnet中进行进一步提取;

21.重复以上步骤,最后经过n*n的卷积运算得到分割预测结果。

22.进一步,对车辆图像特征信息以及车辆预测框信息进行特征融合,具体包括:将车辆预测框信息中车辆轮廓和位置根据标定好的参数,计算投影到车辆图像特征信息中车辆轮廓结果对应的某个点。

23.进一步,所述步骤s4,还包括:判定危化品车辆轮廓的检测精度:

24.对危化品车辆轮廓进行归一化处理,并将危化品车辆轮廓通过等比例放缩后,与标准的车辆轮廓进行比较,得到标准化的危化品车辆轮廓;

25.计算标准化的危化品车辆轮廓与真实车辆外观轮廓的重合度,并根据重合度判定危化品车辆轮廓的检测精度。

26.本发明的有益效果是:本发明公开的一种基于多传感器数据融合的车辆识别方法,基于高清图像、雷达等多源数据融合技术和深度神经网络算法,将多源异质异构数据进行自适应对齐同步和特征关联,实现数据流的智能管道归一化,并训练了特种运输车识别增强模型,增强了识别的鲁棒性,解决了传统视频监测方案在低视见环境下识别率不高、监测范围小的问题。本发明能够提升在灰尘、雾霾以及光照条件等外界恶劣环境下的车辆识别鲁棒性,并能为整个交通流的车型识别提供更加丰富的目标物空间信息。

附图说明

27.下面结合附图和实施例对本发明作进一步描述:

28.图1为本发明的方法流程示意图;

29.图2为本发明的数据融合配准示意图;

30.图3为本发明的跨阶段网络结构图;

31.图4为本发明的图像检测算法网络结构图;

32.图5为本发明的前景点云分割器原理示意图。

具体实施方式

33.以下结合说明书附图对本发明做出进一步的说明,如图所示:

34.本发明的基于多传感器数据融合的车辆识别方法,包括如下步骤:

35.s1.同步采集车辆的视频信息以及雷达点云信息;

36.s2.提取视频信息中的车辆图像特征信息,并对雷达点云信息进行3d检测,得到车

辆预测框信息;

37.s3.对车辆图像特征信息以及车辆预测框信息进行特征融合,得到车辆融合结果;

38.s4.判断车辆融合结果中车辆图像轮廓投影与车辆预测框轮廓的最大外界矩形重叠度是否大于设定值,若是,则车辆融合结果有效,并确定车辆的外型轮廓;若否,则车辆融合结果无效。其中,所述设定值可根据实际工况进行设置;若车辆的融合结果有效,则只需要将车辆的融合结果与现有的车辆外型轮廓数据库中的外型轮廓数据信息进行比对,即可确定目标车辆的外型轮廓。若车辆融合结果无效,则无法对车辆外型轮廓进行识别,可重新执行步骤s1-s4。

39.本实施例中,在同步采集车辆的视频信息以及雷达点云信息之前,需要对采集设备进行校正,所述采集设备包括雷达以及相机,所述雷达采用激光雷达,所述相机采用rgb-d相机;对采集设备进行校正,具体包括:用张正友标定法快速标定相机内参矩阵k,将内参作为已知量,采用aruco标志实现rgb-d相机和lidar(激光雷达)安装参数的标定。

40.同步采集车辆的视频信息以及雷达点云信息中所述同步包括时间同步以及空间同步;

41.由于激光雷达和相机的采样频率不同,各自提取有效目标的消耗时间不同,送入融合系统中心的数据可能是不同时刻的信息,这就会导致后期的融合结果出现较大的偏差,则有必要进行时间同步处理。

42.所述时间同步,具体包括:在采集车辆的雷达点云信息并接收雷达信号的同时,采集并接收车辆的视频信息;也即是,将雷达获取有效目标序列和相机获取有效目标序列作为两个子线程,而将后期的融合过程作为主线程,在接收雷达信号的同时触发相机接收数据帧线程,从而保证传感器在时间上的同步。

43.为了更好地实现同步采集,在保证时间同步的基础上,还要进行空间同步处理。

44.所述空间同步,具体包括:在车辆所在的世界坐标系中,标定雷达与相机的坐标位置,获得雷达与相机的相对位置;其中,所述雷达用于采集雷达点云信息,所述相机用于采集视频信息。实现空间配准后,可根据雷达与相机的相对位置关系进一步推导雷达点云信息与视频信息的融合关系,如图2所示。

45.本实施例中,通过对现有的yolov5网络进行改进,使得改进后的yolov5网络能更加准确地输出多尺度目标检测结果,并降低了误检率。

46.提取视频信息中的车辆图像特征信息,具体包括:

47.将现有yolov5网络的主干进行改造,来构建改进的yolov5网络:在输入算法块之前,将输入的底层特征映射划分为第一部分以及第二部分;所述第一部分通过一个带权重的直连映射后进行连接处理,所述第二部分通过算法块进行推理计算;通过跨级层次结构将第一部分的处理结果与第二部分的计算结果拼接合并,得到网络输出结果;也即是:运用上述思想的一阶检测网络由部分算法块和部分连接层组成。如图3所示,将通过基础网络得到的特征图分成两个部分,可由式(1)表示:

48.x0=[x

’0,x”0

]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0049]

其中,x”0

经过第二部分算法块的推理得到x

t

,x

’0直接与第二部分算法块输出结果x

t

进行连接融合得到网络输出结果xu,其网络计算推理可由式(2)(3)(4)表示:

[0050]

[0051][0052][0053]

其中,xk表示检测算法块内部的计算推理,w表示各层网络的权重值。

[0054]

通过上述步骤,得到改进的yolov5网络,如图4所示,将视频信息中的车辆图像输入到改进的yolov5网络中,输出车辆图像的多尺度目标检测结果。

[0055]

本实施例中,使用point-rcnn算法对雷达点云信息进行3d检测,得到车辆预测框信息。所述point-rcnn算法在保证相对准确的识别率基础上能很好地控制了网络的复杂度,符合既定要求,并且能鲁棒地运行。

[0056]

point-rcnn算法采用的三维检测网络模型包括以自底向上的方式从原始点云中生成3d预测框的网络a以及以标准坐标细化3d预测结果的网络b。

[0057]

将雷达点云信息输入至上述三维检测网络模型中,网络a中先利用前景点云分割器实现前景与背景分割,再将所有前景车辆目标点云进行自底向上的bin运算处理,得到3d预测框,所述3d预测框可用于后期精细化3d预测框以及融合;

[0058]

将3d预测框输入至网络b进行标准坐标细化处理,得到精细化的预测框信息,并将精细化的预测框信息作为车辆预测框信息。

[0059]

本实施例中,利用前景点云分割器对雷达点云信息的前景与背景进行分割,其中,所述前景点云分割器的分割原理如图5所示,前景点云分割器中采样层、分组层和单一pointnet组成来预设搜索区域,以此可以进行点云的区域分割任务;具体的分割过程为:

[0060]

基于k近邻的反向距离加权的平均进行插值,再将插值特征通过跨层联接进行特征堆叠,堆叠后的特征再输入到uint pointnet中进行进一步提取;

[0061]

重复以上步骤,最后经过1*1的卷积运算得到分割预测结果。

[0062]

本实施例中,对车辆图像特征信息以及车辆预测框信息进行特征融合,具体包括:将车辆预测框信息中车辆轮廓和位置根据标定好的参数,计算投影到车辆图像特征信息中车辆轮廓结果对应的某个点。其中,所述标定好的参数根据上述aruco标志实现的标定设置进行确定;通过上述操作,使得雷达检测到的车辆轮廓和位置与相机检测到的车辆轮廓能够一一对应,利用识别车辆的外型轮廓。

[0063]

本实施例中,步骤s4中,由于远、近场景中危化品车的轮廓所占的像素大小相差很大,会导致危化品车的车辆轮廓识别检测精度下降,则可以通过如下方法判定危化品车辆轮廓的检测精度:

[0064]

对危化品车辆轮廓进行归一化处理,并将危化品车辆轮廓通过等比例放缩后,与标准的车辆轮廓进行比较,得到标准化的危化品车辆轮廓;

[0065]

计算标准化的危化品车辆轮廓与真实车辆外观轮廓的重合度,并根据重合度判定危化品车辆轮廓的检测精度。通过对危化品车辆轮廓的检测精度进行判定,可以根据判定结果来评估车辆外型轮廓识别的准确性,从而提高了车辆识别的可靠性。

[0066]

最后说明的是,以上实施例仅用以说明本发明的技术方案而非限制,尽管参照较佳实施例对本发明进行了详细说明,本领域的普通技术人员应当理解,可以对本发明的技术方案进行修改或者等同替换,而不脱离本发明技术方案的宗旨和范围,其均应涵盖在本发明的权利要求范围当中。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。