1.本发明涉及视频目标跟踪技术领域,更具体地涉及一种基于语言建模式孪生网络的目标跟踪方法。

背景技术:

2.目标跟踪技术在民用和国防领域都具有广泛的应用价值,对机器人、飞行器、无人驾驶、安防等领域的发展有重要意义。例如,在安防领域中,摄像头对视场内的行人进行跟踪,并经过一系列的后续智能算法分析处理,使监控系统对人体姿态、动作、行为意图有更好的感知和理解,从而实现智能、及时和高效的监控。自动跟随是指通过在初始化画面中选取跟踪的目标,然后对跟踪目标进行跟踪并根据目标所在的位置调整自身的姿态以及和目标的距离,从而保证跟踪目标有较好的成像。

3.当前的跟踪算法可分为两大类:一类基于传统机器学习算法,如相关滤波、支持向量机等机器学习算法,这一类算法主要依靠在线的训练分类器来区分目标与背景,然后利用分类器从候选区域定位到目标。第二类基于深度学习算法,如卷积神经网络、孪生神经网络等,此类算法首先在大规模的数据集上进行离线训练,然后再对目标进行跟踪。从目前各类算法在测试数据集上的表现来看,深度学习类跟踪算法依托强大的特征表示能力,在跟踪精度上远远超过了传统的跟踪算法。

4.由于目标跟踪是计算机视觉当中的一个基础子领域,需要和更多的视觉处理算法结合起来才能具有更好的应用价值,如人体姿态估计、行人重识别和动作识别等。而当前跟踪算法都仅限于为后续算法提供矩形框,扩展性较差,通常仅能接入一些特定的智能系统。并且,当前跟踪算法需要向算法中融入大量精心设计和高度任务定制化的专家经验知识,实现过程较为繁杂。

技术实现要素:

5.为解决上述现有技术中的问题,本发明提供一种基于语言建模式孪生网络的目标跟踪方法,能够接入更一般的智能系统,并且不需要向算法中融入专家经验知识,实现过程简单方便。

6.本发明提供的一种基于语言建模式孪生网络的目标跟踪方法,包括:

7.步骤s1,获取包含目标连续运动的视频,并根据所述视频制作训练数据集;

8.步骤s2,根据所述训练数据集,训练孪生神经网络;

9.步骤s3,保持所述孪生神经网络的参数不变,训练目标位置提取网络;

10.步骤s4,对训练后的孪生神经网络和训练后的目标位置提取网络再进行联合训练,得到语言建模式孪生网络;

11.步骤s5,获取所述待跟踪目标的实时图像,利用所述语言建模式孪生网络对所述待跟踪目标进行实时跟踪。

12.进一步地,所述步骤s1中制作训练数据集包括:

13.步骤s11,将包含目标连续运动的视频分帧为图像序列,标注出目标在每个图像中的边界框。

14.进一步地,所述步骤s2中训练孪生神经网络包括:

15.步骤s21,从图像序列中随机挑选两帧,从其中一帧获取模板图片输入至孪生神经网络的模板分支,所述模板分支输出模板特征图;从另一帧获取候选区域图片输入至孪生神经网络的候选分支,所述候选分支输出候选特征图;

16.步骤s22,对所述模板特征图和所述候选特征图进行卷积运算,并输出编码结果图;

17.步骤s23:根据编码结果图确定损失函数,利用损失函数训练孪生神经网络。

18.进一步地,所述步骤s3中训练目标位置提取网络包括:

19.步骤s31,将所述步骤s22获取的卷积结果展开成向量形式,输入至目标位置提取网络的特征维度压缩子网络,得到压缩结果向量;

20.步骤s32,将所述压缩向量输入至目标位置提取网络的transformer解码器,得到待跟踪目标的预测坐标,根据待跟踪目标的预测坐标和待跟踪目标的实际坐标计算损失,并用梯度反向传播算法训练目标位置提取网络。

21.进一步地,所述步骤s5中对待跟踪目标进行实时跟踪包括:

22.步骤s51,初始化i=2;

23.步骤s52,获取待跟踪目标在第i-1帧图像中的边界框,提取出待跟踪目标在第i-1帧图像中的模板图片;将待跟踪目标在第i-1帧图像中的模板图片输入至语言建模式孪生网络中孪生神经网络的模板分支,得到第i-1帧模板特征图;

24.步骤s53,以待跟踪目标在第i-1帧图像中的位置为中心,从第i帧图像中切取一个大小为255

×

255像素的图片作为第i帧候选区域图片;

25.步骤s54,将第i帧候选区域图片输入至语言建模式孪生网络中孪生神经网络的候选分支,得到第i帧候选特征图;

26.步骤s55,对第i帧候选特征图与第i-1帧模板特征图进行卷积运算,将卷积运算得到的特征图展开成向量,然后将其送入语言建模式孪生网络中的目标位置提取网络,得到第i帧跟踪到的目标框;

27.步骤s56,从第i帧跟踪到的目标框中提取出第i帧目标图片,并根据第i帧目标图片获取第i帧预测出的目标位置特征图;

28.步骤s57,根据第i-1帧模板特征图以及第i帧预测出的目标特征图,获取第i帧的模板特征图;

29.步骤s58,根据待跟踪目标的实时图像,判断第i帧是否为待跟踪目标的最后一帧图像,若是,则结束流程;若否,则令i=i 1,重复步骤s53-步骤s57。

30.本发明将目标跟踪问题建模成基于像素输入的语言建模问题,有效融合了图像与语言序列方法来对特定目标进行跟踪。与传统的基于纯视觉的目标跟踪方法相比,本发明不需要向算法中融入专家经验知识,实现过程更为简单方便。此外,本发明的扩展性很强,其离散语言序列式输出可作为语言接口,接入更一般的智能系统。

附图说明

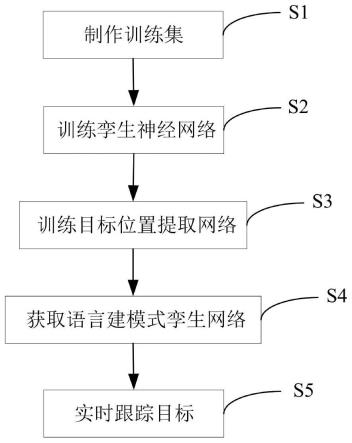

31.图1是按照本发明的一种基于语言建模式孪生网络的目标跟踪方法的流程图。

具体实施方式

32.下面结合附图,给出本发明的较佳实施例,并予以详细描述。

33.由于人类对环境的深层次广范围感知和分析强依赖于自然语言,本发明利用自然语言中的处理方法来解决计算机视觉中的跟踪问题,提供了一种基于语言建模式孪生网络的目标跟踪方法,如图1所示,该方法包括以下步骤:

34.步骤s1,获取包含目标连续运动的视频,并根据包含目标连续运动的视频制作训练数据集。

35.具体地,制作训练数据集的方法包括:

36.步骤s11,将包含目标连续运动的视频分帧为图像序列,标注出待跟踪目标在每个图像中的边界框。根据标注出的边界框,可获取边界框的中心点、长度以及宽度。

37.步骤s12,根据待跟踪目标在每个图像中的边界框,获取模板图片和候选区域图片。其中,模板图片为边界框内的区域的图片。候选区域图片的获取方法为:以边界框的中心点随机偏移后的位置作为目标的中心,围绕目标的中心外扩出一个255

×

255像素的方形区域,该方形区域即为候选区域,该方形区域内的图片即为候选区域图片。

38.步骤s13,根据候选区域图片,构建词表,词表存储待跟踪目标的实际坐标。词表大小根据候选区域的大小确定,因而该词表大小为255

×

255,即词表存储65025个坐标,坐标包括边界框左上角点和右下角点位置。构建的词表,在后续监督训练中,将目标位置提取网络的预测结果和用词表标注的真值输入损失函数计算损失,从而用梯度反向传播算法更新网络参数,在后续的实时跟踪过程中,预测结果也是使用词表当中的词表示。本发明以像素级的精度确定目标在候选区域图片中的位置,保证图像精度的同时,也保证了定位精度。

39.步骤s2,根据制作的训练数据集,训练孪生神经网络。

40.具体地,训练孪生神经网络包括以下步骤:

41.步骤s21,从步骤s11的图像序列中随机挑选两帧,从其中一帧获取模板图片输入至孪生神经网络的模板分支,模板分支输出模板特征图;从另一帧获取候选区域图片输入至孪生神经网络的候选分支,候选分支输出候选特征图。

42.步骤s22,对模板特征图和候选特征图进行卷积运算,获取卷积结果,并输出编码结果图。编码结果图对应待跟踪目标的特征图,特征图中的值反应待跟踪目标在当前位置的可能性,特征图的值越大表示目标在当前位置的可能性越大。

43.步骤s23:根据编码结果图和标注结果训练损失函数,利用梯度反向传播算法训练孪生神经网络。

44.需要说明的是,训练孪生神经网络时,使用以待跟踪目标中心为均值的高斯标签作为真实标签。用于训练孪生神经网络的损失函数如下式所示:

[0045][0046]

式中,n表示编码结果图d的元素个数,u表示编码结果图d的元素位置,y∈{1,0}表示真实标签,v表示编码结果图中的实际值,log表示以2为低的逻辑斯蒂函数。

[0047]

步骤s3,保持孪生神经网络的参数不变,训练目标位置提取网络。

[0048]

孪生神经网络的参数包括滤波器参数和偏置项,在训练目标位置提取网络的过程中,将这两项参数设置成不可训练状态。目标位置提取网络包括特征维度压缩子网络和transformer解码器,训练目标位置提取网络包括以下步骤:

[0049]

步骤s31,将步骤s22获取的卷积特征图展开成向量,输入至特征维度压缩子网络,得到压缩结果向量。特征维度压缩子网络由两个全连接层组成,用于压缩卷积结果的维度,减少后续网络的计算量。

[0050]

步骤s32,将压缩结果向量输入至transformer解码器,transformer解码器输出最终的预测结果,预测结果包括待跟踪目标的预测坐标(左上角点坐标和右下角点坐标)。随后,根据待跟踪目标的预测坐标和待跟踪目标的实际坐标计算损失,并用梯度反向传播算法训练目标位置提取网络

[0051]

用于训练目标位置提取网络的损失函数如下式所示:

[0052][0053]

式中,ωj表示词表中第j个坐标的权重,l表示目标的图像序列包括的坐标总数,x表示编码结果向量(即卷积特征图展开成的向量),表示第j个预测的坐标,yj表示目标在图像序列中的第j个坐标。在本实施例中,所有坐标的权重相等。在其他实施例中,也可根据坐标的位置设置其权重。

[0054]

步骤s4,对训练后的孪生神经网络和训练后的目标位置提取网络再进行联合训练,得到语言建模式孪生网络。

[0055]

具体地,以多任务的形式联合训练整个网络,其中以中继监督的方式训练孪生神经网络的卷积输出,其标签以及损失函数与步骤s2保持一致。

[0056]

用于训练语言建模式孪生网络的损失函数如下式所示:

[0057]

loss=λ1loss1 λ2loss2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0058]

其中,λ1、λ2分别表示两个损失函数在总损失函数中所占的比例。

[0059]

步骤s5,获取待跟踪目标的实时图像,利用语言建模式孪生网络对待跟踪目标进行实时跟踪。

[0060]

具体地,对待跟踪目标进行实时跟踪包括以下步骤:

[0061]

步骤s51,初始化i=2。

[0062]

步骤s52,获取待跟踪目标在第i-1帧图像中的边界框,提取出待跟踪目标在第i-1帧图像中的模板图片;将待跟踪目标在第i-1帧图像中的模板图片输入至语言建模式孪生网络中孪生神经网络的模板分支,得到第i-1帧模板特征图。

[0063]

步骤s53,以待跟踪目标在第i-1帧图像中的位置为中心,从第i帧图像中切取一个大小为255

×

255像素的图片作为第i帧候选区域图片。

[0064]

步骤s54,将第i帧候选区域图片输入至语言建模式孪生网络中孪生神经网络的候选分支,得到第i帧候选特征图。

[0065]

步骤s55,对第i帧候选特征图与第i-1帧模板特征图进行卷积运算,将卷积运算得到的特征图展开成向量,输入至语言建模式孪生网络中的目标位置提取网络,得到第i帧跟踪到的目标框。根据目标框,可得到目标框的中心位置、长度以及宽度。

[0066]

步骤s56,从第i帧跟踪到的目标框中提取出第i帧目标图片,并将第i帧目标图片输入孪生网络的模板分支获取第i帧的目标特征图。

[0067]

步骤s57,根据第i-1帧模板特征图以及第i帧的目标特征图,获取第i帧模板特征图。

[0068]

获取第i帧的模板特征图可用下式表达:

[0069]fi

=ωf

i-1

(1-ω)fi[0070]

式中,fi表示第i帧的模板特征图,fi表示第i帧预测出的目标特征图,ω∈[0 1]表示第i-1帧的模板特征图在第i帧的模板特征图中所占的比例。

[0071]

步骤s58,根据待跟踪目标的实时图像,判断第i帧是否为待跟踪目标的最后一帧图像,若是,则结束流程;若否,则令i=i 1,重复步骤s53-步骤s57。

[0072]

本发明将目标跟踪问题建模成基于像素输入的语言建模问题,有效融合了图像与语言序列方法来对特定目标进行跟踪。与传统的基于纯视觉的目标跟踪方法相比,本发明不需要向算法中融入专家经验知识,更易于使用语言工具对跟踪目标进行分析,实现过程更为简单方便。此外,本发明的扩展性很强,其离散语言序列式输出可作为语言接口来接入更一般的智能系统,更易于后续模型借助语言工具对跟踪目标进行分析。

[0073]

以上所述的,仅为本发明的较佳实施例,并非用以限定本发明的范围,本发明的上述实施例还可以做出各种变化。即凡是依据本发明申请的权利要求书及说明书内容所作的简单、等效变化与修饰,皆落入本发明专利的权利要求保护范围。本发明未详尽描述的均为常规技术内容。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。