1.本发明属于图像超分辨率领域,涉及一种基于线扫描的图像超分辨率方法,适用于各种资源受限的图像超分应用场景。

背景技术:

2.图像超分辨率重建(super-resolution,sr)是指从观测到的同一场景的单幅或者多幅低分辨率(low resolution,lr)图像中,通过相应的算法恢复一个高分辨率(high resolution,hr)图像的过程。该技术已经广泛应用在医疗诊断、遥感探测、计算机视觉以及军事侦察等各个领域

[1,2]

。

[0003]

传统的图像超分辨率方法包括插值方法和基于学习的方法。最早使用的插值方法

[3]

只能利用低分辨率图像自身的像素信息对周围下像素进行插值实现高分辨率图像重构,难以得到满意的结果。为了缓解这一问题,基于实例学习的方法

[4-7]

通过尽可能挖掘lr与hr图像块对之间的映射关系,并将其作为先验知识重构更高质量的高分辨率图像。近年来,基于深度学习的方法

[8-11]

成为研究热点,并取得了一些优秀成果,但由于输入图像中所包含的目标真实信息有限,单纯基于软件算法的重建方法仍难以实现复杂图像的重构。

[0004]

近年来,基于空间光调制器件实现图像或场景的光路复用技术

[12]

为超分辨率成像问题带来新的思路。通过控制调制器件实现逐像素扫描方法能够最直接获取目标的全部高像素信息,但为了避免点扩撒函数的混叠,图像采集时间较长。为了加快成像速度,压缩感知技术被应用于这个课题

[13-14]

。但上述方法仍然存在两个限制:(1)由于光复用过程中是基于单个像素水平的信息采集,对成像传感器的光照灵敏度要求较高;(2)受限于传感器的填充系数无法达到100%,重建结果会产生不可避免的不均匀性噪声。

技术实现要素:

[0005]

本发明针对现有技术的不足,利用基于目标线空间信息的光路复用技术,在正交方向上采集多幅包含目标不同信息的低分辨率图像,并进一步将其进行融合与重建,从而实现从目标低分辨率图像实现高分辨率图像重建的方法。

[0006]

基于线扫描的图像超分辨率方法是利用一种基于线的光多路复用技术来设计一种新的成像框架,在正交方向上分别采集包含不同空间信息的低分辨率图像。并进一步提出一种基于全变分和低秩约束的联合重建算法对两个方向的重建结果进行融合。如何实现数据的快速采集和高质量结果重建,以及如何有效解决像素混叠和结果的不均匀性是基于线扫描的图像超分辨率方法的关键问题。

[0007]

本发明所采用的技术方案是:一种基于线扫描的图像超分辨率方法,首先将白光作为照明光源,目标表面反射光通过物镜汇聚到空间光调制器工作液晶面上,利用高分辨率空间光调制器对目标分别进行行方向和列方向扫描,将扫描后的图像再次成像在低分辨率图像传感器上,通过合成多幅包含不同行列信息的低分辨率图像分别得到行列两个方向的超分辨结果。最后我们提出一种基于全局和低秩约束的重建算法将两个方向的结果进行

融合重建,得到最终的高分辨率重建图像。其系统原理图如附图1所示。该方法包括以下步骤:

[0008]

步骤1:搭建光学系统。将白光光源打在目标物上,使目标的反射光经过物镜会聚在空间光调制器表面,经空间光调制后的物体高分辨率线扫描信息经过成像透镜成像在图像探测器光敏面上。根据分辨率增强的倍数设置空间光调制器的工作像素大小以及相应图像探测器成像区域像素大小。

[0009]

步骤2:对空间光调制器和探测器进行工作频率同步匹配。

[0010]

步骤3:空间光调制器在水平和垂直方向设置合适的线扫描间隔分别对投影的目标信息进行扫描,用图像探测器获取每次扫描图像,从而在正交方向上得到目标一系列低分辨率图像。

[0011]

步骤4:将步骤3中得到的系列低分辨率图像分别在水平和垂直方向上进行对应像素位置的拼接融合后得到两个方向上的图像超分结果。

[0012]

步骤5:提出一种基于全局和低秩约束的联合重建方法,对步骤4中得到的正交方向上的超分结果进行融合重建,同时解决因为像素扫描带来的线状条纹噪声的问题,从而得到最终的高分辨率重建图像。

[0013]

进一步的,步骤1的具体实现包括以下子步骤:

[0014]

步骤1.1,将白光光源照射到探测目标的表面,目标表面反射光经焦距为f 的双胶合透镜会聚在空间光调制器液晶工作面上。

[0015]

步骤1.2,旋转空间光调制器前后两个偏振片,使其偏振方向为正交方向,从而使空间光调制器调制效果最佳。

[0016]

步骤1.3,在空间光调制器中输入像素大小为m

×

n的全通矩阵,使其与目标信息相作用后通过一组变焦镜头成像在ccd光敏面上。进一步调整镜头焦距使ccd成像区域像素大小为m

×

n,要求分辨率增强倍数sr为空间光调制器与 ccd成像区域像素之比,即:

[0017][0018]

进一步的,为了能够同步空间光调制器的调制与ccd的图像采集,在步骤 2中我们设置空间光调制器图像翻转频率fs与ccd图像采集频率fz相同。

[0019]

进一步的,步骤3的具体实现包括以下子步骤:

[0020]

步骤3.1,在计算机上设计需要的线扫描调制矩阵,在水平方向上,设置扫描间隔为t(t≥sr),此时需要t个调制矩阵,第p个调制矩阵为:

[0021][0022]

其中,r

(i,j)

表示在水平方向扫描时,第p个调制矩阵r;m,n表示空间光调制器输入调制矩阵大小为m行n列。

[0023]

同理,在垂直方向上,在相同的扫描间隔下同样需要t个调制矩阵,第p个调制矩阵为:

[0024][0025]

其中,c

(i,j)

表示在水平方向扫描时,第p个调制矩阵c;

[0026]

步骤3.2,合理调整扫描间隔t,使其尽量小的同时,ccd获取的线扫描信息之间无混叠。

[0027]

步骤3.3,空间光调制器按顺序播放上述线扫描调制矩阵,相应的ccd同步获取每次经调制后的目标图像,此时我们将分别在水平和垂直方向获得t幅低分辨率图像和其中m

×

n表示ccd成像分辨率,即获取的低分辨率图像的分辨率,u,v分别表示在水平方向获得的第u幅低分辨率图像和在垂直方向获得的第v幅低分辨率图像。

[0028]

进一步的,步骤4中,分别将步骤3中ccd获取的水平和垂直方向多幅低分辨率扫描图像中的线条纹信息进行提取和拼接融合。融合后我们得到水平方向重建结果和垂直方向重建结果

[0029]

进一步的,步骤5的具体实现包括以下子步骤:

[0030]

步骤5.1,我们定义目标结果为变量f,变量y为含有线条纹噪声的f,其中y包含两个内容:目标结果f以及线条纹噪声b。步骤4中的重建结果mr和mc被认为是y的下采样版本。我们将联合重建问题描述为:

[0031][0032]

其中ψr和ψc为下采样算子,为frobenius范数,‖

·

‖

tv

为tv范数,‖

·

‖

*

为核范数,α,λ,ρ为相关参数。

[0033]

步骤5.2,通过解决关于变量y,f,和b的三个子问题得到最终目标重建结果f。

[0034]

关于y的子问题被描述为:

[0035][0036]

其中,t表示迭代次数,我们采用快速收缩阈值算法

[15]

对ψr和ψc进行分离并进一步解决这个问题。

[0037]

关于f的子问题被描述为:

[0038][0039]

这个结果可以直接由增广的拉格朗日方法

[16]

导出。

[0040]

关于b的子问题被描述为:

[0041][0042]

可以利用软阈值方法

[17]

解决这个问题。

[0043]

通过解决以上问题我们可以得到最终的重建高分辨率结果f。

[0044]

与现有技术相比,本发明的优点和有益效果如下:本发明考虑利用一种基于线扫描的光多路复用技术,提出一种新的成像框架。在正交方向上分别采集包含目标不同空间信息的低分辨率图像,并提出一种联合重建算法对两个方向上的重建结果进行融合,实现了图像的超分辨成像,并有效解决了扫描成像过程中由于 ccd像素响应的不均匀性产生的条纹噪声,显著提高了图像重建质量。

附图说明

[0045]

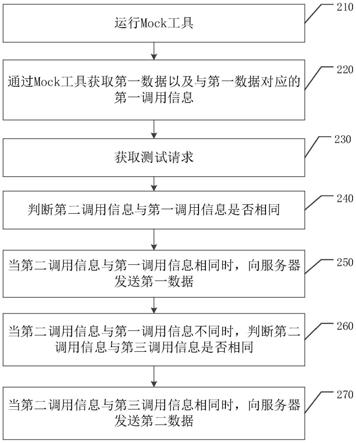

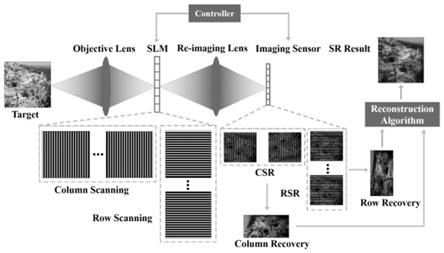

图1是基于线扫描的图像超分辨率方法系统原理图。

[0046]

图2为实施例的测量系统装置图。

[0047]

图3是扫描调制矩阵示例图。

[0048]

图4是调制后ccd采集图像示例图。

[0049]

图5是两个方向上超分辨率重建结果图。

[0050]

图6是初始低分辨率图与最终联合重建结果图。

[0051]

图7是不同线采样间隔图像4倍超分辨率结果对比图。

具体实施方式

[0052]

为了便于本领域普通技术人员理解和实施本发明,下面结合附图及实施例对本发明做进一步的详细描述,应当理解的是,此处所描述的实施例仅用于解释本发明,并不用于限定本发明。

[0053]

本发明主要针对图像超分辨率的应用需求。用低分辨率探测器多次采集投影在空间光调制器上的高分辨率目标信息,通过多幅低分辨率图像的融合实现正交方向的图像超分辨率重建。最后利用一种联合重建方法融合两个方向上的重建结果得到最终的高分辨率图像。

[0054]

附图2为实施例的测量系统装置图。系统主要由物镜,空间光调制器,偏振片,成像镜头和ccd探测器组成。

[0055]

步骤1:搭建光学系统。将白光光源打在目标物上,使目标的反射光经过物镜会聚在空间光调制器表面,经空间光调制后的物体高分辨率线扫描信息经过成像透镜成像在图像探测器光敏面上。根据分辨率增强的倍数设置空间光调制器的工作像素大小以及相应图像探测器成像区域像素大小。具体实现包括以下子步骤:

[0056]

步骤1.1,将白光光源照射到探测目标的表面,目标表面反射光经焦距为 f=200mm的双胶合透镜会聚在空间光调制器液晶工作面上。

[0057]

步骤1.2,旋转空间光调制器前后两个偏振片,使其偏振方向为正交方向,从而使空间光调制器调制效果最佳。

[0058]

步骤1.3,在空间光调制器中输入像素大小为m

×

n(m=n=512)的全通矩阵,使其与目标信息相作用后通过一组变焦镜头成像在ccd光敏面上。进一步调整镜头焦距使ccd成像区域像素大小为m

×

n(m=n=64),要求分辨率增强倍数sr为空间光调制器与ccd成像区域像素之比,即:

[0059][0060]

步骤2:对空间光调制器和探测器进行工作频率同步匹配,为了采样频率尽可能大,我们设置空间光调制器的调制频率和相机采集频率均为60hz。

[0061]

步骤3:空间光调制器在水平和垂直方向设置合适的线扫描间隔分别对投影的目标信息进行扫描,用图像探测器获取每次扫描图像,从而在正交方向上得到目标一系列低分辨率图像。具体实现包括以下子步骤:

[0062]

步骤3.1,在计算机上设计需要的线扫描调制矩阵,在水平方向上,设置扫描间隔

为t(t≥sr),此时需要t个调制矩阵,第p个调制矩阵为:

[0063][0064]

其中,r

(i,j)

表示在水平方向扫描时,第p个调制矩阵r;m,n表示空间光调制器输入调制矩阵大小为m行n列;

[0065]

同理,在垂直方向上,在相同的扫描间隔下同样需要t个调制矩阵,第p个调制矩阵为:

[0066][0067]

其中,c

(i,j)

表示在水平方向扫描时,第p个调制矩阵c;调制矩阵示例如附图3 所示。

[0068]

步骤3.2,合理调整扫描间隔t,在此实例中我们设置t=32,使得ccd获取的线扫描信息之间间隔清晰无混叠。

[0069]

步骤3.3,空间光调制器按顺序播放上述线扫描调制矩阵,相应的ccd同步获取每次经调制后的目标图像,此时我们将分别在水平和垂直方向获得t=32幅低分辨率图像和其中m

×

n表示 ccd成像分辨率,即获取的低分辨率图像的分辨率,u,v分别表示在水平方向获得的第u幅低分辨率图像和在垂直方向获得的第v幅低分辨率图像,图像示例如附图4所示。

[0070]

步骤4:分别将步骤三中ccd获取的水平和垂直方向t=32幅低分辨率扫描图像中的线条纹信息进行提取和拼接融合。融合后我们得到水平方向重建结果和垂直方向重建结果此步骤结果如附图5所示。

[0071]

步骤5:提出一种基于全局和低秩约束的联合重建方法,对步骤4中得到的正交方向上的超分结果进行融合重建,同时解决因为像素扫描带来的线状条纹噪声的问题,从而得到最终的高分辨率重建图像。具体实现包括以下子步骤:

[0072]

步骤5.1,我们定义目标结果为变量f,变量y为含有线条纹噪声的f,其中y包含两个内容:目标结果f以及线条纹噪声b。步骤4中的重建结果mr和mc被认为是y的下采样版本。我们将联合重建问题描述为:

[0073][0074]

其中ψr和ψc为下采样算子,为frobenius范数,‖

·

‖

tv

为tv范数,‖

·

‖

*

为核范数,α,λ,ρ为相关参数。

[0075]

步骤5.2,通过解决关于变量y,f,和b的三个子问题得到最终目标重建结果f。

[0076]

关于y的子问题被描述为:

[0077][0078]

我们采用快速收缩阈值算法

[15]

对ψr和ψc进行分离并进一步解决这个问题。

[0079]

关于f的子问题被描述为:

inf.fusion79,188-199(2022).

[0095]

[3]q.wangandr.k.ward,“aneworientation-adaptiveinterpolationmethod,”ieeetransactionsonimageprocess.16,889-900(2007).

[0096]

[4]h.chang,d.-y.yeung,andy.xiong,“super-resolutionthroughneighborembedding,”inproc.ieeeconf.comput.vis.pattemrecognit.,(2004).

[0097]

[5]j.yang,j.wright,t.s.huang,andy.ma,“imagesuper-resolutionviasparserepresentation,”ieeetransactiousonimageprocess.19,2861-2873(2010).

[0098]

[6]m.bevilacqua,a.roumy,c.guillemot,andm.-l.alberi-morel,“lowcomplexitysingleimagesuper-resolutionbasedonnonnegativeneighborembedding,”inproc.brit.mach.vis.conf.,(2012).

[0099]

[7]j.jiang,x.ma,c.chen,t.lu,z.wang,andj.ma,“singleimagesuper-resolutionvialocallyregularizedanchoredneighborhoodregressionandnonlocalmeans,”ieeetransactionsonmultimed.19,15-26(2016).

[0100]

[8]p.yi,z.wang,k.jiang,j.jiang,t.lu,andj.ma,“aprogressivefusiongenerativeadversarialnetworkforrealisticandconsistentvideosuper-resolution,”ieeetransactionsonpatternanalysismach.intell.(2020).

[0101]

[9]m.haris,g.shakhnarovich,andn.ukita,“deepback-projectionnetworksforsuper-resolution,”inproc.ieeeconf.comput.vis.patternrecognit.,(2018),pp.1664-1673.

[0102]

[10]k.zhang,l.v.gool,andr.timofte,“deepunfoldingnetworkforimagesuper-resolution,”inproc.ieeeconf.comput.vis.patternrecognit.,(2020),pp.3217-3226.

[0103]

[11]d.ulyanov,a.vedaldi,andv.lempitsky,“deepimageprior,”inproc.ieeeconf.comput.vis.patternrecognit.,(2018),pp.9446-9454.

[0104]

[12]h.chen,m.salmanasif,a.c.sankaranarayanan,anda.veeraraghavan,“fpa-cs:focalplanearray-basedcompressiveimaginginshortwaveinfrared,”inproc.ieeeconf.comput.vis.patternrecognit.,(2015),pp.2358-2366.

[0105]

[13]f.li,h.chen,a.pediredla,c.yeh,k.he,a.veeraraghavan,ando.cossairt,“cs-tof:high-resolutioncompressivetime-of-flflightimaging,”opt.express25,31096-31110(2017).

[0106]

[14]q.sun,x.dun,y.peng,andw.heidrich,“depthandtransientimagingwithcompressivespadarraycameras.”inproc.ieeeconf.comput.vis.patternrecognit.,(2018),pp.273-282.

[0107]

[15]a.beckandm.teboulle,siamj.onimagingsci.2,183(2009).

[0108]

[16]s.h.chan,r.khoshabeh,k.b.gibson,p.e.gill,andt.q.nguyen,ieeetransactiousonimageprocess.20,3097(2011).

[0109]

[17]j.-f.cai,e.j.cand

è

s,andz.shen,siamj.onoptim.20,1956(2010)。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。