protocol for leo satellite network》in 2020chinese automation congress,p.zha,c.long,j.wu and s.li,提出一种以相邻节点到目的地的距离为参考因素的适用于低轨卫星网络的gpsr方法。《a traffic-light-based intelligent routing strategy for ngeo satellite ip networks[j]》song g,chao m,yang b,et al.受交通灯启发,提出了tlr(traffic-light based intelligent routing strategy,交通灯智能路由策略)方法,方法将下一节点的网络拥塞状态用红、黄、绿颜色描述,以便动态的调整数据流的走向。

[0005]

对于针对于低轨卫星网络的中心式负载均衡路由算法,虽然该类型方法通过掌握低轨卫星网络全局的信息进行中继卫星节点的选择,但该类型方法更新缓慢,很难适用于具有节点快速移动、网络环境急速变化特点的低轨卫星网络。

[0006]

对于低轨卫星网络的分布式负载均衡路由算法来说,该类型方法一般需要依靠局部卫星节点通过信息交互获知周边卫星节点的负载状态,作为参考进行卫星路由节点的选择。此类型方法存在两个缺点:一是所掌握的局部信息类型一般比较片面,例如仅获取节点负载状态、通信能力等信息,很难做出更优的路由决策;二是该类型方法一般依靠一定的阈值设置进行卫星节点状态的判定,而阈值的设置具有局限性,若阈值设定不当,方法很难适用于实际的低轨卫星网络。

[0007]

因此,如何提升低轨卫星网络在高负载情况下的运行可靠性,是现有技术亟需解决的。

技术实现要素:

[0008]

本发明针对现有技术如何提升低轨卫星网络在高负载情况下的运行可靠性的问题,提出了本发明。

[0009]

为解决上述技术问题,本发明提供如下技术方案:

[0010]

一方面,本发明提供了一种低轨卫星网络负载均衡的路由方法,该方法由低轨卫星网络负载均衡的路由系统实现,该系统包括多个卫星节点以及目标节点;多个卫星节点包括当前卫星节点以及相邻卫星节点;该方法包括:

[0011]

s1、当前卫星节点通过通信交互的方式获取相邻卫星节点的节点信息;节点信息包括相邻卫星节点的间隔、空间位置、排队延迟、可用频率资源以及信道的信噪比。

[0012]

s2、当前卫星节点根据自身状态、相邻卫星节点的节点信息以及训练完毕的深度q网络dqn模型,得到所选的下一跳的相邻卫星节点。

[0013]

s3、当前卫星节点将待传输数据转发给所选的相邻卫星节点。

[0014]

s4、将所选的相邻卫星节点视为新的当前卫星节点,重复上述s1-s3,直到目标节点接收到数据。

[0015]

可选地,s2中的dqn模型的训练过程包括:

[0016]

s21、设计dqn模型的参数;参数包括状态、动作、奖励以及网络。

[0017]

s22、设计dqn模型的优化目标;优化目标为最小化损失函数loss。

[0018]

s23、获取大量拓扑快照,根据拓扑快照对dqn模型的参数进行更新,得到训练完毕的dqn模型。

[0019]

可选地,s2中的dqn模型的训练过程还包括:

[0020]

采用结构相同但参数不同的q网络和目标网络,对dqn模型的动作参数进行训练。

[0021]

可选地,s2中的dqn模型的训练过程还包括:

[0022]

在每次训练后记录所选传输路径的总奖励,如果当前网络的总奖励是先前网络的奖励中的最高奖励,则将主网络的参数复制到目标网络。

[0023]

可选地,s21中的状态如下式(1)所示:

[0024][0025]

其中,表示t时刻当前节点i的状态;ηi={η

i,j

}表示当前节点i周围链路的信噪比向量,j=1,2

…

j为当前节点i的周围卫星节点的索引;bi={b

i,j

},j=1,2

…

j表示周围链路的可用带宽;ti={t

i,j

},j=1,2

…

j表示周围节点的排队延迟;di={d

i,j

},j=1,2

…

j表示当前节点与下一跳节点之间的距离;ξi={ξ

i,j

},j=1,2

…

j表示周围卫星节点j与目的节点之间的距离;χi表示当前节点要传输的数据量;表示相邻节点的可用缓存空间;fi的值描述为

[0026]

可选地,s21中的动作如下式(2)所示:

[0027]

a={node

i1

,node

i2

,

…

,node

in

,

…

,node

in

} (2)

[0028]

其中,node

in

∈{0,1}表示卫星节点的下一跳是否为卫星节点n;n为卫星节点个数。

[0029]

可选地,s21中的奖励如下式(3)所示:

[0030]

r=-(μ1t

i,j

′

μ2ξ

i,j

′

μ3β

i,j-μ4h)(1-f

i,j

) (3)

[0031]

其中,μ1为与归一化延迟相关的权重参数;μ2为与距目的节点的距离相关的权重参数;μ3为与丢包率相关的权重参数;μ4为与跳数相关的权重参数;μ1 μ2 μ3 μ4=1;t

i,j

为归一化后卫星节点i与卫星节点j之间的总延迟;ξ

i,j

′

为归一化后周围卫星节点j与目的节点之间的距离;β

i,j

表示数据包丢失的过程;h表示跳数相关的奖励。

[0032]

可选地,s21中的网络采用八层残差网络resnet;

[0033]

网络还包括adam优化器和relu激活函数。

[0034]

可选地,s22中的最小化损失函数loss如下式(4)所示:

[0035][0036]

其中,r为奖励;γ∈(0,1)为折扣率;q(s',a')为状态为s'、动作为a'的状态-动作值函数;s'为新状态;a'为新动作;q(s,a)为状态为s、动作为a的状态-动作值函数;s为状态;a为动作。

[0037]

另一方面,本发明提供了一种低轨卫星网络负载均衡的路由系统,该系统应用于实现低轨卫星网络负载均衡的路由方法,该系统包括多个卫星节点以及目标节点;多个卫星节点包括当前卫星节点以及相邻卫星节点;其中:

[0038]

多个卫星节点,用于当前卫星节点通过通信交互的方式获取相邻卫星节点的节点信息;节点信息包括相邻卫星节点的间隔、空间位置、排队延迟、可用频率资源以及信道的信噪比;当前卫星节点根据自身状态、相邻卫星节点的节点信息以及训练完毕的深度q网络dqn模型,得到所选的下一跳的相邻卫星节点;当前节点将待传输数据转发给所选的相邻卫星节点;将所选的相邻卫星节点视为新的当前卫星节点,重复上述步骤,直到目标节点接收到数据。

[0039]

目标节点,用于接收待传输数据。

[0040]

可选地,s2中的dqn模型的训练过程包括:

[0041]

s21、设计dqn模型的参数;参数包括状态、动作、奖励以及网络。

[0042]

s22、设计dqn模型的优化目标;优化目标为最小化损失函数loss。

[0043]

s23、获取大量拓扑快照,根据拓扑快照对dqn模型的参数进行更新,得到训练完毕的dqn模型。

[0044]

可选地,多个卫星节点,进一步用于:

[0045]

采用结构相同但参数不同的q网络和目标网络,对dqn模型的动作参数进行训练。

[0046]

可选地,多个卫星节点,进一步用于:

[0047]

在每次训练后记录所选传输路径的总奖励,如果当前网络的总奖励是先前网络的奖励中的最高奖励,则将主网络的参数复制到目标网络。

[0048]

可选地,s21中的状态如下式(1)所示:

[0049][0050]

其中,表示t时刻当前节点i的状态;ηi={η

i,j

}表示当前节点i周围链路的信噪比向量,j=1,2

…

j为当前节点i的周围卫星节点的索引;bi={b

i,j

},j=1,2

…

j表示周围链路的可用带宽;ti={t

i,j

},j=1,2

…

j表示周围节点的排队延迟;di={d

i,j

},j=1,2

…

j表示当前节点与下一跳节点之间的距离;ξi={ξ

i,j

},j=1,2

…

j表示周围卫星节点j与目的节点之间的距离;χi表示当前节点要传输的数据量;表示相邻节点的可用缓存空间;fi的值描述为

[0051]

可选地,s21中的动作如下式(2)所示:

[0052]

a={node

i1

,node

i2

,

…

,node

in

,

…

,node

in

} (2)

[0053]

其中,node

in

∈{0,1}表示卫星节点的下一跳是否为卫星节点n;n为卫星节点个数。

[0054]

可选地,s21中的奖励如下式(3)所示:

[0055]

r=-(μ1t

i,j

′

μ2ξ

i,j

′

μ3β

i,j-μ4h)(1-f

i,j

) (3)

[0056]

其中,μ1为与归一化延迟相关的权重参数;μ2为与距目的节点的距离相关的权重参数;μ3为与丢包率相关的权重参数;μ4为与跳数相关的权重参数;μ1 μ2 μ3 μ4=1;t

i,j

为归一化后卫星节点i与卫星节点j之间的总延迟;ξ

i,j

′

为归一化后周围卫星节点j与目的节点之间的距离;β

i,j

表示数据包丢失的过程;h表示跳数相关的奖励。

[0057]

可选地,s21中的网络采用八层残差网络resnet;

[0058]

网络还包括adam优化器和relu激活函数。

[0059]

可选地,s22中的最小化损失函数loss如下式(4)所示:

[0060][0061]

其中,r为奖励;γ∈(0,1)为折扣率;q(s',a')为状态为s'、动作为a'的状态-动作值函数;s'为新状态;a'为新动作;q(s,a)为状态为s、动作为a的状态-动作值函数;s为状态;a为动作。

[0062]

本发明实施例提供的技术方案带来的有益效果至少包括:

[0063]

上述方案中,环境自适应能力强,本专利基于人工智能手段实现低轨卫星网络场景下的负载均衡路由,相比于常用的依靠对部分参数手工设定门限的路由方法,所提方法能够通过与环境的交互掌握节点的选择规律,依靠奖励的引导做出有利于性能提升的决策。

[0064]

数据回传延迟更低,数据回传的延迟情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传延迟的路由方式,仿真上也证明了这一点。

[0065]

传输丢包率更低,数据传输的丢包情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传数据丢包率的路由方式,仿真上也证明了这一点。

[0066]

更适用于低轨卫星网络,相比于中心式路由方法,本专利所提方法不需要对全局信息进行定期更新,前者的更新操作存在巨大的延迟,限制了在具备高动态特性的低轨卫星网络上的应用,相比于常见的分布式路由方法,所提方法仅需要一跳卫星节点的状态情况,对信息量的要求相对较低,因而更能适用于状态变化迅速的低轨卫星网络。

附图说明

[0067]

为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0068]

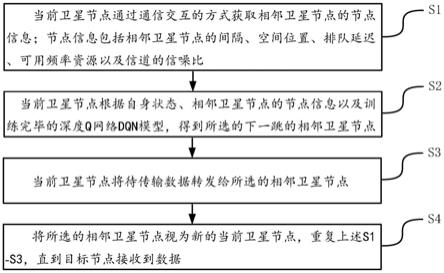

图1是本发明实施例提供的低轨卫星网络负载均衡的路由方法流程示意图;

[0069]

图2是本发明实施例提供的智能路由模型示意图;

[0070]

图3是本发明实施例提供的存在2mbit/5mbit/8mbit/10mbit待发送数据时所提方法的收敛过程示意图;

[0071]

图4是本发明实施例提供的不同路由方法的延迟性能对比图;

[0072]

图5是本发明实施例提供的不同路由方法的丢包率性能对比图;

[0073]

图6是本发明实施例提供的多个随机卫星拓扑快照的延迟性能情况示意图;

[0074]

图7是本发明实施例提供的多个随机卫星拓扑快照的丢包率性能情况示意图;

[0075]

图8是本发明实施例提供的低轨卫星网络负载均衡的路由系统框图。

具体实施方式

[0076]

为使本发明要解决的技术问题、技术方案和优点更加清楚,下面将结合附图及具体实施例进行详细描述。

[0077]

如图1所示,本发明实施例提供了一种低轨卫星网络负载均衡的路由方法,该方法可以由低轨卫星网络负载均衡的路由系统实现。如图1所示的低轨卫星网络负载均衡的路由方法流程图,该方法的处理流程可以包括如下的步骤:

[0078]

s1、当前卫星节点通过通信交互的方式获取相邻卫星节点的节点信息;节点信息包括相邻卫星节点的间隔、空间位置、排队延迟、可用频率资源以及信道的信噪比。

[0079]

一种可行的实施方式中,如图2所示,与铱星系统类似,本专利每个卫星节点通常有四个isl(inter-switch link,星间链路),即两个轨道内的isl和两个轨道间的isl。当卫

星进入高纬度区域或处于反向接缝位置时,其部分isl将相应关闭。此外,还假设每个卫星或每个isl都有不同的可用资源,如存储空间、排队延迟、可用带宽等,由于卫星星座建设时间长,每个卫星节点的能力和激活时间不同,每个轨道的业务量也可能不同。

[0080]

进一步地,当前卫星节点通过通信交互获取相邻节点的间隔(对于轨道间isl来说是可变的)、空间位置、排队延迟、可用频率资源、信道的snr(signal-to-noise ratio,信噪比)以及其他相关信息。

[0081]

s2、当前卫星节点根据自身状态、相邻卫星节点的节点信息以及训练完毕的深度q网络dqn模型,得到所选的下一跳的相邻卫星节点。

[0082]

一种可行的实施方式中,利用训练完毕的dqn(deep q network,深度q网络)模型,当前卫星节点根据前一步获取的信息和自身状态获取映射输出。

[0083]

与传统的集中式路由方法一般依靠地面站根据卫星运动规律进行综合规划不同,本专利对分布式路由进行了探索和验证。具体来说,假设卫星星座中的每个节点都可以通过交互获取邻居节点的状态,基于此,当前节点可以选择下一跳路由节点。可以预见,这种方法可以显著减少路由决策的广播延迟,并且可以很好地适应卫星网络的动态,即使决策可能不是全局最优的。

[0084]

可选地,s2中的dqn模型的训练过程包括:

[0085]

s21、设计dqn模型的参数;参数包括状态、动作、奖励以及网络。

[0086]

一种可行的实施方式中,在强化学习过程中,智能体和环境在一系列离散时间内相互作用,完成一个任务。强化学习的过程可使用mdp(markov decision process,马尔可夫决策过程)进行建模,一般使用五元组<s,a,p,r,γ>进行描述,其中s代表状态空间,a代表动作空间,p为状态转移概率,p(s'|s,a)表示在状态s下采取动作a随后环境状态转移到s'的概率,r为奖励函数,γ∈[0,1]为折扣率,r表明了智能体的当前动作是好动作还是坏动作。强化学习智能体的策略使用π表示,智能体根据策略π选择动作。

[0087]

其中,智能体与环境交互过程包括以下几个过程:在t时刻,智能体观察环境的状态s

t

∈s,智能体根据策略π(s

t

)选择动作a

t

,动作a

t

作用于环境,随后环境状态转变为s

t 1

,此时环境会给予智能体相应的奖励r

t

,之后智能体会依据新的环境状态和策略做出新的决策,该交互过程不断重复,直至智能体完成相应的目标任务。强化学习智能体的目标即为最大化累计奖励的期望e(∑γ

trt

),其中,γ∈(0,1)是折扣率,当γ接近0时,智能体更注重短期回报;当γ接近1时,长期回报变得更重要。

[0088]

q学习是强化学习典型算法之一。q学习是指在策略π,环境状态s下采取动作a时,智能体学习期望累积报酬的动作值函数q

π

(s,a),如下式(1)所示:

[0089][0090]

最佳动作值函数由贝尔曼最优方程可知下式(2):

[0091][0092]

其中,s'是状态动作对(s,a)之后的新状态。q学习背后的主要思想是迭代地估计每个状态-动作对(s,a)出现时的q

*

(s,a)。设q(s,a)为迭代过程中的动作值函数,根据状态-动作对(s

t

,a

t

)和奖励r

t 1

,q学习更新q(s

t

,a

t

)的过程如下式(3)所示:

[0093][0094]

其中,β∈(0,1]是学习速率。

[0095]

q学习在更新q(s,a)的同时,也会根据q(s,a)进行动作决策。为避免局部收敛,智能体会以一定概率随机选择动作,这种方式称为ε-贪婪策略,即下式(5):

[0096][0097]

其中,随机选择一个动作是为了避免陷入尚未收敛到q

*

(s,a)的q(s,a)函数中。

[0098]

可选地,s21中的状态如下式(6)所示:

[0099][0100]

其中,表示t时刻当前节点i的状态;ηi={η

i,j

}表示当前节点i周围链路的信噪比向量,j=1,2

…

j为当前节点i的周围卫星节点的索引;bi={b

i,j

},j=1,2

…

j表示周围链路的可用带宽;ti={t

i,j

},j=1,2

…

j表示周围节点的排队延迟;di={d

i,j

},j=1,2

…

j表示当前节点与下一跳节点之间的距离;ξi={ξ

i,j

},j=1,2

…

j表示周围卫星节点j与目的节点之间的距离;χi表示当前节点要传输的数据量;表示相邻节点的可用缓存空间;fi的值描述为

[0101]

一种可行的实施方式中,虽然仅依赖当前卫星节点周围的一跳卫星来确定其路由策略,但可以注意到,链路的许多状态可能会影响路由的性能。具体而言,应考虑信噪比、可用频率、链路间距以及下一跳节点的排队延迟、缓存空间等。因此,设置时间t当前卫星节点的状态为其中ηi={η

i,j

}表示周围链路的snr向量,j=1,2

…

j代表当前节点周围卫星节点的索引,且有:

[0102][0103]

其中,g

i,j

(t)表示当前节点i和下一跳节点j之间的星间链路的平均信道增益,p

i,j

(t)表示当前节点i和节点j的传输功率,表示节点j处高斯白噪声的方差。考虑到不同链路的可用频谱资源可能不同,状态中采用bi={b

i,j

},j=1,2

…

j来表示周围链路的可用带宽。ti={t

i,j

},j=1,2

…

j和di={d

i,j

},j=1,2

…

j分别表示周围节点的排队延迟以及当前节点与下一跳节点之间的距离。继而,节点间链路的传播延迟可以计算为d

i,j

/c,其中c代表光的传输速度。同时还采用ξi={ξ

i,j

},j=1,2

…

j来表示周围卫星节点j与目的节点之间的距离,因为在路由算法中应该考虑距离因素。考虑到卫星的分布具有一定的规律性,卫星之间的通信是基于星间链路的,本专利利用曼哈顿距离来计算ξi。此外,χi记录了当前节点要传输的数据量。表示相邻节点的可用缓存空间,fi={f

i,j

},j=1,2

…

j表示节点j是否为目标节点。

[0104]

可选地,s21中的动作如下式(7)所示:

[0105]

a={node

i1

,node

i2

,

…

,node

in

,

…

,node

in

} (7)

[0106]

其中,node

in

∈{0,1}表示卫星节点的下一跳是否为卫星节点n;n为卫星节点个数。

[0107]

一种可行的实施方式中,考虑到方法的目标是为当前卫星找到下一跳路由节点,设置动作为a={node

i1

,node

i2

,

…

,node

in

,

…

,node

in

},其中node

in

∈{0,1}表征路由节点的下一跳是否为节点n。

[0108]

可选地,s21中的奖励如下式(8)所示:

[0109]

r=-(μ1t

i,j

′

μ2ξ

i,j

′

μ3β

i,j-μ4h)(1-f

i,j

)

ꢀꢀꢀꢀ

(8)

[0110]

其中,μ1为与归一化延迟相关的权重参数;μ2为与距目的节点的距离相关的权重参数;μ3为与丢包率相关的权重参数;μ4为与跳数相关的权重参数;μ1 μ2 μ3 μ4=1;t

i,j

为归一化后卫星节点i与卫星节点j之间的总延迟;ξ

i,j

′

为归一化后周围卫星节点j与目的节点之间的距离;β

i,j

表示数据包丢失的过程;h表示跳数相关的奖励。

[0111]

一种可行的实施方式中,本专利提出的dqn-lbr(load balancing route,负载均衡的路由器)算法的目标是在保持低丢包率的同时减少传输延迟。在这种情况下,目标可能会受到所考虑状态中参数的影响。具体而言,节点i和节点j之间所选链路的容量可以用香农公式表示,即为下式(9):

[0112]vi,j

=b

i,j

log2(1 η

i,j

) (9)

[0113]

然后,这两个节点之间的总延迟可以描述为下式(10):

[0114][0115]

其中方程右侧的三项分别为传输延迟、排队延迟和传播延迟。此外,数据包丢失的过程可以描述为下式(11):

[0116][0117]

考虑到跳数也是路由方法中的一个重要影响因素,将与跳数相关的奖励设置为下式(12):

[0118]

h=1/(1 e-(m-m)

) (12)

[0119]

其中,m表示设置的参考跳数,而m=1,2

…

表示当前的实际跳数。从上式可以得出结论,当m不大于m时,奖励趋于0,如果m远大于m,则与跳数相关的奖励值趋于-1。为了平衡各考虑因素的不同区间问题,专利采用以下公式对其进行归一化,即:

[0120][0121]

通过归一化操作,可将t

i,j

和ξ

i,j

分别转换成t

i,j

'和ξ

i,j

'。那么dqn-lbr的奖励函数最终可以描述为下式(13):

[0122]

r=-(μ1t

i,j

′

μ2ξ

i,j

′

μ3β

i,j-μ4h)(1-f

i,j

) (13)

[0123]

其中μ1、μ2、μ3和μ4分别为与归一化延迟、距目的节点的距离、丢包率和跳数相关的权重参数,且有μ1 μ2 μ3 μ4=1成立。

[0124]

可选地,s21中的网络采用八层残差网络resnet;

[0125]

网络还包括adam优化器和relu激活函数。

[0126]

一种可行的实施方式中,本专利的方法采用八层resnet(residual network,残差网络)(对应于dqn)来估计和预测q函数值,因为resnet已被证明能够有效地解决传统网络结构中的网络退化问题。此外,还为resnet配备使用adam优化器和relu激活函数。网络的输入和输出分别是当前卫星节点的状态和每个动作对应的q值。

[0127]

s22、设计dqn模型的优化目标;优化目标为最小化损失函数loss。

[0128]

一种可行的实施方式中,传统的强化学习使用存储表的方法记录表示策略π,然而当状态-动作空间较大时,传统强化学习方法变得不再实用。在低轨卫星网络中,网络规模的增长及监控粒度的不断细化,导致低轨卫星网络的状态空间维度爆炸,依靠传统强化学习实现低轨卫星的路由算法愈发困难。深度强化学习将深度学习的感知能力和强化学习的决策能力相结合,通过充分发挥二者各自的优势使得智能体能够直接从高维输入数据中获得感知信息,并使用获得的感知信息进行模型训练,得到最优策略并做出决策,实现对智能体的行为进行合理有效的控制,为复杂系统感知决策问题提供了一种新的解决思路。

[0129]

在强化学习中引入深度学习有三种方法,分别为基于值的深度强化学习、基于策略的深度强化学习和基于模型的深度强化学习。其中,基于值的深度强化学习方法,即dqn(深度q学习),使用神经网络来估计状态-动作值函数(即q值),dqn与q学习类似,仍然通过差分学习的方式更新q值。

[0130]

dqn的优化目标为最小化损失函数loss,loss表示的是现实值与估计值的偏差大小,定义为下式(14):

[0131][0132]

其中,r为奖励;γ∈(0,1)为折扣率;q(s',a')为状态为s'、动作为a'的状态-动作值函数;s'为新状态;a'为新动作;q(s,a)为状态为s、动作为a的状态-动作值函数;s为状态;a为动作。

[0133]

s23、获取大量拓扑快照,根据拓扑快照对dqn模型的参数进行更新,得到训练完毕的dqn模型。

[0134]

一种可行的实施方式中,假设低轨卫星网络由大量拓扑快照组成,每个快照都被视为准静态卫星拓扑。在这种情况下,可以使用足够的快照来学习/更新所使用的dqn的合理参数。

[0135]

可选地,s2中的dqn模型的训练过程还包括:

[0136]

采用结构相同但参数不同的q网络和目标网络,对dqn模型的动作参数进行训练。

[0137]

在常规dqn中,选择动作和评估选择的动作使用相同的网络参数,这导致q值被过高估计,为解决这个问题,可以使用两个结构相同但参数不同的神经网络,分别称为q网络和目标网络,以减少q值的过度估计,同时降低训练时震荡发生的可能性。其中,q网络是一种网络结构,可以认为是一种神经网络,是用于训练得到q值的神经网络。

[0138]

可选地,s2中的dqn模型的训练过程还包括:

[0139]

在每次训练后记录所选传输路径的总奖励,如果当前网络的总奖励是先前网络的奖励中的最高奖励,则将主网络的参数复制到目标网络。

[0140]

通过所提出的dqn-lbr方法可以探索/学习合理的路由,该方法总结在算法1中。表示设定的奖励的参考值。在模型训练学习的过程中,方法使用重放存储器记录四元

组,随后其可用于优化网络参数(算法1的步骤12)。与传统的dqn算法仅通过学习步数更新网络参数不同,该算法增加了另一个目标网络,并在传统dqn算法的基础上更新新网络的参数。具体来说,方法将在每次训练后记录所选传输路径的总奖励,如果当前总奖励是先前奖励中的最高奖励,则将主网络的参数复制到目标网络。其中,主网络和目标网络是两个神经网络,主网络负责模型训练,目标网络负责指引主网络的训练,目标网络的结构与主网络一样;主网络基于q网络结构。

[0141][0142][0143]

s3、当前卫星节点将待传输数据转发给所选的相邻卫星节点。

[0144]

当前卫星节点完成下一跳路由节点的输出和选择之间的映射,并将数据转发给所选节点。

[0145]

s4、将所选的相邻卫星节点视为新的当前卫星节点,重复上述s1-s3,直到目标节点接收到数据。

[0146]

一种可行的实施方式中,将新卫星节点视为当前卫星节点,并重复上述步骤直到目标节点(即卫星或地面站)接收到数据。

[0147]

一种可行的实施方式中,为了训练该方法的深度q网络dqn,本专利采用keras平台。在仿真中,总共在1000公里的高度上设立了48颗低轨卫星,每个轨道上有8个轨道和6个

卫星节点。此外,每颗卫星配备四个双工收发器。相关的仿真参数总结于表1仿真参数设置情况中。为了指导方法完全掌握和适应低轨卫星网络的情况,专利方法在训练过程中生成了大量卫星快照。此外,可用带宽、传输功率、信道增益、排队延迟、可用缓存空间等参数是随机生成的,它们服从不同的均匀分布。在每次训练中还随机选择源卫星节点和目的地节点,并且当目的地节点接收到要发送的数据时完成训练。每个生成的低轨卫星网络快照训练4000次。

[0148]

表1

[0149][0150][0151]

本专利采用四种方法来呈现所提出的dqn-lbr方法的性能优势,如下所示:

[0152]

1)gpsr(greedy perimeter stateless routing,基于位置的路由协议),文献《satellite lifetime predicted greedy perimeter stateless routing protocol for leo satellite network》提出的方法,该方法将相邻节点与目的地之间的距离作为选择下一跳的参考因子。

[0153]

2)elb(elastic load balancing,弹性负载均衡),文献《explicit load balancing technique for ngeo satellite ip networks with on-board processing capabilities[j]》提出的方法,该方法基于预先计算的全局路由结果,避免了高负载卫星节点。

[0154]

3)dqn-v(变体)算法,一种改进的dqn-lbr方法。该方法不考虑式(13)中的延迟因子。

[0155]

4)dqn-ir(智能路由)算法,该方法可以看作是提出的dqn-lbr方法的一种变型,它不考虑式(13)中的丢包率因子。

[0156]

本专利首先测试了提出方法的收敛性能。图3示出了所提出的dqn-lbr方法的收敛过程,其中需要发送2mbit/5mbit/8mbit/10mbit数据。可以看出,虽然在训练的初始阶段存在一些较大的波动,但所提出的方法最终可以在四种情况下收敛(大约1100轮后)。此外,还可以观察到,随着要传输的数据量的增加,收敛后的回报逐渐减少。这是因为延迟和丢包率随着数据量的增加而增加,这会影响奖励值。

[0157]

然后通过大量随机生成的快照验证了传输延迟和丢包率的性能。图4和图5分别示出了所使用的五种方法的平均延迟和分组丢失率与要发送的数据量的关系。如图4所示,gpsr和elb方法的延迟随着数据量线性增加,这是因为这两种方法对该参数不敏感,并且无论要发送的数据量如何,它们都使用相同的路由。总体而言,dqn-ir方法的性能依次优于dqn-lbr、dqn-v、elb和gpsr方法,因为dqn-ir主要考虑延迟特性。与此相反,可以观察到dqn-ir方法对于图5中的丢包率性能较差。方法dqn-lbr和dqn-v表现出几乎一致的丢包率性能,因为后者只忽略了延迟因素。提出的dqn-lbr方法在丢包率性能方面优于elb、dqn-ir和gpsr方法。考虑到图4和图5中的性能结果,可以得出结论,与其他四种比较方法相比,所提出的dqn-lbr方法的性能更好。

[0158]

为了从直观的角度观测性能情况,最后在图6和图7中展示了十个随机生成的卫星拓扑快照方法的传输延迟和丢包率性能。虽然给出的结果随着快照变化有很大不同,但可以明显地观察到gpsr和elb具有相似的延迟性能,而dqn-v在传输延迟方面的性能不如dqn-lbr和dqn-ir。由于考虑了负载状态的影响因素,dqn-v方法和提出的dqn-lbr方法比其他方法具有更好的丢包率性能。此外,实验结果也验证了该方法比经典的elb方法更灵活,后者仅在中心路由策略的基础上避免了下一跳的过载节点,前者综合考虑了与负载平衡相关的诸多因素,通过充分的训练获得路由。综上所述,上述测试证明了本文提出的dqn-lbr的合理性,它对所考虑的负载平衡路由场景的适应性,以及它比常用路由算法的优越性。

[0159]

负载均衡对于业务繁忙、强动态性的低轨卫星网络具有重要意义,本专利所提路由方法的前提是依靠当前节点一跳范围内的邻居卫星节点的状态情况做出的路径决策,相应的状态信息包含可用带宽、信噪比、距离、排队延迟和缓存空间等,这种路由决策方式与目前的仅依靠部分信息实现的路由方法存在显著不同,当前方式具备综合考量的特点,因而理论和仿真的性能上更优。

[0160]

本专利提出使用深度强化学习解决关注场景中的负载均衡路由规划问题,通过一系列合理的与场景密切相关的状态、动作、奖励以及网络等参数的设计,尤其是涉及到影响路由效果的诸多因素的奖励设置问题,总结并验证了所提出的行之有效的方法,所提方法具备综合性能更优、方法适应性强的诸多优点。

[0161]

本发明实施例中,环境自适应能力强,本专利基于人工智能手段实现低轨卫星网络场景下的负载均衡路由,相比于常用的依靠对部分参数手工设定门限的路由方法,所提方法能够通过与环境的交互掌握节点的选择规律,依靠奖励的引导做出有利于性能提升的决策。

[0162]

数据回传延迟更低,数据回传的延迟情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传延迟的路由方式,仿真上也证明了这一点。

[0163]

传输丢包率更低,数据传输的丢包情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传数据丢包率的路由方式,仿真上也证明了这一点。

[0164]

更适用于低轨卫星网络,相比于中心式路由方法,本专利所提方法不需要对全局信息进行定期更新,前者的更新操作存在巨大的延迟,限制了在具备高动态特性的低轨卫星网络上的应用,相比于常见的分布式路由方法,所提方法仅需要一跳卫星节点的状态情况,对信息量的要求相对较低,因而更能适用于状态变化迅速的低轨卫星网络。

[0165]

如图8所示,本发明实施例提供了一种低轨卫星网络负载均衡的路由系统,该系统应用于实现低轨卫星网络负载均衡的路由方法,该系统包括多个卫星节点以及目标节点;多个卫星节点包括当前卫星节点以及相邻卫星节点;其中:

[0166]

多个卫星节点,用于当前卫星节点通过通信交互的方式获取相邻卫星节点的节点信息;节点信息包括相邻卫星节点的间隔、空间位置、排队延迟、可用频率资源以及信道的信噪比;当前卫星节点根据自身状态、相邻卫星节点的节点信息以及训练完毕的深度q网络dqn模型,得到所选的下一跳的相邻卫星节点;当前节点将待传输数据转发给所选的相邻卫星节点;将所选的相邻卫星节点视为新的当前卫星节点,重复上述步骤,直到目标节点接收到数据。

[0167]

目标节点,用于接收待传输数据。

[0168]

可选地,s2中的dqn模型的训练过程包括:

[0169]

s21、设计dqn模型的参数;参数包括状态、动作、奖励以及网络。

[0170]

s22、设计dqn模型的优化目标;优化目标为最小化损失函数loss。

[0171]

s23、获取大量拓扑快照,根据拓扑快照对dqn模型的参数进行更新,得到训练完毕的dqn模型。

[0172]

可选地,多个卫星节点,进一步用于:

[0173]

采用结构相同但参数不同的q网络和目标网络,对dqn模型的动作参数进行训练。

[0174]

可选地,多个卫星节点,进一步用于:

[0175]

在每次训练后记录所选传输路径的总奖励,如果当前网络的总奖励是先前网络的奖励中的最高奖励,则将主网络的参数复制到目标网络。

[0176]

可选地,s21中的状态如下式(1)所示:

[0177][0178]

其中,表示t时刻当前节点i的状态;ηi={η

i,j

}表示当前节点i周围链路的信噪比向量,j=1,2

…

j为当前节点i的周围卫星节点的索引;bi={b

i,j

},j=1,2

…

j表示周围链路的可用带宽;ti={t

i,j

},j=1,2

…

j表示周围节点的排队延迟;di={d

i,j

},j=1,2

…

j表示当前节点与下一跳节点之间的距离;ξi={ξ

i,j

},j=1,2

…

j表示周围卫星节点j与目的节点之间的距离;χi表示当前节点要传输的数据量;表示相邻节点的可用缓存空间;fi的值描述为

[0179]

可选地,s21中的动作如下式(2)所示:

[0180]

a={node

i1

,node

i2

,

…

,node

in

,

…

,node

in

} (2)

[0181]

其中,node

in

∈{0,1}表示卫星节点的下一跳是否为卫星节点n;n为卫星节点个数。

[0182]

可选地,s21中的奖励如下式(3)所示:

[0183]

r=-(μ1t

i,j

′

μ2ξ

i,j

′

μ3β

i,j-μ4h)(1-f

i,j

) (3)

[0184]

其中,μ1为与归一化延迟相关的权重参数;μ2为与距目的节点的距离相关的权重参数;μ3为与丢包率相关的权重参数;μ4为与跳数相关的权重参数;μ1 μ2 μ3 μ4=1;t

i,j

为归一化后卫星节点i与卫星节点j之间的总延迟;ξ

i,j

′

为归一化后周围卫星节点j与目的节点之间的距离;β

i,j

表示数据包丢失的过程;h表示跳数相关的奖励。

[0185]

可选地,s21中的网络采用八层残差网络resnet;

[0186]

网络还包括adam优化器和relu激活函数。

[0187]

可选地,s22中的最小化损失函数loss如下式(4)所示:

[0188][0189]

其中,r为奖励;γ∈(0,1)为折扣率;q(s',a')为状态为s'、动作为a'的状态-动作值函数;s'为新状态;a'为新动作;q(s,a)为状态为s、动作为a的状态-动作值函数;s为状态;a为动作。

[0190]

本发明实施例中,环境自适应能力强,本专利基于人工智能手段实现低轨卫星网络场景下的负载均衡路由,相比于常用的依靠对部分参数手工设定门限的路由方法,所提方法能够通过与环境的交互掌握节点的选择规律,依靠奖励的引导做出有利于性能提升的决策。

[0191]

数据回传延迟更低,数据回传的延迟情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传延迟的路由方式,仿真上也证明了这一点。

[0192]

传输丢包率更低,数据传输的丢包情况在本专利所提方法的设计过程中予以了考虑,方法能够自适应的掌握有利于降低回传数据丢包率的路由方式,仿真上也证明了这一点。

[0193]

更适用于低轨卫星网络,相比于中心式路由方法,本专利所提方法不需要对全局信息进行定期更新,前者的更新操作存在巨大的延迟,限制了在具备高动态特性的低轨卫星网络上的应用,相比于常见的分布式路由方法,所提方法仅需要一跳卫星节点的状态情况,对信息量的要求相对较低,因而更能适用于状态变化迅速的低轨卫星网络。

[0194]

本领域普通技术人员可以理解实现上述实施例的全部或部分步骤可以通过硬件来完成,也可以通过程序来指令相关的硬件完成,所述的程序可以存储于一种计算机可读存储介质中,上述提到的存储介质可以是只读存储器,磁盘或光盘等。

[0195]

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。