1.本发明涉及电动汽车充电控制系统,是一种电动汽车有序充电控制方法。

背景技术:

2.目前,为了有效降低大规模电动汽车接入对电网造成的不利影响,以及电动汽车集群效应引发电动汽车用户充电难,充电需求难以满足的问题;为了电动汽车的有序充电控制策略主要有以下三种方法:(1)通过控制用户接入的时间和地点,减少电动汽车对配电网的电压波动,实现削峰填谷;(2)通过v2g(vehicletogrid)技术实现电能的合理吸纳和释放;(3)构建充电站经济效益最大或用户充电费用最小的目标函数,引导电动汽车前往合适的充电站。但由于电动汽车的出行时间、行驶位置、返程时刻、充电时间都具有很大的随机性,较难保障充电用户需求和配电网电压的稳定性,实现电动汽车的有序充电,较难解决充电站设备利用不均衡、车辆排队时间长短不一、配电网电压质量差的问题。为此,另一一些现有电动汽车充电采用q学习和agent技术进行充电站的优化布设,如中国专利文献中披露的申请号201911316131.x,申请公布日2020.04.10,发明名称“一种基于双中心q学习的充电场站协同优化控制方法”;再如中国专利文献中披露的申请号202110725797.1,申请公布日2021.08.27,发明名称“一种基于agent仿真的电动汽车充电桩布局优化方法”;但上述q学习和agent技术同时用于电动汽车有序充电控制,保障充电用户需求和配电网电压的稳定性的较少。

技术实现要素:

3.为克服上述不足,本发明的目的是向本领域提供一种电动汽车有序充电控制方法,使其主要解决现有电动汽车充电控制系统较难保障充电用户需求和配电网电压的稳定性,模型缺少大数据分析和多代理机制,构建充电负荷时空分布预测模型和行为决策模型的技术问题。其目的是通过如下技术方案实现的。

4.一种电动汽车有序充电控制方法,该方法包括充电负荷时空分布预测结果、用户充电成本分析和基于q学习的充电站资源协同分配,其特征在于该方法采用一个多代理系统的电动汽车充电优化控制策略,即使用多代理机制来模拟电动汽车、充电站、交通网络的代理之间信息交互行为,建立基于多代理技术的电动汽车充电行为仿真系统;通过融合电动汽车的轨迹数据和充电站的充电信息,以交通路网的出行模式、逗留时间、平均车速、拥挤系数为载体,并采用大数据分析的方法刻画电动汽车充电需求的关键特征,基于实时数据构建充电负荷时空分布预测模型,获取充电需求数据和时空数据;同时以大数据分析得到的实时数据环境下用户到达各充电站时的充电负荷时空分布预测结果、充电需求可达率、充电需求满足率、配电网运行状态、充电站容量约束、配电网电压约束、馈线电流约束、当前电价为环境信息,采用q学习算法建立电动汽车代理的行为决策模型,模拟区域内电动汽车的充电行为,在满足充电需求前提下,采用一系列充电优化控制策略来引导电动汽车的充电行为,实现电动汽车的有序充电。

5.所述充电负荷时空分布预测结果基于车联网平台的电动汽车轨迹的gps数据提取,即车联网平台对电动汽车轨迹数据采用gps的方式记录,首先需要对电动汽车轨迹数据进行提取,包括gps点的时间和地理信息;

6.对gps数据进行预处理,由于gps数据受到随机因素的影响,因此gps点与道路之间的垂直距离肯定是不相同的,接着需要对gps点进行预处理,并把gps点反映在道路的中心线上;

7.结合时间和地理因素,采用lcss的方法获取用户的充电模式,包括充电开始、充电结束时间和充电地点;

[0008][0009]

其中,

△

t为时间精度,设为半个小时,δ(li(u),lj(v))是一个重合性公式,当两个用户的充电站重合时,值为1,否则为0;如果col大于1/3,那么说明电动汽车在同一个充电站内进行充电,假设有n个用户在某个

△

t为时间精度内充电;

[0010]

电动汽车电池剩余电量计算,在充电模式下,电动汽车剩余电量与日行驶距离;

[0011]qr,u

(t)=q

0,u-du(t)wuꢀꢀ

(公式2);

[0012]

其中,q

0,u

其实电池电量,q

r,u

(t)充电前一个时刻的剩余电量;接着,通过大数据的方法,统计每一周每一个时刻,以半小时为一个统计周期;某一个充电站的所有电动汽车充电前一个时刻的平均剩余电量;

[0013][0014]

某一个充电站的站点在某一个时刻的充电负荷统计,获取该站点某

△

t时间精度开始充电到该时刻结束时用户充电的平均时长:

[0015][0016]

其中,c表示

△

t时间精度结束时刻时n个用户电池的平均容量,当

△

t取30分钟,每个

△

t开始时刻认为i是1,每个

△

t结束时刻认为是30,得出结束时刻时n个用户电池的平均容量;η时充电站的充电效率,pc是充电站的平均功率;

[0017]

在某一个充电站的站点内,基于充电时长,电动汽车的数量n,充电站的充电功率,充电站的充电效率,获得该

△

t的充电负荷预测:

[0018][0019]

至此,计算整个城市领域内每一个站点在每个时刻的充电负荷,那么即可预测每一个站点在每个时刻的充电负荷,从而跟现有的实际值乘以电动汽车的在每个月的增长数量实现预测,最终实现充电负荷时空分布预测结果。

[0020]

所述用户充电成本分析的用户充电成本包括电动汽车的行驶距离成本、时间成本和充电服务费用成本,所述时间成本包括行驶时间成本和排队等待时间成本;

[0021]

行驶距离成本:

[0022]

其中,li表示gps点两点的距离,汽车行驶距离成本是从充电需求时刻出发,前往充电站经过的路程长度,长度通过gps两两之间的距离累加;

[0023]

行驶时间成本:

[0024]

其中,v表示汽车在该时刻的平均行驶速度,通过车联网获得各路段的平均行驶速度;

[0025]

排队等待时间成本:

[0026]

排队等待实践成本需要根据上述大数据对所述充电负荷时空分布预测结果的部分结果来预测;假设电动汽车的需求服务充电站分布,电动汽车在某一个时刻对某个充电站的期望μ采用上一个月在某个

△

t为时间精度内充电ni个需求用户的加权平均得出;同理,方差σ结合上一个月某个

△

t的充电用户数和平均值得出;

[0027]

其中,ρk是第k个充电站电动汽车到达率,通过所述充电负荷时空分布预测结果的采用上一个月某个

△

t为时间精度的汽车达到量/用户需求得出;ck表示第k个充电站的充电枪数量;这里的等待时间是通过上面电动汽车的行驶时间推到汽车到达充电站的时刻开始计算,ρk、μ、σ采用上个月在该时刻所属在

△

t的统计值;

[0028]

充电服务费用成本是指在当前时刻,用户充电所发生的实际费用:

[0029][0030]

得出用户充电成本分析。

[0031]

所述基于q学习的充电站资源协同分配采用多个agent的协作学习算法,每个充电站看成是一个agent;充电站收集周围的用户充电需求以及附近充电站的容量、电压、电流系统状态,然后选择一种最优的资源分配策略后执行;agent的协作学习采用全局奖励值,即包括所有充电站的奖励函数值之和;定义一个集中控制器来统一管理各充电站的资源分配策略表,该策略表是每个充电站所共用的;充电站每进行一次资源分配,便将本次的资源分配策略传输至该集中控制器更新策略表,然后获取其相邻充电站的资源分配情况。

[0032]

所述多个agent的协作学习算法步骤如下:

[0033]

agent:k,1≤k≤n,每一个充电站视为一个agent;

[0034]

state:在t时刻,系统状态s定义为s[t]={k,q,p

fcs

,v,i},其中,q表示当前可用充电枪数量,p

fcs

表示第k个充电站的容量预测值,v表示当前时刻的电压,i表示当前时间的电流;

[0035]

action:在t时刻,系统的策略集a[t]={allocation of q};

[0036]

reward:系统奖励:全部充电站收益最大化以及用户成本最小化;

[0037]

充电站收益表示为:

[0038]

其中,p是供电站收取用户每一度电的价格,

△

t表示从t时刻到t 1时刻的时间跨

度,也就是决策的时间间隔,pk表示第k个充电站的功率,nk表示当前第k个充电站的已经使用的充电枪数量,f表示用户成本;

[0039]

用户成本表示为:

[0040]

其中,α β γ=1;

[0041]

从而通过在线学习机制,充电站不断收集自身和其他充电站的状态信息,然后进行资源分配,由于是协同学习,所有的充电站必须及时更新资源分配表;有了这些信息,agent根据最大的总收益来执行相应的策略,q函数的更新过程:

[0042][0043]

其中,sk表示agent当前的状态,表示agent前一的状态,θ表示学习速率;

[0044]

建立电动汽车代理的行为决策模型。

[0045]

所述q函数学习的约束条件具体如下,公式13-17:

[0046][0047]

公式13是充电站电量约束,第k个充电站的容量预测值是根据公式5算出来的;

[0048]vkmin

≤v≤v

kmax

ꢀꢀ

(公式14)

[0049]

公式14是充电站电压约束,v

kmin

表示第k个充电站所允许的电压最小值,v

kmax

表示第k个充电站所允许的电压最大值;

[0050]

ik≤i

k,max

ꢀꢀ

(公式15)

[0051]

公式15是充电站电流约束,i

k,max

表示第k个充电站所允许的电压最小值,v

kmax

表示第k个充电站所允许的电压最大值;

[0052]

li≤l

i,max

ꢀꢀ

(公式16)

[0053]

公式16是汽车行驶距离li小于电动汽车可行驶的最大距离l

i,max

;

[0054][0055]

公式17表示电动汽车只能选择一个充电站充电。

[0056]

该方法为了保障充电用户需求和配电网电压的稳定性,采用一个多代理系统的电动汽车充电优化控制策略,即使用多代理机制来模拟电动汽车、充电站、交通网络的代理之间信息交互行为,建立基于多代理技术的电动汽车充电行为仿真系统;通过融合电动汽车的轨迹数据和充电站的充电信息,以交通路网的出行模式、逗留时间、平均车速、拥挤系数为载体,并采用大数据分析的方法刻画电动汽车充电需求的关键特征,基于实时数据构建充电负荷时空分布预测模型,获取充电需求数据和时空数据;同时以大数据分析得到的实时数据环境下用户到达各充电站时的充电负荷时空分布预测结果(电动汽车到达各充电站后的动态队列)、充电需求可达率、充电需求满足率(行驶距离、平均行驶速度)、配电网运行状态、充电站容量约束、配电网电压约束、馈线电流约束、当前电价为环境信息,采用q学习算法建立电动汽车代理的行为决策模型,模拟区域内电动汽车的充电行为,在满足充电需求前提下,采用一系列充电优化控制策略来引导电动汽车的充电行为,实现电动汽车的有序充电。从而该方法解决了充电站的利用不均衡、车辆排队时间长短不一、配电网电压质量

差的问题,提高充电站的综合利用率。

[0057]

本发明的建模方式科学,模型和系统通过多代理系统对电动汽车充电优化,采用大数据分析获取充电需求数据和时空数据,实现电动汽车充电资源的有序分配,提高充电站的综合利用率;其适合作为电动汽车有序充电控制方法使用,及其同类系统和方法的技术改进。

附图说明

[0058]

图1是本发明的用户轨迹点预处理过程电动汽车轨迹线路图。

[0059]

图2是图1的合并点位置后电动汽车轨迹线路图。

具体实施方式

[0060]

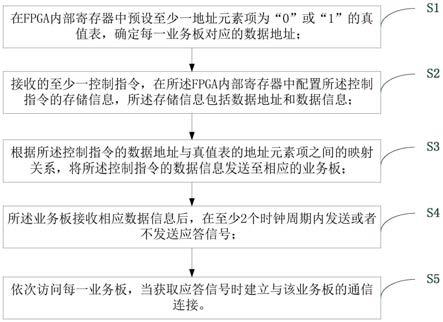

现结合附图,对本发明的具体实施步骤进行进一步的具体描述。如图1和图2所示,该方法的具体实施步骤如下:

[0061]

(1)充电负荷时空分布预测结果

[0062]

1、基于车联网平台的电动汽车轨迹的gps数据提取,即车联网平台对电动汽车轨迹数据采用gps的方式记录,首先需要对电动汽车轨迹数据进行提取,包括gps点的时间和地理信息。

[0063]

2、对gps数据进行预处理,由于gps数据受到随机因素的影响,因此gps点与道路之间的垂直距离肯定是不相同的,接着需要对gps点进行预处理,并把gps点反映在道路的中心线上。

[0064]

如图1所示,用户的gps轨迹点与道路中心线进行垂直处理,其垂足可视为用户的位置;同时,由于用户的gps点在红绿灯路口或者塞车的时候会有大量的点出现,需要将道路中心线的垂足进行合并,如果点与点之间的距离小于100米,则将上述的点进行合并,合并后的点的位置在两边垂足的中心位置上,合并点的时间取两边垂足的时间平均值,如图2所示。

[0065]

3、结合时间和地理因素,采用lcss算法的方法获取用户的充电模式,包括充电开始、充电结束时间和充电地点;

[0066][0067]

其中,

△

t为时间精度,设为半个小时,δ(li(u),lj(v))是一个重合性公式,当两个用户的充电站重合时,值为1,否则为0;如果col大于1/3,那么说明电动汽车在同一个充电站内进行充电,假设有n个用户在某个

△

t为时间精度内充电。

[0068]

4、电动汽车电池剩余电量计算,在充电模式下,电动汽车剩余电量与日行驶距离;

[0069]qr,u

(t)=q

0,u-du(t)wuꢀꢀ

(公式2);

[0070]

其中,q

0,u

其实电池电量,q

r,u

(t)充电前一个时刻的剩余电量;接着,通过大数据的方法,统计每一周每一个时刻,以半小时为一个统计周期;某一个充电站的所有电动汽车充电前一个时刻的平均剩余电量;

[0071][0072]

5、某一个充电站的站点在某一个时刻的充电负荷统计,获取该站点某

△

t时间精度开始充电到该时刻结束时用户充电的平均时长:

[0073][0074]

其中,c表示

△

t时间精度结束时刻时n个用户电池的平均容量,当

△

t取30分钟,每个

△

t开始时刻认为i是1,每个

△

t结束时刻认为是30,得出结束时刻时n个用户电池的平均容量;η时充电站的充电效率,pc是充电站的平均功率;

[0075]

在某一个充电站的站点内,基于充电时长,电动汽车的数量n,充电站的充电功率,充电站的充电效率,获得该

△

t的充电负荷预测:

[0076][0077]

至此,计算整个城市领域内每一个站点在每个时刻的充电负荷,那么即可预测每一个站点在每个时刻的充电负荷,从而跟现有的实际值乘以电动汽车的在每个月的增长数量实现预测,最终实现充电负荷时空分布预测结果。

[0078]

(2)用户充电成本分析

[0079]

用户充电成本包括电动汽车的行驶距离成本(从用户发出充电需求开始到充电站之间的行驶距离)、时间成本(时间成本包括行驶时间成本和排队等待时间成本)和充电服务费用成本,及各充电站利用均衡率、充电成本进行考量。

[0080]

行驶距离成本:

[0081]

其中,li表示gps点两点的距离,汽车行驶距离成本是从充电需求时刻出发,前往充电站经过的路程长度,长度通过gps两两之间的距离累加。

[0082]

行驶时间成本:

[0083]

其中,v表示汽车在该时刻的平均行驶速度,通过车联网获得各路段的平均行驶速度。

[0084]

排队等待时间成本:

[0085]

排队等待实践成本需要根据上述大数据对所述充电负荷时空分布预测结果的部分结果来预测;假设电动汽车的需求服务充电站分布,电动汽车在某一个时刻对某个充电站的期望μ采用上一个月在某个

△

t为时间精度内充电ni个需求用户的加权平均得出(一个月有30天,每天在某个

△

t为时间精度都有ni个需求用户,通过加权平均得出期望值);同理,方差σ结合上一个月某个

△

t的充电用户数和平均值得出。

[0086]

其中,ρk是第k个充电站电动汽车到达率,通过所述充电负荷时空分布预测结果的采用上一个月某个

△

t为时间精度的汽车达到量/用户需求得出;ck表示第k个充电站的充电枪数量;这里的等待时间是通过上面电动汽车的行驶时间推到汽车到达充电站的时刻开

始计算,ρk、μ、σ采用上个月在该时刻所属在

△

t的统计值。

[0087]

充电服务费用成本是指在当前时刻,用户充电所发生的实际费用:

[0088][0089]

得出用户充电成本分析。

[0090]

(3)基于q学习的充电站资源协同分配

[0091]

采用多个agent的协作学习算法,每个充电站看成是一个agent;充电站收集周围的用户充电需求以及附近充电站的容量、电压、电流系统状态,然后选择一种最优的资源分配策略后执行;agent的协作学习采用全局奖励值,即包括所有充电站的奖励函数值之和;定义一个集中控制器来统一管理各充电站的资源分配策略表,该策略表是每个充电站所共用的;充电站每进行一次资源分配,便将本次的资源分配策略传输至该集中控制器更新策略表,然后获取其相邻充电站的资源分配情况。该系统在多agent的协作学习下,使得学习的收敛速度更快,公平性更好;同时,这里利用q学习算法对状态动作对的值函数估计来获取最优的资源分配策略。

[0092]

agent:k,1≤k≤n,每一个充电站视为一个agent。

[0093]

state:在t时刻,系统状态s定义为s[t]={k,q,p

fcs

,v,i},其中,q表示当前可用充电枪数量,p

fcs

表示第k个充电站的容量预测值,v表示当前时刻的电压,i表示当前时间的电流。

[0094]

action:在t时刻,系统的策略集a[t]={allocation of q};

[0095]

reward:系统奖励:全部充电站收益最大化以及用户成本最小化。

[0096]

充电站收益表示为:

[0097]

其中,p是供电站收取用户每一度电的价格,

△

t表示从t时刻到t 1时刻的时间跨度,也就是决策的时间间隔,pk表示第k个充电站的功率,nk表示当前第k个充电站的已经使用的充电枪数量,f表示用户成本。

[0098]

用户成本表示为:

[0099]

其中,α β γ=1。

[0100]

从而通过在线学习机制,充电站不断收集自身和其他充电站的状态信息,然后进行资源分配,由于是协同学习,所有的充电站必须及时更新资源分配表;有了这些信息,agent根据最大的总收益来执行相应的策略,q函数的更新过程:

[0101][0102]

其中,sk表示agent当前的状态,表示agent前一的状态,θ表示学习速率。如果当前状态的q值比上一个状态好,那么agent执行策略,随着学习的深入,越到后面,q值越大,表示agent所采取的策略越好。

[0103]

上述q函数学习的约束条件具体如下,公式13-17:

[0104]

[0105]

公式13是充电站电量约束,第k个充电站的容量预测值是根据公式5算出来的;

[0106]vkmin

≤v≤v

kmax

ꢀꢀ

(公式14)

[0107]

公式14是充电站电压约束,v

kmin

表示第k个充电站所允许的电压最小值,v

kmax

表示第k个充电站所允许的电压最大值。

[0108]

ik≤i

k,max

ꢀꢀ

(公式15)

[0109]

公式15是充电站电流约束,i

k,max

表示第k个充电站所允许的电压最小值,v

kmax

表示第k个充电站所允许的电压最大值。

[0110]

li≤l

i,max

ꢀꢀ

(公式16)

[0111]

公式16是汽车行驶距离li小于电动汽车可行驶的最大距离l

i,max

。

[0112][0113]

公式17表示电动汽车只能选择一个充电站充电。

[0114]

综上所述,该方法采用q学习的方法实现充电资源的有序分配,该方法利用充电站学习和交换信息得到的环境知识采用协同决策的方式进行充电资源的分配。同时,该方法采用大数据实现充电负荷时空分布预测,为充电站在每一个时刻的系统状态提供数据支持。因为用户充电具有突发性和随机性的特点,每一个时刻的系统状态,特别是容量预测具有很大的动态性,由于系统策略的更新并非是实时的,肯定是以某一个时间颗粒执行的,而用户充电需求会在几分钟内出现一个暴增的情况,因此采用上一时刻的系统容量会出现较大的误差,采用容量预测的方法会降低用户使用随机性和突变性所带来的负面影响。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。