1.本发明涉及人体行为动作检测识别方法,具体涉及一种基于ros服务机器人、视觉追踪、意外检测、音视频通讯技术对人体行为动作检测识别方法及系统。

背景技术:

2.行为识别,是一种基于计算机计算,通过数学算法研究,使计算机能够实现对样本的识别和分析,达到能够自主处理和判断。随着计算机发展和人工智能的快速发展,人类对行为识别算法所进行融合和优化,使得构建的模型能达到更高的识别分类精度和泛化能力,智能系统不仅可自组织性与自适应性地在传统的诺依曼的计算机上运行,而且也可自组织性与自适应性地在新一代的非诺依曼结构的计算机上运行。本发明以ros服务机器人系统为平台,通过对当前算法进行优化创新,提高人工智能的实用性、推广性和在非实验室场合的运用,运用于一些特殊领域如独居者场合。

技术实现要素:

3.为了克服现有技术的不足,本发明提出一种人体行为动作检测识别方法,以ros服务机器人系统为平台,对用户进行定位,以及对用户生理特征、行为异常进行判断,满足易部署、高速率通信等要求的人体行为动作检测识别方法。

4.本发明为实现上述目的,所采用的技术方案是:一种人体行为动作检测识别方法,基于ros服务机器人的硬件设施配置,实现目标人体行为动作的识别,包括如下步骤:步骤1:启动ros服务机器人并启用智能系统;步骤2:启动kinect深度双目摄像头,并读取深度双目摄像头的参数摄影角α,为视野范围最大角度,图像宽度记为image_width,图像高度记为image_height,读取系统设置的人机距离阈值记为d;步骤3:kinect深度双目摄像头将获取的灰度图像传递给ros服务机器人;步骤4:利用当前处理好的深度图像结合python功能包skimage中的子模块morphology的skeletonize(image)函数和medial_axis(image, mask=none, return_distance=false)函数获取当前监护目标的骨骼图,并对当前图像进行稳定、平滑处理,其中image为图像对象,mask:为掩模,默认为none, 如果给定一个掩模,则在掩模内的像素值才执行骨架算法,return_distance:为bool型值,默认为false. 如果为true, 则除了返回骨架,还将距离变换值也同时返回,距离指的是中轴线上的所有点与背景点的距离。

5.步骤5:通过启用2d雷达获取当前的人机距离man_machine_distance,提取目标中心点,获取目标方位target_bearing,target_bearing为中心点位于图像宽度的位置;步骤6:判断与 两式是否成立,如果不成立,则根据两式的大小情况驱动stm32单片机运动底盘调整机器人位置,具体规则如下:若,则驱动stm32运动底盘向远离人体

方向移动,若,则驱动stm32运动底盘向人体方向移动;若,则驱动stm32运动底盘向左转向,若,则驱动stm32运动底盘向右转向,直至满足与二式,此时系统将人机距离阈值d传递至下一步实际高度的计算中;步骤7:此时人机距离man_machine_distance与提前预设的阈值d相等,且当前追踪目标位于图像中间,于是利用公式求得当前画面的实际高度h,其中h为ros服务机器人实际高度;步骤8:提取目标中心点并利用图像比例关系,求得目标中心实际高度,公式如下:,其中image_height为图像高度,为中心点在图像中的高度;步骤9:间隔t时间后再抓取一帧画面,重复步骤7获得t时间后的目标中心实际高度;步骤10:计算监护目标中心点的下降速度spine v,计算公式如下:;步骤11:判断spinev与vt的大小关系,其中vt为中心点下降速度的阈值,该阈值利用牛顿第二定律结合运动学公式,由工控机搭载不同处理器、系统搭载的摄像头的性能与检测精度要求决定。

6.步骤12:如果spinev小于vt,则返回至步骤2重新开始循环执行;步骤13:如果spine v大于vt,则向人体发送音视频通话请求。

7.进一步的,中心点下降速度的阈值设定在1.21m/s-2.05m/s。

8.进一步的,为实现人体行为动作检测识别方法采用智能系统实现,该智能系统包括ros服务机器人工控机、电源、stm32运动底盘、led屏幕、2d雷达、kinect深度双目摄像机以及音频设备,将电源连接至stm运动底盘与工控机,其余硬件连接至工控机后搭载至机器人外壳模型上即可,所述电源用于为ros服务机器人提供能源支持,以确保智能系统可以正常运行,led屏幕用于为用户提供操作支持,kinect深度双目摄像机用于采集当前数据,向智能系统传递rgb图像与当前实时画面,工控机用于搭载程序并集中处理来自雷达、kinect深度双目摄像机传输的数据并做出继续追踪或拨通音视频通话的决策,stm32运动底盘用于控制ros服务机器人进行移动,2d雷达用于检测ros服务机器人与监护人的距离与避障,音频设备用于监护人与用户之间的音频转播。

9.本发明的有益效果是:本发明人体行为动作检测识别方法,采用确定目标用户中心点高度位置及下降速度的检测,通过该算法可以检测到被监护者当前状态是否跌倒,若跌倒则调用自动音视频通话模块,将当前被监护者情况实时转发至监护人终端,使得监护

人可以在第一时间发现被监护者发生意外,并迅速采取积极措施对被监护者进行施救,避免意外发生。

附图说明

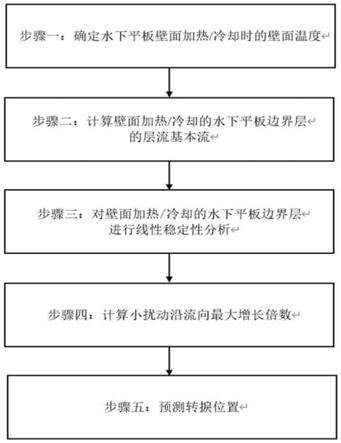

10.图1是本发明所设计用户行为动作检测识别方法的架构原理示意图;图2是本发明方法流程图。

具体实施方式

11.为使本公开实施例的目的、技术方案和优点更加清楚,下面对本公开实施例的技术方案进行清楚、完整地描述。显然,所描述的实施例是本公开的一部分实施例,而不是全部的实施例。基于所描述的本公开的实施例,本领域普通技术人员在无需创造性劳动的前提下所获得的所有其他实施例,都属于本公开保护的范围。

12.在一个实施例中,参见图1,本发明的一种人体行为动作检测识别方法基于ros服务机器人的硬件设施搭配,包括ros服务机器人工控机、电源、stm32运动底盘、led屏幕、2d雷达、kinect深度双目摄像机、音频设备。

13.所述电源用于为ros服务机器人提供能源支持,以确保智能系统可以正常运行,led屏幕用于为用户提供操作支持,kinect深度双目摄像机用于采集当前数据,向智能系统传递rgb图像与当前实时画面,工控机用于搭载本发明智能系统并集中处理来自雷达、kinect深度双目摄像机传输的数据并做出继续追踪或拨通音视频通话的决策,stm32运动底盘用于控制ros服务机器人进行移动,2d雷达用于检测ros服务机器人与监护人的距离与避障,音频设备用于监护人与老人之间的音频转播。

14.在一个实施例中,参见图2,本发明提供一套智能系统的算法流程,为更详细的解释本发明的实施方式,特以实例作进一步说明,此处需要强调,本实例仅用于解释本发明,并非限制本发明参数与场景:步骤1:启动ros服务机器人并启用本发明智能系统。

15.步骤2:启动kinect深度双目摄像头,并读取深度双目摄像头的参数摄影角α(即视野范围最大角度,下文同),图像宽度image_width,图像高度image_height,读取系统设置的人机距离阈值d。假设此时α = 90

°

,image_width = 640,image_height = 480 ,d = 1.2m。

16.步骤3:kinect深度双目摄像头将获取的灰度图像传递给ros服务机器人。

17.步骤4:利用当前处理好的深度图像结合python功能包skimage中的子模块morphology的skeletonize(image)函数和medial_axis(image, mask=none, return_distance=false)函数获取当前监护目标的骨骼图,并对当前图像进行稳定、平滑处理。其中image为图像对象,mask:为掩模,默认为none, 如果给定一个掩模,则在掩模内的像素值才执行骨架算法,return_distance:为bool型值,默认为false,如果为true, 则除了返回骨架,还将距离变换值也同时返回。这里的距离指的是中轴线上的所有点与背景点的距离。

18.步骤5:通过启用2d雷达获取当前的人机距离man_machine_distance,提取目标中心点,获取目标方位target_bearing,target_bearing为中心点位于图像宽度的位置。假设此时man_machine_distance = 1m,target_bearing = 300。

19.步骤6:判断与 两式是否成立,此时,,系统则驱动stm32运动底盘向远离监护人方向移动,,则驱动stm32运动底盘向左转向,直至满足与二式。此时系统将人际距离阈值d = 1.2m传递至下一步实际高度的计算中。

20.步骤7:此时人机距离man_machine_distance 与 提前预设的阈值d相等,且当前追踪目标位于图像中间,于是利用公式求得当前画面的实际高度h = 1.9m。

21.步骤8:提取目标中心点并利用图像比例关系公式如下:,其中image_height为图像高度,为中心点在图像中的高度,假设此时 = 240,即 = ,求得目标中心实际高度 = 0.95m。

22.步骤9:假设间隔t = 0.1s时间后再抓取一帧画面,重复步骤7获得0.1s时间后的目标中心实际高度 。

23.若假设:步骤10:计算监护目标中心点的下降速度spine v,计算公式如下:,此时spinev = 0.001m/s。

24.步骤11:判断spinev与vt的大小关系,其中vt为中心点下降速度的阈值,一般取1.21m/s~2.05m/s。

25.步骤12:此时spinev小于vt,返回至步骤2重新开始循环执行。

26.若假设:步骤10:计算监护目标中心点的下降速度spine v,计算公式如下:,此时spinev = 1.4m/s。

27.步骤11:判断spinev与vt的大小关系,其中vt为中心点下降速度的阈值,一般取1.21m/s~2.05m/s,该阈值利用牛顿第二定律结合运动学公式,由工控机搭载不同处理器、系统搭载的摄像头的性能与检测精度要求决定。

28.步骤12:此时spine v大于vt,则向监护人发送音视频通话请求,将当前被监护者情况实时转发至监护人终端,使得监护人可以在第一时间发现被监护者发生意外,并迅速采取积极措施对被监护者进行施救,避免意外发生。

29.通过本发明人体行为动作检测识别方法可应用于智能养老监护场景,通过本发明可以节省极大的人力、物力、财力来达到对老年人监护的目的。

30.以上所述仅为本发明的实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其它相关的技术领域,均同理包括在本发明的专利保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。