1.本发明涉及电子通信中的数据传输,尤其是涉及一种基于ldpc码的分布式联合信源信道编码系统的深度学习译码方法。

背景技术:

2.第五代5g蜂窝网络具有高速率、低延时和支持大量设备互联的特点,5g促进物联网的大量实际运用。同时,物联网的出现也推动5g网络呈现指数级增长。其中传感器网络能够高准确率,低功耗地实现数据传输是物联网中的关键一环。分布式联合信源信道编码系统是一种对多个传感器相关输出在不相互通信进行压缩编码在译码端进行联合译码的技术,它将信道编码和分布式信源编码联合起来,更适用于传感器节点能量受限以及更复杂的实际应用场景。如何设计译码端的结构得到信源信息显得尤其关键。

3.min-sum算法性能虽然不及置信传播迭代译码算法,但其结构简单且易于硬件实现而被广泛使用。随着深度学习的快速发展,有大量的研究者开始将深度学习运用在通信的物理层的译码问题上,进而提高min-sum算法的译码性能。但是针对分布式信源信道编码系统的译码网络结构还没有被提出。

技术实现要素:

4.本发明的目的在于针对分布式联合信源信道编码系统提供可以并行译码并只增加和迭代次数一样的额外权值参数,为了挖掘分布式信源之间的相关性,增加信息交互单元,获得额外的性能增益的一种分布式联合信源信道编码系统的深度学习译码方法。

5.为了达到上述目的,本发明包括以下步骤:

6.1)建立分布式联合信源信道编码系统译码的训练样本集,获得对应的校验矩阵hi,i=1,2,

…

s,其中s为分布式信源个数;

7.2)建立分布式联合信源信道编码系统的深度学习译码模型;

8.3)确定深度学习网络模型的loss函数;

9.4)确定需要增加交互单元的隐藏层位置并插入信息交互单元隐藏层;

10.5)确定模型的激活函数,初始化权值w;

11.6)对步骤1)中输入的样本采用随机梯度下降的方式对模型进行训练,得最优的权值w,确定最终的网络模型;

12.7)将需要译码的样本集输入到步骤6)最终确定的模型中,通过最终的硬判决完成分布式联合信源信道的译码。

13.在步骤1)中,所述建立分布式联合信源信道编码系统译码的训练样本集的具体方法可为:首先不失一般性地假设有两个相关信源x和y,其中信源概率为p[x=0]=p[y=0]=1/2,两个信源之间的相关性定义为ρ,这两个信源可看作是通过转移概率为p[y=x|x]=ρ的bsc信道产生的相关信源,通过获得的校验矩阵h1,h2得到生成矩阵g1,g2后,实现x'=x*g1与y'=y*g2,其中x',y'是经过编码之后的信息序列;假设信源x和y信息序列长度均为k比

特,经过编码后得到长度为n比特的信息序列;为了同时实现压缩及纠错功能,分布式信源x只发送信息比特前αk部分及校验比特,其中α是介于[0,1]之间的常数;分布式信源y只发送信息比特的后(1-α)k部分及校验比特;需要发送的信息序列经过bpsk调制后通过awgn信道得到r

x

与ry。

[0014]

其次,计算分布式信源各个变量节点的初始似然信息l(u

i,x

),l(u

i,y

),其中未发送部分需要利用信源之间的相关性获得。假设信源x发送信息位的前一部分和校验节点,信源y发送信息位的后一部分和校验节点,不失一般性以x为例,其信道初始似然信息计算为以下步骤:

[0015][0016]

其中,σ2为awgn信道噪声的方差,之后将计算得到的l(u

i,x

)与l(u

i,y

)整合为一个大小为(2n,c

×

num)的矩阵,其中c表示信噪比的类别个数,num表示训练过程中不同信噪比的帧数,该矩阵即为训练样本集。

[0017]

在步骤2)中,所述建立分布式联合信源信道编码系统的深度学习译码模型,是将分布式信源通过检验矩阵hi(i=1,2,

…

s)获得的深度学习的译码网络整合在同一个隐藏层建立分布式联合信源信道编码系统的深度学习译码模型,具体方法为:假设有两个相关信源x和y,根据校验矩阵h1,h2采用迭代译码min-sum算法确定隐藏层中各个神经元的连接关系,其中的连接关系对应h矩阵中'1'的位置,并通过给'1'的位置进行更新神经元的输入和输出。然后将两个信源同一层的变量节点神经元整合为网络的一层变量节点隐藏层,两个信源同一层的校验节点神经元整合为网络的一层校验节点隐藏层。确定迭代次数l

max

后,可以得到隐藏层的个数为2l

max

,每一隐藏层都分别对应两个信源的迭代译码的连接关系。

[0018]

在步骤3)中,所述确定深度学习网络模型的loss函数的具体步骤可为:为了避免将分布式信源的译码过程整合为一个网络时训练向其中任何一个信源译码任务倾斜,综合考虑分布式信源译码任务的loss,两相关信源选择的loss函数如下:

[0019]

l(u,o)=λ

(l)

l

x

(u,o) (1-λ

(l)

)ly(u,o),λ∈(0,1)

[0020]

其中,l

x

(u,o)与ly(u,o)分别是分布式信源x与y译码任务的multi-loss函数。

[0021]

在步骤4)中,所述确定需要增加交互单元的隐藏层位置并插入信息交互单元隐藏层的具体方法为:选择对应的迭代次数t,即在对应的第2t层隐藏层之后插入信息交互单元隐藏层实现信息交互,两相关信源其信息交互单元具体操作如下:

[0022]

[0023][0024]

其中,与表示第t次迭代,即对应2t层隐藏层的变量节点的信息,l

x

(q

i,x

)与ly(q

i,y

)是信息交互单元隐藏层的输出。

[0025]

在步骤5)中,所述确定模型的激活函数,初始化权值w的具体方法可为:确定激活函数为σ(x)=(1 e-x

)-1

,初始化最初的权值w为均值为0、方差为1的高斯分布的随机变量。

[0026]

在步骤7)中,所述将需要译码的样本集输入到步骤6)最终确定的模型中,通过最终的硬判决完成分布式联合信源信道的译码,具体可为:

[0027][0028]

其中,l(qi)是输出层的似然信息。

[0029]

本发明的有益效果如下:

[0030]

本发明基于深度学习的分布式联合信源信道编码系统的译码方法可以实现并行译码,并能通过信息交互单元隐藏层实现分布式信源间的信息交互,充分挖掘分布式信源间的相关性以提高系统的译码性能。计算机仿真表明本发明性能明显优于传统的min-sum译码方法。

附图说明

[0031]

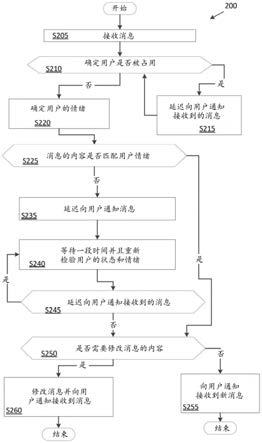

图1为本发明分布式联合信源信道编码系统基于深度学习的译码方法流程图;

[0032]

图2为本发明分布式联合信源信道编码系统基于深度学习译码的模型结构图;

[0033]

图3为分布式信源间相关性ρ=0.02,本发明与传统的min-sum算法的ber性能曲线对比图;

[0034]

图4为分布式信源间相关性ρ=0.04,本发明与传统的min-sum算法的ber性能曲线对比图。

具体实施方式

[0035]

为使本发明实现的技术手段、特征易于明白了解,下面结合附图与具体实施方式,进一步详细阐述。

[0036]

图1给出本发明分布式联合信源信道编码系统基于深度学习的译码方法流程图,参见图1,本发明实施例包括以下步骤:

[0037]

1)建立分布式联合信源信道编码系统译码的训练样本集,获得对应的校验矩阵hi,i=1,2,

…

s,其中s为分布式信源个数;

[0038]

2)建立分布式联合信源信道编码系统的深度学习译码模型;

[0039]

3)确定深度学习网络模型的loss函数;

[0040]

4)确定需要增加交互单元的隐藏层位置并插入信息交互单元隐藏层;

[0041]

5)确定模型的激活函数,初始化权值w;

[0042]

6)对步骤1)中输入的样本采用随机梯度下降的方式对模型进行训练,得最优的权值w,确定最终的网络模型;

[0043]

7)将需要译码的样本集输入到步骤6)最终确定的模型中,通过最终的硬判决完成分布式联合信源信道的译码。

[0044]

在步骤1)中,建立分布式联合信源信道编码系统译码的训练样本集是指:

[0045]

首先不失一般性地假设有两个相关信源x和y,其中信源概率为p[x=0]=p[y=0]=1/2,两个信源之间的相关性定义为ρ,这两个信源可以看作是通过转移概率为p[y=x|x]=ρ的bsc信道产生的相关信源,通过获得的校验矩阵h1与h2得到生成矩阵g1与g2后,实现x'=x*g1与y'=y*g2,其中,x',y'是经过编码之后的信息序列。假设信源x和y信息序列长度均为k比特,经过编码后得到长度为n比特的信息序列。为了同时实现压缩及纠错功能,分布式信源x只发送信息比特前αk部分及校验比特,其中α是介于[0,1]之间的常数;分布式信源y只发送信息比特的后(1-α)k部分及校验比特。需要发送的信息序列经过bpsk调制后通过awgn信道得到r

x

与ry。

[0046]

其次,计算分布式信源各个变量节点的初始似然信息l(u

i,x

),l(u

i,y

),其中未发送部分需要利用分布式信源之间的相关性获得。假设信源x发送信息位的前一部分和校验节点,信源y发送信息位的后一部分和校验节点,不失一般性以x为例,其信道初始似然信息计算为以下步骤:

[0047][0048]

其中,σ2为awgn信道噪声的方差。给定训练过程中信噪比类别个数c以及每一信噪比的帧数num基础上,将计算得到的l(u

i,x

)与l(u

i,y

)整合为一个大小为(2n,c

×

num)的矩阵,该矩阵即为训练样本集。

[0049]

步骤2)中,所述将分布式信源通过检验矩阵hi(i=1,2,

…

s)获得的深度学习的译码网络整合在同一个隐藏层来建立分布式联合信源信道编码系统的深度学习译码模型是指:假设有两个相关信源x和y,根据校验矩阵h1,h2采用迭代译码min-sum算法确定隐藏层中各个神经元的连接关系,其中的连接关系对应h矩阵中'1'的位置,并通过给'1'的位置进行更新神经元的输入和输出。然后将两个信源同一层的变量节点神经元整合为网络的一层变量节点隐藏层,两个信源同一层的校验节点神经元整合为网络的一层校验节点隐藏层。确定迭代次数l

max

后,可以得到隐藏层的个数为2l

max

,每一隐藏层都分别对应两个信源的迭代译码的连接关系。

[0050]

步骤3)中,确定该深度学习网络模型的loss函数是指,为了避免将分布式信源的译码过程整合为一个网络时训练向其中任何一个信源译码任务倾斜,综合考虑分布式信源译码任务的loss,两相关信源选择的loss函数如下:

[0051]

l(u,o)=λ

(l)

l

x

(u,o) (1-λ

(l)

)ly(u,o),λ∈(0,1),

[0052]

其中,l

x

(u,o)与ly(u,o)分别是分布式信源x与y译码任务的

multi-loss函数。

[0053]

步骤4)中,确定需要增加交互单元的隐藏层位置并插入信息交互单元隐藏层是指,选择对应的迭代次数t,即在对应的第2t层隐藏层之后插入信息交互单元隐藏层实现信息交互,两相关信源其信息交互单元具体操作如下:

[0054][0055][0056]

其中,与表示第t次迭代,即对应2t层隐藏层的变量节点的信息,l

x

(q

i,x

)与ly(q

i,y

)是信息交互单元隐藏层的输出。

[0057]

步骤5)中,确定激活函数为σ(x)=(1 e-x

)-1

,初始化最初的权值w,其中权值w满足均值为0、方差为1的高斯分布。

[0058]

步骤6)中,对步骤1)中输入的样本采用随机梯度下降的方式对模型进行训练并确定更新的步长和学习率,最终得到最优的权值w;

[0059]

步骤7)中,将需要译码的样本集输入到6)中最终确定的模型中,通过最终的硬判决完成分布式联合信源信道编码系统的译码。具体操作如下:

[0060][0061]

其中,l(qi)是输出层的似然信息。

[0062]

如图2所示,产生的输入样本集经过对应的变量节点隐藏层和校验节点隐藏层以及似然信息值交互单元隐藏层,每一次的迭代过程就对应两层隐藏层,最后到达输出层进行硬判决。

[0063]

通过如下的技术方案实现:

[0064]

第一步,确定分布式联合信源信道编码系统译码的训练样本集;

[0065]

第二步,确定深度学习译码模型;

[0066]

第三步,确定深度学习网络模型的loss函数;

[0067]

第四步,确定需要增加信息交互单元的隐藏层位置并插入信息交互单元隐藏层;

[0068]

第五步,确定深度学习译码训练模型的隐藏层的激活函数;

[0069]

第六步,确定输入的训练样本集梯度下降的方式来训练模型,调整训练的参数来确定最后网络模型;

[0070]

第七步,将需要译码样本集输入模型完成分布式联合信源信道系统信源的译码。

[0071]

具体步骤为:

[0072]

步骤1),对每一个分布式信源计算各个变量节点的初始似然信息,其中发送变量节点的初始似然信息基于接收的码字计算获得,而未发送部分则利用分布式信源间的相关性获得。假设信源x发送信息位的前αk部分和校验节点,信源y发送信息位的后(1-α)k部分

和校验节点,其中k为信源x和y信息序列长度,α是介于[0,1]之间的常数。不失一般性以x为例,其信道初始似然信息计算为以下步骤:

[0073][0074]

给定信噪比类别个数c以及每个信噪比的训练帧数num,将计算得到的l(u

i,x

)与l(u

i,y

)整合为一个大小为(2n,c

×

num)的矩阵,该矩阵作为训练样本集。

[0075]

步骤2),两个分布式信源x和y根据校验矩阵h1,h2采用迭代译码min-sum算法确定隐藏层中各个神经元的连接关系,其中的连接关系对应h矩阵中'1'的位置,并通过给'1'的位置来进行更新神经元的输入和输出。然后将两个信源同一层的变量节点神经元整合为网络的一层变量节点隐藏层,两个信源同一层的校验节点神经元整合为网络的一层校验节点隐藏层。确定迭代次数l

max

后,可以得到隐藏层的个数为2l

max

,每一隐藏层都分别对应两个信源的迭代译码的连接关系。

[0076]

步骤3),确定该深度学习网络模型的loss函数。为了避免将分布式信源的译码过程整合为一个网络时训练向其中任何一个信源译码任务倾斜,综合考虑分布式信源译码任务的loss,两相关信源选择的loss函数如下:

[0077]

l(u,o)=λ

(l)

l

x

(u,o) (1-λ

(l)

)ly(u,o),λ∈(0,1)

[0078]

步骤4),确定需要增加交互单元的隐藏层位置并插入信息交互单元隐藏层。选择对应的迭代次数t,即在对应的第2t层隐藏层之后插入信息交互单元隐藏层来实现信息交互,两相关信源其信息交互单元具体操作如下:

[0079][0080][0081]

步骤5),确定激活函数为σ(x)=(1 e-x

)-1

,初始化最初的权值w,其中权值w满足均值为0、方差为1的高斯分布。

[0082]

步骤6),对步骤1)中输入的样本采用随机梯度下降的方式来对模型进行训练并确定更新的步长和学习率,最终得到最优的权值w;

[0083]

步骤7),将需要译码的样本集输入到6)中最终确定的模型中,通过最终的硬判决来完成分布式联合信源信道编码系统的译码。具体操作如下:

[0084]

[0085]

本发明针对分布式联合信源信道编码系统提出的基于深度学习的译码方法与传统的min-sum算法的对比如下,相应的仿真参数为:h1=h2,g1=g2,选择1/2码率的ldpc码,帧长为800比特,参数α=1/2,即对称压缩,信源x发送前一半信息比特和校验比特,信源y发送后一半信息比较和校验比特。信噪比范围为[1.25db,3.25db],其中步进长度为0.25db,即c=9,训练过程帧数设为num=180。

[0086]

相关系数ρ分别取0.02和0.04,迭代次数l

max

=30,加入信息交换单元的位置为t=15,即似然信息交互单位对应的隐藏层位置为2t 1,因此最终整个网络模型的隐藏层数为2l

max

1。

[0087]

图3和4分别展示该条件下与传统min-sum算法的ber性能对比图,可以看出本发明与传统min-sum算法相比具有明显的性能增益。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。