1.本发明涉及英语教学技术领域,尤其涉及一种基于多场景互动的多模态英语教学系统。

背景技术:

2.英语教学承担培养学生基本英语素养和发展学生思维能力的任务,即学生通过英语课程掌握基本的英语语言知识,发展基本的英语听说读写技能,初步形成用英语与他人交流的能力,进一步促进思维能力的发展,为今后继续学习英语和用英语学习其他相关科学文化知识奠定基础,英语教学过程中常常需要通过英语对话场景的练习来进行口语互动。

3.如cn209265774u现有技术公开了一种英语教学互动装置,目前口语互动中往往采用教师直接口头设置英语对话场景,无法生动的展示英语对话场景且在切换英语对话场景时易出现混杂重复的情况。

4.另一种典型的如cn213365803u的现有技术公开的一种商务英语教学用互动装置,英语教学承担培养学生基本英语素养和发展学生思维能力的任务,即学生通过英语课程掌握基本的英语语言知识,发展基本的英语听说读写技能,初步形成用英语与他人交流的能力,进一步促进思维能力的发展,为今后继续学习英语和用英语学习其他相关科学文化知识奠定基础,英语教学过程中常常需要通过英语对话场景的练习来进行口语互动,但是目前在商务英语的教学中,当进行口语类的互动时,往往采用教师直接通过口头设定商务英语的对话场景,易造成无法清晰明确的展示英语对话场景,同时在切换商务英语的对话场景时,易出现混淆的情况。

5.为了解决本领域普遍存在无法切换场景、互动场景少、交互体验差和场景切换复杂等等问题,作出了本发明。

技术实现要素:

6.本发明的目的在于,针对目前所存在的不足,提出了一种基于多场景互动的多模态英语教学系统。

7.为了克服现有技术的不足,本发明采用如下技术方案:

8.一种基于多场景互动的多模态英语教学系统,包括服务器、交互终端、角色创建模块、场景切换模块、语言转换模块、交互模块和处理器,

9.所述处理器分别与角色创建模块、场景切换模块、语言转换模块、交互模块控制连接;

10.所述服务器分别与所述角色创建模块、所述场景切换模块、所述语言转换模块和交互模块连接;

11.所述角色创建模块用于对互动的角色进行创建,以建立多角色的场景对话;

12.所述场景切换模块用于对各个角色所选定的场景进行切换,以实现不同对话场景

的语义和语境的表达;

13.所述语言转换模块根据所述场景切换模块所设定的场景,将角色的语言进行识别,并将其转换为与设定场景匹配的语言;所述交互模块用于与所述交互终端进行配对,以实现对所述交互终端的交互数据进行采集;其中,所述交互终端用于对使用者的动作和语音数据进行采集,并将采集采集到的数据传输至所述交互模块中;所述语言转换模块包括采集单元和设定单元,所述设定单元用于对角色的语境进行设定;所述采集单元采集使用者发出的声音;

14.所述采集单元包括支撑构件、录音构件和采集构件,所述录音构件和所述采集构件设置在所述支撑构件上,其中,所述支撑构件用于固定在使用者的颈部;所述支撑构件包括固定环和支撑杆,所述支撑杆的一端与所述固定环连接,所述支撑杆的另一端朝向远离所述固定环的一侧伸出且所述采集构件设置在其端部;

15.所述支撑杆的杆体上设置有供所述录音构件放置的存储腔,使所述录音构件隐藏在所述存储腔中;

16.所述录音构件包括拾音阵列和传输器,所述拾音阵列用于对所述使用者的声音进行采集;所述传输器将拾音阵列的声音数据向所述服务器传输;

17.所述采集构件设置在所述支撑杆上朝向使用者的嘴巴一侧,并对所述使用者的口型变化进行采集;所述采集构件包括采集探头和存储单元,所述采集探头对所述使用者嘴巴的图像数据进行采集;所述存储单元对所述采集探头采集的数据进行存储;

18.所述采集单元还包括分析构件,所述分析构件用于对所述录音构件捕获的声音数据进行分析;所述分析构件包括语音云数据库、裁剪器和语音识别工具,所述裁剪器用于对声音数据进行裁剪,并与所述语音云数据库进行比对;所述语音云数据库存储有各种语音对话的场景,并对所述使用者的语音数据进行分析后,匹配该对话场景对话下的回应;

19.获取一个触发周期中所述使用者的语音数据,并通过所述裁剪器将所述语音数据进行裁剪,形成一个语音片段矩阵voice,

[0020][0021]

其中,m为声音片段数,n为采样点,a

ij

表示第i个采样点的第j个声音片段;

[0022]

对声音片段矩阵中的声音片段进行检测,以过滤掉一些无效的声音片段,依次对所述声音片段进行声音能量的检测:

[0023]

其中,第a

ij

声音片段的声音能量q(a

ij

)为:

[0024]

q(a

ij

)=g2(a

ij

)

·

δt

[0025]

式中,g(a

ij

)为声音信号在第i个采样点的第j个声音片段的采样的幅值;

△

t为每次采样的时长

[0026]

计算每个片段的所述声音能量后,计算出时间长度为t的声音片段的声音能量r,计算公式:

[0027][0028]

式中,n为声音片段的总数,满足:n=t/

△

t;t为声音片段的时间长度;根据r的取值,确定语音片段矩阵voice中的有效成分,并对矩阵进行更新形成有效片段矩阵voice’。

[0029]

可选的,所述设定单元包括偏好收集器和数据库,所述偏好收集器用于收集所述使用者的设定的数据;所述数据库根据所述偏好收集器的数据,调用所述服务器中存储的语言数据,并存储在本地的存储器中;

[0030]

其中,所述偏好收集器生成一个采集所述使用者个人喜好的情境信息,基于情境信息生成包括用户偏好、兴趣或习惯中的至少一个用户简档,以实现识别用户的表达或行为规则。

[0031]

可选的,所述场景切换模块包括场景建立单元和显示单元,所述场景建立单元基于设定或选定的场景数据源建立对话场景;所述显示单元用于显示所述对话场景;其中,各个所述对话场景预置在所述数据库中,并在所述使用者选定后,调用选定的对话场景。

[0032]

可选的,所述交互模块包括授权单元和配对单元,所述授权单元用于验证设备是否经过授权;所述配对单元用于与交互终端进行配对,以建立数据传输关系;

[0033]

所述授权单元包括授权器和存储器,所述授权器识别交互终端的识别码,并建立数据传输通道;所述存储器用于对所述交互终端的配对历史进行存储,若所述交互终端在存储器中有记录,且正处于激活状态,则恢复其数据传输通道。

[0034]

可选的,所述角色创建模块对各个使用者扮演的角色进行创建,其中,所述角色创建模块包括验证单元和创建单元,所述验证单元对所述使用者的身份进行核验,若使用者的身份核验通过,则采集所述使用者的角色建立数据;

[0035]

其中,所述角色建立数据包括角色姓名、英语对话类型、角色性别和角色的年龄;所述创建单元根据所述验证单元的数据,建立一个使用者的角色;

[0036]

所述验证单元读取所述使用者的识别信息,所述识别信息包括身份证和校园卡;

[0037]

所述验证单元核验所述识别信息并核验通过后,将识别信息与所述角色建立数据绑定。

[0038]

可选的,所述创建单元包括激活器和选择器,所述选择器用于调用数据库中存储的默认角色;其中,所选择的默认角色与所述角色建立数据相匹配;

[0039]

所述激活器根据所述选择器所选定的角色,并根据所述录音构件和所述采集构件的数据将该角色进行激活。

[0040]

本发明所取得的有益效果是:

[0041]

1.通过采用动作采集模块用于对使用者的动作进行采集,使得使用者的动作能够被采集,并对创建的角色进行动作的控制或者传导动作;

[0042]

2.通过偏好收集器生成一个采集使用者个人喜好的情境信息,基于情境信息生成包括用户偏好、兴趣或习惯中的至少一个用户简档,以实现识别用户的表达或行为规则;

[0043]

3.通过采用设定单元在收集使用者的偏好数据后,能够对使用者的惯常喜好或者表达方式进行设定,使得使用者获得最佳的使用体验;

[0044]

4.通过识别探头对使用者的身份进行识别,使得角色创建模块创建的模块能与使

用者进行绑定;

[0045]

5.通过采用动作采集模块用于对使用者的动作进行采集,使得使用者的动作能够被采集,并对创建的角色进行动作的控制或者传导动作。

[0046]

为使能更进一步了解本发明的特征及技术内容,请参阅以下有关本发明的详细说明与附图,然而所提供的附图仅用于提供参考与说明,并非用来对本发明加以限制。

附图说明

[0047]

从以下结合附图的描述可以进一步理解本发明。图中的部件不一定按比例绘制,而是将重点放在示出实施例的原理上。在不同的视图中,相同的附图标记指定对应的部分。

[0048]

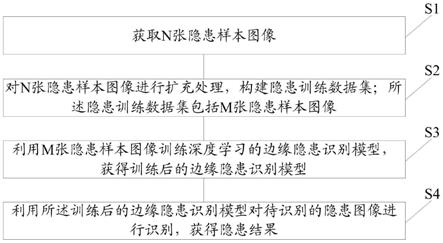

图1为本发明的整体的方框示意图。

[0049]

图2为本发明的所述角色和显示单元的显示方框示意图。

[0050]

图3为本发明的所述采集单元的结构示意图。

[0051]

图4为本发明的所述显示单元的结构示意图。

[0052]

图5为本发明的所述手套的结构示意图。

[0053]

图6为本发明的所述手环的结构示意图。

[0054]

图7为本发明的声音数据的音素分析示意图。

[0055]

附图标号说明:1-支撑构件;2-支撑杆;3-拾音阵列;4-采集构件;5-存储单元;6-传输器;7-限位板;8-支撑底座;9-全息显示探头;10-抬升构件;11-采集探头;12-手环;13-核验单元;14-身份信息;15-存储腔;16-手套。

具体实施方式

[0056]

以下是通过特定的具体实施例来说明本发明的实施方式,本领域技术人员可由本说明书所公开的内容了解本发明的优点与效果。本发明可通过其他不同的具体实施例加以施行或应用,本说明书中的各项细节也可基于不同观点与应用,在不悖离本发明的精神下进行各种修饰与变更。另外,本发明的附图仅为简单示意说明,并非依实际尺寸的描绘,事先声明。以下的实施方式将进一步详细说明本发明的相关技术内容,但所公开的内容并非用以限制本发明的保护范围。

[0057]

实施例一。

[0058]

根据图1、图2、图3、图4、图5、图6和图7,本实施例提供一种基于多场景互动的多模态英语教学系统,包括服务器、交互终端、角色创建模块、场景切换模块、语言转换模块、交互模块和处理器,

[0059]

所述处理器分别与角色创建模块、场景切换模块、语言转换模块、交互模块控制连接,并基于所述处理器对所述角色创建模块、场景切换模块、语言转换模块、交互模块进行集中的控制;

[0060]

所述服务器分别与所述角色创建模块、所述场景切换模块、所述语言转换模块和交互模块连接;

[0061]

所述语言转换模块将使用者的声音数据进行收集,并传输至所述交互模块中进行分析;其中,所述交互模块在对使用者的声音信号进行检测的过程中,通过访问服务器,并根据所述服务器对声音数据进行分析或者识别;同时,所述服务器根据识别出来的声音信

息,准备相应的对话素材;

[0062]

所述角色创建模块用于对互动的角色进行创建,以建立多角色的场景对话;

[0063]

所述场景切换模块用于对各个角色所选定的场景进行切换,以实现不同对话场景的语义和语境的表达;

[0064]

所述语言转换模块根据所述场景切换模块所设定的场景,将角色的语言进行识别,并将其转换为与设定场景匹配的语言;所述交互模块用于与所述交互终端进行配对,以实现对所述交互终端的交互数据进行采集;其中,所述交互终端用于对使用者的动作和语音数据进行采集,并将采集采集到的数据传输至所述交互模块中;

[0065]

可选的,所述角色创建模块对各个使用者扮演的角色进行创建,其中,所述角色创建模块包括验证单元和创建单元,所述验证单元对所述使用者的身份进行核验,若使用者的身份核验通过,则采集所述使用者的角色建立数据;

[0066]

其中,所述角色建立数据包括角色姓名、英语对话类型、角色性别和角色的年龄;所述创建单元根据所述验证单元的数据,建立一个使用者的角色;

[0067]

所述验证单元读取所述使用者的识别信息,所述识别信息包括身份证和校园卡;

[0068]

所述验证单元核验所述识别信息并核验通过后,将识别信息与所述角色建立数据绑定;其中,所述核验单元包括收集器、识别探头和支撑座,所述收集器设置在所述支撑座上,且所述支撑座的主体上设有存储腔,所述存储腔用于对所述使用者的身份信息进行存储;同时,所述识别探头设置在所述存储腔中;所述身份信息包括身份证和校园卡;通过所述识别探头对所述使用者的身份信息进行识别,使得所述角色创建模块创建的模块能与所述使用者进行绑定;

[0069]

通过所述验证单元对使用者的身份进行采集,使得采集所述使用者的身份并能被识别,以建立相对应的角色;其中,所述角色为虚拟的动画角色,并通过所述交互模块显示出来,增加使用者在对话之间的交互;同时,所述动画角色根据模型生成辅助工具根据服务器和使用者设定的数据进行生成;其中,所述模型生成辅助工具是本领域的技术人员所熟知的技术手段,本领域的技术人员可以查询相关的技术手册获知该技术,因而在本实施例中不再一一赘述;

[0070]

可选的,所述创建单元包括激活器和选择器,所述选择器用于调用数据库中存储的默认角色;其中,所选择的默认角色与所述角色建立数据相匹配;所述激活器根据所述选择器所选定的角色,并根据所述语言转换模块的数据将该角色进行激活;当所述角色建立后,通过显示单元进行显示,且当所述使用者进行语音表述时,所述激活器激活所述角色,使其进行同步的显示和动作展示;

[0071]

所述语言转换模块包括采集单元和设定单元,所述设定单元用于对角色的语境进行设定;所述采集单元采集使用者发出的声音;在对所述角色进行绑定后,通过所述场景创建模配合所述角色进行声音和动画的显示;其中,所述声音根据所述使用者的声音数据进行同步转述;所述角色的动画根据所述声音进行适配,并配合所述设定单元对动画的动作进行显示;

[0072]

可选的,所述设定单元包括偏好收集器和数据库,所述偏好收集器用于收集所述使用者的设定的数据;所述数据库根据所述偏好收集器的数据,调用所述服务器中存储的语言数据,并存储在本地的存储器中;其中,所述偏好收集器生成一个采集所述使用者个人

喜好的情境信息,基于情境信息生成包括用户偏好、兴趣或习惯中的至少一个用户简档,以实现识别用户的表达或行为规则;所述设定单元在收集所述使用者的偏好数据后,能够对所述使用者的惯常喜好或者表达方式进行设定,使得所述使用者获得最佳的使用体验;

[0073]

同时,所述数据库还与所述服务器进行数据连接,并根据所述偏好采集器采集的用户简档适配相对应的语境数据;

[0074]

所述采集单元包括支撑构件、录音构件和采集构件,所述录音构件和所述采集构件设置在所述支撑构件上,其中,所述支撑构件用于固定在使用者的颈部;所述支撑构件包括固定环和支撑杆,所述支撑杆的一端与所述固定环连接,所述支撑杆的另一端朝向远离所述固定环的一侧伸出且所述采集构件设置在其端部;所述支撑杆的杆体上设置有供所述录音构件放置的存储腔,使所述录音构件隐藏在所述存储腔中;

[0075]

所述录音构件包括拾音阵列和传输器,所述拾音阵列用于对所述使用者的声音进行采集;所述传输器将拾音阵列的声音数据向所述服务器传输;所述固定环呈半圆,并嵌套在所述使用者头部上;

[0076]

所述采集单元还包括限位板,所述限位板设置在所述固定环上,并使得所述固定环能够有效的夹持在所述使用者的脖颈或者头上,使得设置在其上的所述录音构件和所述采集构件能对所述使用者的声音数据和口型的视频数据;所述支撑杆设置为可掰动的硅胶材质,使得所述采集构件对所述使用者的嘴型的采集角度能够被调整;

[0077]

所述采集构件设置在所述支撑杆上朝向使用者的嘴巴一侧,并对所述使用者的口型变化进行采集;所述采集构件包括采集探头和存储单元,所述采集探头对所述使用者嘴巴的图像数据进行采集;所述存储单元对所述采集探头采集的数据进行存储;

[0078]

所述采集单元还包括分析构件,所述分析构件用于对所述录音构件捕获的声音数据进行分析;所述分析构件包括语音云数据库、裁剪器和语音识别工具,所述裁剪器用于对声音数据进行裁剪,并与所述语音云数据库进行比对;所述语音云数据库存储有各种语音对话的场景,并对所述使用者的语音数据进行分析后,匹配该对话场景对话下的回应;

[0079]

获取一个触发周期中所述使用者的语音数据,并通过所述裁剪器将所述语音数据进行裁剪,形成一个语音片段矩阵voice,

[0080][0081]

其中,m为声音片段数,n为采样点,a

ij

表示第i个采样点的第j个声音片段;

[0082]

对声音片段矩阵中的声音片段进行检测,以过滤掉一些无效的声音片段,依次对所述声音片段进行声音能量的检测:

[0083]

其中,第a

ij

次声音片段的声音能量q(a

ij

)为:

[0084]

q(a

ij

)=g2(a

ij

)

·

δt

[0085]

式中,g(a

ij

)为声音信号在第i个采样点的第j个声音片段的采样的幅值;

△

t为每次采样的时长;

[0086]

计算每个片段的所述声音能量后,计算出时间长度为t的声音片段的声音能量r,

计算公式:

[0087][0088]

式中,n为声音片段的总数,满足:n=t/

△

t;t为声音片段的长度;根据r的取值,确定语音片段矩阵voice中的有效成分,并对矩阵进行更新形成有效片段矩阵voice’;

[0089]

将有效片段矩阵voice’中的所述声音片段与所述语音云数据库中的声音进行比对,找出其中的相似识别数据,具体的对比方式包括如下步骤:

[0090]

step1:将所述有效片段矩阵voice’的每一个横向数列{a

ix

}与语音云数据库中的监测片段进行对比,找到最佳对照点ti;

[0091]

step2:以ti为起点截取时长与有效声音片段相同的部分,得到对照矩阵d,将i从1至n遍历一次,共可得到n个对照矩阵;

[0092]

step3:计算每一个对照矩阵d与有效片段矩阵voice’的重叠度sam;

[0093]

step4:在得到的对照矩阵d中选择重叠度最大的对照矩阵,若其重叠度大于阈值,则将对应的识别数据作为候选识别数据;

[0094]

对于步骤step1中寻找最佳对照点的方法包括如下步骤:

[0095]

step101:对指针k初始化,赋值为1,当指针为1时,则在选取的片段中对监测片段的声音片段进行逐个监测;

[0096]

step102:将所述横向数列的第一个数据a

i1

与当前声音检测构件的识别数据的第f个声音数据对齐;

[0097]

step103:获取与横向数列{a

ix

}对应的识别声音数列{b

x

},若横向数列的最后一个数据a

1m

无法找到对应的识别声音数据,则跳至步骤step106;

[0098]

step104:计算识别声音数列与横向数列的同步度zk:

[0099][0100]

式中,zk中的k为每次指针k变化的同步度的值;

[0101]

step105:将指针k累加1,跳至步骤step102;

[0102]

step106:选择识别出来的最接近1的声音同步度zk,其对应的f值作为最佳对照点;若不存在最接近1的声音同步度zk,则直接取:zk=1;

[0103]

在步骤step3中的重叠度sam的计算公式为:

[0104][0105]

其中,j为采点数,h为监测片段数;c

vu

表示对照矩阵d中的片段;g为重叠基数,其值与监测片段的长度有关;

[0106]

特别的,当获取的对照矩阵d与有效片段矩阵voice’完全一样时,所述重叠度sam的值为0;从所述候选识别数据中选择出其重叠度最接近0的识别数据作为相似识别数据,并将相似识别数据的数据和所述声音片段发送至处理器进行进一步的分析,若无候选识别声音数据,则直接放弃声音片段;

[0107]

可选的,所述交互模块包括授权单元和配对单元,所述授权单元用于验证设备是

否经过授权;所述配对单元用于与交互终端进行配对,以建立数据传输关系;所述授权单元包括授权器和存储器,所述授权器识别交互终端的识别码,并建立数据传输通道;所述存储器用于对所述交互终端的配对历史进行存储,若所述交互终端在存储器中有记录,且正处于激活状态,则恢复其数据传输通道;

[0108]

所述交互终端包括动作采集模块,在使用系统之前,需要对交互终端进行连接,使得交互终端能把使用者的所述动作数据进行采集,并触发对多场景的互动或者多种形态的英语肢体语言的表达;同时,本系统能够对所述英语教学过程中的口语表达练习或者训练;其中,所述动作采集模块用于对所述使用者的动作进行采集,使得所述使用者的动作能够被采集,并对创建的角色进行动作的控制或者传导动作;

[0109]

同时,所述动作采集模块佩戴在所述使用者的手掌或者手臂上,并收集所述使用者的动作数据,并将所述使用者的动作数据与创建的角色进行映射;

[0110]

所述动作采集模块包括姿势检测探头、手环和手套,各个所述姿势检测探头设置在所述手环或者手套上,并对所述手套或者手环的位置位移进行检测;其中,所述姿势检测探头用于对所述手环或手套的空间坐标、姿势进行采集;

[0111]

所述姿势检测探头包括但是不局限于以下列举的几种:姿势传感器、空间传感器、空间跟踪定位器或三维空降传感器等用于对所述使用者手臂或者胳膊进行检测传感器;

[0112]

特别的,所述动作采集模块与所述处理器控制连接,并将其上的数据传输至所述处理器中进行处理;同时,所述角色的动作或者转动根据所述动作采集模块的数据进行触发,并映射到所述角色上,使其进行同步的转动动作;

[0113]

可选的,所述场景切换模块包括场景建立单元和显示单元,所述场景建立单元基于设定或选定的场景数据源建立对话场景;所述显示单元用于显示所述对话场景;其中,各个所述对话场景预置在所述数据库中,并在所述使用者选定后,调用选定的对话场景;

[0114]

所述显示单元在对所述角色的动画进行显示的过程中,通过全息投影的方式进行显示;并根据所述使用者动作变化的数据进行角色动作的映射,使得所述角色跟随所述使用者的动作数据进行同步转动或者偏移;

[0115]

所述显示单元包括控制面板、支撑底座、若干个全息显示探头和抬升构件,各个所述全息显示探头设置在所述抬升构件上,并通过所述抬升构件对各个全息显示探头的显示高度进行调整;所述控制面板包括控制按钮、通信器和微控制器,所述微控制器通过所述通信器与所述处理器控制连接,同时,所述控制按钮、各个所述全息显示探头和所述抬升构件分别与所述微控制电连接,使得所述微控制在对所述显示高度和显示内容进行控制;各个所述全息显示探头设置在所述抬升构件上形成显示部,所述显示部设置在所述支撑底座的一侧,并分布于支撑的四个角拐角处,且各个所述全息显示探头朝向支撑底座的中心轴线处;所述验证单元设置在所述支撑底座中,并用于对使用者的身份信息进行核验;

[0116]

其中,各个所述全息显示探头用于对显示内容进行显示;所述抬升构件用于对所述全息显示探头的显示高度进行显示;在显示的过程中,需要将创建的角色数据和所述动作采集模块的动作数据转换为全息数据,使得各个全息显示探头根据全息数据进行显示;其中,所述全息数据包括所述抬升构件的抬升高度和显示的范围。

[0117]

实施例二。

[0118]

本实施例应当理解为至少包含前述任一一个实施例的全部特征,并在其基础上进

一步改进,根据图1、图2、图3、图4、图5、图6和图7,还在于采集构件对所述使用者的嘴型进行采集,用于对所述使用者的表达过程进行评估;其中,将采集构件采集的数据传输至处理器中,并通过所述处理器调用facegen软件对口型或者嘴型变化进行识别,以获取一个使用者的多个口型动作;

[0119]

另外,根据facegen软件对所述使用者的面部尤其是嘴部进行建模,建模的过程根据所述facegen软件采集有限组(200组)面部数据进行建模,对于如何对面部的特征点以及如何建模是本领域的技术人员所熟知的技术手段,本领域的技术人员可以查询相关的技术手册获知该技术,因而在本实施例中不再一一赘述;

[0120]

将更新后的声音片段矩阵voice’中截取声音片段,设p(x)表示第x个子片段,取p(x)和p(x 1)两个子片段,它们各包含有n

x

、n

(x 1)

个时间帧;语音段p(x)和p(x 1)内各时间帧的特征矢量分别为w

x_i

、w

(x 1)_j

,(1≤i≤n

x

,1≤j≤n

(x 1)

);

[0121]

设w

x_i

和w

(x 1)_j

的欧氏距离为d

ij

,那么有p(x)和p(x 1)两个片段的段间距离为l

x

:

[0122][0123]

式中,l

x

为p(x)和p(x 1)两个片段间所有特征矢量距离的平均值;段间距离l

x

反映了两个语音段之间的差异程度,若相邻的两个语音片断同属于一个音素,则所述段间距离小;若相邻的两个语音片断不属于同一个音素,则所述段间距离大;根据所述段间距离的大小,将同一语音数据中的两个单词划分开;将两个单词进行划分后,通过所述分析构件对句子的语义进行识别,使得交互的效果更加准确可靠;

[0124]

另外,所述口型的视频数据根据所述采集构件所采集;设待分割的口型视频数据被划分为t帧,分别标记为1,

……

,t;假设以第t帧为分界,前后各取m帧构成两个子语音段,即i∈[t-m 1,

…

,t]与j∈[t 1,

…

,t m],根据上式可以得到这两个子语音段的段间距离为:

[0125][0126]

为了在t-m 1《1和t m》t时也能计算r

t

,以反映语音起始和结束部分的变化情况,则对语音段的特征参数序列作扩展,即:将第1帧向前延伸1帧,每帧均为第1帧的复制;将第t帧向后延伸m-1,每帧均为第t帧的复制;

[0127]

计算得到每一帧的段间距离,将其在时间轴上(按时间帧)依次取值标出r

t

;当t在一个语音片段内部区域取值时,由于特征矢量相对稳定,图像上反映出来的r

t

数值变化较缓;当从一个单词向另一个单词过渡的时候,特征矢量变化较大,从而r

t

的数值会出现较大幅度的跃升,反映在图像上会呈现两个音素之间形成大的峰值;因此可以根据r

t

的峰值来确定两个单词表达之间的边界,达到将其分割开的目的;

[0128]

另外,所述矩阵的声音片段矩阵voice也可根据此方法进行裁剪;

[0129]

通过将两个单词进行拆分后,可以对这两个单词进行分析,以获取该语音片段的语义;

[0130]

对所述语音数据与所述角色的动画数据进行同步的方法还包括以下步骤:

[0131]

step1:接收所述使用者表述的语音数据,如果是语音输入则转至step2,否则转至step3;

[0132]

step2:将英语语音通过tts(语音引擎)换为英文文本;

[0133]

step3:将英文文本转换为英语语音;

[0134]

step4:从文本产生合成语音的样本;

[0135]

step5:根据处理器,且从分析构件中决定当前的音素;

[0136]

step6:从当前音节的轨迹中计算出目前的口型;

[0137]

step7:合成语音同步的口型并且同步角色展示的内容,返回step5直至没有可读因素为止;

[0138]

其中,step1至step4为预处理阶段,是对整个算法的基础,因为语音转换和口型变化的数据样本可以被预产生并存储在磁盘里;

[0139]

而step5至step7是实现语音口型动画同步性的关键;综合英语表述时口型变化的规律和每个单词的转折或表达的时间控制,能够合成角色与语音表达同步的连续变化的口型动画模型;

[0140]

特别的,在处理过程中,需要数/模(d/a)转换产生声波的模拟信号,并配合所述显示单元对角色动画进行显示,以增强使用者的使用体验和使用乐趣。

[0141]

以上所公开的内容仅为本发明的优选可行实施例,并非因此局限本发明的保护范围,所以凡是运用本发明说明书及附图内容所做的等效技术变化,均包含于本发明的保护范围内,此外,随着技术发展其中的元素可以更新的。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。