1.本发明涉及自然语言处理领域,尤其涉及一种基于长度归一化和主动学习的变长文本分类方法。

背景技术:

2.在电子商务、网络舆情、旅游资讯等多个应用场景中,单个主体可能存在多方面的属性,对于相关文本进行总体的情感或倾向判别不能全面反映对象的特征。例如,当我们在一个电子产品评测网站上看到针对一款手机的评论“屏幕很清晰,但电池很不耐用”,不能简单地说这是一条正面或者负面的评论,它包含了屏幕和电池两方面不同的意见,分别表达了正面和负面的情绪。这些多属性信息对于网站的用户都有一定的价值,需要全方位进行分析,帮助消费者做出理性的判断。这涉及到文本分类中的细粒度情感分析或者多特征分类问题。

3.细粒度情感分析包含多种不同的技术,实现流程中也涉及多个步骤,主要包含:

4.1.方面词(aspect term)或方面类型(aspect category)标注;

5.2.与每个方面词或方面类型相关的语义信息识别,给出其正负面情感判别,或者将其根据需求划分成更细的多分类特征。

6.其中前者根据应用场景不同,通常需要领域专家根据其经验进行方面类型的划分和确定,再匹配文本中显式或者隐式出现的方面词信息,确定需要进行情感判别或者特征识别的对象。后者基于待分类的方面词信息,建立相应的二分类或多分类的分类模型,基于带标注的训练数据集训练分类器,然后应用于更多不带标签的数据集。现有的一些分类方法包括:

7.1、使用人工标注的方法,逐条处理待分析的大量数据。准确度高,但是消耗人力极大,无法处理来自于网络的大量待分类信息。

8.2、基于专家经验和对于训练数据集中各类数据的观察,建立与各类对应的关键词表,使用关键词匹配的方式,采用计数比较或者建立规则的方式进行分类。对于专家的依赖性很高,当数据量不大时基于专家经验能够获得较好的效果,但对于新的数据集中出现的关键词无法覆盖,容易出现过拟合情况。

9.3、使用独热文本表征和向量空间模型,用公式建立关键词权重向量,然后用支持向量机、朴素贝叶斯、k-近邻等传统机器学习方法建立分类器。当数据集中关键词特征一致性较好时能取得良好效果,但无法实现同义词、近义词的模糊匹配,可扩展性较差,分类准确度低于深度学习模型。

10.4、使用嵌入式表征,包括word2vec、glove等静态嵌入式向量或者bert等包含上下文信息的动态表征,建立基于深度学习模型的分类器。这是现在自然语言处理领域的主流模型,但静态嵌入向量的灵活性较差,不能充分利用上下文信息。以bert为代表的transformer网络是现阶段最流行的模型,现有的bert模型在有高质量预训练模型的前提下对于通用场景有较好的效果,但预训练和细调的成本很高。这类模型对于训练数据集较

小的应用场景,容易出现过拟合,并且它通常对于输入文本的长度有一定限制,较短时需要补齐到固定长度,太长时又需要截断,对于原始文本信息有较大损失。

技术实现要素:

11.针对现有技术之不足,提出一种基于长度归一化和主动学习的变长文本分类方法,所述分类方法包括以下步骤:

12.步骤1:获取待分类数据集,采用网络爬虫获取不同应用场景的相关网页数据并通过行业专家对其进行标注,或者下载公开的数据集和标签;

13.步骤2:根据具体的应用场景,组织行业专家讨论并确定所述待分类数据中需要进行情感分析或者特征提取的方面类型,并标注每个方面类型下的部分方面词,构成训练集;

14.步骤3:对所述训练集中的每条待分类文本数据,使用tf-idf公式对其进行重要关键词筛选,将其压缩或补全到分类模型需要的标准长度;

15.步骤31:对于一条待分类的文本数据di,如果其原始长度小于或等于设定的阈值len,使用默认空白字符将其补全到长度len,跳转到步骤4;

16.步骤32:如果所述文本数据di的文本长度大于设定的阈值len,统计所述文本数据di中关键词j出现的次数tf

ij

;

17.步骤33:记录所述文本数据di的长度li和所述训练集中的文本数量n;

18.步骤34:统计训练集中n个文本中包含关键词j的数量dfj;

19.步骤35:计算n个文本的平均长度l

ave

;

20.步骤36:对于每个关键词j,计算它在文档中的tf-idf权重;

[0021][0022]

步骤37:将文本di中所有关键词按照tf-idf权重从大到小排序;

[0023]

步骤38:删除原始文本的所有内容,并将排序后的关键词按照tf-idf权重从大到小的顺序逐个放回文档中的原始位置,直到文档长度达到或超过给定阈值len;

[0024]

步骤39:对于原始文档中的每个关键词都会得到一个tf-idf权重,根据步骤38中的方式进行放回后会有一些权重较低的位置没有填充,成为空白,去掉文档中的所有空白位置后,如果长度仍然大于len,将其截断到len;

[0025]

步骤4:构建bert模型或者xlnet模型,针对具体的方面类型或者主体特征建立分类器,具体包括:

[0026]

步骤41:下载对应语言的通用预训练模型,如bert或xlnet;

[0027]

步骤42:针对情感分析或特征分类任务建立细调模型;

[0028]

步骤5:对建立的所述细调模型使用主动学习方法进行多轮的调优,其主要思路是基于前一轮的错分样本,从未标注数据中匹配和它们相似的容易错分样本,然后对它们进行人工标注,用于扩展训练数据:

[0029]

步骤51:使用训练集数据对于所述细调模型进行训练,得到初始分类模型;

[0030]

步骤52:使用验证集数据对于所述初分类模型进行测试,计算其分类精度;

[0031]

步骤53:如果达到分类准确度目标,步骤5结束,输出达到分类精度的模型,否则转

步骤54;

[0032]

步骤54:提取所述验证集中的分类错误的样本,再从未标注数据中使用这些样本作为种子,提取其关键词特征,使用这些关键词作为检索词,使用信息检索模型和相似度计算方法寻找类似的新样本;

[0033]

步骤55:对于这些新样本进行人工标注;

[0034]

步骤56:将所述新样本和所述分类错误样本一起加入训练集,重新执行步骤51;

[0035]

步骤6:将所述步骤5输出的达到精度目标的模型,应用于包含大量未标注数据的测试集,并进行分类精度的验证,如果未达到精度目标,跳转到步骤54,使用测试集中的错分样本作为种子,寻找未标注的类似样本进行人工标注,以扩充训练数据集。

[0036]

本发明的有益效果在于:

[0037]

1、本发明采用tf-idf方法筛选具有较大信息量的关键词,实现了变长文本的标准化,在输入文本长度差异较大的情况下,不会对较长的文本进行截断,而是保留原文中具有较大信息量的关键词,避免了原始文本信息的损失,提高了分类的精度。

[0038]

2、在细调过程中使用主动学习的方法补充容易错分的训练数据,提高分类模型精度,用较少的训练轮次提高模型准确度,在训练数据集较小的应用场景中具有较好效果,避免模型出现过拟合,提高了模型的泛化性能和分类精度。

附图说明

[0039]

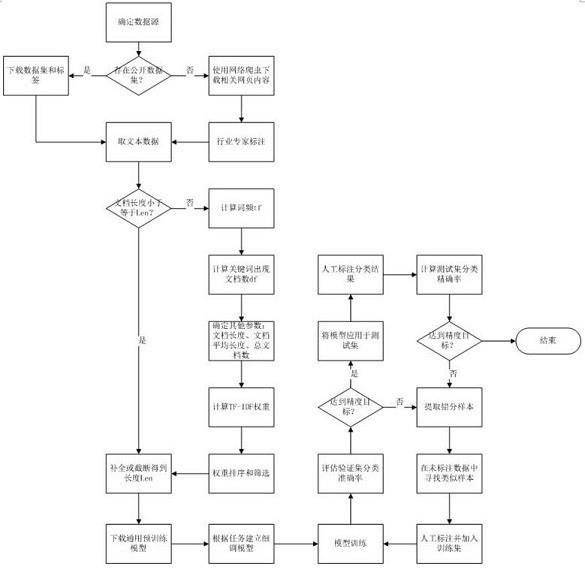

图1是本发明技术方案的方法流程图;和

[0040]

图2是基于bert的一种情感分析微调模型。

具体实施方式

[0041]

为使本发明的目的、技术方案和优点更加清楚明了,下面结合具体实施方式并参照附图,对本发明进一步详细说明。应该理解,这些描述只是示例性的,而并非要限制本发明的范围。此外,在以下说明中,省略了对公知结构和技术的描述,以避免不必要地混淆本发明的概念。

[0042]

下面结合附图进行详细说明。

[0043]

本发明对于细粒度情感分析或者多属性特征分类,人工方法无法处理大量数据,传统的关键词表方法和机器学习模型都有可扩展性较差的特点,基于深度学习的方法,尤其是以bert为代表的transformer网络成为主流模型。bert等模型对于带标注训练数据较少的情况很容易出现过拟合,而且输入文本长度差异较大的情况对于其精度也有较大影响。本发明在现有bert模型基础上增加了长度归一化的步骤,使用tf-idf方法筛选具有较大信息量的关键词,实现了变长文本的标准化。另一方面在细调过程中使用主动学习的方法补充容易错分的训练数据,提高分类模型精度,用较少的训练轮次提高模型准确度。

[0044]

图1是本发明技术方案的方法流程图。针对现有技术存在的不足,提出一种基于长度归一化和主动学习的变长文本分类方法,所述分类方法包括以下步骤:

[0045]

步骤1:获取待分类数据集,采用网络爬虫获取不同应用场景的相关网页数据并通过行业专家对其进行标注,或者下载公开的数据集和标签。

[0046]

步骤2:根据具体的应用场景,组织行业专家讨论并确定所述待分类数据中需要进

行情感分析或者特征提取的方面类型,并标注每个方面类型下的部分方面词,构成训练集。

[0047]

一种具体的实施方式,以semeval-2014中对于饭馆评论的细粒度情感分析任务为例,对于每条评论,主要的方面类型包括{食物、价格、服务、环境、其他}。在每个方面类型下,训练数据中又会有一定数量的方面词标注,以及对应的情感倾向,用于模型训练。

[0048]

步骤3:对所述训练集中的每条待分类文本数据,使用tf-idf公式对其进行重要关键词筛选,将其压缩或补全到分类模型需要的标准长度。

[0049]

步骤31:对于一条待分类的文本数据di,如果其原始长度小于或等于设定的阈值len,使用默认空白字符将其补全到长度len,跳转到步骤4。

[0050]

步骤32:如果所述文本数据di的文本长度大于设定的阈值len,统计所述文本数据di中关键词j出现的次数tf

ij

。

[0051]

步骤33:记录所述文本数据di的长度li和所述训练集中的文本数量n。

[0052]

步骤34:统计训练集中n个文本中包含关键词j的数量dfj;

[0053]

步骤35:计算n个文本的平均长度l

ave

;

[0054]

步骤36:对于每个关键词j,计算它在文档中的tf-idf权重;

[0055][0056]

步骤37:将文本di中所有关键词按照tf-idf权重从大到小排序。

[0057]

步骤38:删除原始文本的所有内容,并将排序后的关键词按照tf-idf权重从大到校的顺序逐个放回文档中的原始位置,直到文档长度达到或超过给定阈值len。

[0058]

步骤39:对于原始文档中的每个关键词都会得到一个tf-idf权重,根据步骤38中的方式进行放回后会有一些权重较低的位置没有填充,成为空白。去掉文档中的所有空白位置后,如果长度仍然大于len,将其截断到len。

[0059]

本发明步骤3提出的采用tf-idf方法筛选具有较大信息量的关键词,实现了变长文本的标准化,在输入文本长度差异较大的情况下,不会对较长的文本进行截断,而是保留原文中具有较大信息量的关键词,避免了原始文本信息的损失,提高了分类的精度

[0060]

步骤4:构建bert模型或者xlnet模型,针对具体的方面类型或者主体特征建立分类器,具体包括:

[0061]

步骤41:下载对应语言的通用预训练模型,如bert或xlnet模型。

[0062]

步骤42:针对情感分析或特征分类任务建立细调模型。由于bert或xlnet均属于通用语言模型,对于其预训练过程中所用到的大量无标注数据能获得较好的语义表达效果,但对于后续的有监督分类问题,直接使用预训练得到的表征通常不能取得最好的分类精度。因此,对于大多数下游应用,需要在其带标注训练数据上对于通用预训练模型(包含其结构和参数)和后续的网络结构同时进行细调,以保证通用模型的输出能够更好适应下游应用的场景。

[0063]

图2是基于bert模型的情感分析细调模型。通用bert分类模型通常是从开始标志[cls]处取表征,而本发明的细调模型从方面词battery和timer处取bert模型的表征,然后通过一个最大池化层和一个全连接网络输出分类概率和标签。进行细调时,bert的transformer网络和后续的最大池化、全连接网络参数都参与调节过程。

[0064]

步骤5:对建立的所述细调模型使用主动学习方法进行多轮的调优,其主要思路是基于前一轮的错分样本,从未标注数据中匹配和它们相似的容易错分的样本,然后对它们进行人工标注,用于扩展训练数据。

[0065]

步骤51:使用训练集数据对于所述细调模型进行训练,得到初始分类模型。

[0066]

步骤52:使用验证集数据对于所述初分类模型进行测试,计算其分类精度。

[0067]

步骤53:如果达到分类准确度目标,步骤5结束,输出达到分类精度的模型,否则转步骤54。

[0068]

步骤54:提取所述验证集中的分类错误的样本,再从未标注数据中使用这些样本作为种子,提取其关键词特征,使用这些关键词作为检索词,使用信息检索模型(如向量空间模型)和相似度计算方法(如余弦相似度)寻找类似的新样本。

[0069]

步骤55:对于这些新样本进行人工标注。

[0070]

步骤56:将所述新样本和所述分类错误样本一起加入训练集,重新执行步骤51。

[0071]

步骤5的主动学习体现在:基于分类器的当前性能选择它最容易犯错的关键样本进行标注,可以降低人工标注的工作量,属于主动学习方法。

[0072]

步骤6:将所述步骤5输出的达到精度目标的模型,应用于包含大量未标注数据的测试集,并进行分类精度的验证,如果未达到精度目标,跳转到步骤54,使用测试集中的错分样本作为种子,寻找未标注的类似样本进行人工标注,以扩充训练数据集。

[0073]

在细调过程中使用主动学习的方法补充容易错分的训练数据,提高分类模型精度,用较少的训练轮次提高模型准确度,在训练数据集较小的应用场景中具有较好效果,避免模型出现过拟合,提高了模型的泛化性能和分类精度。

[0074]

为了进一步说明本发明所提出模型的有效性,将本发明的模型应用于一个旅游信息数据集,在情感分类任务中不同模型取得的分类准确率如表1:

[0075]

表1

[0076][0077][0078]

同时,对于部分特征数据的多类分类器,平均准确率如下表,多数特征的准确率达到90%以上,如表2所示:

[0079]

表2

[0080]

特征平均分类准确率(%)隐患89.62城市90.42文旅93.14

[0081]

需要注意的是,上述具体实施例是示例性的,本领域技术人员可以在本发明公开内容的启发下想出各种解决方案,而这些解决方案也都属于本发明的公开范围并落入本发明的保护范围之内。本领域技术人员应该明白,本发明说明书及其附图均为说明性而并非构成对权利要求的限制。本发明的保护范围由权利要求及其等同物限定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。